18 mei 2025·8 min

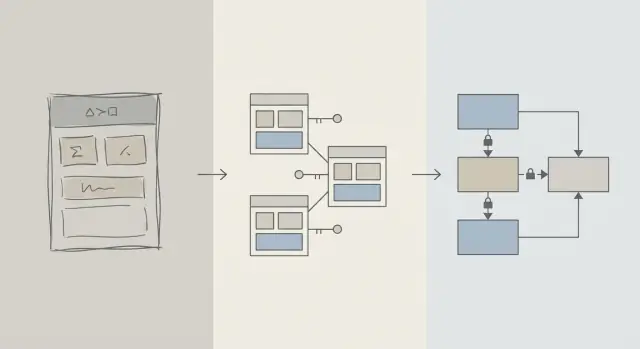

Schema-ontwerp eerst: snellere apps dan vroege query-tuning

Vroege performancewinst komt vaak van beter schema-ontwerp: de juiste tabellen, sleutels en constraints voorkomen trage queries en dure herschrijvingen later.

Schema versus query-optimalisatie: wat we bedoelen

Wanneer een app traag aanvoelt, is de eerste neiging vaak om “de SQL te fixen.” Die impuls is begrijpelijk: één query is zichtbaar, meetbaar en gemakkelijk als zondebok aan te wijzen. Je kunt EXPLAIN draaien, een index toevoegen, een JOIN aanpassen en soms direct resultaat zien.

Maar vroeg in het leven van een product komen snelheidsproblemen net zo goed voort uit de vorm van de data als uit de specifieke querytekst. Als het schema je dwingt tegen de database te vechten, wordt query-tuning een whack-a-mole-cyclus.

Schema-ontwerp (in gewone taal)

Schema-ontwerp is hoe je je data organiseert: tabellen, kolommen, relaties en regels. Het omvat beslissingen zoals:

- Welke “dingen” hun eigen tabel verdienen (gebruikers, orders, events)

- Hoe tabellen zich tot elkaar verhouden (one-to-many, many-to-many)

- Wat uniek of verplicht moet zijn (constraints)

- Hoe je status en geschiedenis vastlegt (timestamps, statusvelden, audit-registraties)

Goed schema-ontwerp zorgt dat de natuurlijke manier om vragen te stellen ook de snelle manier is.

Query-optimalisatie (in gewone taal)

Query-optimalisatie is het verbeteren van hoe je data ophaalt of bijwerkt: queries herschrijven, indexen toevoegen, onnodig werk verminderen en patronen vermijden die tot grote scans leiden.

Beide zijn belangrijk—maar timing is belangrijker

Dit artikel stelt niet “schema goed, queries slecht.” Het gaat om volgorde: zorg eerst dat de fundamenten van het databaseschema kloppen, en tune daarna de queries die het echt nodig hebben.

Je leert waarom schema-beslissingen vroeg presteren domineren, hoe je herkent wanneer het schema de echte bottleneck is, en hoe je het veilig kunt evolueren naarmate je app groeit. Dit is geschreven voor productteams, oprichters en ontwikkelaars die echte apps bouwen—niet voor databasespecialisten.

Waarom schema-ontwerp de meeste vroege performance bepaalt

Vroege performance gaat meestal niet over slimme SQL—het gaat over hoeveel data de database gedwongen is te raken.

Structuur bepaalt hoeveel je scant

Een query kan alleen zo selectief zijn als het datamodel toelaat. Als je ‘status’, ‘type’ of ‘eigenaar’ in losjes gestructureerde velden opslaat (of verspreid over inconsistente tabellen), moet de database vaak veel meer rijen scannen om te bepalen wat overeenkomt.

Een goed schema verkleint de zoekruimte natuurlijk: duidelijke kolommen, consistente datatypes en goed afgebakende tabellen zorgen dat queries vroeg kunnen filteren en minder pagina’s van schijf of geheugen lezen.

Ontbrekende sleutels creëren duur werk

Als primaire en buitenlandse sleutels ontbreken (of niet worden afgedwongen), worden relaties gokken. Dat schuift werk naar de querylaag:

- Joins worden groter omdat er geen betrouwbare, geïndexeerde join-pad is.

- Filters worden complexer omdat je compenseert voor duplicaten, nulls en “bijna overeenkomende” waarden.

Zonder constraints hoopt slechte data zich op—dus worden queries langzamer naarmate je meer rijen toevoegt.

Indexen volgen het schema (en kunnen niet alles oplossen)

Indexen zijn het meest nuttig wanneer ze overeenkomen met voorspelbare toegangspaden: joinen op foreign keys, filteren op goed gedefinieerde kolommen, sorteren op veelgebruikte velden. Als het schema belangrijke attributen in de verkeerde tabel opslaat, betekenissen in één kolom mixt, of afhankelijk is van tekstparsing, kunnen indexen je niet redden—je scant en transformeert nog steeds te veel.

Snel standaard

Met schone relaties, stabiele identifiers en zinnige tabelgrenzen worden veel alledaagse queries “snel standaard” omdat ze minder data raken en eenvoudige, indexvriendelijke predicaten gebruiken. Query-tuning wordt dan een laatste stap—niet een constante brandbestrijding.

De realiteit in de vroege fase: verandering is constant

Vroege producten hebben geen “stabiele requirements”—ze draaien op experimenten. Features worden opgestuurd, herschreven of verdwijnen. Een klein team jongleert roadmap-druk, support en infrastructuur met beperkte tijd om oude beslissingen opnieuw te bekijken.

Wat het vaakst verandert

Het is zelden de SQL-tekst die eerst verandert. Het is de betekenis van de data: nieuwe statussen, nieuwe relaties, “o, we moeten ook bijhouden…” velden en hele workflows die bij lancering niet waren bedacht. Die churn is normaal—en precies daarom zijn schema-keuzes vroeg zo belangrijk.

Waarom een schema later fixen lastiger is dan een query

Een query herschrijven is meestal omkeerbaar en lokaal: je kunt een verbetering uitrollen, meten en terugdraaien indien nodig.

Een schema herschrijven is anders. Zodra je echte klantdata hebt opgeslagen, wordt elke structurele wijziging een project:

- Migraties die tabellen vergrendelen of writes vertragen tijdens piekmomenten

- Backfills om nieuwe kolommen te vullen of afgeleide data te herbouwen

- Dual-write of shadow-tabellen om de app draaiende te houden tijdens een overgang

- Risico op downtime als een verandering niet online uitgevoerd kan worden

Zelfs met goede tools brengen schema-wijzigingen coördinatiekosten met zich mee: app-code-updates, volgorde van deployments en datavalidatie.

Hoe vroege beslissingen compenseren

Als de database klein is, kan een onhandig schema ‘prima’ lijken. Naarmate rijen groeien van duizenden naar miljoenen, zorgt hetzelfde ontwerp voor grotere scans, zwaardere indexen en duurdere joins—en bouwt elke nieuwe feature voort op dat fundament.

Het doel in de vroege fase is geen perfectie. Het is een schema kiezen dat verandering kan absorberen zonder bij elke product-'learn' riskante migraties te vereisen.

Ontwerpprincipes die trage queries voorkomen

De meeste “trage query”-problemen in het begin gaan niet over SQL-trucs—ze gaan over onduidelijkheid in het datamodel. Als het schema onduidelijk maakt wat een record vertegenwoordigt of hoe records zich verhouden, wordt elke query duurder om te schrijven, uit te voeren en te onderhouden.

Begin met een kleine set kernentiteiten

Begin met het benoemen van de paar dingen zonder welke je product niet kan functioneren: gebruikers, accounts, orders, subscriptions, events, facturen—wat echt centraal is. Definieer daarna expliciet de relaties: one-to-many, many-to-many (meestal met een join-tabel) en ownership (wie ‘bevat’ wat).

Een praktische controle: van elke tabel moet je de zin kunnen afmaken “Een rij in deze tabel vertegenwoordigt ___.” Als dat niet lukt, mixt de tabel waarschijnlijk concepten, wat later complexe filtering en joins forceert.

Maak naamgeving en ownership saai consistent

Consistentie voorkomt per ongeluk joinen en verwarrend API-gedrag. Kies conventies (snake_case vs camelCase, *_id, created_at/updated_at) en houd je eraan.

Bepaal ook wie een veld bezit. Bijvoorbeeld: behoort “billing_address” tot een order (een snapshot op dat moment) of tot een gebruiker (huidige standaard)? Beide kunnen geldig zijn—maar ze zonder duidelijke intent mixen veroorzaakt trage, foutgevoelige queries om de ‘waarheid’ te achterhalen.

Kies datatypes die passen bij de realiteit

Gebruik types die runtime-conversies vermijden:

- Gebruik timestamps met zone-regels die je begrijpt.

- Gebruik decimals voor geld (geen floats).

- Gebruik enums of referentietabellen voor bekende categorieën.

Als types verkeerd zijn, kan de database niet efficiënt vergelijken, worden indexen minder nuttig en moeten queries vaak casten.

Dupliceer feiten niet zonder plan

Het opslaan van hetzelfde feit op meerdere plekken (bijv. order_total en sum(line_items)) creëert drift. Als je een afgeleide waarde cachet, documenteer het, definieer de bron van waarheid en zorg dat updates consistent gebeuren (vaak via applicatielogica plus constraints).

Sleutels en constraints: snelheid begint met data-integriteit

Een snelle database is meestal een voorspelbare database. Sleutels en constraints maken je data voorspelbaar door ‘onmogelijke’ toestanden te voorkomen—ontbrekende relaties, dubbele identiteiten of waarden die niet betekenen wat de app denkt. Die netheid beïnvloedt performance direct omdat de database betere aannames kan doen bij het plannen van queries.

Primaire sleutels: elke tabel heeft een stabiele identifier nodig

Elke tabel moet een primaire sleutel (PK) hebben: een kolom (of klein set kolommen) die een rij uniek identificeert en nooit verandert. Dit is niet alleen een theoretische regel—het stelt je in staat efficiënt te joinen, veilig te cachen en records zonder giswerk te refereren.

Een stabiele PK voorkomt ook dure workarounds. Ontbreekt een echte identifier, dan beginnen applicaties rijen te identificeren op e-mail, naam, timestamp of een bundel kolommen—wat leidt tot bredere indexen, tragere joins en edge-cases wanneer die waarden veranderen.

Foreign keys: integriteit die de optimizer helpt

Foreign keys (FKs) dwingen relaties af: orders.user_id moet verwijzen naar een bestaande users.id. Zonder FKs sluipen ongeldige referenties binnen (orders voor verwijderde gebruikers, comments voor ontbrekende posts) en moet elke query defensief filteren, left-joinen en nulls afhandelen.

Met FKs kan de queryplanner joins vaak zekerder optimaliseren omdat de relatie expliciet en gegarandeerd is. Je loopt ook minder snel tegen orphan-rows aan die tabellen en indexen opblazen.

Constraints als vangrails voor schone, snelle data

Constraints zijn geen bureaucratie—het zijn vangrails:

- UNIQUE voorkomt duplicaten die de app extra lookups en cleanup laten doen. Bijvoorbeeld: één canonieke

users.email. - NOT NULL voorkomt driedelige logica en verrassende null-handling takken in queries.

- CHECK houdt waarden binnen een bekende set (bijv.

status IN ('pending','paid','canceled')).

Schonere data betekent eenvoudigere queries, minder fallbackcondities en minder “voor het geval”-joins.

Veelvoorkomende anti-patronen die vertragen

- Geen foreign keys: je betaalt later met orphan-cleanupjobs en ingewikkelde querylogica.

- Dubbele “email” velden (bijv.

users.emailencustomers.email): conflicterende identiteiten en dubbele indexen. - Vrije-tekst statusstrings: typfouten zoals "Cancelled" vs "canceled" creëren verborgen segmenten die filters en rapportages breken.

Als je vroeg snelheid wilt, maak het moeilijk om slechte data op te slaan. De database beloont je met eenvoudigere plannen, kleinere indexen en minder performance-verrassingen.

Normalisatie vs denormalisatie: een praktische balans

Bouw React en Go snel

Maak snel een React-app met een Go- en PostgreSQL-backend vanuit één gesprek.

Normalisatie is eenvoudig: sla elk “feit” op één plek op zodat je data niet overal in de database dupliceert. Wanneer dezelfde waarde in meerdere tabellen of kolommen gekopieerd wordt, worden updates riskant—de ene kopie verandert, de andere niet, en de app toont conflicterende antwoorden.

Normalisatie (de default): één feit, één huis

In de praktijk betekent normalisatie dat entiteiten worden gescheiden zodat updates schoon en voorspelbaar zijn. Bijvoorbeeld: een productnaam en prijs horen in een products-tabel, niet herhaald in elke orderregel. Een categorienaam hoort in categories, gerefereerd door een ID.

Dit vermindert:

- gedupliceerde data (minder opslag, minder inconsistenties)

- updatefouten (eens veranderen, overal doorgevoerd)

- verwarrende “welke waarde is correct?” bugs

Wanneer over-normaliseren schaadt

Normalisatie kan te ver worden doorgevoerd als je data in veel kleine tabellen splitst die constant gejoined moeten worden voor alledaagse schermen. De database kan nog steeds correcte resultaten teruggeven, maar veelvoorkomende reads worden langzamer en complexer omdat elk verzoek meerdere joins nodig heeft.

Een typisch vroeg-fase symptoom: een “simpel” scherm (zoals een bestelgeschiedenis) vereist 6–10 joins, en performance varieert afhankelijk van verkeer en cache-warmte.

Een praktische aanpak: normaliseer kernfeiten, denormaliseer voor de heetste reads

Een verstandige balans:

- Normaliseer kernfeiten en ownership (source of truth). Houd productattributen in

products, categorienamen incategoriesen relaties via foreign keys. - Denormaliseer zorgvuldig voor de heetste reads—maar alleen als je het voordeel kunt uitleggen en kunt waarborgen dat het correct blijft.

Denormalisatie betekent bewust een klein stukje data dupliceren om een veelvoorkomende query goedkoper te maken (minder joins, snellere lijsten). Het sleutelwoord is zorgvuldig: elk gedupliceerd veld heeft een plan nodig om up-to-date te blijven.

Voorbeeld: products, categories en order_items

Een genormaliseerde setup kan er zo uitzien:

products(id, name, price, category_id)categories(id, name)orders(id, customer_id, created_at)order_items(id, order_id, product_id, quantity, unit_price_at_purchase)

Let op de subtiele winst: order_items slaat unit_price_at_purchase op (een vorm van denormalisatie) omdat je historische nauwkeurigheid nodig hebt als de productprijs later verandert. Die duplicatie is opzettelijk en stabiel.

Als je meest voorkomende scherm “orders met item-samenvattingen” is, kun je ook product_name denormaliseren in order_items om elke keer joinen met products te vermijden—maar alleen als je voorbereid bent om het in sync te houden (of accepteert dat het een snapshot bij aankoop is).

Index-strategie volgt schema, niet andersom

Indexen worden vaak gezien als een magische “speed-knop”, maar ze werken alleen goed als de onderliggende tabelstructuur zinvol is. Als je kolommen nog hernoemt, tabellen splitst of verandert hoe records zich tot elkaar verhouden, zal je indexset ook blijven veranderen. Indexen werken het best wanneer kolommen (en de manier waarop de app filtert/sorteert) stabiel genoeg zijn dat je ze niet wekelijks herbouwt.

Begin met de vragen die je app het meest stelt

Je hoeft de toekomst niet perfect te voorspellen, maar je hebt wel een korte lijst nodig van de queries die er echt toe doen:

- “Vind een gebruiker op e-mail.”

- “Toon recente orders voor een klant.”

- “Maak een lijst met facturen per status, nieuwste eerst.”

Die uitspraken vertalen direct naar welke kolommen een index verdienen. Als je die niet hardop kunt zeggen, is het meestal een schema-duidelijkheidsprobleem—geen indexprobleem.

Samengestelde indexen, in gewone taal

Een samengestelde index dekt meer dan één kolom. De volgorde van kolommen is belangrijk omdat de database de index efficiënt van links naar rechts kan gebruiken.

Bijvoorbeeld: als je vaak filtert op customer_id en daarna sorteert op created_at, is een index op (customer_id, created_at) meestal nuttig. De omgekeerde (created_at, customer_id) helpt mogelijk niet hetzelfde.

Indexeer niet alles

Elke extra index heeft een prijs:

- Langzamere writes: inserts/updates moeten ook elke index bijwerken.

- Meer opslag: indexen kunnen een groot deel van je databasegrootte worden.

- Meer complexiteit: extra indexen maken onderhoud en tuning lastiger.

Een schoon, consistent schema beperkt de “juiste” indexen tot een kleine set die bij echte toegangspatronen past—zonder constant een write- en opslagbelasting te betalen.

Schrijfprestaties: de verborgen kosten van een rommelig schema

Verdien credits terwijl je leert

Krijg credits door content te maken over Koder.ai of nieuwe gebruikers te verwijzen.

Trage apps worden niet altijd vertraagd door reads. Veel vroege performanceproblemen duiken op tijdens inserts en updates—gebruikersregistraties, checkout-flow, achtergrondjobs—omdat een rommelig schema elk write extra werk laat doen.

Waarom writes duur worden

Een paar schema-keuzes vergroten stilletjes de kosten van elke wijziging:

- Brede rijen: tientallen (of honderden) kolommen in één tabel proppen betekent vaak grotere rijen, meer I/O en meer cache-churn—zelfs als de meeste kolommen zelden gebruikt worden.

- Te veel indexen: indexen versnellen reads, maar elke insert/update moet ook elke index bijwerken.

- Triggers en cascades: triggers kunnen werk verbergen (extra inserts/updates) achter een simpele

INSERT. Cascading foreign keys kunnen correct en nuttig zijn, maar ze voegen nog steeds write-tijd werk toe dat groeit met gerelateerde data.

Read-heavy vs write-heavy: kies je pijn bewust

Als je workload read-heavy is (feeds, zoekpagina’s), kun je meer indexing en soms selectieve denormalisatie verdragen. Als het write-heavy is (event ingestie, telemetry, hoog volume orders), prioriteer een schema dat writes simpel en voorspelbaar houdt, en voeg read-optimalisaties alleen daar toe waar nodig.

Veelvoorkomende vroege patronen die writes schaden

- Audit logs: goed voor compliance, maar vermijd het loggen van enorme snapshots bij elke update.

- Evenementtabellen: append-only tabellen schalen goed, maar kunnen opbollen als je redundante payloads opslaat.

- Soft deletes: handig, maar vergroten indexgrootte en kunnen updates en queries vertragen tenzij goed gepland.

Houd writes simpel en bewaar historiek

Een praktische aanpak:

- Sla de “huidige staat” op in één tabel en geschiedenis in een aparte append-only tabel.

- Houd historierijen smal (alleen wat echt nodig is: wie/wanneer/wat veranderde).

- Voeg indexen aan geschiedenis toe op basis van echte gebruikspatronen (meestal

entity_id,created_at). - Vermijd triggers voor auditing in het begin; geef de voorkeur aan expliciete applicatie-writes zodat de kosten zichtbaar en testbaar zijn.

Schone write-paden geven je ademruimte—en maken latere query-optimalisatie veel eenvoudiger.

Hoe ORMs en API's schema-beslissingen versterken

ORMs maken databasewerk moeiteloos: je definieert modellen, roept methodes aan en data verschijnt. Maar een ORM kan ook dure SQL verbergen totdat het pijn doet.

ORMs: gemak dat trage patronen kan maskeren

Twee veelvoorkomende valkuilen:

- Inefficiënte joins: een ogenschijnlijk simpele

.include()of geneste serializer kan leiden tot brede joins, dubbele rijen of grote sorteringen—vooral als relaties niet duidelijk gedefinieerd zijn. - N+1 queries: je haalt 50 records op en de ORM draait stilletjes 50 extra queries om gerelateerde data te laden. Het werkt vaak in ontwikkeling en scheurt onder echt verkeer.

Een goed ontworpen schema verkleint de kans dat deze patronen ontstaan en maakt ze makkelijker te detecteren als ze dat wel doen.

Duidelijke relaties maken ORM-gebruik veiliger

Wanneer tabellen expliciete foreign keys, unique constraints en not-null regels hebben, kan de ORM veiligere queries genereren en kan je code op consistente aannames vertrouwen.

Bijvoorbeeld: afdwingen dat orders.user_id moet bestaan (FK) en dat users.email uniek is voorkomt hele klassen edge-cases die anders in applicatielogica en extra querywerk terechtkomen.

API's maken schema-keuzes tot productgedrag

Je API-design is downstream van je schema:

- Stabiele IDs (en consistente sleuteltypes) maken URLs, caching en client-side state eenvoudiger.

- Paginatie werkt het best wanneer je kunt ordenen op een geïndexeerde, monotone kolom (vaak

created_at+id). - Filtering wordt voorspelbaar als kolommen echte attributen representeren (geen overladen strings of JSON-blobs) en constraints waarden schoon houden.

Maak het een workflow, geen reddingsmissie

Behandel schema-beslissingen als eersteklas engineering:

- Gebruik migraties voor elke wijziging, gereviewd als code.

- Voeg lichte “schema-reviews” toe voor nieuwe endpoints: welke tabellen, welke sleutels, welke constraints, welke query-vorm.

- Log ORM-queries in staging en flag N+1 patronen vóór productie.

Als je snel bouwt met een chat-gedreven workflow (bijvoorbeeld een React-app plus een Go/PostgreSQL-backend genereren in Koder.ai), helpt het om “schema review” vroeg in het gesprek op te nemen. Je kunt snel itereren, maar wil nog steeds constraints, sleutels en een migratieplan bewust inrichten—vooral vóór traffic binnenkomt.

Vroege waarschuwingssignalen dat het schema de bottleneck is

Sommige performanceproblemen zijn niet zozeer “slechte SQL” als wel de database die tegen de vorm van je data vecht. Als je dezelfde issues over veel endpoints en rapporten ziet, is het vaak een schema-signaal, geen query-tuning kans.

Veelvoorkomende symptomen om op te letten

Trage filters zijn een klassiek teken. Als eenvoudige voorwaarden zoals “vind orders per klant” of “filter op aanmaakdatum” consequent traag zijn, kan het probleem ontbreken van relaties, mismatched types of kolommen die niet effectief geïndexeerd kunnen worden zijn.

Een ander rood vlaggetje is exploderende join-aantallen: een query die zou moeten joinen tussen 2–3 tabellen, schakelt 6–10 tabellen aan om een basisvraag te beantwoorden (vaak door over-normalized lookups, polymorfe patronen of “alles in één tabel” ontwerpen).

Let ook op inconsistente waarden in kolommen die als enums dienen—vooral statusvelden (“active”, “ACTIVE”, “enabled”, “on”). Inconsistentie dwingt defensieve queries af (LOWER(), COALESCE(), OR-ketens) die traag blijven ongeacht tuning.

Schema-checklist (snel te verifiëren)

- Ontbrekende indexen op foreign keys (joins worden full scans naarmate tabellen groeien).

- Verkeerde datatypes (bv. IDs als strings, datums als tekst, geld als floats).

- EAV-tabellen (Entity–Attribute–Value) gebruikt voor kerndata: in het begin flexibel, maar filters/sorts worden vele joins en lastig te indexeren predicaten.

Simpele, tool-agnostische diagnostiek

Begin met realiteitschecks: rijaantallen per tabel en kardinaliteit voor sleutelkolommen (hoeveel distinct waarden). Als een “status”-kolom 4 waarden zou moeten hebben maar je vindt er 40, lekt het schema al complexiteit.

Bekijk daarna queryplannen voor je trage endpoints. Als je herhaaldelijk sequentiële scans op join-kolommen of grote tussenresultaten ziet, zijn schema en indexering waarschijnlijk de wortel.

En bekijk slow-query logs. Wanneer veel verschillende queries op vergelijkbare manieren traag zijn (zelfde tabellen, dezelfde predicaten), is het meestal een structureel probleem dat je op modelniveau wilt oplossen.

Het schema veilig evolueren naarmate je groeit

Exporteer je source code wanneer je wilt

Behoud controle door broncode te exporteren terwijl je schema en functies evolueren.

Vroege schema-keuzes overleven zelden het eerste contact met echte gebruikers. Het doel is niet perfect zijn—het is veranderen zonder productie te breken, data te verliezen of het team een week te laten vastlopen.

Een lichte, herhaalbare veranderworkflow

Een praktische workflow die schaalt van één persoon tot een groter team:

- Model: Schrijf de nieuwe vorm op (tabellen/kolommen, relaties en wat source of truth wordt). Voeg voorbeeldrecords en edge-cases toe.

- Migreer: Voeg nieuwe structuren backward-compatible toe (nieuw columns/tabellen eerst; vermijd direct verwijderen of hernoemen).

- Backfill: Vul nieuwe velden in batches vanuit bestaande data. Houd voortgang bij zodat je kunt hervatten.

- Valideer: Voeg constraints pas toe nadat data schoon is (bijv. NOT NULL, foreign keys). Voer checks uit die oude en nieuwe outputs vergelijken.

Feature flags en dual writes (spaarzaam gebruiken)

De meeste schema-wijzigingen hebben geen complexe rollout nodig. Geef de voorkeur aan “expand-and-contract”: schrijf code die zowel oud als nieuw kan lezen en schakel writes pas om als je zeker bent.

Gebruik feature flags of dual writes alleen wanneer je echt een geleidelijke overgang nodig hebt (hoog verkeer, lange backfills of meerdere services). Als je dual write gebruikt, voeg monitoring toe om drift te detecteren en definieer welke zijde wint bij conflicten.

Rollbacks en migratietests die realistisch zijn

Veilige rollbacks beginnen met migraties die omkeerbaar zijn. Oefen het ‘undo’-pad: een nieuwe kolom droppen is makkelijk; overschreven data terughalen is dat niet.

Test migraties op realistische datavolumes. Een migratie die in 2 seconden op een laptop klaar is, kan tabellen minutenlang vergrendelen in productie. Gebruik productie-achtige rij-aantallen en indexen en meet runtimes.

Platformtools kunnen hier risico verlagen: betrouwbare deployments plus snapshots/rollback (en de mogelijkheid je code te exporteren) maken het veiliger om schema en app-logic samen te itereren. Als je Koder.ai gebruikt, kun je vertrouwen op snapshots en planning-modus bij migraties die zorgvuldige sequencing vereisen.

Documenteer beslissingen voor de volgende persoon (inclusief toekomstige jij)

Houd een korte schema-log bij: wat veranderde, waarom en welke trade-offs werden geaccepteerd. Link het in /docs of in je repo README. Voeg notities toe zoals “deze kolom is bewust denormalized” of “foreign key toegevoegd na backfill op 2025-01-10” zodat toekomstige wijzigingen niet oude fouten herhalen.

Wanneer queries optimaliseren (en een verstandige volgorde)

Query-optimalisatie doet ertoe—maar het betaalt zich het meest terug wanneer je schema je niet tegenwerkt. Als tabellen geen duidelijke sleutels hebben, relaties inconsistent zijn of er geen “één rij per ding” is, kun je uren besteden aan het tunen van queries die volgende week toch herschreven worden.

Een praktische prioriteitenorde

-

Los schema-blockers eerst op. Begin met alles wat correct queryen moeilijk maakt: ontbrekende primaire sleutels, inconsistente foreign keys, kolommen die meerdere betekenissen mixen, gedupliceerde sources of truth of types die niet overeenkomen met de realiteit (bv. datums als strings).

-

Stabiliseer de toegangspatronen. Zodra het datamodel weerspiegelt hoe de app zich gedraagt (en waarschijnlijk blijft voor de volgende paar sprints), wordt query-tuning duurzaam.

-

Optimaliseer de top-queries—niet alle queries. Gebruik logs/APM om de traagste en meest frequente queries te identificeren. Een endpoint dat 10.000 keer per dag wordt geraakt is meestal belangrijker dan een zeldzaam admin-rapport.

De 80/20 van vroege query-tuning

De meeste vroege winst komt van een kleine set acties:

- Voeg de juiste index toe voor je meest gebruikte filters en joins (en verifieer dat hij ook echt wordt gebruikt).

- Retourneer minder kolommen (vermijd

SELECT *, vooral op brede tabellen). - Vermijd onnodige joins—soms bestaat een join alleen omdat het schema je dwingt basisattributen te ‘vinden’.

Verwachtingen managen: het is doorlopend, maar fundamenten eerst

Performance-werk stopt nooit helemaal, maar het doel is voorspelbaarheid. Met een schoon schema voegt elke nieuwe feature incrementele last toe; met een rommelig schema bouwt elke feature op compound verwarring.

Checklist voor deze week

- Maak een lijst van de top 5 traagste en top 5 meest frequente queries.

- Bevestig voor elk: primaire sleutel aanwezig, joins zijn key-to-key en types kloppen.

- Voeg één index toe die past bij het dominante filter/order.

- Vervang

SELECT *in één hot path. - Meet opnieuw en noteer beknopt een “voor/na” voor de volgende sprint.