10 nov 2025·8 min

Schema-wijzigingen en migraties in AI-gebouwde systemen: een gids

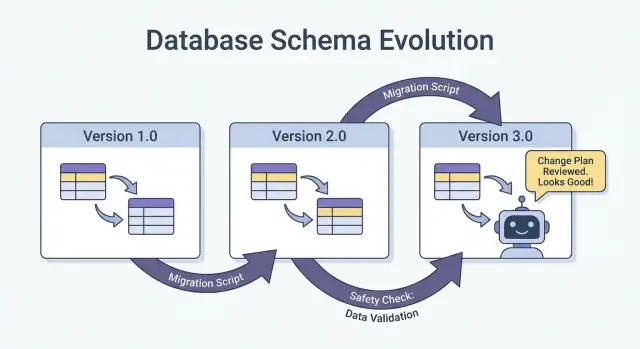

Leer hoe AI-gebouwde systemen schemawijzigingen veilig afhandelen: versionering, backward-compatible uitrol, datamigraties, testen, observability en rollback-strategieën.

Wat “schema” betekent in AI-gebouwde systemen

Een schema is simpelweg de gedeelde afspraak over de vorm van data en wat elk veld betekent. In AI-gebouwde systemen verschijnt die afspraak op meer plekken dan alleen databasetabellen — en het verandert vaker dan teams verwachten.

Schema is niet alleen een database-ding

Je komt schema’s tegen in minstens vier veelvoorkomende lagen:

- Databases: tabel-/kolomnamen, datatypes, constraints, indexen en relaties.

- API's: request/response JSON-vorm, verplichte versus optionele velden, enums, foutformaten, pagineringsconventies.

- Events en berichten: de payloads die door streams, queues en webhooks gaan (vaak impliciet geversioneerd via consumenten).

- Configuraties en contracten: feature flags, omgevingsvariabelen, YAML/JSON-configs en “verborgen contracten” zoals bestandsformaten en naamgevingsconventies.

Als twee delen van het systeem data uitwisselen, is er een schema — zelfs als niemand het heeft opgeschreven.

Waarom schemawijzigingen vaker voorkomen in AI-gebouwde systemen

Door AI gegenereerde code kan ontwikkeling sterk versnellen, maar het verhoogt ook churn:

- Gegenereerde code weerspiegelt de laatste prompt en context, dus kleine promptwijzigingen kunnen veldnamen, nesting, defaults of validaties veranderen.

- Vereisten evolueren sneller wanneer het goedkoop is om een nieuw endpoint of pipelinestap te publiceren.

- Inconsistente conventies (snake_case vs. camelCase,

idvs.userId) duiken op wanneer meerdere generaties of refactors door teams plaatsvinden.

Het resultaat is vaker “contract drift” tussen producers en consumers.

Als je een vibe-coding workflow gebruikt (bijvoorbeeld handlers, DB-access-lagen en integraties genereren via chat), is het de moeite waard om schema-disciplines vanaf dag één in die workflow te verankeren. Platforms zoals Koder.ai helpen teams snel te bewegen door React/Go/PostgreSQL en Flutter-apps vanuit een chatinterface te genereren — maar hoe sneller je kunt shippen, hoe belangrijker het wordt om interfaces te versioneren, payloads te valideren en veranderingen bedachtzaam uit te rollen.

Het doel van deze gids

Dit artikel richt zich op praktische manieren om productie stabiel te houden terwijl je toch snel kunt itereren: backward compatibility behouden, wijzigingen veilig uitrollen en data migreren zonder verrassingen.

Wat we niet behandelen

We duiken niet diep in theorie-rijke modellering, formele methoden of vendor-specifieke features. De nadruk ligt op patronen die je over stacks heen kunt toepassen — of je systeem nu handmatig gecodeerd, AI-ondersteund of grotendeels AI-gegenereerd is.

Waarom schemawijzigingen vaker gebeuren met AI-gegenereerde code

AI-gegenereerde code maakt schemawijzigingen vaak normaal — niet omdat teams onzorgvuldig zijn, maar omdat de inputs van het systeem vaker veranderen. Wanneer het gedrag van je applicatie deels gestuurd wordt door prompts, modelversies en gegenereerde glue code, is de kans dat de datavorm in de loop van de tijd verschuift veel groter.

Veelvoorkomende triggers die je in de praktijk ziet

Een paar patronen veroorzaken herhaaldelijk schema-churn:

- Nieuwe productfeatures: een nieuw veld toevoegen (bijv.

risk_score,explanation,source_url) of één concept opsplitsen in meerdere (bijv.addressnaarstreet,city,postal_code). - Model-output veranderingen: een nieuwere modelversie kan meer gedetailleerde structuren, andere enum-waarden of licht andere naamgevingen produceren (“confidence” vs. “score”).

- Prompt-updates: promptwijzigingen bedoeld om kwaliteit te verbeteren kunnen onbedoeld formatting, verplichte velden of nesting veranderen.

Risicovolle patronen die AI-systemen fragiel maken

AI-gegenereerde code werkt vaak snel, maar kan fragiele aannames vastleggen:

- Impliciete aannames: code gaat stilzwijgend uit van een veld dat altijd aanwezig is, altijd numeriek is of binnen een bepaald bereik valt.

- Verborgen koppeling: één service vertrouwt op interne veldnamen of volgorde van een andere service in plaats van een gedefinieerde interface.

- Ongedocumenteerde velden: het model begint een nieuwe property te produceren, en downstream code gaat erop vertrouwen zonder dat er expliciet is afgesproken dat het onderdeel is van het contract.

Waarom AI de veranderingen versterkt

Codegeneratie stimuleert snelle iteratie: je regenereert handlers, parsers en database-access-lagen naarmate vereisten evolueren. Die snelheid is nuttig, maar maakt het ook makkelijk om kleine interfacewijzigingen herhaaldelijk te publiceren — soms zonder het te merken.

De veiligere mindset is om elk schema als een contract te behandelen: databasetabellen, API-payloads, events en zelfs gestructureerde LLM-responses. Als een consumer ervan afhankelijk is, versieer het, valideer het en verander het doelbewust.

Types schemawijzigingen: Additief vs. Brekend

Schemawijzigingen zijn niet allemaal gelijk. De meest nuttige eerste vraag is: blijven bestaande consumers werken zonder aanpassingen? Als ja, is het meestal additief. Zo niet, is het brekend — en heeft het een gecoördineerd rollout-plan nodig.

Additieve wijzigingen (meestal veilig)

Additieve wijzigingen breiden uit zonder bestaande betekenis te veranderen.

Veelvoorkomende databasevoorbeelden:

- Een kolom toevoegen met een default of NULL toestaan (bijv.

preferred_language). - Een nieuwe tabel of index toevoegen.

- Een optioneel veld toevoegen aan een JSON-blob opgeslagen in een kolom.

Niet-database voorbeelden:

- Een nieuwe property toevoegen aan een API-response (clients die onbekende velden negeren blijven werken).

- Een nieuw eventveld toevoegen in een stream/queue-bericht.

- Een nieuwe waarde voor een feature flag toevoegen terwijl bestaande gedrag als default blijft.

Additief is alleen “veilig” als oudere consumers tolerant zijn: ze moeten onbekende velden negeren en nieuwe velden niet vereisen.

Brekende wijzigingen (riskant)

Brekende wijzigingen veranderen of verwijderen iets waar consumers al op vertrouwen.

Typische database-brekende wijzigingen:

- Wijzigen van een kolomtype (string → integer, timestamp-precisie verandert).

- Een veld/kolom hernoemen (alles dat de oude naam leest faalt).

- Een kolom/tabel verwijderen die nog steeds wordt aangeroepen.

Niet-database brekende wijzigingen:

- JSON-velden hernoemen/verwijderen in request/response payloads.

- Eventsemantiek wijzigen (zelfde veldnaam, andere betekenis).

- Webhook-payloadstructuur wijzigen zonder versieverhoging.

Schrijf altijd op wat de impact op consumers is

Documenteer vóór het mergen:

- Wie het consumeert (services, dashboards, datapijplijnen, partners).

- Compatibiliteit (backward/forward, en voor hoe lang).

- Faalmodus (parsing-fouten, stille datacorruptie, verkeerde businesslogica).

Dit korte “impactnotitie” dwingt duidelijkheid af — vooral wanneer AI-gegenereerde code schemawijzigingen impliciet introduceert.

Versioneringsstrategieën voor schema’s en interfaces

Versionering is hoe je andere systemen (en je toekomstige zelf) vertelt “dit is veranderd, en dit is hoe risicovol het is.” Het doel is geen papierwinkel — het voorkomt stille breuken wanneer clients, services of datapijplijnen in verschillende snelheden updaten.

Een plain-language semantic versioning mindset

Denk in major / minor / patch termen, zelfs als je niet letterlijk 1.2.3 publiceert:

- Major: brekende wijziging. Oude consumers kunnen falen of verkeerd gedrag vertonen zonder aanpassingen.

- Minor: veilige uitbreiding. Oude consumers blijven werken; nieuwe consumers kunnen nieuwe mogelijkheden gebruiken.

- Patch: bugfix of verduidelijking die de betekenis niet verandert.

Een simpele regel die teams redt: verander de betekenis van een bestaand veld nooit stilzwijgend. Als status="active" vroeger “betalende klant” betekende, gebruik het dan niet ineens voor “account bestaat”. Voeg een nieuw veld toe of maak een nieuwe versie.

Geversioneerde endpoints vs. geversioneerde velden

Je hebt meestal twee praktische opties:

1) Geversioneerde endpoints (bijv. /api/v1/orders en /api/v2/orders):

Goed wanneer wijzigingen echt brekend of wijdverspreid zijn. Het is duidelijk, maar kan duplicatie en langdurig onderhoud opleveren als je meerdere versies moet blijven ondersteunen.

2) Geversioneerde velden / additieve evolutie (bijv. voeg new_field toe, behoud old_field):

Goed wanneer je wijzigingen additief kunt maken. Oudere clients negeren wat ze niet begrijpen; nieuwere clients lezen het nieuwe veld. Deprecateer en verwijder het oude veld uiteindelijk met een expliciet plan.

Event-schema’s en registries

Voor streams, queues en webhooks bevinden consumers zich vaak buiten jouw deploy-controle. Een schema registry (of een gecentraliseerd schemacatalogus met compatibiliteitschecks) helpt regels af te dwingen zoals “alleen additieve wijzigingen toegestaan” en maakt duidelijk welke producers en consumers op welke versies vertrouwen.

Veilige rollouts: Expand/Contract (het meest betrouwbare patroon)

De veiligste manier om schemawijzigingen te deployen — vooral bij meerdere services, jobs en AI-gegenereerde componenten — is het expand → backfill → switch → contract-patroon. Het minimaliseert downtime en voorkomt “alles of niets”-deploys waarbij één achterblijvende consumer productie breekt.

De vier stappen (en waarom ze werken)

1) Expand: Introduceer het nieuwe schema op een backward-compatible manier. Bestaande readers en writers blijven ongewijzigd werken.

2) Backfill: Vul nieuwe velden voor historische data (of verwerk berichten opnieuw) zodat het systeem consistent wordt.

3) Switch: Update writers en readers om het nieuwe veld/formaat te gebruiken. Dit kan geleidelijk (canary, percentage rollout) omdat het schema beide ondersteunt.

4) Contract: Verwijder het oude veld/formaat pas nadat je zeker weet dat er niets meer van afhankelijk is.

Twee-fase (expand → switch) en drie-fase (expand → backfill → switch) rollouts verminderen downtime doordat ze strakke koppeling vermijden: writers kunnen eerst verhuizen, readers later, en omgekeerd.

Voorbeeld: voeg een kolom toe, backfill, en maak het dan verplicht

Stel dat je customer_tier wilt toevoegen.

- Expand: Voeg

customer_tiertoe als nullable met defaultNULL. - Backfill: Draai een job die tiers voor bestaande rijen berekent.

- Switch: Update de app en pipelines om altijd

customer_tierte schrijven, en update readers om het te prefereren. - Contract: Na monitoring maak je het NOT NULL (en verwijder je eventueel legacy-logica).

Coordinatie: writers en readers moeten het eens zijn

Behandel elk schema als een contract tussen producers (writers) en consumers (readers). In AI-gebouwde systemen is dit makkelijk te missen omdat nieuwe codepaden snel verschijnen. Maak rollouts expliciet: documenteer welke versie wat schrijft, welke services beide kunnen lezen, en de exacte “contractdatum” waarop oude velden verwijderd mogen worden.

Database-migraties: hoe je data verandert zonder productie te breken

Plan your next schema change

Use planning mode to map expand-backfill-switch-contract before you generate code.

Database-migraties zijn de “handleiding” om productie-data en -structuur van de ene veilige staat naar de volgende te brengen. In AI-gebouwde systemen zijn ze nog belangrijker omdat gegenereerde code per ongeluk kan aannemen dat een kolom bestaat, velden inconsistent hernoemen of constraints veranderen zonder rekening te houden met bestaande rijen.

Migratiebestanden vs. auto-migraties

Migratiebestanden (in source control) zijn expliciete stappen zoals “add column X”, “create index Y” of “copy data from A to B”. Ze zijn auditeerbaar, reviewbaar en kunnen in staging en productie worden afgespeeld.

Auto-migraties (gegenereerd door een ORM/framework) zijn handig voor vroege ontwikkeling en prototyping, maar kunnen risicovolle operaties produceren (kolommen droppen, tabellen herbouwen) of veranderingen in een onverwachte volgorde uitvoeren.

Een praktische regel: gebruik auto-migraties om wijzigingen op te stellen, en zet ze vervolgens om naar gereviewde migratiebestanden voor alles dat productie raakt.

Idempotentie en volgorde

Maak migraties waar mogelijk idempotent: opnieuw uitvoeren moet data niet beschadigen of halverwege falen. Gebruik bij voorkeur “create if not exists”, voeg nieuwe kolommen eerst toe als nullable en bescherm datatransformaties met checks.

Houd ook een duidelijke volgorde. Elke omgeving (lokaal, CI, staging, prod) moet dezelfde migratiereeks toepassen. “Fix” productie niet handmatig met SQL tenzij je het daarna vastlegt in een migratie.

Langlopende migraties zonder tabelvergrendeling

Sommige schemawijzigingen kunnen writes (of zelfs reads) blokkeren als ze een grote tabel vergrendelen. Hoge-niveau manieren om risico te verminderen:

- Gebruik online/lock-minimizing operaties die je database ondersteunt (bijv. concurrent index builds).

- Splits veranderingen in stappen: voeg nieuwe structuren eerst toe, backfill in batches, en switch dan de app.

- Plan zware operaties tijdens low-traffic windows, met timeouts en monitoring.

Multi-tenant en geshardde setups

Voor multi-tenant databases: draai migraties in een gecontroleerde loop per tenant, met progress tracking en veilige retries. Voor shards behandel elke shard als een aparte productieomgeving: rol migraties shard-voor-shard uit, verifieer gezondheid en ga dan door. Dit beperkt blast radius en maakt rollback haalbaar.

Backfills en Reprocessing: bestaande data bijwerken

Een backfill vult nieuw toegevoegde velden (of gecorrigeerde waarden) voor bestaande records. Reprocessing draait historische data opnieuw door een pipeline — typisch omdat businessregels veranderden, een bug is gefixt of een model/output-formaat is geüpdatet.

Beide komen vaak voor na schemawijzigingen: het is makkelijk om de nieuwe vorm alleen voor “nieuwe data” te schrijven, maar productiesystemen vertrouwen ook op data van gisteren die consistent moet zijn.

Veelvoorkomende aanpakken

Online backfill (in productie, geleidelijk). Je draait een gecontroleerde job die records in kleine batches bijwerkt terwijl het systeem live blijft. Dit is veiliger voor kritieke services omdat je de load kunt throttlen, pauzeren en hervatten.

Batch backfill (offline of geplande jobs). Je verwerkt grote stukken tijdens low-traffic windows. Het is operationeel eenvoudiger, maar kan pieken in database-load veroorzaken en het duurt langer om van fouten te herstellen.

Lazy backfill on read. Wanneer een oud record gelezen wordt, berekent/populeert de applicatie de missende velden en schrijft het terug. Dit spreidt de kosten over tijd en vermijdt een grote job, maar maakt de eerste read trager en kan oude data lang on geconverteerd laten.

In de praktijk combineren teams dit vaak: lazy backfill voor de lange staart en een online job voor de meest gebruikte data.

Hoe valideer je een backfill

Validatie moet expliciet en meetbaar zijn:

- Counts: hoeveel rijen/events moeten worden bijgewerkt vs. hoeveel zijn bijgewerkt.

- Checksums/aggregaten: vergelijk totalen (bijv. som van bedragen, distinct IDs) voor en na.

- Sampling: steekproef controle van een statistisch zinvolle set, inclusief randgevallen.

Valideer ook downstream-effecten: dashboards, zoekindexen, caches en exports die op de bijgewerkte velden vertrouwen.

Kosten, tijd en acceptatiecriteria

Backfills ruilen snelheid (snel klaar) tegen risico en kosten (load, compute en operationele overhead). Stel van tevoren acceptatiecriteria: wat “klaar” betekent, verwachte runtime, maximaal toegestane foutmarge en wat je doet als validatie faalt (pauzeren, retryen of terugdraaien).

Event- en berichtschema-evolutie (streams, queues, webhooks)

Keep mobile clients stable

Create a Flutter mobile app that stays compatible as your backend schema evolves.

Schema’s bestaan niet alleen in databases. Elke keer dat één systeem data naar een ander stuurt — Kafka topics, SQS/RabbitMQ queues, webhook payloads, zelfs “events” geschreven naar object storage — creëer je een contract. Producers en consumers bewegen onafhankelijk, dus deze contracten breken vaker dan de interne tabellen van één app.

Het veiligste default: evolueer events backward-compatibly

Voor eventstreams en webhook-payloads, geef de voorkeur aan wijzigingen die oude consumers kunnen negeren en nieuwe consumers kunnen adopteren.

Een praktische regel: voeg velden toe, verwijder of hernoem niet. Als je iets moet deprecaten, blijf het een tijdlang sturen en documenteer het als deprecated.

Voorbeeld: breid een OrderCreated-event uit door optionele velden toe te voegen.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Oudere consumers lezen order_id en created_at en negeren de rest.

Consumer-driven contracts (plain-English versie)

In plaats van dat de producer gokt wat anderen kan breken, publiceren consumenten waar ze op vertrouwen (velden, types, required/optional regels). De producer valideert dan veranderingen tegen die verwachtingen voordat er wordt gedeployed. Dit is vooral nuttig in AI-gegenereerde codebases, waar een model een veld “behulpzaam” kan hernoemen of een type kan veranderen.

Onbekende velden veilig behandelen

Maak parsers tolerant:

- Negeer onbekende velden standaard (faal niet alleen omdat er een nieuwe key verschijnt).

- Behandel nieuwe velden als optioneel totdat je ze echt nodig hebt.

- Log onverwachte velden op een laag niveau zodat je adoptieproblemen kunt spotten zonder te pagineren.

Als je een brekende wijziging moet doorvoeren, gebruik dan een nieuw event-type of een geversioneerde naam (bijv. OrderCreated.v2) en draai beide parallel totdat alle consumers gemigreerd zijn.

AI-output als schema: prompts, modellen en gestructureerde responses

Wanneer je een LLM toevoegt aan een systeem, worden de outputs snel een de-facto schema — zelfs als niemand een formeel spec heeft geschreven. Downstream code gaat er bijvoorbeeld van uit “er zal een summary-veld zijn”, “de eerste regel is de titel”, of “bulletpunten zijn gescheiden door streepjes”. Die aannames verhardt en een kleine verschuiving in modelgedrag kan ze breken, net als een hernoemde databasekolom.

Geef de voorkeur aan expliciete structuur (en valideer die)

In plaats van “mooie tekst” te parseren, vraag om gestructureerde outputs (meestal JSON) en valideer ze voordat ze de rest van je systeem in gaan. Zie dit als het verschuiven van “beste poging” naar een contract.

Een praktische aanpak:

- Definieer een JSON-schema (of een getypt interface) voor de modelresponse.

- Afkeur of quarantineer ongeldige responses (converteer ze niet stilzwijgend).

- Log validatiefouten zodat je ziet wat verandert.

Dit is vooral belangrijk wanneer LLM-responses data pipelines, automatisering of gebruikergerichte content voeden.

Plan voor model drift

Zelfs met dezelfde prompt kunnen outputs in de loop van de tijd verschuiven: velden kunnen weggelaten worden, extra keys verschijnen en types kunnen veranderen ("42" vs 42, arrays vs strings). Beschouw dit als schema-evolutie.

Mitigaties die goed werken:

- Maak velden waar redelijk optioneel en stel expliciet defaults in.

- Sta onbekende keys toe maar negeer ze veilig (tenzij je strikt moet zijn vanwege compliance).

- Voeg “guardrails” toe (bijv. vereiste velden, maximumlengtes, enum-waarden).

Behandel prompt-wijzigingen als API-wijzigingen

Een prompt is een interface. Als je die wijzigt, versieer hem. Houd prompt_v1, prompt_v2 en rol wijzigingen geleidelijk uit (feature flags, canaries of per-tenant toggles). Test met een vaste evaluatieset voordat je promoot, en houd oudere versies draaiend totdat downstream consumers aangepast zijn. Voor meer over veilige uitrolmechanieken, link je aanpak naar /blog/safe-rollouts-expand-contract.

Testen en validatie voor schemawijzigingen

Schemawijzigingen falen meestal op saaie, dure manieren: een nieuwe kolom ontbreekt in één omgeving, een consumer verwacht nog een oud veld, of een migratie draait goed op lege data maar timeouts in productie. Testen verandert die “verrassingen” in voorspelbaar, oplosbaar werk.

Drie testniveaus (en wat elk opvangt)

Unit tests beschermen lokale logica: mappingfuncties, serializers/deserializers, validators en query-builders. Als een veld hernoemd of een type verandert, moeten unit tests dicht bij de betreffende code falen.

Integratietests zorgen dat je app nog werkt met echte afhankelijkheden: dezelfde database-engine, een echte migratietool en echte berichtformaten. Hier vang je problemen als “het ORM-model veranderde maar de migratie niet” of “de nieuwe indexnaam conflicteert”.

End-to-end tests simuleren gebruikers- of workflowresultaten over services heen: maak data aan, migreer die, lees hem terug via API’s en verifieer dat downstream consumers nog correct reageren.

Contracttests voor producers en consumers

Schema-evolutie breekt vaak op boundaries: service-naar-service APIs, streams, queues en webhooks. Voeg contracttests toe die aan beide zijden draaien:

- Producers bewijzen dat ze events/responses kunnen uitsturen die overeenkomen met een afgesproken contract.

- Consumers bewijzen dat ze zowel de oude als nieuwe versies tijdens een rollout kunnen parsen.

Migratietesten: apply en rollback in schone omgevingen

Test migraties zoals je ze ook uitrolt:

- Begin vanaf een schone database-snapshot.

- Pas alle migraties in volgorde toe.

- Verifieer dat de app kan lezen/schrijven.

- Draai een rollback (indien ondersteund) of een “down” migratie en bevestig dat het terugkeert naar een werkende staat.

Fixtures voor oude en nieuwe schema-versies

Houd een kleine set fixtures bij die representeren:

- Data geschreven onder het vorige schema (legacy rijen/events).

- Data geschreven onder het nieuwe schema.

Deze fixtures maken regressies duidelijk, vooral wanneer AI-gegenereerde code subtiel veldnamen, optionaliteit of formatting verandert.

Observability: breakage vroeg detecteren

Build with schema discipline

Build a React, Go, and PostgreSQL app in chat while keeping schemas and migrations explicit.

Schemawijzigingen falen zelden luid op het moment van deploy. Meestal zie je het als een langzame stijging in parsingfouten, “onbekende veld” waarschuwingen, ontbrekende data of achtergrondjobs die achterlopen. Goede observability zet die zwakke signalen om in actieerbare feedback terwijl je de rollout nog kunt pauzeren.

Wat te monitoren tijdens een rollout

Begin met de basis (app-gezondheid) en voeg schema-specifieke signalen toe:

- Fouten: pieken in 4xx/5xx, maar ook “soft” fouten zoals JSON-parsefouten, mislukte deserialisatie en retries.

- Latentie: p95/p99 responstijden en queue-verwerkingstijd. Schemawijzigingen kunnen extra joins, grotere payloads of extra validatie toevoegen.

- Data-kwaliteitsignalen: toename van null-rate in belangrijke kolommen, plotselinge daling in eventvolume, nieuwe default-waarden die te vaak voorkomen of mismatches tussen oude en nieuwe representaties.

- Pipeline-lag: consument-lag in streams/queues, webhook delivery backlog en migratiejob-throughput.

Belangrijk is om voor en na te vergelijken en te segmenteren op clientversie, schemaversie en verkeerssegment (canary vs. stable).

Dashboards die echt helpen

Maak twee dashboardviews:

-

Application behavior dashboard

- Request rate, error rate, latency (RED)

- Top exceptions (gegroepeerd op message)

- Validatie-/parsefoutenaantal en percentage

- Payloadgrootte-distributie (om onverwacht grote berichten te detecteren)

-

Migratie- en achtergrondjob-dashboard

- Migratiejob-progressie (% voltooid), rijen per sec, ETA

- Faalpercentage en retry-aantal

- Queue-diepte / consument-lag

- Dead-letter queue-volume (indien van toepassing)

Als je een expand/contract-rollout draait, voeg dan een paneel toe dat reads/writes opgesplitst naar oud vs. nieuw schema toont, zodat je kunt zien wanneer het veilig is naar de volgende fase te gaan.

Alerts voor schema-specifieke fouten

Page bij issues die erop wijzen dat data verloren gaat of verkeerd gelezen wordt:

- Schema-validatiefoutpercentage boven een lage drempel (vaak \u003c0.1% is al betekenisvol)

- Parsing/deserialisatie-fouten (vooral als ze geconcentreerd zijn bij één producer/consumer)

- Onverwacht veld / ontbrekend verplicht veld waarschuwingen die stijgen

- Migratiejob vastgelopen (geen progressie voor N minuten) of lag sneller groeiend dan throughput

Vermijd lawaaierige alerts op ruwe 500s zonder context; koppel alerts aan de schema-rollout met tags zoals schemaversie en endpoint.

Log de versie zodat je snel kunt debuggen

Tijdens de transitie, include en log:

- Schemaversie (bijv.

X-Schema-Versionheader, message metadata field) - Producer- en consumer-appversie

- Modelversie / promptversie wanneer AI-gegenereerde outputs gestructureerde data voeden

Die ene detail maakt “waarom faalde deze payload?” beantwoordbaar in minuten in plaats van dagen — vooral wanneer verschillende services (of verschillende AI-modelversies) tegelijk live zijn.

Rollback, herstel en change management

Schemawijzigingen falen op twee manieren: de wijziging zelf is fout, of het systeem eromheen gedraagt zich anders dan verwacht (vooral wanneer AI-gegenereerde code subtiele aannames introduceert). In beide gevallen heeft elke migratie een rollback-verhaal nodig voordat je het deployt — zelfs als dat verhaal expliciet “geen rollback” is.

Kiezen voor “geen rollback” kan valide zijn wanneer de wijziging onomkeerbaar is (bijv. kolommen droppen, identifiers herschrijven of destructieve deduplicatie). Maar “geen rollback” betekent niet afwezigheid van een plan; het is een beslissing die het plan verschuift naar forward fixes, restores en containment.

Praktische rollback-opties die echt werken

Feature flags / config gates: Wikkel nieuwe readers, writers en API-velden in een flag zodat je het nieuwe gedrag kunt uitzetten zonder te redeployen. Dit is vooral nuttig wanneer AI-gegenereerde code syntactisch juist maar semantisch onjuist kan zijn.

Disable dual-write: Als je tijdens een expand/contract-rollout naar oude en nieuwe schema's schrijft, houd dan een kill switch. Het uitschakelen van de nieuwe schrijfroute stopt verdere divergentie terwijl je het onderzoekt.

Revert readers (niet alleen writers): Veel incidenten gebeuren omdat consumers te vroeg nieuwe velden of tabellen gaan lezen. Maak het makkelijk om services terug te wijzen naar de vorige schema-versie of om nieuwe velden te negeren.

Ken de grenzen van omkeerbaarheid

Sommige migraties zijn niet netjes ongedaan te maken:

- Destructieve transformaties (bijv. hashing, lossy normalisatie).

- Drops/hernoemingen zonder bewaarde kopie.

- Backfills die de “source of truth” waarden overschrijven.

Voor deze gevallen plan je restore-from-backup, replay from events of recompute from raw inputs — en controleer dat je die inputs nog hebt.

Pre-flight checklist (voor de deploy)

- Rollback-beslissing gedocumenteerd (“revert”, “forward fix” of “no rollback + restore path”).

- Duidelijke stopknop: flags en/of dual-write disable switch.

- Backups/snapshots geverifieerd; restore minstens één keer getest.

- Migratie is idempotent; opnieuw uitvoeren corrumpeert data niet.

- Monitoring en alerts voor error rates, schema-validatiefouten en lag.

- Eigenaarschap: wie goedkeurt, wie runt, wie on-call is tijdens rollout.

Goed change management maakt rollbacks zeldzaam — en maakt herstel saai wanneer ze wél nodig zijn.

Als je team snel iterereert met AI-ondersteunde ontwikkeling, helpt het deze praktijken te combineren met tooling die veilig experimenteren ondersteunt. Bijvoorbeeld, Koder.ai bevat een planning mode voor ontwerp vóór wijzigingen en snapshots/rollback voor snelle recovery wanneer een gegenereerde wijziging per ongeluk een contract verschuift. Gebruikt samen laten snelle codegeneratie en gedisciplineerde schema-evolutie je sneller bewegen zonder productie als testomgeving te behandelen.