Wat dit verhaal uitlegt (en waarom het ertoe doet)

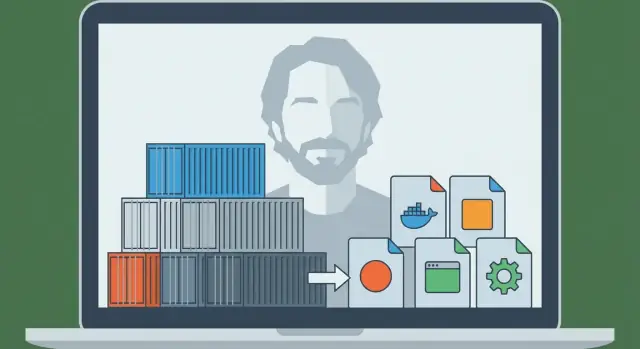

Solomon Hykes is de engineer die een lang bestaand idee—software isoleren zodat het overal hetzelfde draait—omzette in iets dat teams dagelijks konden gebruiken. In 2013 werd het project dat hij publiek maakte Docker, en dat veranderde snel hoe bedrijven applicaties uitrollen.

Destijds was de pijn simpel en herkenbaar: een app werkte op de laptop van een ontwikkelaar, gedroeg zich anders op de machine van een collega en brak opnieuw in staging of productie. Die “inconsistente omgevingen” waren niet alleen irritant—ze vertraagden releases, maakten bugs moeilijk reproduceerbaar en zorgden voor eindeloze overdrachten tussen development en operations.

Het probleem dat Docker oploste (in gewone taal)

Docker gaf teams een herhaalbare manier om een applicatie te verpakken met de afhankelijkheden die het verwacht—zodat de app op dezelfde manier kan draaien op een laptop, een testserver of in de cloud.

Daarom zeggen mensen dat containers de “standaard verpakkings- en deploy-eenheid” werden. Simpel gezegd:

- Verpakkings-eenheid: het ding dat je bouwt en opslaat (een containerimage)

- Deploy-eenheid: het ding dat je draait in een omgeving (een container)

In plaats van te deployen met “een zipbestand plus een wiki vol setup-stappen” zetten veel teams een image in die al bevat wat de app nodig heeft. Het resultaat: minder verrassingen en snellere, voorspelbaardere releases.

Wat je van dit verhaal krijgt

Dit artikel mixt geschiedenis met praktische concepten. Je leert wie Solomon Hykes is in deze context, wat Docker op het juiste moment introduceerde en de basismechanica—zonder diepgaande infrastructuurkennis te veronderstellen.

Je ziet ook waar containers vandaag passen: hoe ze aansluiten op CI/CD en DevOps-workflows, waarom orkestratietools zoals Kubernetes later belangrijk werden, en wat containers niet automatisch oplossen (vooral op het gebied van veiligheid en vertrouwen).

Aan het einde zou je duidelijk en met vertrouwen moeten kunnen uitleggen waarom “ship it as a container” een standaardaanname werd voor moderne applicatie-deployments.

Voor Docker: waarom apps uitrollen zo moeilijk was

Voordat containers mainstream werden, was het vaak lastiger om een applicatie van de laptop van een ontwikkelaar naar een server te krijgen dan om de app zelf te schrijven. Teams misten niet het talent—ze misten een betrouwbare manier om “het ding dat werkt” tussen omgevingen te verplaatsen.

“Works on my machine” was een echt probleem

Een ontwikkelaar kon de app perfect draaien op zijn computer en vervolgens zien dat het faalde in staging of productie. Niet omdat de code veranderde, maar omdat de omgeving dat deed. Verschillende OS-versies, ontbrekende libraries, net iets andere configbestanden of een database met andere defaults konden dezelfde build laten breken.

Conflicterende afhankelijkheden en eindeloze setup-docs

Veel projecten leunden op lange, fragiele setup-instructies:

- installeer deze runtime

- compileer dat systeempakket

- pin een specifieke libraryversie

- zet omgevingsvariabelen precies op de juiste plek

Zelfs zorgvuldig geschreven handleidingen verouderen snel. Eén collega die een dependency upgrade doet, kan per ongeluk de onboarding voor iedereen breken.

Erger nog: twee apps op dezelfde server kunnen incompatibele versies van dezelfde runtime of library nodig hebben, wat teams dwong tot omslachtige workarounds of aparte machines.

Verpakking en deployment waren gescheiden—en kwamen niet overeen

“Verpakken” betekende vaak een ZIP, tarball of installer maken. “Deployment” vroeg een andere set scripts en serverstappen: een machine provisionen, configureren, bestanden kopiëren, services herstarten en hopen dat niets anders op de server geraakt werd.

Die twee zorgen sloten zelden netjes op elkaar aan. Het pakket beschreef niet altijd de benodigde omgeving volledig, en het deploy-proces hing sterk af van de doelsystemen die “precies goed” voorbereid moesten zijn.

Het ontbrekende stuk: een draagbare eenheid

Wat teams nodig hadden was één draagbare eenheid die zijn afhankelijkheden meedraagt en consistent draait op laptops, testservers en productie. Die druk—herhaalbare setup, minder conflicten en voorspelbare deployment—legde de basis voor containers als standaard manier om applicaties te leveren.

Solomon Hykes en de geboorte van Docker (hoog niveau tijdlijn)

Docker begon niet als groot plan om “software voor altijd te veranderen.” Het groeide uit praktisch engineeringwerk dat Solomon Hykes leidde tijdens het bouwen van een platform-as-a-service product. Het team had een herhaalbare manier nodig om applicaties te verpakken en te draaien op verschillende machines zonder de gebruikelijke “werkt op mijn laptop” verrassingen.

Voordat Docker een bekende naam was, was de onderliggende behoefte helder: lever een app met zijn afhankelijkheden, draai het betrouwbaar en doe dat keer op keer voor veel klanten.

Het project dat Docker werd, ontstond als interne oplossing—iets dat deployments voorspelbaar maakte en omgevingen consistent. Toen het team inzag dat die verpakkings- en draamweergave breed nuttig was buiten hun eigen product, brachten ze het publiekelijk uit.

Die release deed ertoe omdat het een privé-deploy-techniek veranderde in een gedeelde toolchain die de industrie kon adopteren, verbeteren en standaardiseren.

“Docker” versus “containers”: niet hetzelfde

Het is makkelijk om die twee door elkaar te halen, maar ze zijn verschillend:

- Containers zijn het concept: geïsoleerde processen die OS-niveau features gebruiken (zoals namespaces en cgroups op Linux) om apps met hun afhankelijkheden te draaien.

- Docker (project en later bedrijf) bood de geproductiseerde ervaring die containers toegankelijk maakte voor alledaagse ontwikkelaars.

Containers bestonden al in verschillende vormen vóór Docker. Wat veranderde is dat Docker de workflow verpakte in een ontwikkelaarvriendelijke set commando’s en conventies—bouw een image, draai een container, deel hem met iemand anders.

Mijlpalen die het dagelijkse werk van ontwikkelaars veranderden

Enkele breed bekende stappen duwden Docker van “interessant” naar “standaard”:

- Een eenvoudige build-format (Dockerfile) maakte app-verpakking meer een recept dan fragiele setup-docs.

- Een standaard artefact (de image) liet teams omgevingen behandelen als versioneerbare deliverables.

- Gemakkelijk delen via registries maakte “pull en run” workflows mogelijk op laptops, CI-servers en productie.

- Ecosysteem en standaardisatie-inspanningen zorgden dat containerimages en runtimes minder aan één leverancier gebonden raakten en meer een gemeenschappelijke industrie-interface werden.

Het praktische resultaat: ontwikkelaars stopten met debatteren over hoe omgevingen te repliceren en begonnen dezelfde runnable eenheid overalheen te sturen.

Containers 101: wat ze zijn (en wat niet)

Containers zijn een manier om een applicatie te verpakken en draaien zodat deze hetzelfde werkt op je laptop, op die van een collega en in productie. De kern is isolatie zonder een volledig nieuwe computer.

Containers versus virtuele machines (eenvoudig mentaal model)

Een virtuele machine (VM) is als het huren van een heel appartement: je krijgt je eigen voordeur, je eigen nutsvoorzieningen en je eigen kopie van het besturingssysteem. Daarom kunnen VM's verschillende OS-types naast elkaar draaien, maar ze zijn zwaarder en starten meestal langzamer.

Een container is meer als het huren van een afgesloten kamer in een gedeeld gebouw: je brengt je meubels mee (app-code + libraries), maar de nutsvoorzieningen (de kernel van de host-OS) worden gedeeld. Je hebt scheiding van andere kamers, maar je start niet telkens een heel nieuw OS.

Hoe containers apps isoleren (conceptueel)

Op Linux vertrouwen containers op ingebouwde isolatiefuncties die:

- processen hun eigen “zicht” van het systeem geven (zodat app A niet de bestanden en processen van app B ziet)

- resources zoals CPU en geheugen beperken en toewijzen (zodat een luide app anderen niet gemakkelijk uithongert)

Je hoeft de kernel-details niet te kennen om containers te gebruiken, maar het helpt om te weten dat ze OS-features gebruiken—geen magie.

Waarom mensen er dol op zijn

Containers werden populair omdat ze:

- Lichtgewicht zijn: kleiner dan VM-images omdat ze geen volledig OS bundelen

- Snel starten: vaak seconden (of minder), wat goed is voor schalen en testen

- Consistent: hetzelfde verpakte runtime vermindert “werkt op mijn machine” problemen

Wat containers niet zijn

Containers vormen standaard geen volledige veiligheidsgrens. Omdat containers de kernel van de host delen, kan een kernel-zwakte meerdere containers beïnvloeden. Het betekent ook dat je geen Windows-container op een Linux-kernel (en vice versa) kunt draaien zonder extra virtualisatie.

Kortom: containers verbeteren verpakking en consistentie—maar je hebt nog steeds slimme beveiliging, patching en configuratiepraktijken nodig.

Het Docker-model: Dockerfile, Image, Container

Docker slaagde deels omdat het teams een eenvoudig mentaal model gaf met duidelijke “delen”: een Dockerfile (instructies), een image (het gemaakte artefact) en een container (de draaiende instantie). Als je die keten snappt, begint de rest van het Docker-ecosysteem logisch te worden.

Dockerfile: een herhaalbaar recept

Een Dockerfile is een platte-tekstbestand dat beschrijft hoe je je applicatieomgeving stap voor stap bouwt. Zie het als een kookrecept: het voedt niemand direct, maar vertelt precies hoe je elke keer hetzelfde gerecht maakt.

Typische Dockerfile-stappen omvatten: kiezen van een base (zoals een language runtime), je app-code kopiëren, afhankelijkheden installeren en het commando declareren dat moet draaien.

Image versus container: blauwdruk versus draaiende app

Een image is het gebouwde resultaat van een Dockerfile. Het is een verpakte snapshot van alles wat nodig is om te draaien: je code, afhankelijkheden en config-standaarden. Het is niet “levend”—meer een verzegelde doos die je kunt verzenden.

Een container krijg je als je een image draaien. Het is een live proces met een geïsoleerd bestandssysteem en instellingen. Je kunt het starten, stoppen, herstarten en meerdere containers van dezelfde image maken.

Layers en caching: waarom builds snel kunnen zijn

Images worden gebouwd in lagen. Elke instructie in een Dockerfile maakt meestal een nieuwe laag, en Docker probeert lagen te hergebruiken (cache) die niet veranderd zijn.

In eenvoudige termen: als je alleen je applicatiecode verandert, kan Docker vaak de lagen hergebruiken die het OS-pakketten en afhankelijkheden installeerden, waardoor rebuilds veel sneller zijn. Dit moedigt ook hergebruik tussen projecten aan—veel images delen gemeenschappelijke basislagen.

Een klein end-to-end flow

Dit is hoe het “recept → artefact → draaiende instantie” eruitziet:

FROM node:20-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

CMD ["node", "server.js"]

- Dockerfile: de instructies hierboven

- Build een image:

docker build -t myapp:1.0 .

- Run een container:

docker run --rm -p 3000:3000 myapp:1.0

Dit is de kernbelofte die Docker populair maakte: als je de image kunt bouwen, kun je hetzelfde betrouwbaar draaien—op je laptop, in CI of op een server—zonder steeds installatie-instructies opnieuw te schrijven.

Van laptop naar team: registries en het delen van images

Scale from free to business

Schakel van een snel prototype naar een teamklare setup met het plan dat bij je past.

Een container op je eigen laptop draaien is nuttig—maar dat was niet de doorbraak. De echte verschuiving kwam toen teams exact dezelfde build konden delen en overal draaien, zonder “werkt op mijn machine” discussies.

Docker maakte dat delen zo normaal als code delen.

Wat een registry is (in gewone taal)

Een container registry is een opslagplaats voor containerimages. Als een image de verpakte app is, is een registry de plek waar je verpakte versies bewaart zodat anderen of systemen ze kunnen ophalen.

Registries ondersteunen een eenvoudige workflow:

- Push: upload een image die je gebouwd hebt

- Pull: download een image die iemand anders gebouwd heeft

- Version: houd meerdere benoemde releases bij zodat je kunt terug- of voorwaarts keren

Publieke registries (zoals Docker Hub) maakten een eenvoudige start mogelijk. Maar de meeste teams wilden al snel een registry die aan hun toegangsregels en compliance-eisen voldeed.

Images worden meestal aangeduid als naam:tag—bijv. myapp:1.4.2. Die tag is meer dan een label: het is hoe mensen en automatisering overeenkomen welke build te draaien.

Een veelgemaakte fout is vertrouwen op latest. Het klinkt handig, maar het is dubbelzinnig: “latest” kan veranderen zonder waarschuwing, waardoor omgevingen kunnen verschuiven. Eén deploy kan een nieuwere build halen dan een vorige—zelfs als niemand een upgrade bedoelde.

Betere gewoonten:

- Gebruik expliciete versietags (bv.

1.4.2) voor releases

- Overweeg ook te taggen met een commit hash voor traceerbaarheid

- Behandel tags als onderdeel van je releaseproces, niet als bijzaak

Waarom private registries belangrijk zijn voor echte teams

Zodra je interne services, betaalde dependencies of bedrijfs-code deelt, wil je meestal een private registry. Die geeft je controle over wie kan pullen of pushen, integratie met single sign-on en houdt proprietaire software uit openbare indexen.

Dit is de sprong van “laptop naar team”: zodra images in een registry staan, kunnen je CI-systeem, collega’s en productie-servers allemaal dezelfde artifact pullen—en deployment wordt herhaalbaar, niet geïmproviseerd.

Waarom containers zo goed bij CI/CD passen

CI/CD werkt het best als het je applicatie als één herhaalbaar “ding” kan behandelen dat door fasen beweegt. Containers bieden precies dat: één verpakt artefact (de image) dat je één keer bouwt en vaak runt, met veel minder “werkt op mijn machine”-verrassingen.

Gestandaardiseerde lokale ontwikkeling

Voor containers probeerden teams vaak omgevingen gelijk te trekken met lange setup-docs en gedeelde scripts. Docker veranderde de standaardworkflow: repo pullen, image bouwen, app draaien. Dezelfde commando’s werken meestal op macOS, Windows en Linux omdat de applicatie in de container draait.

Die standaardisatie versnelt onboarding. Nieuwe collega’s besteden minder tijd aan dependencies installeren en meer tijd aan het product begrijpen.

“Build once, run everywhere” in de praktijk

Een goede CI/CD-opzet streeft naar één pipeline-output. Met containers is die output een image die getagd is met een versie (vaak gekoppeld aan een commit SHA). Die zelfde image wordt gepromoveerd van dev → test → staging → productie.

In plaats van de app voor elke omgeving anders te bouwen, verander je configuratie (zoals omgevingsvariabelen) terwijl het artefact identiek blijft. Dat vermindert drift en maakt releases makkelijker te debuggen.

Natuurlijke match voor CI-pijplijnen

Containers mappen netjes op pipeline-stappen:

- Build: maak de image vanuit een Dockerfile

- Test: draai unit/integratie-tests binnen de container

- Scan: controleer de image op bekende kwetsbaarheden en onveilige pakketten

- Deploy: push naar een registry, dan pull en run in de volgende omgeving

Omdat elke stap tegen dezelfde verpakte app draait, zijn fouten betekenisvoller: een test die in CI slaagt, gedraagt zich waarschijnlijk hetzelfde na deployment.

Als je je proces verfijnt, is het ook de moeite waard simpele regels vast te stellen (tagconventies, image signing, basis-scanning) zodat de pipeline voorspelbaar blijft. Je kunt van daaruit uitbreiden naarmate je team groeit (zie /blog/common-mistakes-and-how-to-avoid-them).

Waar dit aansluit op moderne AI-gestuurde workflows: platforms zoals Koder.ai kunnen volledige full-stack apps genereren en itereren (React voor web, Go + PostgreSQL voor backend, Flutter voor mobiel) via een chatinterface—maar je hebt nog steeds een betrouwbaar verpakkingsunit nodig om van “het draait” naar “het wordt uitgeleverd” te gaan. Iedere build als een versioned containerimage behandelen houdt ook AI-versnelde ontwikkeling in lijn met dezelfde CI/CD-verwachtingen: reproduceerbare builds, voorspelbare deploys en rollback-klaar releases.

Draaien op schaal: waarom Kubernetes in beeld kwam

Design your delivery flow upfront

Gebruik Planning Mode om services, omgevingen en releases uit te tekenen voordat je code genereert.

Docker maakte het praktisch om een app één keer te verpakken en overal te draaien. De volgende uitdaging kwam snel: teams draaiden niet één container op één laptop—ze draaiden er tientallen (en later honderden) over veel machines, met voortdurend wisselende versies.

Dan wordt “een container starten” niet meer het moeilijke deel. Het moeilijke deel wordt het beheren van een vloot: beslissen waar elke container draait, het juiste aantal exemplaren online houden en automatisch herstellen als er iets faalt.

Waarom orchestrators verschenen

Als je veel containers over veel servers hebt, heb je een systeem nodig dat ze coördineert. Dat is wat containerorkestrators doen: ze behandelen je infrastructuur als een pool resources en werken continu om applicaties in de gewenste staat te houden.

Kubernetes werd het meest gebruikte antwoord op die behoefte (maar het is niet de enige). Het biedt een gedeelde set concepten en API's waar veel teams en platforms zich op standaardiseren.

Docker versus orkestratie: verschillende taken

Het helpt om verantwoordelijkheden te scheiden:

- Docker (en vergelijkbare tools) richt zich op bouwen van containerimages en het draaien van containers op één machine.

- Kubernetes richt zich op runnen op schaal: over meerdere machines, verspreid over availability zones, met rolling updates.

De kernideeën die Kubernetes bracht

Kubernetes introduceerde (en populariseerde) praktische mogelijkheden die teams nodig hadden zodra containers verder gingen dan één host:

- Scheduling: containers plaatsen op geschikte machines op basis van beschikbare CPU/geheugen en constraints

- Scaling: het aantal draaiende kopieën verhogen of verlagen op basis van vraag

- Service discovery en load balancing: containers stabiele manieren geven om elkaar te vinden zelfs als IP's en instanties veranderen

- Self-healing: crashed containers herstarten, ongezonde instances vervangen en werk verplaatsen bij machine-falen

Kortom: Docker maakte de eenheid draagbaar; Kubernetes hielp die operabel te maken—voorspelbaar en continu—wanneer er veel eenheden tegelijk bewegen.

Hoe containers applicatie-architectuur veranderden

Containers veranderden niet alleen hoe we software deployen—ze duwden teams ook om software anders te ontwerpen.

“Microservices makkelijker te deployen” (zonder monolieten te verbieden)

Voor containers kostte het opsplitsen van een app in veel kleine services vaak extra operationele pijn: verschillende runtimes, conflicterende afhankelijkheden en ingewikkelde deploy-scripts. Containers verminderden die frictie. Als elke service als image wordt geleverd en op dezelfde manier draait, voelt het creëren van een nieuwe service minder riskant.

Toch werken containers ook goed voor monolieten. Een monoliet in een container kan eenvoudiger zijn dan een half-afgemaakte microservices-migratie: één deploybaar onderdeel, één set logs, één schaalhendel. Containers dwingen geen stijl af—ze maken meerdere stijlen beheersbaarder.

Gestandaardiseerde interfaces werden de norm

Containerplatforms moedigden apps aan zich te gedragen als goed-gedisciplineerde “black boxes” met voorspelbare inputs en outputs. Veelvoorkomende conventies zijn:

- Poorten: de app luistert op een bekende poort en het platform routeert verkeer

- Omgevingsvariabelen: configuratie wordt tijdens runtime geïnjecteerd, niet in de code gebakken

- Volumes: persistente data wordt gemount, waardoor de container zelf makkelijker te vervangen is

Deze interfaces maakten het eenvoudiger om versies te wisselen, terug te rollen en dezelfde app op laptop, CI en productie te draaien.

Nieuwe patronen (en verleidingen)

Containers populariseerden herhaalbare bouwstenen zoals sidecars (hulpcontainer naast de hoofdapp voor logging, proxies of certificaten). Ze versterkten ook de richtlijn van één proces per container—geen strikte regel, maar een nuttige default voor duidelijkheid, schaling en troubleshooting.

De belangrijkste valkuil is over-splitsen. Alleen omdat je alles in services kunt opdelen, betekent dat niet dat je het moet doen. Als een microservice meer coördinatie, latency en deploy-overhead toevoegt dan het wegneemt, houd het samen totdat er een duidelijke scheidingslijn is—zoals andere schaalbehoeften, eigenaarschap of foutisolatie.

Veiligheid en vertrouwen: wat containers niet automatisch oplossen

Containers maken software makkelijker te leveren, maar ze maken het niet automatisch veiliger. Een container is nog steeds code plus afhankelijkheden en kan verkeerd geconfigureerd, verouderd of zelfs kwaadaardig zijn—vooral als images van internet worden gehaald zonder controle.

Vertrouwen begint bij image-provenance

Als je niet kunt beantwoorden “Waar komt deze image vandaan?” loop je al risico. Teams bewegen naar een duidelijke keten van bewaring: images in gecontroleerde CI bouwen, tekenen of attesten wat is gebouwd, en bijhouden wat er in de image zit (afhankelijkheden, base image-versie, buildstappen).

Daar helpen SBOMs (Software Bills of Materials) bij: ze maken de inhoud van je container zichtbaar en auditbaar.

Scannen is de volgende praktische stap. Scan images regelmatig op bekende kwetsbaarheden, maar behandel resultaten als input voor beslissingen—niet als een garantie voor veiligheid.

Least privilege en secrets: veelvoorkomende valkuilen

Een veelgemaakte fout is containers draaien met te brede permissies—root als default, extra Linux-capabilities, host networking of privileged mode “omdat het werkt.” Elk van deze vergroot de blast radius als er iets misgaat.

Secrets vormen een andere valkuil. Omgevingsvariabelen, ingebakken configbestanden of gecommitte .env-bestanden kunnen credentials lekken. Gebruik bij voorkeur een secret store of orchestrator-managed secrets en roteer ze alsof blootstelling onvermijdelijk is.

Runtime-risico’s die men over het hoofd ziet

Zelfs “schone” images kunnen gevaarlijk zijn tijdens runtime. Let op blootgestelde Docker-sockets, te permissieve volume-mounts en containers die toegang hebben tot interne services die ze niet nodig hebben.

Onthoud ook: het patchen van je host en kernel blijft belangrijk—containers delen de kernel.

Een eenvoudige checklist-mentaliteit

Denk in vier fasen:

- Build: gecontroleerde builds, SBOMs, scan, minimaliseer base images

- Store: private registries, toegangscontrole, immutability-beleid

- Run: least privilege, netwerkbeperkingen, resource limits, geen secrets-sprawl

- Monitor: logs, alerts, anomaliedetectie, snel rebuild-en-redeploy

Containers verlagen frictie—maar vertrouwen moet nog steeds verdiend, geverifieerd en continu onderhouden worden.

Veelvoorkomende fouten en hoe ze te vermijden

Go from spec to Flutter

Prototypeer een Flutter-mobiele app vanuit een simpel spec en exporteer de broncode.

Docker maakt verpakking voorspelbaar, maar alleen als je het met enige discipline gebruikt. Veel teams rijden in dezelfde kuilen—en geven daarna “containers” de schuld terwijl het eigenlijk workflowproblemen zijn.

Anti-patronen die iedereen vertragen

Een klassieke fout is reusachtige images bouwen: volledige OS-base images gebruiken, build-tools installeren die je niet nodig hebt tijdens runtime, en de hele repo kopiëren (inclusief tests, docs en node_modules). Het resultaat is trage downloads, trage CI en meer aanvalsoppervlak voor beveiligingsproblemen.

Een andere veelvoorkomende fout is langzame, cache-brekende builds. Als je de hele source kopieert voordat je afhankelijkheden installeert, dwingt elke kleine code-wijziging een volledige dependency-herinstallatie af.

Tot slot gebruiken teams vaak vage of zwevende tags zoals latest of prod. Dat maakt rollbacks pijnlijk en verandert deployments in giswerk.

“Het werkt lokaal maar niet in prod”: de echte oorzaken

Dit komt meestal door verschillen in configuratie (missende env vars of secrets), networking (andere hostnames, poorten, proxies, DNS) of opslag (data naar het containerbestandssysteem schrijven in plaats van een volume, of bestandspermissies die tussen omgevingen verschillen).

Praktische fixes die je vandaag kunt toepassen

Gebruik slim base images wanneer mogelijk (of distroless als je team er klaar voor is). Pin versies voor base images en belangrijke dependencies zodat builds herhaalbaar zijn.

Adopteer multi-stage builds om compilers en build-tools uit de uiteindelijke image te houden:

FROM node:20 AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

FROM node:20-slim

WORKDIR /app

COPY --from=build /app/dist ./dist

CMD ["node","dist/server.js"]

Tag images met iets traceerbaars, zoals een git SHA (en optioneel een gebruiksvriendelijke releasetag).

Wanneer niet te containerizen

Als een app echt simpel is (énige statische binary, zelden draaien, geen schaalbehoefte), kunnen containers extra overhead toevoegen. Legacy-systemen met strakke OS-koppelingen of gespecialiseerde hardwaredrivers kunnen ook minder geschikt zijn—soms is een VM of een managed service de schonere keuze.

Wat “standaard-eenheid” vandaag betekent—en wat je nu kunt doen

Containers werden de standaard-eenheid omdat ze een heel specifiek, herhaalbaar probleem oplosten: hetzelfde app op dezelfde manier laten draaien op laptops, testservers en productie. Het samen verpakken van de app en zijn afhankelijkheden maakte deployments sneller, rollbacks veiliger en overdrachten tussen teams minder fragiel.

Even belangrijk: containers standaardiseerden de workflow: build once, ship, run.

Wat “standaard” in de praktijk betekent

“Standaard” betekent niet dat alles overal in Docker draait. Het betekent dat de meeste moderne delivery-pijplijnen een containerimage als primair artefact behandelen—meer dan een zip-bestand, VM-snapshot of set handmatige setup-stappen.

Dat standaard omvat meestal drie onderdelen die samenwerken:

- Images: onveranderlijke build-outputs getagd met versies (en idealiter een commit SHA).

- Registries: een gedeelde plek om images op te slaan en op te halen (privé of publiek), zodat teams hetzelfde artefact kunnen gebruiken.

- Orchestration: een scheduler (vaak Kubernetes) die containers betrouwbaar runt, mislukkingen vervangt en schaalt.

Volgende stappen die je deze week kunt nemen

Begin klein en focus op herhaalbaarheid.

- Leer Dockerfile basics: houd images minimaal, pin base image-versies en structureer lagen zodat rebuilds snel zijn. Voeg vroeg een

.dockerignore toe.

- Gebruik een registry doelbewust: publiceer images met betekenisvolle tags (bijv.

1.4.2, main, sha-…) en bepaal wie mag pushen versus pullen.

- Implementeer CI buildregels: bouw images in CI, draai tests in de containercontext en promoot dezelfde image door staging naar productie (niet per omgeving opnieuw bouwen).

Als je experimenteert met snellere manieren om software te bouwen (inclusief AI-ondersteunde methoden), blijf dezelfde discipline toepassen: versies van de image, bewaar in een registry en laat deployments dat ene artefact promoten. Daarom profiteren teams die Koder.ai gebruiken ook van container-first delivery—snelle iteratie is geweldig, maar reproduceerbaarheid en rollback-mogelijkheid maken het veilig.

Houd een gebalanceerde blik

Containers verminderen “works on my machine”-problemen, maar ze vervangen geen goede operationele gewoonten. Je hebt nog steeds monitoring, incident response, secrets management, patching, toegangscontrole en duidelijke eigenaarschap nodig.

Behandel containers als een krachtig verpakkingsstandaard—niet als een shortcut om engineeringdiscipline te vermijden.