12 nov 2025·8 min

Van non-profit lab naar AI‑leider: de geschiedenis van OpenAI

Ontdek de geschiedenis van OpenAI — van non-profit oorsprong en belangrijke onderzoeksdoorbraken tot de lancering van ChatGPT, GPT-4 en de veranderende missie.

Ontdek de geschiedenis van OpenAI — van non-profit oorsprong en belangrijke onderzoeksdoorbraken tot de lancering van ChatGPT, GPT-4 en de veranderende missie.

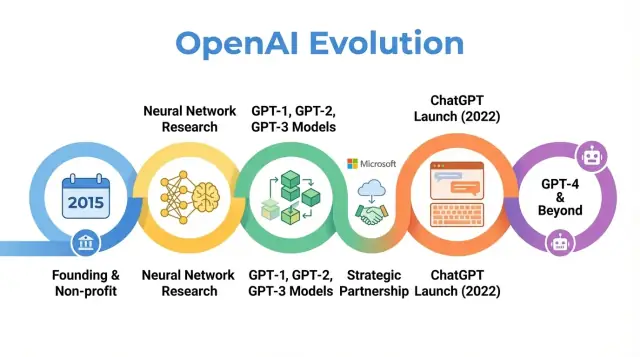

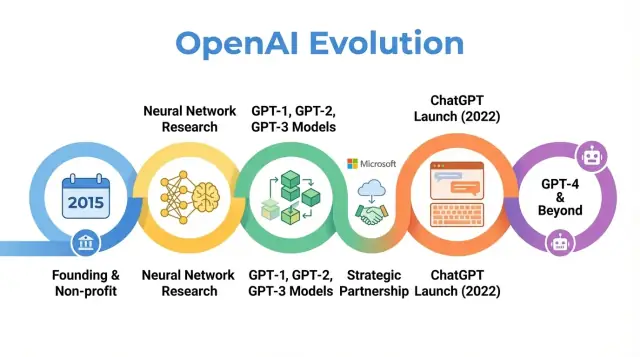

OpenAI is een onderzoeks‑ en implementatiebedrijf voor AI wiens werk heeft meegewerkt aan de manier waarop mensen over kunstmatige intelligentie denken, van vroege wetenschappelijke artikelen tot producten zoals ChatGPT. Begrijpen hoe OpenAI zich ontwikkelde — van een kleine non-profit lab in 2015 naar een centrale speler in AI — helpt verklaren waarom moderne AI er vandaag zo uitziet.

Het verhaal van OpenAI is niet alleen een reeks modelreleases. Het is een case study in hoe missie, prikkels, technische doorbraken en publieke druk op elkaar inwerken. De organisatie begon met sterke nadruk op open onderzoek en breed voordeel, herstructureerde zichzelf om kapitaal aan te trekken, vormde een diepe samenwerking met Microsoft en lanceerde producten die door honderden miljoenen mensen worden gebruikt.

Het volgen van OpenAI’s geschiedenis verduidelijkt een aantal bredere trends in AI:

Missie en waarden: OpenAI werd opgericht met het expliciete doel dat artificial general intelligence (AGI), als die ontstaat, ten goede moet komen aan de mensheid. De manier waarop die missie is geïnterpreteerd en aangepast laat de spanning zien tussen idealistische doelen en commerciële realiteit.

Onderzoeksdoorbraken: De ontwikkeling van vroege projecten naar systemen zoals GPT-3, GPT-4, DALL·E en Codex volgt een bredere verschuiving richting grootschalige foundation‑modellen die veel huidige AI‑toepassingen aandrijven.

Bestuur en structuur: De stap van pure non-profit naar een capped‑profit entiteit en de creatie van complexe governance‑mechanismen illustreren hoe nieuwe organisatorische vormen worden geprobeerd om krachtige technologieën te beheersen.

Publieke impact en toezicht: Met ChatGPT en andere releases ging OpenAI van een onderzoeksinstituut binnen AI‑kringen naar een naam die bij het brede publiek bekend is, wat aandacht bracht voor veiligheid, alignment en reguleringsdebatten.

Dit artikel volgt OpenAI’s reis vanaf 2015 tot de meest recente ontwikkelingen en toont hoe elke fase bredere verschuivingen in AI‑onderzoek, economie en bestuur weerspiegelt — en wat dat zou kunnen betekenen voor de toekomst van het veld.

OpenAI werd opgericht in december 2015, op een moment dat machine learning — en met name deep learning — snel verbeterde maar nog ver verwijderd was van algemene intelligentie. Beeldherkenningsbenchmarks daalden, spraaksystemen werden beter en bedrijven als Google, Facebook en Baidu investeerden fors in AI.

Onder onderzoekers en tech‑leiders groeide de zorg dat geavanceerde AI uiteindelijk gecontroleerd zou kunnen worden door een handvol machtige bedrijven of overheden. OpenAI werd bedacht als tegenwicht: een onderzoeksorganisatie gericht op lange‑termijn veiligheid en brede distributie van AI‑voordelen, in plaats van op smalle commerciële winst.

Vanaf dag één definieerde OpenAI zijn missie rond artificial general intelligence, niet slechts incrementele vooruitgang in machine learning. De kernstelling was dat OpenAI zou werken om te garanderen dat AGI, als het wordt gecreëerd, “ten goede komt aan de gehele mensheid.”

Die missie had concrete implicaties:

Vroege blogposts en het oprichtingscharter benadrukten zowel openheid als voorzichtigheid: OpenAI zou veel van zijn werk publiceren, maar ook rekening houden met de maatschappelijke impact van het vrijgeven van krachtige mogelijkheden.

OpenAI begon als een non-profit onderzoekslab. De initiële financieringsvermeldingen lagen rond $1 miljard aan toezeggingen, hoewel dit een langjarige toezegging was en niet directe cash. Belangrijke vroege financiers waren Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston en YC Research, plus steun van bedrijven zoals Amazon Web Services en Infosys.

Het vroege leiderschap combineerde startup‑, onderzoeks‑ en operationele ervaring:

Deze mix van Silicon Valley‑ondernemerschap en topklasse AI‑onderzoek bepaalde de vroege cultuur: zeer ambitieus om de grenzen van AI te verleggen, maar georganiseerd als een missiegedreven non‑profit gericht op lange‑termijn wereldwijde impact in plaats van snelle commercialisatie.

Toen OpenAI in 2015 als non-profit lab begon, was de publieke belofte simpel maar ambitieus: AI vooruit helpen terwijl je zoveel mogelijk deelt met de bredere gemeenschap.

De vroege jaren werden bepaald door een “open by default” filosofie. Onderzoeksartikelen werden snel gepubliceerd, code werd meestal vrijgegeven en interne tools werden publieke projecten. Het idee was dat het versnellen van breed wetenschappelijk vooruitgang — en publieke toetsing — veiliger en nuttiger zou zijn dan het concentreren van mogelijkheden binnen één bedrijf.

Tegelijkertijd maakte veiligheid al deel uit van het gesprek. Het team besprak wanneer openheid misbruikrisico’s zou vergroten en begon ideeën te schetsen voor gefaseerde uitgave en beleidsreviews, al waren die ideeën toen nog minder formeel dan latere governanceprocessen.

OpenAI’s vroege wetenschappelijke focus omvatte meerdere kerngebieden:

Deze projecten draaiden minder om gepolijste producten en meer om het testen van wat mogelijk was met deep learning, rekenkracht en slimme trainingsregimes.

Twee van de meest invloedrijke uitkomsten uit deze periode waren OpenAI Gym en Universe.

Beide projecten weerspiegelden de inzet voor gedeelde infrastructuur in plaats van propriëtair voordeel.

In deze non‑profitperiode werd OpenAI vaak neergezet als een missiegedreven tegenwicht voor de AI‑labs van grote techbedrijven. Collega’s waardeerden de kwaliteit van het onderzoek, de beschikbaarheid van code en omgevingen, en de bereidheid om over veiligheid te debatteren.

De media benadrukten de ongewone combinatie van hoogprofiel financiers, een niet‑commerciële structuur en de belofte om open te publiceren. Die reputatie — als invloedrijk, open onderzoeksinstituut met aandacht voor lange‑termijngevolgen — zou later reacties op elke strategische verschuiving kleuren.

Het keerpunt in OpenAI’s geschiedenis was de keuze om zich te concentreren op grote, transformer‑gebaseerde taalmodellen. Die verschuiving transformeerde OpenAI van een voornamelijk onderzoeksgefocust non‑profit naar een organisatie bekend om foundation‑modellen waar anderen op bouwen.

GPT‑1 was bescheiden vergeleken met latere modellen — 117 miljoen parameters, getraind op BookCorpus — maar het bood een cruciaal proof of concept.

In plaats van aparte modellen voor elke NLP‑taak te trainen, toonde GPT‑1 dat één transformer‑model, getraind met een simpel doel (voorspel het volgende woord), met minimale fine‑tuning aangepast kon worden voor taken zoals vraag‑antwoord, sentimentanalyse en tekstuele entailment.

Voor OpenAI’s roadmap bevestigde GPT‑1 drie ideeën:

GPT‑2 zette hetzelfde recept veel verder: 1,5 miljard parameters en een veel grotere dataset van webmateriaal. De output was vaak opvallend coherent: meerparagraaf‑artikelen, fictieve verhalen en samenvattingen die op het eerste gezicht menselijk leken.

Die capaciteiten wekten zorgen over mogelijk misbruik: geautomatiseerde propaganda, spam, intimidatie en fake news op schaal. In plaats van het volledige model meteen vrij te geven, koos OpenAI voor een gefaseerde uitgave:

Dit was één van de eerste publieke voorbeelden waarin OpenAI expliciet inzet op deployment‑beslissingen gekoppeld aan veiligheid en maatschappelijke impact.

GPT‑3 schaalde weer op — ditmaal naar 175 miljard parameters. In plaats van voornamelijk op fine‑tuning te vertrouwen, liet GPT‑3 “few‑shot” en zelfs “zero‑shot” leren zien: het model kon vaak een nieuwe taak uitvoeren op basis van instructies en een paar voorbeelden in de prompt.

Die mate van generaliteit veranderde hoe OpenAI en de bredere industrie over AI‑systemen dachten. In plaats van veel smalle modellen, kon één groot model fungeren als een algemene motor voor:

Cruciaal was dat OpenAI ervoor koos GPT‑3 niet open‑source te maken. Toegang kwam via een commerciële API. Deze beslissing markeerde een strategische twist:

GPT‑1, GPT‑2 en GPT‑3 laten een duidelijke lijn zien: transformers opschalen, emergente capaciteiten ontdekken, worstelen met veiligheid en misbruik, en het commerciële fundament leggen voor producten zoals ChatGPT en de verdere ontwikkeling richting GPT‑4.

Tegen 2018 waren OpenAI‑leiders ervan overtuigd dat blijven als een klein, door donaties gefinancierd laboratorium niet genoeg zou zijn om zeer grote AI‑systemen te bouwen en veilig te sturen. Het trainen van grensmodellen vereiste al tientallen miljoenen dollars aan compute en talent, met kosten die veel hoger zouden worden. Om talent te concurreren, schaalexperimenten te voeren en langdurige toegang tot cloudinfrastructuur te verzekeren, had OpenAI een structuur nodig die grote externe investeringen kon aantrekken zonder de oorspronkelijke missie los te laten.

In 2019 startte OpenAI OpenAI LP, een nieuwe "capped‑profit" limited partnership. Het doel was grote externe investeringen mogelijk te maken terwijl de non‑profitmissie — dat AGI de hele mensheid ten goede moet komen — bovenaan de besluitvormingshiërarchie bleef.

Traditionele venture‑startups zijn uiteindelijk verantwoordelijk aan aandeelhouders die onbeperkte rendementen nastreven. De oprichters vreesden dat dit sterke druk zou leggen op winst boven veiligheid, openheid of zorgvuldige uitrol. De LP‑structuur was een compromis: ze kon belangen uitgeven die op equity leken en zo kapitaal aantrekken, maar onder andere regels dan een standaard startup.

In het capped‑profit model kunnen investeerders en werknemers rendementen verdienen op hun belangen, maar slechts tot een vaste veelvoud van hun oorspronkelijke investering (voor vroege investeerders vaak genoemd tot circa 100x, met lagere caps in latere ronden). Zodra die limiet is bereikt, is extra waarde bedoeld om naar de non‑profit ouder te vloeien om in lijn met de missie te worden ingezet.

Dit contrasteert met typische startups, waar equity theoretisch onbeperkt in waarde kan stijgen en maximale aandeelhouderswaarde de wettelijke en culturele norm is.

OpenAI Nonprofit blijft de controlerende entiteit. De raad ziet toe op OpenAI LP en is gecharterd om de belangen van de mensheid boven die van een bepaalde investeerdersgroep of werknemers te stellen.

Formeel:

Dit governance‑ontwerp is bedoeld om OpenAI de financierings‑ en personeelsflexibiliteit van een commercieel bedrijf te geven, terwijl de missie formeel wordt verankerd.

De herstructurering leidde tot debat binnen en buiten de organisatie. Voorstanders stelden dat het de enige praktische manier was om de miljarden te verkrijgen die nodig zijn voor state‑of‑the‑art AI‑onderzoek, terwijl toch winstprikkels werden beperkt. Critici vroegen zich af of welke structuur dan ook die grote rendementen mogelijk maakt werkelijk commerciële druk kan weerstaan en of de caps voldoende of afdwingbaar waren.

In de praktijk opende OpenAI LP de deur naar grote strategische investeringen, met name van Microsoft, en stelde het het bedrijf in staat concurrerende compensatie te bieden gekoppeld aan potentieel rendement. Dat maakte het mogelijk om onderzoeksteams uit te breiden, trainingsruns voor modellen zoals GPT‑3 en GPT‑4 op te voeren en de infrastructuur te bouwen om systemen zoals ChatGPT wereldwijd te deployen — terwijl formele governance terugleidde naar de non‑profit oorsprong.

In 2019 kondigden OpenAI en Microsoft een meerjarige samenwerking aan die de rollen van beide bedrijven in AI veranderde. Microsoft investeerde naar verluidt $1 miljard, gecombineerd uit cash en Azure‑cloudkredieten, in ruil voor de status van voorkeurscommerciële partner.

De deal sloot aan bij OpenAI’s behoefte aan enorme compute‑resources om steeds grotere modellen te trainen, terwijl Microsoft toegang kreeg tot geavanceerde AI die zijn producten en cloudplatform kon onderscheiden. In de jaren daarna verdiepten extra financieringen en technische samenwerking de relatie.

OpenAI koos Microsoft Azure als primair cloudplatform om meerdere redenen:

Dit maakte Azure de standaardomgeving voor het trainen en serveren van modellen zoals GPT‑3, Codex en later GPT‑4.

De samenwerking leidde tot één van de grootste AI‑supercomputers ter wereld, gebouwd op Azure voor OpenAI’s workloads. Microsoft profileerde deze clusters als vlaggenschipvoorbeelden van Azure’s AI‑mogelijkheden, terwijl OpenAI erop vertrouwde om modelgrootte, trainingsdata en experimentatiesnelheid te vergroten.

Deze gezamenlijke infrastructuuraanpak vervaagde de grens tussen “klant” en “partner”: OpenAI beïnvloedde Azure’s roadmap en Azure werd specifiek afgestemd op OpenAI’s behoeften.

Microsoft kreeg exclusieve licentierechten op sommige OpenAI‑technologieën, met name GPT‑3. Dat stelde Microsoft in staat om OpenAI‑modellen in te bouwen in producten — Bing, Office, GitHub Copilot en Azure OpenAI Service — terwijl andere bedrijven toegang kregen via OpenAI’s eigen API.

Deze exclusiviteit wekte discussie op: voorstanders zeiden dat het de financiering en distributie leverde die nodig was om krachtige AI veilig op te schalen; critici waarschuwden dat het invloed over frontier‑modellen concentreerde bij één grote techspeler.

Tegelijkertijd gaf het partnerschap OpenAI mainstreamzichtbaarheid. Microsofts branding, productintegraties en enterprise‑kanalen hielpen OpenAI‑systemen van onderzoeksdemo’s naar alledaagse tools te brengen, waardoor het publieke beeld van OpenAI dubbelzinnig werd — zowel onafhankelijk onderzoeksinstituut als belangrijke Microsoft‑partner.

Naarmate OpenAI’s modellen beter werden in taal, zette het team stappen in nieuwe modaliteiten: beelden en code. Deze uitbreiding bracht OpenAI’s werk van schrijven en dialoog naar visuele creativiteit en softwareontwikkeling.

CLIP (Contrastive Language–Image Pretraining), aangekondigd begin 2021, was een belangrijke stap naar modellen die de wereld beter begrijpen zoals mensen dat doen.

In plaats van alleen op gelabelde afbeeldingen te trainen, leerde CLIP van honderden miljoenen image–caption‑paren van het openbare web. Het werd getraind om afbeeldingen te koppelen aan de meest waarschijnlijke tekstbeschrijvingen en ze te onderscheiden van onjuiste beschrijvingen.

Dit gaf CLIP verrassend algemene vermogens:

CLIP werd een basis voor later generatie‑werk met beelden bij OpenAI.

DALL·E (2021) paste GPT‑achtige architecturen toe op afbeeldingen en genereerde beelden direct uit tekstprompts: “een fauteuil in de vorm van een avocado” of “een winkelbord met het woord ‘openai’”. Het liet zien dat taalmodellen uitgebreid konden worden om samenhangende, vaak speelse beeldoutput te produceren.

DALL·E 2 (2022) verbeterde resolutie, realisme en controleerbaarheid aanzienlijk. Het introduceerde functies zoals:

Deze systemen veranderden hoe ontwerpers, marketeers, kunstenaars en hobbyisten ideeën prototypen, waarbij creatief werk deels verschoof van handmatig schetsen naar iteratief promptgestuurd verkennen.

Codex (2021) nam het GPT‑3‑familieprincipe en paste het toe op broncode, getraind op grote publieke codebases. Het kan natuurlijke taal vertalen naar werkende codefragmenten voor talen zoals Python, JavaScript en vele anderen.

GitHub Copilot, gebouwd op Codex, bracht dit naar dagelijkse ontwikkeltools. Programmeurs kregen hele functies, tests en boilerplate als suggesties en gebruikten natuurlijke‑taalcommentaar als gids.

Voor softwareontwikkeling suggereerde Codex een geleidelijke verschuiving:

Samen toonden CLIP, DALL·E en Codex aan dat OpenAI’s aanpak verder reikt dan tekst en impact heeft op kunst, design en engineering.

OpenAI lanceerde ChatGPT als gratis "research preview" op 30 november 2022 met een korte blogpost en tweet in plaats van een groot productcampagne. Het model was gebaseerd op GPT‑3.5 en geoptimaliseerd voor dialoog, met regels om schadelijke of onveilige verzoeken te weigeren.

Het gebruik nam bijna direct enorm toe. Binnen enkele dagen meldden miljoenen mensen zich aan en ChatGPT werd een van de snelst groeiende consumententoepassingen ooit. Gespreksscreenshots overspoelden sociale media terwijl gebruikers testten of het essays kon schrijven, code debuggen, e‑mails opstellen en complexe onderwerpen in eenvoudige taal uitleggen.

De aantrekkingskracht van ChatGPT lag in zijn veelzijdigheid, niet in één enkel gebruiksgeval.

Op school gebruikten studenten het om samenvattingen te maken, oefenvragen te genereren, artikelen te vertalen of te vereenvoudigen en stapsgewijze uitleg te krijgen bij wiskunde of natuurkunde. Docenten experimenteerden ermee om syllabi te ontwerpen, rubrics te schrijven en differentiërenede lesmaterialen te maken, terwijl scholen discussieerden over toelating en beperkingen.

Op het werk vroegen professionals ChatGPT om e‑mails, marketingteksten en rapporten te schetsen, presentatiestructuren uit te werken, codefragmenten en testcases te genereren en het te gebruiken als brainstormpartner voor productideeën en strategieën. Freelancers en kleine bedrijven leunden er vooral op als goedkope assistent voor content en analyse.

Voor alledaagse problemen gebruikten mensen ChatGPT voor reisplannen, kookideeën op basis van wat in de koelkast lag, basale juridische en medische uitleg (met waarschuwingen om professioneel advies te zoeken) en hulp bij het leren van nieuwe vaardigheden of talen.

Het eerste research‑preview was gratis om frictie te verlagen en feedback te verzamelen over fouten, misbruik en ontbrekende mogelijkheden. Naarmate het gebruik groeide, zag OpenAI zowel hoge infrastructuurkosten als vraag naar betrouwbaardere toegang.

In februari 2023 introduceerde OpenAI ChatGPT Plus, een abonnementsplan met snellere reacties, prioriteit tijdens piekbelasting en vroege toegang tot nieuwe functies en modellen zoals GPT‑4. Dit creëerde een terugkerende inkomstenstroom terwijl er een gratis laag bleef voor brede toegang.

In de loop der tijd voegde OpenAI meer zakelijke opties toe: API‑toegang tot dezelfde conversatiemodellen, integratietools voor workflows en aanbiedingen zoals ChatGPT Enterprise en teamplannen gericht op organisaties die hogere veiligheid, beheerderscontrole en compliance nodig hebben.

De plotselinge zichtbaarheid van ChatGPT verscherpte langlopende debatten over AI.

Toezichthouders en beleidsmakers maakten zich zorgen over privacy, gegevensbescherming en naleving van wetgeving, vooral in regio’s als de Europese Unie. Sommige autoriteiten beperkten of onderzochten ChatGPT tijdelijk terwijl zij nagingen of dataverzameling en ‑verwerking aan regelgeving voldeden.

Onderwijzers werden geconfronteerd met plagiaat en academische integriteitsproblemen omdat studenten essays en huiswerkantwoorden konden genereren die moeilijk te detecteren waren. Dat leidde tot verboden of strenge regels in sommige scholen, terwijl andere instellingen overgingen naar opdrachten die proces en mondelinge toetsen benadrukten.

Ethici en onderzoekers waarschuwden voor desinformatie, overmatige afhankelijkheid van AI voor kritieke beslissingen, bias in antwoorden en mogelijke effecten op creatief en kenniswerk. Er rezen ook vragen over trainingsdata, auteursrecht en de rechten van kunstenaars en schrijvers wiens werk het model mogelijk heeft beïnvloed.

Voor OpenAI markeerde ChatGPT een kantelpunt: de organisatie veranderde van een grotendeels onderzoeksgericht lab naar een bedrijf centraal in wereldwijde discussies over hoe krachtige taalmodellen zouden moeten worden uitgerold, bestuurd en geïntegreerd in het dagelijks leven.

OpenAI bracht GPT‑4 uit in maart 2023 als een belangrijke stap voorbij GPT‑3.5, het model dat aanvankelijk ChatGPT aandreef. GPT‑4 verbeterde redeneren, het volgen van complexe instructies en het behouden van coherentie over langere gesprekken. Het werd ook veel beter in het verwerken van genuanceerde prompts, zoals het uitleggen van juridische clausules, het samenvatten van technische papers of het schrijven van code op basis van vage vereisten.

In vergelijking met GPT‑3.5 verminderde GPT‑4 veelvoorkomende foutmodi: het verzon minder vaak bronnen bij het vragen om citaties, ging beter om met randgevallen in wiskunde en logica en produceerde consistenter output over herhaalde vragen.

GPT‑4 introduceerde multimodale mogelijkheden: naast tekst kan het in bepaalde configuraties ook afbeeldingen als input accepteren. Dat maakt scenario’s mogelijk zoals het beschrijven van grafieken, het lezen van handgeschreven aantekeningen, het interpreteren van UI‑screenshots of het analyseren van foto’s om gestructureerde informatie te extraheren.

Op gestandaardiseerde benchmarks presteerde GPT‑4 significant beter dan eerdere modellen. Het behaalde bijna toppercentielen op gesimuleerde professionele examens zoals de bar exam, SAT en verschillende advanced placement‑testen. Het verbeterde ook op codeer‑ en redeneerbenchmarks, wat wijst op sterkere taalbegrip- en probleemoplossende vaardigheden.

GPT‑4 werd snel de kern van OpenAI’s API en dreef een nieuwe golf van derde‑partijproducten aan: AI‑copilots in productiviteitspakketten, codeerassistenten, klantenservice‑tools, onderwijsplatforms en verticale toepassingen in recht, financiën en gezondheidszorg.

Ondanks deze verbeteringen blijft GPT‑4 hallucineren, kan het via prompting onveilige of bevooroordeelde output genereren en mist het echte begrip of up‑to‑date feitelijke kennis. OpenAI zette zwaar in op alignmentonderzoek voor GPT‑4 — met technieken zoals reinforcement learning from human feedback, red‑teaming en systeemniveau veiligheidsregels — maar benadrukt dat zorgvuldige uitrol, monitoring en voortdurende research nodig blijven om risico’s te beheersen.

Vanaf de vroege jaren stelde OpenAI veiligheid en alignment als kern van zijn missie, niet als een bijzaak bij productlanceringen. De organisatie zegt consequent dat het doel is om zeer capabele AI‑systemen te bouwen die afgestemd zijn op menselijke waarden en zo te deployen dat iedereen profiteert, niet slechts aandeelhouders of vroege partners.

In 2018 publiceerde OpenAI het OpenAI Charter, dat zijn prioriteiten formaliseerde:

Het charter fungeert als governancekompas en beïnvloedt beslissingen over onderzoeksrichting, snelheid van uitrol en externe partnerschappen.

Naarmate modellen capabeler werden, bouwde OpenAI toegewijde veiligheid‑ en governancefuncties naast de kernonderzoeksteams:

Deze teams beïnvloeden lanceringsbeslissingen, toegangsniveaus en gebruiksbeleid voor modellen zoals GPT‑4 en DALL·E.

Een kenmerkende technische aanpak is reinforcement learning from human feedback (RLHF). Menselijke beoordelaars evalueren modelantwoorden, rangschikken ze en trainen een rewardmodel. Het hoofdmodel wordt daarna geoptimaliseerd om reacties te geven die meer overeenkomen met menselijk voorkeurgedrag, waardoor toxische, bevooroordeelde of onveilige outputs afnemen.

In de loop der tijd heeft OpenAI RLHF gecombineerd met extra technieken: systeemniveau veiligheidsbeleid, contentfilters, domeinspecifieke fine‑tuning en monitoringtools die risicovol gebruik kunnen beperken of signaleren.

OpenAI neemt deel aan publieke veiligheidskaders, zoals vrijwillige toezeggingen met overheden, modelrapportagepraktijken en standaarden voor frontier‑modelveiligheid. Het werkt samen met academici, maatschappelijke organisaties en security‑onderzoekers aan evaluaties, red‑teaming en audits.

Deze samenwerkingen, samen met documenten als het Charter en evoluerende gebruiksbeleid, vormen de ruggengraat van OpenAI’s benadering om steeds krachtiger wordende AI‑systemen te besturen.

OpenAI’s snelle opkomst gaat gepaard met kritiek en interne spanningen, vaak gecentreerd rond de vraag of de organisatie nog steeds trouw is aan haar oorspronkelijke missie van breed en veilig voordeel.

Aanvankelijk benadrukte OpenAI open publicatie en delen. Naarmate modellen als GPT‑2, GPT‑3 en GPT‑4 krachtiger werden, verschoof het bedrijf naar beperkte releases, API‑toegang en minder technische details.

Critici zeggen dat die koers in strijd is met de impliciete belofte van de naam “OpenAI”. Voorstanders binnen de organisatie beargumenteren dat het achterhouden van volledige modelgewichten en trainingsdetails noodzakelijk is om misbruik en veiligheidsrisico’s te beheersen.

OpenAI heeft gereageerd door veiligheidsbeoordelingen, systeemkaarten en beleidsdocumenten te publiceren, terwijl de kernmodelgewichten proprietair blijven. Het presenteert dit als een afweging tussen openheid, veiligheid en commerciële druk.

Terwijl OpenAI zijn samenwerking met Microsoft verdiepte — met integraties in Azure en producten zoals Copilot — klonken zorgen over concentratie van compute, data en besluitvormingsmacht.

Critici vrezen dat een klein aantal bedrijven nu de meest geavanceerde algemene modellen en de bijbehorende infrastructuur controleert. Anderen vinden dat agressieve commercialisatie (ChatGPT Plus, enterprise‑aanbiedingen en exclusieve licenties) afwijkt van de oorspronkelijke non‑profitmissie om voordelen breed te delen.

De leiding van OpenAI heeft inkomsten gepresenteerd als noodzakelijk om duur onderzoek te financieren, terwijl het een capped‑profit structuur en het charter als waarborgen noemt. Het introduceerde ook programma’s zoals gratis toegangslagen, onderzoekspartnerschappen en enkele open‑source tools om publiek voordeel te tonen.

Interne meningsverschillen over snelheid, openheid en prioriteitstelling van veiligheid kwamen regelmatig naar voren.

Dario Amodei en anderen verlieten OpenAI in 2020 om Anthropic te starten, met verschillende zienswijzen op veiligheid en governance als reden. Latere vertrekken van sleutelonderzoekers, waaronder Jan Leike in 2024, belichtten publiekelijk zorgen dat kortetermijnproductdoelen mogelijk voorrang kregen boven lange‑termijnveiligheid.

De meest zichtbare breuk gebeurde in november 2023, toen de raad CEO Sam Altman kort verwijderde vanwege een verlies van vertrouwen. Na hevig protest van werknemers en onderhandelingen met Microsoft en andere partijen keerde Altman terug, werd de raad herzien en kondigde OpenAI governance‑hervormingen aan, waaronder een nieuwe Safety and Security Committee.

Deze episodes tonen aan dat de organisatie nog steeds worstelt met het verzoenen van snelle uitrol, commercieel succes en haar verantwoordelijkheden rond veiligheid en breed voordeel.

OpenAI is verschoven van een klein onderzoekslab naar een centraal infrastructuurplatform voor AI, dat beïnvloedt hoe nieuwe tools worden gebouwd, gereguleerd en begrepen.

In plaats van alleen modellen te publiceren, exploiteert OpenAI nu een volledig platform dat wordt gebruikt door startups, bedrijven en individuele ontwikkelaars. Via API’s voor modellen als GPT‑4 en DALL·E is het geworden:

Deze platformrol betekent dat OpenAI niet alleen onderzoek vooruitdrijft, maar ook standaarden zet voor hoe miljoenen mensen voor het eerst krachtige AI ervaren.

OpenAI’s werk zet concurrenten en open‑source gemeenschappen aan tot nieuwe modellen, trainingsmethoden en veiligheidsaanpakken. Die concurrentie versnelt vooruitgang en scherpt tegelijk debatten aan over openheid, centralisatie en commercialisatie.

Overheden en regelgevers kijken steeds vaker naar OpenAI’s praktijken, transparantierapporten en alignmentonderzoek bij het opstellen van regels voor AI‑deploy, veiligheidsmetingen en verantwoord gebruik. Publieke gesprekken over ChatGPT, GPT‑4 en toekomstige systemen bepalen sterk hoe de samenleving risico’s en voordelen van AI voorstelt.

Naarmate modellen capabeler worden, worden onopgeloste kwesties rond OpenAI’s rol urgenter:

Deze vragen bepalen of toekomstige AI‑systemen bestaande ongelijkheden versterken of juist helpen verminderen.

Ontwikkelaars en bedrijven kunnen:

Individuen kunnen:

De toekomstige invloed van OpenAI hangt niet alleen af van interne keuzes, maar ook van hoe overheden, concurrenten, maatschappelijk middenveld en gewone gebruikers deze systemen kritisch volgen, bekritiseren en verantwoordelijk vragen om verantwoording.

OpenAI is in 2015 opgericht als een non-profit onderzoeksinstituut met als missie ervoor te zorgen dat kunstmatige algemene intelligentie (AGI), als die ooit ontstaat, ten goede komt aan de gehele mensheid.

Enkele factoren die de oprichting beïnvloedden:

Dit ontstaan blijft invloedrijk voor OpenAI’s structuur, partnerschappen en publieke toezeggingen.

AGI (artificial general intelligence) verwijst naar AI-systemen die een breed scala aan cognitieve taken op of boven menselijk niveau kunnen uitvoeren, in plaats van smalle tools die zijn geoptimaliseerd voor één taak.

OpenAI’s missie is om:

Deze missie is verankerd in het OpenAI Charter en beïnvloedt belangrijke beslissingen over onderzoeksrichting en uitrol.

OpenAI schakelde van een pure non-profit naar een "capped‑profit" limited partnership (OpenAI LP) om de grote hoeveelheden kapitaal aan te trekken die nodig zijn voor grensverleggend AI‑onderzoek, terwijl de missie bovenaan de besluitvorming zou blijven staan.

Kernpunten:

Het is een experimentele governance‑vorm waarvan effectiviteit onderwerp van debat is.

Microsoft levert OpenAI enorme cloud‑computingcapaciteit via Azure en heeft miljarden in het bedrijf geïnvesteerd.

Het partnerschap omvat onder andere:

In ruil daarvoor krijgt OpenAI de middelen om modellen op wereldschaal te trainen en te deployen, terwijl Microsoft zich onderscheidt met geavanceerde AI‑mogelijkheden in zijn ecosysteem.

De GPT‑serie illustreert groei in schaal, capaciteiten en strategie:

Elke stap verlegde technische grenzen en dwong nieuwe overwegingen over veiligheid, toegang en commercialisatie af.

OpenAI begon met een “open by default” benadering—veel papers, code en tools zoals OpenAI Gym werden breed gedeeld. Naarmate modellen krachtiger werden, verschoof het beleid naar:

OpenAI stelt dat dit nodig is om misbruik en veiligheidsrisico’s te beperken. Critici vinden dat het de oorspronkelijke belofte die de naam “OpenAI” suggereert ondermijnt en macht concentreert bij één organisatie.

OpenAI gebruikt een mix van organisatorische maatregelen en technische methoden om veiligheid en alignment te bevorderen:

Deze maatregelen verminderen risico’s, maar lossen niet alle problemen op: hallucinerende antwoorden, bias en misbruik blijven actieve uitdagingen.

ChatGPT, gelanceerd eind 2022, maakte grootschalige taalmodellen direct toegankelijk voor een breed publiek via een eenvoudige chatinterface.

Het veranderde AI‑adoptie door:

De publieke zichtbaarheid verhoogde ook de aandacht voor OpenAI’s governance, businessmodel en veiligheidspraktijken.

OpenAI’s modellen, vooral Codex en GPT‑4, veranderen al delen van kenniswerk en creatief werk.

Mogelijke voordelen:

Risico’s en zorgen:

Je kunt op verschillende manieren verantwoord met OpenAI omgaan:

In alle gevallen helpt het om geïnformeerd te blijven over hoe modellen worden getraind en bestuurd en om te pleiten voor transparantie, verantwoording en eerlijke toegang naarmate systemen krachtiger worden.

Het netto-effect hangt sterk af van beleid, organisatorische keuzes en hoe mensen en bedrijven AI integreren.