01 sep 2025·8 min

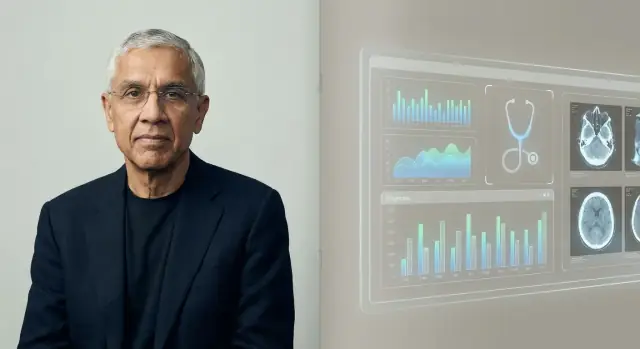

Vinod Khosla en de weddenschap dat AI artsen zal vervangen

Waarom Vinod Khosla betoogde dat AI veel artsen zou kunnen vervangen—zijn redenering, de zorgweddenschappen erachter, wat AI wel en niet kan, en wat het betekent voor patiënten.

Wat Khosla bedoelde met “AI zal artsen vervangen"

Als Vinod Khosla zegt “AI zal artsen vervangen”, beschrijft hij meestal geen sci‑fi‑ziekenhuis zonder mensen. Hij maakt een scherper, operationeel punt: veel taken die nu de tijd van een arts opslokken—vooral informatie‑intensief werk—kunnen door software worden gedaan die sneller, goedkoper en steeds nauwkeuriger is.

De reikwijdte: vervanging van taken, niet van compassie

In Khosla’s formulering betekent “vervangen” vaak het substitueren van een groot deel van wat artsen dagelijks doen, niet het uitwissen van het beroep. Denk aan de repetitieve onderdelen van zorg: het verzamelen van symptomen, het checken van richtlijnen, het rangschikken van waarschijnlijke diagnoses, het aanbevelen van vervolgstappen, het monitoren van chronische aandoeningen en het vroegtijdig signaleren van risico.

Daarom is het idee eerder “pro‑automatisering” dan “anti‑arts.” De onderliggende weddenschap is dat de gezondheidszorg vol patronen zit—en patroonherkenning op schaal is precies waar AI de neiging heeft te excelleren.

Verwachtingen stellen voor dit artikel

Dit stuk behandelt de uitspraak als een hypothese die geëvalueerd moet worden, niet als een slogan om te juichen of te verwerpen. We bekijken de redenering erachter, welke soorten zorgproducten daarbij passen, en de reële beperkingen: regelgeving, veiligheid, aansprakelijkheid en het menselijke deel van geneeskunde.

Belangrijke termen die we zullen gebruiken

- Vervangen: AI voert een taak end‑to‑end uit met minimale betrokkenheid van een zorgverlener.

- Aanvullen: AI ondersteunt, maar een zorgverlener blijft de beslisser.

- Zorgverlener: een gediplomeerd professional (arts, nurse practitioner, physician assistant) die patiëntenzorg levert.

- Diagnose: niet alleen een ziekte een naam geven, maar een waarschijnlijkheidsgewogen verklaring vormen en vervolgstappen kiezen (testen, behandeling, follow‑up).

Wie is Vinod Khosla, en waarom doet zijn mening ertoe

Een korte, feitelijke achtergrond

Vinod Khosla is een Silicon Valley‑ondernemer en investeerder, vooral bekend als medeoprichter van Sun Microsystems in de jaren tachtig en later als oprichter van Khosla Ventures in 2004, na een periode bij Kleiner Perkins.

Die mix—operative ervaring plus decennia aan investeren—helpt verklaren waarom zijn uitspraken over AI en gezondheidszorg veel verder gedragen worden dan alleen de technische kringen.

De “stijl” van Khosla Ventures in gewone woorden

Khosla Ventures heeft de reputatie grote, hoog‑convictie weddenschappen te steunen die aanvankelijk onredelijk kunnen lijken. Het fonds neigt vaak naar:

- contrarian‑theses (ideeën die veel experts vroeg afwijzen)

- platformverschuivingen (technologieën die meerdere industrieën hervormen)

- lange tijdshorizonten (bereidheid te wachten op regelgeving, adoptie of infrastructuur)

Dat is van belang omdat voorspellingen als “AI zal artsen vervangen” niet alleen retoriek zijn—ze kunnen bepalen welke startups financiering krijgen, welke producten worden gebouwd en welke verhalen besturen en directies serieus nemen.

Waarom de gezondheidszorg een groot doelwit werd voor AI‑weddenschappen

De zorg is een van de grootste, duurste sectoren van de economie en zit vol signalen waar AI mogelijk van kan leren: beelden, labresultaten, notities, sensordata en uitkomsten. Zelfs bescheiden verbeteringen in nauwkeurigheid, snelheid of kosten kunnen leiden tot significante besparingen en betere toegang.

Khosla en zijn fonds hebben herhaaldelijk beargumenteerd dat de geneeskunde rijp is voor softwaregestuurde verandering—vooral op het gebied van triage, diagnostische ondersteuning en workflowautomatisering. Of je het eens bent met de “vervangings”formulering of niet, zijn visie is belangrijk omdat hij weerspiegelt hoe een groot deel van durfkapitaal de toekomst van geneeskunde evalueert—en waar geld naartoe zal stromen.

De logica achter de voorspelling

Khosla’s voorspelling rust op een simpele bewering: een groot deel van de geneeskunde—vooral de eerstelijnszorg en vroege triage—is patroonherkenning onder onzekerheid. Als diagnose en behandelingskeuze in veel gevallen neerkomt op “vergelijk deze presentatie met wat het meest waarschijnlijk is”, dan zou software die op miljoenen voorbeelden kan leren uiteindelijk beter kunnen worden dan individuele clinici die uit duizenden leren.

Patroonherkenning op schaal

Mensen zijn uitstekend in patroonherkenning, maar we worden beperkt door geheugen, aandacht en ervaring. Een AI‑systeem kan veel meer gevallen, richtlijnen en uitkomsten opnemen dan één arts in een carrière tegenkomt, en die geleerde patroon‑matching consequent toepassen. In Khosla’s denkwijze, zodra het foutpercentage van het systeem onder dat van de gemiddelde clinicus zakt, is de rationele keuze voor patiënten en betalers om routinematige beslissingen via de machine te laten lopen.

Kosten, toegang en consistentie

Economie is de andere drijvende kracht. Eerstelijnszorg wordt beperkt door tijd, geografie en personeelstekorten; consulten kunnen duur, kort en variabel van kwaliteit zijn. Een AI‑dienst kan 24/7 beschikbaar zijn, opschalen naar onderbediende gebieden en meer uniforme besluitvorming leveren—waardoor het probleem “het hangt ervan af wie je zag” wordt verminderd.

Waarom het haalbaar werd

Vroegere expert‑systemen hadden moeite omdat ze op handgecodeerde regels en smalle datasets leunden. De haalbaarheid verbeterde toen medische data digitaliseerden (EHRs, beeldvorming, labs, wearables) en rekencapaciteit het praktisch maakte modellen op enorme corpora te trainen en continu bij te werken.

Automatisering versus menselijke zorg

Zelfs binnen deze logica wordt de “vervangings”lijn meestal getekend rond routinematige diagnoses en protocolgestuurde behandeling—niet de onderdelen van de geneeskunde die draaien om vertrouwen, complexe afwegingen en het begeleiden van patiënten door angst, ambiguïteit of levensveranderende beslissingen.

Belangrijke argumenten en quotes (met de juiste context)

Khosla’s “AI zal artsen vervangen” wordt vaak als prikkelende voorspelling gebracht, niet als letterlijke belofte dat ziekenhuizen zonder mensen zullen zijn. De terugkerende thematiek in zijn gesprekken en interviews is dat veel geneeskunde—vooral diagnose en routinematige behandelbeslissingen—patronen volgt die software kan leren, meten en verbeteren.

Argument 1: Patroonherkenning schaalt sneller dan menselijke training

Hij schetst klinisch redeneren vaak als een vorm van patroonmatching over symptomen, anamnese, beelden, labs en uitkomsten. De kernclaim is dat zodra een AI‑model een bepaalde kwaliteitsdrempel haalt, het breed inzetbaar is en continu bijgewerkt kan worden—terwijl opleiding van clinici traag, duur en ongelijk is over regio's.

Argument 2: Beter gemiddeld presteren, minder ‘slechte dagen’

Een belangrijk nuancepunt is variabiliteit: clinici kunnen uitstekend zijn maar inconsistent door vermoeidheid, werkdruk of beperkte blootstelling aan zeldzame gevallen. AI kan daarentegen constantere prestaties bieden en potentieel lagere foutpercentages als het goed getest, gemonitord en opnieuw getraind wordt.

Argument 3: Second opinions worden de norm

In plaats van AI als een eenmalige vervanger te zien, klinkt zijn sterkste versie meer als: de meeste patiënten raadplegen eerst een AI, en menselijke clinici zullen steeds vaker optreden als reviewers voor complexe gevallen, randvoorwaarden en beslissingen met hoge inzet.

Belangrijke context: een omstreden voorspelling, geen voldongen feit

Voorstanders interpreteren zijn houding als een stimulans naar meetbare uitkomsten en toegang. Critici merken op dat de echte wereld van geneeskunde ambiguïteit, ethiek en aansprakelijkheid bevat—en dat “vervanging” net zozeer afhankelijk is van regelgeving, workflow en vertrouwen als van modelnauwkeurigheid.

De zorgweddenschappen die bij de these passen

Khosla’s bewering sluit goed aan bij de soorten zorgstartups waarin VC's graag investeren: bedrijven die snel kunnen opschalen, romig klinisch werk kunnen standaardiseren en deskundig oordeel in software kunnen omzetten.

De belangrijkste investeringscategorieën

Veel van de weddenschappen die bij deze these passen clusteren rond enkele herhaalbare thema's:

- Diagnostiek en vroege opsporing: tools die ziekten eerder detecteren dan routinematige zorg, vaak door labs, symptomen, voorgeschiedenis en eerdere gegevens in één risicoscore te combineren.

- Triage en routering: AI‑“voordeuren” die bepalen wie spoedeisende zorg nodig heeft, wie zichzelf kan behandelen en welke specialist nodig is.

- Beeld- en signaalinterpretatie: radiologie, pathologie, dermatologiefoto's, ECG's—gebieden waar patroonherkenning centraal staat en prestaties meetbaar zijn.

- Workflowautomatisering: samenvatten van dossiers, documentatie, prior‑auth‑ondersteuning, codering en inboxbeheer—minder koppenmakend, maar direct gekoppeld aan klinische tijdswinst.

Waarom deze weddenschappen bij VC‑prikkels passen

Het (deels) vervangen of verkleinen van de behoefte aan clinici is een enorme prijs: zorguitgaven zijn groot en arbeid is een belangrijke kostenpost. Dat creëert prikkels om tijdlijnen gedurfd te formuleren—want fondsenwerving beloont een duidelijk, hoog‑upside verhaal, ook als klinische adoptie en regelgeving langzamer gaan dan software.

“Platform” versus “point solution” in medische AI

Een point solution doet één taak goed (bijv. het uitlezen van thorax‑röntgenfoto's). Een platform probeert zich over veel workflows heen te zetten—triage, diagnostische ondersteuning, follow‑up, billing—met gedeelde datapijplijnen en modellen.

Het “artsen vervangen” narratief hangt meer af van platforms: als AI slechts wint in één smal taakgebied, passen artsen zich aan; als het veel taken end‑to‑end coördineert, kan de rol van de clinicus verschuiven naar toezicht, uitzonderingen en verantwoording.

Voor oprichters die deze platformideeën verkennen, telt snelheid vroeg: je hebt vaak werkende prototypes van intakeflows, clinician dashboards en auditlogs nodig voordat je een workflow kunt testen. Tools zoals Koder.ai kunnen teams helpen interne webapps (meestal React aan de voorkant, Go + PostgreSQL aan de achterkant) vanuit een chatinterface te bouwen, vervolgens broncode te exporteren en snel te itereren. Voor alles wat klinische beslissingen raakt, heb je nog steeds degelijke validatie, security‑review en een regelgevingsstrategie nodig—maar snel prototypen kan het pad naar een realistische pilot verkorten.

Waar AI realistisch kan concurreren met of beter kan zijn dan clinici

Bouw een kliniekworkflowprototype

Zet je intake-, routerings- en auditlogideeën om in een werkende app via chat.

AI overtreft mensen al in specifieke, smalle delen van klinisch werk—vooral wanneer de taak vooral gaat om patroonherkenning, snelheid en consistentie. Dat betekent niet “AI‑arts” in de volle betekenis. Het betekent dat AI een zeer sterke component van zorg kan zijn.

Taken waarbij AI echt sterk is

AI blinkt uit waar veel repeterende informatie en duidelijke feedbackloops zijn:

- Samenvatten: lange dossiers omzetten in een helder tijdspad (medicatie, labs, eerdere diagnoses) of visitnotities opstellen uit transcripties.

- Triage: symptomen en risicofactoren in urgentiecategorieën indelen (zelfzorg vs afspraak dezelfde dag vs SEH), vooral in settings met veel volume.

- Patroondetectie: subtiele signalen in beelden en golfvormen opsporen (radiologie, dermatologiefoto's, ECG's) en combinaties van labtrends signaleren die mensen kunnen missen wanneer ze moe of gehaast zijn.

In deze gebieden betekent “beter” vaak minder gemiste bevindingen, meer gestandaardiseerde beslissingen en snellere doorlooptijden.

Klinische beslissingsondersteuning versus autonome diagnose

De meeste echte successen vandaag komen van klinische beslissingsondersteuning (CDS): AI suggereert waarschijnlijke aandoeningen, markeert gevaarlijke alternatieven, raadt vervolgtests aan of controleert richtlijn‑naleving—terwijl een clinicus verantwoordelijk blijft.

Autonome diagnose (AI die de beslissing end‑to‑end neemt) is haalbaar in beperkte, goed gedefinieerde contexten—zoals screeningsworkflows met strikte protocollen—maar het is niet de standaard voor complexe patiënten met meerdere aandoeningen.

De clou: datakwaliteit en representativiteit

AI‑nauwkeurigheid hangt sterk af van trainingsdata die overeenkomt met de patiëntpopulatie en zorgsetting. Modellen kunnen verslechteren wanneer:

- het ziekenhuis andere apparatuur of documentatiestijlen gebruikt,

- de patiëntmix anders is (leeftijd, etniciteit, comorbiditeiten), of

- de ‘ground truth’ labels inconsistent waren.

Waarom menselijk toezicht nog steeds nodig is

In situaties met hoge inzet is toezicht geen optie maar een veiligheidslaag voor randgevallen, ongewone presentaties en waardegedreven oordelen (wat een patiënt bereid is te doen, te verdragen of belangrijk vindt). AI kan uitstekend zien, maar clinici moeten nog steeds beslissen wat dat voor deze persoon vandaag betekent.

Waar AI nog tekortschiet

AI kan indrukwekkend zijn in patroonmatching, het samenvatten van dossiers en het suggereren van waarschijnlijke diagnoses. Maar geneeskunde is niet alleen een voorspellingsprobleem. Veel van de moeilijkste onderdelen spelen zich af wanneer het “juiste” antwoord onduidelijk is, de doelen van de patiënt conflicteren met richtlijnen, of het systeem rond de zorg rommelig is.

Vertrouwen, bedside manner en gedeelde besluitvorming

Mensen willen niet alleen een resultaat—ze willen zich gehoord, geloofd en veilig voelen. Een clinicus kan angst, schaamte, verwarring of huiselijke risico's opmerken en het gesprek en plan daarop afstemmen. Gedeelde besluitvorming vereist ook het onderhandelen over afwegingen (bijwerkingen, kosten, levensstijl, familieondersteuning) op een manier die vertrouwen opbouwt over tijd.

Ambiguïteit, multi‑morbiditeit en zeldzame gevallen

Echte patiënten hebben vaak meerdere aandoeningen tegelijk, onvolledige anamnese en symptomen die niet in een netjes sjabloon passen. Zeldzame ziekten en atypische presentaties kunnen als gewone problemen lijken—totdat ze dat niet meer doen. AI kan plausibele suggesties genereren, maar “plausibel” is niet hetzelfde als klinisch bewezen, vooral wanneer subtiele context (recent reizen, nieuwe medicatie, sociale factoren, “ik voel dat er iets niet klopt”) doorslaggevend is.

Aansprakelijkheid wanneer de AI het fout heeft

Zelfs een zeer nauwkeurig model faalt soms. De lastige vraag is wie verantwoordelijkheid draagt: de clinicus die het hulpmiddel volgde, het ziekenhuis dat het implementeerde of de leverancier die het bouwde? Duidelijke aansprakelijkheid beïnvloedt hoe voorzichtig teams moeten zijn—en hoe patiënten verhaal kunnen halen.

Operationele realiteit: inpassen in klinieken en EHRs

Zorg gebeurt binnen workflows. Als een AI‑tool niet soepel met EHRs, ordersystemen, documentatie en declaratie integreert—of als het extra klikken en onzekerheid toevoegt—zullen drukke teams er niet op vertrouwen, hoe goed de demo ook is.

Regulering, ethiek en veiligheid bij medische AI

Medische AI is niet alleen een engineeringvraagstuk—het is een veiligheidsvraagstuk. Wanneer software diagnose of behandeling beïnvloedt, behandelen regelgevers het eerder als een medisch hulpmiddel dan als een typische app.

FDA‑ en CE‑toezicht: de basis

In de VS reguleert de FDA veel “Software as a Medical Device”‑tools, vooral diegene die diagnosticeren, behandelingen aanbevelen of direct zorgbeslissingen beïnvloeden. In de EU speelt CE‑markering onder de Medical Device Regulation (MDR) een vergelijkbare rol.

Deze kaders vereisen bewijs dat het hulpmiddel veilig en effectief is, duidelijkheid over de beoogde toepassing en voortdurende monitoring na uitrol. De regels zijn belangrijk omdat een model dat in een demo goed lijkt, in echte klinieken met echte patiënten kan falen.

Bias en ongelijke prestaties

Een groot ethisch risico is ongelijkmatige nauwkeurigheid over populaties (bijv. verschillende leeftijdsgroepen, huidtinten, talen of comorbiditeiten). Als trainingsdata bepaalde groepen ondervertegenwoordigen, kan het systeem systematisch diagnoses missen of te veel interventies aanraden voor die groepen. Fairness‑testing, subgroeprapportage en zorgvuldige datasetontwerpen zijn geen optionele extra’s—het zijn basisveiligheidsmaatregelen.

Privacy, toestemming en patiëntgegevens

Het trainen en verbeteren van modellen vereist vaak grote hoeveelheden gevoelige gezondheidsdata. Dat roept vragen op over toestemming, secundair gebruik, beperkingen van de‑identificatie en wie er financieel van profiteert. Goed bestuur omvat duidelijke patiëntmededelingen, strikte toegangsbewaking en beleid voor databehoud en modelupdates.

“Human‑in‑the‑loop” als veiligheidspatroon

Veel klinische AI‑tools zijn ontworpen om te assisteren, niet te vervangen, door een clinicus verantwoordelijk te houden voor de uiteindelijke beslissing. Deze “human‑in‑the‑loop”‑benadering kan fouten opvangen, context leveren die het model mist en verantwoordelijkheidslijnen duidelijker maken—hoewel het alleen werkt als workflows en prikkels blind vertrouwen voorkomen.

Wat dit betekent voor artsen en banen in de zorg

Creëer een triage‑voordeur

Maak in dagen in plaats van maanden een symptoomintake en escalatiedashboard voor het personeel.

Khosla’s bewering wordt vaak gehoord als “artsen worden overbodig.” Een nuttiger lezing is het onderscheid tussen vervanging (AI voert een taak end‑to‑end uit met minimale menselijke input) en herallocatie (mensen blijven eigenaar van uitkomsten, maar werk verschuift naar toezicht, empathie en coördinatie).

Vervanging versus herallocatie

In veel settings zal AI eerst stukken klinisch werk vervangen: notities opstellen, differentiële diagnoses naar boven halen, richtlijnnaleving controleren en patiëntgeschiedenis samenvatten. De baan van de clinicus verschuift van antwoorden genereren naar auditen, contextualiseren en communiceren.

Welke rollen veranderen eerst

Huisartsgeneeskunde kan de verandering voelen als de “voordeur” verbetert: symptoomcheckers en ambient documentatie verkorten routinematige bezoeken, terwijl complexe gevallen en relationele zorg menselijk blijven. Radiologie en pathologie kunnen meer directe taakvervanging zien omdat het werk al digitaal en patroongebaseerd is. Dat betekent niet direct minder specialisten—waarschijnlijker is hogere doorvoer, nieuwe kwaliteitsworkflows en druk op vergoedingen.

Verpleegkunde draait minder om diagnose en meer om continue beoordeling, educatie en coördinatie. AI kan administratieve lasten verminderen, maar zorg aan het bed en escalatiebeslissingen blijven mensgericht.

Nieuwe banen die ontstaan

Verwacht groei in rollen zoals AI‑supervisor (monitoren van modelprestaties), klinische informatica (workflow + data‑stewardship) en care coordinator (de gaten dichten die het model signaleert). Deze functies kunnen binnen bestaande teams zitten in plaats van aparte titels te worden.

Opleiding en credentialing

Medische opleiding kan AI‑geletterdheid toevoegen: hoe outputs te valideren, reliance te documenteren en faalwijzen te herkennen. Credentialing kan evolueren naar “human‑in‑the‑loop” standaarden—wie welke tools mag gebruiken, onder welke supervisie en hoe aansprakelijkheid wordt toegewezen als AI fouten maakt.

De sterkste tegenargumenten tegen Khosla’s visie

Khosla’s uitspraak is prikkelend omdat het “arts” grotendeels behandelt als een diagnostische motor. De sterkste tegenargumenten stellen dat zelfs als AI clinici op patroonherkenning kan evenaren, artsen vervangen een heel andere taak is.

Geneeskunde is meer dan diagnose

Een groot deel van de klinische waarde zit in het kaderen van het probleem, niet alleen in het beantwoorden ervan. Artsen vertalen rommelige verhalen in werkbare opties, onderhandelen over afwegingen (risico, kosten, tijd, waarden) en coördineren zorg tussen specialisten. Ze regelen ook toestemming, omgaan met onzekerheid en ‘watchful waiting’—gebieden waar vertrouwen en aansprakelijkheid minstens zo belangrijk zijn als nauwkeurigheid.

Bewijsgaps: trials, uitkomsten en generalisatie

Veel AI‑systemen zien er indrukwekkend uit in retrospectieve studies, maar dat is niet hetzelfde als het verbeteren van echte uitkomsten. Het moeilijkste bewijs is prospectief: vermindert AI gemiste diagnoses, complicaties of onnodige tests over verschillende ziekenhuizen, patiëntgroepen en workflows?

Generalisatie is ook een zwakke plek. Modellen kunnen verslechteren als de populatie verandert, apparatuur verschilt of documentatiegewoonten verschuiven. Een systeem dat op één locatie goed presteert, kan elders struikelen—vooral bij zeldzamere aandoeningen.

Automatiseringsbias en over‑vertrouwen

Zelfs sterke hulpmiddelen creëren nieuwe faalwijzen. Clinici kunnen zich teveel op het model verlaten wanneer het fout is (automatiseringsbias) of stoppen met de tweede vraag die randgevallen ontdekt. Vaardigheden kunnen op den duur verzwakken als mensen rubberstamp‑achtig worden, wat ingrijpen moeilijker maakt wanneer AI onzeker of onjuist is.

Adoptie kan traag zijn zelfs als de technologie werkt

De gezondheidszorg is geen puur technologiemarkt. Aansprakelijkheid, vergoeding, inkoopcycli, integratie met EHRs en klinische training vertragen uitrol. Patiënten en regelgevers kunnen ook eisen dat een mens de uiteindelijke beslissing neemt voor ingrijpende keuzes—dus “AI overal” kan er nog lang uitzien als “AI onder toezicht van artsen.”

Praktische conclusies voor patiënten

Begin gratis, schaal later

Kies een gratis plan om te verkennen en upgrade wanneer je pilot meer nodig heeft.

AI is al op stille manieren aanwezig in de zorg—risicoscores in je dossier, geautomatiseerde interpretaties van scans, symptoomcheckers en tools die prioriteit geven wie het eerst gezien wordt. Voor patiënten is het doel niet om “AI blind te vertrouwen” of “AI te verwerpen”, maar te weten wat je kunt verwachten en hoe je de regie houdt.

Wat je kunt verwachten (goed en minder goed)

Je zult waarschijnlijk meer screening zien (berichten, vragenlijsten, wearabledata) en snellere triage—vooral in drukke klinieken en SEH's. Dat kan snellere antwoorden voor gewone klachten en vroegere opsporing voor sommige aandoeningen betekenen.

De kwaliteit zal variëren. Sommige tools zijn uitstekend in smalle taken; andere zijn inconsistente over leeftijdsgroepen, huidtinten, zeldzame ziekten of rommelige real‑world data. Zie AI als helper, niet als definitief oordeel.

Vragen om te stellen wanneer AI betrokken is

Als een AI‑tool invloed heeft op je zorg, vraag dan:

- Is AI gebruikt voor diagnose, beeldinterpretatie, triage of behandelaanbevelingen?

- Welke gegevens gebruikte het (mijn voorgeschiedenis, labs, beelden, wearables)?

- Is het gevalideerd op patiënten zoals ik (leeftijd, geslacht, etniciteit, aandoeningen)?

- Wie is verantwoordelijk voor de uiteindelijke beslissing—mijn clinicus of de software?

- Kan ik de redenering of bewijslast achter de aanbeveling zien?

Hoe AI‑uitkomsten te interpreteren

Veel AI‑uitkomsten zijn waarschijnlijkheden (“20% risico”) in plaats van zekerheden. Vraag wat het getal voor jou betekent: wat gebeurt er bij verschillende risiconiveaus en wat is de false‑alarm‑rate.

Als de aanbeveling ingrijpend is (operatie, chemo, stoppen met medicatie), vraag dan om een second opinion—menselijk en/of een ander hulpmiddel. Het is redelijk te vragen: “Wat zou u doen als dit AI‑resultaat niet bestond?”

Informed consent en transparantie

Je hoort te weten wanneer software betekenisvol beslissingen beïnvloedt. Als je je ongemakkelijk voelt, vraag naar alternatieven, hoe je gegevens worden opgeslagen en of afzien invloed heeft op toegang tot zorg.

Praktische conclusies voor klinieken en zorgteams

AI in de zorg is het gemakkelijkst te adopteren wanneer je het als elk ander klinisch hulpmiddel behandelt: definieer de use case, test het, monitor het en maak verantwoordelijkheid duidelijk.

Begin waar het risico laag en het volume hoog is

Voordat je AI voor diagnose inzet, gebruik het om dagelijkse frictie weg te nemen. De veiligste vroege successen zijn workflows die throughput verbeteren zonder medische beslissingen te nemen:

- documentatieondersteuning (visit notes, after‑visit summaries)

- planning, verwijzingen, prior‑auth‑voorbereiding

- triage en routering van patiëntberichten

Deze gebieden leveren vaak meetbare tijdsbesparing en helpen teams vertrouwen op te bouwen in verandertrajecten. Als je team lichte interne tools nodig heeft ter ondersteuning—intakeformulieren, routeringdashboards, auditlogs—kan snel app‑bouwen net zo waardevol zijn als modelkwaliteit. Platforms zoals Koder.ai zijn ontworpen voor “vibe‑coding” teams: je beschrijft de app in chat, iterereert snel en exporteert de broncode wanneer je klaar bent om het voor productie te harden. In klinische contexten behandel je dit als een manier om operationele software en pilots te versnellen, met de vereiste security, compliance en validatie.

Een eenvoudige checklist voor evaluatie vóór uitrol

Voor elk AI‑systeem dat patiëntenzorg raakt—even indirect—vereis bewijs en operationele controles:

- Nauwkeurigheid: valideer tegen jouw patiëntmix, niet alleen vendor‑demo's

- Bias‑testing: controleer prestaties over leeftijd, geslacht, ras/etniciteit, taal en comorbiditeiten

- Monitoring: definieer driftchecks, alarmdrempels en wie reageert

- Auditlogs: log inputs, outputs, model/version en acties van clinici

Als een leverancier niet kan uitleggen hoe het model is geëvalueerd, bijgewerkt en geaudit, beschouw dat als een veiligheidswaarschuwing.

Implementatiebasis die pijnlijke fouten voorkomt

Maak “hoe we dit gebruiken” even duidelijk als “wat het doet.” Bied training aan clinici die veelvoorkomende faalwijzen behandelt en stel expliciete escalatiepaden vast (wanneer AI te negeren, wanneer een collega te raadplegen, wanneer te verwijzen, wanneer naar de SEH te sturen). Wijs een eigenaar aan voor prestatiebeoordelingen en incidentmelding.

Als je hulp wilt bij het selecteren, pilo↵ten of besturen van tools, creëer een intern pad voor belanghebbenden om ondersteuning aan te vragen via /contact (of /pricing als je deploy‑diensten verpakt).

Een realistische tijdlijn en waar je op moet letten

Voorspellingen dat AI “artsen zal vervangen” falen vaak wanneer ze geneeskunde behandelen als één baan met één eindstreep. Een realistischer beeld is dat verandering ongelijk arriveert—per specialisme, setting en taak—en wordt versneld wanneer prikkels en regels in lijn komen.

Korte en lange termijn verwachtingen (zonder te doen alsof we de datum weten)

Op korte termijn zijn de grootste winstpunten ‘workflowwins’: betere triage, duidelijkere documentatie, snellere prior‑authorizations en beslissingsondersteuning die duidelijke fouten reduceert. Deze kunnen de toegang vergroten zonder patiënten te dwingen een machine alléén te vertrouwen.

Op de langere termijn zie je geleidelijke verschuivingen in wie wat doet—vooral in gestandaardiseerde, hoogvolume zorg waar data overvloedig is en uitkomsten meetbaar.

Hoe “vervanging” er stapsgewijs uit kan zien

Vervanging betekent zelden dat artsen verdwijnen. Het kan eruitzien als:

- Assisteren: AI suggereert, vat samen en markeert risico; clinici blijven primaire beslissers.

- Toezicht: clinici houden toezicht op AI‑geleide beoordelingen en grijpen in bij randgevallen.

- Automatiseren: voor smalle, goed gedefinieerde problemen handelt AI de volledige lus (screen → beslissing → follow‑up) met menselijke escalatie.

Signalen om te blijven volgen

- Vergoeding: verzekeraars die betalen voor AI‑ondersteunde consulten, remote monitoring of autonome screening.

- Regelgevende goedkeuringen: tools die niet alleen voor “ondersteuning” zijn vrijgegeven, maar voor het nemen of uitvoeren van klinische beslissingen.

- Aansprakelijkheidsnormen: duidelijkere regels over wie verantwoordelijk is wanneer AI fout zit—leverancier, clinicus of zorgsysteem.

De gebalanceerde conclusie: voortgang zal echt en soms verbluffend zijn, maar geneeskunde is niet alleen patroonherkenning. Vertrouwen, context en patiëntgerichtheid houden mensen centraal—zelfs als de gereedschapskist verandert.

Veelgestelde vragen

Bedoelde Khosla letterlijk dat artsen zullen verdwijnen?

Khosla bedoelt meestal dat AI een groot deel van de dagelijkse klinische taken zal vervangen, vooral informatie‑intensief werk zoals triage, het controleren van richtlijnen, het rangschikken van waarschijnlijke diagnoses en het monitoren van chronische aandoeningen.

Het is minder “geen mensen meer in ziekenhuizen” en meer “software wordt de standaard eerste stap voor routinematige beslissingen.”

Wat is het verschil tussen AI die artsen “vervangt” versus “aanvult”?

In de termen van dit artikel:

- Vervangen: AI voert een taak end‑to‑end uit met minimale betrokkenheid van een arts.

- Aanvullen: AI ondersteunt terwijl een arts de uiteindelijke beslisser blijft.

De meeste werkelijke implementaties op korte termijn lijken op aanvulling, waarbij vervanging beperkt blijft tot smalle, goed afgebakende workflows.

Wat is de belangrijkste reden achter de voorspelling dat AI artsen zal vervangen?

De kernlogica is patroonherkenning op schaal: veel klinische oordelen (vooral vroege triage en routinediagnose) lijken op het matchen van symptomen, voorgeschiedenis, laboratoria en beelden met waarschijnlijke aandoeningen.

AI kan op veel meer gevallen trainen dan een individuele arts in zijn of haar loopbaan ziet en die kennis consequent toepassen, wat over tijd tot lagere gemiddelde foutpercentages kan leiden.

Waarom doet Vinod Khosla’s mening over medische AI ertoe?

Investeerders letten op Khosla omdat zijn visie kan beïnvloeden:

- welke startups gefinancierd worden,

- welke productcategorieën eerst ontwikkeld worden,

- hoe bestuurders en directies over automatisering in de zorg praten.

Zelfs als je het oneens bent met de formulering, kan het de kapitaalstromen en adoptieprioriteiten sturen.

Waarom is de zorg een primair doelwit voor AI‑gedreven automatisering?

De gezondheidszorg is duur en arbeidsintensief en genereert veel data (EHR‑notities, laboratoria, beeldvorming, sensorgegevens). Die combinatie maakt het aantrekkelijk voor AI‑inzichten waarbij zelfs kleine verbeteringen grote besparingen kunnen opleveren.

Het is ook een sector met toegankelijkheidsproblemen (tekorten, geografie), waar 24/7 softwarediensten overtuigend kunnen lijken.

Welke medische taken kan AI vandaag realistisch evenaren of verslaan?

AI is het sterkst waar het werk repetitief en meetbaar is, zoals:

- samenvatten van dossiers en notities,

- triage en routering op basis van risico,

- patroonherkenning in beeldvorming of signalen (radiologie, pathologie, ECG's),

- checks van richtlijnen en herinneringen als klinische beslissingsondersteuning.

Dit zijn componentwins die de werkbelasting van clinici kunnen verlagen zonder zorg volledig te automatiseren.

Wat zijn de grootste redenen dat AI nog tekortschiet in de echte medische praktijk?

Belangrijke beperkingen zijn onder meer:

- rommelige real‑world context (multi‑morbiditeit, incomplete anamnese),

- vertrouwen en gedeelde besluitvorming,

- omgaan met zeldzame of atypische gevallen,

- integratie in workflows (EHR‑klikken, orderen, declaratie),

- duidelijke aansprakelijkheid wanneer het hulpmiddel fout zit.

Hoge nauwkeurigheid in een demo vertaalt zich niet automatisch naar veilige, betrouwbare prestaties in klinieken.

Hoe beïnvloeden regelgeving en veiligheidsregels of AI artsen kan vervangen?

Veel tools die diagnose of behandeling beïnvloeden worden gereguleerd als Software as a Medical Device:

- In de VS verlangt de FDA vaak bewijs van veiligheid/efficiëntie en duidelijkheid over de beoogde toepassing.

- In de EU regelt CE‑markering onder MDR iets soortgelijks.

Voortdurende monitoring is belangrijk omdat modellen kunnen ‘driften’ wanneer populaties, apparatuur of documentatiepatronen veranderen.

Wat betekent “bias in medische AI” en waarom is het een veiligheidsprobleem?

Bias ontstaat wanneer trainingsdata bepaalde groepen of zorginstellingen ondervertegenwoordigen, wat leidt tot ongelijkmatige prestaties over leeftijd, huidskleur, taal, comorbiditeiten of geografische groepen.

Praktische mitigaties zijn onder meer subgroepvalidatie, rapportage van prestaties per populatie en monitoring na uitrol—niet het behandelen van eerlijkheid als een eenmalige checklist.

Wat moeten patiënten vragen wanneer AI bij hun zorg betrokken is?

Begin met patiëntgerichte transparantie en controle:

- Vraag of AI werd gebruikt bij triage, beeldlezing, diagnose of behandelaanbevelingen.

- Vraag welke gegevens het gebruikte en of het gevalideerd is op patiënten zoals jij.

- Vraag wie verantwoordelijk is voor de uiteindelijke beslissing.

- Behandel uitkomsten als waarschijnlijkheden en vraag om een second opinion bij ingrijpende beslissingen.

Een nuttige vraag is: “Wat zou u doen als dit AI‑resultaat niet bestond?”