Wat JavaScript-runtimes zijn en waarom ze ertoe doen

JavaScript is de taal. Een JavaScript-runtime is de omgeving die de taal nuttig maakt buiten een browser: het embed een JavaScript-engine (zoals V8) en omringt die met de systeemfuncties die echte apps nodig hebben—bestandstoegang, netwerken, timers, procesbeheer en API's voor cryptografie, streams en meer.

Als de engine het “brein” is dat JavaScript begrijpt, is de runtime het hele “lichaam” dat met je besturingssysteem en het internet kan praten.

Waar runtimes voorkomen

Moderne runtimes zijn niet alleen voor webservers. Ze voeden:

- Servers en API's (traditionele backend-apps)

- CLI-tools (formatters, buildtools, automatiseringsscripts)

- Edge-functies (code die dicht bij gebruikers draait, vaak met striktere limieten)

- Desktop-apps (vaak via frameworks die een runtime bundelen)

Dezelfde taal kan overal draaien, maar elke omgeving heeft andere beperkingen—opstarttijd, geheugengrenzen, beveiligingsgrenzen en beschikbare API's.

Waarom meerdere runtimes bestaan (en blijven veranderen)

Runtimes evolueren omdat ontwikkelaars andere afwegingen willen. Sommigen geven prioriteit aan maximale compatibiliteit met het bestaande Node.js-ecosysteem. Anderen streven naar strengere beveiligingsinstellingen, betere TypeScript-ergonomie of snellere cold starts voor tooling.

Zelfs wanneer twee runtimes dezelfde engine delen, kunnen ze dramatisch verschillen in:

- Ingebouwde API's en standaardsupport

- Aanpak van pakketbeheer

- Machtigingen- en sandboxingmodel

- Tooling-ervaring (testen, formatteren, bundelen)

Wat “concurreren” echt betekent

Concurrentie gaat niet alleen over snelheid. Runtimes concurreren om adoptie (community en mindshare), compatibiliteit (hoeveel bestaande code “gewoon werkt”) en vertrouwen (beveiligingshouding, stabiliteit, langetermijnonderhoud). Die factoren bepalen of een runtime de standaardkeuze wordt of een nichetool blijft die je alleen voor specifieke projecten gebruikt.

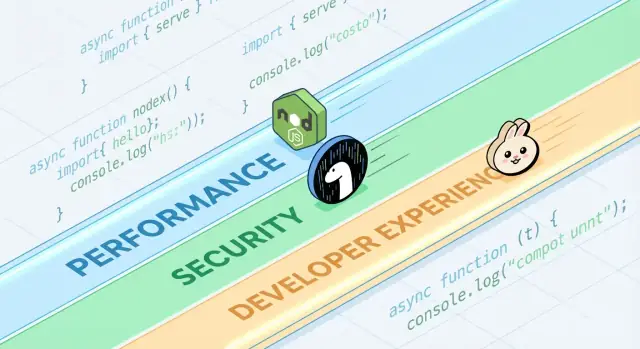

Een snelle rondleiding langs populaire runtimes

Als mensen “JavaScript-runtime” zeggen, bedoelen ze meestal “de omgeving die JS buiten (of binnen) een browser draait, plus de API's die je gebruikt om daadwerkelijk dingen te bouwen.” De runtime die je kiest bepaalt hoe je bestanden leest, servers start, pakketten installeert, machtigingen afhandelt en productie-issues debugt.

Veelvoorkomende voorbeelden

Node.js is al lang de standaard voor server-side JavaScript. Het heeft het breedste ecosysteem, volwassen tooling en enorme community-momentum.

Deno is ontworpen met moderne defaults: eersteklas TypeScript-ondersteuning, een standaard strengere beveiligingshouding, en een meer “batterijen inbegrepen”-benadering van de standaardbibliotheek.

Bun richt zich sterk op snelheid en ontwikkelaarsgemak, en bundelt een snelle runtime met een geïntegreerde toolchain (zoals pakketinstallatie en testen) die gericht is op het verminderen van setup-werk.

Browser-runtimes (Chrome, Firefox, Safari) blijven de meest voorkomende JS-runtimes overall. Ze zijn geoptimaliseerd voor UI-werk en bieden Web API's zoals DOM, fetch en opslag—maar ze geven geen directe bestandssysteemtoegang zoals server-runtimes dat doen.

Wat runtimes gemeen hebben

De meeste runtimes combineren een JavaScript-engine (vaak V8) met een event loop en een set API's voor netwerken, timers, streams en meer. De engine voert code uit; de event loop coördineert asynchroon werk; de API's zijn wat je dagelijks gebruikt.

Wat verschilt (en waarom het dagelijks uitmaakt)

Verschillen verschijnen in ingebouwde features (zoals ingebouwde TypeScript-afhandeling), standaard tooling (formatter, linter, test-runner), compatibiliteit met Node's API's en beveiligingsmodellen (bijvoorbeeld of bestand-/netwerktoegang onbeperkt is of via machtigingen verloopt). Daarom is “runtime-keuze” geen abstractie—het beïnvloedt hoe snel je een project kunt starten, hoe veilig je scripts kunt draaien en hoe pijnlijk (of soepel) deployment en debugging aanvoelen.

Prestaties: de meetwaarden waar runtimes om strijden

“Snel” is geen enkel getal. JavaScript-runtimes kunnen geweldig lijken in één grafiek en gewoon gemiddeld in een andere, omdat ze optimaliseren voor verschillende definities van snelheid.

Latency versus throughput

Latency is hoe snel een enkel verzoek klaar is; throughput is hoeveel verzoeken je per seconde kunt afhandelen. Een runtime die is afgestemd op lage opstarttijd en snelle reacties kan piek-throughput opofferen onder zware concurrency, en andersom.

Een API die gebruikersprofielen ophaalt geeft om tail-latency (p95/p99). Een batchjob die duizenden events per seconde verwerkt geeft meer om throughput en steady-state efficiëntie.

Cold start-tijd (serverless en CLI's)

Cold start is de tijd van “niets draait” tot “klaar om werk te doen.” Het is erg belangrijk voor serverless-functies die naar nul schalen en voor CLI-tools die gebruikers vaak starten.

Cold starts worden beïnvloed door moduleladen, TypeScript-transpilatie (indien aanwezig), initialisatie van ingebouwde API's en hoeveel werk de runtime doet voordat jouw code draait. Een runtime kan zeer snel zijn zodra hij warm is, maar traag aanvoelen als het opstarten extra tijd kost.

I/O-prestaties: netwerk, bestandssysteem, streams

De meeste server-side JavaScript is I/O-bound: HTTP-verzoeken, databasecalls, bestanden lezen, data streamen. Hier gaat performance vaak over de efficiëntie van de event loop, de kwaliteit van async I/O-bindings, stream-implementaties en hoe goed backpressure wordt afgehandeld.

Kleine verschillen—zoals hoe snel de runtime headers parsed, timers plant of writes wegspoelt—kunnen zich vertalen in echte wins in webservers en proxies.

CPU-bound werk: engine-krachten en beperkingen

CPU-intensieve taken (parsing, compressie, beeldverwerking, crypto, analytics) belasten de JavaScript-engine en JIT-compiler. Engines kunnen hot code paths optimaliseren, maar JavaScript heeft nog steeds grenzen voor langdurige numerieke workloads.

Als CPU-bound werk domineert, is de “snelste runtime” mogelijk degene die het gemakkelijkst maakt om hot loops naar native code te verplaatsen of worker threads te gebruiken zonder veel complexiteit.

Benchmarking: realiteitscheck en veelvoorkomende valkuilen

Benchmarks kunnen nuttig zijn, maar ze zijn makkelijk verkeerd te begrijpen—vooral als ze als universele scoreborden worden behandeld. Een runtime die een grafiek wint, kan nog steeds langzamer zijn voor jouw API, je buildpipeline of je datapijplijn.

Microbenchmarks versus echte applicaties

Microbenchmarks testen meestal een piepkleine operatie (zoals JSON-parsing, regex of hashing) in een strakke lus. Dat is bruikbaar om één ingrediënt te meten, niet het hele gerecht.

Echte apps besteden tijd aan dingen die microbenchmarks negeren: netwerkwachttijd, databasecalls, bestand-I/O, framework-overhead, logging en geheugenbelasting. Als je workload voornamelijk I/O-bound is, zal een 20% snellere CPU-lus je end-to-end latency mogelijk niet beïnvloeden.

Resultaten veranderen met workload, OS en versies

Kleine omgevingsverschillen kunnen resultaten omdraaien:

- Workloadvorm: veel kleine verzoeken vs minder grote; streaming vs bufferen.

- OS en hardware: Linux vs macOS; verschillende CPU's; container-limieten.

- Runtime- en dependencyversies: engine-updates, libc-verschillen en librarywijzigingen kunnen domineren.

Als je een benchmark-screenshot ziet, vraag dan welke versies en flags zijn gebruikt—en of die overeenkomen met je productie-setup.

Warm-up (JIT) en caching-effecten

JavaScript-engines gebruiken JIT-compilatie: code kan eerst langzamer draaien en daarna versnellen als de engine hot paths leert. Als een benchmark alleen de eerste paar seconden meet, kan dat de verkeerde dingen belonen.

Caching is ook belangrijk: diskcache, DNS-cache, HTTP keep-alive en applicatie-level caches kunnen latere runs er veel beter uit laten zien. Dat kan reëel zijn, maar het moet gecontroleerd worden.

Eerlijk, herhaalbaar testen ontwerpen

Streef naar benchmarks die jouw vraag beantwoorden, niet die van iemand anders:

- Meet end-to-end: includeer framework + typische middleware + realistische payloadgroottes.

- Scheid cold vs warm: registreer opstart, eerste verzoek en steady-state.

- Draai meerdere trials: rapporteer mediaan en variantie, niet alleen de beste run.

- Lock de omgeving: pin versies, isoleer CPU en documenteer commando's.

Als je een praktisch template nodig hebt, leg je test-harnas vast in een repo en verwijs je ernaar in interne docs (of een tekst over runtime benchmarking) zodat resultaten later reproduceerbaar zijn.

Onder de motorkap: engines, API's en uitvoeringsmodellen

Plan je runtime-pilot

Gebruik Planning Mode om metrics, endpoints en payloads uit te zetten voordat je benchmarks draait.

Wanneer mensen Node.js, Deno en Bun vergelijken, praten ze vaak over features en benchmarks. Daaronder wordt het “gevoel” van een runtime gevormd door vier grote onderdelen: de JavaScript-engine, de ingebouwde API's, het uitvoeringsmodel (event loop + schedulers) en hoe native code eraan gekoppeld is.

Engines: V8, JavaScriptCore en waarom ze ertoe doen

De engine is het deel dat JavaScript parseert en uitvoert. V8 (gebruikt door Node.js en Deno) en JavaScriptCore (gebruikt door Bun) doen beide geavanceerde optimalisaties zoals JIT-compilatie en garbage collection.

In de praktijk kan de keuze van engine invloed hebben op:

- Opstarttijd en geheugengedrag (hoe snel een proces bruikbaar wordt)

- Prestaties van “hot code” nadat optimalisaties ingrijpen

- Welke lage-level features eerder beschikbaar komen (sommige engines leveren nieuwe JS-mogelijkheden eerder dan anderen)

Ingebouwde API's: meer dan “kan ik fetchen?”

Moderne runtimes concurreren op hoe compleet hun standaardbibliotheek aanvoelt. Ingebouwde functies zoals fetch, Web Streams, URL-utilities, bestands-API's en crypto kunnen afhankelijkheidssprawl verminderen en code draagbaarder maken tussen server en browser.

Het addertje onder het gras: dezelfde API-naam betekent niet altijd identiek gedrag. Verschillen in streaming, timeouts of file-watching kunnen echte apps meer beïnvloeden dan ruwe snelheid.

Uitvoeringsmodellen: event loops, schedulers en native bindings

JavaScript is bovenaan single-threaded, maar runtimes coördineren achtergrondwerk (netwerken, bestand-I/O, timers) via een event loop en interne schedulers. Sommige runtimes leunen zwaar op native bindings (gecompileerde code) voor I/O en performance-kritische taken, terwijl anderen de nadruk leggen op web-standaard interfaces.

WebAssembly: wanneer het helpt

WebAssembly (Wasm) is nuttig als je voorspelbare, snelle berekeningen nodig hebt (parsing, beeldverwerking, compressie) of code uit Rust/C/C++ wilt hergebruiken. Het zal typische I/O-gefocuste webservers niet magisch versnellen, maar het kan een sterk hulpmiddel zijn voor CPU-bound modules.

Beveiliging: defaults, machtigingen en supply-chain realiteit

“Secure by default” in een JavaScript-runtime betekent meestal dat de runtime onbetrouwbare code aannneemt totdat je expliciet toegang verleent. Dat keert het traditionele server-side model om (waarin scripts vaak standaard bestanden kunnen lezen, netwerk kunnen gebruiken en env-variabelen kunnen inspecteren) naar een voorzichtiger houding.

Tegelijk beginnen veel echte incidenten voordat jouw code draait—binnen je dependencies en installproces—dus runtime-beveiliging is één laag, niet de hele strategie.

Machtigingsprompts en allowlists

Sommige runtimes kunnen gevoelige mogelijkheden achter machtigingen zetten. De praktische versie daarvan is een allowlist:

- Bestandssysteem: sta lezen/schrijven alleen toe naar specifieke paden (bijv. een config-map)

- Netwerk: sta outbound requests alleen toe naar goedgekeurde hosts/poorten

- Omgevingsvariabelen: geef alleen specifieke keys bloot in plaats van de hele process env

Dit kan per ongeluk datalekken verminderen (zoals het sturen van secrets naar een onverwachte endpoint) en beperkt de blast radius bij het draaien van third-party scripts—vooral in CLI's, buildtools en automatisering.

Sandboxing heeft zijn grenzen

Machtigingen zijn geen magisch schild. Als je netwerktoegang geeft naar “api.mycompany.com,” kan een gecompromitteerde dependency nog steeds data exfiltreren naar diezelfde host. En als je lezen van een directory toestaat, vertrouw je alles daarin. Het model helpt intentie uit te drukken, maar je hebt nog steeds dependency-vetting, lockfiles en zorgvuldige review nodig van wat je toestaat.

Veilige defaults in gangbare API's

Beveiliging zit ook in kleine defaults:

- TLS/HTTPS: verstandige certificaatvalidatie en moderne protocolinstellingen standaard

- HTTP: veilig redirect-gedrag en duidelijke controle over headers/cookies

- Crypto-API's: moderne primitieve functies met interfaces die moeilijk verkeerd te gebruiken zijn

De afweging is frictie: strengere defaults kunnen legacy-scripts breken of extra flags toevoegen die je moet onderhouden. De beste keuze hangt af van of je gemak voor vertrouwde diensten waardeert of juist hekken voor gemengde-trust code.

Supply-chain risico's die je niet kunt negeren

Supply-chain aanvallen misbruiken vaak hoe pakketten worden ontdekt en geïnstalleerd:

- Typosquatting: een kwaadaardig pakket met een naam die één karakter afwijkt (bijv.

expresss).

- Dependency confusion: een publiek pakket krijgt dezelfde naam als een intern pakket en misleidt installers om de publieke versie te halen.

- Gecompromitteerde maintainers: een accountovername levert een “legitieme” update met geïnjecteerde code.

Deze risico's treffen elke runtime die van een publieke registry downloadt—dus hygiëne is net zo belangrijk als runtime-features.

Lockfiles, integriteitschecks en provenance

Lockfiles pinnen exacte versies (en transitieve dependencies), maken installs reproduceerbaar en verminderen verrassende updates. Integriteitschecks (hashes opgenomen in de lockfile of metadata) helpen bij het detecteren van manipulatie tijdens download.

Provenance is de volgende stap: kunnen beantwoorden “wie heeft dit artifact gebouwd, vanuit welke bron, met welke workflow?” Zelfs als je nog geen volledige provenance-tooling adopteert, kun je het benaderen door:

- voorkeur te geven aan goed onderhouden pakketten met transparante releasepraktijken,

- geen ongepinde Git-afhankelijkheden te gebruiken voor productiebuilds,

- tags/releases te vereisen in plaats van installeren vanaf willekeurige commits.

Audit- en update-workflows die werken

Behandel dependency-werk als routineonderhoud:

- draai geautomatiseerde audits in CI op elke pull request,

- plan regelmatige update-vensters (wekelijks/tweewekelijks) om “big bang” upgrades te vermijden,

- bekijk changelogs voor grote sprongen en beveiligingsrelevante releases.

Teambeleid dat ontwikkeling niet vertraagt

Lichtgewicht regels werken goed:

- blokkeer nieuwe afhankelijkheden tenzij er een duidelijke noodzaak en een eigenaar is,

- beperk install-scripts waar mogelijk (ze zijn een veelvoorkomend uitvoeringspad),

- gebruik een private registry of gescope-de pakketten voor interne namen om verwarring te verminderen.

Goede hygiëne gaat minder over perfectie en meer over consistente, saaie gewoontes.

Compatibiliteit en ecosysteem als concurrentievoordelen

Prestaties en beveiliging halen vaak de krantenkoppen, maar compatibiliteit en ecosysteem bepalen vaak wat er daadwerkelijk wordt uitgerold. Een runtime die je bestaande code draait, je dependencies ondersteunt en hetzelfde gedrag levert tussen omgevingen vermindert risico meer dan één enkele feature.

Compatibiliteit beïnvloedt beveiliging en onderhoud

Compatibiliteit gaat niet alleen over gemak. Minder herschrijven betekent minder kans op subtiele bugs en minder unieke patches die je vergeet bij te werken. Volwassen ecosystemen hebben ook vaak beter bekende faalmodi: populaire libraries zijn vaker geaudit, issues zijn gedocumenteerd en mitigaties makkelijker te vinden.

Aan de andere kant kan “compatibiliteit tegen elke prijs” legacy-patronen in stand houden (zoals te brede bestand-/netwerktoegang), dus teams hebben nog steeds duidelijke grenzen en goede afhankelijkheidshygiëne nodig.

Node-compatibiliteitslagen versus web-standaard API's

Runtimes die drop-in compatibel met Node.js willen zijn, kunnen de meeste server-side JavaScript direct draaien—wat een groot praktisch voordeel is. Compatibiliteitslagen kunnen verschillen gladstrijken, maar ze kunnen ook runtime-specifiek gedrag verbergen—vooral rond filesystem, networking en module-resolutie—waardoor debuggen lastiger wordt als iets in productie anders werkt.

Web-standaard API's (zoals fetch, URL en Web Streams) duwen code richting draagbaarheid tussen runtimes en zelfs edge-omgevingen. De afweging: sommige Node-specifieke pakketten veronderstellen Node-internals en werken niet zonder shims.

Het NPM-ecosysteem: sterke punten en afwegingen

De grootste kracht van NPM is simpel: bijna alles is er. Die breedte versnelt levering, maar vergroot ook de blootstelling aan supply-chain risico's en dependency-bloat. Zelfs als een pakket “populair” is, kunnen de transitieve dependencies je verrassen.

Wanneer “werkt overal” belangrijker is dan nieuwe features

Als je prioriteit is voorspelbare deployments, makkelijker werven en minder integratieverrassingen, wint “werkt overal” vaak. Nieuwe runtime-mogelijkheden zijn spannend—maar draagbaarheid en een bewezen ecosysteem kunnen weken besparen gedurende de levensduur van een project.

Draai een benchmarkbare API op

Maak een kleine API vanuit chat en gebruik die als realistisch end-to-end benchmarkdoel.

Ontwikkelaarservaring is waar runtimes stilletjes winnen of verliezen. Twee runtimes kunnen dezelfde code draaien, maar totaal anders aanvoelen als je een project opzet, een bug jaagt of een kleine service probeert te deployen.

TypeScript-ondersteuning: ingebouwd versus zelf regelen

TypeScript is een goede DX-lakmoesproef. Sommige runtimes behandelen het als een first-class input (je kunt .ts-bestanden draaien met minimale ceremonie), terwijl anderen een traditionele toolchain verwachten (tsc, een bundler of loader) die je zelf configureert.

Geen van beide benaderingen is universeel “beter”:

- Ingebouwde ondersteuning vermindert setup en kan defaults standaardiseren over een team.

- Geconfigureerde tooling geeft fijne controle over tsconfig, emit-doelen en build-output—handig voor libraries en grotere monorepo's.

De kernvraag is of het TypeScript-verhaal van je runtime overeenkomt met hoe je team daadwerkelijk code oplevert: directe uitvoering in dev, gecompileerde builds in CI, of beide.

Bundling, transpiling en test-standaarden

Moderne runtimes leveren steeds vaker opinionated tooling: bundlers, transpilers, linters en test-runners die out of the box werken. Dat kan de “choose your own stack”-belasting voor kleinere projecten wegnemen.

Maar defaults zijn alleen DX-positief als ze voorspelbaar zijn:

- Kun je uitvoerformaten (ESM/CJS), targets en externe afhankelijkheden eenvoudig wijzigen?

- Integreert de test-runner goed met coverage en CI?

- Is de configuratie minimaal en stabiel over versies?

Als je vaak nieuwe services start, kan een runtime met solide ingebouwde tools plus goede docs uren per project besparen.

Debugging: stacktraces, sourcemaps en inspectors

Debugging is waar runtime-polijsting duidelijk wordt. Hoge-kwaliteit stacktraces, correcte sourcemap-afhandeling en een inspector die “gewoon werkt” bepalen hoe snel je fouten begrijpt.

Let op:

- Duidelijke fouten die naar jouw bron wijzen (niet gegenereerde code)

- Betrouwbare async stacktraces

- Goede integratie met editors en Chrome DevTools-achtige inspectors

Templates en scaffolding die wrijving wegnemen

Projectgenerators kunnen onderschat zijn: een schoon template voor een API, CLI of worker zet vaak de toon voor een codebase. Geef de voorkeur aan scaffolds die een minimaal, productiegericht structuur (logging, env-handling, tests) maken, zonder je vast te pinnen aan een zwaar framework.

Als je inspiratie nodig hebt, zie gerelateerde gidsen in /blog.

Als praktische workflow gebruiken teams soms Koder.ai om een kleine service of CLI te prototypen in verschillende “runtime-stijlen” (Node-first vs Web-standaard API's), en exporteren ze dan de gegenereerde broncode voor een echte benchmarkronde. Het is geen vervanging voor productietests, maar het kan de tijd van idee → uitvoerbare vergelijking verkorten wanneer je trade-offs evalueert.

Pakketbeheerkeuzes vormen de DX

Pakketbeheer is waar “ontwikkelaarservaring” tastbaar wordt: installatiesnelheid, lockfile-gedrag, workspace-ondersteuning en hoe betrouwbaar CI een build reproduceert. Runtimes behandelen dit steeds meer als een kernfeature.

Runtime-native package managers en prestatie-doelen

Node.js vertrouwt traditioneel op externe tooling (npm, Yarn, pnpm), wat zowel een kracht (keuze) als een bron van inconsistentie is voor teams. Nieuwere runtimes leveren meningen: Deno integreert dependency-management via deno.json (en ondersteunt npm-pakketten), terwijl Bun een snelle installer en lockfile bundelt.

Deze runtime-native tools optimaliseren vaak voor minder netwerkrondes, agressieve caching en nauwere integratie met de module-loader van de runtime—handig voor cold starts in CI en voor het onboarden van nieuwe collega's.

Monorepo's, workspaces en caching-basics

De meeste teams hebben uiteindelijk workspaces nodig: gedeelde interne pakketten, consistente afhankelijkheidsversies en voorspelbare hoistingregels. npm, Yarn en pnpm ondersteunen allemaal workspaces, maar gedragen zich anders qua schijfruimte, node_modules-layout en deduplicatie. Dat beïnvloedt installatietijd, editor-resolutie en “werkt op mijn machine”-bugs.

Caching is net zo belangrijk. Een goed uitgangspunt is het cachen van de package manager-store (of downloadcache) plus lockfile-gebaseerde installatie-stappen, en zorg dat scripts deterministisch blijven. Documenteer dit naast je buildstappen in /docs.

Publiceren en consumeren: wat teams moeten weten

Interne package-publicatie (of het consumeren van private registries) dwingt je standaarden af voor auth, registry-URL's en versiebeheerregels. Zorg dat je runtime/tooling dezelfde .npmrc-conventies, integriteitschecks en provenance-verwachtingen ondersteunt.

Migratie-zorgen: lockfile-wijzigingen en CI-aanpassingen

Het wisselen van package manager of het adopteren van een runtime-bundled installer verandert meestal lockfiles en install-commando's. Plan voor PR-churn, update CI-images en spreek af welke lockfile de ‘single source of truth’ is—anders debug je dependency-drift in plaats van features uit te rollen.

Een runtime kiezen op basis van use case (niet hype)

Vergelijk Node vs web-API's

Prototypeer een Node-compatibele versie en een web-standaard API-versie naast elkaar.

Het kiezen van een JavaScript-runtime draait minder om “de snelste op een grafiek” en meer om de vorm van je werk: hoe je deployt, waarmee je moet integreren en hoeveel risico je team kan dragen. Een goede keuze verkleint wrijving voor jouw beperkingen.

Serverless en edge-workloads

Hier zijn cold-start en concurrency-gedrag net zo belangrijk als ruwe throughput. Let op:

- Opstarttijd (hoe snel een functie verzoeken kan afhandelen)

- Isolatiemodel (processen vs isolates/worker-stijl uitvoering)

- Beschikbaarheid van API's (Web API's, fetch, streams, crypto) in het doelplatform

Node.js wordt breed ondersteund door providers; Deno's web-standaard API's en machtigingsmodel kunnen aantrekkelijk zijn waar beschikbaar; Bun's snelheid kan helpen, maar controleer platformondersteuning en edge-compatibiliteit voordat je je vastlegt.

Voor command-line utilities kan distributie de doorslag geven. Geef prioriteit aan:

- Single-binary builds en voorspelbare installs

- Cross-platform gedrag (macOS, Windows, Linux)

- Snelle startup en goede ontwikkelaarsergonomie

Deno's ingebouwde tooling en eenvoudige distributie zijn sterk voor CLI's. Node.js is solide als je de breedte van npm nodig hebt. Bun kan geweldig zijn voor snelle scripts, maar valideer packaging en Windows-ondersteuning voor je doelgroep.

Containers en langlopende services

In containers wegen stabiliteit, geheugengedrag en observeerbaarheid vaak zwaarder dan kopregels op benchmarks. Evalueer steady-state geheugengebruik, GC-gedrag onder load en volwassenheid van debugging/profiling tooling. Node.js is vaak de “veilige standaard” voor langlopende productie services vanwege ecosysteemrijpheid en operationele bekendheid.

Teambeperkingen wegen zwaarder dan nieuwigheid

Kies de runtime die past bij de vaardigheden, libraries en operationele gewoontes van je team (CI, monitoring, incident response). Als een runtime herschrijvingen, nieuwe debugging-workflows of onduidelijke afhankelijkheidspatronen forceert, kan elk prestatievoordeel worden opgegeten door leveringsrisico.

Als je doel is features sneller uit te rollen (en niet alleen runtimes bespreken), overweeg waar JavaScript daadwerkelijk in je stack zit. Bijvoorbeeld, Koder.ai richt zich op het bouwen van volledige applicaties via chat—webfrontends in React, backends in Go met PostgreSQL, en mobiele apps in Flutter—dus teams bewaren runtime-beslissingen vaak voor de plekken waar Node/Deno/Bun echt ertoe doen (tooling, edge-scripts of bestaande JS-services), terwijl ze toch snel verdergaan met een productiegericht startpunt.

Beslissingschecklist en vervolgstappen

Een runtime kiezen gaat minder om het kiezen van een “winnaar” en meer om risico te verminderen terwijl je uitkomsten voor team en product verbetert.

Korte checklist

- Prestatietests: Weet je je top-3 knelpunten (opstarttijd, request-throughput, CPU-intensief werk, I/O-latency)? Kun je ze lokaal en in CI reproduceren?

- Beveiligingsbehoeften: Heb je een machtigingsmodel nodig (bestand/netwerk/env-toegang), strakkere sandboxing of compliance-gedreven controles?

- DX-prioriteiten: Welke wrijving kost je vandaag het meest—TypeScript-setup, debugging, hot reload, testtooling of deployment-packaging?

Vragen om te stellen voordat je runtimes wisselt

- Welk probleem lossen we op: kosten, latency, ontwikkelaarsnelheid of veiligheid?

- Welke delen van ons systeem zijn runtime-gevoelig (edge-functies, CLI's, API's, achtergrondjobs)?

- Zijn we gebonden aan een specifiek pakket-ecosysteemgedrag (native addons, postinstall-scripts, CommonJS/ESM-verwachtingen)?

- Wat is ons rollback-plan als een dependency of platformintegratie zich anders gedraagt?

- Wie is verantwoordelijk voor runtime-upgrades en het bijhouden van breaking changes?

Een praktisch pilotplan

Begin klein en meetbaar:

- Kies een enkele service of intern hulpmiddel met duidelijke inputs/outputs (bijv. een webhook-handler, een CLI, een kleine worker).

- Definieer succesmetrics: p95 latency, geheugen, CPU, buildtijd, cold start en ontwikkelaarstijd tot fix.

- Run de pilot in twee omgevingen: staging en een production canary (indien haalbaar).

- Vergelijk resultaten, documenteer verrassingen en itereren (tune configuraties, afhankelijkheidskeuzes) voordat je bredere migratie overweegt.

Als je de feedbackloop wilt verkorten, kun je het pilot-service en benchmark-harnas snel opzetten in Koder.ai, Planning Mode gebruiken om het experiment uit te lijnen (metrics, endpoints, payloads), en dan de broncode exporteren zodat de uiteindelijke metingen in een gecontroleerde omgeving draaien.

Waar je verder kunt leren

Gebruik primaire bronnen en blijf signalen volgen:

- Officiële docs en compatibiliteitsnotities voor Node.js, Deno en Bun

- Release notes en changelogs (let op beveiligingsfixes en breaking changes)

- Security advisories en CVE-feeds relevant voor je dependencies

- Community issue-trackers om reële edge-cases te spotten

Als je een diepergaande gids wilt over eerlijk meten van runtimes, zie /blog/benchmarking-javascript-runtimes.