Wat “prompting” betekent in echt engineeringwerk

Prompting in engineering is niet “praten met een AI.” Het is het geven van controleerbare inputs die een assistent richting een specifiek, toetsbaar resultaat sturen—vergelijkbaar met hoe je een ticket, een spec of een testplan schrijft.

Een goed prompt is meestal een klein pakketje met:

- Doel: wat te bouwen of beslissen

- Beperkingen: talen, frameworks, prestatiebudgetten, toegankelijkheidsregels, API‑contracten, platformlimieten

- Context: bestaande codepatronen, naamgevingsconventies, architectuurgrenzen

- Voorbeelden: voorbeeld‑inputs/outputs, randgevallen, UI‑screenshots beschreven in tekst, bestaande endpoints

- Acceptatiecriteria: hoe je verifieert dat het werkt (tests, lintregels, verwacht gedrag)

Prompting is “spec‑schrijven,” gewoon strakker

In echte projecten vraag je niet om “een loginpagina.” Je specificeert “een loginformulier dat onze design‑tokens volgt, e‑mailformat valideert, fouten inline toont en unittests heeft voor validatie en submit‑staten.” Het prompt wordt een concreet artefact dat iemand anders kan reviewen, bewerken en hergebruiken—vaak samen met de code in de repo gezet.

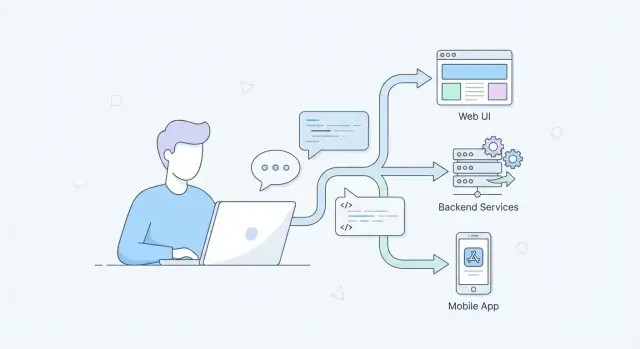

Waarom het stack‑breed uitmaakt

- UI / UX / frontend: prompts kunnen toegankelijkheidseisen, responsief gedrag, microcopy en component‑API‑regels vastleggen zodat output niet afwijkt van het designsystem.

- APIs / backend: prompts kunnen request/response‑vormen, foutsemantiek, idempotentie, paginatie en database‑beperkingen vastleggen—waardoor “ziet er goed uit” code die onder load breekt, wordt verminderd.

- Mobiel: prompts kunnen rekening houden met offline‑modus, batterij, netwerkgemeten, toestemmingsstromen, apparaat‑specifieke UI‑beperkingen en app‑store‑regels.

Wat dit bericht behandelt (en vermijdt)

Dit bericht richt zich op herhaalbare praktijken: promptpatronen, workflows, prompttesten en teamreviewgewoonten.

Het vermijdt hype en “magische resultaten.” AI‑assistentie is nuttig, maar alleen wanneer het prompt verwachtingen expliciet maakt—en wanneer engineers de output verifiëren op dezelfde manier als ze menselijk geschreven code verifiëren.

Waarom prompting nu een kernvaardigheid wordt

Prompting verschuift van een “nice‑to‑have” naar een dagelijkse engineeringcompetentie omdat het verandert hoe snel teams van idee naar iets controleerbaars komen.

Snellere iteratie zonder slordigheid

AI‑geassisteerde tools kunnen in seconden UI‑varianten opstellen, API‑vormen voorstellen, testcases genereren of logs samenvatten. De snelheid is echt—maar alleen als je prompts specifiek genoeg zijn om output te leveren die je daadwerkelijk kunt evalueren. Engineers die vaag doel omzetten in heldere instructies krijgen meer bruikbare iteraties per uur, en dat stapelt zich op over sprints.

Natuurlijke‑taal‑specs vervangen sommige tickets—en ze hebben nog steeds precisie nodig

Meer werk verhuist naar natuurlijk taalgebruik: architectuurnotities, acceptatiecriteria, migratieplannen, release‑checklists en incidentbeschrijvingen. Dit zijn nog steeds “specs”, ook al lijken ze niet op traditionele specs. Prompting is de vaardigheid om die specs zo te schrijven dat ze eenduidig en toetsbaar zijn: beperkingen, randgevallen, succescriteria en expliciete aannames.

Een goed prompt leest vaak als een mini‑designbrief:

- Wat je bouwt en voor wie

- Inputs/outputs en beperkingen (performance, toegankelijkheid, apparaatlimieten)

- Non‑goals en trade‑offs

- Voorbeelden en tegenvoorbeelden

AI komt binnen in de IDE, CI en documentatieworkflow

Naarmate AI‑functies geïntegreerd worden in IDE's, pull‑requests, CI‑checks en documentatiepijplijnen, wordt prompting minder een incidentele chat en meer onderdeel van de dagelijkse engineeringflow. Je vraagt om code, dan om tests, daarna om een risico‑review—elke stap profiteert van consistente, herbruikbare promptstructuur.

Cross‑functionele teams gebruiken dezelfde interface

Design, product, QA en engineering werken steeds vaker samen via gedeelde AI‑tools. Een duidelijk prompt wordt een boundary‑object: iedereen kan het lezen, bekritiseren en zich afstemmen op wat “klaar” betekent. Die gedeelde helderheid vermindert herwerk en maakt reviews sneller en rustiger.

Van vage verzoeken naar duidelijke, toetsbare prompts

Een vaag verzoek zoals “maak een loginpagina” dwingt het model te raden wat je bedoelt. Een toetsbaar prompt leest meer als een mini‑spec: het noemt inputs, verwachte outputs, randgevallen en hoe je weet dat het correct is.

Zet verzoeken om in requirements

Begin met te schrijven wat het systeem ontvangt en wat het moet produceren.

- Inputs: gebruikersacties, API‑payloads, apparaatbeperkingen

- Outputs: UI‑staten, responses, logs/metrics

- Randgevallen: ongeldige data, timeouts, lege staten, gedeeltelijke fouten

Bijvoorbeeld, vervang “maak het formulier werkend” door: “Wanneer het e‑mailveld ongeldig is, toon een inline foutmelding en disable submit; wanneer de API 409 retourneert, toon ‘Account already exists’ en behoud de ingevulde waarden.”

Voeg beperkingen toe die “mooi maar verkeerd” antwoorden voorkomen

Beperkingen houden de output in lijn met je realiteit.

Neem concreet op zoals:

- Techstack (bijv. React + TypeScript, Node + Express)

- Prestatie‑doelen (bijv. render onder 100ms, vermijd N+1 queries)

- Toegankelijkheid (WCAG‑niveau, keyboardnavigatie, ARIA‑verwachtingen)

- Foutafhandeling (retry‑beleid, gebruikersmeldingen, logging)

Vraag naar trade‑offs en redenering

In plaats van alleen code te vragen, vraag het model om beslissingen en alternatieven uit te leggen. Dat vergemakkelijkt reviews en brengt verborgen aannames boven water.

Voorbeeld: “Stel twee benaderingen voor, vergelijk voors/tegens voor onderhoudbaarheid en performance, en implementeer vervolgens de aanbevolen optie.”

Gebruik voorbeelden en non‑examples

Voorbeelden verminderen ambiguïteit; non‑examples voorkomen misinterpretatie.

Zwakkere prompt: “Maak een endpoint om een gebruiker te updaten.”

Sterkere prompt: “Design PATCH /users/{id}. Accept JSON { displayName?: string, phone?: string }. Weiger onbekende velden (400). Als gebruiker niet gevonden (404). Valideer telefoon als E.164. Return updated user JSON. Voeg tests toe voor ongeldige telefoon, lege payload en onbevoegde toegang. Verander het e‑mailveld niet.”

Een nuttige vuistregel: als je geen paar testgevallen uit het prompt kunt schrijven, is het nog niet specifiek genoeg.

Webontwikkeling: prompts voor UI, UX en frontendkwaliteit

Web‑prompting werkt het best als je het model behandelt als een junior teamgenoot: het heeft context, beperkingen en een definitie van “klaar” nodig. Voor UI‑werk betekent dat het specificeren van designregels, staten, toegankelijkheid en hoe de component geverifieerd moet worden.

Componentgeneratie met echte designbeperkingen

In plaats van “Bouw een loginformulier”, neem het designsystem en randgevallen op:

- Layout: responsieve breakpoints, spacing schaal, max widths

- Staten: default, loading, disabled, error, success

- A11y: labels, focusvolgorde, keyboardinteracties, ARIA

Voorbeeldprompt: “Genereer een React LoginForm met onze Button/Input‑componenten. Voeg loading‑state toe bij submit, inline validatie en toegankelijke foutmeldingen. Voorzie Storybook‑stories voor alle staten.”

UI‑code veilig refactoren

Refactors verlopen soepeler wanneer je bewaarbakens zet:

“Refactor deze component om UserCardHeader en UserCardActions te extraheren. Houd de bestaande props‑API stabiel, behoud CSS‑klassenamen en verander de visuele output niet. Als je moet hernoemen, geef een migratienotitie.”

Dat vermindert onbedoelde brekende veranderingen en helpt naming en styling consistent te houden.

Content + UI‑consistentie

Vraag expliciet om microcopy en staatsteksten, niet alleen markup:

“Stel microcopy voor voor lege staat, netwerkfout en permissie geweigerd. Houd de toon neutraal en beknopt. Retourneer copy + waar het in de UI verschijnt.”

Debuggen met reproducerende stappen en logs

Voor frontendbugs moeten prompts bewijs bundelen:

“Gezien deze stappen om te reproduceren, console‑logs en de stacktrace, stel waarschijnlijke oorzaken voor en rangschik fixes op vertrouwen. Voeg toe hoe te verifiëren in de browser en in een unit‑test.”

Wanneer prompts beperkingen en verificatie bevatten, krijg je UI‑output die consistenter, toegankelijker en reviewbaar is.

Backendontwikkeling: prompts voor API's, data en betrouwbaarheid

Backendwerk bevat veel randgevallen: gedeeltelijke fouten, ambiguë data, retries en prestatieverrassingen. Goede prompts helpen beslissingen vast te leggen die in een chat makkelijk weggemoffeld worden maar pijnlijk zijn om in productie te herstellen.

API‑designprompts (routes, schema's, statuscodes)

In plaats van “bouw een API,” dwing het model een contract te produceren dat je kunt reviewen.

Vraag om:

- Routes en verbs, met duidelijke resource‑naamgeving

- Request/response‑schema's (inclusief required vs optional velden)

- Statuscodes voor succes en falen

- Paginatiestrategie (cursor vs offset) en sortering

- Idempotentieregels voor writes (vooral POST)

Voorbeeldprompt:

Design a REST API for managing subscriptions.

Return:

1) Endpoints with method + path

2) JSON schemas for request/response

3) Status codes per endpoint (include 400/401/403/404/409/422/429)

4) Pagination and filtering rules

5) Idempotency approach for create/cancel

Assume multi-tenant, and include tenant scoping in every query.

Datavalidatie en foutafhandeling

Prompt voor consistente validatie en een stabiele “foutvorm” zodat clients problemen voorspelbaar kunnen afhandelen.

Nuttige beperkingen:

- Valideer aan de boundary (DTO/input), en opnieuw bij persistatie indien nodig

- Gebruik getypeerde foutcodes (geen losse strings)

- Map domeinfouten naar HTTP‑statuses (bijv. 409 voor conflicten, 422 voor semantische validatie)

- Include correlation IDs in responses en logs

Modellen genereren vaak correcte‑maar‑trage code tenzij je expliciet om performancekeuzes vraagt. Prompt voor verwacht verkeer, latencydoelen en dataschaal, en vraag daarna om trade‑offs.

Goede aanvullingen:

- “Assume 1k RPS and 50ms p95 target”

- “Vermijd N+1 queries; toon queryplan of indexes”

- “Stel cachinglagen voor (in‑memory vs Redis) en invalidatiestrategie”

- “Batch externe calls; voeg timeouts en circuit breakers toe”

Observability: logs, metrics, traces, alerts

Behandel observability als onderdeel van de feature. Prompt voor wat je meet en wat actie triggert.

Vraag het model om output in de vorm van:

- Gestructureerde logs (eventnaam + sleutelvelden, geen gevoelige data)

- Metrics (RPS, error rate, latency p50/p95/p99, queue depth)

- Trace‑spans rond DB en externe calls

- Alertregels die actiegericht zijn (symptoom + waarschijnlijke oorzaken + runbook hints)

Mobiele ontwikkeling: prompts voor beperkingen en echte apparaten

Ga van build naar deploy

Deploy en host je app wanneer deze klaar is, met ondersteuning voor custom domains.

Mobiele apps falen niet alleen door “slechte code.” Ze falen omdat echte apparaten rommelig zijn: netwerken vallen weg, batterijen lopen leeg, achtergronduitvoering is beperkt, en kleine UI‑fouten worden toegankelijkheidsbarrières. Goede prompting voor mobiel betekent het model vragen te ontwerpen voor beperkingen, niet alleen features.

Prompts voor offlinegedrag, batterij en netwerkvariabiliteit

In plaats van “Voeg offline‑modus toe,” vraag om een plan dat trade‑offs expliciet maakt:

- “Design an offline‑first approach for this screen. Specify what data is cached, cache invalidation rules, and what the UI shows for ‘stale but usable’ data.”

- “Given intermittent connectivity (2G–5G, captive portals), propose retry/backoff rules and user messaging. Include edge cases like app backgrounding during a request.”

- “Suggest ways to reduce battery impact for this feature. Consider background tasks, location usage, polling intervals, and when to stop work.”

Deze prompts dwingen het model verder te denken dan het happy path en beslissingen te leveren die je kunt reviewen.

State‑management en navigatieflows

Mobiele bugs ontstaan vaak uit state die “voor het grootste deel klopt” totdat de gebruiker terugtapt, het apparaat roteert of terugkeert via een deep link.

Gebruik prompts die flows beschrijven:

“Hier zijn de schermen en events (login → onboarding → home → details). Stel een statemodel en navigatieregels voor. Beschrijf hoe je state herstelt na process death, en hoe je dubbele taps en snelle back‑navigatie afhandelt.”

Als je een vereenvoudigd flowdiagram of lijst routes plakt, kan het model een checklist van transities en faalmodi produceren die je kunt testen.

Vraag om platform‑specifieke review, niet generieke UI‑adviezen:

“Review dit scherm tegen iOS Human Interface Guidelines / Material Design en mobiele toegankelijkheid. Noem concrete issues: touch target sizes, contrast, dynamische tekst‑schaal, screenreader‑labels, keyboardnavigatie en haptics‑gebruik.”

Crashrapporten worden actiegericht wanneer je de stacktrace koppelt aan context:

“Gezien deze stacktrace en apparaatinformatie (OS‑versie, model, app‑versie, geheugen‑druk, reproducerende stappen), stel de meest waarschijnlijke oorzaken voor, welke logs/metrics toe te voegen, en een veilige fix met rollout‑plan.”

Dat verandert “Wat is er gebeurd?” in “Wat doen we nu?”—en daar betaalt prompting zich het meest uit voor mobiel.

Promptpatronen die werken voor web, backend en mobiel

Goede prompts zijn herbruikbaar. De beste lezen als een kleine specificatie: helder doel, genoeg context om te handelen, en een controleerbare output. Deze patronen werken of je nu een UI verbetert, een API vormt of een mobiele crash debugt.

De “Spec Prompt”‑structuur

Een betrouwbare structuur is:

- Rol: wie het model moet aannemen (bijv. “senior frontend engineer”)

- Doel: hoe succes eruitziet

- Context: relevante bestanden, platform, beperkingen, huidig gedrag

- Beperkingen: performance, toegankelijkheid, backwards compatibility, libraries, OS‑versies

- Voorbeelden: inputs/outputs, randgevallen, “do/don’t” voorbeelden

- Output‑formaat: wat terug te geven (bullets, patch, JSON)

Dit vermindert ambiguïteit over domeinen: web (a11y + browserondersteuning), backend (consistency + foutcontracten), mobiel (batterij + apparaatbeperkingen).

Stap‑voor‑stap vs. directe output

Gebruik directe output wanneer je al weet wat je nodig hebt: “Genereer een TypeScript‑type + voorbeeldpayload.” Het is sneller en voorkomt lange uitleg.

Vraag om trade‑offs en korte redenering wanneer beslissingen belangrijk zijn: kies je een paginatiestrategie, bepaal je cachinggrenzen, of diagnoseer je een flaky mobiele test. Een praktisch compromis: “Leg kort de belangrijkste aannames en trade‑offs uit, en geef daarna het uiteindelijke antwoord.”

Prompt “contracten” (lintbare outputs)

Behandel prompts als mini‑contracten door gestructureerde output te eisen:

{

"changes": [{"file": "", "summary": "", "patch": ""}],

"assumptions": [],

"risks": [],

"tests": []

}

Dat maakt resultaten reviewbaar, diff‑vriendelijk en makkelijker te valideren met schema‑checks.

Hallucinaties verminderen

Voeg belemmeringen toe:

- Eist dat het model aannames opsomt en vragen stelt als belangrijke inputs ontbreken.

- Vraag het model onzekerheid te signaleren: “Als je het niet zeker weet, zeg het en bied opties.”

- Vraag om verificatiestappen: commando's, testcases of waar in de code te kijken.

- Wanneer externe feiten worden genoemd, vraag om bronnen te citeren (of expliciet “geen bronnen gebruikt”).

Engineeringworkflow: prompts als eersteklas artefacten

Beweeg sneller met chat

Gebruik de chatinterface om code, tests en verfijningen op één plek te schetsen.

Als je team AI regelmatig gebruikt, stoppen prompts met “chatberichten” te zijn en gedragen ze zich als engineeringassets. De snelste manier om kwaliteit te verbeteren is prompts dezelfde behandeling te geven als code: duidelijk doel, consistente structuur en een wijzigingsgeschiedenis.

Behandel prompts als code

Geef ownership en bewaar prompts in versiebeheer. Als een prompt verandert, moet je kunnen beantwoorden: waarom, wat verbeterde en wat brak er. Een lichte aanpak is een /prompts‑map in elke repo, met één bestand per workflow (bijv. pr‑review.md, api‑design.md). Review promptwijzigingen in pull‑requests, net als andere bijdragen.

Als je een “vibe‑coding” platform gebruikt zoals Koder.ai, geldt hetzelfde principe: zelfs als de interface chat‑gebaseerd is, moeten inputs die productiecode opleveren versiebeheer hebben (of in ieder geval als herbruikbare templates worden vastgelegd), zodat teams resultaten over sprints kunnen reproduceren.

Gebruik templates voor herhaalbaar werk

De meeste teams herhalen dezelfde AI‑ondersteunde taken: PR‑reviews, incident‑samenvattingen, datamigraties, release‑notes. Maak prompttemplates die inputs standaardiseren (context, beperkingen, definitie van klaar) en outputs (formaat, checklists, acceptatiecriteria). Dit vermindert variantie tussen engineers en maakt resultaten makkelijker te verifiëren.

Een goede template bevat meestal:

- Doel (welk resultaat je nodig hebt)

- Beperkingen (talen, frameworks, tijd/ geheugenlimits)

- Projectcontext (bestandslinks, architectuurnotities)

- Outputformaat (tabellen, diffs, stap‑voor‑stap plan)

Maak goedkeuringen expliciet

Documenteer waar mensen outputs moeten goedkeuren—vooral security‑gevoelige gebieden, compliance‑wijzigingen, productiedatabankbewerkingen en alles wat auth of betalingen raakt. Zet deze regels naast het prompt (of in /docs/ai‑usage.md) zodat niemand op geheugen hoeft te vertrouwen.

Wanneer je tooling het ondersteunt, leg “veilige iteratie” mechanics vast in de workflow zelf. Bijvoorbeeld, platforms zoals Koder.ai ondersteunen snapshots en rollback, wat experimenteren met gegenereerde wijzigingen, reviewen van diffs en veilig terugdraaien vergemakkelijkt.

Wanneer prompts eersteklas artefacten worden, krijg je herhaalbaarheid, auditability en veiliger AI‑geassisteerde levering—zonder het team te vertragen.

Testen en evalueren van promptkwaliteit

Behandel prompts als elk ander engineeringasset: als je ze niet kunt evalueren, kun je ze niet verbeteren. “Lijkt te werken” is fragiel—vooral wanneer hetzelfde prompt door een team wordt hergebruikt, in CI draait of op nieuwe codebases wordt toegepast.

Bouw gouden testcases

Maak een kleine suite van “bekende inputs → verwachte outputs” voor je prompts. Het belangrijkste is dat outputs controleerbaar zijn:

- Geef de voorkeur aan gestructureerde outputs (JSON, tabellen, expliciete kopjes) boven vrij‑vorm tekst.

- Neem randgevallen op (lege inputs, lange strings, ongebruikelijke locales, foutpaden).

- Versioneer prompt en de gouden cases samen zodat veranderingen intentioneel zijn.

Voorbeeld: een prompt dat een API‑foutcontract genereert zou altijd dezelfde velden en namen en statuscodes moeten produceren.

Gebruik diff‑gebaseerde evaluatie

Wanneer je een prompt bijwerkt, vergelijk de nieuwe output met de vorige en vraag: wat is er veranderd en waarom? Diffs maken regressies duidelijk (missende velden, andere toon, verschoven volgorde) en helpen reviewers focussen op gedrag in plaats van stijl.

Automatiseer checks in de pipeline

Prompts kunnen met dezelfde discipline als code getest worden:

- Schema‑validatie voor JSON‑outputs

- Unittests die kernvereisten asserten (bijv. bevat paginatie, behandelt nulls)

- Statische analyse voor gegenereerde code

- “Buildt en draait het?” checks om syntax en dependencyfouten te vangen

Als je volledige applicaties genereert (web, backend of mobiel) via een platformworkflow—zoals Koder.ai’s chatgestuurde buildproces—zijn deze checks nog belangrijker, omdat je snel grotere changesets kunt produceren. De snelheid moet de reviewdoorvoer verhogen, niet de rigor verminderen.

Meet echte uitkomsten

Tenslotte, meet of prompts daadwerkelijk de levering verbeteren:

- Tijdbesparing per taak (baseline vs AI‑assisted)

- Foutpercentage (bugs in QA/ productie)

- Herwerkpercentage (hoe vaak outputs handmatig moeten worden aangepast)

Als een prompt minuten bespaart maar herwerk verhoogt, is het niet “goed”—het is alleen snel.

Beveiliging, privacy en risicocontroles voor AI‑geassisteerd werk

Het gebruik van een LLM in engineering verandert wat “default veilig” betekent. Het model kan niet bepalen welke details vertrouwelijk zijn, en kan code genereren die er goed uitziet terwijl het stilletjes kwetsbaarheden introduceert. Behandel AI‑assistentie als een tool die guardrails nodig heeft—net als CI, dependency scanning of code review.

Lek geen geheimen (ook niet per ongeluk)

Ga ervan uit dat alles wat je in een chat plakt opgeslagen, gelogd of ingezien kan worden. Plak nooit API‑sleutels, access tokens, private certificaten, klantdata, interne URLs of incidentdetails. Gebruik in plaats daarvan placeholders en minimale, synthetische voorbeelden.

Als je aan het debuggen bent, deel dan:

- Het kleinste reproduceerbare snippet met nepwaarden

- Een geredigeerd logfragment (verwijder IDs, e‑mails, tokens)

- Een duidelijke verklaring wat publiek vs vertrouwelijk is

Maak een teamredactie‑workflow (templates en checklists) zodat mensen niet onder tijdsdruk hun eigen regels verzinnen.

AI‑gegenereerde code kan klassieke issues introduceren: injection‑risico's, onveilige defaults, ontbrekende autorisatiechecks, onveilige dependencykeuzes en fragiele cryptografie.

Een praktische promptgewoonte is het model zijn eigen output te laten bekritiseren:

- “Noem mogelijke securityrisico's in deze code, gerangschikt op impact.”

- “Welke inputs kunnen door een aanvaller gecontroleerd worden?”

- “Wat moet server‑side gevalideerd worden en hoe?”

Vereis security‑reviewprompts voor gevoelige gebieden

Voor authenticatie, cryptografie, permissiechecks en access control, maak “security‑reviewprompts” onderdeel van je definition of done. Koppel ze aan menselijke reviews en geautomatiseerde checks (SAST, dependency scanning). Als je interne standaarden hebt, refereer ernaar in het prompt (bijv. “Volg onze auth‑richtlijnen in /docs/security/auth”).

Het doel is AI niet te verbieden—maar veilig gedrag het makkelijkste gedrag te maken.

Teamvaardigheden: samenwerking, reviews en training

Zet prompts om in builds

Zet spec‑achtige prompts om in controleerbare web-, backend- of mobiele code met Koder.ai.

Prompting schaalt het beste wanneer het als teamvaardigheid wordt behandeld, niet als een persoonlijke truc. Het doel is niet “betere prompts” abstract—het is minder misverstanden, snellere reviews en voorspelbaardere uitkomsten van AI‑geassisteerd werk.

Definieer wat “goed” betekent

Voordat iemand prompts schrijft, stem af op een gedeelde definitie van klaar. Maak “maak het beter” toetsbaar: acceptatiecriteria, codingstandaarden, naamgevingsconventies, toegankelijkheidseisen, performancebudgetten en logging/observability‑behoeften.

Een praktische aanpak is een kleine “outputcontract” in prompts op te nemen:

- Wat de wijziging moet doen (acceptatiecriteria)

- Wat het niet mag doen (non‑goals, beperkingen)

- Hoe het geleverd moet worden (bestanden om te wijzigen, codestijl, vereiste tests)

Als teams dit consequent doen, wordt promptkwaliteit reviewbaar—net als code.

Pair prompting: schrijven + bevragen

Pair prompting spiegelt pair‑programming: de ene persoon schrijft het prompt, de andere reviewt en bevraagt aannames. De reviewer stelt vragen als:

- Welke inputs, randgevallen en foutstaten worden geïmpliceerd maar niet genoemd?

- Welke dependencies of productregels kunnen hierdoor geschonden worden?

- Welke tests bewijzen dat dit correct is?

Dit vangt vroeg ambiguïteit en voorkomt dat de AI vol vertrouwen het verkeerde bouwt.

Train met een gedeeld playbook

Maak een lichte promptplaybook met voorbeelden uit je codebase: “API‑endpoint template,” “frontend component refactor template,” “mobiele performance‑constraint template,” enz. Bewaar het waar engineers al werken (wiki of repo) en link het in PR‑templates.

Als je organisatie één platform gebruikt voor cross‑functioneel bouwen (product + design + engineering), leg die templates daar ook vast. Bijvoorbeeld, Koder.ai‑teams standaardiseren prompts vaak rond planning mode (eerst scope en acceptatiecriteria afspreken), en genereren daarna implementatiestappen en tests.

Bouw feedbackloops vanuit echte issues

Wanneer een bug of incident terug te voeren is op een onduidelijk prompt, repareer dan niet alleen de code—update ook het prompttemplate. Na verloop van tijd worden je beste prompts institutionele kennis, wat herhaalde fouten en onboardingtijd vermindert.

Een praktisch adoptieplan voor je engineeringteam

AI‑prompting adopteren werkt het beste als een kleine engineeringverandering, niet als een ingrijpend “AI‑initiatief.” Behandel het als elke andere productiviteitspraktijk: begin smal, meet effect, en breid uit.

Week 1: Kies enkele high‑value use cases

Kies 3–5 use cases per team die frequent, laag‑risico en makkelijk te evalueren zijn. Voorbeelden:

- API‑scaffold generatie (handlers, routing, OpenAPI‑snippets)

- Testgeneratie (unittests, randgevallen, regressiechecks)

- UI‑componentvarianten (staten, toegankelijkheidsnotities)

- Migratiehelpers (SQL‑migraties, data‑validatiescripts)

Schrijf op wat “goed” eruitziet (tijdsbesparing, minder bugs, duidelijkere docs) zodat het team een gedeeld doel heeft.

Weken 2–3: Maak een kleine set prompttemplates

Bouw een kleine bibliotheek van prompttemplates (5–10) en itereer wekelijks. Houd elke template gefocust en gestructureerd: context, beperkingen, verwachte output en een korte “definition of done.” Bewaar templates waar engineers al werken (repo‑map, interne wiki of ticketing‑systeem).

Als je een platformoptie evalueert, kijk of het de volledige levenscyclus ondersteunt: code genereren, tests draaien, deployen en source exporteren. Bijvoorbeeld, Koder.ai kan web, backend en Flutter‑apps maken vanuit chat, ondersteunt source code export en biedt deployment/hosting—nuttig als je wilt dat prompts verder gaan dan snippets en reproduceerbare builds opleveren.

Voortdurend: Voeg lichte governance toe

Houd governance simpel zodat het de doorvoer niet vertraagt:

- Wijs een duidelijke eigenaar toe voor elke template

- Vereis snelle peer review voor wijzigingen (zoals code review)

- Houd een korte changelog bij (wat veranderde, waarom, waargenomen impact)

Maand 2: Breid uit met training en gedeelde metrics

Organiseer 30‑minute sessies waarin teams één prompt demo’en die aantoonbaar geholpen heeft. Meet een paar metrics (cyclustijdreductie, minder reviewcomments, verbeterde testcoverage) en verwijder templates die hun waarde niet waarmaken.

Voor meer patronen en voorbeelden, exploreer /blog. Als je tooling of workflows evalueert om teams op schaal te ondersteunen, zie /pricing.