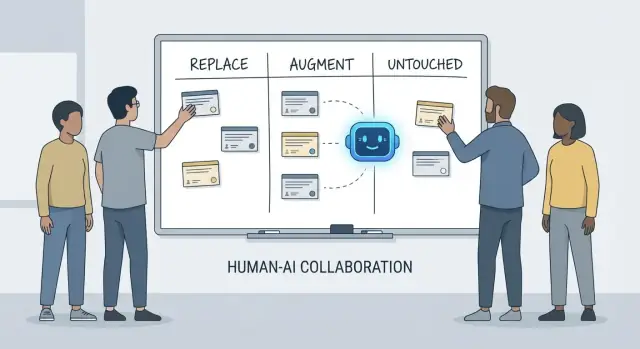

Vervangen, Aanvullen, Onaangetast: Een simpel kader

Discussies over wat “AI met ontwikkelaars doet” raken snel verward omdat we vaak tools met verantwoordelijkheden door elkaar halen. Een tool kan code genereren, een ticket samenvatten of tests voorstellen. Een verantwoordelijkheid is waar het team nog steeds voor aansprakelijk is als het voorstel niet klopt.

Dit artikel gebruikt een eenvoudig kader—vervangen, aanvullen, onaangetast—om het dagelijkse werk in echte teams te beschrijven: met deadlines, legacy‑code, productie‑incidenten en stakeholders die betrouwbare uitkomsten verwachten.

Wat “vervangen” betekent (en wat het niet betekent)

Vervangen betekent dat de AI de taak end‑to‑end kan uitvoeren meestal met duidelijke guardrails, en dat de menselijke rol verschuift naar toezicht en steekproefsgewijze controles.

Voorbeelden zijn vaak begrensd werk: boilerplate genereren, code tussen talen vertalen, repetitieve testcases opstellen of een eerste versie van documentatie produceren.

Vervangen betekent niet “geen menselijke eindverantwoordelijkheid.” Als de output productie breekt, data lekt of standaarden overtreedt, ligt de verantwoordelijkheid nog steeds bij het team.

Wat “aanvullen” betekent

Aanvullen betekent dat de AI een ontwikkelaar sneller of grondiger maakt, maar het werk niet betrouwbaar afmaakt zonder menselijk oordeel.

Dit is de gebruikelijke situatie in professioneel werk: je krijgt nuttige drafts, alternatieve benaderingen, snelle uitleg of een shortlist van waarschijnlijke bugs—maar een ontwikkelaar bepaalt nog steeds wat correct, veilig en passend is voor het product.

Wat “onaangetast” blijft

Onaangetast betekent dat de kernverantwoordelijkheid menselijk blijft omdat het context, afwegingen en verantwoording vereist die zich niet goed laten samenvatten in prompts.

Denk aan: onderhandelen over vereisten, kiezen van systeembreedte beperkingen, incidenten afhandelen, kwaliteitsnormen stellen en beslissen waar geen enkel "juist" antwoord is.

Waarom verantwoordelijkheden de analysenheid zijn

Tools veranderen snel. Verantwoordelijkheden veranderen langzaam.

Stel dus niet de vraag “Kan een AI deze code schrijven?”, maar “Wie is eigenaar van het resultaat?” Die invalshoek houdt verwachtingen gegrond in nauwkeurigheid, betrouwbaarheid en aansprakelijkheid—dingen die belangrijker zijn dan indrukwekkende demo’s.

Wat we bedoelen met “verantwoordelijkheden van ontwikkelaars”

Als mensen vragen wat AI in ontwikkeling “vervangt”, bedoelen ze vaak taken: schrijf een functie, genereer tests, maak documentatie. Teams leveren echter geen taken op—ze leveren uitkomsten. Daar zijn verantwoordelijkheden van ontwikkelaars relevant.

De gebruikelijke bundel verantwoordelijkheden

Het werk van een ontwikkelaar omvat meestal meer dan alleen programmeertijd:

- Oplevering: een vaag idee omzetten in werkende software die op tijd wordt geleverd.

- Kwaliteit: correctheid, onderhoudbaarheid en het voorkomen van regressies.

- Beveiliging & privacy: veilige defaults, dataverwerking en dreigingsbewustzijn.

- Operaties: services draaiende houden, faalwijzen begrijpen en incidenten afhandelen.

- Communicatie: afstemmen met product, design, support en andere engineers.

Deze verantwoordelijkheden lopen door de gehele levenscyclus—van “wat moeten we bouwen?” tot “is het veilig?” tot “wat gebeurt er om 3 uur ’s nachts als het faalt?”

Waarom het meer is dan een checklist

Elke verantwoordelijkheid bestaat uit veel kleine beslissingen: welke randgevallen tellen, welke metrics geven gezondheid aan, wanneer scope inkorten, of een fix veilig is om te shippen, en hoe je een afweging uitlegt aan stakeholders. AI kan helpen met het uitvoeren van delen van dit werk (code drafts, testvoorstellen, log‑samenvattingen), maar verantwoordelijkheid gaat over het eigenaarschap van het resultaat.

Waar overdrachten mislukken

Breuken ontstaan vaak bij overdrachtsgrenzen:

- “QA zal het oppikken” (maar niemand heeft gedefinieerd wat kwaliteit betekent).\n- “Security zal reviewen” (maar het ontwerp heeft al risicovolle keuzes vastgelegd).\n- “Ops regelt het” (maar de service is niet gebouwd om operateerbaar te zijn).

Als eigenaarschap onduidelijk is, valt werk tussen de mazen van het net.

Beslissingsrechten: wie beslist vs. wie voert uit

Een nuttige manier om over verantwoordelijkheden te praten is beslissingsrechten:

- Wie beslist over vereisten, afwegingen en acceptabel risico?\n- Wie voert uit implementatie en verificatie?

AI kan de uitvoering versnellen. De beslissingsrechten—en de aansprakelijkheid voor uitkomsten—moeten nog steeds een menselijke naam hebben.

Werk dat AI vaak kan vervangen (met guardrails)

AI‑codeassistenten zijn echt nuttig wanneer het werk voorspelbaar, laag‑risico en makkelijk te verifiëren is. Zie ze als een snelle junior‑collega: goed in het produceren van een eerste versie, maar met duidelijke instructies en een zorgvuldige controle.

In de praktijk gebruiken sommige teams steeds vaker “vibe‑coding” platforms (zoals Koder.ai) om deze vervangbare stukken te versnellen: scaffolds genereren, CRUD‑flows koppelen en initiële UI‑ en backend‑code produceren vanuit chat. De sleutel blijft hetzelfde: guardrails, review en duidelijk eigenaarschap.

Laag‑risico boilerplate

Veel ontwikkelaarstijd gaat naar het opzetten van projecten en het aan elkaar koppelen van onderdelen. AI kan vaak genereren:

- startbestanden en mappen (controllers, routes, DTO’s)\n- repetitieve “glue code” tussen lagen\n- eenvoudige CRUD‑endpoints die een vastgesteld patroon volgen

De guardrail hier is consistentie: zorg dat het bij je bestaande conventies past en geen nieuwe patronen of afhankelijkheden introduceert.

Mechanische refactors en migraties

Als een wijziging voornamelijk mechanisch is—een symbool hernoemen door de hele codebase, herformatteren of een eenvoudige API‑aanpassing—kan AI het saaie werk versnellen.

Behandel het nog steeds als een bulk‑bewerking: voer de volledige test‑suite uit, scan diffs op onbedoelde gedragsveranderingen en laat het niet “verbeteringen” aanbrengen buiten de gevraagde refactor.

Documentatie‑drafts (controle vereist)

AI kan READMEs, inline‑comments en changelog‑items opstellen op basis van code en commitnotities. Dat versnelt helderheid, maar kan ook zelfverzekerd klinkende onjuistheden creëren.

Beste praktijk: gebruik AI voor structuur en zinsopbouw, verifieer vervolgens elke bewering—vooral installatie‑stappen, configuratiedefaults en randgevallen.

Basis testgeneratie als startpunt

Voor goedgespecificeerde, zuivere functies kunnen door AI gegenereerde unit‑tests initiële coverage bieden en je herinneren aan randgevallen. Guardrail: eigenaarschap blijft nodig: jij bepaalt wat belangrijk is, voegt asserts toe die echte eisen weerspiegelen en zorgt dat tests falen om de juiste redenen.

Samenvattingen van threads en logs

Bij lange Slack‑threads, tickets of incidentlogs kan AI ze omzetten in beknopte aantekeningen en actiepunten. Houd het betrouwbaar door volledige context te leveren en verifieer daarna kernfeiten, tijdstempels en beslissingen voordat je deelt.

Werk dat AI meestal aanvult: sneller, maar niet af

AI‑codeassistenten zijn het meest effectief wanneer je al weet wat je wilt en hulp nodig hebt om vooruitgang te boeken. Ze verminderen de tijd die je aan “typwerk” besteedt en geven relevante context, maar nemen het eigenaarschap, verificatie en oordeel niet weg.

Implementatie versnellen (een sterke eerste versie)

Met een duidelijke specificatie—inputs, outputs, randgevallen en beperkingen—kan AI een redelijke startimplementatie schetsen: boilerplate, datamapping, API‑handlers, migraties of een eenvoudige refactor. Het voordeel is momentum: je hebt snel iets draaibaars.

De waarschuwing is dat eerste‑versiecode vaak subtiele eisen mist (foutsemantiek, performance‑beperkingen, backward compatibility). Behandel het als een intern‑draft: nuttig, maar niet gezaghebbend.

Opties voorstellen—met afwegingen die jij moet valideren

Als je tussen benaderingen kiest (bijv. caching vs. batching, optimistisch vs. pessimistisch locken), kan AI alternatieven voorstellen en afwegingen opsommen. Dat is waardevol voor brainstormen, maar de afwegingen moeten worden getoetst aan de realiteit van je systeem: verkeerspatroon, dataconsistentie, operationele beperkingen en teamconventies.

Codebegrip en navigatie in de codebase

AI is goed in het uitleggen van onbekende code, het aanwijzen van patronen en het vertalen van “wat doet dit?” naar gewone taal. In combinatie met zoektools helpt het bij vragen als “Waar wordt X gebruikt?” en het genereren van een impactlijst van waarschijnlijke call sites, configs en tests om te herzien.

Ontwikkelaarsergonomie: snellere feedbackloops

Praktische verbeteringen: duidelijkere foutmeldingen, kleine voorbeelden en kant‑en‑klare snippets. Deze verlagen wrijvingsverlies, maar vervangen geen zorgvuldige review, lokale runs en gerichte tests—zeker niet voor wijzigingen die gebruikers of productie beïnvloeden.

Productbegrip en vereisten: nog steeds menselijk geleid

AI kan helpen vereisten te schrijven en aan te scherpen, maar het kan niet betrouwbaar beslissen wat je zou moeten bouwen of waarom het ertoe doet. Productbegrip is geworteld in context: zakelijke doelen, gebruikerspijn, organisatorische beperkingen, randgevallen en de kosten van een fout. Die inputs zitten in gesprekken, geschiedenis en verantwoordelijkheid—dingen die een model kan samenvatten, maar niet echt kan bezitten.

Vage doelen omzetten in iets bouwbaars

Vroege verzoeken klinken vaak als “Maak onboarding vloeiender” of “Verminder supporttickets.” De taak van een ontwikkelaar is dat omzetten in heldere vereisten en acceptatiecriteria.

Die vertaling is vooral menselijk werk omdat het afhankelijk is van gerichte vragen en oordeel:\n

- Voor welk gebruikerssegment optimaliseren we en welk gedrag moet veranderen?\n- Wat telt als “klaar” en hoe meten we dat?\n- Welke beperkingen zijn ononderhandelbaar (privacy, performance, deadlines)?

AI kan mogelijke metrics voorstellen of acceptatiecriteria opstellen, maar het weet niet welke constraints echt zijn tenzij iemand die aanlevert—en het zal niet tegengas geven bij tegenstrijdige verzoeken.

Afwegingen en verwachtingsmanagement

Vereistenwerk is waar ongemakkelijke afwegingen naar boven komen: tijd vs. kwaliteit, snelheid vs. onderhoudbaarheid, nieuwe features vs. stabiliteit. Teams hebben een persoon nodig om risico’s expliciet te maken, opties voor te stellen en stakeholders op één lijn te krijgen over de consequenties.

Een goede specificatie is niet alleen tekst; het is een beslissingendossier. Het moet toetsbaar en implementeerbaar zijn, met scherpe definities (inputs, outputs, randgevallen en faalwijzen). AI kan helpen de structuur te maken, maar de verantwoordelijkheid voor correctheid—en het zeggen “dit is dubbelzinnig, we hebben een besluit nodig”—blijft bij mensen.

Systeemontwerp en architectuurbeslissingen

Systeemontwerp is waar “wat bouwen we?” verandert in “waar bouwen we het op en hoe gedraagt het zich als dingen misgaan?” AI kan je helpen opties te verkennen, maar het kan de consequenties niet dragen.

Een architectuur kiezen die bij de realiteit past

Kiezen tussen een monolith, modulair monolith, microservices, serverless of managed platforms is geen multiple‑choice met één juist antwoord. Het is een fit‑probleem: verwachte schaal, budget, time‑to‑market en de vaardigheden van het team.

Een assistent kan patronen samenvatten en referentie‑architecturen voorstellen, maar het weet niet dat jouw team wekelijks on‑call draait, dat werving traag is, of dat je database‑contract volgend kwartaal verloopt. Zulke details bepalen vaak of een architectuur slaagt.

Afwegingen expliciet maken

Goede architectuur draait om afwegingen: simpelheid vs. flexibiliteit, performance vs. kosten, snelheid nu vs. onderhoudbaarheid later. AI kan snel voor‑/nadelenlijsten produceren, wat handig is—vooral om beslissingen te documenteren.

Wat het niet kan is prioriteiten stellen als afwegingen pijn doen. Bijvoorbeeld: “We accepteren iets tragere responsies om het systeem eenvoudiger en beter beheerbaar te houden” is een zakelijke keuze, geen puur technische.

Grenzen, data‑eigendom en faalwijzen

Het definiëren van servicegrenzen, wie welke data bezit en wat er gebeurt bij gedeeltelijke uitval vereist diep product‑ en operationele context. AI kan faalwijzen bedenken (“wat als de betalingsprovider down is?”), maar mensen moeten bepalen het verwachte gedrag, klantcommunicatie en rollback‑plan.

APIs die bruikbaar blijven

Het ontwerpen van APIs is het ontwerpen van een contract. AI kan voorbeelden genereren en inconsistenties vinden, maar jij moet beslissen over versioning, backwards compatibility en wat je bereid bent lange termijn te ondersteunen.

Bepalen wanneer je niet moet bouwen (of moet verwijderen)

Misschien is de belangrijkste architectuurbeslissing “nee zeggen” of een feature verwijderen. AI kan de opportunity cost of politieke risico’s niet meten. Teams kunnen en moeten dat doen.

Debuggen en root‑causeanalyse in de praktijk

Debugging is waar AI vaak indrukwekkend lijkt—en waar het tegelijkertijd de meeste tijd kan verspillen. Een assistent kan logs scannen, verdachte codepaden aanwijzen of een fix suggereren die “juist lijkt”. Maar root‑causeanalyse is niet alleen verklaringen genereren; het is ze bewijzen.

AI kan suggereren; jij bevestigt de oorzaak

Behandel AI‑output als hypothesen, niet als conclusies. Veel bugs hebben meerdere plausibele oorzaken, en AI heeft de neiging een keurig verhaaltje te kiezen dat bij het stukje code past dat je plakte, niet bij de realiteit van het draaiende systeem.

Een praktisch workflow is:\n

- Vraag AI om mogelijke oorzaken en welk bewijs ze van elkaar onderscheidt.\n- Reproduceer het probleem en verzamel dat bewijs.\n- Accepteer pas een fix als deze het falende gedrag daadwerkelijk wegneemt en verifieer dat.

Reproduceren en bewijsgaring blijven menselijk geleid

Betrouwbare reproductie is een debugging‑superkracht omdat het een mysterie in een test verandert. AI kan helpen een minimale repro te schrijven, een diagnostisch script opstellen of extra logging voorstellen, maar jij bepaalt welke signalen tellen: request‑IDs, timing, omgevingsverschillen, feature flags, datavorm of concurrency.

Als gebruikers symptomen melden (“de app bevroor”), moet je dat nog vertalen naar systeemgedrag: welke endpoint stokte, welke timeouts traden op, welke signals in het error‑budget veranderden. Dat vereist context: hoe het product wordt gebruikt en wat “normaal” is.

Vermijd “plausibel maar verkeerd” verklaringen

Als een suggestie niet te valideren valt, ga er dan vanuit dat het onjuist is totdat het bewezen is. Geef de voorkeur aan verklaringen die een toetsbare voorspelling doen (bijv. “dit gebeurt alleen bij grote payloads” of “alleen na cache warm‑up”).

Patch, revert of redesign?

Zelfs na het vinden van de oorzaak blijft de harde beslissing bestaan. AI kan afwegingen schetsen, maar mensen kiezen de respons:\n

- snel patchen om het bloeden te stoppen\n- revert om bekende goede staat te herstellen\n- redesign als het falen een dieper probleem onthult (performance, datamodel, aannames)

Root‑causeanalyse is uiteindelijk verantwoording: het uitleggen, fixen en vertrouwen dat het niet terugkomt.

Code review: oordeel en standaarden automatiseren niet

Code review is niet alleen een checklist voor stijlissues. Het is het moment waarop een team besluit wat het wil onderhouden, ondersteunen en waarvoor het aansprakelijk is. AI kan je helpen meer te zien, maar het kan niet bepalen wat telt, wat bij je productintentie past of welke afwegingen je team accepteert.

Waar AI goed in is bij reviews

AI‑codeassistenten kunnen fungeren als onvermoeibare tweede paar ogen. Ze kunnen snel:\n

- waarschijnlijke bugs, verdachte patronen, ontbrekende null‑checks of onveilige stringhandeling signaleren\n- voorstellen doen voor duidelijkere namen, refactors of eenvoudiger control flow\n- inconsistenties in formatting of duidelijke duplicatie aanwijzen\n- reviewvragen genereren (“Wat gebeurt er als deze API een lege lijst teruggeeft?”)

Gebruikt op deze manier verkort AI de tijd tussen “PR geopend” en “risico opgemerkt”.

Wat nog steeds menselijk oordeel vereist

Correctheid beoordelen gaat verder dan of code compileert. Mensen verbinden wijzigingen met echt gebruikersgedrag, productiebeperkingen en langetermijnonderhoud.

Een reviewer moet nog steeds beslissen:\n

- Wat te shippen: AI kan issues noemen, maar kan niet kiezen welke release‑blockend zijn.\n- Leesbaarheid en onderhoud: “Technisch correct” code kan nog steeds verwarrend, kwetsbaar of lastig uitbreidbaar zijn.\n- Randgevallen en omgevingsgaten: Veel fouten zijn “works on my machine”‑problemen—configuratie, datavreemdheden, concurrency of deploy‑timing. AI kan je runtime‑realiteit niet betrouwbaar afleiden.\n- Standaarden en intentie: Alleen het team kent zijn conventies en risicotolerantie. Een verandering kan nette code zijn en toch het verkeerde gedrag introduceren.

Een praktische workflow: AI als co‑reviewer

Behandel AI als een tweede reviewer, niet als eind‑goedkeurder. Vraag om een gerichte pass (security checks, randgevallen, backwards compatibility) en neem daarna een menselijke beslissing over scope, prioriteit en of de wijziging overeenkomt met teamstandaarden en productintentie.

Teststrategie en kwaliteits‑eigenaarschap

AI‑codeassistenten kunnen snel tests genereren, maar ze bezitten geen kwaliteit. Een test‑suite is een reeks weddenschappen over wat kan breken, wat nooit mag breken en wat je bereid bent te releasen zonder elk randgeval te bewijzen. Die weddenschappen zijn product‑ en engineeringbeslissingen—door mensen te maken.

AI kan tests opstellen; mensen stellen de doelen

Assistants zijn goed in unit‑testscaffolding, dependencies mocken en “happy path” coverage op basis van implementatie. Wat ze niet betrouwbaar doen is beslissen welke coverage telt.

Mensen bepalen:\n

- welke modules diepe coverage nodig hebben omdat ze safety‑kritisch of vaak gewijzigd zijn\n- wat “klaar” betekent voor een riskante refactor versus een kleine bugfix\n- wanneer te investeren in regressietests versus monitoring en rollback‑plannen

De juiste mix van testtypes kiezen

De meeste teams hebben een gelaagde strategie nodig, niet simpelweg “meer tests”. AI kan veel daarvan schrijven, maar de keuze en grenzen blijven menselijk:\n

- Unit tests voor bedrijfsregels en lastige randgevallen\n- Integratietests voor database/queue/service interacties\n- End‑to‑end tests voor kritieke gebruikerspaden (weinig, stabiel, hoge waarde)\n- Contracttests om API‑compatibiliteit tussen teams/diensten te bewaren\n- Performancetests om latency en kosten onder load te beschermen

Flaky tests en valse zekerheid vermijden

AI‑gegenereerde tests volgen vaak de code te nauw, wat leidt tot fragiele assertions of over‑gemockte setups die slagen terwijl het echte gedrag faalt. Ontwikkelaars voorkomen dit door:\n

- observeerbaar gedrag te testen, niet interne implementatiedetails\n- deterministische data te gebruiken en tijd, willekeur en netwerk te controleren\n- falen te reviewen om te bepalen: echte bug, testbug of omgevingsprobleem

Strategie afstemmen op risico en releaserytme

Een goede strategie past bij hoe je uitrolt. Snellere releases vragen sterkere automatische checks en duidelijke rollback‑paden; langzamere releases kunnen zwaardere pre‑merge validatie verdragen. De kwaliteits‑eigenaar is het team, niet het gereedschap.

Uitkomsten meten die ertoe doen

Kwaliteit is geen dekkingspercentage. Meet of testen leidt tot betere uitkomsten: minder productie‑incidenten, snellere herstelmiddelen en veiliger uitrol (minder rollbacks, snellere vertrouwde deploys). AI versnelt werk, maar verantwoordelijk blijft bij ontwikkelaars.

Beveiliging, privacy en complianceverantwoordelijkheden

Beveiligingswerk gaat minder over code genereren en meer over het maken van afwegingen binnen echte beperkingen. AI kan checklists en veelvoorkomende fouten aanreiken, maar de verantwoordelijkheid voor risicokeuzes blijft bij het team.

Threat‑modeling heeft context nodig

Threat‑modeling is geen generieke oefening—wat telt hangt af van je businessprioriteiten, gebruikers en faalwijzen. Een assistent kan typische dreigingen voorstellen (injection, gebroken auth, onveilige defaults), maar het weet niet welke incidenten echt kostbaar zijn voor jouw product: accountovername vs. datalek vs. dienstonderbreking, of welke assets juridisch gevoelig zijn.

App‑specifieke risico’s zijn geen patroon

AI is goed in bekende antipatronen herkennen, maar veel incidenten komen door app‑specifieke details: een permissie‑randgeval, een “tijdelijke” admin‑endpoint of een workflow die per ongeluk goedkeuringen omzeilt. Die risico’s vereisen het lezen van de intentie van het systeem, niet alleen de code.

Geheimen, permissies en retentie zijn bewuste keuzes

Tools kunnen je eraan herinneren geen keys hard te coderen, maar ze nemen geen volledig beleid over:\n

- waar geheimen leven (vault, CI, runtime) en hoe ze roteren\n- least‑privilege rollen en access‑reviews\n- dataretentie: wat je opslaat, hoe lang en wie het kan exporteren

Afhankelijkheden en supply‑chain risico

AI kan verouderde libraries aanwijzen, maar teams moeten praktijken hebben: versies pinnen, herkomst verifiëren, transitive dependencies reviewen en beslissen wanneer risico acceptabel is versus wanneer te investeren in mitigatie.

Compliance en audits vereisen bewijs

Compliance is niet “encryptie toevoegen.” Het zijn controles, documentatie en verantwoording: toegangslogs, goedkeuringssporen, incidentprocedures en bewijs dat je ze hebt gevolgd. AI kan templates opstellen, maar mensen moeten het bewijsmateriaal valideren en ondertekenen—want daar vertrouwen auditors en klanten op.

Operaties, betrouwbaarheid en incidentresponse

AI kan ops‑werk versnellen, maar het neemt geen eigendom over. Betrouwbaarheid is een keten van beslissingen onder onzekerheid, en de kosten van een verkeerde keuze zijn meestal hoger dan de kosten van een trage keuze.

Waar AI helpt in het dagelijkse werk

AI is nuttig voor het opstellen en onderhouden van operationele artifacts—runbooks, checklists en "als X dan Y" playbooks. Het kan ook logs samenvatten, vergelijkbare alerts clusteren en eerste hypothesen voorstellen.

Voor betrouwbaarheid vertaalt dat zich in snellere iteratie op:\n

- monitoringdashboards en alertbeschrijvingen\n- capacity‑notities en schaalheuristieken\n- error‑budget rapportagetemplates

Dit zijn sterke versnellers, maar ze zijn niet het werk zelf.

De onderdelen die menselijk blijven

Incidenten volgen zelden het script. On‑call engineers hebben te maken met onduidelijke signalen, gedeeltelijke uitval en rommelige afwegingen terwijl de klok tikt. AI kan waarschijnlijke oorzaken noemen, maar kan niet betrouwbaar beslissen of je een ander team moet pagineren, een feature uitschakelen of tijdelijke klantimpact accepteren om data‑integriteit te bewaren.

Deployveiligheid blijft mensenwerk. Tools kunnen rollbacks, feature flags of gefaseerde releases aanraden, maar teams moeten het veiligste pad kiezen gezien businesscontext en blast radius.

Postmortems: leren is het doel

AI kan tijdlijnen opstellen en sleutelgebeurtenissen uit chat, tickets en monitoring halen. Mensen doen nog steeds het kritieke werk: bepalen wat “goed” leren is, fixes prioriteren en veranderingen doorvoeren die herhaling voorkomen (niet alleen hetzelfde symptoom aanpakken).

Als je AI gebruikt als co‑piloot voor ops‑papierwerk en patroonherkenning—niet als incidentcommandant—krijg je snelheid zonder aansprakelijkheid op te geven.

Teamcommunicatie, mentoring en eigenaarschap

AI kan concepten helder en op verzoek uitleggen: “Wat is CQRS?”, “Waarom treedt deze deadlock op?”, “Vat deze PR samen.” Dat helpt teams sneller te handelen. Maar werkcommunicatie gaat niet alleen over informatieoverdracht—het gaat over vertrouwen opbouwen, gedeelde gewoonten vestigen en toezeggingen doen waarop mensen kunnen rekenen.

Onboarding: meer dan documentatie

Nieuwe ontwikkelaars hebben niet alleen antwoorden nodig; ze hebben context en relaties nodig. AI kan modules samenvatten, leerroutes voorstellen en jargon vertalen. Mensen moeten nog steeds uitleggen wat hier telt: welke afwegingen het team prefereren, wat “goed” is in deze codebase en wie te benaderen als iets vreemd voelt.

Afstemming tussen rollen

De meeste frictie ontstaat tussen rollen: product, design, QA, security, support. AI kan notulen opstellen, acceptatiecriteria voorstellen of feedback neutraler herformuleren. Mensen moeten nog steeds prioriteiten onderhandelen, ambiguïteit oplossen en aanvoelen wanneer een stakeholder “akkoord” zegt zonder het echt te menen.

Definitie van klaar en eigenschapsgrenzen

Teams falen wanneer verantwoordelijkheid vaag is. AI kan checklists genereren, maar afdwingen kan het niet. Mensen moeten definiëren wat “klaar” betekent (tests? docs? rollout‑plan? monitoring?) en wie wat na merge bezit—vooral wanneer AI‑gegenereerde code complexiteit verbergt.

Checklist: verantwoord AI‑gebruik in teamworkflows

- Maak gebruik van AI inzichtelijk wanneer het beslissingen, schattingen of geauthoriseerde code beïnvloedt.\n- Verifieer feiten: links, API’s, securityclaims en “best practices” voordat je ze deelt.\n- Houd prompts vrij van geheimen (sleutels, klantdata, incidentdetails).\n- Behandel AI‑outputs als drafts; wijs voor elke beslissing een menselijke eigenaar aan.\n- Leg teamnormen vast: wanneer AI is toegestaan, wanneer niet, en evalueer verwachtingen.\n- Geef de voorkeur aan kleine, reviewbare wijzigingen—vermijd “big bang” AI‑refactors.