29 mrt 2025·7 min

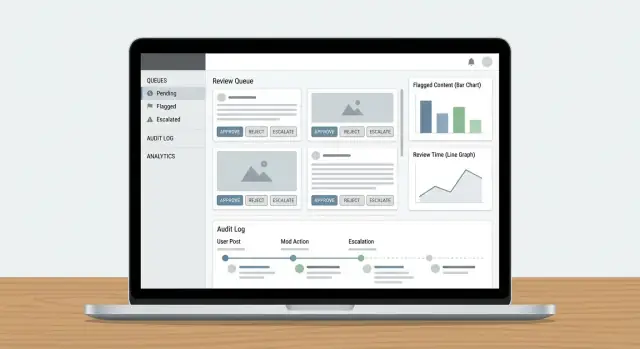

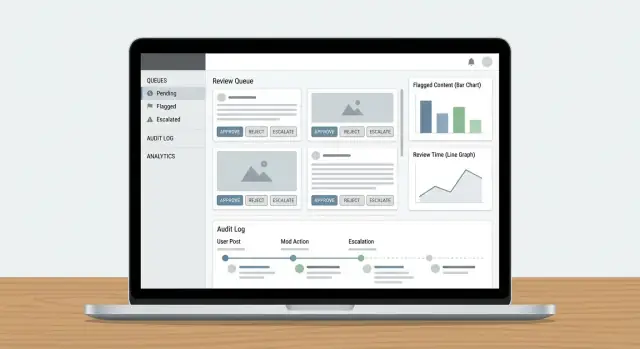

Een webapp bouwen voor contentmoderatie-workflows

Leer hoe je een webapp ontwerpt en bouwt voor contentmoderatie: wachtrijen, rollen, beleidsregels, escalatie, auditlogs, analytics en veilige integraties.

Leer hoe je een webapp ontwerpt en bouwt voor contentmoderatie: wachtrijen, rollen, beleidsregels, escalatie, auditlogs, analytics en veilige integraties.

Voordat je een contentmoderatie-workflow ontwerpt, bepaal wat je precies gaat modereren en wat “goed” betekent. Een duidelijke scope voorkomt dat je moderatiewachtrij volloopt met randgevallen, duplicaten en verzoeken die er niet thuishoren.

Schrijf alle contenttypen op die risico of schade aan gebruikers kunnen veroorzaken. Veelvoorkomende voorbeelden zijn door gebruikers gemaakte tekst (reacties, posts, reviews), afbeeldingen, video, livestreams, profielvelden (namen, bio's, avatars), directe berichten, communitygroepen en marktplaatsvermeldingen (titels, omschrijvingen, foto’s, prijzen).

Noteer ook de bronnen: gebruikersinzendingen, geautomatiseerde imports, bewerkingen van bestaande items en meldingen door andere gebruikers. Dat voorkomt dat je een systeem bouwt dat alleen voor “nieuwe posts” werkt en edits, heruploads of DM-misbruik mist.

De meeste teams balanceren vier doelen:

Wees expliciet over welk doel per gebied primair is. Bijvoorbeeld: bij hoog-ernstige misbruikgevallen kan snelheid voorrang krijgen boven perfecte consistentie.

Maak een lijst van alle uitkomsten die je product nodig heeft: goedkeuren, afwijzen/verwijderen, bewerken/redigeren, labelen/age-gaten, zichtbaarheid beperken, onder beoordeling plaatsen, escaleren naar een lead en accountniveau-acties zoals waarschuwingen, tijdelijke locks of bans.

Definieer meetbare doelen: mediaan en 95e percentiel reviewtijd, backloggrootte, omkeerpercentage bij beroep, beleidsnauwkeurigheid uit QA-steekproeven en het percentage hoog-ernstige items dat binnen een SLA is afgehandeld.

Betrek moderators, teamleads, beleid, support, engineering en legal. Onenigheid hier veroorzaakt later extra werk—vooral rond wat “escalatie” betekent en wie de uiteindelijke beslissingen neemt.

Voordat je schermen en wachtrijen bouwt, schets je de volledige levenscyclus van een enkel contentitem. Een helder workflowmodel voorkomt “mystery states” die reviewers verwarren, notificaties breken en audits pijnlijk maken.

Begin met een simpel, end-to-end statemodel dat je in een diagram en in je database kunt zetten:

Submitted → Queued → In review → Decided → Notified → Archived

Houd staten wederzijds exclusief en definieer welke transities toegestaan zijn (en door wie). Bijvoorbeeld: “Queued” mag alleen naar “In review” gaan wanneer toegewezen, en “Decided” moet onveranderlijk zijn behalve via een beroepstraject.

Geautomatiseerde classifiers, keywordmatches, rate limits en gebruikersmeldingen moeten als signalen worden behandeld, niet als beslissingen. Een "mens-in-de-lus" ontwerp houdt het systeem eerlijk:

Deze scheiding maakt het ook makkelijker om modellen later te verbeteren zonder beleidslogica te herschrijven.

Beslissingen zullen worden betwist. Voeg eersteklas flows toe voor:

Modelleer bezwaren als nieuwe reviewevents in plaats van het bewerken van de geschiedenis. Zo kun je het volledige verhaal vertellen van wat er is gebeurd.

Voor audits en geschillen, definieer welke stappen met timestamps en actoren moeten worden vastgelegd:

Als je later een beslissing niet kunt uitleggen, moet je aannemen dat deze niet heeft plaatsgevonden.

Een moderatietool leeft of sterft op toegangscontrole. Als iedereen alles kan doen, krijg je inconsistente beslissingen, per ongeluk datalekken en geen duidelijke verantwoordelijkheid. Begin met rollen die overeenkomen met hoe je trust & safety-team werkelijk werkt en vertaal die naar permissies die je app kan afdwingen.

De meeste teams hebben een klein aantal duidelijke rollen nodig:

Deze scheiding helpt voorkomen dat beleid per ongeluk wordt veranderd en houdt beleidsbeheer los van dagelijkse handhaving.

Implementeer rolgebaseerde toegangscontrole zodat elke rol alleen krijgt wat nodig is:

can_apply_outcome, can_override, can_export_data) in plaats van per pagina.Als je later nieuwe functies toevoegt (exports, automatiseringen, derdepartij-integraties), kun je ze aan permissies koppelen zonder je hele organisatiestructuur te herdefiniëren.

Plan vroeg voor meerdere teams: taalpods, regiogroepen of aparte lijnen voor verschillende producten. Modelleer teams expliciet en scope daarna wachtrijen, contentzichtbaarheid en toewijzingen per team. Dit voorkomt cross-region reviews en houdt workloads per groep meetbaar.

Admins moeten soms gebruikers impersoneren om toegang te debuggen of een reviewerprobleem te reproduceren. Behandel impersonatie als een gevoelige actie:

Voor onomkeerbare of high-risk acties, voeg admin-goedkeuring toe (of twee-personen review). Die kleine friction beschermt tegen fouten en insider-misbruik, terwijl routine-moderatie snel blijft.

Wachtrijen maken moderatiewerk beheersbaar. In plaats van één eindeloze lijst, splits werk in wachtrijen die risico, urgentie en intentie reflecteren—en zorg dat items niet tussen de mazen vallen.

Begin met een klein aantal wachtrijen die passen bij hoe je team daadwerkelijk werkt:

Houd wachtrijen waar mogelijk wederzijds exclusief en gebruik tags voor secundaire attributen.

Binnen elke wachtrij definieer je scoringsregels die bepalen wat bovenaan komt:

Maak prioriteiten uitlegbaar in de UI (“Waarom zie ik dit?”) zodat reviewers de ordening vertrouwen.

Gebruik claiming/locking: wanneer een reviewer een item opent, wordt het aan hen toegewezen en verborgen voor anderen. Voeg een timeout toe (bijv. 10–20 minuten) zodat achtergelaten items terugkeren naar de wachtrij. Log altijd claim-, release- en completion-events.

Als het systeem snelheid beloont, kiezen reviewers mogelijk snelle gevallen en vermijden moeilijke. Tegengaan door:

Het doel is consistente dekking, niet alleen hoge throughput.

Een moderatiebeleid dat alleen als PDF bestaat, wordt door elke reviewer anders geïnterpreteerd. Om beslissingen consistent (en auditeerbaar) te maken, vertaal je beleidstekst naar gestructureerde data en UI-keuzes die je workflow kan afdwingen.

Begin met het opsplitsen van beleid in een gedeelde vocabulaire die reviewers kunnen selecteren. Een nuttige taxonomie bevat meestal:

Deze taxonomie vormt later de basis voor wachtrijen, escalatie en analytics.

In plaats van reviewers elke keer een beslissing volledig te laten formuleren, bied beslissingssjablonen gekoppeld aan taxonomie-items. Een sjabloon kan vooraf invullen:

Sjablonen maken het “happy path” snel, terwijl uitzonderingen nog steeds mogelijk zijn.

Beleid verandert. Sla beleid op als versieerbare records met ingangsdata, en leg vast welke versie toegepast werd bij elke beslissing. Dit voorkomt verwarring wanneer oudere zaken worden aangevochten en zorgt dat je uitkomsten maanden later kunt uitleggen.

Vrije tekst is moeilijk te analyseren en makkelijk te vergeten. Vereis dat reviewers één of meer gestructureerde redenen kiezen (uit je taxonomie) en eventueel notities toevoegen. Gestructureerde redenen verbeteren bezwarenafhandeling, QA-sampling en trendrapportage zonder reviewers essays te laten schrijven.

Een reviewer-dashboard slaagt als het zoeken naar informatie minimaliseert en zelfverzekerde, herhaalbare beslissingen maximaliseert. Reviewers moeten kunnen begrijpen wat er gebeurde, waarom het belangrijk is en wat de volgende stap is—zonder vijf tabbladen te openen.

Toon geen geïsoleerd bericht en verwacht consistente uitkomsten. Geef een compact contextpaneel dat veelvoorkomende vragen in één oogopslag beantwoordt:

Houd de standaardweergave beknopt, met opties om uit te klappen voor diepere inspectie. Reviewers hoeven zelden het dashboard te verlaten om te beslissen.

Je actiebalk moet aansluiten op beleidsuitkomsten, niet op generieke CRUD-knoppen. Veelvoorkomende patronen zijn:

Maak acties zichtbaar en expliciet voor onomkeerbare stappen (bevestiging alleen wanneer nodig). Leg een korte reden-code vast plus optionele notities voor latere audits.

Grote volumes vragen om weinig frictie. Voeg sneltoetsen toe voor de belangrijkste acties (goedkeuren, afwijzen, volgend item, label toevoegen). Toon een sneltoetsoverzicht in de UI.

Voor repetitieve taken (bijv. eenvoudig spam) ondersteun bulkselectie met guardrails: toon een preview-aantal, vereis een reden-code en log de batchactie.

Moderatie kan reviewers blootstellen aan schadelijk materiaal. Voeg veiligheidsstandaarden toe:

Deze keuzes beschermen reviewers en houden beslissingen accuraat en consistent.

Auditlogs zijn je “single source of truth” wanneer iemand vraagt: Waarom is deze post verwijderd? Wie heeft het bezwaar goedgekeurd? Was het model of een mens die de uiteindelijke beslissing nam? Zonder traceerbaarheid worden onderzoeken giswerk en daalt het vertrouwen van reviewers snel.

Voor elke moderatieactie log je wie het deed, wat er veranderde, wanneer het gebeurde en waarom (policyreden + vrije tekstnotities). Net zo belangrijk: sla before/after snapshots op van relevante objecten—contenttekst, mediahashes, gedetecteerde signalen, labels en de uiteindelijke uitkomst. Als het item kan veranderen (bewerkingen, verwijderingen), voorkomen snapshots dat “het record” verschuift.

Een praktisch patroon is een append-only eventrecord:

{

"event": "DECISION_APPLIED",

"actor_id": "u_4821",

"subject_id": "post_99102",

"queue": "hate_speech",

"decision": "remove",

"policy_code": "HS.2",

"reason": "slur used as insult",

"before": {"status": "pending"},

"after": {"status": "removed"},

"created_at": "2025-12-26T10:14:22Z"

}

Naast beslissingen, log workflowmechanica: claimed, released, timed out, reassigned, escalated en auto-routed. Deze events verklaren “waarom het 6 uur duurde” of “waarom dit item tussen teams bounce”, en zijn essentieel om misbruik te detecteren (bijv. reviewers die alleen makkelijke items kiezen).

Geef onderzoekers filters op gebruiker, content-ID, policycode, tijdsbereik, wachtrij en actietype. Voeg export naar een casebestand toe, met onveranderlijke timestamps en verwijzingen naar gerelateerde items (duplicaten, heruploads, bezwaren).

Stel duidelijke retentiewindows in voor auditevents, snapshots en reviewnotities. Maak het beleid expliciet (bijv. 90 dagen voor routinematige wachtrijlogs, langer voor juridische houdingen) en documenteer hoe redactie- of verwijderverzoeken opgeslagen bewijsmateriaal beïnvloeden.

Een moderatietool is alleen nuttig als het de cirkel sluit: meldingen worden reviewtaken, beslissingen bereiken de juiste mensen en accountacties worden consequent uitgevoerd. Hier falen veel systemen—iemand ruimt de wachtrij op, maar verder verandert er niets.

Behandel gebruikersmeldingen, geautomatiseerde flags (spam/CSAM/hashmatches/toxicity-signalen) en interne escalaties (support, community managers, legal) als hetzelfde kernobject: een report dat één of meer reviewtaken kan creëren.

Gebruik een enkele report-router die:

Als support-escalaties deel van de flow zijn, koppel ze direct (bijv. /support/tickets/1234) zodat reviewers niet hoeven te wisselen van context.

Moderatiebesluiten moeten templated notificaties genereren: content verwijderd, waarschuwing uitgegeven, geen actie of accountactie uitgevoerd. Houd berichten consistent en beknopt—leg de uitkomst uit, verwijs naar het relevante beleid en geef bezwaarinstructies.

Operationeel: stuur notificaties via een event zoals moderation.decision.finalized, zodat e-mail/in-app/push zich kunnen abonneren zonder de reviewer te vertragen.

Beslissingen vereisen vaak acties buiten één stuk content:

Maak deze acties expliciet en omkeerbaar, met duidelijke duur en redenen. Koppel elke actie terug aan de beslissing en onderliggende melding voor traceerbaarheid, en bied een snelle route naar bezwaren zodat beslissingen kunnen worden herzien zonder handmatig speurwerk.

Je datamodel is de “single source of truth” voor wat er met elk item gebeurde: wat is beoordeeld, door wie, onder welk beleid en wat het resultaat was. Als je deze laag goed krijgt, worden wachtrijen, dashboards, audits en analytics veel eenvoudiger.

Vermijd alles in één record opslaan. Een praktisch patroon is om te bewaren:

HARASSMENT.H1 of NUDITY.N3, opgeslagen als referenties zodat beleid kan evolueren zonder geschiedenis te herschrijven.Dit houdt beleidshandhaving consistent en maakt rapportage helderder (bijv. “top overtreden policycodes deze week”).

Stop geen grote afbeeldingen/video's rechtstreeks in je database. Gebruik object storage en bewaar alleen object keys + metadata in je contenttabel.

Voor reviewers genereer je kortlopende signed URLs zodat media toegankelijk is zonder publiek te worden. Signed URLs laten je ook expiratie regelen en toegang intrekken indien nodig.

Wachtrijen en onderzoeken hebben snelle zoekopdrachten nodig. Voeg indexen toe voor:

Modelleer moderatie als expliciete staten (bijv. NEW → TRIAGED → IN_REVIEW → DECIDED → APPEALED). Sla state transition events op (met timestamps en actor) zodat je items kunt detecteren die niet vooruitgaan.

Een eenvoudige safeguard: een last_state_change_at veld plus alerts voor items die een SLA overschrijden, en een repair job die items opnieuw in de wachtrij plaatst als ze te lang IN_REVIEW staan.

Trust & Safety-tools verwerken vaak de meest gevoelige data van je product: gebruikerscontent, meldingen, accountidentifiers en soms juridische verzoeken. Behandel de moderatie-app als een high-risk systeem en ontwerp beveiliging en privacy vanaf dag één.

Begin met sterke authenticatie en strakke sessiecontroles. Voor de meeste teams betekent dat:

Combineer dit met rolgebaseerde toegangscontrole zodat reviewers alleen zien wat ze nodig hebben (bijv. één wachtrij, één regio of één contenttype).

Versleutel data in transit (HTTPS overal) en at rest (beheerde database/storage-encryptie). Richt je daarna op blootstellingsminimalisatie:

Als je toestemming of speciale datacategorieën verwerkt, maak die flags zichtbaar voor reviewers en handhaaf ze in de UI (bijv. beperkte weergave of retentieregels).

Rapportage- en bezwaarendpoints zijn veeldoelwitten voor spam en misbruik. Voeg toe:

Maak ten slotte elke gevoelige actie traceerbaar met een audittrail zodat je reviewerfouten, gecompromitteerde accounts of gecoördineerd misbruik kunt onderzoeken.

Begin met het opschrijven van elke contentsoort die je gaat behandelen (posts, reacties, DMs, profielen, listings, media), plus elke bron (nieuwe inzendingen, bewerkingen, imports, gebruikersmeldingen, geautomatiseerde flags). Bepaal vervolgens wat buiten scope valt (bijv. interne admin-notities, systeemgegenereerde content) zodat je wachtrij geen afvoerputje wordt.

Een praktische toets: als je de contentsoort, bron en eigenaarsteam niet duidelijk kunt benoemen, zou het waarschijnlijk nog geen moderatietaak moeten aanmaken.

Kies een klein setje operationele KPI's die zowel snelheid als kwaliteit weerspiegelen:

Stel doelen per wachtrij (bijv. high-risk vs. backlog) zodat je niet per ongeluk lage-urgentiewerk optimaliseert terwijl schadelijke content blijft liggen.

Gebruik een simpele, expliciete statemachine en handhaaf toegestane overgangen, bijvoorbeeld:

SUBMITTED → QUEUED → IN_REVIEW → DECIDED → NOTIFIED → ARCHIVEDMaak staten wederzijds exclusief, en behandel “Decided” als onveranderlijk behalve via een appeal/re-review flow. Dit voorkomt “mystery states”, kapotte notificaties en moeilijk te auditen bewerkingen.

Behandel geautomatiseerde systemen als signalen, niet als definitieve uitkomsten:

Dit houdt beleidshandhaving uitlegbaar en maakt het later makkelijker om modellen te verbeteren zonder je beslislogica te herschrijven.

Maak bezwaren tot eersteklas objecten gelinkt aan de oorspronkelijke beslissing:

Begin met een klein, duidelijk RBAC-set:

Gebruik meerdere wachtrijen met duidelijke ‘home’-ownership:

Prioriteer binnen een wachtrij met uitlegbare signalen zoals ernst, bereik, unieke reporters en SLA-timers. In de UI: toon “Waarom zie ik dit?” zodat reviewers de volgorde vertrouwen en je gaming kunt opsporen.

Implementeer claiming/locking met timeouts:

Dit vermindert dubbele inspanning en geeft data om knelpunten en cherry-picking te analyseren.

Zet je beleid om in een gestructureerde taxonomie en sjablonen:

Dit verhoogt consistentie, maakt analytics zinnig en vereenvoudigt audits en bezwaren.

Log alles wat nodig is om het verhaal te reconstrueren:

Maak logs doorzoekbaar op actor, content-ID, policycode, wachtrij en tijdsperiode, en definieer retentieregels (inclusief juridische houdingen en hoe verwijderverzoeken opgeslagen bewijsmateriaal beïnvloeden).

Leg altijd vast welke versie van het beleid oorspronkelijk werd toegepast en welke versie tijdens het bezwaar wordt gebruikt.

Voeg daarna least-privilege permissies per capaciteit toe (bijv. can_export_data, can_apply_account_penalty) zodat nieuwe functies je toegangsmodel niet breken.