29 apr 2025·8 min

Hoe je een webapp bouwt voor prijsexperimenten

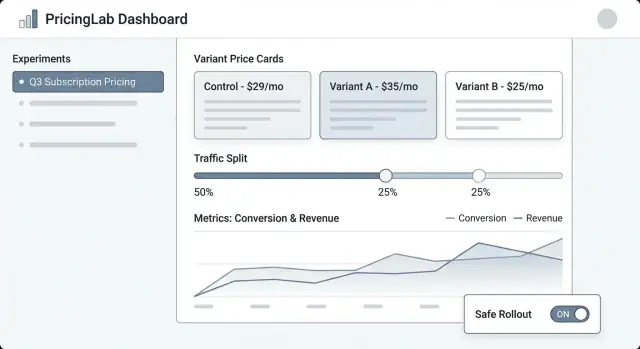

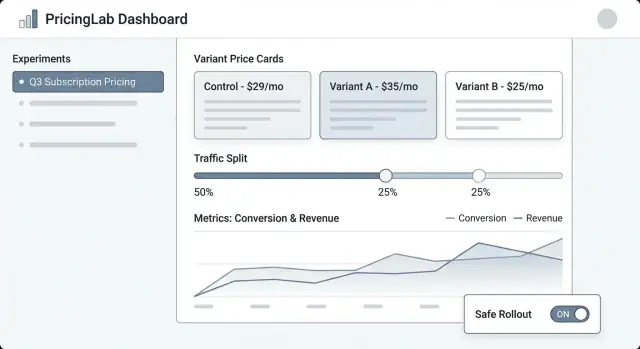

Plan, ontwerp en lever een webapp om prijsexperimenten te beheren: varianten, traffic splits, toewijzing, metrics, dashboards en veilige rollout-guardrails.

Plan, ontwerp en lever een webapp om prijsexperimenten te beheren: varianten, traffic splits, toewijzing, metrics, dashboards en veilige rollout-guardrails.

Prijsexperimenten zijn gestructureerde tests waarbij je verschillende prijzen (of verpakking) aan verschillende groepen klanten toont en meet wat er verandert—conversie, upgrades, churn, omzet per bezoeker en meer. Het is de prijsversie van een A/B-test, maar met extra risico: een fout kan klanten verwarren, supporttickets veroorzaken of interne regels schenden.

Een pricing experiment manager is het systeem dat deze tests beheersbaar, observeerbaar en omkeerbaar houdt.

Controle: Teams hebben één plek nodig om te definiëren wat er getest wordt, waar en voor wie. “We hebben de prijs veranderd” is geen plan—een experiment heeft een duidelijke hypothese, data, targetingregels en een kill switch.

Tracking: Zonder consistente identifiers (experiment key, variant key, toewijzingstijdstempel) wordt analyseren giswerk. De manager moet ervoor zorgen dat elke exposure en aankoop aan de juiste test te relateren is.

Consistentie: Klanten mogen niet één prijs op de prijspagina zien en een andere bij checkout. De manager moet coördineren hoe varianten over oppervlakken worden toegepast zodat de ervaring coherent is.

Veiligheid: Prijsfouten zijn kostbaar. Je hebt guardrails nodig zoals traffic-limieten, eligibility-regels (bijv. alleen nieuwe klanten), goedkeuringsstappen en auditbaarheid.

Dit artikel richt zich op een interne webapp die experimenten beheert: het aanmaken ervan, toewijzen van varianten, verzamelen van events en rapporteren van resultaten.

Het is niet een volledige pricing-engine (belastingberekening, facturatie, multicurrency-catalogi, proratie, enz.). In plaats daarvan is het het controlpanel en de trackinglaag die prijstesten veilig genoeg maakt om regelmatig uit te voeren.

Een pricing experiment manager is alleen nuttig als duidelijk is wat hij wel—en niet—doet. Strakke scope houdt het product makkelijk te gebruiken en veiliger om uit te rollen, vooral wanneer er echte omzet op het spel staat.

Minimaal moet je webapp een niet-technische operator in staat stellen een experiment end-to-end uit te voeren:

Als je niets anders bouwt, bouw deze goed—met duidelijke defaults en guardrails.

Bepaal vroeg welke experimentformaten je gaat ondersteunen zodat UI, datamodel en toewijzingslogica consistent blijven:

Wees expliciet om “scope creep” te voorkomen die een experimenttool verandert in een kwetsbaar bedrijfskritisch systeem:

Definieer succes in operationele termen, niet alleen statistisch:

Een pricing experimentapp leeft of sterft door zijn datamodel. Als je niet betrouwbaar kunt beantwoorden “welke prijs zag deze klant en wanneer?”, zullen je metrics ruis bevatten en verliest je team vertrouwen.

Begin met een kleine set kernobjecten die aansluiten bij hoe pricing werkelijk werkt in je product:

Gebruik stabiele identifiers over systemen heen (product_id, plan_id, customer_id). Vermijd “mooie namen” als keys—die veranderen.

Tijdvelden zijn net zo belangrijk:

Overweeg ook effective_from / effective_to op Price-records zodat je prijzen op elk moment in de tijd kunt reconstrueren.

Definieer relaties expliciet:

In de praktijk betekent dit dat een Event customer_id, experiment_id en variant_id moet bevatten (of joinbaar moet zijn). Als je alleen customer_id opslaat en later de assignment opzoekt, loop je het risico op foute joins wanneer toewijzingen veranderen.

Prijsexperimenten vragen om een audit-vriendelijke geschiedenis. Maak sleutelrecords append-only:

Deze aanpak houdt je rapportage consistent en maakt governance-functies zoals auditlogs later gemakkelijk.

Een pricing experiment manager heeft een duidelijke lifecycle nodig zodat iedereen begrijpt wat bewerkbaar is, wat vergrendeld is en wat er met klanten gebeurt als de experimentstatus verandert.

Draft → Scheduled → Running → Stopped → Analyzed → Archived

Om risico’s bij lancering te verminderen, dwing vereiste velden af naarmate het experiment vordert:

Voor pricing voeg optionele poorten toe voor Finance en Legal/Compliance. Alleen approvers mogen Scheduled → Running zetten. Als je overrides ondersteunt (bijv. urgente rollback), leg vast wie overruled, waarom en wanneer in een auditlog.

Wanneer een experiment Stopped is, definieer twee expliciete gedragingen:

Maak dit een verplichte keuze bij het stoppen zodat het team niet zomaar een experiment stopt zonder de klantimpact te beslissen.

Het correct krijgen van toewijzing is het verschil tussen een betrouwbaar prijsexperiment en ruis. Je app moet het gemakkelijk maken te definiëren wie een prijs krijgt en ervoor zorgen dat ze die consequent blijven zien.

Een klant moet dezelfde variant zien over sessies, apparaten (waar mogelijk) en refreshes. Dat betekent dat toewijzing deterministisch moet zijn: gegeven dezelfde assignment key en experiment is het resultaat altijd hetzelfde.

Veelvoorkomende benaderingen:

(experiment_id + assignment_key) en map die naar een variant.Veel teams gebruiken standaard hash-based assignment en slaan toewijzingen alleen op wanneer dat nodig is (voor supportcases of governance).

Je app moet meerdere keys ondersteunen, omdat pricing user-level of account-level kan zijn:

user_id na signup/login.Die upgrade-path is belangrijk: als iemand anoniem browse en later een account aanmaakt, moet je beslissen of je hun oorspronkelijke variant behoudt (continuïteit) of ze herverdeelt (schonere identiteitregels). Maak dit een duidelijke, expliciete instelling.

Ondersteun flexibele allocatie:

Bij ramp-ups moeten toewijzingen sticky blijven: meer traffic toevoegen moet nieuwe gebruikers aan het experiment toevoegen, niet bestaande herschikken.

Gelijktijdige tests kunnen botsen. Bouw guardrails voor:

Een duidelijke “Assignment preview” scherm (gegeven een voorbeeld user/account) helpt niet-technische teams de regels te verifiëren voor lancering.

Prijsexperimenten mislukken het meest op de integratielaag—niet omdat de experimentlogica fout is, maar omdat het product de ene prijs toont en de ander in rekening brengt. Je webapp moet heel expliciet maken “wat de prijs is” en “hoe het product die gebruikt”.

Behandel prijsdefinitie als de bron van waarheid (de prijsregels van de variant, geldigheidsdatums, valuta, belastingafhandeling, enz.). Behandel prijslevering als een eenvoudige mechaniek om de geselecteerde variantprijs op te halen via een API-endpoint of SDK.

Deze scheiding houdt het experimentbeheer schoon: niet-technische teams bewerken definities, engineers integreren een stabiel delivery-contract zoals GET /pricing?sku=....

Er zijn twee veelvoorkomende patronen:

Een praktische aanpak is “weergeven op client, verifiëren en berekenen op server,” met dezelfde experimenttoewijzing.

Varianten moeten dezelfde regels volgen voor:

Sla deze regels op naast de prijs zodat elke variant vergelijkbaar en finance-vriendelijk is.

Als de experimentservice traag of down is, moet je product een veilige standaardprijs teruggeven (meestal de huidige baseline). Definieer timeouts, caching en een duidelijk “fail closed” beleid zodat checkout niet faalt—en log fallbacks zodat je de impact kunt kwantificeren.

Prijsexperimenten leven of sterven door meting. Je webapp moet het moeilijk maken om “ship and hope” te doen door vóór lancering duidelijke beslissingsmetriek, schone events en een consistente attributiebenadering te eisen.

Begin met één of twee metrics die je gebruikt om de winnaar te bepalen. Veelvoorkomende prijskeuzes:

Een handige regel: als teams na de test nog ruzie hebben over het resultaat, had je waarschijnlijk de beslissingsmetriek niet duidelijk genoeg gedefinieerd.

Guardrails vangen schade die een hogere prijs kan veroorzaken, zelfs als kortetermijnomzet goed lijkt:

Je app kan guardrails afdwingen door drempels te vereisen (bijv. “refund rate mag niet met meer dan 0.3% stijgen”) en door overtredingen duidelijk op de experimentpagina te tonen.

Minimaal moet je tracking stabiele identifiers voor experiment en variant bevatten op elk relevant event.

{

"event": "purchase_completed",

"timestamp": "2025-01-15T12:34:56Z",

"user_id": "u_123",

"experiment_id": "exp_earlybird_2025_01",

"variant_id": "v_price_29",

"currency": "USD",

"amount": 29.00

}

Maak deze eigenschappen verplicht bij ingestie, niet “best effort.” Als een event binnenkomt zonder experiment_id/variant_id, routeer het naar een “unattributed” bucket en markeer dat als datakwaliteitsprobleem.

Prijsuitkomsten zijn vaak vertraagd (vernieuwingen, upgrades, churn). Definieer:

Dit houdt teams aligned over wanneer een resultaat betrouwbaar is—en voorkomt voortijdige beslissingen.

Een pricing experiment tool werkt alleen als productmanagers, marketeers en finance zonder steeds een engineer te bellen ermee kunnen werken. De UI moet snel drie vragen beantwoorden: Wat draait er? Wat verandert voor klanten? Wat is er gebeurd en waarom?

Experimentlijst moet aanvoelen als een operatie-dashboard. Toon: naam, status (Draft/Scheduled/Running/Paused/Ended), start/einddata, traffic split, primaire metric en owner. Voeg een zichtbare “laatst bijgewerkt door” en timestamp toe zodat mensen vertrouwen hebben in wat ze zien.

Experimentdetail is de thuisbasis. Zet een compact overzicht bovenaan (status, data, doelgroep, split, primaire metric). Daaronder tabs zoals Varianten, Targeting, Metrics, Change log en Results.

Variant-editor moet eenvoudig en opinionated zijn. Elke variantregel moet prijs (of prijsregel), valuta, factureringsperiode en een beschrijving in gewoon Nederlands bevatten (“Jaarabonnement: $120 → $108”). Maak het moeilijk om per ongeluk een live variant te bewerken door bevestiging te vereisen.

Results view moet leiden met de beslissing, niet alleen grafieken: “Variant B verhoogde checkoutconversie met 2.1% (95% CI …).” Geef daarna ondersteunende drilldowns en filters.

Gebruik consistente statusbadges en toon een tijdlijn met sleuteldata. Toon de traffic split als percentage en als balk. Voeg een “Wie heeft wat veranderd” paneel (of tab) toe met edits aan varianten, targeting en metrics.

Voordat Start toegestaan wordt, eis: minstens één primaire metric geselecteerd, ten minste twee varianten met geldige prijzen, een gedefinieerd ramp-plan (optioneel maar aanbevolen) en een rollback-plan of fallbackprijs. Als iets mist, toon actiegerichte fouten (“Voeg een primaire metric toe om resultaten te activeren”).

Bied veilige, prominente acties: Pause, Stop, Ramp up (bijv. 10% → 25% → 50%), en Duplicate (kopieer instellingen naar een nieuwe Draft). Voor risicovolle acties gebruik confirmaties die impact samenvatten (“Pauzeren bevriest toewijzingen en stopt exposure”).

Als je workflows (Draft → Scheduled → Running) wilt valideren voordat je volledig bouwt, kan een vibe-coding platform zoals Koder.ai je helpen snel een interne webapp op te zetten vanuit een chat-spec—en daarna snel itereren met rolgebaseerde schermen, auditlogs en eenvoudige dashboards. Het is vooral nuttig voor vroege prototypes waarbij je een werkende React UI en een Go/PostgreSQL-backend wilt hebben die je later kunt exporteren en hardenen.

Een pricing experiment dashboard moet één vraag snel beantwoorden: “Moeten we deze prijs houden, terugdraaien of verder leren?” De beste rapportage is niet de fraaiste—het is diegene die het makkelijkst te vertrouwen en te verklaren is.

Begin met een kleine set trendcharts die automatisch updaten:

Onder de grafieken, zet een variantvergelijkingstabel: variantnaam, traffic share, bezoekers, aankopen, conversieratio, omzet per bezoeker en de delta vs control.

Voor vertrouwenindicatoren, vermijd academische bewoording. Gebruik platte labels zoals:

Een korte tooltip kan uitleggen dat vertrouwen toeneemt met sample size en tijd.

Prijs wint vaak overall maar faalt voor belangrijke groepen. Maak segmenttabs makkelijk te wisselen:

Houd overal dezelfde metrics zodat vergelijkingen consistent aanvoelen.

Voeg lichte alerts direct op het dashboard toe:

Als een alert verschijnt, toon het vermoedelijke venster en een link naar de ruwe eventstatus.

Maak rapportage draagbaar: een CSV-download voor de huidige weergave (inclusief segmenten) en een deelbare interne link naar het experimentrapport. Als nuttig, verwijs naar een korte uitleg zoals /blog/metric-guide zodat stakeholders begrijpen wat ze zien zonder een extra meeting te plannen.

Prijsexperimenten raken omzet, klantvertrouwen en vaak gereguleerde rapportage. Een simpel permissiemodel en een duidelijke audittrail verminderen per ongeluk lanceringen, eindeloze “wie heeft dit veranderd?” discussies en helpen je sneller met minder omkeren te shippen.

Houd rollen makkelijk uit te leggen en lastig te misbruiken:

Als je meerdere producten of regio’s hebt, scope dan rollen per workspace (bijv. “EU Pricing”) zodat een editor in één gebied geen impact heeft op een ander.

Je app moet elke wijziging loggen met wie, wat, wanneer, bij voorkeur met before/after-diffs. Minimale events om vast te leggen:

Maak logs doorzoekbaar en exporteerbaar (CSV/JSON), en link ze direct vanaf de experimentpagina zodat reviewers niet hoeven te zoeken. Een speciale /audit-log view helpt compliance-teams.

Behandel klantidentifiers en omzet standaard als gevoelig:

Voeg lichte notities toe aan elk experiment: de hypothese, verwachte impact, goedkeuringsrationale en een “waarom we stopten” samenvatting. Zes maanden later voorkomen deze notities het opnieuw uitvoeren van gefaalde ideeën—en maken rapportage veel geloofwaardiger.

Prijsexperimenten falen op subtiele manieren: een 50/50 split verschuift naar 62/38, één cohort ziet de verkeerde valuta, of events komen nooit in rapportage terecht. Behandel het experiment-systeem voordat echte klanten het zien als een betaalfunctie—valideer gedrag, data en faalmodi.

Begin met deterministische testcases zodat je kunt bewijzen dat de toewijzingslogica stabiel is over services en releases. Gebruik vaste inputs (customer IDs, experiment keys, salt) en assert dat dezelfde variant elke keer wordt teruggegeven.

customer_id=123, experiment=pro_annual_price_v2 -\u003e variant=B

customer_id=124, experiment=pro_annual_price_v2 -\u003e variant=A

Test daarna de distributie op schaal: genereer bijvoorbeeld 1M synthetische customer IDs en controleer dat de waargenomen split binnen een strakke tolerantie blijft (bijv. 50% ± 0.5%). Verifieer ook randgevallen zoals traffic caps (slechts 10% ingeschreven) en "holdout" groepen.

Stop niet bij “het event vuurde af.” Voeg een geautomatiseerde flow toe die een testtoewijzing maakt, een aankoop of checkout-event triggert en verifieert:

Draai dit in staging en in productie met een testexperiment dat alleen voor interne gebruikers beperkt is.

Geef QA en PMs een simpele “preview” tool: voer een customer ID (of session ID) in en zie de toegewezen variant en de exacte prijs die zou renderen. Dit vangt mismatches in afronding, valuta, belastingweergave en "verkeerd plan" issues vóór lancering.

Overweeg een veilige interne route zoals /experiments/preview die nooit echte toewijzingen verandert.

Oefen de lelijke scenario’s:

Als je niet vol vertrouwen kunt antwoorden op “wat gebeurt er als X faalt?”, ben je niet klaar om te shippEN.

Het lanceren van een pricing experiment manager gaat minder over “een scherm uitrollen” en meer over zorgen dat je blast radius kunt beheersen, gedrag snel kunt observeren en veilig kunt herstellen.

Begin met een launchpad die past bij je vertrouwen en productbeperkingen:

Behandel monitoring als een deploy-vereiste, niet als “nice to have.” Stel alerts in voor:

Maak een geschreven runbook voor operations en on-call:

Als de kernworkflow stabiel is, geef prioriteit aan upgrades die betere beslissingen mogelijk maken: targetingregels (geo, plan, klanttype), sterkere statistieken en guardrails, en integraties (datawarehouse, billing, CRM). Als je tiers of packaging aanbiedt, overweeg experimentcapaciteiten te documenteren op /pricing zodat teams begrijpen wat ondersteund wordt.

Het is een intern controlpanel en een trackinglaag voor prijstests. Het helpt teams experimenten te definiëren (hypothese, doelgroep, varianten), zorgt dat een consistente prijs op alle plekken wordt getoond, verzamelt attributie-klare events, en maakt het veilig mogelijk om tests te starten/pauzeren/stoppen met audit-trail.

Het is bewust geen volledige facturerings- of belastingmotor; het orkestreert experimenten rond je bestaande pricing/billing stack.

Een praktisch MVP bevat:

Als deze betrouwbaar zijn, kun je later itereren op rijkere targeting en rapportage.

Modelleer de kernobjecten die je het antwoord geven op: “Welke prijs zag deze klant en wanneer?” Gewoonlijk:

Vermijd het muteren van belangrijke historie: versioneer prijzen en voeg nieuwe assignment-records toe in plaats van bestaande te overschrijven.

Gebruik een lifecycle zoals Draft → Scheduled → Running → Stopped → Analyzed → Archived.

Vergrendel risicovolle velden zodra het experiment Running is (varianten, targeting, split) en eis validatie voordat je van state wisselt (metrics geselecteerd, tracking bevestigd, rollback-plan). Dit voorkomt mid-test wijzigingen die resultaten onbetrouwbaar maken en klantconsistentie breken.

Gebruik sticky assignment zodat dezelfde klant dezelfde variant blijft zien over sessies/apparaten wanneer mogelijk.

Gangbare patronen:

(experiment_id + assignment_key) naar een variantbucketVeel teams gebruiken hash-first en slaan toewijzingen alleen op wanneer governance of support dat vereist.

Kies een sleutel die past bij hoe klanten prijs ervaren:

Als je begint anoniem, beslis expliciet een “identity upgrade” regel bij signup/login (behoud de originele variant voor continuïteit vs. herverdelen voor schonere identiteit).

Behandel “Stop” als twee aparte beslissingen:

Maak de serving policy een verplichte keuze bij het stoppen zodat teams niet zomaar een test stoppen zonder de impact op klanten te erkennen.

Zorg dat dezelfde variant zowel de weergave als het afrekenen bepaalt:

Definieer ook een veilige fallback als de experiment-service traag of onbeschikbaar is (meestal baseline pricing) en log elke fallback voor zichtbaarheid.

Eis een kleine, consistente eventschema waarbij elk relevant event experiment_id en variant_id bevat.

Je definieert typisch:

Als een event binnenkomt zonder experiment/variant velden, routeer het naar een “unattributed” bucket en markeer dat als datakwaliteitsprobleem.

Gebruik een simpele rolindeling en een volledige audit trail:

Dit vermindert per ongeluk lanceringen en maakt finance/compliance reviews en latere retrospectives veel eenvoudiger.