10 nov 2025·8 min

Hoe je een website bouwt voor je product-experimentenlogboek

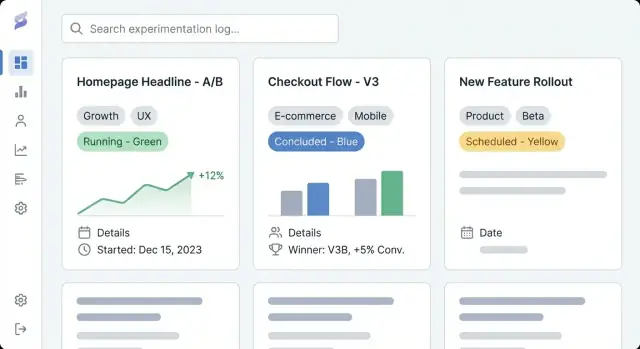

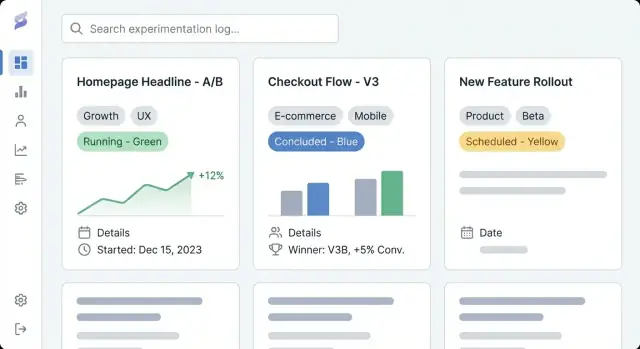

Leer hoe je een website plant, ontwerpt en lanceert om productexperimenten te documenteren met consistente items, tagging, zoeken en duidelijke resultaten.

Leer hoe je een website plant, ontwerpt en lanceert om productexperimenten te documenteren met consistente items, tagging, zoeken en duidelijke resultaten.

Een product-experimentenlogwebsite is een gedeelde plek om elk experiment van je team vast te leggen—A/B-tests, prijsproeven, aanpassingen aan onboarding, feature-flag rollouts, e-mailexperimenten en zelfs "mislukte" ideeën die nog steeds iets leerden. Zie het als een combinatie van een experimentrepository en een productleerlog: een archief van wat je probeerde, waarom je het probeerde, wat er gebeurde en welke beslissing je daarna nam.

De meeste teams hebben al fragmenten van experimenttracking verspreid over documenten, dashboards en chatgesprekken. Een toegewijde experimenttracking-website verzamelt die artefacten in een enkele, doorzoekbare geschiedenis.

De praktische uitkomsten zijn:

Deze gids richt zich op hoe je een website bouwt die experimentdocumentatie makkelijk maakt om te creëren en te gebruiken. We behandelen hoe je structuur en navigatie plant, een data-model voor experimentitems definieert (zodat items consistent blijven), leesbare paginatemplates maakt, tagging en zoeken opzet voor snelle ontdekking, en de juiste implementatiebenadering kiest (CMS versus custom app).

Aan het einde heb je een helder plan voor een A/B-testdocumentatiesite die de dagelijkse productwerkstroom ondersteunt—het vastleggen van hypothesen, metrics en resultaatsrapportage en beslissingen op een manier die doorzoekbaar, betrouwbaar en nuttig is in de tijd.

Voordat je tools kiest of experimentsjablonen ontwerpt, wees duidelijk waarom deze experimenttracking-website bestaat en voor wie hij bedoeld is. Een product-experimentenlog is alleen nuttig als hij aansluit op hoe jullie teams daadwerkelijk beslissingen nemen.

Schrijf 2–4 meetbare uitkomsten op voor de experimentrepository. Veelvoorkomende definities van succes zijn:

Deze doelen moeten later alles beïnvloeden: welke velden je verplicht in elk item, hoe strikt je workflow is en hoe geavanceerd je tagging en zoeken moeten zijn.

Maak een lijst van je primaire doelgroepen en wat zij moeten kunnen doen in het productleerlogboek:

Een eenvoudige manier om dit te valideren: vraag elke groep "Welke vraag wil je binnen 30 seconden beantwoord hebben?" Zorg er daarna voor dat je experimentsjablonen en paginalay-out dat ondersteunen.

Bepaal vroeg of je CMS voor experimentlogs moet zijn:

Als je gemengd kiest, definieer wat in publieke items is toegestaan (bijv. geen ruwe metrics, geanonimiseerde segmenten, geen namen van niet-uitgebrachte features) en wie publicatie goedkeurt. Dit voorkomt extra werk later als je team leerpunten extern wil delen.

Een product-experimentenlog werkt alleen als mensen het juiste experiment binnen een minuut kunnen vinden. Voordat je tools kiest of schermen ontwerpt, bepaal hoe iemand door je experimenttracking-website zal bladeren wanneer ze niet precies weten wat ze zoeken.

Houd de hoofdnavigatie beperkt en voorspelbaar. Een praktisch beginpunt is:

Als “Metrics” te zwaar voelt, kun je er in eerste instantie naar linken vanuit Experiments en later uitbreiden.

Bepaal de belangrijkste "vorm" van browsen. De meeste productleerlogs werken het beste met één primaire weergave en de rest geregeld via filters:

Kies wat stakeholders al in gesprekken gebruiken. Alles wat overblijft kan in tags (bijv. platform, hypothesethema, segment, experimenttype).

Maak URL's leesbaar en stabiel zodat mensen ze in Slack en tickets kunnen delen:

/experiments/2025-12-checkout-free-shipping-thresholdVoeg breadcrumbs toe zoals Experiments → Checkout → Free shipping threshold om doodlopende paden te voorkomen en scannen intuïtief te houden.

Maak een lijst van wat je op dag één publiceert versus later: recente experimenten, top playbooks, een kernmetrics-glossarium en teampagina's. Prioriteer items die vaak worden geraadpleegd (impactvolle tests, canonieke experimentsjablonen en metricdefinities die in resultaatsrapportage worden gebruikt).

Een nuttige product-experimentenlog is niet alleen een lijst links—het is een database van leerpunten. Het data-model is de "vorm" van die database: wat je opslaat, hoe items zich verhouden en welke velden aanwezig moeten zijn zodat experimenten over tijd vergelijkbaar blijven.

Begin met een kleine set contenttypen die aansluiten op hoe teams daadwerkelijk werken:

Het scheiden van deze typen voorkomt dat elk experiment nieuwe metricnamen verzint of beslissingen in vrije-tekst notes begraven worden.

Maak de "minimale levensvatbare entry" makkelijk in te vullen. Vereis ten minste:

Optioneel—maar vaak waardevol—zijn doelpubliek, trafficallocatie, testtype (A/B, multivariate) en links naar tickets of designs.

Resultaten zijn waar logs vaak stuklopen, dus standaardiseer ze:

Als je bijlagen toestaat, houd dan een consistente plek voor screenshots zodat lezers weten waar ze moeten kijken.

Modelleer relaties expliciet zodat ontdekking en rapportage later werken:

Standaardiseer statussen zodat sorteren en dashboards zinvol blijven: proposed, running, concluded, shipped, archived. Dit voorkomt dat "done", "complete" en "finished" uitmonden in drie verschillende statussen.

Goede templates transformeren "iemand's notities" in een gedeeld record dat het hele bedrijf kan scannen, vertrouwen en hergebruiken. Het doel is consistentie zonder dat auteurs het gevoel krijgen formulieren in te vullen.

Begin met de informatie die een lezer nodig heeft om te beslissen of ze verder lezen.

/docs/...) en primaire metric.Je indexpagina moet zich gedragen als een dashboard. Voeg filters toe voor status, team, tag, daterange en platform; sorteeropties voor recent bijgewerkt, startdatum en (als je impact kunt kwantificeren) impact; en quick-scan velden zoals status, owner, start/einddates en een één-regel resultaat.

Maak één standaardtemplate plus optionele varianten (bijv. "A/B-test", "Prijs-test", "Onboarding-experiment"). Prefill headings, voorbeeldtekst en verplichte velden zodat auteurs niet vanaf een blanco pagina hoeven te beginnen.

Gebruik een single-column lay-out, ruime regelspatiëring en duidelijke typografie. Houd belangrijke feiten in een sticky samenvattingsblok (waar zinvol), en maak tabellen horizontaal scrollbaar zodat resultaten op telefoons leesbaar blijven.

Een product-experimentenlog is alleen nuttig als mensen snel relevante leerpunten kunnen vinden. Tagging en taxonomie veranderen een stapel experimentpagina's in iets dat je kunt browsen, filteren en hergebruiken.

Definieer een handvol taggroepen die overeenkomen met hoe je team natuurlijk zoekt. Een praktisch basisniveau is:

Beperk het aantal groepen. Te veel dimensies maakt filteren verwarrend en stimuleert inconsistente tagging.

Ongecontroleerde tags worden snel "signup", "sign-up" en "registration" tegelijk. Creëer een gecontroleerde vocabulaire:

Een eenvoudige aanpak is een "tag registry"-pagina die het team onderhoudt (bijv. /experiment-tags) plus een lichte review tijdens experiment-schrijfsessies.

Tags zijn prima voor ontdekking, maar sommige attributen moeten gestructureerde velden zijn om consistent te blijven:

Gestructureerde velden voeden betrouwbare filters en dashboards, terwijl tags nuance vastleggen.

Help lezers tussen verbonden werk te springen. Voeg secties toe zoals Related experiments (zelfde feature of metric) en Similar hypotheses (zelfde veronderstelling elders getest). Dit kan in het begin handmatig met links, en later geautomatiseerd met regels op basis van gedeelde tags om buren voor te stellen.

Deze keuze bepaalt het plafond voor wat je product-experimentenlog kan worden. Een CMS kan je snel publiceren laten starten, terwijl een custom app de log kan veranderen in een strak geïntegreerd besluitvormingssysteem.

Een CMS past goed wanneer je belangrijkste behoefte consistente, leesbare A/B-testdocumentatie is met lichte structuur.

Gebruik een CMS als je wilt:

Een typisch patroon: een headless CMS (content opgeslagen in het CMS, gepresenteerd door je site) gecombineerd met een static site generator. Dat houdt de experimentrepository snel, makkelijk te hosten en vriendelijk voor niet-technische bijdragers.

Een custom experimenttracking-website is zinvol als de log direct met je productdata en interne tools moet verbinden.

Overweeg een custom app als je nodig hebt:

Als je dit snel wilt prototypen, kan een vibe-coding platform zoals Koder.ai een praktische shortcut zijn: je kunt het datamodel (experiments, metrics, decisions), paginatemplates en workflows in chat beschrijven en vervolgens itereren op een werkende React + Go + PostgreSQL-app, met deployment/hosting, source export en snapshots/rollback voor veilige wijzigingen.

Wees expliciet over waar experimentdata leeft.

Schrijf dit vroeg op—anders eindigen teams met dubbele entries in docs, spreadsheets en tools, en verliest de repository vertrouwen.

Je experimentenlog heeft geen exotische technologie nodig. De beste stack is wat je team betrouwbaar kan beheren, beveiligd kan houden en zonder frictie kan laten evolueren.

Een static site (vooraf gebouwde pagina's) is vaak de eenvoudigste keuze: snel, goedkoop te hosten en weinig onderhoud. Het werkt goed als experimenten grotendeels leesbaar zijn en updates via een CMS of pull requests gebeuren.

Een server-rendered app (pagina's gegenereerd op aanvraag) past wanneer je sterkere toegangcontrole, dynamische filters of per-team weergaven zonder complexe clientlogica nodig hebt. Ook makkelijker om permissies op serverniveau af te dwingen.

Een single-page app (SPA) voelt zeer responsief aan voor filteren en dashboards, maar voegt complexiteit toe rond SEO, auth en initiële laadtijd. Kies dit alleen als je echt app-achtige interacties nodig hebt.

Als je een custom app bouwt, bepaal dan ook of je een conventionele buildpipeline wilt of een versnelde aanpak. Bijvoorbeeld, Koder.ai kan de kernscaffolding (React UI, Go API, PostgreSQL-schema) genereren vanuit een geschreven specificatie, wat handig is tijdens iteraties met meerdere stakeholders.

Prioriteer betrouwbaarheid (uptime, monitoring, alerting) en backups (geautomatiseerd, geteste restores). Houd omgevingenscheiding: minstens een staging-omgeving om taxonomie-wijzigingen, template-updates en permissieregels te testen voordat je naar productie gaat.

De meeste teams hebben uiteindelijk SSO nodig (Okta, Google Workspace, Azure AD), plus rollen (viewer, editor, admin) en private gebieden voor gevoelige leerpunten (omzet, gebruikersdata, juridische notities). Plan dit vroeg om herarchitectuur later te vermijden.

Gebruik caching (CDN en browsercaching), houd pagina's licht en optimaliseer media (gecomprimeerde afbeeldingen, lazy loading waar geschikt). Een snelle paginasnelheid is cruciaal—mensen gaan een log die traag voelt niet gebruiken, zeker niet als ze tijdens een vergadering snel een test willen vinden.

Een product-experimentenlog wordt echt nuttig als mensen "dat ene testje" binnen enkele seconden kunnen vinden—zonder de exacte titel te kennen.

On-site search (ingebouwd in je CMS of app-database) is meestal voldoende bij een paar honderd experimenten, een klein team en eenvoudige behoeften (zoeken in titels, samenvattingen en tags). Het is makkelijker te onderhouden en vermijdt extra leverancierssetup.

Een externe zoekdienst (zoals Algolia/Elastic/OpenSearch) is de moeite waard bij duizenden items, behoefte aan razendsnelle resultaten, typo-tolerantie en synoniemen (bijv. "checkout" = "purchase"), of geavanceerde ranking zodat de meest relevante experimenten bovenaan komen. Externe zoekdiensten helpen ook als je content meerdere bronnen bestrijkt (docs + log + wiki).

Zoeken alleen is niet genoeg. Voeg filters toe die echte besluitvorming reflecteren:

Maak filters combineerbaar (bijv. “Concluded + Last 90 days + Growth team + Activation metric”).

Opgeslagen views veranderen terugkerende vragen in one-click antwoorden:

Laat teams gedeelde views vastpinnen in de navigatie en laat individuen persoonlijke views opslaan.

Toon in zoekresultaten een korte snippet: hypothese, variant, doelgroep en de kop-uitkomst. Markeer overeenkomende zoekwoorden in titel en samenvatting en toon enkele sleutelvelden (status, owner, primaire metric) zodat gebruikers kunnen beslissen wat zij willen openen zonder meerdere pagina's te hoeven bezoeken.

Een geweldige experimenttracking-website is meer dan pagina's en tags—het is een gedeeld proces. Duidelijke eigenaarschap en een lichte workflow voorkomen half-af items, ontbrekende resultaten en "mystery decisions" maanden later.

Begin met beslissen wie experimentitems mag aanmaken, bewerken, reviewen en publiceren. Een eenvoudig model volstaat voor de meeste teams:

Houd permissies in lijn met je toegangsniveaus (intern vs publiek vs beperkt). Als je private experimenten ondersteunt, eis een expliciete eigenaar voor elk item.

Definieer een korte checklist die elk experiment moet doorstaan voordat het gepubliceerd wordt:

Deze checklist kan een verplicht formulieronderdeel zijn in je experimentsjablonen.

Behandel items als levende documenten. Schakel versiegeschiedenis in en eis korte wijzigingsnotities voor materiële updates (metricfix, analysescorrectie, beslissingsomkering). Dit houdt vertrouwen hoog en audits eenvoudig.

Bepaal vooraf hoe je gevoelige informatie opslaat:

Governance hoeft niet zwaar te zijn. Het moet gewoon expliciet zijn.

Een experimenttracking-website is alleen nuttig als mensen kunnen vinden, vertrouwen en hergebruiken wat erin staat. Lichtgewicht analytics helpt je zien waar de log werkt—en waar hij stilletjes faalt—zonder de site in een surveillancesysteem te veranderen.

Begin met een paar praktische signalen:

Als je analytics-tool het ondersteunt, schakel IP-logging uit en vermijd gebruikersniveau-identificatie. Geef de voorkeur aan geaggregeerde, paginaniveau-rapportage.

Gebruiksstatistieken zeggen niet of items compleet zijn. Voeg "content health"-checks toe die de repository zelf bewaken:

Dit kan zo simpel zijn als een wekelijkse rapportage uit je CMS/database of een klein script dat items markeert. Het doel is zichtbaarheid van hiaten zodat eigenaren ze kunnen herstellen.

Experimentverslagen mogen bijna nooit persoonlijke gebruikersdata bevatten. Houd items vrij van:

Link naar geaggregeerde dashboards in plaats van ruwe datasets in te bedden en bewaar gevoelige analyses in goedgekeurde systemen.

A/B-testresultaten zijn makkelijk uit hun context verkeerd te interpreteren. Voeg een korte disclaimer toe in je experimentsjabloon (en/of footer) die vermeldt dat:

Dit houdt de log eerlijk en vermindert ‘cargo-cult’ hergebruik van vroegere uitkomsten.

Een goede experimentenlog is niet "klaar" zodra de site live is. De echte waarde verschijnt als teams het vertrouwen, het actueel houden en het na zes maanden nog kunnen vinden.

De meeste teams beginnen met spreadsheets, slide decks of verspreide docs. Kies een kleine pilotset (bijv. de experimenten van het laatste kwartaal) en map elk bronveld naar je nieuwe template.

Als het kan, importeer bulkgewijs: exporteer spreadsheets naar CSV en maak vervolgens een script of gebruik een CMS-importer om items in het nieuwe formaat te creëren. Voor documenten migreer je eerst de kernsamenvattingsvelden (doel, wijziging, resultaten, beslissing) en link je naar het originele bestand voor ondersteunende details.

Doe één pass gericht op consistentie, niet perfectie. Veelvoorkomende issues om te vangen:

Dit is ook het moment om overeen te komen welke velden verplicht zijn voor iets dat als voltooid wordt gemarkeerd.

Controleer voor aankondiging:

Houd een lichte routine aan: maandelijkse opschoning (verouderde drafts, ontbrekende resultaten) en een kwartaalreview van de taxonomie (tags samenvoegen, nieuwe categorieën zorgvuldig toevoegen).

Als de basis stabiel is, overweeg integraties: automatische koppelingen tussen experimenten en issue-trackers, of analyticscontext ophalen zodat elk item wijst naar het exacte dashboard dat voor resultaatsrapportage werd gebruikt.

Als je naar een custom applicatie evolueert, kun je ook eerst in "planning mode" itereren—werkflows, vereiste velden en goedkeuringsregels opschrijven en daarna implementeren. Platforms zoals Koder.ai ondersteunen dit soort iteratieve bouw-en-verfijning (met deploys, snapshots en rollback) zodat je log kan groeien zonder een grootschalige herbouw.

Een product-experimentenlogwebsite is een gedeelde, doorzoekbare repository voor het documenteren van experimenten (A/B-tests, prijsproeven, onboardingwijzigingen, feature-flagrolouts, e-mailtests). Elk item legt vast wat je probeerde, waarom, wat er gebeurde en welke beslissing daarna werd genomen — zodat leerpunten niet verloren gaan in documenten, dashboards of chats.

Begin met het definiëren van 2–4 meetbare uitkomsten, zoals:

Deze doelen bepalen welke velden verplicht zijn, hoe strikt je workflow moet zijn en hoe geavanceerd je taxonomie/zoekfunctionaliteit moet worden.

Maak een lijst van je belangrijkste doelgroepen en de “30-secondenvraag” die elk beantwoord wil zien. Veelvoorkomende behoeften zijn:

Ontwerp daarna templates en paginalay-out om die antwoorden direct zichtbaar te maken.

Kies één van drie modellen:

Als je mixed kiest, definieer wat publiek mag (bijv. geen ruwe metrics, geanonimiseerde segmenten) en wie publicatie goedkeurt om later dubbel werk te voorkomen.

Houd de topnavigatie eenvoudig en voorspelbaar, bijvoorbeeld:

Kies één primaire browse-dimensie (productgebied, trechterstadium of team) en gebruik filters/tags voor de rest.

Zorg dat elk experiment een consistente minimale set velden heeft:

Voor resultaten, standaardiseer:

Een praktisch standaardvolgorde is:

Gebruik een klein aantal taggroepen die reflecteren hoe mensen zoeken, zoals:

Voorkom tag-sprawl met een gecontroleerde vocabulaire (naamgevingsregels, wie nieuwe tags mag aanmaken, korte tagbeschrijvingen). Houd kernattributen zoals , en als gestructureerde velden — geen vrije-tekst tags.

Gebruik een CMS als je vooral consistente documentatie, permissies en basis-tagging wilt met een gebruiksvriendelijke editor.

Overweeg een custom app als je diepe integraties nodig hebt (feature flags, analytics, datawarehouse, tickets), geavanceerde zoekmogelijkheden en opgeslagen views, workflowregels (verplichte velden/goedkeuringen) of geautomatiseerde resultatenimport.

Wat je ook kiest, leg vast wat de source of truth is (CMS vs database/app) om duplicatie en tegenstrijdige entries te voorkomen.

Begin met praktische ontdekkingstools:

Toon in de lijstresultaten een korte uitkomstsamenvatting plus kernvelden (status, owner, primaire metric) zodat gebruikers niet meerdere pagina's hoeven te openen.

Zo worden notities vergelijkbare records over tijd.

Dit maakt pagina's scanbaar met diepgang beschikbaar indien nodig.