24 nov 2025·8 min

Hoe je een website bouwt voor een technische vergelijkingsmatrix

Leer hoe je een site plant, ontwerpt en bouwt voor een technische vergelijkingsmatrix met duidelijke criteria, scoring, filters en SEO-vriendelijke pagina's.

Leer hoe je een site plant, ontwerpt en bouwt voor een technische vergelijkingsmatrix met duidelijke criteria, scoring, filters en SEO-vriendelijke pagina's.

Een vergelijkingsmatrix is alleen nuttig voor de beslissing die iemand ermee helpt nemen. Voordat je tabellen, filters of scoring ontwerpt, wees specifiek over wie de site gebruikt en welke beslissing ze proberen te nemen. Dit voorkomt een veelvoorkomende fout: een mooie tabel bouwen die geen vragen beantwoordt die iemand stelt.

Verschillende doelgroepen interpreteren dezelfde “functievergelijking” heel anders:

Kies een primaire doelgroep voor de eerste versie. Je kunt secundaire gebruikers blijven ondersteunen, maar de standaardweergaven, terminologie en prioriteiten van de site moeten de hoofdgebruikersgroep weerspiegelen.

Schrijf de concrete beslissingen op die de matrix mogelijk moet maken. Voorbeelden:

Deze beslissingen bepalen welke criteria top-level filters worden, welke details zijn en wat je kunt weglaten.

Vermijd vage doelen zoals “meer engagement”. Kies metrics die vooruitgang in beslissen reflecteren:

“Technische evaluatie” kan veel dimensies omvatten. Spreek af wat het meest telt voor je gebruikers, zoals:

Documenteer deze prioriteiten in heldere taal. Dit wordt je noordster voor latere keuzes: datamodel, scoringsregels, UX en SEO.

Je datamodel bepaalt of de matrix consistent, doorzoekbaar en gemakkelijk bij te werken blijft. Voordat je schermen ontwerpt, bepaal wat de “dingen” zijn die je vergelijkt, wat je meet en hoe je bewijs opslaat.

De meeste technische vergelijkingssites hebben een klein aantal bouwstenen nodig:

Modelleer criteria als herbruikbare objecten en sla elke vendor/productwaarde op als een apart record (vaak “assessment” of “criterion result” genoemd). Zo kun je nieuwe vendors toevoegen zonder de criterialijst te dupliceren.

Voorkom dat alles in platte tekst wordt gedwongen. Kies een type dat past bij hoe mensen zullen filteren en vergelijken:

Bepaal ook hoe je “Onbekend”, “Niet van toepassing” en “Gepland” weergeeft, zodat lege velden niet als “Nee” gelezen worden.

Criteria evolueren. Sla op:

Maak velden (of zelfs een aparte tabel) voor interne commentaren, onderhandelingsdetails en reviewervertrouwen. Publieke pagina's moeten de waarde en het bewijs tonen; interne weergaven kunnen open kaart geven en follow-up taken tonen.

Een vergelijkingsmatrix-site slaagt wanneer bezoekers kunnen voorspellen waar dingen te vinden zijn en hoe ze er komen. Kies een informatiearchitectuur die weerspiegelt hoe mensen opties evalueren.

Begin met een eenvoudige, stabiele taxonomie die niet elk kwartaal verandert. Denk in “probleemgebieden” in plaats van leveranciernamen.

Voorbeelden:

Houd de boom ondiep (meestal zijn 2 niveaus genoeg). Als je meer nuance nodig hebt, gebruik tags of filters (bijv. “Open-source”, “SOC 2”, “Self-hosted”) in plaats van diepe hiërarchie. Dit helpt gebruikers bij het bladeren en voorkomt later dubbele content.

Ontwerp de site rond een paar herhaalbare paginatemplates:

Voeg ondersteunende pagina's toe die verwarring verminderen en geloofwaardigheid opbouwen:

Kies URL-regels vroeg zodat je later geen rommelige redirects creëert. Twee veelvoorkomende patronen:

/compare/a-vs-b (of /compare/a-vs-b-vs-c voor multi-way)/category/ci-cdHoud URL's kort, lowercase en consistent. Gebruik de canonieke naam van het product (of een stabiele slug) zodat hetzelfde hulpmiddel niet onder zowel /product/okta als /product/okta-iam eindigt.

Bepaal ten slotte hoe filtering en sorteren de URL beïnvloeden. Als je deelbare gefilterde weergaven wilt, plan dan een nette query-string aanpak (bijv. ?deployment=saas&compliance=soc2) en houd de basispagina bruikbaar zonder parameters.

Een vergelijkingsmatrix helpt alleen als de regels consistent zijn. Voordat je meer vendors of criteria toevoegt, leg de “wiskunde” en de betekenis achter elk veld vast. Dit voorkomt eindeloze discussies later (“Wat bedoelden we met SSO-ondersteuning?”) en maakt je resultaten verdedigbaar.

Begin met een canonieke lijst van criteria en behandel die als een productspecificatie. Elk criterium moet hebben:

Vermijd bijna-duplicaten zoals “Compliance” vs “Certificeringen” tenzij het verschil expliciet is. Als je varianten nodig hebt (bijv. “Encryptie at rest” en “Encryptie in transit”), maak ze dan aparte criteria met eigen definities.

Scores zijn alleen vergelijkbaar als iedereen dezelfde schaal gebruikt. Schrijf scoringsrubrieken die bij het criterium passen:

Definieer wat elk punt betekent. Bijvoorbeeld kan “3” betekenen “voldoet met beperkingen”, terwijl “5” “voldoet met geavanceerde opties en bewezen implementaties” betekent. Geef ook aan of “N/A” is toegestaan en wanneer.

Weging verandert het verhaal dat je matrix vertelt, dus kies doelbewust:

Als je aangepaste gewichten ondersteunt, definieer guardrails (bijv. gewichten moeten optellen tot 100, of gebruik presets laag/midden/hoog).

Ontbrekende data is onvermijdelijk. Documenteer je regel en pas die overal toe:

Deze policies houden je matrix eerlijk, reproduceerbaar en betrouwbaar naarmate hij groeit.

Je vergelijking-UI slaagt of faalt op één ding: of een lezer snel kan zien wat wezenlijk verschilt. Kies een primaire vergelijkingsweergave en visuele aanwijzingen die contrasten laten opvallen.

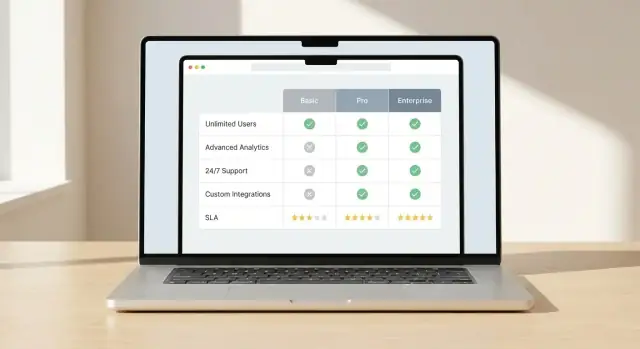

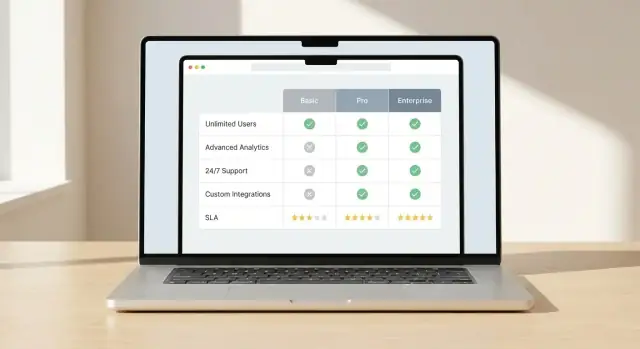

Kies één hoofdpatroon en ontwerp alles daaromheen:

Consistentie is belangrijk. Als gebruikers leren hoe verschillen worden getoond op één plek, moeten dezelfde regels overal gelden.

Vermijd dat mensen elke cel moeten scannen. Gebruik doelbewuste highlights:

Houd kleurgebruik simpel en toegankelijk: één kleur voor “beter”, één voor “slechter”, en een neutrale staat. Vertrouw niet alleen op kleur—gebruik iconen of korte labels.

Lange matrices zijn normaal bij technische evaluatie. Maak ze bruikbaar:

Mobiele gebruikers tolereren geen piepkleine tabellen. Bied:

Als verschillen makkelijk te zien zijn, vertrouwen lezers de matrix en blijven ze hem gebruiken.

Een vergelijkingsmatrix voelt pas “snel” wanneer mensen de lijst kunnen beperken en betekenisvolle verschillen kunnen zien zonder minuten te scrollen. Filtering, sortering en side-by-side weergaven zijn de kerninteracties die dat mogelijk maken.

Begin met een kleine set filters die echte evaluatievragen reflecteren, niet alleen wat makkelijk op te slaan is. Veelgebruikte filters:

Ontwerp filters zodat gebruikers ze kunnen combineren. Toon hoeveel items matchen tijdens het filteren en maak het duidelijk hoe je filters kunt verwijderen. Als sommige filters elkaar uitsluiten, voorkom dan ongeldige combinaties in plaats van “0 resultaten” te tonen zonder uitleg.

Sorteren moet zowel objectieve als doelgroep-specifieke prioriteiten reflecteren. Bied een paar duidelijke opties zoals:

Als je een “beste score” toont, laat zien wat die score betekent (overall vs categorie-score) en laat gebruikers de scoringsweergave wisselen. Vermijd verborgen defaults.

Laat gebruikers een kleine set (meestal 2–5) selecteren en vergelijk ze in een vaste kolomlay-out. Houd de belangrijkste criteria bovenaan vast en groepeer de rest in inklapbare secties om overweldiging te verminderen.

Maak de vergelijking deelbaar met een link die selecties, filters en sorteervolgorde bewaart. Zo kunnen teams dezelfde shortlist bekijken zonder die opnieuw op te bouwen.

Exports kunnen waardevol zijn voor interne review, inkoop en offline discussie. Als je doelgroep het nodig heeft, bied CSV (voor analyse) en PDF (voor delen). Houd exports gefocust: includeer geselecteerde items, gekozen criteria, tijdstempels en eventuele scoringsnotities zodat het bestand later niet misleidend is.

Lezers gebruiken je matrix alleen als ze die vertrouwen. Als pagina's sterke claims maken zonder te tonen waar de data vandaan komt—of wanneer die gecontroleerd is—gaan gebruikers ervan uit dat het bevooroordeeld of verouderd is.

Behandel elke cel als een uitspraak die bewijs nodig heeft. Voor feitelijke items (prijstierlimieten, API-beschikbaarheid, compliance-certificeringen) sla een “source” veld op naast de waarde:

Maak de bron in de UI zichtbaar zonder rommel: een klein “Bron” label in een tooltip of een uitklapbare rij werkt goed.

Voeg metadata toe die twee vragen beantwoordt: “Hoe actueel is dit?” en “Wie staat erachter?”.

Neem een “Laatst geverifieerd” datum op voor elk product (en optioneel per criterium), plus een “Eigenaar” (team of persoon) verantwoordelijk voor review. Dit is vooral belangrijk voor snel veranderende items zoals featureflags, integraties en SLA-voorwaarden.

Niet alles is binair. Voor subjectieve criteria (installatiegemak, kwaliteit van support) of onvolledige items (vendor publiceert geen details) toon vertrouwensniveaus zoals:

Dit voorkomt valse precisie en moedigt lezers aan om in de notities te duiken.

Op elke productpagina, voeg een kleine change log toe wanneer sleutelvelden veranderen (prijs, belangrijke features, security posture). Lezers zien snel wat nieuw is en terugkerende stakeholders weten dat ze niet met verouderde info vergelijken.

Een vergelijkingsmatrix is alleen nuttig zolang hij actueel is. Voordat je de eerste pagina publiceert, bepaal wie data mag aanpassen, hoe die wijzigingen worden beoordeeld en hoe je scoringsconsistentie bewaakt over tientallen (of duizenden) rijen.

Begin met het kiezen van de “source of truth” voor je matrixdata:

De sleutel is niet de technologie, maar of je team het betrouwbaar kan bijwerken zonder de matrix te breken.

Behandel wijzigingen als productreleases, niet als informele edits.

Een praktische workflow ziet er zo uit:

Als je frequent bijwerkt, voeg lichte conventies toe: change requests, een standaard “reden voor update” veld en geplande reviewcycli (maandelijks/kwartaal).

Validatie voorkomt stille drift in je matrix:

Handmatig bewerken schaalt niet. Als je veel vendors of frequente datafeeds hebt, plan voor:

Wanneer je workflow duidelijk en afgedwongen is, blijft je matrix betrouwbaar — en vertrouwen is wat mensen laat handelen.

Een vergelijkingsmatrix oogt simpel, maar de beleving hangt af van hoe je veel gestructureerde data ophaalt, rendert en bijwerkt zonder vertraging. Het doel is pagina's snel te houden en je team makkelijk te laten publiceren.

Kies een model op basis van hoe vaak je data verandert en hoe interactief de matrix moet zijn:

Matrix-tabellen worden snel zwaar (veel vendors × veel criteria). Plan performance vroeg:

Zoeken moet vendor-namen, alternatieve namen en kerncriteria dekken. Voor relevantie indexeer:

Geef resultaten die gebruikers direct naar een vendorrij of criteriasectie brengen, niet alleen een generieke resultatenpagina.

Volg events die intentie en knelpunten laten zien:

Neem de actieve filters en vergeleken vendor-IDs op in de eventpayload zodat je kunt leren welke criteria beslissingen sturen.

Als je snel een vergelijkingssite wilt lanceren — zonder weken aan scaffolding, CRUD-adminschermen en basis table-UX — kan een vibe-coding platform zoals Koder.ai een praktische shortcut zijn. Je kunt je entiteiten beschrijven (products, criteria, evidence), vereiste workflows (review/approval) en kernpagina's (category hub, productpagina, compare page) in chat, en vervolgens itereren op de gegenereerde app.

Koder.ai is vooral relevant als je doeltaak aansluit op de defaults: React op het web, Go op de backend met PostgreSQL, en optioneel Flutter als je later een mobiele companion wilt voor "saved comparisons." Je kunt ook broncode exporteren, snapshots/rollback gebruiken terwijl je de scoringslogica afstemt, en deployen met custom domains wanneer je klaar bent om te publiceren.

Vergelijkingspagina's zijn vaak het eerste contactpunt voor intentievolle bezoekers (“X vs Y”, “beste tools voor…”, “feature comparison”). SEO werkt het beste wanneer elke pagina een duidelijke bedoeling heeft, een stabiele URL en inhoud die echt onderscheidend is.

Geef elke vergelijkingspagina een eigen paginatitel en H1 die bij de intentie past:

Begin met een korte samenvatting die antwoord geeft op: voor wie is deze vergelijking, wat wordt vergeleken, en wat zijn de belangrijkste verschillen. Voeg een compacte conclusie toe (zelfs als het “beste voor X, beste voor Y” is) zodat de pagina niet slechts als een generieke tabel voelt.

Gestructureerde data kan de manier waarop je pagina's in zoekresultaten verschijnen verbeteren als het overeenkomt met zichtbare inhoud.

Vermijd het volproppen van elke pagina met schema types of velden die je niet met bewijs kunt ondersteunen. Consistentie en nauwkeurigheid wegen zwaarder dan volume.

Filtering en sorteren kunnen veel bijna-identieke URL's creëren. Bepaal wat indexeerbaar moet zijn en wat niet:

Help zoekmachines en mensen op dezelfde manier navigeren als ze evalueren:

Gebruik beschrijvende anchortekst (“vergelijk prijsmodel”, “beveiligingsfeatures”) in plaats van herhalend “klik hier”.

Voor grote matrices hangt SEO-succes af van wat je juist níet indexeert.

Neem alleen waardevolle pagina's op in je sitemap (hubs, kernproducten, samengestelde vergelijkingen). Houd dunne, automatisch gegenereerde combinaties buiten indexatie en monitor crawl-statistieken zodat zoekmachines tijd besteden aan pagina's die echt helpen beslissen.

Een vergelijkingsmatrix werkt alleen als hij nauwkeurig, gebruiksvriendelijk en betrouwbaar blijft. Beschouw de lancering als het begin van een cyclus: testen, uitrollen, leren en bijwerken.

Voer usability-tests uit die focussen op de echte uitkomst: kunnen gebruikers sneller en met meer vertrouwen beslissen? Geef deelnemers een realistisch scenario (bijv. “kies de beste optie voor een team van 50 personen met strikte security-eisen”) en meet:

Vergelijkings-UI's falen vaak bij basis toegankelijkheidstests. Controleer voor lancering:

Controleer eerst de meest bekeken vendors/producten en belangrijkste criteria. Test daarna randgevallen:

Stel interne en publieke verwachtingen: data verandert.

Definieer hoe gebruikers fouten kunnen melden of updates kunnen voorstellen. Bied een eenvoudig formulier met categorie-opties (datafout, ontbrekende feature, UX-probleem) en verbind response-targets (bijv. bevestiging binnen 2 werkdagen). Na verloop van tijd wordt dit je beste bron van “wat moet er eerst worden gefixt”.

Begin met het definiëren van de primaire doelgroep en de concrete beslissing die ze willen nemen (shortlist, vervanging, RFP, verificatie van vereisten). Kies daarna criteria en UX-standaarden die bij die doelgroep en hun beperkingen passen.

Een goede interne controle: kan een gebruiker van de landingspagina naar een verdedigbare shortlist gaan zonder het hele scoringssysteem te moeten leren?

Behandel elke cel als een bewering die onderbouwd moet worden. Sla bewijsmateriaal op naast de waarde (documentatie, release-opmerking, intern testresultaat) en toon dit in de UI via tooltips of uitklapbare notities.

Toon ook:

Gebruik kernentiteiten die vergelijkingen consistent houden:

Modelleer criteria als herbruikbare objecten en sla elke productwaarde apart op zodat je leveranciers kunt toevoegen zonder de criterialijst te dupliceren.

Gebruik datatypes die overeenkomen met hoe mensen zullen filteren en vergelijken:

Definieer expliciete toestanden voor Onbekend, Niet van toepassing en Gepland zodat lege cellen niet automatisch als “Nee” worden geïnterpreteerd.

Gebruik een klein aantal herhaalbare templates:

Ondersteun duidelijkheid en geloofwaardigheid met methodology, glossary en contact/correcties-pagina's.

Kies URL-patronen die schaalbaar en consistent blijven:

/compare/a-vs-b (en -vs-c voor multi-way)/category/ci-cdAls je deelbare gefilterde weergaven ondersteunt, houd de basispagina stabiel en gebruik query-strings (bijv. ?deployment=saas&compliance=soc2). Plan ook canonical-URL's om dubbele SEO-pagina's te vermijden.

Schrijf voor elk criterium een rubric en kies een scoringsstijl die past:

Documenteer hoe onbekenden totals beïnvloeden (0 vs neutraal vs uitgesloten) en pas die regel consequent toe op de hele site.

Weging verandert het verhaal, dus beslis bewust:

Als je aangepaste gewichten toestaat, voeg dan randvoorwaarden toe (bijv. gewichten moeten optellen tot 100, presets zoals laag/midden/hoog).

Ontwerp voor snelheid naar een shortlist:

Overweeg CSV/PDF-export als je doelgroep dat nodig heeft voor inkoop/offline review, en voeg timestamps en scoringsnotities toe zodat exports later niet misleidend zijn.

Veelvoorkomende prestatiehefbomen voor grote matrices:

Een praktische aanpak is hybride rendering: bouw stabiele pagina's vooraf en laad interactieve matrixdata via een API zodat de UI snel blijft en de data updateerbaar is.