10 de dez. de 2025·8 min

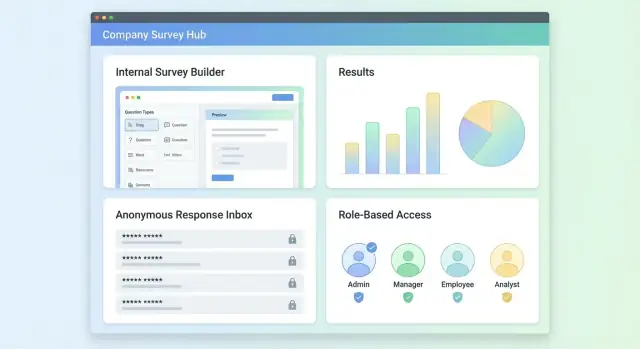

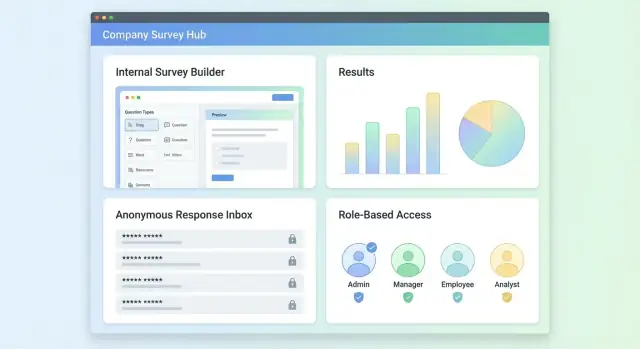

Criar um App Web para Pesquisas e Feedback Interno: Guia

Aprenda a planejar, projetar e construir um app web para pesquisas e feedbacks internos — papéis, anonimato, fluxos, analytics, segurança e etapas de rollout.

Aprenda a planejar, projetar e construir um app web para pesquisas e feedbacks internos — papéis, anonimato, fluxos, analytics, segurança e etapas de rollout.

Um app de pesquisas internas deve transformar o input dos funcionários em decisões — não apenas “rodar pesquisas”. Antes de escolher recursos, defina o problema que você está resolvendo e como é o critério de sucesso.

Comece nomeando os tipos de pesquisa que você espera rodar regularmente. Categorias comuns incluem:

Cada categoria implica necessidades diferentes — frequência, expectativas de anonimato, profundidade de relatório e fluxos de acompanhamento.

Esclareça quem vai possuir, operar e confiar no sistema:

Anote os objetivos das partes interessadas cedo para prevenir escopo excessivo e evitar dashboards que ninguém usa.

Estabeleça resultados mensuráveis para poder julgar o valor do app após o rollout:

Seja explícito sobre restrições que afetam escopo e arquitetura:

Uma primeira versão enxuta geralmente é: criar pesquisas, distribuí‑las, coletar respostas com segurança e produzir resumos claros que gerem ações de acompanhamento.

Papéis e permissões determinam se a ferramenta será crível — ou politicamente arriscada. Comece com um pequeno conjunto de papéis e adicione nuances só quando houver necessidades reais.

Funcionário (respondente)

Funcionários devem conseguir descobrir pesquisas para as quais são elegíveis, submeter respostas rapidamente e (quando prometido) confiar que as respostas não podem ser rastreadas até eles.

Gestor (visualizador + responsável por ações)

Gestores normalmente precisam de resultados a nível de equipe, tendências e ações de follow-up — não linhas brutas de resposta. A experiência deles deve focar em entender temas e melhorar o time.

RH/Admin (dono do programa)

Usuários de RH/admin criam pesquisas, gerenciam templates, controlam regras de distribuição e veem relatórios transversais. Também tratam exportações (quando permitidas) e solicitações de auditoria.

Admin do sistema (proprietário da plataforma)

Este papel mantém integrações (SSO, sincronização de diretório), políticas de acesso, configurações de retenção e configuração global. Não deveria ver resultados de pesquisas automaticamente, a menos que explicitamente autorizado.

Criar pesquisa → distribuir: RH/admin seleciona um template, ajusta perguntas, define audiências elegíveis (ex.: departamento, localização) e agenda lembretes.

Responder: O funcionário recebe um convite, autentica (ou usa um magic link), completa a pesquisa e vê uma confirmação clara.

Revisar resultados: Gestores veem resultados agregados para seu escopo; RH/admin vê insights organizacionais e pode comparar grupos.

Agir: Times criam ações de follow-up (ex.: “melhorar onboarding”), atribuem responsáveis, definem datas e acompanham o progresso.

Defina permissões em linguagem simples:

Uma falha frequente é permitir que gestores vejam resultados muito granulares (ex.: breakdown para um subgrupo de 2–3 pessoas). Aplique limiares mínimos de relatório e suprima filtros que possam identificar indivíduos.

Outra é permissões pouco claras (“Quem pode ver isto?”). Cada página de resultados deve mostrar uma breve nota de acesso, por exemplo: “Você está vendo resultados agregados para Engenharia (n=42). Respostas individuais não estão disponíveis.”

Um bom design de pesquisa é a diferença entre “dados interessantes” e feedback acionável. Em um app interno, busque pesquisas curtas, consistentes e fáceis de reutilizar.

Seu construtor deve começar com alguns formatos opinativos que cobrem a maior parte das necessidades de RH e times:

Esses tipos se beneficiam de estrutura consistente para que resultados possam ser comparados ao longo do tempo.

Uma biblioteca MVP sólida normalmente inclui:

Mostre na pré-visualização exatamente o que os respondentes verão, incluindo marcadores de obrigatório/opcional e rótulos de escala.

Suporte lógica condicional básica como: “Se alguém responder Não, mostre uma pergunta de acompanhamento curta.” Mantenha regras simples (mostrar/ocultar perguntas ou seções). Ramificações muito complexas tornam testes e análises posteriores mais difíceis.

Times vão querer reutilizar pesquisas sem perder histórico. Trate templates como pontos de partida e crie versões ao publicar. Assim você pode editar o pulse do mês que vem sem sobrescrever o anterior, e a análise permanece ligada às perguntas exatas feitas.

Se suas equipes estiverem distribuídas, planeje traduções opcionais: armazene texto por questão por localidade e mantenha opções de resposta consistentes entre idiomas para preservar relatórios.

Confiança é uma funcionalidade do produto. Se funcionários não tiverem certeza de quem pode ver suas respostas, eles pularão a pesquisa ou “responderão na defensiva” em vez de ser honestos. Torne as regras de visibilidade explícitas, aplique‑as nos relatórios e evite vazamentos acidentais de identidade.

Suporte três modos distintos e rotule‑os consistentemente no construtor, no convite e nas telas dos respondentes:

Mesmo sem nomes, grupos pequenos podem “denunciar” alguém. Aplique limites mínimos de grupo sempre que resultados forem quebrados (time, localização, faixa de tempo, gestor):

Comentários são valiosos — e arriscados. Pessoas podem incluir nomes, detalhes de projetos ou dados pessoais.

Mantenha trilhas de auditoria para responsabilidade, mas não as transforme em vazamentos de privacidade:

Antes da submissão, mostre um pequeno painel “Quem pode ver o quê” que corresponda ao modo selecionado. Exemplo:

Suas respostas são anônimas. Gestores verão apenas resultados para grupos de 7+ pessoas. Comentários podem ser revisados pelo RH para remover detalhes identificáveis.

Clareza reduz medo, aumenta a taxa de conclusão e torna o programa de feedback crível.

Colocar a pesquisa diante das pessoas certas — e apenas uma vez — importa tanto quanto as perguntas. Suas escolhas de distribuição e login afetam diretamente a taxa de resposta, a qualidade dos dados e a confiança.

Suporte múltiplos canais para que admins escolham o que se encaixa na audiência:

Mantenha mensagens curtas, inclua tempo estimado de resposta e faça o link ser de um toque.

Para pesquisas internas, abordagens comuns são:

Seja explícito na UI sobre a pesquisa ser anônima ou identificada. Se for anônima, não peça que o usuário “entre com seu nome” a menos que explique claramente como o anonimato é preservado.

Construa lembretes como funcionalidade de primeira classe:

Defina o comportamento claramente:

Combine métodos:

Ótima UX importa quando sua audiência está ocupada e não tem interesse em “aprender uma ferramenta”. Mire em três experiências que pareçam feitas para o propósito: o construtor, o fluxo do respondente e o console admin.

O construtor deve parecer uma checklist. Uma lista de perguntas à esquerda com ordenação drag-and-drop funciona bem, com a pergunta selecionada exibida em um painel de edição simples.

Inclua essenciais onde as pessoas esperam: alternadores de obrigatório, help text (o que a pergunta significa e como as respostas serão usadas) e controles rápidos para rótulos de escala (ex.: “Discordo fortemente” → “Concordo fortemente”). Um botão Pré-visualizar persistente (ou visualização em tela dividida) ajuda criadores a pegar redações confusas cedo.

Mantenha templates leves: deixe times partir de “Pulse check”, “Onboarding” ou “Feedback para gestor” e editar in loco — evite wizards multi‑passos a menos que reduzam erros significativamente.

Respondentes querem velocidade, clareza e confiança. Faça a UI mobile‑friendly por padrão, com espaçamento legível e alvos de toque adequados.

Um indicador de progresso simples reduz abandono (“6 de 12”). Ofereça salvar e continuar sem drama: autosave a cada resposta e torne o link de “Retomar” fácil de achar a partir do convite original.

Quando a lógica oculta/mostra perguntas, evite saltos-surpresa. Use pequenas transições ou cabeçalhos de seção para que o fluxo permaneça coerente.

Admins precisam de controle sem ficar procurando configurações. Organize por tarefas reais: gerenciar pesquisas, selecionar audiências, definir agendas e atribuir permissões.

Telas-chave normalmente incluem:

Cubra o básico: navegação por teclado completa, estados de foco visíveis, contraste suficiente e labels que façam sentido sem contexto.

Para erros e estados vazios, assuma usuários não técnicos. Explique o que aconteceu e o que fazer em seguida (“Nenhuma audiência selecionada—escolha pelo menos um grupo para agendar”). Forneça padrões seguros e undo quando possível, especialmente ao enviar convites.

Um modelo de dados limpo mantém seu app flexível (novos tipos de pergunta, novos times, novas necessidades de relatório) sem transformar cada mudança em uma crise de migração. Mantenha separação clara entre authoring, distribution e results.

No mínimo você vai querer:

Arquitetura de informação segue naturalmente: uma barra lateral com Surveys e Analytics, e dentro de uma survey: Construtor → Distribuição → Resultados → Configurações. Mantenha “Teams” separados de “Surveys” para que controle de acesso permaneça consistente.

Armazene respostas brutas em estrutura append‑friendly (ex.: tabela answers com response_id, question_id, campos tipados de valor). Depois construa tabelas agregadas/views materializadas para relatório (contagens, médias, séries temporais). Isso evita recalcular cada gráfico a cada carregamento de página, preservando auditabilidade.

Se anonimato estiver habilitado, separe identificadores:

responses não contém referência a usuárioinvitations contém o mapeamento, com acesso mais restrito e retenção curtaTorne a retenção configurável por pesquisa: delete links de convite após N dias; exclua respostas brutas após N meses; mantenha apenas agregados se necessário. Forneça exportações (CSV/XLSX) alinhadas com essas regras (/help/data-export).

Para anexos e links nas respostas, padrão é negar a menos que haja um caso de uso forte. Se permitido, armazene arquivos em object storage privado, faça scan de uploads e registre apenas metadados no banco.

Busca por texto livre é útil, mas pode minar a privacidade. Se adicionar, limite indexação a admins, suporte redação e documente que a busca pode aumentar o risco de reidentificação. Considere “buscar dentro de uma única pesquisa” em vez de busca global para reduzir exposição.

Um app de pesquisas não precisa de tecnologia exótica, mas precisa de fronteiras claras: uma UI rápida para criar e responder, uma API confiável, um banco que aguente relatórios, e workers para notificações.

Escolha um stack que sua equipe consiga operar com confiança:

Se você espera análises pesadas, Postgres suporta bem e você pode adicionar um data warehouse depois sem reescrever o app.

Se quiser prototipar rápido (UI, API, DB e auth) a partir de um requirements doc, Koder.ai pode acelerar o build usando um fluxo de trabalho baseado em chat. A plataforma gera apps orientados à produção (comum: React + Go + PostgreSQL) com recursos como modo de planejamento, exportação de código-fonte e snapshots/rollback — útil quando se itera em uma ferramenta interna com permissões sensíveis e regras de privacidade.

Uma base prática é uma arquitetura em três camadas:

Adicione um serviço de workers para tarefas agendadas ou de longa duração (convites, lembretes, exportações) para manter a API responsiva.

REST costuma ser a escolha mais simples para ferramentas internas: endpoints previsíveis, caching fácil, debug direto.

Endpoints REST típicos:

POST /surveys, GET /surveys/:id, PATCH /surveys/:idPOST /surveys/:id/publishPOST /surveys/:id/invites (criar atribuições/invitations)POST /responses e GET /surveys/:id/responses (apenas admin)GET /reports/:surveyId (agregações, filtros)GraphQL pode ajudar se seu builder precisar de muitas leituras aninhadas (survey → páginas → perguntas → opções) e você quiser menos round‑trips. Traz complexidade operacional adicional; use só se a equipe dominar.

Use uma fila de jobs para:

Se suportar uploads ou exportações baixáveis, armazene arquivos fora do banco (ex.: S3‑compatível) e sirva via CDN. Use URLs assinadas com tempo limitado para que só usuários autorizados possam baixar.

Rode dev / staging / prod separadamente. Mantenha segredos fora do código (variáveis de ambiente ou um secrets manager). Use migrations para alterações de esquema e adicione health checks para que deploys falhem rápido sem quebrar pesquisas ativas.

Analytics deve responder duas perguntas práticas: “Ouvimos pessoas suficientes?” e “O que devemos fazer em seguida?” O objetivo não é gráficos chamativos — é insight pronto para decisão que líderes possam confiar.

Comece com uma visão de participação fácil de escanear: taxa de resposta, cobertura de convites e distribuição ao longo do tempo (tendência diária/semanal). Isso ajuda admins a detectar quedas cedo e ajustar lembretes.

Para “temas principais”, tenha cuidado. Se você resumir comentários abertos (manualmente ou com sugestões automáticas), rotule como direcional e permita que usuários cliquem para ver comentários subjacentes. Evite apresentar “temas” como fatos quando a amostra for pequena.

Quebras são úteis, mas podem expor indivíduos. Reuse os mesmos limiares mínimos definidos para anonimato em todas as visualizações. Se um subgrupo estiver abaixo do limiar, agregue em “Outros” ou esconda.

Para organizações menores, considere um “modo privacidade” que aumenta limiares automaticamente e desabilita filtros excessivamente granulares.

Exportações são onde dados frequentemente vazam. Mantenha CSV/PDFs atrás de controles de acesso por papel e registre quem exportou o quê e quando. Para PDFs, watermark opcional (nome + timestamp) pode desencorajar compartilhamento casual sem bloquear relatórios legítimos.

Respostas abertas precisam de um fluxo, não de uma planilha.

Forneça ferramentas leves: tagging, agrupamento por tema e notas de ação anexadas a comentários (com permissões para que notas sensíveis não sejam visíveis a todos). Mantenha o comentário original imutável e armazene tags/notes separadamente para auditoria.

Feche o ciclo permitindo que gestores criem follow-ups a partir de insights: atribua um dono, defina prazo e acompanhe status (ex.: Planejado → Em Progresso → Concluído). Uma visão “Ações” que liga de volta à pergunta e ao segmento de origem facilita a revisão em reuniões de acompanhamento.

Segurança e privacidade não são complementos para um app de pesquisas internas — elas determinam se funcionários confiarão o suficiente na ferramenta para usar honestamente. Trate isto como checklist antes do lançamento e a cada release.

Use HTTPS em todo lugar e configure flags seguras em cookies (Secure, HttpOnly e política SameSite adequada). Exija gerenciamento de sessão robusto (sessões curtas, logout em troca de senha).

Proteja todas requisições que mudam estado com defesas CSRF. Valide e sanitize input no servidor (não apenas no navegador), incluindo perguntas de pesquisa, respostas em texto livre e uploads de arquivo (se houver). Adicione rate limiting para login, endpoints de invitation e lembretes.

Implemente controle de acesso baseado em papéis com fronteiras claras (ex.: Admin, RH/Dono do Programa, Gestor, Analista, Respondente). Default de todo recurso novo deve ser “deny” até ser explicitamente permitido.

Aplique o princípio do menor privilégio também na camada de dados — owners de pesquisa devem acessar apenas suas pesquisas, e analistas devem receber vistas agregadas a menos que acesso ao nível de resposta seja concedido explicitamente.

Se a cultura exigir, adicione aprovações para ações sensíveis como habilitar modos de anonimato, exportar respostas brutas ou adicionar novos owners de pesquisa.

Encripte dados em trânsito (TLS) e em repouso (banco e backups). Para campos especialmente sensíveis (ex.: identificadores de respondentes ou tokens), considere criptografia na camada de aplicação.

Armazene segredos (credenciais DB, chaves de provedores de e-mail) em um secrets manager; rotacione regularmente. Nunca logue tokens de acesso, links de invitation ou identificadores de resposta.

Decida residência de dados cedo (onde banco e backups residem) e documente para funcionários.

Defina regras de retenção: por quanto tempo manter invitations, respostas, logs de auditoria e exportações. Forneça workflow de exclusão consistente com seu modelo de anonimato.

Esteja pronto para DPA: mantenha lista de subprocessadores (e-mail/SMS, analytics, hosting), documente finalidades de processamento e tenha um ponto de contato para solicitações de privacidade.

Adicione testes unitários e de integração para permissões: “Quem pode ver o quê?” e “Quem pode exportar o quê?” devem ser cobertos.

Teste casos de borda de privacidade: limiares para times pequenos, links de convite encaminhados, envios repetidos e comportamento de exportação. Realize revisões periódicas de segurança e mantenha um log de auditoria de ações admin e acessos a dados sensíveis.

Um app de pesquisas internas bem‑sucedido não está “pronto” no lançamento. Trate a primeira versão como uma ferramenta de aprendizado: deve resolver uma necessidade real de feedback, provar confiabilidade e conquistar confiança — depois expanda com base no uso.

Mantenha o MVP focado no ciclo completo da criação ao insight. No mínimo, inclua:

Aposte em “rápido para publicar” e “fácil de responder”. Se admins precisarem de treinamento só para enviar uma pesquisa, a adoção vai estagnar.

Se estiver com recursos limitados, ferramentas como Koder.ai podem ajudar: descreva papéis, modos de anonimato, limiares de relatório e canais de distribuição em modo de planejamento, gere um app inicial e itere rapidamente — preservando a opção de exportar código-fonte e rodar no seu próprio ambiente.

Comece com um piloto em um único time ou departamento. Use um pulse curto (5–10 perguntas) e prazos apertados (ex.: aberto por uma semana, resultados revisados na semana seguinte).

Inclua algumas perguntas sobre a própria ferramenta: Foi fácil acessar? Algo foi confuso? Expectativas de anonimato corresponderam à realidade? Esse meta‑feedback ajuda a corrigir atritos antes do lançamento amplo.

Mesmo o melhor produto precisa de clareza interna. Prepare:

Se tiver intranet, publique uma fonte única de verdade (ex.: /help/surveys) e linke-a nos convites.

Acompanhe alguns sinais operacionais diariamente nas primeiras execuções: entregabilidade (bounces/spam), taxa de resposta por audiência, erros no app e desempenho em mobile. A maioria dos abandonos acontece no login, compatibilidade de dispositivo ou comunicação/expectativa de anonimato.

Quando o MVP estiver estável, priorize melhorias que reduzam esforço admin e aumentem ação: integrações (HRIS/SSO, Slack/Teams), biblioteca de templates, lembretes mais inteligentes e analytics avançado (tendências ao longo do tempo, segmentação com limiares de privacidade, rastreamento de ações).

Mantenha o roadmap vinculado a resultados mensuráveis: criação mais rápida de pesquisas, maior taxa de conclusão e seguimento de ações mais claro.

Comece listando as categorias de pesquisa recorrentes que você precisa (pulse, engajamento, sugestões, 360, pós-evento). Para cada uma, defina:

Isso evita construir uma ferramenta genérica que não atende a nenhum dos seus programas reais.

Use um conjunto pequeno e claro de papéis e limite resultados por padrão:

Acompanhe alguns resultados mensuráveis:

Use esses indicadores para avaliar o valor após o lançamento e priorizar o que construir a seguir.

Suporte modos explícitos e rotule-os de forma consistente no construtor, nos convites e na UI do respondente:

Adicione também um pequeno painel “Quem pode ver o quê” antes da submissão para que a promessa fique inequívoca.

Aplique regras de privacidade em todos os pontos onde os resultados podem ser fatiados:

Mostre mensagens claras como “Não há respostas suficientes para proteger o anonimato.”

Trate comentários como alto valor/alto risco:

Mantenha comentários originais imutáveis e armazene tags/observações separadamente para auditoria.

Ofereça múltiplos canais de convite e mantenha as mensagens curtas (tempo de resposta + data de fechamento):

Para autenticação, opções comuns são SSO, magic links ou acesso baseado em ID de empregado. Se a pesquisa for anônima, explique como o anonimato é preservado mesmo que o usuário autentique para evitar duplicatas.

Inclua estes essenciais:

Invista em estados vazios e mensagens de erro que digam a usuários não técnicos exatamente o que fazer em seguida.

Use um pequeno conjunto de entidades centrais e separe autoria, distribuição e resultados:

Armazene respostas brutas em uma estrutura tipada answers e construa agregados/materialized views para relatório. Para pesquisas anônimas, mantenha mapeamentos de identidade (se existirem) separados e com controle rígido.

Entregue um MVP que complete o ciclo da criação ao insight:

Pilote com um time usando um pulse de 5–10 perguntas por uma semana e reveja os resultados na semana seguinte. Inclua algumas perguntas sobre o acesso à ferramenta e se expectativas de anonimato corresponderam à experiência.

Redija permissões em linguagem simples e mostre uma nota de acesso nas páginas de resultados (ex.: “Resultados agregados para Engenharia (n=42)”).