O que quebra quando você começa a vender para empresas

Vender para equipes pequenas é em grande parte sobre recursos e velocidade. Vender para empresas muda a definição de “bom”. Uma interrupção, um bug confuso de permissões ou uma trilha de auditoria ausente podem desfazer meses de confiança.

Confiabilidade, em termos simples, significa três coisas: o app continua no ar, os dados ficam seguros e o comportamento é previsível. Essa última parte importa mais do que parece. Usuários empresariais planejam trabalho em torno do seu sistema. Eles esperam o mesmo resultado hoje, na próxima semana e após a próxima atualização.

O que normalmente quebra primeiro não é um único servidor. É a lacuna entre o que você construiu para alguns usuários e o que grandes clientes assumem que já existe. Eles trazem mais tráfego, mais papéis, mais integrações e mais escrutínio de segurança e conformidade.

Os pontos de estresse iniciais são previsíveis. Expectativas de uptime saltam de “mais ou menos ok” para “precisa ser entediantemente estável”, com manejo claro de incidentes. Segurança dos dados vira assunto de diretoria: backups, recuperação, logs de acesso e propriedade. Permissões ficam complicadas rápido: departamentos, contratados e acesso pelo princípio do menor privilégio. Mudança se torna arriscada: releases precisam de rollbacks e de uma forma de prevenir comportamentos-surpresa. Suporte deixa de ser “útil” e vira parte do produto, com tempos de resposta e caminhos de escalonamento.

Um cliente startup pode aceitar duas horas de queda e um pedido de desculpas rápido. Um cliente empresarial pode precisar de um resumo da causa raiz, prova de que não vai se repetir e um plano para prevenir falhas similares.

Uma checklist de prontidão empresarial não é sobre “software perfeito”. É sobre escalar sem quebrar confiança, atualizando design do produto, hábitos da equipe e operações do dia a dia juntos.

Diane Greene e a mentalidade VMware em uma página

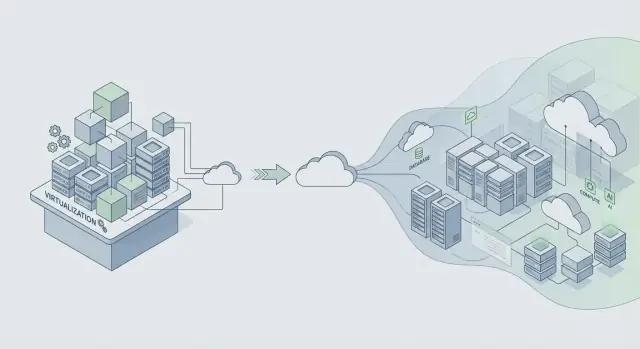

Diane Greene cofundou a VMware em um momento em que o TI empresarial enfrentava um tradeoff doloroso: mover-se rápido e arriscar quedas, ou ficar estável e aceitar mudanças lentas. A VMware importou porque fez os servidores se comportarem como blocos de construção confiáveis. Isso liberou consolidação, upgrades mais seguros e recuperação mais rápida, sem pedir que cada equipe de app reescrevesse tudo.

A promessa central para empresas é simples: estabilidade primeiro, recursos depois. Empresas querem capacidades novas, mas as querem sobre um sistema que continue rodando durante patching, escalonamento e erros rotineiros. Quando um produto se torna crítico para o negócio, “corrigimos na próxima semana” vira receita perdida, prazos perdidos e dores de conformidade.

A virtualização foi uma ferramenta prática de confiabilidade, não apenas para reduzir custos. Criou limites de isolamento. Uma carga de trabalho podia cair sem derrubar toda a máquina. Também tornou a infraestrutura mais repetível: se você pode snapshotar, clonar e mover uma carga, pode testar mudanças e recuperar mais rápido quando algo dá errado.

Essa mentalidade ainda vale: projete para mudança sem downtime. Pressupõe que componentes vão falhar, requisitos vão mudar e upgrades vão acontecer sob carga real. Então crie hábitos que tornem a mudança segura.

Uma forma rápida de descrever a mentalidade VMware é: isole a falha para que um problema não se espalhe, trate upgrades como rotineiros, faça rollback ser rápido e prefira comportamento previsível a truques espertos. Confiança se constrói com confiabilidade entediante, dia após dia.

Se você está construindo em plataformas modernas (ou gerando apps com ferramentas como Koder.ai), a lição se mantém: envie recursos apenas de formas que você consiga implantar, monitorar e desfazer sem quebrar as operações do cliente.

A VMware cresceu em um mundo de software embalado onde “um release” era um grande evento. Plataformas em nuvem inverteram o ritmo: mudanças menores entregues com mais frequência. Isso pode ser mais seguro, mas só quando você controla a mudança.

A constante: mudança é o maior risco para confiabilidade

Quer você entregue um instalador empacotado ou faça deploy na nuvem, a maioria das quedas começa da mesma forma: chega uma mudança, uma suposição oculta quebra e o raio de impacto é maior do que o esperado. Releases mais rápidos não removem risco. Eles o multiplicam quando faltam guardrails.

Times que escalam com confiabilidade assumem que cada release pode falhar e constroem o sistema para falhar com segurança.

Um exemplo simples: uma alteração “inofensiva” de índice no banco parece ok em staging, mas em produção aumenta a latência de escrita, enfileira requisições e faz com que timeouts pareçam erros de rede aleatórios. Releases frequentes te dão mais chances de introduzir esse tipo de surpresa.

Infraestrutura compartilhada mudou os modos de falha

Apps da era cloud muitas vezes servem muitos clientes em sistemas compartilhados. Configurações multi-tenant trazem problemas novos que ainda mapeiam ao mesmo princípio: isolar falhas.

Problemas de noisy neighbor (o pico de um cliente desacelera outros) e falhas compartilhadas (um deploy ruim atinge todos) são a versão moderna de “um bug derruba o cluster”. Os controles são familiares, apenas aplicados continuamente: rollouts graduais, controles por tenant, limites de recursos (quotas, rate limits, timeouts) e designs que lidam com falha parcial.

Observabilidade é a outra constante. Você não pode proteger a confiabilidade se não consegue ver o que está acontecendo. Bons logs, métricas e traces ajudam a detectar regressões rapidamente, especialmente durante rollouts.

Rollback também deixou de ser um movimento de emergência raro. É uma ferramenta normal. Muitos times emparelham rollback com snapshots e passos de deploy mais seguros. Plataformas como Koder.ai incluem snapshots e rollback, o que pode ajudar equipes a desfazer mudanças arriscadas rapidamente, mas o ponto maior é cultural: rollback deve ser praticado, não improvisado.

Se você esperar definir confiabilidade até ter um contrato empresarial na mesa, acabará argumentando por sentimentos: “Parece ok.” Clientes maiores querem promessas claras que possam repetir internamente, como “o app fica no ar” e “páginas carregam rápido o suficiente durante picos”.

Comece com um pequeno conjunto de metas escritas em linguagem simples. Duas que a maioria das equipes concorda rápido são disponibilidade (com que frequência o serviço está utilizável) e tempo de resposta (quão rápidas as ações-chave parecem). Mantenha metas ligadas ao que os usuários fazem, não a uma métrica de servidor isolada.

Um error budget torna essas metas utilizáveis no dia a dia. É a quantidade de falha que você pode “gastar” em um período de tempo enquanto ainda cumpre sua promessa. Quando você está dentro do orçamento, pode correr mais riscos de entrega. Quando o queima, trabalho de confiabilidade passa a ter prioridade sobre novos recursos.

Para manter metas honestas, acompanhe alguns sinais que mapeiam ao impacto real: latência nas ações principais, erros (requisições falhas, crashes, fluxos quebrados), saturação (CPU, memória, conexões do banco, filas) e disponibilidade ao longo do caminho crítico ponta a ponta.

Uma vez que as metas estejam definidas, elas devem mudar decisões. Se um release dispara erros, não debata. Pause, corrija ou faça rollback.

Se você está usando uma plataforma de vibe-coding como Koder.ai para entregar mais rápido, metas importam ainda mais. Velocidade só ajuda quando está limitada por promessas de confiabilidade que você pode cumprir.

Hábitos de arquitetura que protegem a confiabilidade em escala

O salto de confiabilidade de “funciona para nosso time” para “funciona para uma Fortune 500” é, em grande parte, arquitetura. A mudança de mentalidade chave é simples: assuma que partes do seu sistema vão falhar em um dia normal, não apenas durante uma grande falha.

Projete para falhas tornando dependências opcionais quando possível. Se seu provedor de cobrança, serviço de e-mail ou pipeline de analytics estiver lento, seu app principal ainda deve carregar, permitir login e deixar as pessoas fazerem o trabalho principal.

Limites de isolamento são seu melhor amigo. Separe o caminho crítico (login, fluxos principais, gravações no banco principal) de recursos desejáveis (recomendações, feeds de atividade, exports). Quando partes opcionais quebrarem, elas devem falhar fechadas sem arrastar o núcleo.

Alguns hábitos evitam falhas em cascata na prática:

- Coloque timeouts estritos em toda chamada de rede.

- Reencie apenas operações seguras para repetir e adicione jitter para evitar tempestades de retry.

- Use circuit breakers para que uma dependência falhando não consuma todos seus workers ou conexões do banco.

- Controle carga com filas e backpressure para que picos virem lentidões, não quedas.

- Prefira degradação graciosa: retorne resultados parciais com uma mensagem clara em vez de um 500.

Segurança dos dados é onde “a gente conserta depois” vira downtime. Planeje backups, mudanças de esquema e recuperação como se realmente fosse precisar deles, porque vai precisar. Faça drills de recuperação do mesmo jeito que faz simulações de incêndio.

Exemplo: uma equipe entrega um app React com uma API em Go e PostgreSQL. Um novo cliente empresarial importa 5 milhões de registros. Sem limites, a importação compete com o tráfego normal e tudo fica lento. Com os guardrails certos, a importação roda por uma fila, grava em batches, usa timeouts e retries seguros, e pode ser pausada sem afetar usuários do dia a dia. Se você está construindo em uma plataforma como Koder.ai, trate código gerado da mesma forma: adicione esses guardrails antes que clientes reais dependam dele.

Operações: a parte que a maioria dos produtos adiciona tarde demais

Incidentes não são prova de fracasso. São um custo normal de rodar software real para clientes reais, especialmente à medida que o uso cresce e os deploys ocorrem com mais frequência. A diferença é se sua equipe reage com calma e corrige a causa, ou se entra em pânico e repete a mesma queda no mês seguinte.

No começo, muitos produtos dependem de poucas pessoas que “sabem o que fazer”. Empresas não aceitam isso. Elas querem resposta previsível, comunicação clara e evidência de que você aprendeu com as falhas.

Prontidão de on-call (antes de precisar dela)

On-call é menos sobre heroísmo e mais sobre remover o chute às 2 da manhã. Uma configuração simples cobre a maioria do que clientes grandes se importam:

- Nomeie um dono primário para cada serviço.

- Mantenha runbooks curtos para os modos de falha principais.

- Defina escalonamento: quem ligar, quando e quão rápido.

- Rode pelo menos um drill planejado.

- Mantenha um lugar para checar status atual e mudanças recentes.

Monitoramento que importa

Se alertas disparam o dia todo, as pessoas os silenciarão, e o único incidente real passa batido. Vincule alertas ao impacto do usuário: falha de login, aumento de taxa de erros, latência ultrapassando um limiar claro ou jobs em background acumulando.

Após um incidente, faça uma revisão focada em correções, não em culpa. Registre o que aconteceu, que sinais faltaram e quais guardrails teriam reduzido o raio de impacto. Transforme isso em uma ou duas mudanças concretas, atribua um responsável e defina uma data.

Esses básicos operacionais são o que separa um “app funcionando” de um serviço em que clientes podem confiar.

Passo a passo: endureça seu app para clientes maiores

Clientes maiores raramente pedem recursos novos primeiro. Eles perguntam: “Podemos confiar nisso em produção, todo dia?” A forma mais rápida de responder é seguir um plano de hardening e produzir provas, não promessas.

Um plano prático de hardening em 5 passos

-

Liste o que você já atende vs. o que falta. Anote as expectativas empresariais que você honestamente suporta hoje (metas de uptime, controle de acesso, logs de auditoria, retenção de dados, residência de dados, SSO, horas de suporte). Marque cada item como pronto, parcial ou não atendido. Isso transforma pressão vaga em um backlog curto.

-

Adicione segurança de release antes de enviar mais. Empresas se importam menos com a frequência de deploys e mais com a capacidade de deployar sem incidentes. Use um staging que espelhe produção. Use feature flags para mudanças arriscadas, canaries para rollout gradual e um plano de rollback executável rapidamente. Se você constrói em uma plataforma que suporta snapshots e rollback (Koder.ai faz), pratique restaurar uma versão anterior até virar memória muscular.

-

Prove proteção de dados, e prove de novo. Backups não são um checkbox. Agende backups automatizados, defina retenção e rode testes de restauração no calendário. Adicione trilhas de auditoria para ações-chave (mudanças admin, exports de dados, edições de permissões) para que clientes possam investigar e satisfazer requisitos de conformidade.

-

Documente suporte e resposta a incidentes em linguagem simples. Escreva uma promessa de uma página: como reportar um incidente, tempos esperados de resposta, quem comunica atualizações e como são feitos relatórios pós-incidente.

-

Rode uma revisão de prontidão com um plano de load test realista. Escolha um cenário empresarial e teste ponta a ponta: pico de tráfego, banco lento, nó falhando e rollback. Exemplo: um cliente importa 5 milhões de registros numa segunda de manhã enquanto 2.000 usuários fazem login e geram relatórios. Meça o que quebra, corrija o gargalo principal e repita.

Faça esses cinco passos e conversas de vendas ficam mais fáceis porque você pode mostrar seu trabalho.

Uma história realista de escalonamento: um novo cliente empresarial

Um app SaaS de médio porte tem algumas centenas de clientes e uma equipe pequena. Então fecha seu primeiro cliente regulado: um banco regional. O contrato inclui expectativas rígidas de uptime, controles de acesso apertados e promessa de responder perguntas de segurança rapidamente. Nada muda nas funcionalidades principais do produto, mas mudam as regras sobre como rodá-lo.

Nos primeiros 30 dias, a equipe faz upgrades “invisíveis” que os clientes ainda percebem. Monitoramento muda de “estamos up?” para “o que está quebrado, onde e para quem?” Eles adicionam dashboards por serviço e alertas ligados ao impacto do usuário, não ao ruído de CPU. Controles de acesso ficam formais: autenticação mais forte para ações admin, papéis revisados e acesso à produção logado e com tempo limitado. Auditabilidade vira requisito de produto, com logs consistentes para falhas de login, mudanças de permissão, exports de dados e edições de configuração.

Duas semanas depois, um release dá errado. Uma migração de banco leva mais tempo que o esperado e começa a dar timeout em requisições para um subconjunto de usuários. O que impede que vire um incidente de vários dias é disciplina básica: plano claro de rollback, um líder de incidente e um script de comunicação.

Eles pausam o rollout, desviam o tráfego do caminho lento e fazem rollback para a última versão conhecida boa. Se sua plataforma suporta snapshots e rollback (Koder.ai faz), isso pode ser muito mais rápido, mas você ainda precisa de um procedimento treinado. Durante a recuperação, enviam atualizações curtas a cada 30 minutos: o que está impactado, o que está sendo feito e o próximo horário de checagem.

Um mês depois, “sucesso” parece entediante da melhor forma. Há menos alertas, mas mais significativos. A recuperação é mais rápida porque a propriedade está clara: uma pessoa no on-call, uma coordenando e uma comunicando. O banco para de perguntar “vocês têm controle?” e começa a perguntar “quando podemos ampliar o rollout?”

Crescimento muda as regras. Mais usuários, mais dados e clientes maiores transformam pequenas lacunas em quedas, incidentes ruidosos ou longas trocas de suporte. Muitos desses problemas parecem “ok” até a semana em que você assina seu primeiro contrato grande.

As armadilhas que aparecem com mais frequência:

- Entregar rápido sem botão seguro de desfazer. Se você não consegue reverter em minutos, todo deploy vira um evento de alto risco. Isso te desacelera e aumenta o estresse.

- Fazer da confiabilidade “trabalho só dos engenheiros”. Quedas também são problema de suporte e comunicação. Se o suporte não tem atualizações claras de status, a correção técnica chega tarde demais para proteger a confiança.

- Ruído de alertas que treina pessoas a ignorar alarmes. Se tudo dispara, nada é urgente. A resposta desacelera no único alerta que importa.

- Assumir que backups significam restauração. Backups mostram que dados foram salvos, não que você pode recuperar rápido. Se você não praticou restores, não conhece seu tempo real de recuperação.

- Features one-off para enterprise que enfraquecem o núcleo. Comportamentos customizados, flags escondidas e deploys de casos especiais se acumulam. Cada exceção aumenta a superfície de teste e torna incidentes mais difíceis de diagnosticar.

Um exemplo simples: uma equipe adiciona uma integração customizada para um cliente grande e faz deploy como hotfix numa sexta à noite. Não há rollback rápido, os alertas já estão ruidosos e o on-call está chutando. O bug é pequeno, mas a recuperação se arrasta por horas porque a via de restauração nunca foi testada.

Se sua checklist de prontidão empresarial tiver só itens técnicos, expanda. Inclua rollback, drills de restauração e um plano de comunicação que o suporte consiga rodar sem engenharia na sala.

Checklist de prontidão empresarial (checagens rápidas)

Quando clientes maiores perguntam “Vocês estão prontos para empresa?”, geralmente estão perguntando uma coisa: podemos confiar nisso em produção? Use isto como uma autoavaliação rápida antes de prometer qualquer coisa numa conversa de vendas.

- Confiabilidade e incidentes estão definidos (não implícitos). Você tem metas claras de uptime e performance, monitoramento com alertas e um processo de incidentes que as pessoas realmente seguem.

- Princípios básicos de segurança são aplicados por padrão. Acesso segue menor privilégio, ações administrativas são logadas e chaves/segredos têm dono e plano de rotação.

- Dados podem ser recuperados de propósito, não por sorte. Backups rodam automaticamente, restore é testado com agenda definida e você consegue explicar migrações e retenção em linguagem simples.

- Releases são controlados e reversíveis. Você consegue fazer staged releases, reverter rapidamente e tem um processo simples de aprovação (mesmo que seja apenas uma nota de mudança e uma segunda revisão).

- Promessas de suporte batem com a realidade. Você tem um fluxo de suporte (triagem, severidade, tempos de resposta) e um dono claro para escalonamentos.

Antes de mostrar uma demo, junte provas que você pode apontar sem rodeios: screenshots de monitoramento mostrando taxa de erro e latência, um exemplo de log de auditoria redigido (“quem fez o quê, quando”), uma nota de drill de restauração (o que foi restaurado e quanto tempo levou) e uma nota de uma página sobre release e rollback.

Se você constrói apps em uma plataforma como Koder.ai, trate essas checagens da mesma forma. Metas, evidências e hábitos repetíveis importam mais que as ferramentas usadas.

Prontidão empresarial não é um empurrão único antes de um grande contrato. Trate como uma rotina que mantém seu produto calmo sob pressão, mesmo quando equipes, tráfego e expectativas de clientes crescem.

Transforme sua checklist em um plano de ação curto. Escolha as 3 maiores lacunas que criam mais risco, torne-as visíveis e atribua donos com datas reais para cumprimento. Defina “feito” em termos simples (por exemplo, “alerta dispara em 5 minutos” ou “restore testado ponta a ponta”). Mantenha uma pequena faixa no backlog para blockers empresariais para que trabalho urgente não os enterre. Quando fechar uma lacuna, documente o que mudou para que novos colegas possam repetir.

Crie um documento interno de prontidão que você reutilize para cada grande prospect. Mantenha curto e atualize após cada conversa séria com cliente. Um formato simples funciona bem: metas de confiabilidade, princípios básicos de segurança, tratamento de dados, deploy e rollback, e quem está on-call.

Faça revisões de confiabilidade mensais ligadas a eventos reais, não opiniões. Use incidentes e quase-incidentes como pauta: o que falhou, como você detectou, como recuperou e o que vai impedir repetição.

Se você constrói com Koder.ai, incorpore prontidão na forma como entrega. Use o Planning Mode cedo para mapear requisitos empresariais antes de se comprometer com builds, e confie em snapshots e rollback durante releases para que correções permaneçam de baixo estresse à medida que seu processo amadurece. Se quiser um único lugar para centralizar esse fluxo, koder.ai foi projetado para construir e iterar via chat enquanto mantém controles práticos como exportação de fonte, deploy e rollback ao alcance.