05 de jun. de 2025·8 min

Como as linguagens de programação refletem as necessidades da sua época

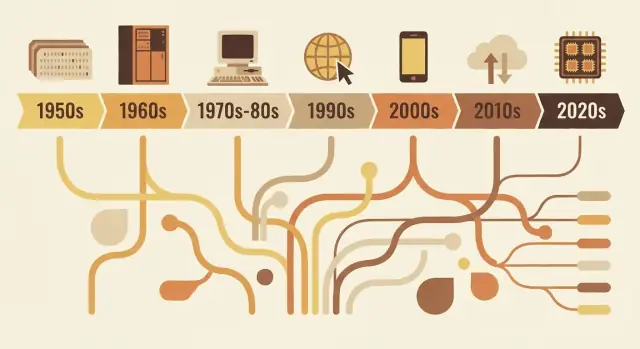

De FORTRAN a Rust, linguagens carregam as prioridades de cada época: limites de hardware, segurança, web e trabalho em equipe. Veja como escolhas de design respondem a problemas reais.

Por que as linguagens são do jeito que são

Linguagens de programação não são simplesmente versões “melhores” ou “piores” umas das outras. Elas são respostas de design aos problemas que as pessoas precisavam resolver em um dado momento da computação.

O que “design de linguagem” realmente inclui

Quando falamos de design de linguagem, estamos falando de mais do que da aparência do código na tela. Uma linguagem é um conjunto de decisões, como:

- Sintaxe: como você expressa ideias (palavras-chave, pontuação, legibilidade)

- Tipos: se valores têm categorias declaradas (e quão estritamente a linguagem as checa)

- Modelo de memória: quem gerencia a memória e quais garantias de segurança existem

- Modelo de execução: compilada vs interpretada, comportamento em tempo de execução, compensações de desempenho

- Biblioteca padrão + ferramentas: pacotes, sistemas de build, depuradores, formatadores e como equipes entregam software

Essas escolhas tendem a se agrupar em torno das restrições da época: hardware limitado, tempo de computação caro, falta de funcionalidades do sistema operacional ou (mais tarde) equipes enormes, redes globais e ameaças de segurança.

A ideia central

Linguagens espelham sua época. Linguagens iniciais priorizavam extrair valor de máquinas escassas. Linguagens posteriores priorizaram portabilidade, conforme o software precisou rodar em muitos sistemas. À medida que projetos cresceram, as linguagens passaram a favorecer estrutura, abstração e ferramentas para manter grandes bases de código compreensíveis. Mais recentemente, concorrência, implantação na nuvem e preocupações com segurança empurraram novos trade-offs.

Este artigo foca em exemplos representativos—não em uma linha do tempo completa ano a ano. Você verá como algumas linguagens influentes incorporam as necessidades de seu período e como ideias são recicladas e refinadas.

Por que isso importa ao escolher ferramentas hoje

Entender o “porquê” por trás de uma linguagem ajuda a prever seus pontos fortes e pontos cegos. Esclarece perguntas como: esta linguagem foi otimizada para desempenho máximo, iteração rápida, manutenção por grandes equipes ou segurança? Ao decidir o que aprender ou usar em um projeto, esse contexto é tão prático quanto qualquer checklist de recursos.

Restrições da computação inicial que moldaram tudo

As linguagens de programação iniciais foram moldadas menos por gosto e mais pela física e orçamentos. Máquinas tinham quantidades reduzidas de memória, armazenamento era escasso e CPUs eram lentas comparadas aos padrões atuais. Isso forçava trocas constantes: cada recurso extra, cada instrução mais longa e cada camada de abstração tinha um custo real.

Pouca memória, ciclos caros

Se você só tem espaço para um programa pequeno e um conjunto de dados reduzido, você projeta linguagens e ferramentas que mantêm programas compactos e previsíveis. Sistemas antigos empurravam programadores para fluxos de controle simples e suporte mínimo de tempo de execução. Até recursos “agradáveis de ter”—como strings ricas, gerenciamento dinâmico de memória ou estruturas de dados de alto nível—podiam ser impraticáveis porque exigiam código extra e controle adicional.

Processamento em lote e longos ciclos de feedback

Muitos programas antigos eram executados em lote. Você preparava um job (frequentemente com cartões perfurados), submetia e esperava. Se algo dava errado, você só descobria depois—quando o job terminava ou falhava.

Esse longo ciclo de feedback mudou o que importava:

- Programas precisavam rodar corretamente na primeira vez, porque reexecuções eram caras.

- Depurar era mais lento, então desenvolvedores confiavam em planejamento cuidadoso e convenções.

- Ferramentas e exploração interativa não eram a experiência padrão.

Por que legibilidade e mensagens de erro não eram prioridade

Quando o tempo de máquina era precioso e as interfaces limitadas, linguagens não otimizavam por diagnósticos amigáveis ou clareza para iniciantes. Mensagens de erro frequentemente precisavam ser curtas, às vezes crípticas, e focadas em ajudar um operador a localizar um problema em um conjunto de cartões ou em uma linha de saída impressa.

Ciência e matemática impulsionaram recursos iniciais

Uma grande parte da demanda computacional inicial veio de trabalhos científicos e de engenharia: cálculos, simulações e métodos numéricos. Por isso, recursos iniciais frequentemente se centravam em operações aritméticas eficientes, arrays e formas de expressar fórmulas que mapeassem bem para o hardware—e para a maneira como cientistas já trabalhavam no papel.

FORTRAN, COBOL e linguagens construídas para trabalhos específicos

Algumas linguagens iniciais não tentavam ser universais. Foram criadas para resolver uma classe estreita de problemas de forma excelente—porque computadores eram caros, tempo era escasso e “bom o bastante para tudo” muitas vezes significava “ótimo para nada em particular”.

FORTRAN: trabalho numérico, velocidade e a rotina do cientista

FORTRAN (FORmula TRANslation) foi direcionado ao cálculo científico e de engenharia. Sua promessa central era prática: permitir que pessoas escrevessem programas pesados em matemática sem codificar cada detalhe em assembly.

Esse objetivo moldou seu design. Enfatizava operações numéricas e computação estilo array, e focava fortemente em desempenho. A inovação real não foi só a sintaxe—foi a ideia de que um compilador poderia gerar código de máquina eficiente o suficiente para que cientistas confiassem nele. Quando seu trabalho central é simulação, tabelas balísticas ou cálculos físicos, reduzir o tempo de execução não é luxo; é a diferença entre obter resultados hoje ou na próxima semana.

COBOL: registros de negócios, legibilidade e relatórios

COBOL mirava um universo diferente: governos, bancos, seguradoras, folha de pagamento e inventário. Esses são problemas de “registros e relatórios”—dados estruturados, fluxos previsíveis e muita auditoria.

Logo, COBOL favoreceu um estilo verboso e semelhante ao inglês que tornava programas mais fáceis de revisar e manter em grandes organizações. Definições de dados eram uma preocupação de primeira classe, porque software de negócios vive e morre pela capacidade de modelar formulários, contas e transações.

O que “próximo ao domínio” realmente significa

Ambas as linguagens mostram um princípio de design que ainda importa: o vocabulário deve refletir o trabalho.

FORTRAN fala em matemática e computação. COBOL fala em registros e procedimentos. Sua popularidade revela as prioridades da época: não a experimentação abstrata, mas fazer cargas de trabalho reais de forma eficiente—se isso significava computação numérica mais rápida ou tratamento claro de dados de negócios e relatórios.

A era dos sistemas: portabilidade e controle (C, Unix)

No final dos anos 1960 e 1970, computadores estavam ficando mais baratos e comuns—mas ainda eram muito diferentes entre si. Se você escrevia software para uma máquina, portar para outra frequentemente significava reescrever grandes partes manualmente.

A dor do assembly empurrou linguagens para cima

Muito software importante era escrito em assembly, que dava máximo desempenho e controle, mas a um alto custo: cada CPU tinha seu conjunto de instruções, o código era difícil de ler e pequenas mudanças podiam implicar dias de edições cuidadosas. Essa dor criou demanda por uma linguagem que ainda parecesse “próxima do metal”, mas que não o prendesse a um processador.

O objetivo central do C: código de sistema portátil

C surgiu como um compromisso prático. Foi projetado para escrever sistemas operacionais e ferramentas—especialmente o Unix—mantendo portabilidade entre hardwares. C deu aos programadores:

- Um conjunto simples e direto de recursos que podia ser compilado em muitas máquinas

- Acesso direto à memória via ponteiros

- A capacidade de escrever código de baixo nível sem voltar para assembly a cada detalhe

O Unix reescrito em C é o ponto de prova famoso: o sistema operacional podia viajar para novos hardwares muito mais facilmente do que um sistema feito só em assembly.

Por que gerenciamento manual de memória era aceitável

C esperava que você gerenciasse a memória (alocá-la, liberá-la, evitar erros). Isso soa arriscado hoje, mas combinava com as prioridades da época. Máquinas tinham recursos limitados, sistemas operacionais precisavam de desempenho previsível e programadores costumavam trabalhar mais próximos do hardware—às vezes conhecendo exatamente o layout de memória que queriam.

A troca duradoura

C otimizou para velocidade e controle, e entregou. O preço foi segurança e facilidade: estouros de buffer, crashes e bugs sutis tornaram-se riscos normais. Naquela era, esses riscos eram frequentemente considerados um custo aceitável por portabilidade e desempenho.

Tornando grandes programas mantíveis: estrutura e tipos

À medida que programas cresceram de utilitários pequenos e pontuais para produtos que rodavam negócios, um novo problema dominou: não apenas “conseguimos fazer funcionar?” mas “conseguimos manter funcionando por anos?” Código inicial frequentemente evoluía por remendos e saltos com goto, produzindo “código espaguete” difícil de ler, testar ou mudar com segurança.

O que programação estruturada tentou consertar

Programação estruturada promoveu uma ideia simples: código deve ter forma clara. Em vez de saltos para linhas arbitrárias, desenvolvedores usaram blocos bem definidos—if/else, while, for e switch—para tornar o fluxo de controle previsível.

Essa previsibilidade importava porque depuração é, em grande parte, responder “como a execução chegou aqui?” Quando o fluxo é visível na estrutura, menos bugs se escondem nas lacunas.

A ascensão de equipes e bases de código de longa vida

Quando o software se tornou atividade de equipe, a manutenção virou um problema social tanto quanto técnico. Novos colegas precisavam entender código que não escreveram. Gerentes precisavam estimativas para mudanças. Empresas precisavam confiança de que updates não quebrariam tudo.

Linguagens responderam incentivando convenções que escalam além da memória de uma pessoa: limites consistentes de função, vidas de variáveis mais claras e formas de organizar código em arquivos e bibliotecas separados.

Por que tipos, módulos e escopos ganharam valor

Tipos começaram a importar mais porque servem como “documentação embutida” e detecção precoce de erros. Se uma função espera um número e recebe texto, um sistema de tipos forte pode pegar isso antes de chegar aos usuários.

Módulos e escopos ajudaram a limitar a área de impacto de mudanças. Mantendo detalhes privados e expondo apenas interfaces estáveis, equipes podiam refatorar internals sem reescrever o programa todo.

Movimentos de design que suportaram composição

Melhorias comuns incluíram:

- Funções menores e bem nomeadas que fazem uma única tarefa

- Escopo léxico para evitar interações acidentais entre variáveis

- Padrões melhores de composição (passar funções/dados de forma clara em vez de depender de estado global)

Juntos, essas mudanças empurraram linguagens para código mais fácil de ler, revisar e evoluir com segurança.

Objetos e a era empresarial: por que OOP se tornou mainstream

Itere sem medo

Salve o progresso com instantâneos e reverta com segurança ao experimentar.

Programação orientada a objetos (OOP) não “venceu” porque era a única boa ideia—venceu porque combinava com o que muitas equipes precisavam construir: software empresarial de longa vida mantido por muitas pessoas.

O que OOP prometia

OOP ofereceu uma história organizada para a complexidade: representar o programa como um conjunto de “objetos” com responsabilidades claras.

Encapsulamento (esconder detalhes internos) soou como uma forma prática de evitar quebras acidentais. Herança e polimorfismo prometiam reaproveitamento: escrever uma versão geral uma vez, especializá-la depois e conectar implementações diferentes à mesma interface.

Por que GUIs e apps empresariais impulsionaram isso

Com a explosão de software de desktop e interfaces gráficas, desenvolvedores precisavam gerir muitos componentes interativos: janelas, botões, documentos, menus e eventos. Pensar em termos de objetos e mensagens mapeava bem para essas partes interativas.

Ao mesmo tempo, sistemas empresariais cresceram em domínios como banca, seguradora, inventário e RH. Esses ambientes valorizavam consistência, colaboração em equipe e bases de código que pudessem evoluir por anos. OOP atendia a uma necessidade organizacional: dividir trabalho em módulos de propriedade de equipes diferentes, aplicar limites e padronizar como recursos eram adicionados.

Onde ajudou—e onde complicou

OOP brilha quando cria limites estáveis e componentes reutilizáveis. Fica doloroso quando desenvolvedores sobre-modelam tudo, criando hierarquias de classes profundas, “objetos deus” ou padrões usados mais por moda do que por necessidade. Camadas demais podem tornar mudanças simples uma burocracia.

Influência duradoura

Mesmo linguagens que não são “puras OOP” tomaram emprestado seus padrões: estruturas tipo classe, interfaces, modificadores de acesso e padrões de projeto. Muito da sintaxe mainstream moderna ainda reflete o foco daquela época em organizar grandes equipes em torno de grandes bases de código.

A era do Java: portabilidade, segurança e escala empresarial

Java surgiu junto com um boom muito específico de software: sistemas empresariais grandes e de longa vida espalhados por uma mistura de servidores, sistemas operacionais e hardwares de fornecedores. Empresas queriam implantações previsíveis, menos crashes e equipes que pudessem crescer sem reescrever tudo a cada poucos anos.

O que a JVM resolveu: portabilidade com runtime gerenciado

Em vez de compilar direto para instruções de uma máquina, Java compila para bytecode que roda na Java Virtual Machine (JVM). Essa JVM virou a “camada padrão” que empresas podiam confiar: envie o mesmo artefato e execute no Windows, Linux ou grandes caixas Unix com mudanças mínimas.

Esse é o núcleo do “write once, run anywhere”: não uma garantia de zero quirks de plataforma, mas uma forma prática de reduzir custo e risco de suportar muitos ambientes.

Padrões de segurança que reduziram falhas em produção

Java tornou segurança um recurso primário em vez de disciplina opcional.

Coleta de lixo eliminou uma categoria inteira de bugs de memória (ponteiros pendentes, double-frees) comuns em ambientes não gerenciados. Verificações de limites em arrays ajudaram a evitar leituras/escritas fora de estruturas. Combinado a um sistema de tipos mais estrito, essas escolhas visavam transformar falhas catastróficas em exceções previsíveis—mais fáceis de reproduzir, logar e corrigir.

Por que se encaixou na realidade empresarial

Empresas valorizavam estabilidade, ferramentas e governança: processos de build padronizados, forte suporte de IDE, bibliotecas extensas e um runtime que podia ser monitorado e gerenciado. A JVM também permitiu um ecossistema rico de servidores de aplicação e frameworks que tornavam o desenvolvimento em grandes equipes mais consistente.

As trocas: overhead, tuning e complexidade

Os benefícios do Java não eram gratuitos. Um runtime gerenciado adiciona tempo de startup e overhead de memória, e a coleta de lixo pode gerar picos de latência se não for ajustada. Com o tempo, o ecossistema acumulou complexidade—camadas de frameworks, configuração e modelos de implantação—que exigiam conhecimento especializado.

Mesmo assim, para muitas organizações, a barganha valia: menos falhas de baixo nível, implantação multiplataforma mais fácil e um runtime compartilhado que escalava com o tamanho da empresa e da base de código.

Linguagens de script e o impulso por produtividade

Projete a construção desde o início

Use o modo Planejamento para mapear funcionalidades antes de gerar código.

No final dos anos 1990 e 2000, muitas equipes não escreviam sistemas operacionais—estavam conectando bancos de dados, construindo sites e automatizando fluxos internos. O gargalo mudou de eficiência bruta da CPU para tempo do desenvolvedor. Feedback mais rápido e ciclos de release curtos fizeram de “com que rapidez conseguimos mudar isto?” um requisito de primeira classe.

Por que iteração rápida virou prioridade

Apps web evoluíam em dias, não em anos. Empresas queriam páginas novas, relatórios novos, integrações e correções rápidas sem um pipeline completo de compilar–linkar–implantar. Linguagens de script se encaixavam nesse ritmo: edite um arquivo, execute, veja o resultado.

Isso também mudou quem podia construir software. Administradores de sistema, analistas e pequenas equipes podiam entregar ferramentas úteis sem profundo conhecimento de gerenciamento de memória ou sistemas de build.

Tipagem dinâmica e ecossistemas “baterias incluídas”

Linguagens como Python e Ruby apostaram em tipagem dinâmica: você pode expressar uma ideia com menos declarações e cerimônia. Combinadas a bibliotecas padrão fortes, tornaram tarefas comuns “a um import de distância”:

- processamento de texto e manipulação de arquivos

- HTTP, email e redes básicas

- acesso a banco de dados e formatos de dados (CSV, JSON, XML)

Essa abordagem “baterias incluídas” recompensou a experimentação e fez scripts de automação crescerem naturalmente para aplicações reais.

Python, Ruby e PHP como respostas práticas

Python virou referência para automação e programação geral, Ruby acelerou o desenvolvimento web (especialmente via frameworks) e PHP dominou o lado servidor inicial porque era fácil de embutir diretamente em páginas e implantar praticamente em qualquer lugar.

As trocas: velocidade, erros em runtime e práticas de escalonamento

Os mesmos recursos que tornaram linguagens de script produtivas também trouxeram custos:

- execução mais lenta comparada a linguagens compiladas

- mais erros descobertos em tempo de execução

- escalabilidade exigia disciplina: testes, revisão de código, linters e convenções

Em outras palavras, linguagens de script otimizaram para mudança. As equipes aprenderam a “comprar de volta” confiabilidade com ferramentas e práticas—preparando o terreno para ecossistemas modernos onde velocidade do desenvolvedor e qualidade de software são esperadas.

JavaScript e o boom do software guiado pelo navegador

O navegador virou um “computador” surpresa entregue a milhões de pessoas. Mas não era um espaço em branco: era uma sandbox, rodava em hardware imprevisível e precisava permanecer responsivo enquanto desenhava telas e aguardava redes. Esse ambiente moldou o papel do JavaScript mais do que qualquer ideia abstrata de linguagem perfeita.

Uma plataforma com restrições incomuns

Browsers exigiam código entregue instantaneamente, executado com segurança ao lado de conteúdo não confiável e que mantivesse a página interativa. Isso empurrou o JavaScript para inicialização rápida, comportamento dinâmico e APIs fortemente ligadas à página: cliques, entradas, timers e, depois, requisições de rede.

Por que “em todo lugar” venceu sobre “perfeito”

JavaScript venceu principalmente porque já estava presente. Se você queria comportamento em um navegador, JavaScript era a opção padrão—sem etapa de instalação, sem permissões, sem runtime separado para convencer usuários a baixar. Ideias concorrentes podiam parecer mais limpas no papel, mas não conseguiam igualar a vantagem de distribuição de “funciona em todo site”.

Dirigido a eventos por necessidade

O navegador é fundamentalmente reativo: usuários clicam, páginas rolam, requisições retornam quando retornam. O estilo orientado a eventos do JavaScript (callbacks, eventos, promises) reflete essa realidade. Em vez de um programa que roda do começo ao fim, muito do código web é “espere algo, então responda”, o que encaixa bem com UI e trabalho de rede.

Efeitos de longo prazo: ecossistemas e compatibilidade

O sucesso criou um poço gravitacional. Ecossistemas enormes se formaram em torno de frameworks e bibliotecas, e o pipeline de build virou uma categoria de produto: transpilers, bundlers, minificadores e gerenciadores de pacotes. Ao mesmo tempo, a promessa da web por compatibilidade retroativa fez decisões antigas permanecerem—então o JavaScript moderno costuma parecer camadas de novas ferramentas construídas para conviver com restrições antigas.

Concorrência e a realidade multicore

Por muito tempo, computadores mais rápidos significavam: seu programa rodava mais rápido sem mudar uma linha de código. Esse acordo quebrou quando chips bateram em limites de calor e energia e começaram a adicionar núcleos em vez de aumentar o clock. De repente, obter mais desempenho frequentemente exigia fazer mais de uma coisa ao mesmo tempo.

Por que multicore tornou concorrência inevitável

Apps modernos raramente fazem uma única tarefa isolada. Atendem muitas requisições, falam com bancos de dados, renderizam UI, processam arquivos e aguardam redes—enquanto usuários esperam respostas instantâneas. Hardware multicore tornou possível executar trabalho em paralelo, mas também tornou doloroso quando uma linguagem ou runtime assumia “um thread principal, um fluxo”.

O que linguagens adicionaram para ajudar

Concorrência inicial confiava em threads do SO e locks. Muitas linguagens expuseram isso diretamente, o que funcionava—mas empurrava complexidade para desenvolvedores. Designs mais novos tentam tornar padrões comuns mais fáceis:

- Threads com primitivas mais seguras: mutexes melhores, pools de threads e modelos de memória mais claros.

- async/await: uma forma de escrever código não bloqueante que ainda lê como lógica passo a passo.

- Canais e passagem de mensagens: “compartilhe dados comunicando” (popularizado por designs estilo CSP) para reduzir bugs de estado compartilhado.

Servidores e sistemas distribuídos mudaram os padrões

À medida que software migrou para serviços sempre ativos, o programa “normal” virou um servidor lidando com milhares de requisições concorrentes. Linguagens começaram a otimizar para workloads I/O-heavy, cancelamento/timeouts e desempenho previsível sob carga.

Armadilhas que linguagens tentam evitar

Falhas de concorrência são raras e difíceis de reproduzir. O design de linguagem tem cada vez mais como alvo prevenir:

- Condições de corrida (duas tarefas atualizando os mesmos dados de forma imprevisível)

- Deadlocks (tarefas esperando umas às outras para sempre)

- Starvation (algum trabalho nunca recebe tempo de CPU)

A grande mudança: concorrência deixou de ser um tópico avançado e virou expectativa básica.

Prioridades modernas: segurança, simplicidade e ferramentas (Go, Rust)

Transforme conceitos em demos

Crie uma demo funcional para validar requisitos com sua equipe.

Nos anos 2010, muitas equipes não lutavam para expressar algoritmos—lutavam para manter serviços seguros, estáveis e fáceis de mudar sob pressão de deploy contínuo. Dois problemas sobressaíram: bugs de segurança causados por erros de memória e arrasto de engenharia causado por stacks excessivamente complexos e ferramentas inconsistentes.

Corrigindo bugs que se repetem

Uma grande parte das vulnerabilidades de alta gravidade ainda remonta a problemas de segurança de memória: estouros de buffer, use-after-free e comportamento indefinido que aparece apenas em certos builds ou máquinas. O design moderno de linguagens trata isso cada vez mais como “armas na mão” inaceitáveis, não só erros de programador.

Rust é a resposta mais clara. Suas regras de ownership e borrowing são essencialmente um acordo: você escreve código que satisfaz checagens estritas em tempo de compilação e, em troca, obtém fortes garantias sobre segurança de memória sem coletor de lixo. Isso torna Rust atraente para código de sistema que historicamente vivia em C/C++—serviços de rede, componentes embarcados, bibliotecas críticas de desempenho—onde segurança e velocidade importam.

Simplicidade e serviços como workload padrão

Go toma quase a abordagem oposta: limitar recursos da linguagem para manter bases de código legíveis e previsíveis em grandes equipes. Seu design reflete um mundo de serviços de longa execução, APIs e infraestrutura em nuvem.

As primitivas de concorrência integradas do Go (goroutines, canais) e sua biblioteca padrão suportam desenvolvimento de serviços diretamente, enquanto seu compilador rápido e história de dependências simples reduzem atrito no dia a dia.

Experiência do desenvolvedor vira recurso

Ferramentas deixaram de ser “extras opcionais” para fazerem parte da promessa da linguagem. Go normalizou essa mentalidade com gofmt e uma forte cultura de formatação padrão. Rust seguiu com rustfmt, clippy e uma ferramenta de build altamente integrada (cargo).

No ambiente atual de “entregas contínuas”, essa história de ferramentas se estende além de compiladores e linters para fluxos de trabalho de nível mais alto: planejamento, scaffolding e loops de iteração mais rápidos. Plataformas como Koder.ai refletem essa mudança ao permitir que equipes construam aplicações web, backend e mobile via interface por chat—depois exportem código-fonte, implantem e revertam com snapshots quando necessário. É outro exemplo do mesmo padrão histórico: as ferramentas que se espalham mais rápido são as que tornam o trabalho comum da época mais barato e menos sujeito a erros.

Quando formatadores, linters e sistemas de build são de primeira classe, equipes gastam menos tempo debatendo estilo ou lutando com ambientes inconsistentes—e mais tempo entregando software confiável.

O que os problemas de hoje sugerem sobre as linguagens de amanhã

Linguagens de programação não “vencem” por serem perfeitas. Vencem quando tornam o trabalho comum do momento mais barato, seguro ou rápido—especialmente quando acompanhadas pelas bibliotecas e hábitos de implantação certos.

IA, trabalho com dados e o poder dos ecossistemas

Um grande motor da popularidade atual de linguagens é onde o trabalho está: pipelines de dados, analytics, machine learning e automação. Por isso Python continua crescendo—não só pela sintaxe, mas pelo ecossistema: NumPy/Pandas para dados, PyTorch/TensorFlow para ML, notebooks para exploração e uma enorme comunidade que produz blocos reutilizáveis.

SQL é o exemplo mais discreto do mesmo efeito. Não é tendência, mas continua sendo a interface padrão para dados de negócio porque se encaixa na tarefa: consultas declarativas, otimizadores previsíveis e ampla compatibilidade entre ferramentas e fornecedores. Novas linguagens frequentemente acabam integrando SQL em vez de substituí-lo.

Enquanto isso, AI que demanda alto desempenho impulsiona ferramentas orientadas a GPU. Vemos mais atenção a vetorização, batching e aceleração de hardware—seja através de ecossistemas CUDA, MLIR e pilhas de compiladores, ou linguagens que facilitam ligar-se a esses runtimes.

O que pode moldar designs futuros de linguagem

Várias pressões provavelmente influenciarão as próximas linguagens ou grandes atualizações:

- Verificação e correção: sistemas de tipos mais fortes, concorrência mais segura e ferramentas que provam propriedades em vez de só testar.

- Privacidade e políticas: melhor suporte para governança de dados, auditabilidade e restrições sobre dados sensíveis.

- Uso de energia e eficiência: linguagens e runtimes que facilitam escrever código rápido sem micromanagement manual.

Conclusão prática

Ao escolher uma linguagem, combine-a com suas restrições: experiência da equipe, mercado de contratação, bibliotecas das quais dependerá, alvos de implantação e necessidades de confiabilidade. Uma linguagem “boa” costuma ser aquela que torna suas tarefas mais frequentes entediantes—e suas falhas mais fáceis de prevenir e diagnosticar.

Se você precisa de um ecossistema baseado em frameworks, escolha pelo ecossistema; se precisa de correção e controle, escolha por segurança e desempenho. Para uma checklist de decisão mais aprofundada, veja /blog/how-to-choose-a-programming-language.