19 de out. de 2025·8 min

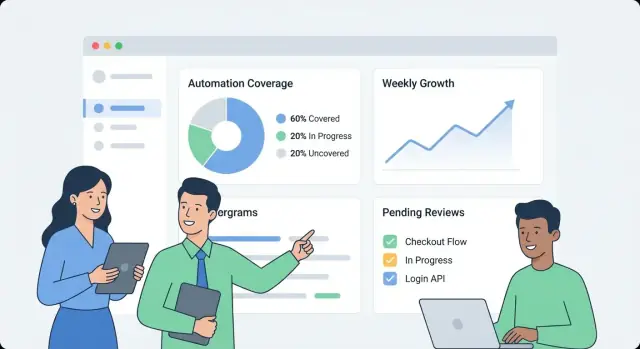

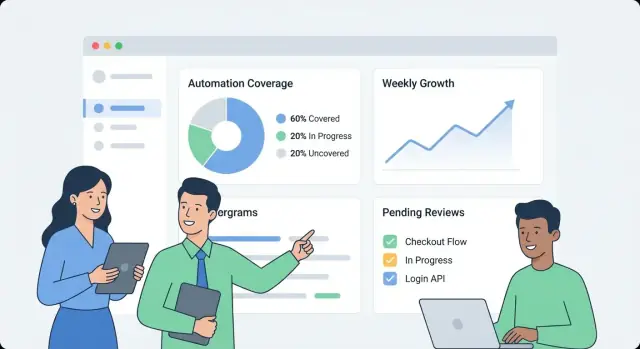

Como construir um app web para monitorar a cobertura de automação interna

Aprenda a projetar e construir um app web que rastreia cobertura de automação interna: métricas, modelo de dados, integrações, UX do painel e alertas.

Aprenda a projetar e construir um app web que rastreia cobertura de automação interna: métricas, modelo de dados, integrações, UX do painel e alertas.

Antes de construir qualquer coisa, escreva o que “cobertura de automação” significa dentro da sua organização. Caso contrário, o painel vira um amontoado de números desconexos que times diferentes interpretam de formas distintas.

Comece escolhendo as unidades que você vai medir. Opções comuns incluem:

Escolha uma definição primária para a v1 e anote tipos secundários que você pode adicionar depois. Seja explícito sobre casos de borda, como etapas “semi-automatizadas” que ainda exigem aprovações.

Públicos diferentes fazem perguntas diferentes:

Escreva 5–10 “perguntas principais” e trate-as como requisitos de produto.

Defina os resultados principais: visibilidade (o que existe), priorização (o que automatizar a seguir), responsabilização (quem é dono), e rastreamento de tendência (está melhorando?).

Estabeleça limites claros para a v1. Exemplos: “Não vamos pontuar qualidade ainda”, “Não vamos medir tempo economizado” ou “Incluir apenas testes baseados em CI, não scripts locais.”

Por fim, decida como medir sucesso: adoção consistente (usuários ativos semanais), alta atualidade dos dados (por exemplo, atualizações em até 24 horas), menos pontos cegos (cobertura mapeada para todos os sistemas críticos) e acompanhamento mensurável (donos atribuídos e lacunas diminuindo mês a mês).

Antes de medir cobertura de automação, você precisa saber onde a “evidência de automação” realmente vive. Na maioria das organizações, a automação está espalhada por ferramentas adotadas em momentos diferentes por times diferentes.

Comece com um inventário pragmático que responda: Quais sinais provam que uma atividade é automatizada e onde podemos obtê-los?

Fontes típicas incluem pipelines de CI (jobs de build/test), frameworks de teste (resultados unit/integration/E2E), ferramentas de workflow (aprovações, deploys, transições de tickets), runbooks (scripts e procedimentos documentados) e plataformas RPA. Para cada fonte, capture o identificador que você poderá juntar depois (repo, nome do serviço, ambiente, time) e a “prova” que você vai armazenar (execução de job, relatório de suíte de testes, regra de automação, execução de script).

Em seguida, liste seus sistemas de registro que definem o que “deveria existir”: hospedagem de repositório, rastreador de issues e uma CMDB/catálogo de serviços. Essas fontes costumam fornecer a lista autoritativa de serviços, donos e criticidade — essencial para calcular cobertura em vez de apenas contar atividade.

Associe cada fonte ao método de ingestão menos frágil:

Registre limites de taxa, métodos de autenticação (PAT, OAuth, service accounts), janelas de retenção e problemas conhecidos de qualidade de dados (renomeação de serviços, nomes inconsistentes, donos faltantes).

Por fim, planeje um score de confiabilidade da fonte por conector (e opcionalmente por métrica) para que os usuários vejam se um número é “alta confiança” ou “melhor esforço”. Isso evita falsa precisão e ajuda a priorizar melhorias nos conectores depois.

Um painel de cobertura útil começa com um modelo de dados que separa o que você pretende automatizar do que realmente rodou recentemente. Se você misturar esses conceitos, seus números podem parecer bons mesmo quando a automação está estagnada.

Comece com estes blocos de construção:

Escolha um nível primário de reporte e mantenha-o:

Você pode suportar múltiplas visões depois, mas a primeira versão deve ter um nível único de “fonte da verdade”.

Use IDs que sobrevivam a refatores:

Trate nomes de exibição como editáveis, não como identificadores.

Um padrão prático:

Isso permite responder: “O que deveria ser coberto?”, “O que reivindica cobrir isso?” e “O que realmente rodou?”.

Capture:

last_seen_at (o asset ainda existe)last_run_at, last_failure_atlast_reviewed_at (alguém confirmou que a claim ainda é válida)Campos de frescor facilitam destacar itens “cobertos mas obsoletos” sem debate.

Se sua métrica de cobertura for vaga, todo gráfico vira argumento. Comece escolhendo uma métrica principal para resumos executivos, depois acrescente desdobramentos de suporte para os times.

A maioria das organizações escolhe uma destas:

Você ainda pode mostrar os três, mas deixe explícito qual é o número “principal”.

Escreva regras explícitas para que os times pontuem itens de forma consistente:

Mantenha regras mensuráveis. Se duas pessoas não conseguem pontuar o mesmo item da mesma forma, refine a definição.

Use escalas inteiras pequenas (1–5) para entradas como risco, impacto de negócio, frequência de execução e tempo economizado. Exemplo: weight = risk + impact + frequency.

Não considere um item “automatizado” a menos que haja evidência, como:

Isso transforma cobertura de uma claim auto-reportada em um sinal observável.

Coloque as regras de pontuação e exemplos em uma página compartilhada (link-a no painel). Interpretação consistente é o que torna tendências confiáveis.

Um app de cobertura de automação interno deve ser “chato” no bom sentido: fácil de operar, fácil de alterar e claro sobre de onde os números vêm. Uma forma simples “API + banco + dashboard” geralmente supera um sistema distribuído até que você realmente precise dele.

Escolha uma stack que seu time já suporte. Um baseline comum é:

Se quiser acelerar a primeira versão interna, uma abordagem de aceleração pode funcionar bem: por exemplo, Koder.ai pode ajudar a gerar um dashboard React mais um backend Go + PostgreSQL a partir de uma especificação estruturada, permitindo que sua equipe itere via chat mantendo exportação completa do código e implantação convencional.

Mesmo em um sistema “simples”, separe responsabilidades:

Use tabelas relacionais para entidades canônicas (times, serviços, automações, evidências, donos). Para tendências (execuções ao longo do tempo, cobertura por semanas), mantenha ou:

Se vários times compartilham o app, adicione campos org_id/team_id cedo. Isso possibilita permissões e evita migrações dolorosas quando a liderança pedir “um único painel, mas segmentado”.

Tenha dev/staging/prod e defina como os dados transitam:

Para mais sobre como tornar a UI fácil de navegar, veja /blog/design-dashboard-ux.

Um painel de cobertura rapidamente vira fonte de verdade, então controle de acesso e tratamento de dados importam tanto quanto os gráficos. Comece simples, mas desenhe para que a segurança possa ficar mais rigorosa sem grandes reescritas.

Se sua empresa já tem SSO, integre-o desde o início (OIDC costuma ser o mais simples; SAML é comum em empresas maiores). Se precisar de um lançamento interno rápido, comece protegido por um proxy interno de autenticação que injete cabeçalhos de identidade, depois troque para SSO nativo.

Normalize identidade para uma chave de usuário estável (email pode mudar). Persista um perfil mínimo e busque associação a grupos/times quando possível.

Defina um conjunto pequeno de papéis e mantenha autorização consistente entre UI e API:

Prefira permissões baseadas em escopo (por time/serviço) em vez de “super usuários”. Isso reduz risco e evita gargalos.

Provas de cobertura costumam incluir links para logs de CI, tickets de incidente ou docs internos. Restrinja acesso a essas URLs e a logs brutos. Armazene apenas o necessário para verificação (por exemplo: ID do build, timestamp e um sumário curto) em vez de copiar logs inteiros para o banco.

Qualquer edição manual em claims de cobertura ou metadata deve gerar um registro de auditoria: quem mudou o quê, quando e por quê (campo texto livre). Finalmente, defina uma política de retenção para histórico de execuções e evidências — determine por quanto tempo guardar e implemente purga segura para que registros antigos possam ser deletados sem quebrar cálculos atuais de cobertura.

Um painel de cobertura tem sucesso quando alguém consegue responder três perguntas em menos de um minuto: Como estamos? O que está mudando? O que devemos corrigir a seguir? Desenhe a UX em torno dessas decisões, não em torno das fontes de dados.

Faça a primeira tela um resumo simples:

Mantenha labels em linguagem simples (“Automatizado recentemente” é melhor que “Recência de evidência”) e evite forçar o leitor a interpretar status técnicos.

De qualquer métrica de resumo, permita que o usuário clique em uma página de serviço/processo que responda “o quê” e “por quê”:

Projete cada linha/cartão para incluir o “porquê por trás do número”: link de evidência, dono, último status de execução e uma próxima ação clara (“Re-executar job”, “Atribuir dono”, “Adicionar evidência ausente”).

Ofereça filtros que mapeiem ao funcionamento da organização:

Mantenha o estado do filtro visível e compartilhável (parâmetros na URL), assim alguém pode enviar um link como “Prod + Tier-1 + últimos 14 dias” a um stakeholder.

Use definições inline, não documentação extensa:

Conectores são onde seu app de cobertura se torna real. O objetivo não é espelhar cada feature do CI ou das ferramentas de teste — é extrair um conjunto consistente de fatos: o que rodou, quando rodou, o que cobriu e quem é o dono.

Comece com sistemas que já produzem sinais de automação: CI (GitHub Actions, GitLab CI, Jenkins), runners de teste (JUnit, pytest) e ferramentas de qualidade (relatórios de coverage, linters, scanners de segurança).

Um conector deve obter (ou receber via webhook) o payload mínimo:

Mantenha conectores idempotentes: pulls repetidos não devem criar duplicatas.

Algumas lacunas de cobertura são intencionais (sistemas legados, restrições de terceiros, iniciativas pausadas). Forneça um registro leve de “exceção” que exija:

Isso evita pontos cegos permanentes e mantém as visões da liderança honestas.

Fontes diferentes raramente concordam em identificadores: um sistema diz “payments-service”, outro diz “payments” e um terceiro usa um slug de repo.

Crie regras de normalização para:

Faça isso cedo; cada métrica downstream depende disso.

Introduza tabelas de alias (por exemplo, service_aliases, repo_aliases) que mapeiem muitos nomes externos para uma entidade canônica. Quando novos dados chegarem, tente casar com IDs canônicos primeiro e depois com aliases.

Se um novo nome não casar, gere sugestões de merge (por exemplo, “payments-api” parece com “payments-service”) para um admin aprovar.

Agende um job recorrente que verifique o timestamp da última execução por fonte e marque o que estiver obsoleto (por exemplo, sem execuções de CI em 7 dias). Exponha isso na UI para que baixa cobertura não seja confundida com dados faltantes.

Um painel é útil, mas alertas e workflows leves são o que transformam dados interessantes em melhoria contínua. O objetivo é simples: notificar as pessoas certas na hora certa, com contexto suficiente para agir.

Comece com um conjunto pequeno de alertas de alto sinal:

Cada alerta deve linkar diretamente para a visão de detalhamento relevante (por exemplo, /services/payments?tab=coverage ou /teams/platform?tab=owners) para que as pessoas não precisem procurar.

Evite regras únicas para tudo. Permita que times configurem regras como:

Isso mantém sinais relevantes e reduz fadiga de alertas.

Envie alertas para canais existentes (email e Slack), e inclua: o que mudou, por que importa e o dono. Junto com alertas em tempo real, adicione um resumo semanal cobrindo:

Trate alertas como tarefas: permita acknowledgement, atribuição e status (open/triaged/resolved). Um pequeno histórico de comentários (“corrigido no PR #1234”) torna o relato crível e evita que os mesmos problemas reapareçam silenciosamente.

Um painel de monitoramento parece rápido quando a API responde às perguntas que a UI realmente faz — sem forçar o navegador a juntar dezenas de chamadas. Comece com uma superfície de API mínima voltada ao dashboard e adicione jobs em background para pré-computar o que for caro.

Mantenha a primeira versão focada nas telas centrais:

GET /api/services (filtros como team, linguagem, tier)GET /api/services/{id}/coverage (score geral + desdobramentos chave)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}Projete respostas para que o dashboard renderize imediatamente: inclua nome do serviço, dono, último timestamp de evidência e score atual em um único payload em vez de exigir várias buscas.

Listas e tabelas de detalhamento devem sempre ser paginadas (limit + cursor). Para endpoints muito acessados, adicione cache na camada de API (ou um cache compartilhado) com chave baseada em filtros e escopo de acesso do chamador.

Para qualquer coisa que exija varredura de muita evidência (por exemplo, “cobertura por time”), pré-compute rollups em um job noturno. Armazene rollups em uma tabela separada (ou view materializada) para que leituras sejam simples e previsíveis.

Tendências ficam fáceis quando você guarda snapshots diários:

GET /api/services/{id}/trend?days=90.Snapshots evitam recalcular métricas históricas a cada carregamento de página e tornam o “frescor” (quão recentemente houve execução) fácil de plotar.

Onboarding em massa fica melhor com:

POST /api/import/services (upload CSV)GET /api/export/services.csvPor fim, aplique validações na escrita: owner requerido, valores de status permitidos e timestamps sensatos (sem evidência no futuro). Rejeitar dados ruins cedo evita correções lentas e confusas depois — especialmente quando rollups dependem de entradas consistentes.

Um painel de cobertura só é útil se as pessoas confiarem nele. Trate deployment e operações como parte do produto: releases previsíveis, sinais claros de saúde e recuperação simples quando algo quebrar.

Para um app interno, otimize por baixa sobrecarga e iteração rápida.

Se estiver usando uma plataforma como Koder.ai para acelerar desenvolvimento, aproveite exportação do código fonte e workflows de deployment cedo, para que seu app interno ainda siga práticas padrão de promoção, revisão e rollback.

Você não precisa de uma stack complexa para obter sinais confiáveis.

Configure backups automáticos do banco e uma política de retenção que atenda suas necessidades.

Documente runbooks para:

Um pouco de disciplina operacional evita que “cobertura” vire adivinhação.

Um app de monitoramento só ajuda se os times confiarem e usarem. Trate rollout como um lançamento de produto: comece pequeno, defina propriedade clara e incorpore um ritmo previsível de atualizações.

Mantenha onboarding leve e repetível:

Um bom objetivo é “primeira visão do dashboard em 30 minutos”, não uma configuração de semana.

Estabeleça dois ritmos:

Pontuações de cobertura podem virar políticas se regras mudarem inesperadamente. Defina um pequeno grupo de governança (frequentemente Eng Productivity + Security/Quality) que possa:

Publique mudanças em um changelog simples como /docs/scoring-changelog.

Acompanhe adoção com métricas diretas: usuários ativos, serviços rastreados e compliance de frescor (quantos serviços têm evidência atualizada). Use isso para guiar iterações: melhor ponderação, tipos de evidência mais ricos e conectores adicionais — sempre priorizando melhorias que reduzam trabalho manual dos times.

Se decidir compartilhar aprendizados internamente ou publicamente, considere padronizar notas de build e templates: times que usam Koder.ai também podem ganhar créditos criando conteúdo sobre seu fluxo de desenvolvimento ou indicando outros usuários via link de referência, o que pode ajudar a financiar iteração contínua em ferramentas internas.

A cobertura de automação é aquilo que sua organização decide medir como “trabalho tratado automaticamente” versus manualmente. Para evitar confusão, escolha uma unidade primária para a v1 (por exemplo: processos, requisitos/controles, suítes de testes ou runbooks) e documente regras claras para casos de borda como etapas “parcialmente automatizadas” que ainda requerem aprovações.

Uma boa definição é aquela em que duas pessoas atribuiriam a mesma avaliação ao mesmo item.

Comece escrevendo 5–10 “perguntas principais” que seus usuários precisam responder e trate-as como requisitos de produto. Exemplos comuns:

Públicos diferentes (QA, Ops, liderança) precisam de cortes diferentes — decida quais necessidades a v1 deve priorizar.

Faça um inventário de onde “provas” de automação existem e de onde vem a lista autoritativa do que “deveria existir”.

Sem um sistema de registro, você pode contar atividade, mas não calcular cobertura confiável (porque não sabe o conjunto completo de alvos).

Escolha o método menos frágil para cada fonte:

Documente também restrições do conector (limites de taxa, autenticação, janelas de retenção) para que os usuários entendam frescor e confiança dos dados.

Separe intenção, reivindicações e provas para que métricas não fiquem “verdes” enquanto a automação está obsoleta.

Um modelo prático:

Use timestamps de frescor e regras de evidência.

Campos comuns:

last_seen_at (o asset ainda existe)last_run_at, last_failure_atlast_reviewed_at (alguém confirmou que a claim ainda vale)Depois, aplique uma regra como “conta como automatizado apenas se houver N execuções bem-sucedidas nos últimos 30 dias”. Isso diferencia “existe” de “funciona recentemente.”

Escolha uma métrica principal e torne as regras de pontuação explícitas.

Opções típicas para o indicador principal:

Mantenha pesos simples (por exemplo, 1–5) e documente o que significa “automatizado / parcialmente automatizado / manual” com exemplos concretos.

Normalize identificadores cedo e trate renomes explicitamente.

Passos práticos:

service_aliases, repo_aliases) para mapear nomes externos a IDs canônicos.Isso evita duplicatas e mantém tendências históricas quando times reorganizam ou renomeiam repositórios.

Integre SSO (OIDC/SAML) se disponível, ou use temporariamente um proxy interno de autenticação que injete cabeçalhos de identidade. Defina um conjunto pequeno de papéis e mantenha permissões consistentes entre UI e API:

Armazene apenas evidências sensíveis mínimas: prefira IDs de build, timestamps e sumários curtos em vez de copiar logs inteiros. Audite edições manuais (quem/o quê/quando/por quê) e defina retenção para o histórico de execuções.

Faça alertas acionáveis e reduza ruído global.

Tipos de alerta de alto sinal:

Permita variação por time/serviço (janelas “stale” diferentes, regras de paging). Inclua links diretos para páginas de detalhamento (por exemplo, /services/payments?tab=coverage) e suporte a reconhecimento/atribuição/status para que os problemas sejam fechados de forma limpa.

Adicione propriedade (time/pessoa) e identificadores estáveis para que renomeações não estraguem o histórico.