Esclareça objetivos, usuários e métricas de sucesso

Antes de rascunhar telas ou escolher um banco de dados, alinhe o que sua equipe entende por um aplicativo web de rastreamento de incidentes — e o que a “gestão de postmortems” deve alcançar. Equipes frequentemente usam as mesmas palavras de forma diferente: para um grupo, um incidente é qualquer problema reportado por cliente; para outro, é somente uma queda Sev-1 com escalonamento on-call.

Defina “rastreamento de incidentes” para sua equipe

Escreva uma definição curta que responda:

- O que qualifica como incidente (impacto no cliente, impacto apenas interno, eventos de segurança, SLAs perdidos)?

- Quando um incidente “começa” e “termina” (primeiro alerta vs. primeiro reconhecimento humano; totalmente corrigido vs. em monitoramento)?

- Quais dados são obrigatórios (serviço afetado, severidade, responsável, timestamps, atualizações de status)?

Essa definição direciona seu fluxo de resposta a incidentes e evita que o app fique ou muito rígido (ninguém usa) ou muito frouxo (dados inconsistentes).

Defina “gestão de postmortems” (e por que você está fazendo isso)

Decida o que é um postmortem na sua organização: um resumo leve para todo incidente, ou uma RCA completa apenas para eventos de alta severidade. Torne explícito se o objetivo é aprender, cumprir regulamentação, reduzir reincidências, ou todos os três.

Uma regra útil: se você espera que um postmortem resulte em mudança, a ferramenta deve suportar rastreamento de itens de ação, não apenas armazenamento de documentos.

Liste os problemas que você está resolvendo

A maioria das equipes constrói esse tipo de app para corrigir um pequeno conjunto de dores recorrentes:

- Visibilidade: “O que está acontecendo agora?” “Com que frequência este serviço quebra?”

- Coordenação: ownership claro, handoffs e uma linha do tempo compartilhada do incidente

- Aprendizado: modelos de RCA consistentes e um processo de revisão que realmente acontece

- Acompanhamento: itens de ação não desaparecem após a reunião

Mantenha essa lista enxuta. Cada recurso incluído deve mapear para pelo menos um desses problemas.

Escolha métricas de sucesso que reflitam comportamento

Selecione algumas métricas que você possa medir automaticamente a partir do modelo de dados do app:

- Tempo para detectar, reconhecer, mitigar e resolver (sua linha do tempo de incidentes deve capturar isso)

- Frequência por severidade, serviço e categoria de causa raiz

- Taxa de fechamento de itens de ação e mediana do tempo para fechamento

- Sinais de qualidade: porcentagem de incidentes com postmortem completado dentro de N dias; porcentagem com responsável claro e atualizações de status

Essas se tornam suas métricas operacionais e sua “definition of done” para o primeiro release.

Esclareça seus usuários (e o que cada um precisa)

O mesmo app atende papéis diferentes em operações de plantão:

- Engenheiro on-call: entrada rápida, campos mínimos, atualizações de status fáceis

- Comandante do incidente: visão de coordenação, estado atual, responsáveis, checkpoints

- Gerentes: tendências, problemas recorrentes, acompanhamento de itens de ação

- Stakeholders: atualizações de status claras sem ruído interno

Se você desenhar para todos ao mesmo tempo, vai construir uma UI poluída. Em vez disso, escolha um usuário principal para a v1 — e garanta que os outros ainda consigam o que precisam via views, dashboards e permissões sob medida mais tarde.

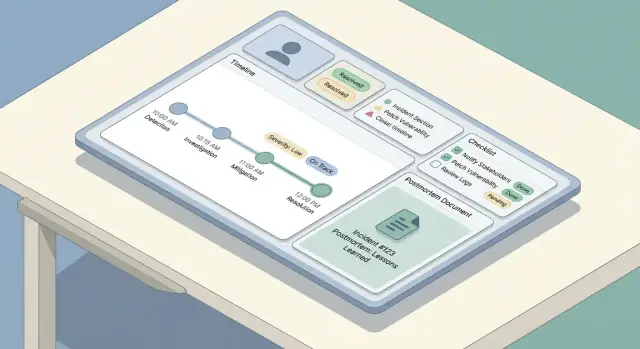

Desenhe o fluxo de incidentes e os papéis

Um fluxo claro previne dois modos comuns de falha: incidentes que ficam parados porque ninguém sabe “o que vem a seguir”, e incidentes que parecem “concluídos” mas nunca geram aprendizado. Comece mapeando o ciclo de vida de ponta a ponta e então anexe papéis e permissões a cada passo.

Mapeie o ciclo de vida do incidente

A maioria das equipes segue um arco simples: detectar → triar → mitigar → resolver → aprender. Seu app deve refletir isso com um conjunto pequeno de passos previsíveis, não um menu infinito de opções.

Defina o que “concluído” significa para cada etapa. Por exemplo, mitigação pode significar que o impacto ao cliente foi interrompido, mesmo que a causa raiz ainda seja desconhecida.

Defina papéis e responsabilidades

Mantenha papéis explícitos para que as pessoas possam agir sem esperar por reuniões:

- Repórter: cria o incidente, adiciona contexto inicial, anexa links/logs.

- Respondedor: investiga, adiciona atualizações, executa mitigações.

- Comandante do Incidente: coordena, designa respondedores, aprova severidade, controla atualizações aos stakeholders.

- Revisor: lidera a revisão pós-incidente, garante qualidade do postmortem.

Sua UI deve tornar o “responsável atual” visível, e o fluxo deve suportar delegação (reatribuir, adicionar respondedores, rotacionar comandante).

Estados e transições

Escolha estados obrigatórios e transições permitidas, como Investigating → Mitigated → Resolved. Adicione guardrails:

- Exigir severidade antes de avançar após a triagem.

- Exigir um resumo de resolução antes de marcar como Resolved.

- Evitar “Resolved → Investigating” a menos que um motivo de reabertura seja registrado.

Planeje canais de comunicação

Separe atualizações internas (rápidas, táticas, podem ser confusas) de atualizações para stakeholders (claras, com timestamp, curadas). Construa dois fluxos de atualização com templates, visibilidade e regras de aprovação diferentes — frequentemente o comandante é o único publicador para stakeholders.

Modele os dados: entidades, relacionamentos e histórico

Uma boa ferramenta de incidentes parece “simples” na UI porque o modelo de dados por trás é consistente. Antes de construir telas, decida quais objetos existem, como se relacionam e o que precisa ser historicamente preciso.

Entidades principais (os objetos que você armazena)

Comece com um pequeno conjunto de objetos de primeira classe:

- Incidente: o contêiner para tudo que aconteceu.

- Serviço: o que você opera (API, banco de dados, app móvel), usado para impacto e relatórios.

- Atualização: atualizações legíveis por humanos (para notas internas e status externos).

- Evento da linha do tempo: fatos precisos com timestamp (“alerta disparou”, “rollback”, “mitigação aplicada”).

- Item de ação: follow-ups com responsáveis e datas de vencimento.

- Postmortem: o relatório estruturado (impacto, análise de causa raiz, lições, links).

Relacionamentos e identificadores

A maioria dos relacionamentos é um-para-muitos:

- Um Incidente → muitas Atualizações / Eventos da linha do tempo / Itens de Ação

- Um Incidente → um (ou zero) Postmortem

- Um Incidente ↔ muitos Serviços (normalmente muitos-para-muitos via join “affected_services”)

Use identificadores estáveis (UUIDs) para incidentes e eventos. Humanos ainda precisam de uma chave amigável como INC-2025-0042, que você pode gerar a partir de uma sequência.

Modele isso cedo para poder filtrar, buscar e reportar:

- Severidade, status (open/mitigated/resolved), tags

- Tempo de início, fim, tempo de detecção

- Comandante do incidente, time proprietário, rotação on-call (opcional)

- Serviços afetados, resumo de impacto ao cliente

Histórico, retenção e auditabilidade

Dados de incidentes são sensíveis e frequentemente revisados posteriormente. Trate edições como dados — não sobrescritas:

- Armazene created_at/created_by em cada registro.

- Para edições, mantenha um log de auditoria (mudanças de campo + ator + timestamp), ou versionamento de documentos importantes (postmortem, atualizações).

- Decida retenção desde o início (ex.: manter incidentes indefinidamente, purgar transcrições de chat após N dias).

Essa estrutura facilita recursos futuros — busca, métricas e permissões — sem retrabalho.

Construa a entrada de incidentes, atualizações e a linha do tempo

Quando algo quebra, o trabalho do app é reduzir digitação e aumentar clareza. Esta seção cobre o "caminho de escrita": como as pessoas criam um incidente, o mantêm atualizado e reconstruem o que aconteceu depois.

Entrada do incidente: campos mínimos, padrões inteligentes

Mantenha o formulário curto o bastante para terminar enquanto você soluciona o problema. Um bom conjunto padrão de campos obrigatórios é:

- Título (linguagem simples: “Erros no checkout no mobile”)

- Serviço/Sistema (escolha de uma lista para evitar variantes de escrita)

- Severidade (padrão baseado no serviço ou horário, mas editável)

- Repórter (auto-preenchido com o usuário logado)

Todo o resto deve ser opcional na criação (impacto, links de tickets de cliente, causa suspeita). Use padrões inteligentes: defina start time como “agora”, pré-selecione o time on-call do usuário e ofereça uma ação de um toque “Criar & abrir sala do incidente”.

Atualizações rápidas: status, impacto, próximos passos

Sua UI de atualização deve ser otimizada para edições pequenas e repetidas. Forneça um painel compacto de atualização com:

- Status (Investigando / Identificado / Mitigado / Resolvido)

- Resumo do impacto (uma ou duas frases)

- Notas principais (o que mudou desde a última atualização)

- Próximos passos (o que está sendo feito, por quem)

Faça atualizações append-friendly: cada atualização vira uma entrada com timestamp, não uma sobrescrita do texto anterior.

Linha do tempo: histórico automático e eventos manuais

Construa uma linha do tempo que misture:

- Eventos auto-capturados: mudanças de campo (severidade, status), responsáveis, links adicionados, hora da resolução

- Eventos manuais: “Deployed hotfix”, “Rollback”, “Failover de BD iniciado”

Isso cria uma narrativa confiável sem forçar as pessoas a lembrarem de registrar cada clique.

Desenhe para velocidade no mobile

Durante uma queda, muitas atualizações acontecem pelo telefone. Priorize uma tela rápida e de baixo atrito: alvos táteis grandes, uma única página rolável, rascunhos offline-friendly e ações de um toque como “Publicar atualização” e “Copiar link do incidente”.

Adicione severidade, checklists e contexto de apoio

Severidade é o “discador de urgência” da resposta a incidentes: indica quão urgentemente agir, o quão amplamente comunicar e quais trade-offs são aceitáveis.

Defina níveis de severidade (e o que implicam)

Evite rótulos vagos como “alto/médio/baixo”. Faça cada nível de severidade mapear a expectativas operacionais claras — especialmente tempo de resposta e cadência de comunicação.

Por exemplo:

- SEV1 (Crítico): queda visível ao usuário ou risco sério de segurança. Page imediatamente, abra uma ponte/chat do incidente, atualize stakeholders a cada 15–30 minutos, e considere uma atualização pública de status.

- SEV2 (Maior): degradação parcial ou impacto severo. Responder rapidamente, coordenar no chat, atualizar stakeholders a cada 30–60 minutos.

- SEV3 (Menor): impacto limitado, workaround disponível. Tratar durante horário comercial quando apropriado, atualizar em marcos.

- SEV4 (Info): sem impacto imediato; acompanhar como questão operacional.

Deixe essas regras visíveis na UI sempre que a severidade for escolhida, para que os respondedores não precisem procurar documentação.

Checklists reduzem carga cognitiva quando as pessoas estão sob estresse. Mantenha-os curtos, acionáveis e vinculados a papéis.

Um padrão útil é algumas seções:

- Triagem: confirmar impacto ao cliente, identificar blast radius, definir severidade, nomear líder do incidente.

- Mitigação: validar ações de rollback/feature flag, verificar sinais de recuperação, monitorar regressão.

- Comms: notificar suporte, postar atualização interna, decidir sobre /status update, capturar mensagem voltada ao cliente.

Faça itens do checklist com timestamp e atribuível, para que entrem no registro do incidente.

Vincule artefatos de suporte (para não perder contexto)

Incidentes raramente vivem em uma única ferramenta. Seu app deve permitir que respondedores anexem links para:

- Dashboards e gráficos específicos

- Queries de logs

- Tickets/Issues

- Threads de chat ou canais de war-room

- Runbooks e playbooks

Prefira links “tipados” (ex.: Runbook, Ticket) para que possam ser filtrados depois.

Capture impacto em SLA/SLO quando relevante

Se sua organização rastreia metas de confiabilidade, adicione campos leves como SLO afetado (sim/não), estimativa de queima do budget de erros, e risco para SLA de cliente. Mantenha-os opcionais — mas fáceis de preencher durante ou logo após o incidente, enquanto os detalhes estão frescos.

Crie modelos de postmortem e fluxo de revisão

Facilite o acesso

Lance uma ferramenta interna com um domínio personalizado que sua equipe lembrará.

Um bom postmortem é fácil de começar, difícil de esquecer e consistente entre equipes. A maneira mais simples de chegar lá é oferecer um modelo padrão (com campos mínimos obrigatórios) e pré-preenchê-lo a partir do registro do incidente para que as pessoas gastem tempo pensando — não reescrevendo.

Um template prático de postmortem (o que incluir)

Seu modelo embutido deve equilibrar estrutura e flexibilidade:

- Resumo: o que aconteceu em linguagem simples (2–5 frases).

- Impacto: quem/o que foi afetado, por quanto tempo, sintomas visíveis ao usuário e impacto no negócio (pedidos atrasados, taxa de erro, SLAs violados).

- Causa raiz: a causa técnica/processual primária. Mantenha factual, sem focar em culpabilização.

- Fatores contribuintes: questões secundárias (lacunas de monitoramento, ownership pouco claro, timing de mudança arriscado).

- O que deu certo / o que deu errado / onde tivemos sorte: prompts que incentivam reflexões honestas e acionáveis.

Deixe “causa raiz” opcional inicialmente se quiser publicação mais rápida, mas exija-a antes da aprovação final.

Vincule automaticamente o postmortem à linha do tempo do incidente

O postmortem não deve ser um documento separado flutuando por aí. Quando um postmortem é criado, anexe automaticamente:

- A linha do tempo do incidente (atualizações chave, mudanças de status, passos de mitigação)

- Participantes (comandante, respondedores, coms)

- Artefatos (tickets relacionados, dashboards, links de logs — armazenados como referências)

Use isso para pré-preencher seções do postmortem. Por exemplo, o bloco “Impacto” pode iniciar com tempos de início/fim e severidade atual do incidente, enquanto “O que fizemos” pode puxar entradas da linha do tempo.

Fluxo de revisão e aprovação que favoreça aprendizado

Adicione um fluxo leve para evitar que postmortems travem:

- Rascunho (criado automaticamente ao fechar o incidente, ou manualmente)

- Em Revisão (revisores designados — muitas vezes IC + dono do serviço)

- Aprovado (resumo final bloqueado + notas de decisão capturadas)

- Publicado (compartilhado internamente; opcionalmente ligado a uma atualização pública)

Em cada etapa, capture notas de decisão: o que mudou, por que mudou e quem aprovou. Isso evita “edições silenciosas” e facilita auditorias futuras.

Se quiser manter a UI simples, trate revisões como comentários com resultados explícitos (Aprovar / Solicitar mudanças) e armazene a aprovação final como um registro imutável.

Para times que precisarem, vincule “Publicado” ao seu fluxo de atualizações de status (veja /blog/integrations-status-updates) sem copiar conteúdo manualmente.

Acompanhe itens de ação até a conclusão

Postmortems só reduzem incidentes futuros se o trabalho de follow-up realmente ocorrer. Trate itens de ação como objetos de primeira classe no app — não como um parágrafo no final de um documento.

Defina itens de ação como registros estruturados

Cada item de ação deve ter campos consistentes para poder ser rastreado e medido:

- Responsável (uma pessoa, mesmo se a execução for compartilhada)

- Data de vencimento (e opcional “iniciar não antes de”)

- Prioridade (ex.: P0–P3 ou Alta/Média/Baixa)

- Status (Aberto, Em andamento, Bloqueado, Concluído, Não faremos)

- Critérios de verificação (como confirmar que o conserto funcionou)

Adicione metadados úteis: tags (ex.: “monitoramento”, “docs”), componente/serviço e “criado de” (ID do incidente e ID do postmortem).

Facilite encontrar trabalho através de incidentes

Não prenda itens de ação dentro de uma única página de postmortem. Forneça:

- Busca global por responsável, serviço, tag e status

- Filtros como “atrasados”, “vence esta semana”, “bloqueado”, “alta prioridade”

- Relatórios simples: contagens por time/serviço, taxa de conclusão, tempo médio para fechar

Isso transforma follow-ups em uma fila operacional em vez de notas espalhadas.

Trabalho recorrente e links externos (opcional)

Algumas tarefas se repetem (game days trimestrais, revisões de runbook). Suporte um template recorrente que gere novos itens numa agenda, mantendo cada ocorrência rastreável individualmente.

Se times já usam outro rastreador, permita que um item de ação inclua uma referência externa e ID, enquanto seu app permanece a fonte para vinculação ao incidente e verificação.

Lembretes e regras de escalonamento

Construa lembretes leves: notifique responsáveis conforme a data de vencimento se aproxima, sinalize itens atrasados para um líder de time e destaque padrões de atraso crônico em relatórios. Mantenha regras configuráveis para que equipes adaptem às realidades de operação on-call.

Permissões, controle de acesso e auditabilidade

Execute como uma ferramenta real

Vá do protótipo para um ambiente hospedado quando estiver pronto para testar.

Incidentes e postmortems frequentemente contêm detalhes sensíveis — identificadores de clientes, IPs internos, descobertas de segurança ou problemas de fornecedores. Regras de acesso claras mantêm a ferramenta colaborativa sem transformá-la em vazamento de dados.

Defina níveis de permissão

Comece com um conjunto pequeno e compreensível de papéis:

- Somente leitura (stakeholders): podem ler resumos, linhas do tempo e postmortems finais, mas não editar. Ideal para liderança, suporte e parceiros.

- Editores (respondedores): podem criar incidentes, adicionar atualizações, gerenciar linhas do tempo e rascunhar postmortems.

- Admins (donos): gerenciam papéis, configuram templates, conectam integrações e resolvem disputas de acesso.

Se você tem múltiplos times, considere escalar papéis por serviço/time (ex.: “Editores de Pagamentos”) em vez de conceder acesso global amplo.

Decida o que é privado vs. compartilhável

Classifique conteúdo cedo, antes que hábitos se consolidem:

- Campos internos: PII de clientes, notas de investigação de segurança, logs brutos, transcrições de chat internas.

- Campos compartilháveis: impacto de alto nível, tempos de início/fim, mitigações, atualizações públicas.

Um padrão prático é marcar seções como Internas ou Compartilháveis e aplicar isso em exportações e status pages. Incidentes de segurança podem requerer um tipo separado com padrões mais restritos.

Logs de auditoria confiáveis

Para toda mudança em incidentes e postmortems, registre: quem mudou, o que mudou e quando. Inclua edições de severidade, timestamps, impacto e aprovações finais. Torne os logs de auditoria pesquisáveis e não editáveis.

Autenticação e segurança de sessão

Ofereça autenticação forte: e-mail + MFA ou magic link, e adicione SSO (SAML/OIDC) se os usuários esperam. Use sessões de curta duração, cookies seguros, proteção CSRF e revogação automática de sessão em mudanças de papel. Para considerações de rollout, veja /blog/testing-rollout-continuous-improvement.

UX: Dashboards, busca e navegação

Quando um incidente está ativo, as pessoas escaneiam — não leem. Sua UX deve tornar o estado atual óbvio em segundos, enquanto permite que respondedores aprofundem em detalhes sem se perder.

Telas principais para desenhar primeiro

Comece com três telas que cobrem a maioria dos fluxos:

- Lista de incidentes (dashboard): tabela ou cards mostrando badge de status, severidade, título, serviços impactados, responsável/comandante, último horário de atualização e duração.

- Detalhe do incidente: base para tudo sobre um incidente — resumo, status atual, links chave, participantes e painel de ações.

- Visão da linha do tempo: feed cronológico de atualizações e eventos (alertas, notas manuais, mudanças de status), com timestamps grandes e legíveis.

Uma regra simples: a página de detalhe do incidente deve responder “O que está acontecendo agora?” no topo, e “Como chegamos aqui?” abaixo.

Filtros e busca que respondedores realmente usam

Incidentes se acumulam rápido, então torne a descoberta rápida e tolerante:

- Filtros rápidos: serviço, severidade, status (open/mitigating/resolved/postmortem due), tag, intervalo de datas, e responsável.

- Busca por: título, ID do incidente, componentes afetados e tags.

Ofereça views salvas como Meus incidentes abertos ou Sev-1 esta semana para que engenheiros on-call não refaçam filtros a cada plantão.

Badges de status e consistência do “estado atual”

Use badges consistentes e com boa percepção de cor por todo o app (evite tons sutis que falhem sob estresse). Mantenha o mesmo vocabulário de status em lista, cabeçalho do detalhe e eventos da linha do tempo.

De relance, respondedores devem ver:

- Status atual + severidade

- Hora da última atualização (e quem postou)

- Próximo checkpoint (ex.: “Próxima atualização em 8 min” se você suportar cadência de updates)

Legibilidade sob pressão

Priorize escaneabilidade:

- Timestamps grandes e seções com cabeçalhos claros

- Cabeçalho do incidente fixo enquanto rola

- Seções colapsáveis para dados ruidosos (alerts brutos, logs longos)

- Navegação amigável ao teclado (/, n/p para próximo/anterior incidente)

Desenhe para o pior momento: se alguém está sem dormir e recebendo páginas pelo celular, a UI ainda deve guiar rapidamente para a ação correta.

Integrações: alertas, chat, gestão de tickets e atualizações de status

Integrações transformam um tracker de incidentes de “um lugar para escrever notas” no sistema em que sua equipe realmente roda incidentes. Comece listando sistemas que precisa conectar: observabilidade/monitoramento (PagerDuty/Opsgenie, Datadog, CloudWatch), chat (Slack/Teams), e-mail, ticketing (Jira/ServiceNow) e uma página de status.

Escolha o estilo de integração

A maioria das equipes fica com um mix:

- Webhooks de entrada para alertas e comandos de chat (rápido, quase em tempo real, baixo custo operacional).

- Polling quando uma ferramenta não consegue enviar eventos; mantenha intervalos conservadores e cacheie resultados.

- Vinculação manual como fallback (colar uma URL de alerta, anexar uma chave de ticket), o que também protege quando APIs estão fora.

Previna incidentes duplicados (idempotência)

Alertas são barulhentos, retriados e muitas vezes chegam fora de ordem. Defina uma chave de idempotência estável por evento do provedor (ex.: provedor + alert_id + occurrence_id) e armazene-a com uma restrição única. Para deduplicação, decida regras como “mesmo serviço + mesma assinatura dentro de 15 minutos” deve anexar a um incidente existente em vez de criar um novo.

Defina limites e modos de falha

Seja explícito sobre o que seu app gerencia vs. o que fica na ferramenta de origem:

- Seu app pode possuir o registro do incidente, linha do tempo, papéis e postmortem.

- O sistema de tickets pode possuir execução de trabalho e aprovações.

Quando uma integração falhar, degrade com graça: enfileire tentativas, mostre um aviso no incidente (“postagem no Slack atrasada”) e sempre permita operação manual.

Trate atualizações de status como uma saída de primeira classe: uma ação estruturada de “Atualizar” na UI deve poder publicar no chat, anexar à linha do tempo do incidente e opcionalmente sincronizar com a página de status — sem forçar o responder a escrever a mesma mensagem três vezes.

Arquitetura e escolhas de stack técnico

Itere com segurança usando snapshots

Salve uma versão estável antes de grandes mudanças e reverta se necessário.

Seu sistema de incidentes é um sistema “durante a queda”, então prefira simplicidade e confiabilidade à novidade. A melhor stack geralmente é aquela que sua equipe sabe operar às 2 da manhã com confiança.

Escolha uma stack que sua equipe possa manter

Comece com o que seus engenheiros já entregam em produção. Um framework web mainstream (Rails, Django, Laravel, Spring, Express/Nest, ASP.NET) costuma ser mais seguro do que um framework novo que só uma pessoa conhece.

Para armazenamento, um banco relacional (PostgreSQL/MySQL) se encaixa bem: incidentes, atualizações, participantes, itens de ação e postmortems se beneficiam de transações e relacionamentos claros. Adicione Redis apenas se realmente precisar de cache, filas ou locks efêmeros.

O hosting pode ser um managed platform (Render/Fly/Heroku-like) ou sua nuvem existente (AWS/GCP/Azure). Prefira bancos gerenciados e backups gerenciados quando possível.

Tempo real: websockets vs. refresh periódico

Incidentes ativos ficam melhores com atualizações em tempo real, mas não é sempre necessário no dia 1.

- Refresh periódico (polling) é mais fácil de implementar e operar. Para muitas equipes, atualizar a linha do tempo a cada 10–30 segundos é “bom o suficiente”.

- Websockets/SSE valem a pena quando há muitos espectadores simultâneos, atualizações rápidas ou colaboração em estilo chat.

Uma abordagem prática: desenhe a API/eventos para começar com polling e evoluir para websockets sem reescrever a UI.

Observabilidade do próprio sistema de incidentes

Se este app falhar durante um incidente, ele vira parte do incidente. Adicione:

- Logs estruturados (quem mudou o quê, contexto da requisição)

- Métricas (latência, taxa de erro, profundidade de filas, conexões websocket)

- Rastreio de erros (exceções não tratadas, crash reporting no frontend)

Backups, migrations e seu próprio plano de recuperação

Trate como um sistema de produção:

- Backups diários automatizados (e testes regulares de restore)

- Migrations seguras (padrões expandir/contrair, CI para migrations)

- Um plano mínimo de DR: como levantar em uma nova região/conta e como acessar dados se o ambiente primário cair

Se quiser validar fluxo e telas antes de investir na construção, uma abordagem de protótipo rápido pode funcionar: use uma ferramenta como Koder.ai para gerar um protótipo funcional a partir de uma especificação detalhada em chat, e então itere com respondedores em exercícios tabletop. Como Koder.ai pode produzir frontends React reais com backend Go + PostgreSQL (e suporta exportação do código-fonte), você pode tratar versões iniciais como protótipos descartáveis ou como ponto de partida para endurecer — sem perder o aprendizado dos exercícios reais.

Testes, rollout e melhoria contínua

Lançar um app de rastreamento de incidentes sem ensaio é um risco. As melhores equipes tratam a ferramenta como qualquer outro sistema operacional: testam caminhos críticos, fazem drills realistas, liberam gradualmente e ajustam conforme o uso real.

Teste os caminhos críticos end-to-end

Foque primeiro nos fluxos que serão usados sob alto estresse:

- Criar um incidente, definir severidade e notificar respondedores

- Postar atualizações (incluindo mudanças de status), verificar ordenação na linha do tempo e garantir que edições fiquem claras

- Resolver e fechar o incidente, então gerar um postmortem a partir do estado final

- Confirmar que links e referências (serviços, responsáveis, tickets, threads de chat) permanecem intactos

Adicione testes de regressão que garantam o que não pode quebrar: timestamps, fusos horários e ordenação de eventos. Incidentes são narrativas — se a linha do tempo estiver errada, a confiança se perde.

Verifique permissões e auditabilidade

Bugs de permissão são riscos operacionais e de segurança. Escreva testes que provem:

- Apenas papéis autorizados podem mudar severidade, editar campos chave ou fechar incidentes

- Usuários com só leitura não acessam incidentes restritos

- Cada ação sensível deixa um rastro de auditoria (quem, o quê, quando) e o log de auditoria não é editável

Teste também “quase erros”, como um usuário perdendo acesso no meio de um incidente ou uma reestruturação de time alterando membros.

Antes do rollout amplo, faça simulações tabletop usando seu app como fonte da verdade. Escolha cenários que a organização reconheça (ex.: degradação parcial, atraso de dados, falha de terceiro). Observe atritos: campos confusos, contexto faltando, muitos cliques, ownership pouco claro.

Capture feedback imediatamente e transforme em melhorias pequenas e rápidas.

Comece com um time piloto e alguns templates pré-construídos (tipos de incidente, checklists, formatos de postmortem). Forneça treinamento curto e uma página de “como rodamos incidentes” vinculada do app (ex.: /docs/incident-process).

Acompanhe métricas de adoção e iterar nos pontos de atrito: tempo para criar, % de incidentes com atualizações, taxa de conclusão de postmortems e tempo de fechamento de itens de ação. Trate essas métricas como métricas de produto — não de conformidade — e melhore continuamente a cada release.