Esclareça o objetivo e o público

Uma matriz de comparação só é útil na medida em que ajuda alguém a tomar uma decisão. Antes de projetar tabelas, filtros ou regras de pontuação, seja específico sobre quem usará o site e o que essa pessoa está tentando decidir. Isso evita um modo de falha comum: construir uma grade bonita que responde a perguntas que ninguém está fazendo.

Identifique os usuários primários (e suas restrições)

Públicos diferentes interpretam a mesma “comparação de recursos” de maneiras distintas:

- Compradores / líderes de produto querem clareza, uma shortlist rapidamente e uma justificativa defensável.

- Engenheiros querem detalhes de implementação: APIs, SDKs, esforço de integração, limites, desempenho e armadilhas.

- Compras / segurança se preocupam com risco: conformidade, certificações, residência de dados, contratos e estabilidade do fornecedor.

Escolha um público primário para a primeira versão. Você ainda pode suportar usuários secundários, mas as visualizações padrão do site, a terminologia e as prioridades devem refletir o grupo principal.

Liste as decisões que o seu site deve suportar

Escreva as decisões concretas que a matriz precisa permitir. Exemplos incluem:

- Escolher uma ferramenta para um novo projeto

- Construir uma shortlist de fornecedores para um RFP

- Substituir um sistema existente com risco mínimo de migração

- Validar se uma solução atende requisitos inegociáveis

Essas decisões informam quais critérios viram filtros de alto nível, quais viram “detalhes” e quais podem ser omitidos.

Defina métricas de sucesso que correspondam a essas decisões

Evite metas vagas como “aumentar engajamento”. Escolha métricas que reflitam progresso na decisão:

- Tempo para shortlist (por exemplo, do landing até uma comparação salva)

- Ações de conversão (pedidos de demo, cadastros, downloads)

- Taxa de conclusão para fluxos-chave (filtro → comparar → exportar)

- Sinais de qualidade (menos perguntas ao suporte, avaliações de confiança mais altas)

Decida o que “técnico” significa para seu público

“Avaliação técnica” pode incluir muitas dimensões. Alinhe o que mais importa para seus usuários, como:

- APIs e integrações (cobertura, limites de taxa, webhooks, conectores)

- Segurança e conformidade (SSO, logs de auditoria, SOC 2, criptografia)

- Preço e embalagem (planos, custos por uso, cobranças ocultas)

- Operações (modelo de deploy, monitoramento, SLAs, suporte)

Documente essas prioridades em linguagem simples. Isso vira sua estrela guia para escolhas posteriores: modelo de dados, regras de pontuação, UX e SEO.

Projete o modelo de dados para comparações

Seu modelo de dados determina se a matriz se mantém consistente, pesquisável e fácil de atualizar. Antes de desenhar telas, decida o que são as “coisas” que você está comparando, o que está medindo e como armazenará as provas.

A maioria dos sites de comparação técnica precisa de um pequeno conjunto de blocos de construção:

- Fornecedores/Produtos: os itens comparados (frequentemente ambos: um fornecedor pode oferecer múltiplos produtos).

- Categorias: agrupamentos como “Segurança”, “Integrações” ou “Preço”.

- Critérios: linhas individuais na matriz (ex.: “SAML SSO”, “Formatos de exportação”, “SLA de disponibilidade”).

- Evidência: o que sustenta um valor (trecho de docs, referência de screenshot, nota de contrato, resultado de teste).

- Fontes: de onde veio a evidência (doc público, e-mail de vendas, entrevista com cliente, teste interno).

Modele critérios como objetos reutilizáveis e armazene o valor de cada fornecedor/produto como um registro separado (frequentemente chamado de “avaliação” ou “resultado de critério”). Isso permite adicionar novos fornecedores sem duplicar a lista de critérios.

Escolha o tipo de dado certo por critério

Evite forçar tudo em texto simples. Escolha um tipo que corresponda a como as pessoas filtrarão e compararão:

- Booleano (Sim/Não) para disponibilidade

- Numérico para limites e desempenho (e armazene unidades)

- Texto para nuances (mantenha curto; adicione notas longas em outro lugar)

- Multi-select para listas como plataformas suportadas ou padrões de conformidade

Decida também como representar “Desconhecido”, “Não aplicável” e “Planejado”, para que vazios não sejam lidos como “Não”.

Planeje para mudanças: versões e timestamps

Os critérios evoluem. Armazene:

- Datas de vigência (quando um valor foi verificado)

- Timestamp do último review por resultado de critério

- Versões de critério opcionais para que renomear ou dividir critérios não quebre o histórico

Separe fatos públicos de notas internas

Crie campos (ou até uma tabela separada) para comentários internos, detalhes de negociação e confiança do revisor. Páginas públicas devem mostrar o valor e a evidência; views internas podem incluir contexto franco e tarefas de acompanhamento.

Planeje a estrutura do site e URLs

Um site de matriz de comparação manda bem quando visitantes conseguem prever onde as coisas ficam e como chegar lá. Decida uma arquitetura de informação que reflita como as pessoas avaliam opções.

Crie uma árvore de categorias consistente

Comece com uma taxonomia simples e estável que não mude todo trimestre. Pense em “áreas de problema” em vez de nomes de fornecedores.

Exemplos:

- Monitoramento

- CI/CD

- IAM

- Data Warehousing

- API Gateways

Mantenha a árvore rasa (geralmente 2 níveis é suficiente). Se precisar de mais nuance, use tags ou filtros (ex.: “Open-source”, “SOC 2”, “Self-hosted”) em vez de aninhamento profundo. Isso ajuda usuários a navegar com confiança e evita conteúdo duplicado no futuro.

Planeje seus tipos de página principais

Projete o site em torno de alguns templates repetíveis:

- Hub de categoria: explica a categoria, lista produtos, destaca critérios comuns e oferece pontos de entrada para “comparar”.

- Página de produto: perfil único do fornecedor/ferramenta com capacidades, limitações, notas de preço, integrações e guia “melhor para”.

- Página de comparação: visão lado a lado para dois ou mais produtos, com linhas de critérios, pontuação (se usada) e notas.

Adicione páginas de suporte que reduzam confusão e construam credibilidade:

- Metodologia (como você pontua, o que testa, frequência de atualização)

- Glossário (defina critérios e siglas)

- Contato (correções, parcerias, fontes de dados)

Escolha padrões de URL que escalem

Escolha regras de URL cedo para não criar redirects bagunçados depois. Dois padrões comuns:

- Comparações:

/compare/a-vs-b (ou /compare/a-vs-b-vs-c para multi-way)

- Categorias:

/category/ci-cd

Mantenha URLs curtas, em minúsculas e consistentes. Use o nome canônico do produto (ou um slug estável) para que a mesma ferramenta não apareça como /product/okta e /product/okta-iam.

Por fim, decida como filtros e ordenações afetam URLs. Se quiser views filtradas compartilháveis, planeje uma abordagem limpa de query string (ex.: ?deployment=saas&compliance=soc2) e mantenha a página base utilizável sem parâmetros.

Defina critérios, regras de pontuação e ponderação

Uma matriz de comparação só ajuda se as regras forem consistentes. Antes de adicionar mais fornecedores ou critérios, trave a “matemática” e o significado por trás de cada campo. Isso evita debates infindáveis depois (“O que queríamos dizer com suporte a SSO?”) e torna os resultados defensáveis.

Padronize nomes e definições de critérios

Comece com uma lista canônica de critérios e trate-a como uma especificação de produto. Cada critério deve ter:

- Um nome claro (curto, escaneável e único)

- Uma definição que remova ambiguidade

- O escopo (o que está incluído/excluído)

- A evidência que você espera para sustentar uma pontuação (docs, screenshots, resultados de teste)

Evite near-duplicates como “Conformidade” vs “Certificações” a menos que a distinção seja explícita. Se precisar de variantes (ex.: “Criptografia em repouso” e “Criptografia em trânsito”), torne-as critérios separados com definições separadas.

Adicione diretrizes de pontuação que as pessoas possam seguir

Pontuações só são comparáveis se todos usarem a mesma escala. Escreva rubricas de pontuação que caibam no critério:

- Escala 1–5 quando suporte parcial importa (comum para usabilidade, maturidade, integrações)

- Aprovado/Reprovado quando for binário (suporta SAML? sim/não)

- Valores numéricos quando a medição for direta (preço, latência, retenção máxima)

Defina o que cada ponto significa. Por exemplo, “3” pode ser “atende o requisito com limitações”, enquanto “5” é “atende com opções avançadas e deploys comprovados”. Especifique também quando “N/A” é permitido.

Decida ponderações (ou decida não usá-las)

Ponderar muda a história que a matriz conta, então escolha intencionalmente:

- Pesos padrão: bom para um ranking “editorial”; documente a razão.

- Pesos customizáveis pelo usuário: melhor para audiências diversas; permita que usuários ajustem e vejam os totais atualizarem.

- Sem pesos: o mais seguro quando você quer neutralidade; foque nas diferenças lado a lado.

Se suportar pesos customizáveis, defina guardrails (ex.: pesos devem somar 100, ou use presets baixo/médio/alto).

Dados faltantes são inevitáveis. Documente sua regra e aplique-a de forma consistente:

- Use “Desconhecido” quando não conseguiu confirmar (mantenha distinto de “Não”).

- Decida se desconhecidos pontuam como 0, neutro ou são excluídos dos totais.

- Registre por quê está desconhecido (fornecedor não respondeu, recurso pouco claro, não testado).

Essas políticas mantêm sua matriz justa, repetível e confiável à medida que cresce.

Crie um padrão de UX que torne diferenças óbvias

A UI de comparação tem sucesso ou fracassa em uma coisa: se o leitor consegue ver rapidamente o que é significativamente diferente. Decida uma visão de comparação principal e um conjunto de sinais visuais que façam os contrastes saltarem aos olhos.

Escolha sua visualização primária (e mantenha-a)

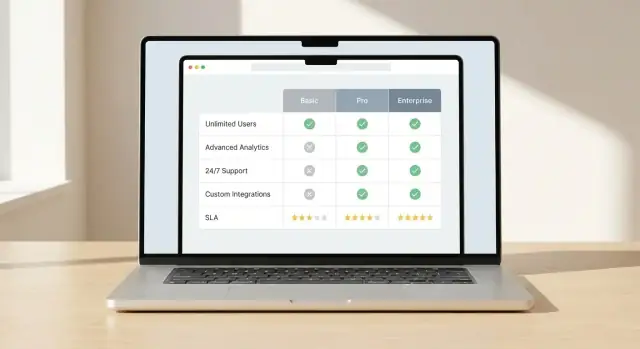

Escolha um padrão principal e projete tudo ao redor dele:

- Matriz em tabela para comparações profundas linha a linha entre muitas opções.

- Cartões para resumir poucas opções com prós/contras e especificações-chave.

- Híbrido quando precisar dos dois: cartões para o “top line” e uma matriz abaixo para detalhes.

Consistência importa. Se usuários aprendem como diferenças são mostradas em uma área, as mesmas regras devem aplicar em todo lugar.

Torne diferenças visualmente óbvias

Evite forçar as pessoas a escanear cada célula. Use destaques deliberados:

- Enfatize deltas, não semelhanças (por exemplo, deixe em negrito os valores que diferem).

- Adicione indicadores “só no A” ou “falta no B” para recursos presentes em uma opção e ausentes em outra.

- Use sombreamento sutil de fundo para critérios “mais importantes” para guiar o olhar.

Mantenha o significado das cores simples e acessível: uma cor para “melhor”, outra para “pior” e um estado neutro. Não dependa apenas da cor—inclua ícones ou rótulos curtos.

Suporte tabelas longas sem perder contexto

Matrizes longas são normais em avaliações técnicas. Torne-as usáveis:

- Cabeçalhos fixos para que nomes de coluna permaneçam visíveis.

- Primeira coluna fixa para que os rótulos de critério não desapareçam.

- Fixar colunas para que leitores possam travar um fornecedor enquanto rolam os outros.

Projete para mobile desde o início

Usuários móveis não toleram grades minúsculas. Ofereça:

- Rolagem horizontal com affordances claras (bordas esmaecidas, “arraste para comparar”).

- Agrupamento de linhas (Desempenho, Segurança, Preço) com seções colapsáveis.

- “Snapshots de comparação” que mostram primeiro 5–8 critérios chave, com “ver matriz completa” para profundidade.

Quando diferenças são fáceis de identificar, leitores confiam na matriz — e a usam mais.

Construa filtragem, ordenação e comparação lado a lado

Uma matriz de comparação só parece “rápida” quando as pessoas conseguem reduzir a lista e ver diferenças significativas sem rolar por minutos. Filtragem, ordenação e views lado a lado são as ferramentas de interação centrais que tornam isso possível.

Filtros que correspondem a como as pessoas decidem

Comece com um conjunto pequeno de filtros que reflitam perguntas reais de avaliação, não apenas o que é fácil de armazenar. Filtros úteis incluem:

- Categoria (ex.: monitoramento, CI/CD, data warehouse)

- Plataforma (web, mobile, desktop, API-only)

- Faixa de preço (gratuito, starter, enterprise)

- Modelo de deploy (SaaS, self-hosted, híbrido)

Projete filtros para que usuários possam combiná-los. Mostre quantos itens correspondem à medida que filtram e deixe claro como limpar filtros. Se alguns filtros forem mutuamente exclusivos, previna combinações inválidas em vez de mostrar “0 resultados” sem explicação.

Ordenação que responde “o que devo ver primeiro?”

Ordenação deve refletir prioridades objetivas e específicas do público. Ofereça algumas opções claras como:

- Melhor pontuação (baseada nas suas regras de pontuação)

- Mais recursos (contagem de critérios suportados)

- Atualização mais recente (última revisão verificada ou update do produto)

Se mostrar uma “melhor pontuação”, exiba o que essa pontuação representa (total geral vs pontuação por categoria) e permita que usuários troquem a visão de pontuação. Evite defaults ocultos.

Comparação lado a lado (2–5 itens)

Permita que usuários selecionem um pequeno conjunto (normalmente 2–5) e comparem em layout de colunas fixas. Mantenha os critérios mais importantes fixados no topo e agrupe o resto em seções colapsáveis para reduzir sobrecarga.

Torne a comparação compartilhável com um link que preserve seleções, filtros e ordenação. Isso permite que equipes revisem a mesma shortlist sem recriá-la.

Opções de exportação quando fizer sentido

Exportações podem ser valiosas para revisão interna, procurement e discussão offline. Se seu público precisar, ofereça CSV (para análise) e PDF (para compartilhamento). Mantenha exportações focadas: inclua itens selecionados, critérios escolhidos, timestamps e quaisquer notas sobre pontuação para que o arquivo não seja enganoso quando visto depois.