Antes de construir uma pontuação de saúde de adoção do cliente, decida o que você quer que a pontuação faça pelo negócio. Uma pontuação destinada a disparar alertas de risco de churn terá formato diferente da usada para guiar onboarding, educação do cliente ou melhorias de produto.

Defina o que “adoção” significa para seu produto

Adoção não é apenas “acessou recentemente”. Registre os poucos comportamentos que realmente indicam que os clientes estão alcançando valor:

- Ativação: o primeiro momento em que um usuário alcança um resultado significativo (ex.: “convidou um colega”, “conectou uma fonte de dados”, “publicou um relatório”).

- Ações principais: comportamentos repetíveis e de alto sinal que se correlacionam com contas bem-sucedidas (ex.: exportações semanais, execuções de automações, dashboards vistos por múltiplos usuários).

- Retenção: uso contínuo na cadência certa para seu produto (diário, semanal, mensal), idealmente por mais de um usuário na conta.

Esses viram seus sinais iniciais de adoção para análise de uso de recursos e, depois, análise por coorte.

Liste as decisões que seu app deve possibilitar

Seja explícito sobre o que acontece quando a pontuação muda:

- Quem é notificado quando uma conta cai abaixo de um limiar?

- Quais playbooks devem ser lançados (contato, treinamento, checagem de suporte)?

- Quais insights devem informar o monitoramento de adoção (pontos de fricção, recursos pouco usados, tempo para valor)?

Se você não consegue nomear uma decisão, não rastreie a métrica ainda.

Identifique usuários, papéis e janelas de tempo

Esclareça quem usará o dashboard de customer success:

- Gerentes de CS precisam de priorização e contexto de conta.

- Produto precisa de padrões, coortes e movimento por recurso.

- Suporte precisa de atividade recente relacionada a tickets e incidentes.

- Liderança precisa de um roll-up compreensível e tendência.

Escolha janelas padrão—últimos 7/30/90 dias—e considere estágios de ciclo de vida (trial, onboarding, steady-state, renovação). Isso evita comparar uma conta recém-criada com uma madura.

Defina critérios de sucesso

Defina “pronto” para seu modelo de pontuação:

- Precisão: ele prevê risco e sinais de expansão melhor que a abordagem atual?

- Explicabilidade: um rep de CS consegue explicar por que a pontuação está alta/baixa em um minuto?

- Facilidade de uso: economiza tempo e gera ações consistentes?

Esses objetivos moldam tudo a jusante: rastreamento de eventos, lógica de pontuação e os fluxos que você constrói ao redor da pontuação.

Selecione métricas para sua pontuação de saúde

Escolher métricas é onde sua pontuação vira um sinal útil ou um número barulhento. Mire em um conjunto pequeno de indicadores que reflitam adoção real—não apenas atividade.

Escolha métricas que mostrem se os usuários estão repetidamente obtendo valor:

- Logins / usuários ativos: ex.: weekly active users (WAU) e a tendência nas últimas 4–8 semanas.

- Dias ativos: quantos dias distintos a conta teve atividade em uma semana/mês (ajuda a evitar falsos positivos de “uma grande sessão”).

- Profundidade de recurso: uso dos seus “recursos de valor” (ações que se correlacionam com sucesso), não todo clique.

- Integrações conectadas: especialmente se integrações aumentam custos de troca ou desbloqueiam fluxos chave.

- Utilização de assentos: porcentagem de assentos comprados que foram convidados, ativados e efetivamente ativos.

Mantenha a lista focada. Se você não consegue explicar por que uma métrica importa em uma frase, provavelmente não é uma entrada principal.

Adicione contexto de negócio (para que as pontuações não sejam injustas)

A adoção deve ser interpretada em contexto. Uma equipe de 3 assentos se comportará diferente de um rollout de 500 assentos.

Sinais de contexto comuns:

- Nível de plano e entitlements

- Tamanho do contrato / faixa de ARR

- Estágio do ciclo de vida: trial vs recém-pago vs janela de renovação

Esses não precisam “somar pontos”, mas ajudam a definir expectativas e limiares realistas por segmento.

Decida indicadores leading vs. lagging

Uma pontuação útil mistura:

- Indicadores leading (predizem sucesso futuro): aumento de dias ativos, conclusão de onboarding, primeira integração conectada.

- Indicadores lagging (confirmam resultados): renovação, expansão, retenção de longo prazo.

Evite sobre-ponderar métricas lagging; elas contam o que já aconteceu.

Se você os tem, NPS/CSAT, volume de tickets de suporte e notas do CSM podem adicionar nuance. Use como modificadores ou flags—não como fundação—porque dados qualitativos podem ser esparsos e subjetivos.

Crie um dicionário de dados simples

Antes de construir gráficos, alinhe nomes e definições. Um dicionário leve deve incluir:

- Nome da métrica (ex.:

active_days_28d)

- Definição clara (o que conta, o que não conta)

- Janela de tempo e cadência de atualização

- Sistema de origem (eventos do produto, CRM, suporte)

Isso evita confusão de “mesma métrica, significado diferente” quando você implementar dashboards e alertas.

Desenhe um modelo de pontuação explicável

Uma pontuação de adoção só funciona se seu time confiar nela. Mire em um modelo que você consiga explicar em um minuto para um CSM e em cinco minutos para um cliente.

Comece simples: pontos ponderados (antes do ML)

Comece com uma pontuação baseada em regras, transparente. Escolha um pequeno conjunto de sinais de adoção (ex.: usuários ativos, uso de recurso-chave, integrações habilitadas) e atribua pesos que reflitam os momentos de “aha” do seu produto.

Exemplo de ponderação:

- Weekly active users por assento: 0–40 pontos

- Frequência de uso de recurso-chave: 0–35 pontos

- Largura de recursos usados: 0–15 pontos

- Tempo desde a última atividade significativa: 0–10 pontos

Mantenha pesos fáceis de defender. Você pode revisá-los depois—não espere pelo modelo perfeito.

Normalize para reduzir viés

Contagens brutas penalizam contas pequenas e suavizam as grandes. Normalize métricas quando necessário:

- Por assento (uso / assentos licenciados)

- Pela idade da conta (contas novas vs maduras)

- Pelo nível de plano (disponibilidade de recursos)

Isso ajuda sua pontuação de adoção a refletir comportamento, não apenas tamanho.

Defina limiares (ex.: Verde ≥ 75, Amarelo 50–74, Vermelho < 50) e documente por que cada corte existe. Relacione limiares a resultados esperados (risco de renovação, conclusão de onboarding, prontidão para expansão) e mantenha as notas em seus docs internos ou em /blog/health-score-playbook.

Torne-a explicável: contribuintes e tendência

Cada pontuação deve mostrar:

- Os 3 principais contribuintes (o que ajudou/prejudicou)

- A mudança ao longo do tempo (últimos 7/30 dias)

- Um resumo em linguagem simples (“Uso do Recurso X caiu 35% semana a semana”)

Planeje iteração: versionamento do modelo

Trate a pontuação como um produto. Versione-a (v1, v2) e meça o impacto: os alertas de churn ficaram mais precisos? Os CSMs agiram mais rápido? Armazene a versão do modelo com cada cálculo para comparar resultados ao longo do tempo.

Instrumente eventos de produto e fontes de dados

Uma pontuação de saúde só é confiável quanto os dados de atividade que a sustentam. Antes de construir a lógica de pontuação, confirme que os sinais certos são capturados de forma consistente entre sistemas.

Escolha suas fontes de evento

A maioria dos programas de adoção puxa de uma mistura de:

- Eventos de frontend (page views, cliques, interações de recurso)

- Ações de backend (chamadas de API, jobs concluídos, registros criados)

- Faturamento (plano, renovações, status de pagamento, contagem de assentos)

- Ferramentas de suporte e sucesso (tickets, CSAT, marcos de onboarding)

Uma regra prática: rastreie ações críticas no lado do servidor (mais difícil de falsificar, menos afetado por ad blockers) e use eventos de frontend para engajamento de UI e descoberta.

Defina um esquema de evento claro

Mantenha um contrato consistente para que eventos sejam fáceis de juntar, consultar e explicar aos stakeholders. Uma base comum:

event_nameuser_idaccount_idtimestamp (UTC)properties (feature, plan, device, workspace_id, etc.)

Use um vocabulário controlado para event_name (por exemplo, project_created, report_exported) e documente em um plano de tracking simples.

Decida entre SDK vs server-side (ou ambos)

- Tracking via SDK é rápido para lançar e ótimo para eventos de UI.

- Tracking server-side é melhor para ações que são sistema de registro.

Muitas equipes fazem ambos, mas garanta que você não conte duas vezes a mesma ação do mundo real.

Pontuações normalmente agregam no nível de conta, então você precisa de mapeamento confiável user→account. Planeje para:

- Usuários pertencendo a múltiplas contas

- Merges de contas (aquisições, consolidação de workspaces)

- IDs anonimizados para comportamento pré-login (com merge seguro após signup)

Insira checagens de qualidade de dados

No mínimo, monitore eventos ausentes, picos duplicados e consistência de fuso horário (armazene em UTC; converta para exibição). Marque anomalias cedo para que seus alertas de risco de churn não disparem porque o tracking quebrou.

Modele seus dados e armazenamento

Um app de pontuação de adoção do cliente vive ou morre pela modelagem de “quem fez o quê e quando”. O objetivo é tornar perguntas comuns rápidas de responder: Como está essa conta esta semana? Quais recursos estão subindo ou caindo? Boa modelagem mantém scoring, dashboards e alertas simples.

Entidades principais a modelar

Comece com um pequeno conjunto de tabelas “fonte da verdade”:

- Accounts: account_id, plan, segment, lifecycle stage, CSM owner

- Users: user_id, account_id, role/persona, created_at, status

- Subscriptions (ou contratos): account_id, start/end, seats, MRR, renewal date

- Features: feature_id, name, category (activation, collaboration, admin, etc.)

- Events: event_id, account_id, user_id, feature_id (nullable), event_name, timestamp, properties

- Scores: account_id, score_date (or computed_at), overall_score, component scores, explanation fields

Mantenha essas entidades consistentes usando IDs estáveis (account_id, user_id) em todos os lugares.

Separe o armazenamento: relacional + analytics

Use um banco relacional (ex.: Postgres) para accounts/users/subscriptions/scores—coisas que você atualiza e junta frequentemente.

Armazene eventos de alto volume no data warehouse/analytics (ex.: BigQuery/Snowflake/ClickHouse). Isso mantém dashboards e análises por coorte responsivos sem sobrecarregar seu BD transacional.

Armazene agregados para velocidade

Em vez de recalcular tudo a partir de eventos brutos, mantenha:

- Resumos diários por conta (uma linha por conta por dia): usuários ativos, contagens de eventos-chave, última atividade, marcos de adoção

- Contadores por recurso: por conta/dia/recurso, contagens de uso, usuários únicos, tempo gasto (se disponível)

Essas tabelas alimentam gráficos de tendência, insights de “o que mudou” e componentes da pontuação.

Retenção, particionamento e desempenho de consulta

Para grandes tabelas de eventos, planeje retenção (ex.: 13 meses brutos, mais para agregados) e particione por data. Cluster/index por account_id e timestamp/date para acelerar consultas “conta ao longo do tempo”.

Em tabelas relacionais, indexe filtros e joins comuns: account_id, (account_id, date) em resumos, e chaves estrangeiras para manter dados limpos.

Planeje a arquitetura do web app

Construa o pipeline de pontuação

Prototipe contas, eventos, agregados e tarefas de pontuação rapidamente para que sua equipe possa iterar desde cedo.

Sua arquitetura deve facilitar o lançamento de um v1 confiável e depois crescer sem reescrever do zero. Comece decidindo quantas partes móveis você realmente precisa.

Monolito vs serviços (mantenha o v1 simples)

Para a maioria das equipes, um monolito modular é o caminho mais rápido: uma codebase com limites claros (ingestão, scoring, API, UI), um único deploy e menos surpresas operacionais.

Migrar para serviços só quando houver motivo claro—necessidade de escalonamento independente, isolamento de dados estrito ou equipes separadas. Caso contrário, serviços prematuros aumentam pontos de falha e desaceleram a iteração.

Defina os componentes centrais

No mínimo, planeje essas responsabilidades (mesmo que morem num único app inicialmente):

- Ingestão: recebe eventos do produto (SDK, Segment, webhook, imports em lote).

- Agregação: transforma eventos brutos em fatos de uso diários/semanais por conta/usuário.

- Scoring: calcula a pontuação de adoção e explicações de suporte.

- API: serve pontuações, tendências e “porquês” para a UI e integrações.

- UI: dashboard de customer success com visão de conta, coortes e drill-down.

Se quiser prototipar rápido, uma abordagem de vibe-coding pode ajudar a chegar num dashboard funcional sem investir demais em infraestrutura. Por exemplo, Koder.ai pode gerar uma UI React e um backend Go + PostgreSQL a partir de uma descrição por chat das suas entidades (accounts, events, scores), endpoints e telas—útil para montar um v1 que o time de CS possa testar cedo.

Jobs agendados vs streaming

Scoring em batch (ex.: horário/noturno) costuma ser suficiente para monitoramento de adoção e é muito mais simples de operar. Streaming faz sentido se você precisar de alertas quase em tempo real (ex.: queda súbita de uso) ou volumes muito altos de eventos.

Um híbrido prático: ingerir eventos continuamente, agregar/pontuar em agenda, e reservar streaming para um pequeno conjunto de sinais urgentes.

Ambientes, segredos e necessidades não funcionais

Configure dev/stage/prod cedo, com contas de amostra em stage para validar dashboards. Use um cofre de segredos gerenciado e faça rotação de credenciais.

Documente requisitos: volume esperado de eventos, frescor da pontuação (SLA), metas de latência da API, disponibilidade, retenção de dados e restrições de privacidade (PII). Isso evita decisões arquiteturais sob pressão mais tarde.

Construa o pipeline de dados e jobs de scoring

Sua pontuação de saúde é tão confiável quanto o pipeline que a produz. Trate o scoring como um sistema de produção: reprodutível, observável e fácil de explicar quando alguém perguntar “Por que essa conta caiu hoje?”.

Um pipeline simples: raw → validated → aggregates

Comece com um fluxo em etapas que refina os dados para algo que você pode pontuar com segurança:

- Raw events: ingestão append-only do app, mobile, integrações e exports de billing/CRM.

- Validated events: eventos que passam em checagens de esquema (campos exigidos, tipos corretos), checagens de identidade (mapeamento user → account) e deduplicação.

- Daily aggregates: rollups por conta (e opcionalmente workspace/team) como usuários ativos, contagens de eventos-chave, marcos de time-to-value e deltas de tendência.

Essa estrutura mantém seus jobs de scoring rápidos e estáveis, porque operam sobre tabelas limpas e compactas em vez de bilhões de linhas brutas.

Agendas de recálculo e backfills

Decida quão “fresca” a pontuação precisa ser:

- Horária funciona para movimentos de alta atenção onde CSMs agem rápido.

- Diária é suficiente para SMB/self-serve e mantém custos baixos.

Projete o scheduler para suportar backfills (ex.: reprocessar últimos 30/90 dias) quando você consertar tracking, mudar pesos ou adicionar um novo sinal. Backfills devem ser uma feature de primeira classe, não um script de emergência.

Idempotência: evite dupla contagem

Jobs de scoring serão reexecutados. Imports serão rerun. Webhooks serão entregues duas vezes. Projete para isso.

Use uma chave de idempotência para eventos (event_id ou hash estável de timestamp + user_id + event_name + properties) e imponha unicidade na camada validated. Para agregados, faça upsert por (account_id, date) para que recomputação substitua resultados anteriores em vez de somar.

Monitoramento e checagens de anomalia

Adicione monitoramento operacional para:

- Sucesso/falha de jobs e contagem de retries

- Lag de dados (o quão atrasado está o último agregado)

- Anomalias de volume (quedas/picos súbitos em eventos, usuários ativos, ações-chave)

Mesmo limites leves (ex.: “events caíram 40% vs média de 7 dias”) evitam que falhas silenciosas enganem o dashboard de customer success.

Trilhas de auditoria para cada pontuação

Armazene um registro de auditoria por conta por execução de scoring: métricas de entrada, features derivadas (como mudança semana a semana), versão do modelo e pontuação final. Quando um CSM clicar “Por quê?”, você mostra exatamente o que mudou e quando—sem precisar reverter logs.

Crie uma API segura para saúde e insights

Deixe pronto para a equipe

Coloque seu painel de CS em um domínio personalizado para facilitar o acesso interno.

Seu web app vive ou morre pela API. É o contrato entre seus jobs de scoring, UI e ferramentas downstream (plataformas de CS, BI, exports). Mire em uma API rápida, previsível e segura por padrão.

Endpoints centrais para suportar workflows reais

Desenhe endpoints ao redor de como Customer Success explora adoção:

- Account health:

GET /api/accounts/{id}/health retorna a pontuação mais recente, banda de status (ex.: Verde/Amarelo/Vermelho) e timestamp do último cálculo.

- Trends:

GET /api/accounts/{id}/health/trends?from=&to= para pontuação ao longo do tempo e deltas de métricas chave.

- Drivers (“por que”):

GET /api/accounts/{id}/health/drivers para mostrar fatores positivos/negativos principais (ex.: “weekly active seats down 35%”).

- Cohorts:

GET /api/cohorts/health?definition= para análise de coorte e benchmarks de pares.

- Exports:

POST /api/exports/health para gerar CSV/Parquet com esquemas consistentes.

Filtros, paginação e caching

Torne endpoints de listagem fáceis de fatiar:

- Filtros essenciais:

plan, segment, csm_owner, lifecycle_stage e date_range.

- Paginação: use paginação por cursor (

cursor, limit) para estabilidade conforme os dados mudam.

- Cache: cacheie consultas pesadas (rollups de coorte, séries de tendência) e retorne

ETag/If-None-Match para reduzir cargas repetidas. Faça chaves de cache sensíveis a filtros e permissões.

Proteja dados no nível da conta. Implemente RBAC (ex.: Admin, CSM, Somente leitura) e aplique no servidor em cada endpoint. Um CSM só deve ver contas que ele gerencia; papéis financeiros podem ver agregados por plano, mas não detalhes de usuários.

Sempre retorne explicabilidade

Junto à pontuação de adoção do cliente numérica, retorne campos de “por quê”: principais drivers, métricas afetadas e baseline de comparação (período anterior, mediana da coorte). Isso transforma monitoramento de adoção de produto em ação, não apenas relatório, e torna seu dashboard de customer success confiável.

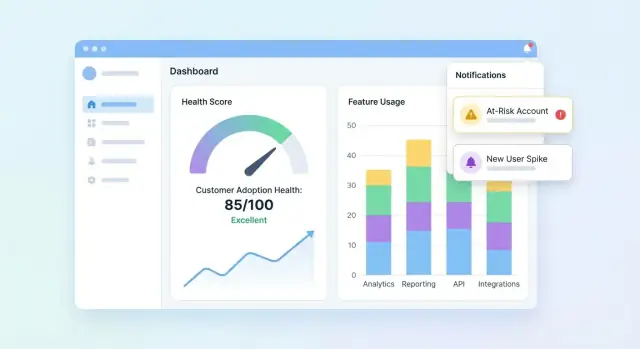

Desenhe dashboards e visualizações por conta

Sua UI deve responder três perguntas rapidamente: Quem está saudável? Quem está escorregando? Por quê? Comece com um dashboard que resume a carteira, depois permita drill-down numa conta para entender a história por trás da pontuação.

Essenciais do dashboard de portfólio

Inclua um conjunto compacto de tiles e gráficos que times de CS varrem em segundos:

- Distribuição de pontuação (histograma ou buckets como Saudável / Monitorar / Em risco)

- Lista de contas em risco com poucos campos necessários para agir (conta, responsável, pontuação, última atividade, driver principal)

- Tendência de pontuação ao longo do tempo (gráfico de linha) com opção de filtro por segmento

Faça a lista de riscos clicável para abrir a conta e ver o que mudou.

Visão da conta: explique a pontuação

A página da conta deve ler como uma linha do tempo de adoção:

- Linha do tempo de eventos chave (passos de onboarding concluídos, integrações conectadas, mudanças de admin, primeiro uso de recurso importante)

- Métricas principais (usuários ativos, ações de recurso-chave, tempo desde a última atividade significativa)

- Quebra de adoção por recurso mostrando quais recursos foram adotados, ignorados ou estão regredindo

Adicione um painel “Por que essa pontuação?”: clicar na pontuação revela sinais contribuintes (positivos e negativos) com explicações em linguagem simples.

Visões de coorte e segmento

Forneça filtros de coorte que batam com como times gerenciam contas: coortes de onboarding, níveis de plano e indústrias. Pareie cada coorte com linhas de tendência e uma pequena tabela dos maiores movers para comparar resultados e identificar padrões.

Visuais acessíveis e confiáveis

Use rótulos e unidades claras, evite ícones ambíguos e ofereça indicadores de status acessíveis (ex.: rótulos de texto + formas). Trate gráficos como ferramentas de decisão: anote picos, mostre intervalos de data e mantenha comportamento de drill-down consistente.

Adicione alertas, tarefas e workflows

Uma pontuação só é útil se gerar ação. Alertas e workflows transformam “dados interessantes” em outreach oportuno, correções de onboarding ou nudges de produto—sem obrigar o time a vigiar dashboards o dia todo.

Defina regras de alerta que mapem para risco real

Comece com um pequeno conjunto de gatilhos de alto sinal:

- Queda de pontuação (ex.: queda de 15 pontos semana a semana)

- Status Vermelho (cruzou um limiar crítico)

- Queda súbita de uso (uso de recurso-chave abaixo de baseline)

- Falha em etapa de onboarding (item da checklist travado, integração não completada)

Faça cada regra explícita e explicável. Em vez de “Saúde ruim”, alerte em “Nenhuma atividade no Recurso X por 7 dias + onboarding incompleto”.

Escolha canais e mantenha configuráveis

Times trabalham de formas diferentes, então construa suporte a canais e preferências:

- Email para responsáveis e gerentes

- Slack para visibilidade do time e resposta rápida

- Tarefas in-app dentro do dashboard de customer success para que o trabalho não se perca

Deixe cada time configurar: quem recebe, quais regras estão ativas e o que significa “urgente”.

Fadiga de alerta mata monitoramento. Adicione controles como:

- Janelas de cooldown (não re-alertar a mesma conta por N horas/dias)

- Limiar mínimo de dados (pule alertas se a conta tiver dados recentes insuficientes)

- Batching/digests para sinais não urgentes (resumos diários/semanais)

Acrescente contexto e próximos passos

Cada alerta deve responder: o que mudou, por que importa e o que fazer em seguida. Inclua drivers recentes da pontuação, uma linha do tempo curta (ex.: últimos 14 dias) e tarefas sugeridas como “Agendar call de onboarding” ou “Enviar guia de integração”. Vincule ao view da conta (ex.: /accounts/{id}).

Acompanhe resultados para fechar o ciclo

Trate alertas como itens de trabalho com status: acknowledged, contacted, recovered, churned. Relatórios de outcomes ajudam a refinar regras, melhorar playbooks e provar que a pontuação está gerando retenção mensurável.

Garanta qualidade de dados, privacidade e governança

Planeje seu modelo com clareza

Mapeie eventos, métricas e limites antes de codificar, depois construa a partir do plano em um único fluxo.

Se sua pontuação for construída em dados não confiáveis, times deixam de confiar nela—e de agir. Trate qualidade, privacidade e governança como features de produto, não como um afterthought.

Coloque checagens automatizadas de dados

Comece com validação leve em cada handoff (ingest → warehouse → saída de scoring). Alguns testes de alto sinal pegam a maioria dos problemas cedo:

- Checagens de esquema: colunas esperadas existem, tipos não mudaram, enums válidos.

- Checagens de faixa: valores impossíveis (sessões negativas, timestamps futuros) falham rápido.

- Checagens de nulos: campos obrigatórios (account_id, event_name, occurred_at) não podem ficar vazios.

Quando testes falham, bloqueie o job de scoring (ou marque resultados como “stale”) para que um pipeline quebrado não gere alertas falsos.

Trate casos de borda comuns explicitamente

Scoring falha em cenários “estranhos mas normais”. Defina regras para:

- Contas novas com poucos dados: mostrar “dados insuficientes” ou usar baseline de rampa em vez de pontuação baixa.

- Uso sazonal: compare com o período anterior da conta ou benchmarks de coorte em vez de um limiar universal.

- Quedas/lag de tracking: marque janelas afetadas e evite penalizar clientes por downtime seu.

Adicione permissões e controles de privacidade

Limite PII por padrão: armazene apenas o necessário para monitoramento de adoção. Aplique RBAC na web app, registre quem visualizou/exportou dados e redija exports quando campos não forem necessários (ex.: ocultar emails em downloads CSV).

Crie runbooks e hábitos de governança

Escreva runbooks curtos para resposta a incidentes: como pausar scoring, backfill de dados e reexecução de jobs históricos. Revise métricas de customer success e pesos de pontuação regularmente—mensal ou trimestralmente—para evitar drift conforme o produto evolui. Para alinhamento de processo, vincule seu checklist interno em /blog/health-score-governance.

Valide, itere e escale a pontuação de saúde

Validação é onde uma pontuação deixa de ser “um gráfico bonito” e vira confiável o suficiente para dirigir ação. Trate sua primeira versão como hipótese, não resposta final.

Comece com um grupo piloto de contas (ex.: 20–50 em diferentes segmentos). Para cada conta, compare a pontuação e as razões de risco com a avaliação do CSM.

Procure padrões:

- Pontuações consistentemente acima/abaixo do julgamento do CSM (calibração)

- “Falsos positivos” (alto risco mas conta está bem) vs “misses” (pontuação saudável mas conta churna)

- Razões que não batem com a realidade (gaps de explicabilidade)

Meça se é realmente útil

Precisão é boa, mas utilidade é o que traz retorno. Meça outcomes operacionais como:

- Time-to-detect risk (com que antecedência você sinaliza um problema)

- Taxa de sucesso de outreach (percentual de contas em risco que melhoram após intervenção)

- Proxies de redução de churn (movimentos de probabilidade de renovação, sinais de expansão, mudança na carga de suporte)

Quando ajustar limiares, pesos ou adicionar sinais, trate como nova versão do modelo. A/B teste versões em coortes comparáveis e mantenha versões históricas para explicar por que pontuações mudaram ao longo do tempo.

Colete feedback dentro da UI

Adicione um controle leve como “Pontuação parece errada” mais um motivo (ex.: “conclusão recente do onboarding não refletida”, “uso sazonal”, “mapeamento de conta incorreto”). Rode esse feedback para o backlog e tagueie com conta e versão do modelo para debug mais rápido.

Depois do piloto estável, planeje trabalho de escala: integrações mais profundas (CRM, billing, suporte), segmentação (por plano, indústria, ciclo de vida), automação (tarefas e playbooks) e autoatendimento para que times personalizem views sem engenharia.

Ao escalar, mantenha o loop construir/iterar rápido. Times frequentemente usam Koder.ai para gerar novas páginas de dashboard, refinar shapes de API ou adicionar features de workflow (tarefas, exports, releases com rollback) diretamente do chat—útil quando você versiona o modelo de pontuação e precisa lançar UI + backend juntos sem frear o ciclo de feedback do CS.