O que “iteração” significa — e onde a IA encaixa

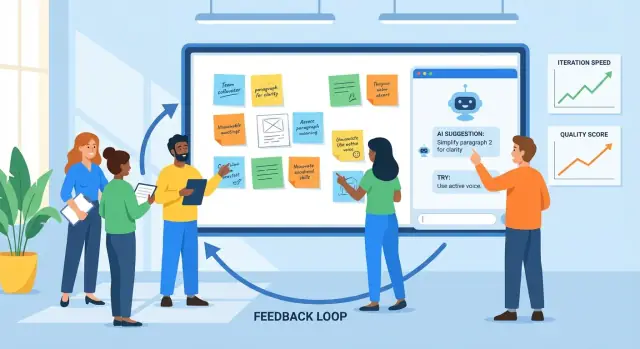

Iteração é a prática de criar algo, obter feedback, melhorar e repetir o ciclo. Você vê isso em design de produto (lançar um recurso, observar uso, refinar), marketing (testar uma mensagem, aprender, reescrever) e escrita (rascunhar, revisar, editar).

Feedback é qualquer sinal que diz o que está funcionando e o que não está: comentários de usuários, tickets de suporte, relatórios de bugs, respostas de pesquisas, métricas de desempenho, notas de stakeholders — até seu próprio check depois de usar o produto. Melhoria é o que você muda com base nesses sinais, desde pequenos ajustes até redesigns maiores.

Por que ciclos mais curtos importam

Ciclos de feedback mais curtos geralmente levam a melhores resultados por duas razões:

- Qualidade melhora mais rápido: você identifica equívocos e defeitos cedo, antes que se espalhem por mais páginas, telas ou releases.

- Velocidade aumenta sem adivinhação: você gasta menos tempo debatendo no abstrato e mais tempo aprendendo com evidência real.

Um bom ritmo de iteração não é “mova-se rápido e quebre tudo.” É “mova-se em passos pequenos e aprenda rápido.”

Onde a IA ajuda (e onde não ajuda)

A IA é útil dentro do loop quando há muita informação e você precisa de ajuda para processá-la. Ela pode:

- resumir feedback de múltiplas fontes em temas

- identificar reclamações repetidas, redação confusa ou detalhes ausentes

- propor versões alternativas (copy, layouts, formulação de tarefas) para considerar

- atuar como um segundo par de olhos para clareza, tom e consistência

Mas a IA não pode substituir as decisões centrais. Ela não conhece seus objetivos de negócio, restrições legais ou o que “bom” significa para seus usuários, a menos que você defina isso. Pode sugerir com confiança mudanças fora da marca, arriscadas ou baseadas em suposições erradas.

Defina expectativas claramente: a IA apoia o julgamento. Sua equipe ainda escolhe o que priorizar, o que mudar, como medir sucesso — e valida as melhorias com usuários reais e dados reais.

O loop básico de feedback: um modelo prático

Iteração é mais fácil quando todos seguem o mesmo loop e sabem o que significa “pronto”. Um modelo prático é:

rascunho → feedback → revisar → checar → publicar

Equipes frequentemente travam porque uma etapa é lenta (revisões), desorganizada (feedback espalhado por ferramentas) ou ambígua (o que exatamente deve mudar?). Usada deliberadamente, a IA pode reduzir atritos em cada ponto.

Etapa 1: Rascunho (chegar a algo revisável)

O objetivo não é perfeição; é uma primeira versão sólida que outros possam avaliar. Um assistente de IA pode te ajudar a estruturar, gerar alternativas ou preencher lacunas para chegar a “revisável” mais rápido.

Onde ajuda mais: transformar um briefing áspero em um rascunho estruturado e produzir opções (por exemplo, três títulos, dois fluxos de onboarding) para comparar.

Etapa 2: Feedback (capturar e condensar)

Feedback normalmente chega como comentários longos, threads de chat, notas de chamada e tickets de suporte. A IA é útil para:

- resumir temas repetidos (o que as pessoas continuam mencionando)

- agrupar feedback por tópico (preço, onboarding, tom, bugs)

- extrair perguntas e itens “precisa-corrigir” vs. “bom ter”

O gargalo que você remove: leitura lenta e interpretação inconsistente do que os revisores queriam dizer.

É aqui que equipes perdem tempo com retrabalho: feedback pouco claro leva a edições que não satisfazem o revisor, e o loop se repete. A IA pode sugerir edições concretas, propor copy revisada ou gerar uma segunda versão que trate explicitamente dos principais temas do feedback.

Etapa 4: Checar (qualidade antes de publicar)

Antes do lançamento, use a IA como um segundo par de olhos: a nova versão introduziu contradições, passos faltando, requisitos quebrados ou variação de tom? O objetivo não é “aprovar” o trabalho; é pegar problemas óbvios cedo.

A iteração acelera quando mudanças vivem em um só lugar: um ticket, doc ou descrição de PR que registre (1) o resumo do feedback, (2) as decisões e (3) o que mudou.

A IA pode ajudar a manter essa “fonte única da verdade” redigindo notas de atualização e alinhando critérios de aceitação com as decisões mais recentes. Em times que constroem e lançam software diretamente (não só docs), plataformas como Koder também podem encurtar essa etapa mantendo planejamento, implementação e deploy conectados — assim a narrativa do “o que mudou” fica próxima ao release real.

Coletando feedback: o que a IA processa bem

A IA só melhora o que você alimenta. A boa notícia é que a maioria das equipes já tem muito feedback — só que espalhado por vários lugares e escrito em estilos diferentes. Seu trabalho é coletá-lo de forma consistente para que a IA possa resumir, encontrar padrões e ajudar a decidir o próximo passo.

Entradas de feedback que funcionam especialmente bem

A IA é mais forte com inputs textuais desorganizados, incluindo:

- comentários de usuários (in-app, posts em comunidade, chat)

- tickets de suporte e transcrições de chat

- respostas abertas de pesquisas

- avaliações em lojas de apps e marketplaces

- notas de chamadas de vendas/CS e resumos de reuniões

- relatórios de bugs e pedidos de recursos de times internos

Você não precisa de formatação perfeita. O que importa é capturar as palavras originais e um pouco de metadado (data, área do produto, plano, etc.).

De “um monte de citações” a temas e pontos de dor

Uma vez coletado, a IA pode agrupar feedback em temas — confusão sobre faturamento, atrito no onboarding, integrações ausentes, desempenho lento — e mostrar o que se repete com mais frequência. Isso importa porque o comentário mais alto nem sempre é o problema mais comum.

Uma abordagem prática é pedir à IA:

- uma lista de temas com rótulos curtos

- citações representativas por tema (para você checar a sanidade)

- sinais de frequência (por exemplo, “mencionado em 18 tickets esta semana”)

- pistas de impacto (quem é afetado e o que fica bloqueado)

Manter contexto para que insights permaneçam relevantes

Feedback sem contexto pode levar a conclusões genéricas. Anexe contexto leve a cada item, como:

- persona ou tipo de cliente (usuário novo, admin, power user)

- objetivo do usuário (“exportar um relatório”, “convidar colegas”)

- restrições (dispositivo, região, plano, necessidades de conformidade)

Mesmo alguns campos consistentes tornam o agrupamento e os resumos da IA muito mais acionáveis.

Privacidade e noções básicas de tratamento de dados

Antes da análise, redija informações sensíveis: nomes, emails, telefones, endereços, dados de pagamento e qualquer coisa confidencial nas notas de chamada. Prefira a minimização de dados — compartilhe apenas o necessário para a tarefa — e armazene os exports brutos com segurança. Se usar ferramentas de terceiros, confirme a política do seu time sobre retenção e treinamento, e restrinja acesso ao conjunto de dados.

Feedback bruto costuma ser um monte de inputs desalinhados: tickets, avaliações, respostas de pesquisa, notas de vendas e threads de Slack. A IA é útil porque consegue ler linguagem “bagunçada” em escala e ajudar a transformar isso em uma lista curta de temas trabalháveis.

1) De comentários dispersos a categorias

Comece alimentando a IA com um lote de feedback (com dados sensíveis removidos) e peça para agrupar itens em categorias consistentes, como onboarding, desempenho, preço, confusão de UI, bugs e pedidos de recurso. O objetivo não é uma taxonomia perfeita — é um mapa compartilhado que a equipe possa usar.

Um resultado prático parece com:

- Categoria: Confusão no onboarding

- O que os usuários tentam fazer: Conectar conta, importar dados

- Bloqueios observados: “Não achei o botão de importar”, “Não tenho certeza se funcionou”

Uma vez agrupado, peça à IA para propor uma pontuação de prioridade usando um critério que você revise:

- Impacto: Quanto isso afeta o sucesso do usuário ou receita?

- Frequência: Com que frequência aparece nas fontes?

- Esforço: Quão difícil é consertar (tempo, dependências)?

- Risco: Qual a chance de quebrar algo ou causar problemas de conformidade/suporte?

Você pode manter leve (Alto/Médio/Baixo) ou numérico (1–5). O importante é que a IA rascunhe a primeira versão e os humanos confirmem as suposições.

3) Resumir sem perder nuances (manter os recibos)

Resumos ficam perigosos quando apagam o “porquê”. Um padrão útil é: resumo do tema + 2–4 citações representativas. Por exemplo:

“Conectei o Stripe mas nada mudou — ele sincronizou?”

“O assistente pulou uma etapa e eu não sabia o que fazer em seguida.”

Citações preservam tom emocional e contexto — e impedem que a equipe trate todo problema como idêntico.

A IA pode dar peso a linguagem dramática ou a comentaristas repetidos se você não guiar. Peça para separar:

- Sinais por volume (quantos usuários únicos mencionaram)

- Sinais por severidade (o quão grave é quando acontece)

Depois, valide com dados de uso e segmentação. Uma reclamação de power users pode ser crítica — ou pode refletir um fluxo de trabalho de nicho. A IA mostra padrões, mas não decide o que “representa seus usuários” sem seu contexto.

Usar IA para gerar versões, não apenas “a resposta”

Prototipe a partir de um briefing

Crie um protótipo rápido, revise e itere sem ficar preso em documentação infinita.

Uma maneira útil de pensar na IA é como um gerador de versões. Em vez de pedir uma única resposta “melhor”, peça várias versões plausíveis para comparar, misturar e refinar. Essa mentalidade mantém você no controle e acelera a iteração.

Isso é especialmente poderoso ao iterar superfícies de produto (fluxos de onboarding, copy de UI, redação de especificações). Por exemplo, se você está construindo uma ferramenta interna ou um app simples no Koder, pode usar o mesmo modo de “gerar múltiplas versões” para explorar telas, fluxos e requisitos em Modo de Planejamento antes de se comprometer — então confiar em snapshots e rollback para manter mudanças rápidas seguras.

Dê restrições para que as variantes sejam comparáveis

Se você pedir “escreva isso para mim”, frequentemente receberá um output genérico. Melhor: defina limites para que a IA possa explorar opções dentro deles.

Tente especificar:

- Público + intenção: “Usuários novos decidindo se cadastram” vs. “Clientes existentes que precisam de reassegurança.”

- Tom: amigável, direto, formal, descontraído (escolha um).

- Tamanho: por exemplo, “120–150 palavras” ou “máx. 3 bullets.”

- Formato: email, hero de landing, FAQ, nota de release.

- Fatos obrigatórios: preços, datas, garantias, limitações do produto.

- Evitar: afirmações proibidas, linguagem sensível, menções a concorrentes.

Com restrições, você pode gerar “Versão A: concisa”, “Versão B: mais empática”, “Versão C: mais específica”, sem perder precisão.

Gerar múltiplas opções, depois escolher (ou combinar)

Peça 3–5 alternativas de uma vez e explique as diferenças: “Cada versão deve usar estrutura e linha de abertura diferentes.” Isso cria contraste real, ajudando a ver o que falta e o que ressoa.

Workflow prático:

- Gere 3–5 versões.

- Escolha as melhores partes (abertura de A, provas de C, CTA de B).

- Peça à IA para mesclá-las em um rascunho, mantendo fatos obrigatórios intactos.

Checklist rápido: o que um “bom rascunho” contém

Antes de enviar um rascunho para revisão ou teste, confira se tem:

- um objetivo claro (o que o leitor deve fazer/entender)

- fatos-chave preservados e consistentes

- uma razão específica e crível para se importar (benefício + prova)

- um CTA primário

- linguagem simples e pouco jargão

- sem promessas não suportadas ou superlativos vagos

Usada assim, a IA não substitui julgamento — acelera a busca por uma versão melhor.

IA como revisor: detectar problemas cedo

Antes de publicar um rascunho — seja especificação de produto, nota de release, artigo de ajuda ou página de marketing — uma ferramenta de IA pode agir como um revisor inicial rápido. O objetivo não é substituir julgamento humano; é surfacing de problemas óbvios para que a equipe gaste tempo nas decisões difíceis, não em limpeza básica.

O que revisões assistidas por IA fazem bem

Revisões com IA são especialmente úteis para:

- Clareza: identificar frases longas, termos pouco claros ou contexto faltando para um leitor novo.

- Consistência: checar nomes (labels, capitalização), afirmações repetidas e contradições entre seções.

- Tom: alinhar a voz com o público (amigável, direta, formal) e sinalizar frases que soem defensivas ou vagas.

- Completude: apontar passos faltantes, casos de borda, pré-requisitos ou lacunas de “o que acontece depois”.

Prompts práticos de revisão que você pode reutilizar

Cole seu rascunho e peça um tipo específico de crítica. Por exemplo:

- “Revise para lacunas: que perguntas um usuário de primeira viagem ainda teria?”

- “Marque pressupostos: o que estou assumindo sobre o produto, usuário ou fluxo?”

- “Simplifique: reescreva qualquer frase com mais de 25 palavras mantendo o sentido.”

- “Verifique inconsistências: liste termos usados de formas diferentes.”

Críticas por papel para ampliar perspectiva

Uma maneira rápida de ampliar a visão é pedir ao modelo para revisar de diferentes papéis:

- “Como cliente, o que parece confuso ou arriscado?”

- “Como suporte, que tickets isso pode gerar?”

- “Como PM, que critérios de aceitação estão faltando?”

- “Como legal/compliance, que promessas precisam ser ajustadas?”

Checagem de segurança: verifique os fatos

A IA pode criticar com confiança enquanto erra sobre detalhes do produto. Trate itens factuais — preços, disponibilidade de recursos, segurança, prazos — como “precisam de verificação.” Mantenha o hábito de marcar afirmações com fontes (links para docs, tickets ou decisões) para que a versão final reflita a realidade, não um palpite plausível.

Converter feedback em edições, tarefas e critérios de aceitação

Feedback bruto raramente está pronto para implementação. Tendem a ser emocionais (“isso soa errado”), mistos (“gosto, mas…”), ou pouco especificados (“torne mais claro”). A IA pode ajudar a traduzir isso em itens de trabalho que a equipe pode entregar — mantendo o comentário original anexado para justificar decisões depois.

Um template simples que a IA pode preencher

Peça à IA para reescrever cada feedback com esta estrutura:

Problema → Evidência → Mudança proposta → Métrica de sucesso

- Problema: o que não está funcionando?

- Evidência: o que o usuário disse/fez? Inclua a citação, referência de screenshot ou timestamp da chamada.

- Mudança proposta: o que você mudará (uma mudança por item).

- Métrica de sucesso: como saberá que melhorou (qualitativa ou quantitativa).

Isso força clareza sem “inventar” requisitos novos.

Exemplo de feedback:

“A página de checkout é confusa e demora muito.”

Output assistido por IA (editado por você):

- Problema: Usuários têm dificuldade em entender os passos e abandonam durante o checkout.

- Evidência: 6/20 entrevistados perguntaram “qual é o próximo passo?”; analytics mostram uma queda de 38% entre Envio → Pagamento (10–20 de dez).

- Mudança proposta: Adicionar um indicador de progresso em 3 passos e renomear o botão primário de “Continuar” para “Continuar para Pagamento.”

- Métrica de sucesso: Reduzir a queda Envio → Pagamento de 38% para ≤30% em 2 semanas.

Depois converta em tarefa com limites:

Tarefa: Adicionar indicador de progresso + atualizar rótulo do botão no checkout.

Fora do escopo: Mudar provedores de pagamento, redesenhar todo o layout do checkout, reescrever todo o copy do produto.

Critérios de aceitação (tornando testável)

Use a IA para rascunhar critérios de aceitação, depois aperfeiçoe:

- Indicador de progresso aparece em mobile e desktop.

- Etapas refletem o estado atual (Envio, Pagamento, Revisão).

- Rótulo do botão atualizado nas telas Envio e Pagamento.

- Sem alteração em preços, impostos ou processamento de pagamento.

Mantenha o feedback rastreável

Armazene sempre:

- o feedback original (citação/link do ticket/chamada)

- a tarefa transformada pela IA

- a decisão final e a justificativa

Essa rastreabilidade protege responsabilidade, evita decisões “porque a IA disse” e torna iterações futuras mais rápidas porque você vê o que mudou — e por quê.

Testando melhorias: experimentos que a IA pode acelerar

Facilite o rollback

Capture uma versão estável antes de grandes edições para comparar alterações e reverter rapidamente.

Iteração vira real quando você testa uma mudança contra um resultado mensurável. A IA pode ajudar a desenhar experimentos pequenos e rápidos — sem transformar cada melhoria em projeto de semanas.

Um modelo simples de experimento (que a IA pode ajudar a redigir)

Um template prático é:

- Hipótese: Se mudarmos X, então Y vai melhorar porque Z.

- Variantes: Versão A (atual) vs. Versão B (uma mudança intencional).

- Métrica de sucesso: o número que decidirá (open rate, taxa de ativação, taxa de conversão, tempo até o primeiro valor).

- Público + duração: quem vê e por quanto tempo.

Peça à IA 3–5 hipóteses candidatas baseadas em temas de feedback (por ex., “usuários dizem que setup é confuso”) e peça para reescrevê-las em declarações testáveis com métricas claras.

Exemplos rápidos que a IA pode gerar (e você pode testar)

Assuntos de email (métrica: open rate):

- A: “Seu relatório semanal está pronto”

- B: “3 insights da sua semana (2 minutos de leitura)”

Mensagem de onboarding (métrica: taxa de conclusão do passo 1):

- A: “Bem-vindo! Vamos configurar sua conta.”

- B: “Bem-vindo — adicione seu primeiro projeto e veja resultados em menos de 5 minutos.”

Microcopy no botão (métrica: CTR):

- A: “Enviar”

- B: “Salvar e continuar”

A IA é útil porque produz múltiplas variantes plausíveis rapidamente — diferentes tons, comprimentos e propostas de valor — para que você escolha uma mudança clara a testar.

Limites: torne o teste interpretável

Velocidade é ótima, mas mantenha experimentos legíveis:

- Mude uma variável por vez quando possível. Reescrever manchete e botão e layout impede saber o que funcionou.

- Mantenha um controle. Preserve sempre a Versão A.

- Defina a métrica antes de olhar. Caso contrário você “encontra” ganhos por acaso.

Meça resultados, não intuições

A IA pode dizer o que “soa melhor”, mas são os usuários que decidem. Use a IA para:

- sugerir limiares de sucesso (por ex., “vamos lançar B se ela melhorar CTR em ≥5%”)

- rascunhar um template de resumo de resultados

- traduzir achados em próxima hipótese

Assim cada teste ensina algo — mesmo quando a nova versão perde.

Medindo resultados e aprendendo a cada ciclo

Iteração só funciona quando você pode dizer se a última mudança ajudou. A IA acelera o passo “medição → aprendizado”, mas não substitui disciplina: métricas claras, comparações limpas e decisões escritas.

Escolha um pequeno conjunto de números a checar a cada ciclo, agrupados pelo que você quer melhorar:

- Conversão: cadastros, início de trials, finalização de checkout, CTR em CTA chave

- Retenção: taxa de retorno em 7/30 dias, churn, compras repetidas, reuso de recurso

- Tempo para completar: tempo de onboarding, tempo até o primeiro valor, tempo de resolução no suporte

- Taxa de erro / qualidade: submissões falhas, relatórios de bugs, taxa de reembolso, contagem de defeitos em QA

- Satisfação: CSAT, NPS, avaliações de app, sentimento em tickets de suporte

O ponto é consistência: se você mudar definições de métricas a cada sprint, os números não vão ensinar nada.

Deixe a IA resumir resultados — e apontar onde mudaram

Com leituras de experimentos, dashboards ou CSVs, a IA é útil para transformar isso em narrativa:

- resumir o que se moveu (e o que não) em linguagem simples

- destacar segmentos notáveis: novos vs. recorrentes, tipo de dispositivo, fonte de tráfego, região, plano, power users vs. casuais

- trazer correlações surpreendentes que valham análise posterior (por ex., conversão subiu no geral, mas caiu no mobile Safari)

Um prompt prático: cole sua tabela de resultados e peça ao assistente para produzir (1) um parágrafo resumo, (2) as maiores diferenças por segmento e (3) perguntas de seguimento para validar.

Evite falsa certeza

A IA pode fazer os resultados soarem definitivos quando não são. Ainda é preciso checar:

- Tamanho da amostra: mudanças pequenas em amostras pequenas costumam ser ruído.

- Sazonalidade e eventos externos: feriados, promoções, quedas, menções na mídia.

- Múltiplas mudanças: se três coisas mudaram, talvez você não saiba qual causou o efeito.

Mantenha um registro leve de aprendizados

Após cada ciclo, escreva uma entrada curta:

- O que mudou (link para ticket ou doc)

- O que aconteceu (métricas + segmentos notáveis)

- O que achamos que significa (sua melhor explicação)

- O que tentaremos a seguir (uma ação concreta)

A IA pode rascunhar a entrada, mas sua equipe deve aprovar a conclusão. Com o tempo, esse log vira memória — e você para repetir experimentos e começa a acumular ganhos.

Tornando o processo repetível: workflows que escalam

Comece com uma stack real

Transforme sua próxima ideia em um app React com backend em Go e PostgreSQL, guiado por chat.

Velocidade é agradável, mas consistência é o que faz iteração compor. O objetivo é transformar “devemos melhorar isto” em uma rotina que sua equipe rode sem heroísmos.

Padrões de workflow leves

Um loop escalável não precisa de processo pesado. Alguns hábitos pequenos vencem sistemas complicados:

- Revisão semanal (30–60 min): escolha 1–3 itens para melhorar, revise mudanças da semana passada e decida o que testar a seguir. Leve resumos preparados pela IA (temas, principais reclamações, riscos emergentes) para manter a reunião focada.

- Change log: mantenha uma nota corrida do que mudou, por que e o que se espera. Um doc simples funciona; a chave é consistência.

- Notas de decisão: para mudanças significativas capture a decisão em cinco linhas: contexto, opções consideradas, decisão, responsável, data. A IA pode rascunhar isso a partir de notas de reunião, mas você confirma a redação.

Templates de prompt + checklists reutilizáveis

Trate prompts como ativos. Armazene-os em pasta compartilhada e versionados como outro trabalho.

Mantenha uma pequena biblioteca:

- Templates de prompt para tarefas repetidas (resumir feedback, propor variantes, reescrever por tom, gerar critérios de aceitação).

- Checklists reutilizáveis para qualidade (clareza, completude, compliance, voz da marca, acessibilidade). Peça à IA para rodar o checklist e destacar lacunas; um humano então verifica.

Uma convenção simples ajuda: “Tarefa + Público + Restrições” (ex.: “Notas de release — não técnico — 120 palavras — incluir riscos”).

Adicione aprovação humana para saídas sensíveis

Para qualquer coisa que afete confiança ou responsabilidade — preços, redação legal, orientação médica ou financeira — use a IA para rascunhar e sinalizar riscos, mas exija um aprovador nomeado antes de publicar. Torne esse passo explícito para que não seja pulado por pressão de prazo.

Nomeação de versões que evita confusão

Iteração rápida cria arquivos bagunçados a menos que você rotule claramente. Use um padrão previsível como:

FeatureOuDoc_Escopo_V#_YYYY-MM-DD_Responsavel

Exemplo: OnboardingEmail_NovoTrial_V3_2025-12-26_JP.

Quando a IA gera opções, mantenha-as agrupadas sob a mesma versão (V3A, V3B) para que todos saibam o que foi comparado e o que foi lançado.

Armadilhas comuns, checagens de segurança e uso responsável

A IA pode acelerar a iteração, mas também acelerar erros. Trate-a como um colega poderoso: útil, rápido e às vezes confiante demais.

Modos de falha comuns (e como evitá-los)

Confiar demais na IA. Modelos podem gerar texto, resumos ou “insights” plausíveis que não batem com a realidade. Crie o hábito de checar qualquer coisa que possa afetar clientes, orçamentos ou decisões.

Prompts vagos geram trabalho vago. Se o seu input é “melhore isto”, você receberá edições genéricas. Especifique público, objetivo, restrições e o que “melhor” significa (mais curto, mais claro, on-brand, menos tickets, maior conversão etc.).

Sem métricas, sem aprendizado. Iteração sem medição é só mudança. Decida desde o início o que irá acompanhar (taxa de ativação, tempo até o primeiro valor, churn, temas de NPS, taxa de erro) e compare antes/depois.

Tratamento de dados: proteja usuários e empresa

Não cole informações pessoais, de clientes ou confidenciais em ferramentas a menos que sua organização permita explicitamente e você entenda políticas de retenção/treinamento.

Regra prática: compartilhe o mínimo necessário.

- Remova nomes, emails, telefones, endereços, IDs de pedido e notas em texto livre que contenham detalhes sensíveis.

- Resuma internamente e peça ao modelo trabalhar a partir do resumo.

- Se precisar analisar feedback real, redija primeiro e armazene o original no sistema aprovado.

Alucinações: verifique fatos e fontes

A IA pode inventar números, citações, detalhes de features ou usuários. Quando a precisão for importante:

- Pergunte por pressupostos e incertezas (“O que você não tem certeza?”).

- Solicite links para fontes primárias apenas quando você puder verificá-los.

- Cruze com seus docs, analytics, changelog ou sistema de suporte.

Checklist “antes de publicar”

Antes de lançar uma mudança assistida por IA, faça uma verificação rápida:

- Objetivo e métrica definidas (o que é sucesso).

- Dados sensíveis removidos dos prompts e logs.

- Fatos verificados (afirmações, números, políticas, citações).

- Casos de borda revisados (acessibilidade, tom, notas legais/compliance).

- Assinatura humana do responsável certo (PM, suporte, jurídico, marca).

- Plano de rollback caso a mudança tenha desempenho pior.

Usada assim, a IA continua sendo um multiplicador de bom julgamento — não um substituto.