25 de jul. de 2025·8 min

Como os LLMs Transformam Ideias em Inglês Simples em Apps Full-Stack

Como LLMs transformam ideias em inglês simples em apps web, mobile e backend: requisitos, fluxos de UI, modelos de dados, APIs, testes e deployment.

Como LLMs transformam ideias em inglês simples em apps web, mobile e backend: requisitos, fluxos de UI, modelos de dados, APIs, testes e deployment.

Uma “ideia de produto em inglês simples” geralmente começa como uma mistura de intenção e esperança: quem é o público, qual problema resolve e como o sucesso é medido. Pode ser algumas frases (“um app para agendar passeadores de cães”), um fluxo aproximado (“cliente solicita → passeador aceita → pagamento”) e alguns itens essenciais (“notificações push, avaliações”). Isso basta para conversar sobre a ideia — mas não para construir consistentemente.

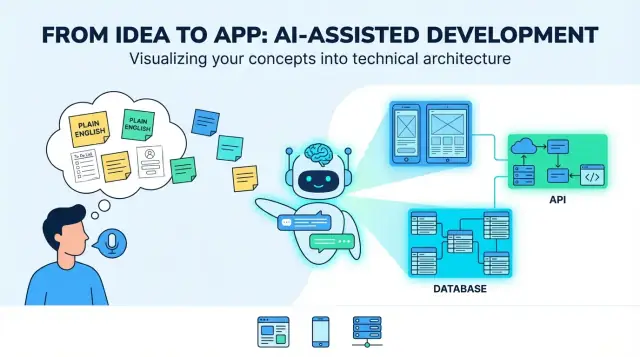

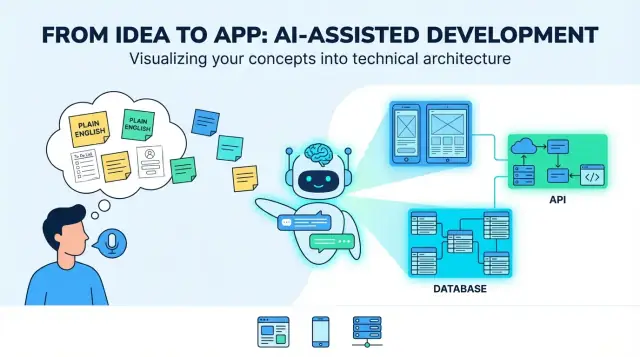

Quando as pessoas dizem que um LLM pode “traduzir” uma ideia em um app, o significado útil é este: transformar metas vagas em decisões concretas e testáveis. A “tradução” não é só reescrever — é acrescentar estrutura para que você possa revisar, desafiar e implementar.

LLMs são bons em produzir um primeiro rascunho dos blocos construtivos principais:

O “resultado típico” parece um blueprint para um produto full-stack: uma UI web (geralmente para admins ou tarefas desktop), uma UI mobile (para usuários em movimento), serviços backend (auth, lógica de negócio, notificações) e armazenamento de dados (banco + arquivo/ mídia).

LLMs não podem escolher de forma confiável os trade-offs do seu produto, porque as respostas certas dependem do contexto que você pode não ter escrito:

Trate o modelo como um sistema que propõe opções e padrões, não a verdade final.

Os maiores modos de falha são previsíveis:

O objetivo real da “tradução” é tornar as suposições visíveis — para que você possa confirmar, revisar ou rejeitar antes que se cristalizem em código.

Antes que um LLM possa transformar “Construa-me um app para X” em telas, APIs e modelos de dados, você precisa de um brief de produto específico o suficiente para projetar. Esta etapa trata de transformar intenção vaga em um alvo compartilhado.

Escreva a declaração do problema em uma ou duas frases: quem está com dificuldade, com o quê, e por que isso importa. Em seguida, acrescente métricas de sucesso observáveis.

Por exemplo: “Reduzir o tempo que uma clínica leva para agendar retornos.” Métricas podem incluir tempo médio de agendamento, taxa de não comparecimento, ou % de pacientes agendando via self-service.

Liste os tipos de usuário primários (não todo mundo que possa tocar o sistema). Dê a cada um uma tarefa principal e um cenário curto.

Um template útil de prompt é: “Como [papel], eu quero [fazer algo] para [benefício].” Mire em 3–7 casos de uso centrais que descrevam o MVP.

Restrições fazem a diferença entre um protótipo limpo e um produto enviável. Inclua:

Seja explícito sobre o que entra na primeira entrega e o que fica postergado. Uma regra simples: recursos do MVP devem suportar os casos de uso primários de ponta a ponta sem gambiarras manuais.

Se quiser, capture isso como um brief de uma página e mantenha como a “fonte da verdade” para os próximos passos (requisitos, fluxos de UI e arquitetura).

Uma ideia em inglês simples é geralmente uma mistura de metas (“ajudar pessoas a reservar aulas”), suposições (“usuários farão login”), e escopo vago (“tornar simples”). Um LLM é útil aqui porque pode transformar entrada bagunçada em requisitos que você pode revisar, corrigir e aprovar.

Comece reescrevendo cada sentença como uma história de usuário. Isso força clareza sobre quem precisa o quê e por quê:

Se uma história não nomeia um tipo de usuário ou benefício, provavelmente ainda está vaga.

Em seguida, agrupe histórias em funcionalidades e marque cada uma como essencial ou desejável. Isso ajuda a evitar aumento de escopo antes do design e engenharia começarem.

Exemplo: “notificações push” pode ser desejável, enquanto “cancelar uma reserva” normalmente é essencial.

Adicione regras simples e testáveis sob cada história. Bons critérios de aceitação são específicos e observáveis:

LLMs frequentemente assumem o “caminho feliz”, então solicite explicitamente casos de borda como:

Esse pacote de requisitos vira a fonte de verdade que você usará para avaliar saídas posteriores (fluxos de UI, APIs e testes).

Uma ideia em inglês simples se torna construtível quando vira jornadas de usuário e telas conectadas por uma navegação clara. Nesta etapa, você não escolhe cores—define o que as pessoas podem fazer, em que ordem, e o que significa sucesso.

Comece listando os caminhos que importam. Para muitos produtos, você pode estruturá-los como:

O modelo pode rascunhar esses fluxos como sequências passo a passo. Seu trabalho é confirmar o que é opcional, o que é obrigatório e onde usuários podem sair e retomar com segurança.

Peça dois entregáveis: um inventário de telas e um mapa de navegação.

Uma boa saída nomeia telas consistentemente (ex.: “Detalhes do Pedido” vs “Detalhe do Pedido”), define pontos de entrada e inclui estados vazios (sem resultados, sem itens salvos).

Transforme requisitos em campos de formulário com regras: obrigatório/opcional, formatos, limites e mensagens de erro amigáveis. Exemplo: regras de senha, formatos de endereço de pagamento, ou “data deve ser no futuro”. Garanta validação inline (enquanto o usuário digita) e no envio.

Inclua tamanhos de texto legíveis, contraste claro, suporte total ao teclado na web e mensagens de erro que expliquem como corrigir (não apenas “Entrada inválida”). Garanta que cada campo de formulário tenha um label e que a ordem do foco faça sentido.

Uma “arquitetura” é a planta do app: que partes existem, pelo que cada parte é responsável, e como se comunicam. Quando um LLM propõe uma arquitetura, seu trabalho é garantir que seja simples o suficiente para construir agora e clara o bastante para evoluir depois.

Para a maioria dos produtos novos, um backend único (monolito) é a escolha certa no início: um código, um deploy, um banco. É mais rápido de construir, mais fácil depurar e mais barato operar.

Um monolito modular costuma ser o ponto ideal: ainda um deploy, mas organizado em módulos (Auth, Billing, Projetos, etc.) com limites claros. Adie a divisão em serviços até haver pressão real — como tráfego intenso, times que precisam de deploys independentes, ou partes que escalam de forma diferente.

Se o LLM sugerir “microservices” de imediato, peça para justificar com necessidades concretas, não hipóteses futuras.

Um bom esboço de arquitetura nomeia o essencial:

O modelo também deve especificar onde cada peça vive (backend vs mobile vs web) e definir como os clientes interagem com o backend (geralmente REST ou GraphQL).

Arquitetura fica ambígua se você não definir o básico: framework backend, banco de dados, hospedagem e abordagem mobile (nativo vs cross-platform). Peça que o modelo escreva essas escolhas como “Suposições” para que todos saibam o que está sendo projetado.

Em vez de grandes reescritas, prefira pequenos “escape hatches”: cache para leituras quentes, fila para jobs em background, e servidores stateless para permitir adicionar instâncias. As melhores propostas explicam essas opções enquanto mantêm o v1 simples.

Uma ideia de produto costuma estar cheia de substantivos: “usuários”, “projetos”, “tarefas”, “pagamentos”, “mensagens”. Modelagem de dados é o passo onde um LLM transforma esses substantivos em um quadro compartilhado do que o app precisa armazenar — e como as coisas se conectam.

Comece listando as entidades-chave e perguntando: o que pertence a quê?

Por exemplo:

Depois defina relacionamentos e restrições: uma tarefa pode existir sem projeto? comentários podem ser editados? projetos podem ser arquivados? o que acontece com tarefas quando um projeto é deletado?

Em seguida, o modelo propõe um esquema inicial (tabelas SQL ou coleções NoSQL). Mantenha simples e foque em decisões que afetam comportamento.

Um rascunho típico pode incluir:

Importante: capture campos de “status”, timestamps e restrições únicas cedo (ex.: email único). Esses detalhes guiam filtros de UI, notificações e relatórios depois.

A maioria dos apps reais precisa de regras claras sobre quem pode ver o quê. Um LLM deve tornar propriedade explícita (owner_user_id) e modelar acesso (membros/papéis). Para produtos multi-tenant (várias empresas no mesmo sistema), introduza uma entidade tenant/organization e anexe tenant_id a tudo que precisa ser isolado.

Também defina como permissões são aplicadas: por papel (admin/membro/visualizador), por propriedade, ou ambos.

Decida o que precisa ser logado e o que deve ser deletado. Exemplos:

Essas escolhas evitam surpresas quando compliance, suporte ou questões de cobrança aparecerem.

APIs backend são onde as promessas do seu app viram ações reais: “salve meu perfil”, “mostre meus pedidos”, “busque anúncios”. Uma boa saída parte das ações do usuário e transforma em um conjunto pequeno de endpoints claros.

Liste as coisas principais com as quais os usuários interagem (ex.: Projects, Tasks, Messages). Para cada uma, defina o que o usuário pode fazer:

Isso normalmente mapeia bem para endpoints como:

POST /api/v1/tasks (create)GET /api/v1/tasks?status=open&q=invoice (list/search)GET /api/v1/tasks/{taskId} (read)PATCH /api/v1/tasks/{taskId} (update)DELETE /api/v1/tasks/{taskId} (delete)Criar uma tarefa: o usuário envia título e data de vencimento.

POST /api/v1/tasks

{

"title": "Send invoice",

"dueDate": "2026-01-15"

}

A resposta retorna o registro salvo (incluindo campos gerados pelo servidor):

201 Created

{

"id": "tsk_123",

"title": "Send invoice",

"dueDate": "2026-01-15",

"status": "open",

"createdAt": "2025-12-26T10:00:00Z"

}

Observação: mantenha esses blocos de código exatamente como referência para implementadores.

Peça que o modelo produza erros consistentes:

Para retries, prefira chaves de idempotência em POST e orientação clara tipo “retry após 5 segundos”.

Clientes mobile atualizam devagar. Use um path base versionado (/api/v1/...) e evite mudanças quebradoras:

GET /api/version)Segurança não é tarefa “para depois”. Quando um LLM transforma sua ideia em specs, você quer defaults seguros explícitos — para que a primeira versão gerada não fique acidentalmente aberta ao abuso.

Peça ao modelo para recomendar um método de login primário e um fallback, além do que acontece quando algo dá errado (perda de acesso, login suspeito). Escolhas comuns incluem:

Defina gerenciamento de sessão (tokens curtos, refresh tokens, logout por dispositivo) e se suporta MFA.

Autenticação identifica; autorização limita acesso. Incentive o modelo a escolher um padrão claro:

project:edit, invoice:export) para produtos flexíveisUma boa saída inclui regras de exemplo como: “Somente donos de projeto podem deletar; colaboradores podem editar; visualizadores podem comentar.”

Peça salvaguardas concretas, não promessas genéricas:

Também solicite uma checklist básica de ameaças: proteções CSRF/XSS, cookies seguros e uploads de arquivo seguros se aplicável.

Adote coleta mínima: só o que o recurso realmente precisa, pelo menor tempo possível.

Peça ao LLM para redigir cópia em linguagem simples para:

Se incluir analytics, insista em um opt-out (ou opt-in quando exigido) e documente isso nas configurações e na política.

Um bom LLM pode transformar requisitos em um plano de testes utilizável — se você obrigar a ancorar tudo aos critérios de aceitação, não a frases genéricas “deve funcionar”.

Comece dando ao modelo sua lista de funcionalidades e critérios de aceitação; então peça testes por critério. Uma saída sólida inclui:

Se um teste não aponta para um critério específico, provavelmente é ruído.

LLMs também podem propor fixtures que espelham o uso real: nomes bagunçados, campos ausentes, fusos horários, textos longos, rede instável e “quase duplicados”.

Peça por:

Adicione uma checklist mobile dedicada:

LLMs são ótimos em rascunhar esqueletos de teste, mas revise:

Trate o modelo como um autor rápido de testes, não como o veredito final de QA.

Um modelo pode gerar muito código, mas usuários só se beneficiam quando está enviado com segurança e quando você consegue ver o que acontece após o lançamento. Esta etapa é sobre releases repetíveis: os mesmos passos toda vez, com mínima surpresa.

Crie uma pipeline CI simples que rode em cada pull request e em merges para a branch principal:

Mesmo que o LLM gere o código, CI diz se ainda funciona após mudanças.

Use três ambientes com propósitos claros:

Configuração via variáveis de ambiente e secrets (não hard-coded). Regra: se mudar um valor exige alterar código, provavelmente está mal configurado.

Para um app full-stack típico:

Planeje três sinais:

Aqui é onde desenvolvimento assistido por IA vira operação: você não está só gerando código — está rodando um produto.

LLMs podem transformar uma ideia vaga em algo que parece um plano completo — mas prosa polida pode esconder lacunas. Falhas mais comuns são previsíveis; você pode evitá-las com alguns hábitos repetíveis.

A maioria das saídas fracas vem de quatro problemas:

Dê material concreto:

Peça checklists por entregável. Ex.: requisitos não estão “prontos” até terem critérios de aceitação, estados de erro, papéis/permissões e métricas mensuráveis de sucesso.

Saídas de LLMs se perdem quando specs, notas de API e ideias de UI vivem em threads separadas. Mantenha um doc vivo (mesmo um markdown simples) que linke:

Quando for fazer outro prompt, cole o trecho mais recente e diga: “Atualize somente as seções X e Y; mantenha o resto inalterado.”

Se você implementa conforme avança, também ajuda usar um fluxo que suporte iteração rápida sem perder rastreabilidade. Por exemplo, o modo de planejamento do Koder.ai se encaixa bem: você pode travar a spec (suposições, perguntas em aberto, critérios de aceitação), gerar scaffolding web/mobile/backend a partir de um único thread de chat, e confiar em snapshots/rollback se uma mudança introduzir regressões. Exportar código é especialmente útil quando quer manter arquitetura gerada e repositório alinhados.

Aqui está como a “tradução por LLM” pode parecer de ponta a ponta — mais os checkpoints onde um humano deve desacelerar e tomar decisões reais.

Ideia em inglês simples: “Um marketplace de pet-sitting onde donos postam pedidos, sitters se candidatam, e pagamentos são liberados após o serviço.”

Um LLM pode transformar isso em um rascunho inicial como:

POST /requests, GET /requests/{id}, POST /requests/{id}/apply, GET /requests/{id}/applications, POST /messages, POST /checkout/session, POST /jobs/{id}/complete, POST /reviews.Isso é útil — mas não está “pronto”. É uma proposta estruturada que precisa de validação.

Decisões de produto: O que torna uma “candidatura” válida? Um dono pode convidar um sitter diretamente? Quando um pedido é considerado “preenchido”? Essas regras afetam todas as telas e APIs.

Revisão de segurança & privacidade: Confirme acesso por papel (donos não leem chats de outros donos), proteja pagamentos e defina retenção de dados (ex.: deletar chat após X meses). Adicione controles de abuso: rate limits, prevenção de spam, logs de auditoria.

Trade-offs de performance: Decida o que deve ser rápido/escalar (busca/filtragem de pedidos, chat). Isso influencia cache, paginação, indexação e jobs em background.

Após um piloto, usuários podem pedir “repetir um pedido” ou “cancelar com reembolso parcial”. Recolha isso como requisitos atualizados, regenere ou aplique patches nos fluxos afetados, e reexecute testes e checagens de segurança.

Capture o “porquê”, não só o “o quê”: regras de negócio chave, matriz de permissões, contratos de API, códigos de erro, migrações de banco e um breve runbook para releases e resposta a incidentes. Isso mantém código gerado compreensível seis meses depois.

Neste contexto, “tradução” significa converter uma ideia vaga em decisões específicas e testáveis: papéis, jornadas, requisitos, dados, APIs e critérios de sucesso.

Não é apenas parafrasear — é tornar suposições explícitas para que você possa confirmá-las ou rejeitá-las antes de construir.

Uma primeira versão prática inclui:

Considere isso um plano inicial que você deve revisar, não uma especificação final.

Porque um LLM não consegue saber, de forma confiável, suas restrições do mundo real e trade-offs sem que você os expresse. Humanos ainda precisam decidir:

Use o modelo para propor opções e então escolha deliberadamente.

Dê ao modelo contexto suficiente para projetar contra:

Se você não pode entregar isso a um colega e obter a mesma interpretação, ainda não está pronto.

Foque em transformar metas em histórias de usuário + critérios de aceitação.

Um pacote forte geralmente contém:

Isso vira sua “fonte da verdade” para UI, APIs e testes.

Peça dois entregáveis:

Depois verifique:

Comece com o padrão: monolito ou monolito modular para a maioria dos produtos v1.

Questione se o modelo recomendar microservices de cara — peça justificativas concretas (tráfego, necessidade de deploys independentes, partes que escalam de maneira diferente). Prefira “vias de escape” em vez de superengenharia:

Mantenha o v1 fácil de lançar e de depurar.

Faça o modelo explicitar:

Decisões de dados impactam filtros da UI, notificações, relatórios e segurança.

Exija consistência e comportamento amigável para mobile:

/api/v1/...)POST que podem ser re-tentadosEvite breaking changes; adicione campos opcionais e mantenha uma janela de depreciação.

Use o modelo para esboçar um plano e depois revise-o contra os critérios de aceitação:

Também peça fixtures reais: fusos horários, textos longos, quase-duplicatas, redes instáveis. Trate testes gerados como ponto de partida, não como QA final.

Você está projetando comportamento, não visuais.