13 de jun. de 2025·8 min

Como Construir uma Aplicação Web para Propriedade Centralizada de Métricas

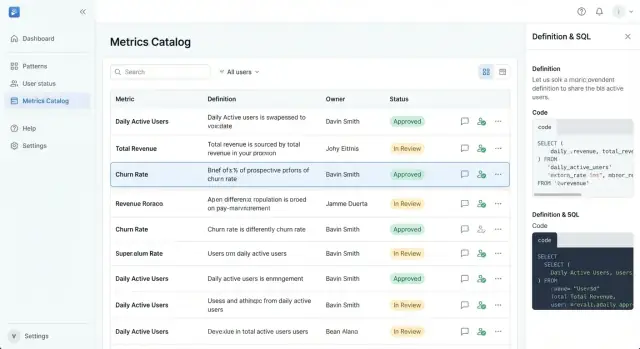

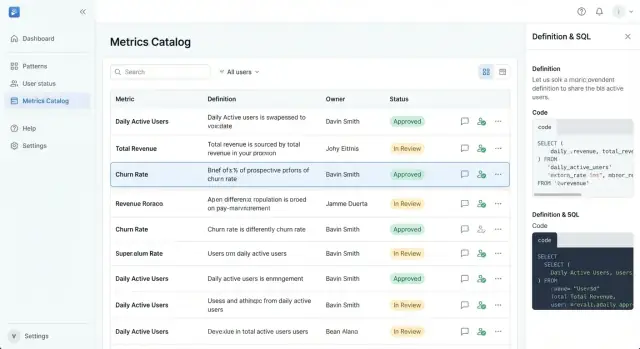

Aprenda um roteiro prático para construir uma aplicação web que centraliza definições de métricas, responsáveis, aprovações e reuso entre equipes.

Aprenda um roteiro prático para construir uma aplicação web que centraliza definições de métricas, responsáveis, aprovações e reuso entre equipes.

Métricas centralizadas significa que sua empresa tem um lugar compartilhado onde métricas de negócio são definidas, têm responsáveis e são explicadas — para que todos trabalhem com o mesmo playbook. Na prática, é um catálogo de métricas (um dicionário de KPIs) onde cada métrica tem uma definição aprovada única, um responsável e orientações claras sobre uso.

Sem uma definição centralizada, as equipes naturalmente criam suas próprias versões do mesmo KPI. “Usuários ativos” pode significar “logou” para Produto, “fez qualquer evento” para Analytics, e “assinantes pagos que usaram um recurso” para Financeiro.

Cada versão pode ser razoável isoladamente — mas quando um dashboard, uma revisão trimestral e um relatório de cobrança discordam, a confiança se rompe rápido.

Você também tem custos ocultos: trabalho duplicado, longas threads no Slack para reconciliar números, mudanças de última hora antes de reuniões executivas e uma pilha crescente de conhecimento tribal que quebra quando pessoas mudam de função.

Um app de métricas centralizado cria uma fonte única de verdade para:

Não se trata de forçar um número para toda pergunta — trata-se de tornar diferenças explícitas, intencionais e descobríveis.

Você saberá que a governança de métricas centralizada está funcionando quando observar menos disputas sobre métricas, ciclos de relatório mais rápidos, menos follow-ups “qual definição você usou?” e KPIs consistentes em dashboards e reuniões — mesmo com o crescimento da empresa.

Antes de desenhar telas ou fluxos, decida pelo que o app é responsável em memorizar. Um app de métricas centralizado falha quando definições vivem em comentários, planilhas ou cabeças das pessoas. Seu modelo de dados deve tornar cada métrica explicável, pesquisável e alterável com segurança.

A maioria das equipes cobre a maior parte dos casos de uso com estes objetos:

Esses objetos fazem o catálogo parecer completo: os usuários podem saltar de uma métrica para suas fatias, origem, guardião e onde ela aparece.

Uma página de métrica deve responder: O que é? Como é calculada? Quando devo usá-la?

Inclua campos como:

Mesmo no nível do modelo de dados, planeje para governança:

Bons catálogos são navegáveis:

Se acertar esses objetos e relacionamentos, sua UX posterior (navegação do catálogo, páginas de métrica, templates) fica simples — e suas definições se mantêm consistentes conforme a empresa cresce.

Um app de métricas centralizado funciona apenas quando cada métrica tem um “adulto na sala”. A propriedade responde perguntas básicas rapidamente: quem garante que a definição está correta? Quem aprova mudanças? Quem avisa todo mundo sobre alterações?

Responsável pela Métrica

A pessoa responsável pelo significado e uso da métrica. Responsáveis não precisam escrever SQL, mas precisam de autoridade e contexto.

Curador / revisor

Um verificador de qualidade que checa se as definições seguem padrões (nomenclatura, unidades, regras de segmentação, filtros permitidos) e se a métrica está alinhada com métricas existentes.

Contribuinte

Qualquer pessoa que possa propor uma nova métrica ou sugerir edições (Product Ops, Analytics, Finanças, Growth, etc.). Contribuintes movem ideias adiante, mas não publicam mudanças sozinhos.

Consumidor

A maioria dos usuários: pessoas que leem, pesquisam e referenciam métricas em dashboards, documentos e planejamento.

Admin

Gerencia o sistema: permissões, atribuição de papéis, templates e ações de alto risco como reatribuição forçada de responsabilidade.

Os responsáveis são responsáveis por:

Defina expectativas diretamente na UI para que as pessoas não adivinhem:

Torne “métrica sem responsável” um estado legítimo. Um caminho pragmático:

Essa estrutura previne métricas fantasmas e mantém definições estáveis conforme equipes mudam.

Um app de métricas centralizado funciona quando está claro quem pode alterar uma métrica, como mudanças são avaliadas e o que “aprovado” realmente garante. Um modelo simples e confiável é um workflow dirigido por status com permissões explícitas e trilha de auditoria visível.

Draft → Review → Approved → Deprecated deve ser mais que rótulos — cada status deve controlar comportamento:

Trate novas métricas e mudanças como propostas. Uma proposta deve capturar:

Um checklist consistente mantém as revisões rápidas e justas:

Cada transição deve ser registrada: proponente, revisores, aprovador, carimbos de data/hora e um diff do que mudou. Esse histórico permite responder com segurança: “Quando esse KPI mudou e por quê?” Também torna rollbacks mais seguros quando uma definição causa surpresas.

Seu app tem sucesso ou falha dependendo se alguém consegue responder, em menos de um minuto: “Essa métrica é real, está atual e quem a possui?” A UX deve parecer mais com um catálogo de produto bem organizado do que com uma ferramenta de dados.

Comece com uma home do catálogo que permita escaneamento rápido e seleção confiante.

Faça a navegação primária opinativa:

Cada card/linha de métrica deve mostrar o mínimo decisório: nome da métrica, definição curta, badge de status, responsável e data da última atualização. Isso evita que usuários abram várias páginas só para descobrir se uma métrica é utilizável.

Uma página de métrica deve ser legível de cima a baixo como uma ficha técnica:

Mantenha conteúdo técnico recolhível (“Mostrar SQL / detalhes do cálculo”) para que usuários não técnicos não sejam forçados a analisar.

Templates reduzem inconsistência. Use campos obrigatórios (nome, definição, responsável, status, domínio, numerador/denominador ou fórmula) e forneça redações sugeridas como “Contagem de…” ou “Percentual de…”. Preencha exemplos para evitar entradas vagas.

Escreva para clareza: evite siglas em títulos, suporte sinônimos (“Usuários Ativos” vs. “DAU”) e mostre tooltips para jargões inevitáveis. Sempre associe uma métrica a um responsável — pessoas confiam mais em pessoas do que em tabelas.

Se um app de métricas é onde definições se tornam oficiais, controle de acesso não pode ser deixado para depois. Você não está apenas protegendo dados — está protegendo decisões: o que conta como Receita, quem pode mudá-la e quando.

Comece com uma abordagem de login clara e mantenha-a consistente:

Seja qual for a escolha, torne a identidade estável: usuários devem ter um ID único mesmo se o email mudar.

Use controle de acesso baseado em papéis (RBAC) para permissões amplas e adicione propriedade a nível de recurso para precisão.

Um modelo simples:

Depois, adicione regras de propriedade como “Apenas o responsável pela métrica (ou aprovador do domínio) pode editar a definição aprovada.” Isso evita edições pontuais ao mesmo tempo que permite colaboração.

Algumas ações devem exigir verificações mais fortes porque alteram confiança:

Salvaguardas práticas: diálogos de confirmação com texto de impacto claro, motivos obrigatórios para mudanças e (para ações sensíveis) reautenticação ou aprovação de um admin.

Adicione uma área de admin que suporte operações reais:

Mesmo que seu primeiro release seja pequeno, desenhar esses controles cedo evita exceções desordenadas depois — e torna a governança previsível em vez de política.

Quando uma métrica muda, a confusão se espalha mais rápido que a atualização. Um app de métricas centralizado deve tratar cada definição como um lançamento de produto: versionada, revisável e fácil de reverter (pelo menos conceptualmente) se algo der errado.

Crie uma nova versão sempre que algo que possa afetar a interpretação mudar — texto da definição, lógica de cálculo, dados incluídos/excluídos, propriedade, limites ou até o nome. “Edição menor” e “edição maior” podem existir, mas ambos devem ser capturados como versões para que se possa responder: Qual definição usamos quando tomamos aquela decisão?

Uma regra prática: se um stakeholder pode perguntar “essa métrica mudou?”, ela merece uma nova versão.

Cada página de métrica deve incluir uma linha do tempo clara que mostre:

As aprovações devem estar ligadas à versão exata que autorizaram.

Muitas métricas precisam de definições que mudam em um ponto específico do tempo (novo preço, nova embalagem de produto, política revisada). Suporte datas de vigência para que o app mostre:

Isso evita reescrever o passado e ajuda analistas a alinharem períodos de relatório corretamente.

Depreciação deve ser explícita, não silenciosa. Quando uma métrica é depreciada:

Feito corretamente, a depreciação reduz KPIs duplicados preservando contexto para dashboards antigos e decisões passadas.

Um app de métricas centralizado só vira fonte de verdade quando se encaixa em como as pessoas já trabalham: dashboards em BI, consultas no warehouse e aprovações no chat. Integrações transformam definições em algo que as equipes confiam e reutilizam.

A página da métrica deve responder uma pergunta simples: “Onde esse número é usado?” Adicione uma integração BI que permita vincular uma métrica a dashboards, relatórios ou tiles específicos.

Isso cria rastreabilidade bidirecional:

/bi/dashboards/123 se você armazenar referências internas).A vantagem prática é auditorias mais rápidas e menos debates: quando um dashboard parece errado, as pessoas verificam a definição em vez de relitigá-la.

A maioria das divergências começa na query. Torne a conexão com o warehouse explícita:

Não é necessário executar queries no app no começo. Mesmo SQL estático mais lineage dá aos revisores algo concreto para validar.

Roteamento por email atrasa tudo. Publique notificações no Slack/Teams para:

Inclua um deep link de volta à página da métrica e a ação específica necessária (revisar, aprovar, comentar).

Uma API permite que outros sistemas tratem métricas como produto, não apenas documento. Priorize endpoints para busca, leitura e status:

Adicione webhooks para que ferramentas reajam em tempo real (ex.: anotar BI quando uma métrica for depreciada). Documente em /docs/api e tenha payloads estáveis para não quebrar automações.

Juntas, essas integrações reduzem conhecimento tribal e mantêm a propriedade de métricas visível onde as decisões acontecem.

Um app de métricas funciona quando definições são consistentes o suficiente para que duas pessoas lendo a mesma métrica cheguem à mesma interpretação. Padrões e checagens de qualidade transformam “uma página com fórmula” em algo que as equipes confiam e reutilizam.

Comece padronizando os campos que toda métrica deve ter:

Torne esses campos obrigatórios no template da métrica, não apenas “recomendados”. Se uma métrica não atende ao padrão, ela não está pronta para publicar.

A maioria das discordâncias acontece nas bordas. Adicione uma seção dedicada a “Casos de borda” com prompts para:

Adicione campos estruturados de validação para que usuários saibam quando a métrica está saudável:

Antes da aprovação, exija um checklist como:

O app deve bloquear submissão ou aprovação até que todos os itens obrigatórios passem, transformando qualidade de orientação em fluxo de trabalho.

Um catálogo de métricas só funciona quando se torna o primeiro local para “O que esse número significa?” Adoção é problema de produto, não só de governança: é preciso valor claro para usuários diários, caminhos de baixa fricção para contribuir e resposta visível de responsáveis.

Instrumente sinais simples que mostram se as pessoas realmente confiam no catálogo:

Use esses sinais para priorizar melhorias. Por exemplo, alta taxa de “sem resultados” frequentemente indica nomenclatura inconsistente ou sinônimos ausentes — conserte com templates e curadoria.

Pessoas confiam mais em definições quando podem fazer perguntas no contexto. Adicione feedback leve onde a confusão acontece:

Encaminhe feedback ao responsável e ao curador, e mostre status (“triado”, “em revisão”, “aprovado”) para que usuários vejam progresso em vez de silêncio.

Adoção emperra quando usuários não sabem contribuir com segurança. Forneça dois guias proeminentes e linke-os do estado vazio e da navegação:

Mantenha essas páginas vivas (ex.: /docs/adding-a-metric e /docs/requesting-changes).

Agende uma reunião semanal (30 minutos é suficiente) com responsáveis e curadores para:

Consistência é o motor da adoção: respostas rápidas geram confiança, e confiança gera uso repetido.

Segurança para um app de propriedade de métricas não é só evitar vazamentos — é manter o catálogo confiável e seguro para compartilhamento cotidiano. O ponto chave é ser claro sobre o que pertence no sistema, o que não pertence, e como mudanças são registradas.

Trate o app como fonte da verdade para significado, não repositório de fatos brutos.

Armazene com segurança:

/dashboards/revenue)Evite armazenar:

Quando equipes quiserem exemplos, use exemplos sintéticos (“Pedido A, Pedido B”) ou agregados (“total da semana passada”) com rótulos claros.

Você vai querer trilha de auditoria para compliance e responsabilidade, mas logs podem vazar dados acidentalmente.

Logue:

Não logue:

Defina retenção por política (por exemplo, 90–180 dias para logs padrão; mais longo para eventos de auditoria) e separe eventos de auditoria de logs de debug.

Expectativas mínimas:

Comece com um piloto de domínio (ex.: Receita ou Aquisição) e 1–2 times. Defina métricas de sucesso como “% de dashboards vinculados a métricas aprovadas” ou “tempo para aprovar um novo KPI”. Itere nos pontos de atrito e depois expanda domínio por domínio com treinamento leve e expectativa clara: se não está no catálogo, não é métrica oficial.

Se for transformar isso em uma ferramenta interna real, o caminho mais rápido costuma ser lançar uma versão fina mas completa — navegação do catálogo, páginas de métrica, RBAC e fluxo de aprovação — e iterar.

Times frequentemente usam Koder.ai para colocar essa primeira versão no ar rapidamente: você descreve o app em chat, usa o Planning Mode para travar escopo e gera uma stack funcional (React no frontend; Go + PostgreSQL no backend). A partir daí, snapshots e rollback ajudam a iterar com segurança, e exportação de código mantém você livre para levar o código ao pipeline de engenharia existente. Deploy/hosting e domínios customizados são úteis para rollouts internos, e os planos facilitam começar pequeno e escalar governança conforme a adoção cresce.

Métricas centralizadas significa que existe um único lugar compartilhado e aprovado para definir KPIs — tipicamente um catálogo de métricas/dicionário de KPIs — para que as equipes não mantenham versões conflitantes.

Na prática, cada métrica tem:

Comece fazendo um inventário dos KPIs que aparecem em reuniões executivas, relatórios financeiros e principais dashboards, e compare as definições lado a lado.

Sinais comuns de problema:

A maioria das equipes cobre bem os casos com estes objetos:

Pense em campos que respondam: O que é? Como é calculada? Quando devo usá-la?

Um conjunto “obrigatório” prático:

Use um fluxo orientado por status que controle o que é editável e o que é “oficial”:

Armazene também um registro de proposta que capture .

Defina papéis claros e vincule-os a permissões:

Versione sempre que uma mudança puder alterar a interpretação (definição, lógica, filtros, granularidade, limites, até renomeações).

Inclua um changelog legível:

Suporte datas de vigência para mostrar definições atuais, futuras e passadas sem reescrever a história.

Use RBAC + propriedade a nível de recurso:

Adicione atrito extra para ações sensíveis à confiança (publicar/aprovar, depreciar/excluir, mudar propriedade/permissões) com prompts de confirmação e motivo obrigatório.

Comece com integrações que reduzam o atrito diário:

Trate adoção como lançamento de produto:

Para segurança, armazene definições e metadados, não dados brutos de clientes nem segredos. Mantenha logs de auditoria para mudanças/aprovações, políticas de retenção e backups com testes de restauração.

Modele as relações explicitamente (por exemplo, dashboards usam muitas métricas; métricas dependem de múltiplas fontes).

Faça de “métrica sem responsável” um estado de primeira classe com regras de escalonamento (sugestão automática → time-box → escalar ao líder de governança).