Antes de rastrear qualquer coisa, decida o que “adoção de recurso” realmente significa para seu produto. Se você pular este passo, vai coletar muitos dados — e ainda assim discutir em reuniões sobre o que isso “significa”.

Defina “adoção” em termos simples

A adoção normalmente não é um momento único. Escolha uma ou mais definições que correspondam a como o valor é entregue:

- Uso: um usuário experimenta o recurso pelo menos uma vez (bom para lançamentos novos).

- Uso repetido: o usuário o usa novamente dentro de uma janela de tempo (bom para fluxos que formam hábito).

- Valor alcançado: o usuário atinge um resultado que o recurso foi projetado para permitir (frequentemente o melhor sinal).

Exemplo: para “Saved Searches”, adoção pode ser criou uma busca salva (uso), executou 3+ vezes em 14 dias (repetição) e recebeu um alerta e clicou (valor alcançado).

Liste as decisões que seu rastreamento deve suportar

Seu rastreamento deve responder perguntas que levem a ação, como:

- O que devemos melhorar porque é usado mas não entrega valor?

- O que devemos aposentar porque adiciona complexidade com baixa adoção?

- O que devemos promover porque aumenta retenção ou upgrades?

Escreva isso como declarações de decisão (ex.: “Se a ativação cair após o release X, revertamos mudanças de onboarding.”).

Identifique stakeholders e como usarão os relatórios

Times diferentes precisam de visões diferentes:

- Produto (PM): adoção por segmento, impacto pós-release, milestones de valor.

- Growth/Marketing: lift de campanhas, funis de conversão, reengajamento.

- Suporte/Success: quais recursos correlacionam com menos tickets ou maiores renovações.

- Engenharia: saúde da instrumentação, mudanças no volume de eventos, marcadores de release.

Defina métricas de sucesso e cadência

Escolha um pequeno conjunto de métricas para revisar semanalmente, além de uma checagem rápida após cada deployment. Defina thresholds (ex.: “Taxa de adoção ≥ 25% entre usuários ativos em 30 dias”) para que os relatórios gerem decisões, não debate.

Mapeie os dados que você precisa: usuários, recursos, eventos, resultados

Antes de instrumentar, decida quais “coisas” seu sistema de analytics vai descrever. Se você acertar essas entidades, seus relatórios ficarão compreensíveis mesmo com a evolução do produto.

Defina cada entidade em linguagem simples e depois traduza em IDs que você pode armazenar:

- User: uma pessoa usando o app (pode começar anônima e depois se autenticar).

- Account / workspace: o cliente pagante ou container de time que vários usuários pertencem.

- Session: uma visita limitada no tempo (útil para engajamento e troubleshooting; opcional para alguns produtos).

- Feature: uma capacidade nomeada que você quer medir adoção (frequentemente um grupo de eventos, não um único clique).

- Event: uma ação ou ocorrência do sistema que você pode registrar (ex.:

project_created, invite_sent).

- Outcome: o milestone de valor que você quer que usuários/contas alcancem (ex.: “primeiro relatório compartilhado”, “assinatura ativada”).

Anote as propriedades mínimas necessárias para cada evento: user_id (ou anonymous ID), account_id, timestamp e alguns atributos relevantes (plano, papel, dispositivo, feature flag, etc.). Evite despejar tudo “só por precaução”.

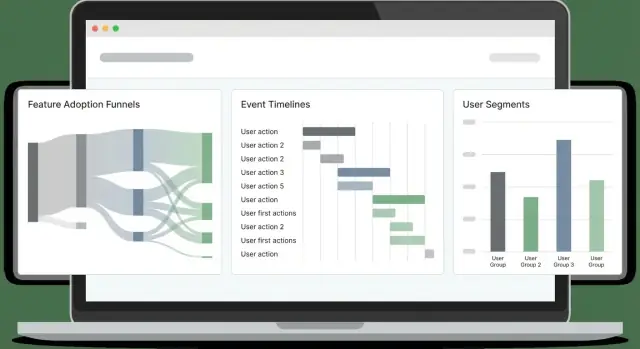

Escolha as visões de adoção que você vai suportar

Escolha os ângulos de relatório que correspondem aos objetivos do seu produto:

- Funis (ativação passo a passo)

- Coortes (grupos por data de cadastro, plano, canal)

- Retenção (eles voltam e repetem ações-chave?)

- Paths (sequências comuns antes/depois de um milestone)

- Tempo-para-primeiro-valor (quanto tempo até o primeiro outcome significativo)

Seu design de eventos deve facilitar esses cálculos.

Seja explícito sobre escopo: só web primeiro, ou web + mobile desde o dia 1. O rastreamento cross-platform fica mais fácil se você padronizar nomes de eventos e propriedades cedo.

Por fim, defina metas não negociáveis: impacto aceitável na performance de página, latência de ingestão (quão frescos os dashboards devem ser) e tempo de carregamento dos dashboards. Essas restrições guiarão escolhas posteriores em rastreamento, armazenamento e consultas.

Desenhe um esquema de rastreamento de eventos que se mantenha consistente

Um bom esquema de rastreamento é menos sobre “rastrear tudo” e mais sobre tornar eventos previsíveis. Se nomes e propriedades derivam, dashboards quebram, analistas deixam de confiar nos dados e engenheiros hesitam em instrumentar novos recursos.

Escolha um padrão simples e repetível e siga-o. Uma escolha comum é verb_noun:

viewed_pricing_pagestarted_trialenabled_featureexported_report

Use tempo passado consistentemente (ou presente consistentemente) e evite sinônimos (clicked, pressed, tapped) a menos que realmente signifiquem coisas diferentes.

Defina propriedades obrigatórias (o “contrato”)

Todo evento deve carregar um pequeno conjunto de propriedades obrigatórias para que você possa segmentar, filtrar e unir de forma confiável depois. No mínimo, defina:

user_id (nulo para usuários anônimos, mas presente quando conhecido)account_id (se seu produto for B2B/multi-seat)timestamp (gerado no servidor quando possível)feature_key (identificador estável como "bulk_upload")plan (ex.: free, pro, enterprise)

Essas propriedades tornam o rastreamento de adoção e a análise de comportamento do usuário muito mais fáceis porque você não precisa adivinhar o que falta em cada evento.

Campos opcionais adicionam contexto, mas são fáceis de extrapolar. Propriedades opcionais típicas incluem:

device, os, browserpage, referrerexperiment_variant (ou ab_variant)

Mantenha propriedades opcionais consistentes entre eventos (mesmas chaves, mesmos formatos de valor), e documente “valores permitidos” quando possível.

Versione seu esquema e escreva uma especificação de instrumentação

Pressuponha que seu esquema irá evoluir. Adicione um event_version (ex.: 1, 2) e atualize quando mudar significado ou campos obrigatórios.

Por fim, escreva uma especificação de instrumentação que liste cada evento, quando ele dispara, propriedades obrigatórias/opcionais e exemplos. Mantenha esse documento no controle de versão junto com seu app para que mudanças de esquema sejam revisadas como código.

Resolva identidade: anônimo, logado e visões a nível de conta

Se seu modelo de identidade for frágil, suas métricas de adoção ficarão ruidosas: funis desalinhados, retenção pior do que realmente é e “usuários ativos” inflados por duplicatas. O objetivo é suportar três visões ao mesmo tempo: visitantes anônimos, usuários logados e atividade por conta/workspace.

Anônimos vs identificados (e quando vincular)

Inicie cada dispositivo/sessão com um anonymous_id (cookie/localStorage). No momento em que o usuário se autentica, vincule esse histórico anônimo a um identified user_id.

Vincule identidades quando o usuário provar propriedade da conta (login bem-sucedido, verificação por magic link, SSO). Evite vincular com sinais fracos (email digitado em um formulário) a menos que você separe claramente como “pré-auth”.

Login, logout e troca de conta sem quebrar métricas

Trate transições de auth como eventos:

login_success (inclui user_id, account_id e o anonymous_id atual)logoutaccount_switched (de account_id → account_id)

Importante: não troque o cookie anônimo no logout. Se você rotacioná-lo, fragmentará sessões e inflará usuários únicos. Em vez disso, mantenha o anonymous_id estável, mas pare de anexar user_id após logout.

Regras de merge de identidade (e evitar dupla contagem)

Defina regras de merge explicitamente:

- User merge: prefira um

user_id interno estável. Se precisar mesclar por email, faça isso server-side e apenas para emails verificados. Mantenha um rastro de auditoria.

- Account merge: use um

account_id/workspace_id estável gerado pelo seu sistema, não um nome mutável.

Ao mesclar, escreva uma tabela de mapeamento (antigo → novo) e aplique-a consistentemente na hora da query ou via job de backfill. Isso evita que “dois usuários” apareçam em coortes.

Armazene chaves estáveis

Armazene e envie:

anonymous_id (estável por navegador/dispositivo)user_id (estável por pessoa)account_id (estável por workspace)

Com essas três chaves, você pode medir comportamento pré-login, adoção por usuário e adoção por conta sem dupla contagem.

Escolha rastreamento client-side vs server-side (e combine-os)

Onde você rastreia eventos muda o que você pode confiar. Eventos do navegador dizem o que as pessoas tentaram fazer; eventos do servidor dizem o que realmente aconteceu.

Rastreio client-side (navegador)

Use rastreamento client-side para interações de UI e contexto que você só tem no navegador. Exemplos típicos:

- Views de página/tela, cliques em botões, troca de abas, abrir/fechar modais

- “Viu recurso” (ex.: página de configurações aberta)

- Contexto cliente: URL, referrer, tags UTM, tipo de dispositivo, tamanho da viewport, idioma

Agrupe eventos para reduzir chatter de rede: enfileire na memória, envie a cada N segundos ou N eventos, e também envie em visibilitychange/page hide.

Rastreio server-side (APIs e jobs)

Use server-side para qualquer evento que represente um outcome concluído ou uma ação sensível para billing/segurança:

- Recurso habilitado/desabilitado salvo com sucesso

- Convite aceito, pagamento sucedido, export gerado

- Jobs em background: sync finalizado, relatório entregue, email enviado

O rastreamento server-side costuma ser mais preciso porque não é bloqueado por ad blockers, recargas de página ou conectividade instável.

Abordagem recomendada: híbrida por padrão

Um padrão prático é: rastreie intenção no cliente e sucesso no servidor.

Por exemplo, emita feature_x_clicked_enable (cliente) e feature_x_enabled (servidor). Em seguida, enriqueça eventos do servidor com contexto do cliente passando um context_id (ou request ID) do navegador para a API.

Confiabilidade: retries, backoff, buffer offline

Adicione resiliência onde eventos têm mais chance de cair:

- Cliente: persista uma fila pequena em

localStorage/IndexedDB, tente novamente com backoff exponencial, limite retries e dedupe por event_id.

- Servidor: retry em falhas transitórias, use uma fila interna e garanta idempotência para que um retry não conte duas vezes.

Essa mistura oferece detalhe comportamental rico sem sacrificar métricas de adoção confiáveis.

Planeje a arquitetura do sistema: ingestão, armazenamento e consulta

Rastreie web e mobile

Crie apps web e mobile juntos para que os nomes de eventos permaneçam consistentes entre plataformas.

Um app de analytics de adoção de recursos é basicamente um pipeline: capture eventos de forma confiável, armazene-os de forma econômica e consulte-os rápido o suficiente para que as pessoas confiem e usem os resultados.

Componentes centrais (e por que importam)

Comece com um conjunto simples e separável de serviços:

- Collector endpoint: um serviço HTTP pequeno que recebe eventos (do browser, mobile, backend). Mantenha-o rápido e mínimo — valide o básico, adicione timestamps no servidor e responda rapidamente.

- Queue/stream: bufferiza picos de tráfego e desacopla ingestão do processamento (Kafka, Kinesis, Pub/Sub, SQS).

- Workers: consomem o stream para enriquecer, deduplicar, impor schema e rotear dados para armazenamento.

- Analytics store: otimizado para dados de eventos append-only em grande volume (ClickHouse, BigQuery, Snowflake, Redshift).

- API: expõe endpoints de consulta consistentes para dashboards (funis, coortes, retenção) e permissões.

- UI: dashboards e ferramentas de exploração; mantenha separado para que você possa mudar a lógica de storage/query sem reescrever o frontend.

Se quiser prototipar um app web interno rapidamente, uma plataforma vibe-coding como Koder.ai pode ajudar a levantar a UI do dashboard (React) e um backend (Go + PostgreSQL) a partir de uma spec guiada por chat — útil para obter uma “fatia funcional” inicial antes de endurecer o pipeline.

Armazenamento: eventos brutos vs agregados

Use duas camadas:

- Eventos brutos append-only para auditabilidade e reprocessamento. Trate isso como fonte da verdade.

- Agregados/visões materializadas para velocidade (DAU diário por feature, passos de funil, tabelas de coorte). Visões materializadas são úteis quando as mesmas queries rodam constantemente.

Escolha a frescura que seu time realmente precisa:

- Near real-time (segundos/minutos) se você monitora lançamentos, quedas de onboarding ou outages.

- Batch diário para relatórios de tendência, adoção semanal e resumos executivos — mais barato e frequentemente mais simples.

Muitos times fazem ambos: contadores em tempo real para “o que está acontecendo agora” e jobs noturnos que reparam métricas canônicas.

Plano de escalonamento: particionamento e crescimento

Projete para crescimento cedo particionando:

- Por tempo (diário/mensal) para manter queries limitadas e políticas de retenção simples.

- Por conta/tenant para suportar permissões e performance B2B.

- Opcionalmente por tipo de evento se poucos eventos de alto volume dominarem.

Também planeje retenção (ex.: 13 meses brutos, agregados por mais tempo) e um caminho de replay para corrigir bugs reprocessando eventos em vez de remendar dashboards.

Modelagem de dados para eventos e consultas analíticas rápidas

Boa analytics começa com um modelo que responda perguntas comuns rapidamente (funis, retenção, uso de recurso) sem transformar cada query em um projeto de engenharia customizado.

Escolha uma estratégia de banco em duas camadas

A maioria dos times se sai melhor com duas stores:

- Relacional (Postgres/MySQL) para metadados “estáveis” que mudam lentamente: usuários, contas, catálogo de features, controle de acesso e configuração.

- Colunar/warehouse (ClickHouse/BigQuery/Snowflake) para eventos de alto volume, onde você precisa de scans rápidos e agregações.

Essa separação mantém o banco do produto enxuto e torna consultas analíticas mais rápidas e baratas.

Defina tabelas principais (e mantenha-as básicas)

Um baseline prático:

- raw_events: uma linha por evento (event_name, timestamp, user_id/anonymous_id, session_id, account_id, properties JSON, source).

- users: perfil do usuário + identificadores atuais.

- accounts: entidade empresa/organização para rollups B2B.

- feature_catalog: sua lista canônica de features (key, display_name, category, lifecycle status).

- sessions: limites de sessão (start/end, device, referrer) para análise de comportamento.

- aggregates: métricas diárias/semanais pré-computadas (ex.: DAU, feature_active_users, contagens de passos de funil).

No warehouse, desnormalize o que você consulta frequentemente (ex.: copie account_id nos eventos) para evitar joins caros.

Particione raw_events por tempo (diário é comum) e opcionalmente por workspace/app. Aplique retenção por tipo de evento:

- Guarde eventos produto de alto nível por mais tempo (meses/anos).

- Exclua eventos de debug ruidosos rapidamente.

Isso impede que o “crescimento infinito” vire seu maior problema de analytics.

Construa checagens de qualidade de dados no modelo

Trate checagens de qualidade como parte do modelagem, não uma limpeza posterior:

- Propriedades obrigatórias faltando (ex.: feature_key).

- Timestamps ruins (datas no futuro, problemas de parsing de timezone).

- Eventos duplicados (retries, instrumentação dupla).

Armazene resultados de validação (ou uma tabela de eventos rejeitados) para monitorar a saúde da instrumentação e corrigir issues antes que dashboards derivem.

Computar métricas de adoção: funis, coortes, retenção e paths

Reduza seus custos de desenvolvimento

Ganhe créditos compartilhando o que você construiu com Koder.ai ou indicando colegas para experimentar.

Uma vez que seus eventos fluem, o próximo passo é transformar cliques brutos em métricas que respondam: “Esse recurso está realmente sendo adotado, e por quem?” Foque em quatro visões que funcionam juntas: funis, coortes, retenção e paths.

Funis: adoção como sequência (não um único clique)

Defina um funil por recurso para ver onde os usuários abandonam. Um padrão prático:

- Descoberta → o usuário vê o ponto de entrada do recurso (botão, item de menu, banner)

- Primeiro uso → a primeira interação significativa (ex.:

feature_used)

- Uso repetido → um segundo uso dentro de uma janela razoável (ex.: 7 dias)

- Ação de valor → o outcome que prova valor (export gerado, automação habilitada, relatório compartilhado)

Mantenha passos de funil atrelados a eventos confiáveis e nomeie-os consistentemente. Se “primeiro uso” puder ocorrer de várias formas, trate-o como um passo com condições OR (ex.: import_started OR integration_connected).

Coortes ajudam a medir melhoria ao longo do tempo sem misturar usuários antigos e novos. Coortes comuns incluem:

- Novos usuários por semana (semana de signup)

- Usuários ativados (alcançaram o evento de ativação)

- Usuários retidos (retornaram e fizeram algo significativo)

- Power users (alta frequência ou ações avançadas)

Acompanhe taxas de adoção dentro de cada coorte para ver se onboarding ou mudanças de UI recentes estão ajudando.

Retenção: “eles voltam e continuam usando?”

Retenção é mais útil quando vinculada a um recurso, não só a “aberturas do app”. Defina como repetir o evento central do recurso (ou ação de valor) no Dia 7/30. Também acompanhe “tempo até o segundo uso” — frequentemente mais sensível que retenção bruta.

Segmentação e paths: quem adota e como chegam lá

Quebre métricas por dimensões que expliquem comportamento: plano, papel, indústria, dispositivo e canal de aquisição. Segmentos frequentemente revelam que a adoção é forte para um grupo e quase inexistente para outro.

Adicione análise de paths para encontrar sequências comuns antes e depois da adoção (ex.: usuários que adotam costumam visitar pricing, depois docs, depois conectam uma integração). Use isso para refinar prompts de onboarding e remover caminhos mortos.

Construa dashboards que as pessoas realmente usem

Dashboards falham quando tentam servir a todos com uma “visão mestre”. Em vez disso, desenhe um pequeno conjunto de páginas focadas que correspondam a como diferentes pessoas tomam decisões, e faça cada página responder a uma pergunta clara.

Uma visão executiva deve ser um check rápido de saúde: tendência de adoção, usuários ativos, top features e mudanças notáveis desde o último release. Uma página de deep dive do recurso deve ser pensada para PMs e engenheiros: onde os usuários começam, onde abandonam e que segmentos se comportam diferente.

Uma estrutura simples que funciona bem:

- Overview: tendência de adoção, tendência de retenção e alguns KPIs principais

- Feature page: funil, retenção por coorte e frequência de uso para um recurso

- Segment explorer: compare planos, regiões ou tamanhos de workspace lado a lado

Facilite a exploração (sem bagunçar)

Inclua gráficos de tendência para o “o quê”, quebras por segmento para o “quem” e drill-down para o “porquê”. O drill-down deve permitir clicar em uma barra/ponto e ver usuários ou workspaces de exemplo (com permissões adequadas), assim times validam padrões e investigam sessões reais.

Mantenha filtros consistentes entre páginas para que usuários não precisem reaprender controles. Filtros mais úteis para rastreamento de adoção de recurso:

- Intervalo de datas

- Plano / tier

- Atributos da workspace/conta (tamanho, indústria)

- Região

- Versão do app (ou canal de release)

Compartilhamento, exportações e views salvas

Dashboards viram parte do fluxo de trabalho quando as pessoas podem compartilhar exatamente o que veem. Adicione:

- Export para CSV para análise rápida em planilhas

- Share com uma view salva linkável (filtros + estado dos gráficos + segmento selecionado)

- Emails/Slack agendados opcionais que apontem para a view salva

Se você está construindo isso dentro de um app de analytics, considere uma página /dashboards com “Pinned” saved views para que stakeholders sempre caiam nos poucos relatórios que importam.

Adicione alertas, detecção de anomalias e marcadores de release

Dashboards são ótimos para exploração, mas times geralmente percebem problemas quando um cliente reclama. Alertas invertem isso: você sabe de uma quebra minutos depois, e pode ligar ao que mudou.

Defina regras de alerta que correspondam a modos reais de falha

Comece com alguns alertas de alto sinal que protejam seu fluxo de adoção principal:

- Queda súbita no primeiro uso (ex.: eventos “Feature X: first_use” por hora caem 40% vs baseline). Indica regressão de UI, mudança de permissões ou bug de tracking.

- Pico de erros (erros cliente, API 4xx/5xx, ou eventos

feature_failed). Inclua thresholds absolutos e baseados em taxa (erros por 1.000 sessões).

- Eventos ausentes após um release (contagem do evento vai a quase zero). Isso pega instrumentação quebrada rapidamente — especialmente após refactors.

Mantenha definições de alerta legíveis e versionadas (até um YAML no repo) para que não vire conhecimento tribal.

Detecção de anomalias: mantenha simples no começo

Detecção básica de anomalias pode ser muito eficaz sem ML sofisticado:

- Compare valores atuais a uma média móvel (ex.: últimos 7 dias, mesma hora do dia).

- Adicione consciência de sazonalidade onde importa (dias da semana vs fim de semana, horário comercial vs noturno).

- Use uma regra de volume mínimo para que métricas de baixo tráfego não spamem.

Marcadores de release: uma linha do tempo do “o que mudou?”

Adicione uma stream de marcadores de release diretamente nos gráficos: deploys, rollouts de feature flags, mudanças de pricing, ajustes de onboarding. Cada marcador deve incluir timestamp, dono e uma nota curta. Quando métricas mudarem, você verá causas prováveis imediatamente.

Roteamento, horários de silêncio e propriedade

Envie alertas por email e canais tipo Slack, mas suporte quiet hours e escalonamento (aviso → page) para issues severas. Todo alerta precisa de um dono e um link para um runbook (mesmo que curto /docs/alerts) descrevendo o que checar primeiro.

Privacidade, consentimento e controle de acesso

Mantenha a propriedade total do código

Gere, revise e exporte o código-fonte para que sua equipe possa assumir a pipeline a longo prazo.

Dados analíticos rapidamente viram dados pessoais se você não tiver cuidado. Trate privacidade como parte do design de rastreamento: reduz risco, constrói confiança e evita retrabalho doloroso.

Consentimento: colete só o que usuários aceitarem

Respeite requisitos de consentimento e permita que usuários optem por não participar quando necessário. Na prática, isso significa que sua camada de rastreamento deve checar uma flag de consentimento antes de enviar eventos, e deve ser capaz de parar de rastrear no meio de uma sessão se o usuário mudar de ideia.

Para regiões com regras estritas, considere recursos “consent-gated":

- Carregue bibliotecas de analytics só após consentimento (não apenas “parar de enviar”).

- Armazene a decisão de consentimento com timestamp e versão, para provar o que o usuário aceitou.

- Forneça uma UI simples de preferências nas configurações do app.

Minimize dados sensíveis (e mantenha-os fora dos eventos)

Minimize dados sensíveis: evite emails crus nos eventos; use IDs hashed/opaque. Payloads de evento devem descrever comportamento (o que aconteceu), não identidade (quem é a pessoa). Se precisar relacionar eventos a uma conta, envie user_id/account_id internos e mantenha o mapeamento no seu banco com controles de segurança apropriados.

Também evite coletar:

- Campos de texto livre (frequentemente contêm informações pessoais acidentais)

- URLs completas que possam incluir tokens ou query params

- Qualquer coisa que você não gostaria de ver em uma captura de tela

Seja transparente: documentação e página clara de privacidade

Documente o que você coleta e por quê; linke para uma página de privacidade clara. Crie um “dicionário de tracking” leve que explique cada evento, seu propósito e período de retenção. No UI do produto, linke para /privacy e mantenha-o legível: o que você rastreia, o que não rastreia e como optar por sair.

Controle de acesso: limite quem vê dados a nível de usuário

Implemente controle baseado em papéis para que apenas times autorizados vejam dados a nível de usuário. A maioria só precisa de dashboards agregados; reserve views brutas para um grupo pequeno (ex.: data/product ops). Adicione logs de auditoria para exports e buscas por usuário, e defina limites de retenção para que dados antigos expirem automaticamente.

Feito corretamente, controles de privacidade não atrapalham a análise — tornam o sistema mais seguro, claro e fácil de manter.

Plano de rollout, QA e manutenção de longo prazo

Deployar analytics é como deployar um recurso: comece pequeno e verificável, depois itere. Trate trabalho de tracking como código de produção com donos, revisões e testes.

Inicie com um conjunto enxuto de golden events para uma área de recurso (ex.: Feature Viewed, Feature Started, Feature Completed, Feature Error). Eles devem mapear diretamente às perguntas que o time fará semanalmente.

Mantenha o escopo propositalmente estreito: menos eventos significa validar qualidade rapidamente e aprender quais propriedades você realmente precisa (plano, papel, origem, variante) antes de escalar.

Valide rastreamento em staging e produção

Use um checklist antes de considerar o rastreamento “pronto”:

- Evento dispara uma vez (sem double-tracking em refresh, retries ou SPA route changes)

- Propriedades obrigatórias presentes e tipadas consistentemente

- PII excluída ou mascarada corretamente

- Eventos recebidos dentro da latência esperada

- Identidades vinculam corretamente (anonymous → logado)

Adicione queries de amostra que você possa rodar em staging e produção. Exemplos:

- “Count events by name in the last 30 minutes” (detectar eventos faltando/extras)

- “Top 20 property values for

feature_name” (pegar typos como Search vs search)

- “Completion rate = Completed / Started by app version” (detectar regressões de release)

Workflow de QA de instrumentação para cada release

Faça instrumentação parte do processo de release:

- Mudança de tracking no mesmo PR que a mudança de UI/API

- Revisor checa nomes/propriedades contra seu schema

- QA verifica eventos em staging com uma conta de teste conhecida

- Nota de release inclui mudanças de tracking (novos eventos, propriedades renomeadas)

Manutenção de longo prazo (schema, backfills, docs)

Planeje mudanças: depreque eventos em vez de deletá-los, versione propriedades quando o significado mudar e agende auditorias periódicas.

Quando adicionar uma propriedade obrigatória nova ou corrigir um bug, decida se precisa de um backfill (e documente a janela de tempo onde os dados ficaram parciais).

Por fim, mantenha um guia leve de tracking na sua documentação e linke-o de dashboards e templates de PR. Um bom ponto de partida é uma checklist curta como /blog/event-tracking-checklist.