Defina o trabalho do assistente e o escopo do MVP

Um “aplicativo assistente pessoal” pode ser qualquer coisa, desde uma lista de tarefas incrementada até uma ferramenta que negocia conflitos de calendário e rascunha e-mails. Se você não definir o trabalho com precisão, acabará construindo uma demonstração de chat que impressiona, mas não ajuda ninguém na segunda-feira de manhã.

Comece nomeando seu público e sua dor recorrente. Um fundador pode querer preparação rápida para reuniões e follow-ups; um estudante pode querer planos de estudo e captura de notas; um gerente de operações pode querer triagem de tarefas e resumos diários. Quanto mais claro o público, mais fácil decidir quais ferramentas seu assistente precisa — e quais ele definitivamente não precisa.

Escolha 1–2 jornadas que provem valor

Seu MVP deve entregar um resultado útil em uma única sessão curta. Uma regra prática é que o usuário obtenha valor dentro de 60–120 segundos ao abrir o app.

Duas jornadas iniciais confiáveis são:

- Capturar → organizar: Adicionar uma tarefa/nota com contexto, confirmar que foi salva corretamente e então vê-la em uma lista simples.

- Resumir → decidir: Gerar um plano/resumo diário a partir de itens salvos, permitindo que o usuário aceite, edite ou reagende.

Observe o que está faltando: onboarding longo, configurações complicadas ou integrações profundas. Você ainda pode simular uma experiência de “assistente” fazendo a interação parecer conversacional enquanto mantém as ações subjacentes determinísticas.

Defina non-goals (e escreva-os)

Muitos apps de assistente falham ao tentar fazer tudo no primeiro dia: voz, sincronização completa de e-mail, acesso de escrita ao calendário, ações autônomas multi-etapa e configurações complexas de agentes. Faça non-goals explícitos para o MVP — sem entrada por voz, sem integração de e-mail bidirecional, sem execução autônoma em segundo plano e sem sincronização entre dispositivos além de contas básicas. Isso mantém o produto honesto e reduz risco de segurança e privacidade no início.

Escolha métricas de sucesso que correspondam ao trabalho

Não meça o MVP por “número de chats”. Meça por resultados:

- Tempo-para-primeiro-resultado-útil: quão rápido os usuários obtêm uma tarefa salva ou um resumo utilizável.

- Qualidade: com que frequência tarefas/datas extraídas estão corretas e com que frequência os usuários editam.

- Retenção: se os usuários retornam no dia seguinte para capturar ou revisar.

Se você estiver vibe-coding em uma plataforma como Koder.ai, jornadas claras e métricas também tornam a velocidade de construção real: você pode escopar as primeiras telas React/Flutter e endpoints Go/PostgreSQL em torno de dois loops principais, depois iterar usando snapshots e rollback quando mudanças não melhoram os resultados.

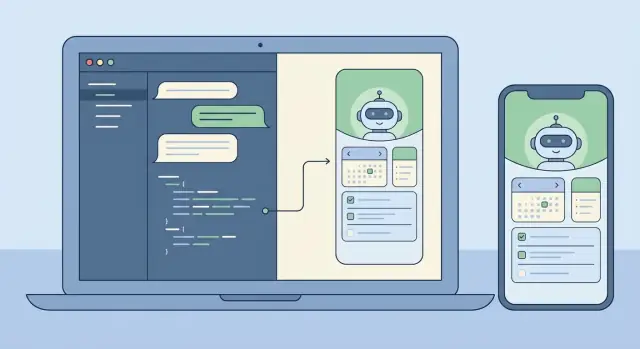

Design de Produto: fluxos de UX que parecem um assistente

Um aplicativo assistente pessoal vence ou perde pela sensação da interação. Os usuários devem ter a impressão de que o app entende a intenção, oferece o próximo passo útil e fica fora do caminho quando eles só querem uma resposta rápida.

A maioria dos assistentes ganha confiança fazendo alguns trabalhos centrais de forma consistente: entender pedidos, armazenar “memória” (preferências e fatos leves de perfil), gerenciar tarefas e lembretes, e gerar resumos rápidos (notas, reuniões ou mensagens longas). O design de produto é tornar essas capacidades óbvias sem transformar o app em um labirinto.

Uma regra útil: toda capacidade do assistente deve ter (1) um caminho conversacional (por exemplo, “me lembre amanhã às 9”) e (2) uma superfície de UI visível para revisão e edição (uma lista de lembretes que você pode escanear).

Escolha um estilo de interação: chat-first vs UI-first

Chat-first funciona melhor quando seu público valoriza velocidade e flexibilidade: um editor, histórico de mensagens e alguns atalhos inteligentes.

UI-first com chat como auxiliar funciona melhor quando os usuários gerenciam muitos itens e precisam de estrutura. Nesse modelo, o app abre em “Tarefas” ou “Hoje”, e o chat é uma ferramenta contextual para mudanças (por exemplo, “mover tudo que vence hoje para amanhã”).

Você não precisa escolher para sempre, mas deve definir uma tela inicial padrão e um modelo mental padrão cedo.

Projete segurança no fluxo (confirmar + desfazer)

Assistentes frequentemente tomam ações que parecem irreversíveis: excluir uma nota, enviar uma mensagem, cancelar algo ou editar muitas tarefas de uma vez. Trate-as como ações arriscadas. O UX deve usar uma etapa clara de confirmação com um resumo em linguagem simples do que vai ocorrer, além de um desfazer imediato após a conclusão.

Um padrão forte é: pré-visualizar → confirmar → executar → desfazer. A pré-visualização é onde o usuário percebe erros (“Enviar para Alex?” “Excluir 12 tarefas?”).

Esboce o conjunto mínimo de telas

Mantenha a primeira versão pequena e coerente. Um mínimo prático é: onboarding (o que pode fazer + permissões), chat, tarefas/lembretes, memória (o que sabe, com editar/excluir), configurações (notificações, tom, privacidade) e uma visão leve de histórico/auditoria.

Se você estiver vibe-coding isso (por exemplo, em Koder.ai), essas telas mapeiam bem para um MVP que você pode gerar rapidamente e depois refinar testando fluxos reais como “capturar uma tarefa”, “definir um lembrete” e “desfazer um erro”.

Prompting e design de comportamento (sem over-engineering)

Um bom assistente parece consistente, previsível e seguro — mais como um colega útil do que um gerador de texto aleatório. Você chega lá mais rápido mantendo prompts simples, em camadas e testáveis.

Use uma hierarquia clara de mensagens

Trate seus prompts como três camadas, cada uma com um propósito diferente:

- Instruções de sistema definem identidade e inegociáveis (tom, segurança, postura de privacidade, como lidar com incerteza).

- Regras do desenvolvedor definem comportamento do produto (recursos suportados, regras de uso de ferramentas, contratos de formato de saída, o que logar).

- Mensagens do usuário são os pedidos que mudam.

Essa separação evita que uma solicitação do usuário (“ignore instruções anteriores”) sobrescreva acidentalmente como seu assistente deve se comportar.

Defina limites (e permissões) das ferramentas

Seu assistente será mais confiável se souber exatamente quando pode agir e quando deve perguntar. Decida quais operações são somente leitura (seguras para executar automaticamente, como buscar notas), quais são ações de escrita (criar/atualizar tarefas, agendar lembretes) e quais são irreversíveis ou caras (excluir dados, contatar serviços externos, compartilhar informação).

Para ações de escrita e irreversíveis, exija confirmação: o modelo propõe um plano de ação, depois espera aprovação explícita.

Prefira saídas estruturadas para ações

Quando o modelo precisa criar uma tarefa ou lembrete, texto plano é frágil. Use objetos de ação em JSON e valide-os antes de executar. Exija campos como action, title, due_at, priority e timezone, e rejeite ou re-pergunte quando algo estiver faltando. Isso mantém seu backend determinístico mesmo quando a redação do modelo varia.

Adicione guardrails leves

Guardrails não precisam ser complicados. Adicione uma política curta para pedidos sensíveis (autolesão, atividade ilegal, acesso a dados privados) e defina padrões de recusa que ainda soem úteis: reconhecer, recusar e oferecer alternativas seguras. Instrua também o modelo a dizer “não sei” quando faltar informação, e a fazer uma pergunta de clarificação em vez de chutar.

Construa uma pequena biblioteca de prompts

Em vez de um mega-prompt, mantenha um pequeno conjunto de comportamentos reutilizáveis que seu assistente pode “chamar” internamente: resumir uma conversa em próximas ações, rascunhar um plano com suposições e questões abertas, checar um pedido por detalhes faltantes, reescrever uma mensagem em um tom específico e extrair tarefas/eventos em JSON. Esse é o ponto ideal: comportamento consistente, fácil de testar e sem espaguete de prompts.

LLM + Ferramentas + Agentes: uma arquitetura prática

Um assistente pessoal parece “inteligente” quando faz duas coisas bem: conversar naturalmente e executar ações confiáveis. O caminho mais rápido é separar conversa (raciocínio do LLM) de execução (ferramentas que chamam seus sistemas reais).

Dois padrões factíveis

Para um MVP, comece com um padrão LLM único + ferramentas: um modelo recebe a mensagem do usuário, decide responder em texto ou chamar uma ferramenta, e então retorna um resultado. Isso é mais simples de depurar e frequentemente suficiente para captura de tarefas, busca de notas e lembretes.

À medida que as capacidades crescem, um padrão coordenador + agentes especialistas torna-se útil. Um coordenador interpreta o pedido e delega a especialistas (por exemplo, um agente de Tarefas vs um agente de Notas), cada um com instruções mais estreitas e menos ferramentas. Isso reduz uso indevido de ferramentas e melhora consistência ao adicionar integrações.

Ferramentas: as mãos do assistente

Ferramentas são APIs pequenas e determinísticas que o assistente pode invocar. Mantenha entradas estritas e saídas estruturadas para validar e logar o que aconteceu.

Ferramentas comuns incluem criar/atualizar/concluir tarefas, busca de notas (palavra-chave + filtros de tempo), agendamento de lembretes (hora, canal, recorrência), consulta de preferências (fuso horário, horário de trabalho), leitura de agenda opcional (se tiver integração de calendário) e gravação de eventos de auditoria.

Modo de planejamento antes de agir

Antes de executar, adicione uma etapa explícita de modo de planejamento: o modelo escreve um plano curto e então seleciona ferramentas para executá-lo. Planejamento ajuda em pedidos multi-etapa como “Mover minhas tarefas de projeto para a próxima semana e me lembrar na segunda”, onde o assistente deve confirmar suposições (fuso horário, o que conta como “tarefas de projeto”) antes de agir.

Aprovação de ação para evitar surpresas

Qualquer ferramenta que cause efeitos colaterais (criar tarefas, enviar lembretes, alterar dados) deve passar por um portão de aprovação de ação. Na prática, o modelo propõe um rascunho de ação (nome da ferramenta + parâmetros + resultado pretendido) e seu app pede ao usuário para confirmar ou editar. Esse único checkpoint reduz dramaticamente mudanças não intencionais e faz o assistente parecer confiável.

Se você usar uma plataforma de vibe-coding como Koder.ai, pode implementar essa arquitetura rapidamente gerando interfaces de ferramenta, lógica de coordenador e UI de aprovação como componentes separados e testáveis — depois iterar via snapshots e rollback ao refinar comportamento.

Memória e contexto: o que salvar, o que recuperar

Um assistente pessoal parece “esperto” quando lembra as coisas certas e esquece o resto. O truque é separar o que o modelo precisa para coerência do que você armazena para o usuário. Se você armazenar tudo, aumenta risco de privacidade e ruído na recuperação. Se não armazenar nada, o assistente fica repetitivo e frágil.

Memória de curto prazo vs longo prazo

Trate a conversa recente como memória de curto prazo: uma janela rolante das últimas trocas mais o objetivo atual. Mantenha-a enxuta — resuma agressivamente — para não pagar tokens desnecessários ou amplificar erros antigos.

Memória de longo prazo é para fatos que devem sobreviver a sessões: preferências, detalhes estáveis de perfil, tarefas e notas que o usuário espera revisitar. Armazene isso primeiro como dados estruturados (tabelas, campos, timestamps) e use trechos em texto livre apenas quando não for possível representar cleanly.

O que vale a pena salvar

Um ponto de partida prático é salvar informações que são autoradas ou aprovadas pelo usuário: perfil e preferências (fuso horário, horário de trabalho, tom, lembretes padrão), tarefas e projetos (status, datas de vencimento, recorrência, prioridade), notas e destaques (decisões, compromissos, contexto-chave), e resultados de ferramentas mais trilha de auditoria. Conversas destacadas importam mais que transcrições completas. Em vez de armazenar tudo que foi dito, armazene fatos duráveis como: “Usuário prefere resumos concisos”, “Voo para NYC na sexta”, “Limite de orçamento é $2.000”.

Recuperação que pareça instantânea (e previsível)

Planeje recuperação em torno de como humanos procuram coisas: palavras-chave, intervalos de tempo, tags e “recentemente alterado.” Use filtros determinísticos primeiro (datas, status, tags) e depois adicione busca semântica no corpo das notas quando a consulta for vaga.

Para evitar alucinações, o assistente deve confiar somente no que realmente recuperou (IDs de registro, timestamps) e fazer uma pergunta de clarificação quando nada relevante for encontrado.

Controles do usuário e confiança

Torne a memória transparente. Usuários devem poder ver o que está salvo, editar, exportar e apagar — especialmente fatos de longo prazo. Se você estiver construindo com um fluxo de vibe-coding como Koder.ai, fazer “Configurações de Memória” uma tela de primeira classe cedo molda tanto o UX quanto seu modelo de dados desde o início.

Frontend: Web (React) e Mobile (Flutter)

Itere com instantâneos

Salve um estado funcional antes de grandes mudanças em prompts, ferramentas ou UI.

Um assistente pessoal vive ou morre pela interface. Escolha a stack com base em onde as pessoas realmente usarão o app: web é frequentemente o caminho mais rápido para utilidade “diária”, enquanto mobile compensa quando notificações, entrada por voz e captura em movimento importam.

Uma abordagem prática é começar com React para UI web (iteração rápida, deploy fácil) e depois espelhar o mesmo modelo de interação em Flutter quando o loop central do assistente funcionar.

Uma UI de chat que se comporta como produto (não demo)

Trate o chat como uma conversa estruturada, não apenas bolhas de texto. Lide com múltiplos formatos de mensagem para que os usuários entendam o que está acontecendo e o que se espera deles: mensagens do usuário, respostas do assistente (incluindo texto em streaming), ações de ferramenta (“Criando tarefa…”), confirmações (aprovar/negare), erros (com opções de retry) e avisos do sistema (offline, limites, capacidade degradada).

Em React, respostas em streaming podem fazer o assistente parecer responsivo, mas mantenha renderização eficiente: anexe deltas, evite re-renderizar toda a transcrição e mantenha comportamento de scroll que respeite usuários lendo mensagens antigas.

Estados de “pensando” sem vazar internos

Usuários precisam de feedback, não seus prompts internos ou detalhes da cadeia de ferramentas. Use indicadores neutros como “Processando” ou “Verificando suas notas” e mostre apenas marcos seguros para o usuário (iniciado, aguardando confirmação, concluído). Isso se torna ainda mais importante ao adicionar fluxos multi-agente.

Configurações que tornam o comportamento controlável

Adicione uma tela de configurações cedo, mesmo que simples. Deixe as pessoas controlar o tom (profissional vs casual), verbosidade (breve vs detalhado) e opções de privacidade (guardar histórico de chat, duração de retenção, habilitar/desabilitar memória). Esses controles reduzem surpresas e ajudam na conformidade.

Se você estiver vibe-coding com Koder.ai, pode gerar tanto a UI web React quanto telas Flutter a partir da mesma intenção de produto, então iterar rapidamente em componentes de conversa, streaming e configurações sem se prender à infraestrutura de UI.

Fundamentos do backend: APIs, autenticação e execução determinística

Um assistente pessoal parece mágico na UI, mas se torna confiável no backend. O objetivo é tornar comportamento conduzido por chat previsível: o modelo pode sugerir ações, mas seu servidor decide o que realmente acontece.

APIs que mapeiam intenção do usuário

Traduza comportamentos do assistente em um pequeno conjunto de endpoints estáveis. Mantenha o chat como ponto de entrada e exponha recursos explícitos para tudo que o assistente pode gerenciar. Por exemplo, o assistente pode rascunhar uma tarefa, mas a chamada final create-task deve ser uma requisição API normal com esquema rígido.

Uma superfície compacta que escala bem inclui chat (enviar/receber mais requisições de ferramenta opcionais), execução de ferramentas (rodar ferramentas aprovadas e retornar resultados estruturados), CRUD de tarefas (com validação server-side), preferências e endpoints de job/status para trabalhos de longa duração.

Autenticação e sessões: decida cedo

Autenticação é mais fácil de adicionar cedo e dolorosa de retrofit. Defina como uma sessão de usuário é representada (tokens ou sessões no servidor) e como requisições são escopadas (user ID, org ID para times). Decida o que o assistente pode fazer “silenciosamente” versus o que exige re-autenticação ou confirmação.

Se planeja tiers (free/pro/business/enterprise), aplique direitos no nível de API desde o primeiro dia (limites de taxa, disponibilidade de ferramentas, permissões de exportação), não dentro de prompts.

Jobs de longa duração: fila, não bloqueie

Resumos de conteúdo grande, imports ou fluxos multi-etapa de agentes devem rodar assincronamente. Retorne rápido com um job ID e forneça updates de progresso (queued → running → partial results → completed/failed). Isso mantém o chat responsivo e evita timeouts.

Execução determinística: modelos propõem, servidores decidem

Trate saídas do modelo como input não confiável. Valide e sanitize tudo: esquemas JSON estritos para chamadas de ferramentas, rejeição de campos desconhecidos, enforcement de tipos/intervalos, normalização server-side de data/fuso horário e logging de requisições/resultado de ferramentas para auditabilidade.

Plataformas como Koder.ai podem acelerar o scaffolding (APIs Go, backing PostgreSQL, snapshots/rollback), mas o princípio é o mesmo: o assistente pode ser criativo na conversa enquanto o backend permanece entediante, rígido e confiável.

Modelo de dados no PostgreSQL: tarefas, notas e auditabilidade

Projete controles de memória

Crie uma tela de memória que os usuários possam visualizar, editar, exportar e excluir.

Um assistente pessoal parece “esperto” quando lembra com confiabilidade, explica o que fez e desfaz erros. Seu esquema PostgreSQL deve suportar isso desde o início: entidades centrais claras, proveniência explícita (de onde cada item veio) e timestamps amigáveis para auditoria.

Entidades centrais a modelar (e por quê)

Comece com um pequeno conjunto de tabelas que correspondam às expectativas do usuário: users, conversations/messages, tasks/reminders, notes e (opcionalmente) embeddings se você fizer retrieval em escala. Mantenha tasks/notes separadas de messages: mensagens são a transcrição bruta; tarefas/notas são os resultados estruturados.

Proveniência: “Qual mensagem criou isto?”

Trate proveniência como recurso de primeira classe. Quando o LLM transforma um pedido em uma tarefa, armazene um source_message_id em tasks/notes, rastreie quem criou (user, assistant ou system) e anexe um tool_run_id se usar ferramentas/agentes. Isso torna o comportamento explicável (“Criado a partir da sua mensagem na terça às 10:14”) e acelera a depuração.

Campos para auditoria e soft delete

Use colunas consistentes entre tabelas: created_at, updated_at e deleted_at para soft deletes. Soft delete é especialmente útil para apps assistentes porque usuários frequentemente querem desfazer, e você pode precisar preservar registros para conformidade ou troubleshooting.

Considere identificadores imutáveis (uuid) e uma tabela de log append-only para eventos chave (tarefa criada, data de vencimento alterada, lembrete disparado). É mais simples do que tentar reconstruir histórico a partir de linhas atualizadas.

Migrações e evolução de esquema

O comportamento do assistente muda rapidamente. Planeje migrações cedo: version your schema, evite mudanças destrutivas e prefira passos aditivos (novas colunas, novas tabelas). Se você estiver vibe-coding com Koder.ai, pareie snapshots/rollback com disciplina de migração para iterar sem perder integridade de dados.

CREATE TABLE tasks (

id uuid PRIMARY KEY,

user_id uuid NOT NULL,

title text NOT NULL,

status text NOT NULL,

due_at timestamptz,

source_message_id uuid,

created_by text NOT NULL,

created_at timestamptz NOT NULL DEFAULT now(),

updated_at timestamptz NOT NULL DEFAULT now(),

deleted_at timestamptz

);

Testes e avaliação: torne confiável

Confiabilidade é a diferença entre uma demo legal e um assistente que as pessoas confiam para trabalho real. A parte complicada é que pedidos de assistente raramente são limpos: usuários são breves, emocionais, inconsistentes e frequentemente pulam detalhes chave. Sua estratégia de testes deve refletir essa realidade.

Construa um conjunto de testes que pareça vida real

Colete (ou escreva) um pequeno mas representativo conjunto de pedidos: mensagens curtas, instruções vagas, erros de digitação, restrições conflitantes e mudanças de última hora. Inclua caminhos felizes (criação clara de tarefa, captura de nota) e caminhos de borda (datas faltando, pronomes ambíguos, várias pessoas com o mesmo nome, pedidos que implicam permissões).

Mantenha esses exemplos como seu conjunto ouro. Rode-o sempre que mudar prompts, ferramentas ou lógica de agentes.

Defina o que é “bom” (além de respostas corretas)

Para apps assistentes, correção não é só sobre texto final. Avalie se tomou a ação certa, pediu confirmação quando necessário e evitou inventar resultados de ferramentas.

Um rubrica prática checa: correção de tarefas, comportamento de confirmação (especialmente antes de deleções/envios/gastos), ações alucinadas (afirmação de execução sem tool run), disciplina de ferramentas (usa ferramentas quando necessário; evita chamadas desnecessárias) e recuperação (tratamento claro de falhas e retries).

Checagens de regressão para prompts e ferramentas

Cada ajuste de prompt pode deslocar comportamento de maneiras inesperadas. Trate prompts como código: versioná-los, rodar o conjunto ouro e comparar resultados. Se usar múltiplos agentes (planner/executor), teste cada etapa — muitas falhas começam como um erro de planejamento que se propaga.

Ao adicionar uma nova ferramenta ou mudar o schema de uma ferramenta, adicione casos de regressão direcionados (por exemplo, “criar uma tarefa para próxima sexta” deve ainda resolver datas consistentemente). Se seu fluxo suporta snapshots e rollback, use-os para reverter rápido quando avaliações caírem.

Instrumentação sem vazar segredos

Logue chamadas de ferramentas, argumentos redigidos, tempos e razões de falha para responder: “O que o modelo tentou fazer?” e “Por que falhou?” Redija tokens, dados pessoais e conteúdo de mensagens por padrão, armazenando apenas o necessário para debug — frequentemente um user ID hasheado, nome da ferramenta, intenção de alto nível e classe de erro são suficientes.

Feito direito, testes transformam iteração em loop controlado: você pode mover mais rápido sem quebrar confiança.

Um assistente pessoal rapidamente vira recipiente de material sensível: calendários, localizações, mensagens, documentos e notas que usuários não pretendiam compartilhar. Trate privacidade como recurso de produto, não um checkbox. Minimize o que coleta e o que envia para um LLM. Se um recurso não requer histórico completo de mensagens, não o armazene; se um pedido pode ser respondido com um resumo curto, envie só o resumo.

Minimização de dados, retenção e controles do usuário

Defina retenção desde o começo: o que armazena (tarefas, notas, preferências), por que armazena e por quanto tempo fica. Faça exclusão real e verificável: usuários devem poder apagar uma nota única, um workspace inteiro e quaisquer arquivos enviados. Considere um “modo esquecido” para conversas sensíveis onde você não persiste conteúdo — apenas metadata mínima para faturamento e prevenção de abuso.

Segredos, tokens e criptografia

Nunca envie chaves de API para o cliente. Mantenha chaves de provedores e credenciais de ferramentas no servidor, rode rotação e aplique escopo por ambiente. Cripte dados em trânsito (TLS) e em repouso (banco e backups). Para tokens de sessão, use durações curtas e fluxos de refresh; armazene hashes quando possível e evite logar prompts ou outputs de ferramentas em texto claro por padrão.

Alguns usuários exigirão residência de dados (países/regiões específicas), especialmente para assistentes corporativos. Planeje deploys orientados por região cedo: mantenha dados do usuário em um banco alinhado à região e evite pipelines cross-region que copiem conteúdo para outros lugares. Koder.ai roda na AWS globalmente e pode hospedar aplicações em países específicos, o que pode simplificar requisitos de residência e transferência transfronteiriça quando necessário.

Proteção contra abuso e defesa contra prompt injection

Assistentes atraem abuso: scraping, credential stuffing e ataques “faça o modelo revelar segredos”. Uma linha de base prática inclui limites de taxa e quotas, detecção de atividade suspeita, permissões estritas de ferramentas (allow-list + validação server-side), higiene contra prompt injection (trate texto externo como não confiável; isole-o das regras de sistema) e logs de auditoria para execução de ferramentas e acesso a dados.

O objetivo é comportamento previsível: o modelo pode sugerir ações, mas seu backend decide o que é permitido.

Implantação, monitoramento e iteração segura

Modele suas tabelas principais

Comece com tarefas, notas e logs de auditoria com campos de proveniência claros.

Lançar um assistente pessoal não é um único momento. É um ciclo: liberar pequeno, observar uso real, ajustar comportamento e repetir — sem quebrar confiança. Como assistentes podem mudar comportamento com um ajuste de prompt ou uma nova integração de ferramenta, você precisa de disciplina de deploy que trate configuração e prompts como código de produção.

Assuma que cada nova capacidade pode falhar de maneiras surpreendentes: bugs de fuso horário, memória salvando detalhe errado ou um modelo ficando mais criativo do que o desejado. Feature flags permitem expor novas ferramentas e comportamentos de memória a um pequeno grupo de usuários (ou contas internas) antes do rollout amplo.

Uma estratégia simples: gate cada integração de ferramenta, gate gravações de memória separadamente das leituras, habilitar modo de planejamento só para testadores, adicionar um “modo seguro” que desativa chamadas de ferramenta (apenas leitura) e usar rollouts percentuais para mudanças arriscadas.

Rollback não é opcional: snapshot de prompts e config

Apps tradicionais fazem rollback de binários; apps de assistente também devem reverter comportamento. Trate prompts de sistema, schemas de ferramentas, regras de roteamento, políticas de segurança e filtros de memória como deployables versionados. Mantenha snapshots para restaurar o último comportamento conhecido bom rapidamente.

Isso é especialmente valioso quando você itera rápido com vibe coding: Koder.ai suporta snapshots e rollback, o que se encaixa bem em assistentes onde pequenas edições de texto podem ter grande impacto no produto.

Estratégia de deploy e domínios customizados

Se oferecer um assistente white-label (para times ou clientes), planeje domínios customizados cedo. Isso afeta callbacks de auth, configurações de cookie/session, limites por tenant e como separar logs e dados. Mesmo para um produto single-brand, defina ambientes (dev/staging/prod) para testar permissões de ferramentas e settings de modelo com segurança.

Monitore o que importa: confiabilidade, velocidade e custo

Monitoramento de assistente é parte analytics de produto, parte operações. Acompanhe latência e erros, mas também sinais comportamentais como custo por conversa, frequência de chamadas a ferramentas e taxa de falha de ferramentas. Combine métricas com amostras de auditoria de conversas para ver se mudanças melhoraram resultados — não só throughput.

Vibe coding é mais valioso quando você precisa de um protótipo real — não um deck de slides. Para um assistente pessoal, isso geralmente significa uma UI de chat, algumas ações centrais (capturar tarefa, salvar nota, agendar lembrete) e um backend que permaneça determinístico mesmo quando o LLM é criativo. Uma plataforma de vibe-coding comprime a linha do tempo do primeiro-para-funcional ao transformar sua descrição de produto em telas, rotas e serviços executáveis.

Um workflow prático estilo Koder.ai

Comece descrevendo o assistente em linguagem natural no chat: quem é, o que faz e como “feito” parece para o MVP. Itere em passos pequenos.

Gere uma interface web React primeiro (vista de conversa, compositor de mensagens, um painel leve de “ferramentas usadas” e uma página de configurações simples), depois adicione uma versão móvel em Flutter quando os fluxos estiverem corretos.

Em seguida, gere um backend em Go com PostgreSQL: autenticação, uma API mínima para conversas e endpoints de ferramentas (create task, list tasks, update task). Mantenha o comportamento do LLM como uma camada fina: instruções de sistema, schema de ferramentas e guardrails. A partir daí, itere prompts e UI juntos: quando o assistente faz uma suposição errada, ajuste o texto de comportamento e adicione uma etapa de confirmação no UX.

Recursos que importam quando você itera rápido

Priorize aceleradores de fluxo que mantenham experimentação segura: modo de planejamento (propor antes de aplicar), snapshots e rollback (recuperação rápida de iterações ruins), deployment e hosting com domínios customizados (acesso rápido para stakeholders) e exportação de código-fonte (para manter propriedade total e migrar para pipeline de longo prazo depois).

Checklist de próximos passos

Antes de escalar além do MVP, consolide:

- Uma especificação MVP de uma página (3–5 jobs de usuário, non-goals, critérios de sucesso)

- Sua lista de ferramentas (o que o assistente tem permissão para fazer via APIs)

- Um pequeno conjunto de avaliação (20–50 cenários + resultados esperados)

- Um plano de implantação (ambientes, segredos, estratégia de rollback, monitoramento)

Com essa estrutura, Koder.ai (koder.ai) pode ser uma maneira prática de ir do conceito para um assistente funcional React/Go/PostgreSQL (e depois Flutter) rapidamente, mantendo comportamento testável e reversível.