23 de nov. de 2025·8 min

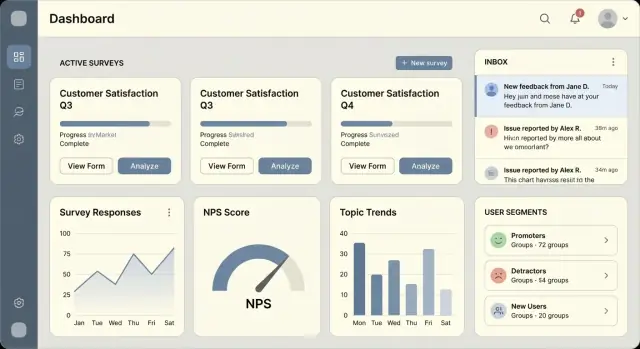

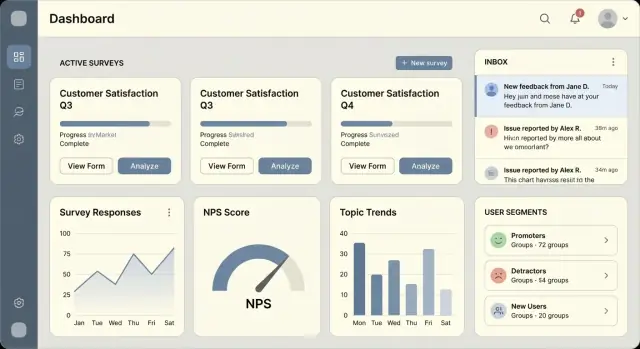

Como construir um app web para coleta de feedback e pesquisas

Aprenda a planejar, construir e lançar um app web para coletar feedback e rodar pesquisas de usuários — cobrindo UX, modelo de dados, analytics e privacidade.

Aprenda a planejar, construir e lançar um app web para coletar feedback e rodar pesquisas de usuários — cobrindo UX, modelo de dados, analytics e privacidade.

Antes de escrever código, decida o que você realmente está construindo. “Feedback” pode significar uma caixa de entrada leve para comentários, uma ferramenta de pesquisas estruturadas ou uma mistura dos dois. Se você tentar cobrir todo caso de uso no dia um, vai acabar com um produto complicado difícil de lançar — e ainda mais difícil para as pessoas adotarem.

Escolha o trabalho central que seu app deve fazer na primeira versão:

Um MVP prático para “ambos” é: um formulário de feedback sempre disponível + um template básico de pesquisa (NPS ou CSAT), alimentando a mesma lista de respostas.

O sucesso deve ser observável em semanas, não trimestres. Escolha um pequeno conjunto de métricas e estabeleça metas de baseline:

Se você não consegue explicar como vai calcular cada métrica, ela ainda não é útil.

Seja específico sobre quem usa o app e por quê:

Públicos diferentes exigem tom distinto, expectativas de anonimato e workflows de follow-up.

Anote o que não pode mudar:

Essa definição de problema/MVP vira seu “contrato de escopo” para a primeira construção — e evita refatorações desnecessárias depois.

Antes de projetar telas ou escolher recursos, decida para quem o app é e o que “sucesso” significa para cada pessoa. Produtos de feedback falham menos por falta de tecnologia e mais por propriedade pouco clara: todo mundo pode criar pesquisas, ninguém as mantém, e os resultados nunca viram ação.

Admin é dono do workspace: faturamento, segurança, branding, acesso de usuários e configurações padrão (retenção de dados, domínios permitidos, texto de consentimento). Importa-se com controle e consistência.

Analista (ou Product Manager) roda o programa de feedback: cria pesquisas, segmenta audiências, acompanha taxas de resposta e transforma resultados em decisões. Importa-se com velocidade e clareza.

Usuário final / respondente responde às perguntas. Importa-se com confiança (por que estou sendo perguntado?), esforço (quanto tempo leva?) e privacidade.

Mapeie o “caminho feliz” de ponta a ponta:

Mesmo se você postergar recursos de “agir”, documente como os times farão isso (por exemplo, exportar para CSV ou enviar para outra ferramenta depois). O importante é evitar lançar um sistema que coleta dados mas não gera ação.

Você não precisa de muitas páginas, mas cada uma deve responder a uma pergunta clara:

Quando essas jornadas estiverem claras, as decisões de recursos ficam mais fáceis — e você mantém o produto focado.

Um app de coleta de feedback e pesquisas com usuários não precisa de arquitetura elaborada para ter sucesso. Seu primeiro objetivo é lançar um construtor de pesquisas confiável, capturar respostas e facilitar a revisão dos resultados — sem criar um ônus de manutenção.

Para a maioria, um monolito modular é o lugar mais simples para começar: um backend, um banco de dados e módulos internos claros (auth, surveys, responses, reporting). Você ainda pode manter limites bem definidos para extrair partes depois.

Escolha serviços simples apenas se tiver um motivo forte — como envio de email em alto volume, cargas analíticas pesadas ou requisitos de isolamento estrito. Caso contrário, microserviços podem atrasar com código duplicado, deploys complexos e debugging mais difícil.

Um compromisso prático é: monolito + alguns add-ons gerenciados, como uma fila para jobs em background e um object store para exports.

No front, React e Vue são ótimos para um construtor de pesquisas por lidarem bem com formulários dinâmicos.

No backend, escolha algo que seu time mova rápido:

Seja qual for a escolha, mantenha APIs previsíveis. Seu construtor e a UI de respostas evoluirão mais rápido se os endpoints forem consistentes e versionados.

Se quiser acelerar a “primeira versão funcional” sem meses de scaffolding, uma plataforma de vibe-coding como Koder.ai pode ser um ponto de partida prático: você conversa para gerar um frontend React mais um backend Go com PostgreSQL, e depois exporta o código quando quiser controlar tudo.

Pesquisas parecem “documentos”, mas a maioria das necessidades de workflow de feedback é relacional:

Um banco relacional como PostgreSQL costuma ser a escolha mais fácil por suportar constraints, joins, queries para relatórios e análises futuras sem gambiarra.

Comece com uma plataforma gerenciada quando possível (PaaS para app e Postgres gerenciado). Reduz o overhead de ops e mantém o time focado em recursos.

Principais geradores de custo:

Conforme crescer, você pode mover peças para o provedor de cloud sem reescrever tudo — se tiver mantido arquitetura simples e modular desde o início.

Um bom modelo de dados facilita tudo: construir o construtor, manter resultados consistentes ao longo do tempo e produzir analytics confiáveis. Mire numa estrutura simples de consultar e difícil de corromper acidentalmente.

A maioria dos apps de coleta de feedback pode começar com seis entidades-chave:

Essa estrutura mapeia bem para o fluxo de feedback de produto: times criam pesquisas, coletam respostas e analisam respostas.

Pesquisas evoluem. Alguém vai corrigir uma redação, adicionar uma pergunta ou mudar opções. Se você sobrescrever perguntas in-place, respostas antigas ficam confusas ou impossíveis de interpretar.

Use versionamento:

Assim, editar uma pesquisa cria uma nova versão enquanto resultados passados permanecem intactos.

Tipos comuns incluem texto, escala/avaliação e múltipla escolha.

Uma abordagem prática:

type, title, required, positionquestion_id e um valor flexível (por exemplo, text_value, number_value, além de option_id para escolhas)Isso mantém o reporting direto (médias para escalas, contagens por opção).

Planeje identificadores cedo:

created_at, published_at, submitted_at e archived_at.channel (in-app/email/link), locale e external_user_id opcional (se precisar vincular respostas a usuários do seu produto).Esses itens básicos tornam sua análise mais confiável e auditorias menos penosas depois.

Um app de coleta de feedback vive ou morre pela sua UI: admins precisam construir pesquisas rapidamente, e respondentes precisam de um fluxo suave e sem distrações. Aqui o seu aplicativo começa a parecer “real”.

Comece com um construtor simples que suporte uma lista de perguntas com:

Se adicionar branching, mantenha opcional e mínimo: permita “Se resposta é X → ir para pergunta Y.” Armazene isso no banco como uma regra anexada a uma opção. Se branching parecer arriscado no v1, lance sem ele e mantenha o modelo de dados preparado.

A UI de resposta deve carregar rápido e funcionar bem no celular:

Evite lógica cliente pesada. Renderize formulários simples, valide obrigatórios e envie respostas em payloads pequenos.

Torne o widget in-app e as páginas de pesquisa usáveis para todos:

Links públicos e convites por email atraem spam. Adicione proteções leves:

Essa combinação mantém a análise limpa sem prejudicar respondentes legítimos.

Canais são como sua pesquisa alcança pessoas. Os melhores apps suportam pelo menos três: widget in-app para usuários ativos, convites por email para outreach direcionado e links compartilháveis para distribuição ampla. Cada canal tem tradeoffs em taxa de resposta, qualidade de dados e risco de uso indevido.

Mantenha o widget fácil de achar, mas não incômodo. Colocações comuns: botão no canto inferior, aba na lateral ou modal que aparece após ações específicas.

Gatilhos devem ser baseados em regras para interromper somente quando fizer sentido:

Adicione limites de frequência (por exemplo, “não mais que uma vez por semana por usuário”) e uma opção clara de “não mostrar novamente”.

Email funciona bem para momentos transacionais (após fim de trial) ou amostragem (N usuários por semana). Evite links compartilháveis gerando tokens de uso único atrelados a um destinatário e pesquisa.

Regras recomendadas para tokens:

Use links públicos quando quiser alcance: NPS de marketing, feedback de evento ou pesquisas comunitárias. Planeje controles anti-spam (rate limiting, CAPTCHA, verificação opcional por email).

Use pesquisas autenticadas quando respostas precisarem mapear para uma conta ou papel: CSAT de suporte, feedback interno de funcionários ou fluxo de feedback ligado ao workspace.

Lembretes aumentam respostas, mas com guardrails:

Esses básicos fazem seu app parecer atencioso e mantêm a qualidade dos dados.

Autenticação e autorização são onde um app de feedback pode falhar silenciosamente: o produto funciona, mas a pessoa errada vê os resultados errados. Trate identidade e limites de tenant como recursos centrais, não complementos.

Para um MVP, email/senha costuma ser suficiente — rápido de implementar e fácil de suportar.

Se quiser login mais suave sem complexidade enterprise, considere magic links (passwordless). Reduz tickets de senha esquecida, mas exige boa entregabilidade de email e manejo de expiração de links.

Planeje SSO (SAML/OIDC) como upgrade futuro. O importante é desenhar seu modelo de usuário para que adicionar SSO não force reescrever tudo (por exemplo, suportar múltiplas “identidades” por usuário).

Um construtor de pesquisas precisa de acesso claro e previsível:

Mantenha checagens de política explícitas no código (checks em cada read/write), não só na UI.

Workspaces permitem que agências, times ou produtos compartilhem a plataforma isolando dados. Cada survey, response e integração deve carregar um workspace_id, e cada query deve ser feita com esse escopo.

Decida cedo se vai suportar usuários em múltiplos workspaces e como será a troca entre eles.

Se expuser chaves de API (para embed do widget in-app, sincronização com um banco de feedback, etc.), defina:

Para webhooks, assine requests, faça retries seguros e permita que usuários desativem ou regenerem segredos a partir de uma tela simples de configurações.

Analytics é onde um app de feedback vira útil para tomada de decisão, não só armazenamento de dados. Comece definindo um pequeno conjunto de métricas confiáveis e depois construa visualizações que respondam perguntas do dia a dia rapidamente.

Instrumente eventos chave por pesquisa:

A partir disso, calcule start rate (starts/views) e completion rate (completions/starts). Também registre pontos de queda — por exemplo, a última pergunta vista ou o passo onde abandonaram. Isso ajuda a identificar pesquisas muito longas, confusas ou mal segmentadas.

Antes de integrações BI avançadas, entregue uma área de relatórios com widgets de alto sinal:

Mantenha gráficos simples e rápidos. A maioria quer responder: “essa mudança melhorou o sentimento?” ou “essa pesquisa está ganhando tração?”.

Adicione filtros cedo para que resultados sejam críveis e acionáveis:

Segmentar por canal é crucial: convites por email costumam ter comportamento diferente de prompts in-product.

Ofereça exportação CSV para resumos e respostas brutas. Inclua colunas para timestamps, channel, atributos do usuário (quando permitido) e IDs/texto das perguntas. Isso dá flexibilidade imediata para times em planilhas enquanto você itera para relatórios mais ricos.

Apps de feedback frequentemente coletam dados pessoais sem intenção: emails em convites, respostas abertas que mencionam nomes, IPs em logs ou IDs de dispositivo no widget. A abordagem mais segura é projetar para o “mínimo necessário” desde o primeiro dia.

Crie um dicionário de dados simples que liste cada campo que você armazena, por que armazena, onde aparece na UI e quem pode acessar. Isso mantém o construtor honesto e evita campos “por precaução”.

Exemplos de campos a questionar:

Se oferecer pesquisas anônimas, trate “anônimo” como promessa do produto: não armazene identificadores em campos ocultos e evite misturar dados de resposta com dados de autenticação.

Deixe o consentimento explícito quando necessário (por exemplo, follow-ups de marketing). Planeje também fluxos operacionais:

Use HTTPS em toda a comunicação (criptografia em trânsito). Proteja segredos com um gerenciador de segredos (não variáveis de ambiente copiadas em docs ou tickets). Criptografe colunas sensíveis em repouso quando apropriado e garanta que backups sejam criptografados e testados com drills de restauração.

Use linguagem simples: quem coleta, por quê, quanto tempo mantém e como contatar. Se usar subprocessadores (envio de email, analytics), liste-os e forneça forma para assinar um acordo de processamento de dados. Mantenha a página de privacidade fácil de achar na UI de resposta e no widget in-app.

Padrões de tráfego são em rajadas: uma campanha de email pode transformar “calmo” em milhares de submissões em minutos. Projetar para confiabilidade desde cedo previne dados ruins, respostas duplicadas e dashboards lentos.

Pessoas abandonam formulários, perdem conexão ou mudam de dispositivo no meio da pesquisa. Valide no servidor, mas seja deliberado sobre o que é realmente obrigatório.

Para pesquisas longas, considere salvar o progresso como rascunho: armazene respostas parciais com status in_progress, e só marque submitted quando todas as obrigatórias passarem na validação. Retorne erros por campo para que a UI destaque exatamente o que resolver.

Double-clicks, reenvios pelo botão voltar e redes móveis flakey criam registros duplicados.

Torne o endpoint de submissão idempotente aceitando uma idempotency key (token único gerado pelo cliente para aquela resposta). No servidor, armazene a chave com a resposta e imponha unicidade. Se a mesma chave for enviada de novo, retorne o resultado original em vez de inserir uma nova linha.

Isso é crítico para:

Mantenha a requisição de “submeter resposta” rápida. Use fila/workers para tudo que não precise bloquear o usuário:

Implemente retries com backoff, dead-letter queues para falhas repetidas e deduplicação de jobs quando aplicável.

Páginas de analytics podem ser as mais lentas conforme as respostas crescem.

survey_id, created_at, workspace_id e qualquer campo de “status`.Uma regra prática: armazene eventos brutos, mas sirva dashboards a partir de tabelas pré-agregadas quando queries começarem a prejudicar performance.

Lançar um app de pesquisas é menos sobre “concluir” e mais sobre prevenir regressões enquanto você adiciona tipos de pergunta, canais e permissões. Uma suíte de testes pequena e consistente mais uma rotina de QA repetível vai poupar bugs de links quebrados, respostas perdidas e analytics incorretos.

Foque testes automatizados em lógica e fluxos end-to-end difíceis de detectar manualmente:

Mantenha fixtures pequenas e explícitas. Se versionar schemas de pesquisa, adicione teste que carregue definições “antigas” para garantir que você ainda renderize e analise respostas históricas.

Antes de cada release, rode uma checklist curta que espelhe uso real:

Mantenha um ambiente de staging que espelhe produção (auth, provedor de email, storage). Adicione seed data: alguns workspaces de exemplo, pesquisas (NPS, CSAT, multi-step) e respostas amostrais. Isso torna regression testing e demos repetíveis e evita surpresas de “funciona na minha conta”.

Pesquisas falham silenciosamente a menos que você monitore os sinais certos:

Uma regra simples: se um cliente não consegue coletar respostas por 15 minutos, você deve saber antes que ele te escreva.

Enviar um app de coleta de feedback não é um único “go-live”. Trate o lançamento como um ciclo controlado de aprendizado para validar com times reais enquanto mantém o suporte manejável.

Comece com beta privado (5–20 clientes confiáveis) onde você pode observar como as pessoas realmente constroem pesquisas, compartilham links e interpretam resultados. Avance para rollout limitado abrindo acesso a uma lista de espera ou segmento (por exemplo, apenas startups) e depois faça release total quando fluxos principais estiverem estáveis e o suporte previsível.

Defina métricas de sucesso por fase: taxa de ativação (criou a primeira pesquisa), taxa de resposta e tempo para o primeiro insight (visualizou analytics ou exportou resultados). Essas são mais úteis que apenas números de signup.

Seja opinativo no onboarding:

Mantenha o onboarding dentro do produto, não só em docs.

Feedback só é útil quando é executado. Adicione workflow simples: atribuir responsáveis, marcar temas, definir status (novo → em andamento → resolvido) e ajudar times a fechar o ciclo notificando respondentes quando um problema for resolvido.

Priorize integrações (Slack, Jira, Zendesk, HubSpot), mais templates NPS/CSAT e refine o packaging. Quando monetizar, direcione usuários para seus planos em /pricing.

Se estiver iterando rápido, pense em como gerenciar mudanças com segurança (rollbacks, staging e deploys rápidos). Plataformas como Koder.ai facilitam snapshots e rollback com hosting one-click — úteis quando você experimenta templates, workflows e analytics sem querer administrar infraestrutura nos estágios iniciais.

Comece escolhendo um objetivo principal:

Mantenha a primeira versão estreita o suficiente para ser entregue em 2–6 semanas e medir resultados rapidamente.

Escolha métricas que você consiga calcular em poucas semanas e defina-as com precisão. Escolhas comuns:

Se você não consegue explicar de onde vêm numerador/denominador no seu modelo de dados, a métrica ainda não está pronta.

Mantenha os papéis simples e alinhados com responsabilidade real:

A maioria das falhas iniciais acontece por permissões pouco claras e “todo mundo pode publicar, ninguém mantém”.

Um conjunto mínimo e de alto impacto é:

Se uma tela não responde a uma pergunta clara, corte-a do v1.

Para a maioria das equipes, comece com um monolito modular: um backend + um banco de dados + módulos internos claros (auth, surveys, responses, reporting). Adicione componentes gerenciados onde necessário, como:

Microserviços tendem a atrasar o desenvolvimento inicial por causa de sobrecarga de deploy e debugging.

Use um core relacional (geralmente PostgreSQL) com estas entidades:

Versionamento é essencial: editar uma pesquisa deve criar uma nova SurveyVersion para que respostas históricas permaneçam interpretáveis.

Mantenha o construtor pequeno mas flexível:

required e texto de ajudaSe adicionar branching, mantenha-o mínimo (por exemplo, “Se opção X → pular para pergunta Y”) e modele como regras anexadas às opções.

Um mínimo prático são três canais:

Projete cada canal para registrar metadados para que você possa segmentar resultados depois.

Trate isso como uma promessa do produto e reflita na coleta de dados:

Foque nos modos de falha que geram dados ruins:

Priorize um lançamento em ciclos controlados para validar com times reais enquanto mantém o suporte manejável:

Defina métricas de sucesso por fase: ativação (criou a primeira pesquisa), taxa de resposta e tempo até o primeiro insight (vê/ exporta resultados).

Torne o onboarding opinativo:

Mantenha o onboarding dentro do produto, não apenas na documentação.

Integre notificações e workflows simples:

Isso garante que o feedback gere ação, não apenas relatórios.

Priorize integrações (Slack, Jira, Zendesk, HubSpot), adicione mais templates NPS/CSAT e refine o packaging. Quando estiver pronto para monetizar, direcione usuários para seus planos em /pricing.

Se iterar rápido, pense em como gerenciar mudanças com segurança (rollbacks, staging e deploys rápidos). Plataformas como Koder.ai oferecem snapshots, rollback e hosting com um clique—úteis quando você experimenta templates, workflows e análises sem querer gerenciar infraestrutura nos estágios iniciais.

channelMantenha também um dicionário de dados simples para justificar cada campo armazenado.

submitted apenas quando completoworkspace_id, survey_id, created_at) e agregados em cacheAdicione alertas para “respostas caíram a zero” e picos de erros de submissão para que a coleta não falhe silenciosamente.