Por que esta história importa para equipes que rodam software

Equipes não têm problema porque não conseguem iniciar um contêiner. Elas têm problema porque precisam rodar centenas deles com segurança, atualizá-los sem downtime, recuperar-se quando algo quebra e ainda entregar funcionalidades no prazo.

A história “cloud-native” de Craig McLuckie importa porque não é uma celebração de demos chamativas. É um registro de como contêineres se tornaram operáveis em ambientes reais — onde incidentes acontecem, existe conformidade e o negócio precisa de entregas previsíveis.

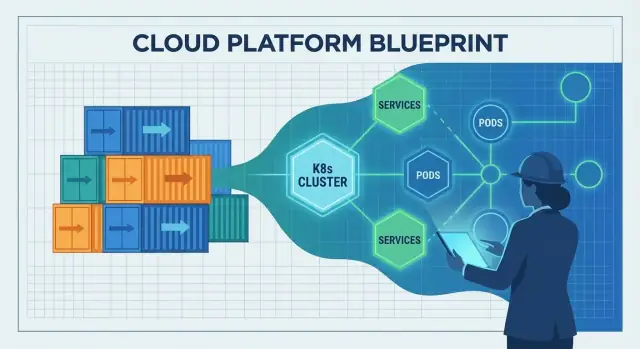

Cloud-native, em termos simples

“Cloud-native” não é “rodar na nuvem”. É uma abordagem para construir e operar software para que ele possa ser implantado frequentemente, escalado quando a demanda muda e reparado rapidamente quando partes falham.

Na prática, isso normalmente significa:

- Aplicações empacotadas e entregues de forma consistente (frequentemente com contêineres)

- Sistemas desenhados como serviços menores, não um único release gigante

- Automação para deploys, escalonamento e rollbacks

- Formas padrão de observar, proteger e governar o que está rodando

A adoção inicial de contêineres muitas vezes parecia uma caixa de ferramentas: equipes pegavam Docker, juntavam scripts e torciam para que operações acompanhasse. Pensamento de plataforma inverte isso. Em vez de cada equipe inventar seu próprio caminho para produção, você constrói “estradas pavimentadas” compartilhadas — uma plataforma que torna o caminho seguro, conforme e observável também o caminho fácil.

Essa mudança é a ponte entre “conseguimos rodar contêineres” e “conseguimos rodar um negócio com eles”.

Para quem é este artigo

Isto é para pessoas responsáveis por resultados, não apenas por diagramas de arquitetura:

- Líderes de engenharia equilibrando velocidade e confiabilidade

- Times de produto que querem iterar mais rápido sem quedas

- Pessoal de plataforma, DevOps e SRE tentando reduzir trabalho manual e atritos

- Desenvolvedores que só querem que implantações sejam monótonas e repetíveis

Se seu objetivo é entrega confiável em escala, essa história tem lições práticas.

Quem é Craig McLuckie (e por que o citam)

Craig McLuckie é um dos nomes mais conhecidos ligados ao movimento cloud-native inicial. Você o verá referenciado em conversas sobre Kubernetes, a Cloud Native Computing Foundation (CNCF) e a ideia de que infraestrutura deve ser tratada como um produto — não como um montinho de tickets e conhecimento tribal.

Não “o inventor”, mas um construtor-chave

Vale ser preciso. McLuckie não “inventou cloud-native” sozinho, e Kubernetes nunca foi projeto de uma só pessoa. Kubernetes foi criado por uma equipe no Google, e McLuckie fez parte desse esforço inicial.

O que frequentemente lhe é creditado é ajudar a transformar um conceito de engenharia em algo que a indústria mais ampla pudesse realmente adotar: construção comunitária mais forte, empacotamento mais claro e um empurrão para práticas operacionais repetíveis.

Um tema consistente: confiabilidade por repetibilidade

Ao longo de Kubernetes e da era CNCF, a mensagem de McLuckie foi menos sobre arquitetura da moda e mais sobre tornar produção previsível. Isso significa:

- Formas padrão de implantar e reverter

- Ambientes consistentes do laptop à produção

- Guardrails operacionais que reduzem surpresas

Se você já ouviu termos como “paved roads”, “golden paths” ou “platform as a product”, está orbitando a mesma ideia: reduzir a carga cognitiva das equipes tornando o certo o caminho fácil.

Por que o artigo o menciona

Este post não é uma biografia. McLuckie é um ponto de referência útil porque seu trabalho fica na interseção de três forças que mudaram a entrega de software: contêineres, orquestração e construção de ecossistema. As lições aqui não são sobre personalidade — são sobre por que o pensamento de plataforma acabou sendo o desbloqueio para rodar contêineres em produção real.

Antes do cloud-native: contêineres existiam, produção era difícil

Contêineres eram uma ideia empolgante muito antes de “cloud-native” virar rótulo comum. Em termos simples, um contêiner é uma forma de empacotar uma aplicação com os arquivos e bibliotecas que ela precisa para rodar da mesma maneira em máquinas diferentes — como enviar um produto numa caixa lacrada com todas as peças dentro.

Por que o uso inicial de contêineres ficou experimental

No começo, muitas equipes usavam contêineres para projetos paralelos, demos e fluxos de trabalho de desenvolvedor. Eram ótimos para testar serviços rapidamente, levantar ambientes de teste e evitar o clássico “funciona no meu laptop” na hora da transição.

Mas mover de uma mão cheia de contêineres para um sistema de produção que roda 24/7 é trabalho diferente. As ferramentas existiam, mas a história operacional estava incompleta.

Bloqueios de produção que as equipes encontraram

Problemas comuns surgiram rápido:

- Atualizações e rollbacks: Como atualizar dezenas (ou centenas) de contêineres em execução com segurança, sem downtime? E como reverter quando algo quebra?

- Rede: Contêineres precisam se encontrar de forma confiável. Descoberta de serviço, roteamento de tráfego, balanceamento de carga e “quem pode falar com quem” não eram padronizados.

- Segurança: Proveniência de imagens, gerenciamento de segredos, controles de acesso e correção de vulnerabilidades tornaram-se trabalho contínuo — não uma configuração única.

- Monitoramento e debugging: Depois que um contêiner é reiniciado, logs podem desaparecer. Métricas, tracing e alertas precisavam ser projetados para um mundo onde processos são de curta duração.

De “funciona na minha máquina” para “roda todos os dias em escala”

Contêineres ajudaram a tornar o software portátil, mas portabilidade por si só não garantia confiabilidade. Equipes ainda precisavam de práticas de deploy consistentes, propriedade clara e guardrails operacionais — para que apps containerizados não rodassem apenas uma vez, mas previsivelmente todos os dias.

Pensamento de plataforma é o momento em que uma empresa para de tratar infraestrutura como projeto único e começa a tratá-la como um produto interno. Os “clientes” são seus desenvolvedores, times de dados e qualquer pessoa que entrega software. O objetivo do produto não é mais servidores ou YAMLs — é um caminho mais suave da ideia à produção.

Uma plataforma real tem uma promessa clara: “Se você construir e implantar usando estes caminhos, terá confiabilidade, segurança e entrega previsível.” Essa promessa exige hábitos de produto — documentação, suporte, versionamento e loops de feedback. Também exige uma experiência de usuário deliberada: padrões sensatos, estradas pavimentadas e uma saída quando uma equipe realmente precisa.

Por que padronização acelera entregas (e reduz risco)

Padronização elimina fadiga de decisão e previne complexidade acidental. Quando equipes compartilham os mesmos padrões de deploy, logging e controles de acesso, problemas se tornam repetíveis — e, portanto, solucionáveis. Rodízios de on-call melhoram porque incidentes ficam familiares. Revisões de segurança ficam mais rápidas porque a plataforma incorpora guardrails em vez de depender que cada equipe os reinvente.

Não se trata de forçar todos a caberem na mesma caixa. Trata-se de concordar sobre os 80% que deveriam ser enfadonhos, para que as equipes gastem energia nos 20% que diferenciam o negócio.

De servidores artesanais para padrões repetíveis

Antes de abordagens de plataforma, a infraestrutura frequentemente dependia de conhecimento especial: poucas pessoas sabiam quais servidores estavam atualizados, quais configurações eram seguras e quais scripts eram “os bons”. O pensamento de plataforma substitui isso por padrões repetíveis: templates, provisionamento automatizado e ambientes consistentes do dev à produção.

Governança sem burocracia

Feito bem, plataformas criam governança melhor com menos papelada. Políticas viram checagens automatizadas, aprovações viram fluxos auditáveis e evidência de conformidade é gerada conforme equipes implantam — assim a organização ganha controle sem frear todos.

Kubernetes como ponte entre contêineres e operações

Contêineres tornaram fácil empacotar e enviar uma app. A parte difícil era o que acontecia depois: escolher onde rodar, mantê-la saudável e adaptar quando o tráfego ou a infraestrutura mudavam.

Essa é a lacuna que Kubernetes preencheu. Ele transformou “um monte de contêineres” em algo que você pode operar dia após dia, mesmo quando servidores falham, releases acontecem e a demanda sobe.

O que orquestração realmente resolve

Kubernetes é frequentemente descrito como “orquestração de contêineres”, mas os problemas práticos são mais específicos:

- Agendamento: decidir qual máquina deve executar cada contêiner, com base em CPU/memória disponíveis e regras de posicionamento.

- Auto-recuperação: reiniciar contêineres que caíram, reprogramá-los se um nó morrer e manter o número desejado de instâncias.

- Escalonamento: aumentar ou diminuir réplicas conforme demanda, e implantar novas versões sem derrubar tudo.

Sem um orquestrador, equipes acabam criando scripts para esses comportamentos e gerenciando exceções manualmente — até que os scripts não correspondem mais à realidade.

Um plano de controle comum

Kubernetes popularizou a ideia de um control plane compartilhado: um lugar onde você declara o que quer (“rode 3 cópias deste serviço”) e a plataforma trabalha continuamente para fazer o mundo real igualar essa intenção.

Isso é uma grande mudança de responsabilidades:

- Desenvolvedores implantam: constroem uma imagem, aplicam um deployment, definem requests de recursos e health checks.

- A plataforma mantém em execução: posiciona workloads, substitui instâncias falhas, equilibra rollouts e mantém descoberta de serviços.

Construído a partir de padrões operacionais reais

Kubernetes não surgiu porque contêineres eram tendência. Ele cresceu a partir de lições aprendidas operando frotas grandes: trate infraestrutura como um sistema com loops de feedback, não como um conjunto de tarefas de servidor pontuais. Essa mentalidade operacional é o motivo pelo qual ele virou a ponte entre “conseguimos rodar contêineres” e “conseguimos rodá-los com confiabilidade em produção”.

O que “cloud-native” mudou na entrega diária

Ganhe créditos enquanto aprende

Ganhe créditos por conteúdo ou indicações enquanto explora o Koder.ai.

Cloud-native não introduziu apenas novas ferramentas — mudou o ritmo diário de entrega de software. Equipes passaram de “servidores artesanais e runbooks manuais” para sistemas projetados para serem dirigidos por APIs, automação e configuração declarativa.

De tickets e SSH para APIs e automação

Uma configuração cloud-native assume que infraestrutura é programável. Precisa de um banco de dados, um load balancer ou um novo ambiente? Em vez de esperar por configuração manual, equipes descrevem o que querem e deixam a automação criar.

A mudança chave é configuração declarativa: você define o estado desejado (“rode 3 cópias deste serviço, exponha na porta X, limite memória para Y”) e a plataforma trabalha para casar o mundo real com esse estado. Isso torna mudanças revisáveis, repetíveis e mais fáceis de reverter.

Implantações imutáveis reduzem deriva

A entrega tradicional frequentemente envolvia aplicar patches em servidores vivos. Ao longo do tempo, cada máquina ficava um pouco diferente — deriva de configuração que só aparece durante um incidente.

A entrega cloud-native empurrou equipes para implantações imutáveis: construa um artefato uma vez (geralmente uma imagem de contêiner), implante-o e, se precisar mudar, publique uma nova versão em vez de modificar o que está rodando. Com rollouts automatizados e health checks, isso reduz “quedas misteriosas” causadas por correções pontuais.

Contêineres facilitaram empacotar e rodar muitos serviços pequenos de forma consistente, o que incentivou arquiteturas de microserviços. Microserviços, por sua vez, aumentaram a necessidade de deploy, escalonamento e descoberta consistentes — áreas onde orquestração de contêineres se destaca.

O trade-off: mais serviços significam mais overhead operacional (monitoramento, rede, versionamento, resposta a incidentes). Cloud-native ajuda a gerenciar essa complexidade, mas não a elimina.

Portabilidade: real, mas não mágica

A portabilidade melhorou porque equipes padronizaram primitivas de deploy e APIs comuns. Ainda assim, “rodar em qualquer lugar” geralmente exige trabalho — diferenças em segurança, armazenamento, rede e serviços gerenciados importam. Cloud-native é melhor entendido como reduzir lock-in e atritos, não eliminá-los.

CNCF e o efeito de ecossistema: por que acelerou a adoção

Kubernetes não se espalhou só porque era poderoso. Espalhou porque ganhou um lar neutro, governança clara e um lugar onde empresas concorrentes podiam cooperar sem que um fornecedor “controlasse” as regras.

Uma fundação neutra torna a colaboração mais segura

A Cloud Native Computing Foundation (CNCF) criou governança compartilhada: tomada de decisões aberta, processos de projeto previsíveis e roadmaps públicos. Isso importa para times que apostam em infraestrutura central. Quando as regras são transparentes e não atreladas ao modelo de negócio de uma empresa, a adoção parece menos arriscada — e contribuições ficam mais atraentes.

O papel da CNCF: mais que um logo

Ao hospedar Kubernetes e projetos relacionados, a CNCF ajudou a transformar “uma ferramenta open source popular” em uma plataforma de longo prazo com suporte institucional. Ela forneceu:

- Uma forma consistente de gerenciar mantenedores, releases e práticas de segurança

- Um local para coordenação entre empresas

- Um sinal ao mercado: este projeto foi pensado para sobreviver além de um fornecedor

Padrões abertos e contribuidores diversos

Com muitos contribuidores (provedores de nuvem, startups, empresas e engenheiros independentes), Kubernetes evoluiu mais rápido e em direções do mundo real: rede, armazenamento, segurança e operações de day-2. APIs abertas e padrões facilitaram a integração de ferramentas, o que reduziu o lock-in e aumentou a confiança para uso em produção.

Efeito de ecossistema (e o trade-off)

A CNCF também acelerou uma explosão de ecossistema: service meshes, controladores de ingress, ferramentas CI/CD, engines de política, pilhas de observabilidade e mais. Essa abundância é força — mas cria sobreposição.

Para a maioria das equipes, sucesso vem de escolher um pequeno conjunto de componentes bem suportados, favorecer interoperabilidade e ser claro sobre propriedade. Uma abordagem “o melhor de tudo” frequentemente leva a ônus de manutenção em vez de melhor entrega.

De ferramentas para confiabilidade: a camada operacional que faltava

Escolha o plano certo

Comece no plano gratuito e depois evolua conforme as necessidades da sua equipe crescerem.

Contêineres e Kubernetes resolveram grande parte da pergunta “como rodamos software?”. Não resolveram automaticamente a mais difícil: “como o mantemos rodando quando usuários reais aparecem?” A camada que faltava é confiabilidade operacional — expectativas claras, práticas compartilhadas e um sistema que torna comportamentos corretos o padrão.

Defina a baseline de produção

Uma equipe pode entregar rápido e ainda estar a um deploy ruim da catástrofe se a baseline de produção não estiver definida. No mínimo, você precisa de:

- Observabilidade: habilidade de ver o que está acontecendo e por quê (não apenas se está “up”).

- Resposta a incidentes: papéis, plantões, caminhos de escalonamento e revisões pós-incidente.

- Planejamento de capacidade: entender carga, limites e como o sistema se comporta sob estresse.

Sem essa baseline, cada serviço inventa suas próprias regras e a confiabilidade vira questão de sorte.

DevOps e SRE introduziram hábitos importantes: propriedade, automação, confiabilidade mensurável e aprendizado a partir de incidentes. Mas hábitos por si só não escalam entre dezenas de equipes e centenas de serviços.

Plataformas tornam essas práticas repetíveis. SRE define metas (como SLOs) e loops de feedback; a plataforma fornece estradas pavimentadas para atendê-las.

Componentes “obrigatórios” de confiabilidade

Entrega confiável geralmente requer um conjunto consistente de capacidades:

- Logging, métricas, tracing (para debugar e melhorar)

- Alerting ligado a impacto no usuário (para que on-call não seja ruído)

- Rollbacks seguros e padrões de entrega progressiva (para que falhas não sejam catastróficas)

Uma boa plataforma incorpora esses padrões como defaults em templates, pipelines e políticas de runtime: dashboards padrão, regras comuns de alerta, guardrails de implantação e mecanismos de rollback. Assim a confiabilidade deixa de ser opcional e passa a ser um resultado previsível de se entregar software.

Ferramentas cloud-native podem ser poderosas e ainda parecer “demais” para a maioria dos times de produto. Engenharia de plataforma existe para fechar essa lacuna. A missão é simples: reduzir a carga cognitiva de times de aplicação para que possam entregar funcionalidades sem virar especialistas em infraestrutura.

Uma boa equipe de plataforma trata infraestrutura interna como produto. Isso significa usuários claros (desenvolvedores), resultados claros (entrega segura e repetível) e um loop de feedback. Em vez de entregar um monte de primitivos Kubernetes, a plataforma oferece maneiras opinativas de construir, implantar e operar serviços.

Uma lente prática é perguntar: “Um desenvolvedor consegue ir da ideia a um serviço em execução sem abrir uma dúzia de tickets?” Ferramentas que comprimem esse fluxo — preservando guardrails — estão alinhadas com o objetivo de plataforma cloud-native.

Blocos de construção que tornam cloud-native prático

A maioria das plataformas é um conjunto de “estradas pavimentadas” reutilizáveis que as equipes podem escolher por padrão:

- Templates e scaffolding para novos serviços (estrutura do repositório, CI, observabilidade base)

- Fluxos de autoatendimento (criar um ambiente, requisitar um banco, rotacionar segredos)

- Padrões de deploy padrão (ingress, autoscaling, health checks, releases canário)

O objetivo não é esconder Kubernetes — é empacotá-lo em defaults sensatos que previnam complexidade acidental.

Nesse espírito, Koder.ai pode ser usado como uma camada de “aceleração de DX” para equipes que querem criar ferramentas internas ou funcionalidades de produto rapidamente via chat, e depois exportar o código-fonte quando for hora de integrar a uma plataforma mais formal. Para equipes de plataforma, seu modo de planejamento e snapshots/rollback embutidos também podem espelhar a postura de confiabilidade que você quer em fluxos de trabalho de produção.

Trade-offs: flexibilidade vs consistência

Cada estrada pavimentada é um trade-off: mais consistência e operações mais seguras, mas menos opções pontuais. Equipes de plataforma têm melhor desempenho quando oferecem:

- um golden path para 80% dos serviços

- uma porta de saída para casos de borda legítimos (com propriedade explícita)

Sinais de que está funcionando

Você vê sucesso de plataforma de maneiras mensuráveis: onboarding mais rápido de novos engenheiros, menos scripts de deployment feitos sob medida, menos clusters “snowflake” e propriedade mais clara quando incidentes acontecem. Se equipes conseguem responder “quem possui este serviço e como entregamos?” sem uma reunião, a plataforma está cumprindo seu papel.

O que dá errado: armadilhas que retardam o progresso cloud-native

Cloud-native pode acelerar entrega e acalmar operações — mas só quando equipes sabem o que querem melhorar. Muitos retrocessos acontecem quando Kubernetes e seu ecossistema são tratados como objetivo, não como meio.

1) Primeiro Kubernetes, depois resultados

Erro comum é adotar Kubernetes porque é “o que times modernos fazem”, sem um alvo concreto como menor lead time, menos incidentes ou maior consistência de ambientes. O resultado é muito trabalho de migração sem ganho visível.

Se critérios de sucesso não são definidos desde o início, toda decisão vira subjetiva: qual ferramenta escolher, quanto padronizar e quando a plataforma está “pronta”.

2) Crescimento de complexidade do ecossistema

Kubernetes é uma fundação, não uma plataforma completa. Equipes costumam acrescentar complementos rapidamente — service mesh, múltiplos ingress controllers, operadores customizados, engines de política — sem limites claros ou dono.

Personalizações excessivas também são armadilha: padrões YAML sob medida, templates caseiros e exceções que só os autores entendem. A complexidade cresce, o onboarding desacelera e upgrades viram risco.

3) Custo, proliferação e pontos cegos de segurança

Cloud-native facilita criar recursos — e esquecê-los. Proliferação de clusters, namespaces não usados e workloads superprovisionados inflacionam custos silenciosamente.

Pitfalls de segurança são igualmente comuns:

- Permissões que crescem com o tempo (RBAC amplo, contas de serviço compartilhadas)

- Risco na cadeia de suprimento (imagens não avaliadas, muitos charts de terceiros)

- Políticas inconsistentes entre clusters e ambientes

4) Como mitigar (sem parar o progresso)

Comece pequeno com um ou dois serviços bem delimitados. Defina padrões cedo (golden paths, imagens base aprovadas, regras de upgrade) e mantenha a superfície da plataforma intencionalmente limitada.

Meça resultados como frequência de deploy, MTTR e tempo até o primeiro deploy do desenvolvedor — e trate qualquer coisa que não mova esses números como opcional.

Um playbook prático para aplicar essas lições

Uma especificação para web e mobile

Crie um app web e um app móvel em Flutter a partir dos mesmos requisitos.

Você não “adota cloud-native” de uma vez. As equipes que têm sucesso seguem a mesma ideia central associada à era de McLuckie: construa uma plataforma que torne o jeito certo o jeito fácil.

Um caminho simples de adoção

Comece pequeno, depois codifique o que funciona.

- Piloto: Escolha um serviço que seja doloroso o suficiente para justificar mudança, mas não crítico para o negócio. Containerize-o, automatize builds e faça deploys repetidos até que vire rotina.

- MVP de plataforma: Transforme os aprendizados do piloto em uma plataforma interna enxuta: templates padrão, um caminho de deploy pavimentado, observabilidade básica e um modelo claro de propriedade.

- Expansão: Onboard mais equipes e serviços usando os mesmos defaults. Priorize consistência em vez de customização.

- Otimização: Adicione políticas, controles de custo, fluxos de incidentes e recursos de autoatendimento quando o básico estiver estável.

Se você está experimentando novos fluxos, um padrão útil é prototipar a experiência end-to-end do “golden path” antes de padronizá-la. Por exemplo, times podem usar Koder.ai para gerar rapidamente um app web (React), backend (Go) e banco (PostgreSQL) via chat, e então tratar o código resultante como ponto de partida para templates da plataforma e convenções de CI/CD.

Perguntas de decisão para manter honestidade

Antes de adicionar uma ferramenta, pergunte:

- Por que contêineres? Qual fricção você está removendo (deriva de ambiente, empacotamento, portabilidade) e que novo trabalho você está assumindo?

- Por que orquestração? Você realmente precisa de escalonamento automatizado, rollouts e resiliência de serviço — ou automações mais simples bastariam?

- Por que agora? Isso é motivado por dor de entrega, risco de confiabilidade ou um objetivo de produto claro (não só pressão de tendência)?

Métricas que mostram progresso real

Monitore resultados, não uso de ferramentas:

- Frequência de deploy e lead time (velocidade de entrega)

- Confiabilidade (atingimento de SLOs, taxa de incidentes, MTTR)

- Satisfação do desenvolvedor (pequenas pesquisas, tempo de onboarding, “tempo até o primeiro deploy”)

Se quiser exemplos do que bons pacotes de “MVP de plataforma” parecem, veja /blog. Para orçamento e planejamento de rollout, você também pode consultar /pricing.

O próximo capítulo do cloud-native (e como se preparar)

A grande lição da última década é simples: contêineres não “venceram” porque eram um empacotamento esperto. Venceram porque pensamento de plataforma os tornou confiáveis — implantações repetíveis, rollouts seguros, controles de segurança consistentes e operações previsíveis.

O próximo capítulo não será sobre uma única ferramenta revolucionária. Será sobre fazer cloud-native parecer entediante no melhor sentido: menos surpresas, menos correções pontuais e um caminho mais suave do código à produção.

O que observar a seguir

Policy-as-code vira padrão. Em vez de revisar cada implantação manualmente, equipes codificam regras para segurança, rede e conformidade para que guardrails sejam automáticos e auditáveis.

Experiência do desenvolvedor (DX) passa a ser tratada como produto. Espere mais foco em estradas pavimentadas: templates, ambientes self-service e golden paths claros que reduzem carga cognitiva sem limitar autonomia.

Ops mais simples, não mais dashboards. As melhores plataformas esconderão complexidade: defaults opinativos, menos peças móveis e padrões de confiabilidade embutidos, não acoplados.

Evite a armadilha de colecionar ferramentas

O progresso cloud-native desacelera quando equipes correm atrás de features em vez de resultados. Se você não consegue explicar como uma nova ferramenta reduz lead time, diminui taxa de incidentes ou melhora postura de segurança, provavelmente não é prioridade.

Um próximo passo claro

Avalie seus pontos de dor na entrega atual e mapeie-os para necessidades de plataforma:

- Onde deploys falham ou atrasam com mais frequência?

- Quais aprovações e checagens deveriam virar guardrails automáticos?

- O que os desenvolvedores repetidamente reconstroem (e que poderia ser padronizado)?

Trate as respostas como backlog da plataforma — e meça sucesso pelos resultados que as equipes sentem toda semana.