Por que as previsões de AGI de Kurzweil importam

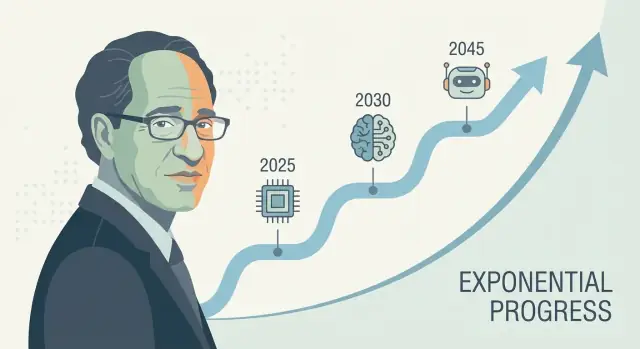

Ray Kurzweil é uma das vozes mais reconhecidas em previsões tecnológicas de longo prazo—especialmente sobre inteligência artificial e a singularidade tecnológica. Quando ele faz uma previsão concreta de AGI (frequentemente enquadrada como uma data, não um vago “algum dia”), isso tende a repercutir: investidores citam, jornalistas debatem e pesquisadores são solicitados a responder.

Por que as previsões dele atraem atenção

A influência de Kurzweil não é apenas sobre otimismo. É sobre oferecer uma narrativa repetível do porquê o progresso deve acelerar—frequentemente ligada ao crescimento exponencial em computação e à ideia de que cada geração de ferramentas ajuda a construir a próxima. Concorde ou não, ele fornece uma forma estruturada de discutir uma linha do tempo para inteligência artificial geral em vez de tratar o tema como pura ficção científica.

O que “prever décadas à frente” realmente significa

Uma previsão para décadas à frente é menos sobre adivinhar uma data no calendário e mais sobre projetar um conjunto de tendências: computação, custo, dados, algoritmos e a capacidade prática de construir sistemas que generalizem. A aposta é que essas curvas continuem a se mover—e que os “pedaços faltantes” de hoje sejam problemas de engenharia solucionáveis que encolhem conforme os insumos melhoram.

O que você vai aprender neste artigo

Este texto detalha:

- O método por trás das estratégias de previsão tecnológica de Kurzweil (o que ele mede e extrapola)

- Que evidências apoiam a visão de que os indicadores de progresso em IA estão se acelerando—e onde os dados são escassos

- As críticas mais fortes às previsões de IA que dependem de extrapolações lineares de crescimento exponencial

- Conclusões práticas para usar previsões como ferramentas de planejamento sem tratá‑las como certezas

Uma nota rápida sobre incerteza

Mesmo entre especialistas sérios, cronogramas para AGI variam amplamente porque dependem de suposições: o que “AGI” significa, quais gargalos importam mais e com que rapidez avanços se traduzem em produtos confiáveis. As linhas do tempo de Kurzweil são influentes não porque sejam garantidas, mas porque são específicas o bastante para serem testadas—e difíceis de ignorar.

Quem é Ray Kurzweil?

Ray Kurzweil é um inventor, autor e futurista americano conhecido por fazer previsões tecnológicas de longo alcance—e por fundamentá‑las com gráficos, dados históricos e prazos ousados.

Inventor, empreendedor e “detector de padrões”

Kurzweil ficou conhecido inicialmente por invenções práticas, especialmente em tecnologias de fala e texto. Ele criou empresas focadas em reconhecimento óptico de caracteres (OCR), texto‑para‑fala e ferramentas musicais, e passou décadas perto das restrições reais de produto: qualidade de dados, custos de hardware e o que os usuários realmente adotam. Essa mentalidade de construtor molda suas previsões—ele tende a tratar o progresso como algo que pode ser projetado e escalado.

Ele também trabalhou dentro de grandes organizações de tecnologia (incluindo o Google), o que reforça sua visão de que grandes saltos frequentemente vêm de investimento sustentado, melhores ferramentas e melhorias compostas—não apenas de avanços isolados.

Livros e ideias-chave que influenciam debates sobre AGI

A linha do tempo de Kurzweil para AGI é normalmente discutida através de seus livros populares, especialmente The Age of Spiritual Machines (1999) e The Singularity Is Near (2005). Essas obras argumentam que as tecnologias de informação melhoram de maneiras aceleradas e compostas—e que essa aceleração eventualmente produzirá máquinas com capacidades no nível humano (e depois além do humano).

Concorde ou não, sua escrita ajudou a definir os termos da conversa pública: progresso em IA como mensurável, orientado por tendências e (pelo menos em princípio) previsível.

Definições rápidas (para falarmos a mesma língua)

AGI (Inteligência Artificial Geral): um sistema de IA que pode aprender e executar uma ampla variedade de tarefas em nível aproximadamente humano, adaptando‑se a novos problemas sem ser estreitamente especializado.

Singularidade: termo de Kurzweil para um período em que o progresso tecnológico se torna tão rápido (e a IA tão capaz) que muda a sociedade de maneiras imprevisíveis e difíceis de modelar.

Linha do tempo: uma previsão com datas e marcos (por exemplo, “IA em nível humano até o ano X”), não apenas uma afirmação geral de que o progresso continuará.

Afirmativas centrais de Kurzweil sobre cronogramas de AGI

Kurzweil tem repetidamente argumentado que a inteligência artificial geral em nível humano é provável dentro da primeira metade do século XXI—mais notoriamente concentrada entre o final dos anos 2020 e a década de 2030 em palestras e livros públicos. Ele nem sempre é rígido sobre um ano único, mas a afirmação central é consistente: uma vez que poder de computação, dados e algoritmos ultrapassem certos limiares, sistemas igualarão a amplitude e adaptabilidade da cognição humana.

Como AGI se conecta à “singularidade”

No enquadramento de Kurzweil, AGI não é a linha de chegada—é um gatilho. Depois que máquinas alcançam (e depois superam) a inteligência geral em nível humano, o progresso se compõe: sistemas mais inteligentes ajudam a projetar sistemas ainda mais inteligentes, acelerando descobertas científicas, automação e integração humano–máquina. Essa dinâmica de composição é o que ele associa à ideia mais ampla de “singularidade tecnológica”: um período em que a mudança se torna tão rápida que a intuição cotidiana deixa de ser um guia confiável.

AGI vs. os sistemas de IA de hoje

Uma nuance chave em suas previsões é a definição de AGI. Os modelos líderes de hoje podem ser impressionantes em muitas tarefas, mas ainda tendem a ser:

- frágeis fora dos padrões de treinamento,

- fracos em planejamento de longo horizonte e ancoragem no mundo real,

- dependentes de objetivos e avaliações curados por humanos.

O “AGI” de Kurzweil implica um sistema que pode transferir aprendizado entre domínios, formar e perseguir objetivos em situações novas, e lidar de forma confiável com a variedade aberta do mundo real—não apenas sobressair em benchmarks.

Por que marcos são melhores que uma data única

Uma previsão em calendário é fácil de debater e difícil de usar. Marcos são mais práticos: aprendizado autônomo sustentado, uso confiável de ferramentas e planejamento, forte desempenho em ambientes reais e bagunçados, e substituição econômica clara em muitos tipos de trabalho. Mesmo que você discorde do timing exato, esses pontos de verificação tornam a previsão testável—e mais útil que apostar num único ano de manchete.

Histórico: acertos, erros e o que é debatível

Kurzweil é frequentemente descrito como um “preditor serial”, e essa reputação é parte do motivo pelo qual sua linha do tempo para AGI recebe atenção. Mas seu histórico é misto de um jeito útil para entender previsão: algumas previsões foram específicas e mensuráveis, outras estavam corretas em direção mas vagas, e algumas subestimaram restrições importantes.

Previsões notáveis frequentemente associadas a Kurzweil

Ao longo de livros e palestras, ele é relacionado a previsões como:

- computadores melhorando constantemente em custo/desempenho (continuação de tendências no estilo da lei de Moore)

- reconhecimento de fala tornando‑se amplamente utilizável para consumidores

- computação móvel e sempre conectada se tornando padrão

- IA superando humanos em tarefas estreitas (por exemplo, jogos, reconhecimento de padrões)

- aumento da integração humano–máquina (vestíveis, implantes, tecnologia assistiva)

Previsões claras e verificáveis vs. vagas

Previsões claras e verificáveis estão atreladas a uma data e um resultado mensurável: “até o ano X, a tecnologia Y alcançará a performance Z”, ou “a maioria dos dispositivos terá o recurso F.” Essas podem ser testadas contra benchmarks públicos (taxas de acurácia, dados de vendas/adoção, custos de computação).

Previsões vagas soam plausíveis mas são difíceis de falsificar, como “computadores estarão em toda parte”, “IA transformará a sociedade” ou “humanos se fundirão com tecnologia.” Essas podem parecer verdadeiras mesmo se os detalhes, timing ou mecanismos diferirem.

Como julgar “certo”, “parcialmente certo” e “errado” (sem marcar pontos)

Uma forma prática de avaliar qualquer previsor é separar direção, tempo e especificidade.

- Certo: o resultado corresponde à afirmação e o timing é próximo o bastante para ter guiado expectativas.

- Parcialmente certo: a direção está correta, mas o timing escorrega, a adoção é mais lenta ou o resultado chega em forma diferente (por exemplo, “funciona em demos” vs. “funciona para a maioria das pessoas, na maioria das vezes”).

- Errado: restrições chave foram subestimadas—limitações de dados, regulação, comportamento de usuários, custo ou a lacuna entre desempenho de laboratório e confiabilidade no mundo real.

O ponto não é rotular previsões como “boas” ou “ruins”. É notar como previsões confiantes e baseadas em dados ainda podem depender de suposições ocultas—especialmente quando envolvem adoção social, não apenas melhoria de hardware ou algoritmos.

A “Lei dos Retornos Acelerados” em linguagem simples

A “Lei dos Retornos Acelerados” de Kurzweil é a ideia de que quando uma tecnologia melhora, essas melhorias frequentemente tornam mais fácil melhorá‑la novamente. Isso cria um ciclo de retroalimentação onde o progresso acelera ao longo do tempo.

Tendências exponenciais, explicadas sem matemática

Uma tendência linear é como somar a mesma quantidade todo ano: 1, 2, 3, 4.

Uma tendência exponencial é como multiplicar: 1, 2, 4, 8. No começo parece lenta—depois parece que tudo acontece de uma vez. Kurzweil argumenta que muitas tecnologias (especialmente as de informação) seguem esse padrão porque cada geração de ferramentas ajuda a construir a próxima.

Kurzweil não pergunta apenas “Podemos fazer X?” Ele pergunta “Com que barato podemos fazer X?” Um padrão comum em computação é: performance sobe enquanto o custo cai. Quando o custo para rodar um modelo útil cai, mais gente pode experimentar, implantar produtos e financiar a próxima onda—acelerando o progresso.

Por isso ele presta atenção a curvas de longo prazo como “operações por dólar”, não apenas demos de destaque.

Onde a lei de Moore se encaixa—e onde não se encaixa

A lei de Moore é o exemplo clássico: por décadas, o número de transistores em chips dobrou em uma cadência regular, impulsionando computadores a ficarem mais rápidos e baratos.

O argumento de Kurzweil não é “a lei de Moore vai continuar para sempre.” É mais amplo: mesmo se uma abordagem de hardware desacelerar, outros métodos (chips melhores, GPUs/TPUs, paralelismo, novas arquiteturas, eficiência de software) podem manter a tendência geral de melhoria custo/performance.

Por que pensar linearmente engana

Pessoas frequentemente predizem o futuro estendendo a mudança recente na mesma velocidade. Isso perde a composição. Pode fazer o progresso inicial parecer pouco impressionante—e o progresso posterior parecer “repentino”, quando pode ter sido construído de forma previsível ao longo de uma curva por anos.

Que dados apoiam (e limitam) essas previsões

Crie o próximo experimento

Crie um app web a partir do chat e itere conforme suas suposições mudam.

Previsões como as de Kurzweil geralmente começam com tendências mensuráveis—coisas que você pode colocar num gráfico. Isso é uma força: você pode debater os insumos em vez de argumentar puramente por intuição. É também onde aparecem as maiores limitações.

As curvas “fáceis de medir”: computação, armazenamento, banda, custo

Previsores de tecnologia costumam acompanhar:

- Computação (quantas operações você pode comprar por dólar)

- Armazenamento (quanto dado você pode guardar por dólar)

- Banda (com que rapidez você pode mover dados e a que preço)

- Queda de custos (para chips, instâncias de nuvem, runs de treinamento e energia por unidade de trabalho)

Essas curvas são convincentes porque são de longa duração e frequentemente atualizadas. Se sua visão de AGI é “hardware suficiente mais o software certo”, esses conjuntos de dados podem parecer um alicerce sólido.

Progresso de hardware não é o mesmo que progresso de capacidade

A principal lacuna: mais hardware não produz automaticamente sistemas mais inteligentes. A capacidade de IA depende de algoritmos, qualidade de dados, receitas de treinamento, ferramentas e feedback humano—não apenas de FLOPs.

Uma maneira útil de pensar: hardware é um orçamento, capacidade é o resultado. A relação entre os dois é real, mas não fixa. Às vezes uma pequena mudança algorítmica libera grandes ganhos; outras vezes escalar esbarra em retornos decrescentes.

Por que benchmarks e uso real importam

Para conectar “insumos” (computação, dinheiro) a “resultados” (o que modelos realmente conseguem fazer), previsores precisam de:

- Benchmarks que meçam raciocínio, planejamento e generalização—não apenas casamentos de padrões

- Desempenho no mundo real em ambientes bagunçados: confiabilidade, segurança, tarefas de longo prazo e adaptabilidade

Benchmarks podem ser manipulados, então os sinais mais convincentes combinam pontuações de teste com evidência de utilidade durável.

Armadilhas comuns: gráficos arrumados, gargalos ocultos

Dois erros frequentes são selecionar curvas (escolher janelas de tempo que parecem mais exponenciais) e ignorar gargalos como restrições de energia, limites de dados, latência, regulação ou a dificuldade de transformar competência estreita em competência geral. Isso não acaba com a previsão—mas alarga as barras de erro.

Suposições-chave por trás de previsões para décadas à frente

Previsões de longo prazo para AGI—incluindo as de Kurzweil—dependem menos de um único “momento de ruptura” e mais de uma pilha de suposições que precisam se manter ao mesmo tempo. Se qualquer camada enfraquece, a data pode escorregar mesmo com o progresso continuando.

1) Computação, algoritmos e dados continuam a compor

A maioria das previsões de décadas assume três curvas subindo juntas:

- Escala de computação continua ficando mais barata e mais fácil de implantar (mais chips, maiores clusters, melhor utilização).

- Progresso algorítmico continua entregando ganhos de eficiência significativos—ou seja, cada unidade de computação rende mais capacidade do que antes.

- Disponibilidade de dados permanece suficiente, seja via novas fontes (dados multimodais), dados sintéticos, melhores ferramentas de rotulagem ou auto‑supervisão aprimorada.

Uma suposição oculta: esses três vetores não se substituem perfeitamente. Se a qualidade dos dados estagnar, “basta adicionar computação” pode render menos.

2) Restrições físicas e industriais não atrapalham demais

Previsões tratam frequentemente a computação como uma curva suave, mas a realidade passa por fábricas e redes elétricas.

Custos de energia, capacidade de fabricação de chips, controles de exportação, largura de banda de memória, equipamentos de rede e choques na cadeia de suprimentos podem limitar o ritmo de escalonamento de treinamento e implantação. Mesmo que a teoria diga “10× mais computação”, o caminho até lá pode ser acidentado e caro.

3) Sistemas humanos permitem implantação rápida

Previsões de décadas também assumem que a sociedade não freia muito a adoção:

Regulação, responsabilidade, confiança pública, integração no local de trabalho e ROI influenciam se sistemas avançados são treinados e amplamente usados—ou mantidos em ambientes estreitos e de alta fricção.

4) Ganhos de capacidade se traduzem em generalidade

Talvez a maior suposição é que melhorias de capacidade por escala (melhor raciocínio, planejamento, uso de ferramentas) convergirão naturalmente para inteligência geral.

“Mais computação” pode produzir modelos mais fluentes e úteis, mas não automaticamente mais gerais no sentido de transferência confiável entre domínios, autonomia de longo prazo ou metas estáveis. Cronogramas longos geralmente assumem que essas lacunas são problemas de engenharia—não barreiras fundamentais.

O que poderia atrasar a AGI (mesmo se as tendências subirem)

Coloque no ar rapidamente

Faça o deploy e hospede seu app quando estiver pronto, sem etapas extras de configuração.

Mesmo que poder computacional e tamanhos de modelos continuem a crescer, a AGI ainda pode demorar mais do que previsto por razões pouco relacionadas à velocidade bruta. Vários gargalos dizem respeito ao quê estamos construindo e como sabemos que funciona.

1) A definição do problema pode permanecer imprecisa

“AGI” não é um único recurso que se ativa. Uma definição útil geralmente implica um agente que pode aprender tarefas novas rapidamente, transferir habilidades entre domínios, planejar por longos horizontes, e lidar com metas bagunçadas e em mudança com alta confiabilidade.

Se o alvo continuar mudando—assistente conversacional vs. trabalhador autônomo vs. raciocinador no nível de cientista—o progresso pode parecer impressionante enquanto ainda falta capacidades-chave como memória de longo prazo, raciocínio causal ou tomada de decisão consistente.

2) Medir AGI é mais difícil do que medir GPUs

Benchmarks podem ser manipulados, sobreajustados ou ficar obsoletos. Céticos normalmente querem evidência de que uma IA pode ter sucesso em tarefas não vistas, sob restrições novas, com baixas taxas de erro e resultados repetíveis.

Se o campo não concordar sobre testes que separam convincentemente “excelente completude de padrões” de “competência geral”, cronogramas viram conjectura—e a cautela pode retardar a implantação.

3) Alinhamento e segurança podem virar o item limitador

Capacidade pode aumentar mais rápido que controlabilidade. Se sistemas se tornarem mais agentivos, o patamar sobe para prevenir engano, deriva de objetivos e efeitos colaterais nocivos.

Regulação, auditorias e engenharia de segurança podem acrescentar tempo mesmo se os modelos sobem rapidamente—especialmente em usos de alto risco.

4) Embarcação e interação no mundo real permanecem questões em aberto

Muitas definições de AGI implicam competência no mundo físico: manipular objetos, conduzir experimentos, operar ferramentas e adaptar‑se a feedback em tempo real.

Se o aprendizado no mundo real se mostrar sedento por dados, lento ou arriscado, a AGI pode ficar em “brilhante na tela” enquanto a generalidade prática espera por robótica melhor, simulação e métodos de treinamento seguros.

Principais críticas à abordagem de Kurzweil

As previsões de Kurzweil são influentes em parte porque são claras e quantitativas—mas essa mesma clareza convida críticas afiadas.

Uma objeção comum é que Kurzweil apoia‑se fortemente em estender curvas históricas (computação, armazenamento, banda) para o futuro. Críticos afirmam que a tecnologia nem sempre escala suavemente: progresso em chips pode desacelerar, custos de energia podem punir, e incentivos econômicos podem mudar. Mesmo que a direção de longo prazo seja ascendente, a taxa pode mudar de formas que tornam datas específicas pouco confiáveis.

2) Sistemas complexos não entregam avanços segundo um cronograma

AGI não é só questão de hardware mais rápido. É um problema de sistemas complexos envolvendo algoritmos, dados, métodos de treinamento, avaliação, restrições de segurança e adoção humana. Avanços podem ficar presos por uma única ideia faltante—algo que você não pode simplesmente “calendário”. Céticos apontam que a ciência frequentemente avança por passos desiguais: longos platôs seguidos por saltos súbitos.

3) Efeitos de seleção fazem previsões ousadas parecerem melhores

Outra crítica é psicológica: lembramos chamadas corretas dramáticas mais do que os erros mais discretos ou os quase‑acertos. Se alguém faz muitas previsões fortes, alguns acertos memoráveis podem dominar a percepção pública. Isso não significa que o previsor esteja “errado”, mas pode inflar a confiança na precisão das linhas do tempo.

4) Por que pessoas inteligentes discordam sobre cronogramas

Mesmo especialistas que aceitam progresso rápido em IA divergem sobre o que “conta” como AGI, quais capacidades devem se generalizar e como medi‑las. Pequenas diferenças definicionais (amplitude de tarefas, autonomia, confiabilidade, aprendizado no mundo real) podem deslocar previsões por décadas—sem que ninguém mude sua visão subjacente sobre o progresso atual.

Como outros especialistas prevêem cronogramas de AGI

Kurzweil é uma voz alta, mas cronogramas de AGI são um debate amplo. Uma maneira útil de mapear é o campo de curto prazo (AGI em anos a algumas décadas) versus o longo prazo (várias décadas ou “não neste século”). Frequentemente olham as mesmas tendências mas discordam sobre o que falta: os otimistas de curto prazo enfatizam escala rápida e capacidades emergentes, enquanto os de longo prazo enfatizam problemas não resolvidos como raciocínio confiável, autonomia e robustez no mundo real.

Pesquisas com especialistas agregam crenças de pesquisadores e praticantes (por exemplo, enquetes perguntando quando há 50% de chance de “IA em nível humano”). Essas revelam mudanças de sentimento ao longo do tempo, mas também refletem quem foi consultado e como as perguntas foram formuladas.

Planejamento de cenários evita escolher uma data única. Em vez disso, descreve múltiplos futuros plausíveis (progresso rápido, progresso lento, gargalos regulatórios, limitações de hardware) e pergunta quais sinais indicariam cada caminho.

Previsão baseada em benchmarks e capacidades acompanha marcos concretos (tarefas de codificação, raciocínio científico, confiabilidade de agentes) e estima que taxa de melhoria seria necessária para atingir competência mais ampla.

Definições mudam a data

“AGI” pode significar passar uma suíte ampla de testes, fazer a maioria dos trabalhos, operar como agente autônomo ou igualar humanos em domínios com supervisão mínima. Uma definição mais estrita geralmente empurra cronogramas para mais tarde, e a discordância aqui explica boa parte da variação.

O mais próximo de consenso: incerteza

Mesmo otimistas e céticos tendem a concordar numa coisa: cronogramas são altamente incertos, e previsões devem ser tratadas como intervalos com suposições—não compromissos de calendário.

Sinais a observar nos próximos 5–10 anos

Prototipe, não apenas preveja

Transforme suas ideias de cronograma de IA em um protótipo funcional sem um longo desenvolvimento.

Previsões sobre AGI podem parecer abstratas, então ajuda acompanhar sinais concretos que deveriam se mover antes de qualquer “grande momento”. Se cronogramas ao estilo Kurzweil estiverem na direção certa, a próxima década deve mostrar ganhos constantes em capacidade, confiabilidade, economia e governança.

1) Indicadores de capacidade (o que os sistemas realmente conseguem)

Observe modelos que planejam de forma confiável em muitos passos, se adaptam quando planos falham e usam ferramentas (código, navegadores, apps de dados) sem supervisão constante. O sinal mais significativo não é uma demo chamativa—é autonomia com limites claros: agentes que completam tarefas de várias horas, fazem perguntas de esclarecimento e entregam trabalho de forma segura quando incertos.

Progresso vai parecer redução nas taxas de erro em fluxos de trabalho realistas, não apenas maior pontuação em benchmarks. Acompanhe se as “alucinações” caem quando sistemas são exigidos a citar fontes, rodar verificações ou auto‑verificar. Um marco chave: desempenho forte sob condições de auditoria—mesma tarefa, múltiplas execuções, resultados consistentes.

3) Indicadores econômicos (onde aparece valor)

Procure por ganhos de produtividade mensuráveis em papéis específicos (suporte, análise, software, operações), junto com novas categorias de trabalho centradas em supervisionar e integrar IA. Custos importam também: se produção de alta qualidade fica mais barata (por tarefa, por hora), a adoção acelera—especialmente para equipes pequenas.

4) Indicadores de governança (como a sociedade responde)

Se a capacidade aumenta, a governança deve sair de princípios para prática: padrões, auditorias independentes, relatórios de incidentes e regulação que clareia responsabilidade. Observe também regras de monitoramento/reporting de computação—sinais de que governos e indústria tratam a escala como uma alavanca rastreável e controlável.

Se quiser usar esses sinais sem reagir demais a manchetes, veja /blog/ai-progress-indicators.

Conclusões práticas: usar previsões sem confiar cegamente nelas

Cronogramas de AGI funcionam melhor como previsões meteorológicas para uma data distante: úteis para planejamento, pouco confiáveis como promessa. Previsões no estilo Kurzweil podem ajudá‑lo a notar tendências de longo prazo e a testar decisões, mas não devem ser o único ponto de falha na sua estratégia.

Como ler previsões de AGI (sem tratá‑las como garantias)

Use previsões para explorar intervalos e cenários, não um único ano. Se alguém diz “AGI até 203X”, traduza para: “Que mudanças teriam de acontecer para que isso seja verdade—e e se não acontecerem?” Então planeje para múltiplos desfechos.

Perguntas a fazer sobre qualquer previsão

- Definição: O que eles querem dizer por “AGI”? Nível humano em testes, utilidade ampla no trabalho ou “pode aprender qualquer coisa”? Definições diferentes produzem cronogramas diferentes.

- Dados: Quais indicadores usam—computação, eficiência de treino, benchmarks, taxas de implantação—e o que ignoram?

- Suposições: Assumem progresso contínuo em algoritmos, dados, energia, chips e governança?

- Incentivos: Estão vendendo um produto, captando fundos ou defendendo política? Incentivos podem afetar certeza e prazos.

Planejamento prático: habilidades, estratégia e consciência de risco

Para indivíduos: desenvolva habilidades duráveis (definição de problemas, expertise de domínio, comunicação) e mantenha o hábito de aprender novas ferramentas.

Para empresas: invista em alfabetização em IA, qualidade de dados e projetos-piloto com ROI claro—enquanto mantém um plano “sem arrependimentos” que funcione mesmo se a AGI chegar mais tarde.

Uma forma pragmática de operacionalizar “observar sinais e iterar” é encurtar ciclos de construção: prototipar fluxos de trabalho, testar confiabilidade e quantificar ganhos de produtividade antes de fazer grandes apostas. Plataformas como Koder.ai encaixam esse método ao permitir que equipes criem apps web, backend e mobile via interface de chat (com modo de planejamento, snapshots e rollback), assim você pode testar processos assistidos por agentes rapidamente, exportar código-fonte quando necessário e evitar amarrar a estratégia a uma única previsão.

Uma conclusão equilibrada: cronogramas podem guiar preparação, não garantir certeza. Use‑os para priorizar experimentos e reduzir pontos cegos—e revise suas suposições regularmente à medida que novas evidências surgem.