Visão geral: por que a história da OpenAI importa

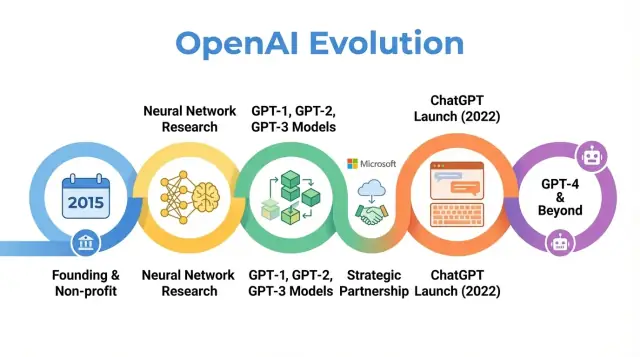

A OpenAI é uma empresa de pesquisa e implantação de IA cujo trabalho moldou a forma como as pessoas pensam sobre inteligência artificial, desde artigos de pesquisa iniciais até produtos como o ChatGPT. Entender como a OpenAI evoluiu — de um pequeno laboratório sem fins lucrativos em 2015 até um ator central em IA — ajuda a explicar por que a IA moderna é como é hoje.

A história da OpenAI não é apenas uma sequência de lançamentos de modelos. É um estudo de caso sobre como missão, incentivos, avanços técnicos e pressão pública interagem. A organização começou com forte ênfase em pesquisa aberta e benefício amplo, depois se reestruturou para atrair capital, formou uma parceria profunda com a Microsoft e lançou produtos usados por centenas de milhões de pessoas.

Por que essa história importa

Traçar a história da OpenAI ilumina várias tendências mais amplas em IA:

-

Missão e valores: A OpenAI foi fundada com o objetivo declarado de garantir que a inteligência artificial geral beneficie toda a humanidade. Como essa missão foi interpretada e revisada ao longo do tempo revela tensões entre metas idealistas e realidades comerciais.

-

Avanços de pesquisa: A progressão de projetos iniciais para sistemas como GPT‑3, GPT‑4, DALL·E e Codex acompanha uma mudança maior rumo a modelos de base em larga escala que alimentam muitas aplicações atuais de IA.

-

Governança e estrutura: A transição de um puro sem fins lucrativos para uma entidade de lucro limitado, e a criação de mecanismos de governança complexos, destacam como novas formas organizacionais estão sendo testadas para gerenciar tecnologias poderosas.

-

Impacto público e escrutínio: Com o ChatGPT e outros lançamentos, a OpenAI passou de um laboratório conhecido principalmente em círculos de IA para um nome familiar, atraindo atenção para segurança, alinhamento e debates regulatórios que agora moldam discussões de políticas em todo o mundo.

Este artigo acompanha a jornada da OpenAI de 2015 aos seus desenvolvimentos mais recentes, mostrando como cada fase reflete mudanças maiores na pesquisa, economia e governança da IA — e o que isso pode significar para o futuro do campo.

Fundando a OpenAI: missão e equipe inicial

O momento de 2015 na IA

A OpenAI foi fundada em dezembro de 2015, num ponto em que o aprendizado de máquina — especialmente o deep learning — melhorava rapidamente, mas ainda estava longe de inteligência geral. Marcos em reconhecimento de imagens estavam sendo superados, sistemas de fala melhoravam e empresas como Google, Facebook e Baidu investiam fortemente em IA.

Uma preocupação crescente entre pesquisadores e líderes de tecnologia era que IA avançada pudesse ficar controlada por um punhado de corporações poderosas ou governos. A OpenAI foi concebida como um contrapeso: uma organização de pesquisa focada em segurança de longo prazo e na ampla distribuição dos benefícios da IA, em vez de vantagem comercial estreita.

Missão: AGI para o benefício de todos

Desde o primeiro dia, a OpenAI definiu sua missão em termos de inteligência artificial geral (AGI), não apenas progresso incremental em aprendizado de máquina. A declaração central era que a OpenAI trabalharia para garantir que a AGI, se criada, “beneficie toda a humanidade”.

Essa missão teve várias implicações concretas:

- Priorizar pesquisas de segurança e questões de alinhamento de longo prazo

- Comprometer‑se a compartilhar pesquisas, código e insights amplamente quando possível

- Evitar uma dinâmica de corrida de winner‑take‑all colaborando com outras instituições

Posts públicos iniciais e a carta fundadora enfatizavam tanto a abertura quanto a cautela: a OpenAI publicaria grande parte de seu trabalho, mas também consideraria o impacto social de liberar capacidades poderosas.

Fundadores, líderes iniciais e estrutura

A OpenAI começou como um laboratório de pesquisa sem fins lucrativos. Os compromissos iniciais de financiamento foram anunciados em torno de US$ 1 bilhão em promessas de apoio, embora isso fosse um compromisso de longo prazo e não caixa à vista. Apoiadores iniciais incluíam Elon Musk, Sam Altman, Reid Hoffman, Peter Thiel, Jessica Livingston e YC Research, além de suporte de empresas como Amazon Web Services e Infosys.

A equipe de liderança inicial combinou experiência em startups, pesquisa e operações:

- Sam Altman – cofundador e presidente inicial do conselho (posteriormente CEO)

- Elon Musk – cofundador e doador inicial, membro do conselho no período inicial

- Greg Brockman – ex‑CTO da Stripe, entrou como CTO e cofundador

- Ilya Sutskever – pesquisador líder em deep learning, entrou como cientista chefe

- Wojciech Zaremba e John Schulman – cofundadores e líderes centrais de pesquisa

Essa mistura de empreendedorismo do Vale do Silício e pesquisa de alto nível moldou a cultura inicial da OpenAI: muito ambiciosa em expandir a fronteira de capacidades de IA, mas organizada como um sem fins lucrativos orientado por missão com foco em impacto global de longo prazo, em vez de comercialização imediata.

Era sem fins lucrativos: pesquisa inicial e ciência aberta

Quando a OpenAI foi lançada como um laboratório de pesquisa sem fins lucrativos em 2015, sua promessa pública era simples, porém ambiciosa: avançar a inteligência artificial enquanto compartilhava o máximo possível com a comunidade.

Aberta por padrão

Os primeiros anos foram definidos por uma filosofia “aberta por padrão”. Artigos de pesquisa eram postados rapidamente, o código costumava ser liberado e ferramentas internas foram transformadas em projetos públicos. A ideia era que acelerar o progresso científico amplo — e a fiscalização pública — seria mais seguro e benéfico do que concentrar capacidades dentro de uma única empresa.

Ao mesmo tempo, a segurança já fazia parte da conversa. A equipe discutia quando a abertura poderia aumentar riscos de uso indevido e começou a esboçar ideias para liberação em etapas e revisões de políticas, mesmo que essas ideias ainda fossem informais se comparadas com processos de governança posteriores.

Áreas de pesquisa emblemáticas

O foco científico inicial da OpenAI abrangeu várias áreas centrais:

- Aprendizado por reforço (RL): Trabalho com agentes dominando jogos como Dota 2 e tarefas de controle complexas ajudou a avançar algoritmos de RL, métodos de exploração e escalabilidade.

- Robótica: Experimentos com mãos robóticas resolvendo tarefas de manipulação mostraram como RL e simulação podiam ser transferidos para o mundo físico.

- Aprendizado não supervisionado e auto-supervisionado: Pesquisadores exploraram como modelos poderiam aprender a partir de grandes conjuntos de dados não rotulados, prenunciando os futuros modelos de base.

Esses projetos tinham menos a ver com produtos polidos e mais com testar o que era possível com deep learning, poder de computação e regimes de treinamento inteligentes.

Ferramentas que moldaram uma comunidade

Dois dos outputs mais influentes dessa era foram o OpenAI Gym e o Universe.

- OpenAI Gym forneceu um conjunto comum de ambientes e métricas para RL. Padronizou como pesquisadores comparavam algoritmos e reduziu drasticamente a barreira de entrada para novos laboratórios e estudantes.

- Universe tinha como objetivo treinar e avaliar agentes em uma grande variedade de ambientes de software existentes, de jogos a aplicativos web. Embora o Universe tenha sido eventualmente descontinuado, ele cristalizou o interesse em agentes de propósito geral.

Ambos os projetos refletiam um compromisso com infraestrutura compartilhada em vez de vantagem proprietária.

Como pares e mídia viam a OpenAI

Durante esse período sem fins lucrativos, a OpenAI frequentemente foi retratada como um contrapeso orientado por missão aos grandes laboratórios de IA das gigantes de tecnologia. Pares valorizavam a qualidade da pesquisa, a disponibilidade de código e ambientes, e a disposição em engajar discussões sobre segurança.

A cobertura da mídia enfatizava a combinação incomum de financiadores de alto perfil, estrutura não comercial e a promessa de publicar abertamente. Essa reputação — como um laboratório aberto e influente preocupado com consequências de longo prazo — estabeleceu expectativas que mais tarde moldaram reações a cada mudança estratégica da organização.

Construindo modelos poderosos: de GPT‑1 ao GPT‑3

O ponto de virada na história da OpenAI foi a decisão de focar em grandes modelos de linguagem baseados em transformadores. Essa mudança transformou a OpenAI de um laboratório principalmente focado em pesquisa para uma empresa conhecida por modelos de base que outros constroem.

O GPT‑1 era modesto pelos padrões posteriores — 117 milhões de parâmetros, treinado no BookCorpus — mas ofereceu uma prova de conceito crucial.

Em vez de treinar modelos separados para cada tarefa de PNL, o GPT‑1 mostrou que um único modelo transformador, treinado com um objetivo simples (prever a próxima palavra), podia ser adaptado com fine‑tuning mínimo para tarefas como perguntas e respostas, análise de sentimento e entailment textual.

Para o roadmap interno da OpenAI, o GPT‑1 validou três ideias:

- Escala importa: modelos maiores com mais dados performam melhor de forma surpreendentemente geral.

- Pré‑treinamento + fine‑tuning pode superar sistemas específicos de tarefa.

- Transformadores são uma arquitetura poderosa para linguagem.

GPT‑2: capacidades e preocupações de uso indevido (2019)

O GPT‑2 levou a mesma receita básica muito mais longe: 1,5 bilhão de parâmetros e um conjunto de dados derivado da web muito maior. Seus outputs eram frequentemente surpreendentemente coerentes: artigos de múltiplos parágrafos, histórias fictícias e resumos que, num relance, pareciam escritos por humanos.

Essas capacidades levantaram alarmes sobre possíveis usos indevidos: propaganda automatizada, spam, assédio e notícias falsas em larga escala. Em vez de liberar o modelo completo imediatamente, a OpenAI adotou uma estratégia de liberação escalonada:

- Primeiro lançamento de um modelo menor, com artigo técnico e exemplos

- Continuação de testes internos e externos para explorar usos indevidos

- Liberação gradual de versões maiores conforme a OpenAI avaliava riscos

Esse foi um dos primeiros exemplos de alto perfil da OpenAI ligando explicitamente decisões de implantação à segurança e impacto social, e moldou como a organização pensou sobre divulgação, abertura e responsabilidade.

GPT‑3: escala, generalidade e a API (2020)

O GPT‑3 aumentou novamente a escala — desta vez para 175 bilhões de parâmetros. Em vez de confiar principalmente em fine‑tuning para cada tarefa, o GPT‑3 demonstrou aprendizado “few‑shot” e até “zero‑shot”: o modelo muitas vezes podia realizar uma nova tarefa apenas a partir de instruções e alguns exemplos no prompt.

Esse nível de generalidade mudou a forma como tanto a OpenAI quanto a indústria em geral pensavam sobre sistemas de IA. Em vez de criar muitos modelos estreitos, um grande modelo podia servir como motor de propósito geral para:

- Redação publicitária e geração de conteúdo

- Trechos de código e autocompletar

- Perguntas e respostas, chat e aumento de buscas

Crucialmente, a OpenAI decidiu não open‑sourcear o GPT‑3. O acesso foi oferecido por meio de uma API comercial. Essa decisão marcou um pivô estratégico:

- De publicar modelos para operá‑los como serviço gerenciado

- De laboratório de pesquisa pura para provedor de plataforma com clientes pagantes

- De demos pontuais para um ecossistema de desenvolvedores construindo sobre os modelos da OpenAI

GPT‑1, GPT‑2 e GPT‑3 traçam um arco claro na história da OpenAI: escalar transformadores, descobrir capacidades emergentes, lidar com segurança e uso indevido, e assentar a base comercial que depois sustentaria produtos como o ChatGPT e o desenvolvimento contínuo do GPT‑4 e além.

Reestruturando a organização: OpenAI LP e modelo de lucro limitado

Por volta de 2018, os líderes da OpenAI estavam convencidos de que permanecer um pequeno laboratório financiado por doações não seria suficiente para construir e guiar com segurança sistemas de IA muito grandes. Treinar modelos de fronteira já exigia dezenas de milhões de dólares em computação e talento, com curvas de custo apontando para valores bem maiores. Para competir por pesquisadores de topo, realizar experimentos em escala e garantir acesso de longo prazo a infraestrutura em nuvem, a OpenAI precisava de uma estrutura que atraísse capital sério sem abandonar sua missão original.

Por que a OpenAI LP foi criada

Em 2019, a OpenAI lançou a OpenAI LP, uma nova sociedade limitada de “lucro limitado”. O objetivo era desbloquear grandes investimentos externos mantendo a missão do sem fins lucrativos — assegurar que a AGI beneficie toda a humanidade — no topo da hierarquia de tomada de decisões.

Startups tradicionais financiadas por venture capital são, em última instância, responsáveis por acionistas que buscam retornos sem limite. Os fundadores da OpenAI temiam que isso criasse pressão forte para priorizar lucro em detrimento de segurança, abertura ou implantação cuidadosa. A estrutura LP foi um compromisso: permitir emissão de interesses semelhantes a ações e captar recursos em escala, mas sob um conjunto diferente de regras.

Como funciona o modelo de lucro limitado

No modelo de lucro limitado, investidores e funcionários podem obter retornos sobre suas participações na OpenAI LP, mas apenas até um múltiplo fixo do investimento original (para investidores iniciais, frequentemente citado como até 100x, com limites menores em tranches posteriores). Uma vez atingido esse limite, qualquer valor adicional criado deve, em teoria, fluir para a entidade sem fins lucrativos controladora para ser usado alinhado à sua missão.

Isso contrasta fortemente com startups típicas, onde o valor de participação pode, teoricamente, crescer sem limites e onde maximizar o valor ao acionista é o padrão legal e cultural.

Relação entre o sem fins lucrativos e a LP

A OpenAI sem fins lucrativos permanece a entidade controladora. Seu conselho supervisiona a OpenAI LP e é incumbido de priorizar os interesses da humanidade acima dos de qualquer grupo particular de investidores ou funcionários.

Formalmente:

- O sem fins lucrativos detém a participação de controle na OpenAI LP.

- O conselho do sem fins lucrativos nomeia a liderança-chave e, em princípio, pode reverter decisões que conflitem com a missão.

- O dever fiduciário é enquadrado em torno da carta do sem fins lucrativos, não de otimização financeira pura.

Esse desenho de governança pretende dar à OpenAI flexibilidade para captar recursos e contratar como uma organização comercial, mantendo controle de missão.

Debates e impacto no financiamento e contratação

A reestruturação gerou debate dentro e fora da organização. Defensores argumentaram que era a única maneira prática de assegurar os bilhões provavelmente necessários para pesquisas de ponta em IA, mantendo limitações sobre incentivos de lucro. Críticos questionaram se qualquer estrutura que ofereça retornos elevados poderia realmente resistir à pressão comercial e se os limites eram suficientemente baixos ou claramente aplicáveis.

Na prática, a OpenAI LP abriu portas para grandes investimentos estratégicos, notadamente da Microsoft, e permitiu à empresa oferecer pacotes de remuneração competitivos vinculados a potencial upside. Isso, por sua vez, viabilizou a ampliação de equipes de pesquisa, execuções de treinamento para modelos como GPT‑3 e GPT‑4, e a construção da infraestrutura necessária para implantar sistemas como o ChatGPT em escala global — tudo isso mantendo um vínculo de governança formal com suas origens sem fins lucrativos.

Mantenha controle total do código

Tenha o projeto como seu exportando o código-fonte quando estiver pronto para avançar.

Investimento de 2019 e acordo de longo prazo

Em 2019, OpenAI e Microsoft anunciaram uma parceria multianual que remodelou os papéis de ambas as empresas em IA. A Microsoft investiu um valor reportado em US$ 1 bilhão, combinando dinheiro e créditos do Azure, em troca de se tornar parceira comercial preferencial da OpenAI.

O acordo alinhou a necessidade da OpenAI por recursos massivos de computação para treinar modelos cada vez maiores, enquanto dava à Microsoft acesso a IA de ponta que poderia diferenciar seus produtos e plataforma em nuvem. Ao longo dos anos subsequentes, a relação se aprofundou por meio de financiamentos adicionais e colaboração técnica.

Azure como espinha dorsal em nuvem da OpenAI

A OpenAI escolheu o Microsoft Azure como sua plataforma primária em nuvem por várias razões:

- Escala e hardware customizado: o Azure comprometeu‑se a construir clusters especializados com milhares de GPUs (e mais tarde aceleradores customizados) otimizados para treinamento em larga escala.

- Co‑engenharia: engenheiros da OpenAI trabalharam próximos aos times do Azure para otimizar rede, armazenamento e orquestração especificamente para grandes modelos de linguagem.

- Estrutura financeira: o investimento e os créditos de nuvem reduziram o custo inicial de experimentos que seriam proibitivamente caros em outros lugares.

Isso tornou o Azure o ambiente padrão para treinar e servir modelos como GPT‑3, Codex e mais tarde o GPT‑4.

Co‑desenvolvendo infraestrutura de supercomputação

A parceria levou à construção de um dos maiores sistemas de supercomputação para IA do mundo, baseado no Azure para cargas de trabalho da OpenAI. A Microsoft destacou esses clusters como exemplos de ponta das capacidades de IA do Azure, enquanto a OpenAI os usou para ampliar tamanho de modelos, dados de treinamento e velocidade de experimentação.

Esse esforço conjunto de infraestrutura apagou um pouco a linha entre “cliente” e “parceiro”: a OpenAI influenciou efetivamente o roadmap de IA do Azure, e o Azure foi ajustado às necessidades da OpenAI.

Licenciamento, produtos e percepção pública

A Microsoft recebeu direitos de licenciamento exclusivos sobre algumas tecnologias da OpenAI, notadamente o GPT‑3. Isso permitiu à Microsoft incorporar modelos da OpenAI em seus produtos — Bing, Office, GitHub Copilot, Azure OpenAI Service — enquanto outras empresas acessavam esses modelos via a própria API da OpenAI.

Essa exclusividade alimentou debates: defensores argumentaram que ela fornecia o financiamento e a distribuição necessários para escalar IA poderosa com segurança; críticos temiam que concentrasse influência sobre modelos de fronteira em uma única grande empresa.

Ao mesmo tempo, a parceria deu à OpenAI visibilidade mainstream. O branding da Microsoft, integrações de produto e canais de venda enterprise ajudaram a mover sistemas da OpenAI de demos de pesquisa para ferramentas do dia a dia usadas por milhões, moldando a percepção pública da OpenAI tanto como um laboratório independente quanto como um parceiro central da Microsoft.

Avanços além do texto: CLIP, DALL·E e Codex

À medida que os modelos da OpenAI melhoraram em entender e gerar linguagem, a equipe avançou para novas modalidades: imagens e código. Essa mudança expandiu o trabalho da OpenAI de escrita e diálogo para criatividade visual e desenvolvimento de software.

CLIP: conectando imagens e linguagem

O CLIP (Contrastive Language–Image Pretraining), anunciado no início de 2021, foi um passo importante em direção a modelos que entendem o mundo de maneira mais parecida com humanos.

Em vez de treinar apenas em imagens rotuladas, o CLIP aprendeu a partir de centenas de milhões de pares imagem‑legenda raspados da web pública. Foi treinado para casar imagens com suas descrições textuais mais prováveis e distingui‑las de descrições incorretas.

Isso deu ao CLIP habilidades surpreendentemente gerais:

- Reconhecer objetos e estilos sem treinamento específico por tarefa

- Seguir prompts em linguagem natural (por exemplo, “uma foto de um gato tigrado”) para classificar imagens

- Servir como uma base visual flexível para outros sistemas

O CLIP tornou‑se uma fundação para trabalhos gerativos visuais posteriores na OpenAI.

DALL·E e DALL·E 2: criatividade texto‑para‑imagem

O DALL·E (2021) aplicou arquiteturas à la GPT a imagens, gerando imagens diretamente a partir de prompts textuais: “uma poltrona em forma de abacate” ou “uma placa de vitrine que diz ‘openai’”. Demonstrou que modelos de linguagem podiam ser estendidos para produzir imagens coerentes e, por vezes, bem-humoradas.

O DALL·E 2 (2022) melhorou significativamente resolução, realismo e controlabilidade. Introduziu recursos como:

- Inpainting: editar partes de uma imagem existente via texto

- Outpainting: estender uma imagem além de seus limites originais

- Controle de estilo e composição: direcionar a saída com prompts detalhados

Esses sistemas mudaram como designers, profissionais de marketing, artistas e amadores prototipam ideias, deslocando parte do trabalho criativo manual para exploração iterativa guiada por prompts.

Codex e o futuro do desenvolvimento de software

O Codex (2021) pegou a família GPT‑3 e a adaptou para código‑fonte, treinando em grandes repositórios públicos. Ele pode traduzir linguagem natural em trechos funcionais para linguagens como Python, JavaScript e muitas outras.

O GitHub Copilot, construído sobre o Codex, trouxe isso para ferramentas de desenvolvimento do dia a dia. Programadores começaram a receber funções inteiras, testes e boilerplate como sugestões, usando comentários em linguagem natural como orientação.

Para o desenvolvimento de software, o Codex sugeriu uma mudança gradual:

- De escrever cada linha manualmente para supervisionar e refinar rascunhos gerados por IA

- De memorizar sintaxe para focar em arquitetura, intenção e revisão

Juntos, CLIP, DALL·E e Codex mostraram que a abordagem da OpenAI podia se estender além do texto para visão e código, ampliando o impacto de sua pesquisa em arte, design e engenharia.

ChatGPT e os holofotes públicos

Publique com sua marca

Coloque seu projeto em um domínio personalizado quando estiver pronto para compartilhar.

Lançamento e adoção explosiva

A OpenAI lançou o ChatGPT como um “preview de pesquisa” gratuito em 30 de novembro de 2022, anunciando‑o em um post curto no blog e em um tweet, em vez de uma grande campanha de produto. O modelo baseava‑se no GPT‑3.5 e foi otimizado para diálogo, com salvaguardas para recusar alguns pedidos nocivos ou inseguros.

O uso disparou quase imediatamente. Milhões de pessoas se inscreveram em dias, e o ChatGPT se tornou um dos aplicativos de consumo que mais cresceu na história. Capturas de tela de conversas inundaram redes sociais enquanto usuários testavam sua capacidade de escrever ensaios, depurar código, redigir e‑mails e explicar tópicos complexos em linguagem simples.

Uso cotidiano no trabalho, na escola e em casa

O apelo do ChatGPT veio de sua versatilidade, não de um caso de uso único.

Na educação, estudantes o usaram para resumir leituras, gerar questões de prática, traduzir ou simplificar artigos acadêmicos e obter explicações passo a passo de problemas de matemática e ciência. Professores experimentaram usá‑lo para elaborar ementas, rascunhar rubricas e criar materiais diferenciados, enquanto escolas debatiam se e como deveria ser permitido.

No trabalho, profissionais pediam ao ChatGPT para redigir e‑mails, textos de marketing e relatórios, esboçar apresentações, gerar trechos de código, escrever casos de teste e servir como parceiro de brainstorming para ideias de produto ou estratégias. Freelancers e pequenas empresas, em especial, o adotaram como assistente de baixo custo para conteúdo e análise.

Para solução de problemas cotidianos, pessoas consultavam o ChatGPT para planos de viagem, ideias de receitas com ingredientes disponíveis, explicações legais e médicas básicas (normalmente com o aviso de buscar conselho profissional) e ajuda para aprender novas habilidades ou idiomas.

Do preview gratuito a ofertas pagas

O preview de pesquisa inicial era gratuito para reduzir atrito e coletar feedback sobre falhas, usos indevidos e lacunas de capacidade. À medida que o uso cresceu, a OpenAI enfrentou tanto altos custos de infraestrutura quanto demanda por acesso mais confiável.

Em fevereiro de 2023, a OpenAI lançou o ChatGPT Plus, um plano de assinatura que oferecia respostas mais rápidas, acesso prioritário em horários de pico e acesso antecipado a novos recursos e modelos como o GPT‑4. Isso criou uma receita recorrente mantendo uma camada gratuita para amplo acesso.

Com o tempo, a OpenAI acrescentou opções voltadas para negócios: acesso à API dos mesmos modelos conversacionais, ferramentas para integração em produtos e fluxos de trabalho, e ofertas como ChatGPT Enterprise e planos para equipes voltados a organizações que precisam de maior segurança, controles administrativos e conformidade.

Debate, regulação e preocupações éticas

A visibilidade súbita do ChatGPT intensificou debates de longa data sobre IA.

Reguladores e formuladores de políticas preocuparam‑se com privacidade, proteção de dados e conformidade com leis existentes, especialmente em regiões como a União Europeia. Algumas autoridades restringiram temporariamente ou investigaram o ChatGPT enquanto avaliavam se a coleta e o processamento de dados atendiam a padrões legais.

Educadores enfrentaram preocupações de plágio e integridade acadêmica, já que estudantes podiam gerar ensaios e respostas que eram difíceis de detectar. Isso levou a proibições ou políticas estritas em algumas escolas, enquanto outras mudaram para avaliações que enfatizam processo, exames orais ou trabalhos em sala.

Éticos e pesquisadores levantaram alertas sobre desinformação, dependência excessiva da IA para decisões críticas, vieses nas respostas e impactos potenciais nos empregos criativos e do conhecimento. Também surgiram questões sobre dados de treinamento, direitos autorais e os direitos de artistas e escritores cujo trabalho pode ter influenciado o comportamento dos modelos.

Para a OpenAI, o ChatGPT marcou um ponto de inflexão: transformou a organização de um laboratório centrado em pesquisa para uma empresa no epicentro de discussões globais sobre como modelos de linguagem poderosos devem ser implantados, governados e integrados à vida cotidiana.

GPT‑4 e avanços nas capacidades de IA

Do GPT‑3.5 ao GPT‑4

A OpenAI lançou o GPT‑4 em março de 2023 como um avanço significativo além do GPT‑3.5, o modelo que inicialmente alimentou o ChatGPT. O GPT‑4 melhorou em raciocínio, seguir instruções complexas e manter coerência ao longo de conversas mais longas. Também ficou muito melhor em lidar com prompts nuançados, como explicar cláusulas legais, resumir artigos técnicos ou gerar código a partir de requisitos ambíguos.

Comparado ao GPT‑3.5, o GPT‑4 reduziu muitos modos óbvios de falha: era menos propenso a inventar fontes quando solicitado a citar, tratava casos extremos em problemas de matemática e lógica com mais confiabilidade e produzia saídas mais consistentes em consultas repetidas.

Multimodalidade e desempenho em benchmarks

O GPT‑4 introduziu capacidades multimodais: além de texto, pode aceitar imagens como entrada em algumas configurações. Isso possibilita casos de uso como descrever gráficos, ler anotações manuscritas, interpretar capturas de tela de interfaces ou analisar fotos para extrair informações estruturadas.

Em benchmarks padronizados, o GPT‑4 superou significativamente modelos anteriores. Alcançou pontuações próximas ao percentil superior em exames profissionais simulados, como a prova da ordem (bar exam), SAT e vários testes de nível avançado. Também melhorou em benchmarks de codificação e raciocínio, refletindo habilidades mais fortes em compreensão de linguagem e resolução de problemas.

Impacto no ecossistema e desafios remanescentes

O GPT‑4 rapidamente se tornou o núcleo da API da OpenAI e impulsionou uma nova onda de produtos de terceiros: copilotos de produtividade, assistentes de codificação, ferramentas de suporte ao cliente, plataformas educacionais e aplicações específicas por setor em áreas como direito, finanças e saúde.

Apesar desses avanços, o GPT‑4 ainda alucina, pode ser induzido a gerar saídas inseguras ou tendenciosas e não possui compreensão genuína nem conhecimento atualizado automaticamente. A OpenAI focou intensamente em pesquisa de alinhamento para o GPT‑4 — usando técnicas como RLHF, red‑teaming e regras de segurança em nível de sistema — mas enfatiza que implantação cuidadosa, monitoramento e pesquisa contínua são necessários para gerenciar riscos e usos indevidos.

Segurança, alinhamento e governança na OpenAI

Desde os primeiros anos, a OpenAI enquadrou segurança e alinhamento como essenciais à sua missão, não como um adendo a lançamentos de produtos. A organização tem declarado consistentemente que seu objetivo é construir sistemas de IA altamente capazes alinhados com valores humanos e implantá‑los de forma a beneficiar todos, não apenas seus acionistas ou parceiros iniciais.

A Carta da OpenAI e prioridades declaradas

Em 2018, a OpenAI publicou a OpenAI Charter, que formalizou suas prioridades:

- Fazer uma AGI amplamente benéfica e evitar usos que possam prejudicar a humanidade.

- Cooperar com outras instituições de pesquisa e políticas sobre segurança.

- Estar preparada para auxiliar outros projetos caso eles estejam mais próximos de uma AGI segura do que a própria OpenAI.

A Carta atua como uma bússola de governança, moldando decisões sobre direções de pesquisa, velocidade de implantação e parcerias externas.

Estruturas de segurança, políticas e red‑teaming

À medida que os modelos ficaram mais capazes, a OpenAI construiu funções dedicadas de segurança e governança ao lado de suas equipes centrais de pesquisa:

- Grupos de pesquisa em alinhamento e segurança exploram como fazer modelos se comportarem de acordo com a intenção humana, mesmo sob solicitações adversariais.

- Equipes de políticas e governança analisam impactos sociais, gerenciam políticas de implantação responsável e interagem com governos e órgãos reguladores.

- Programas de red‑teaming convidam especialistas internos e externos para testar modelos visando uso indevido, vieses, vulnerabilidades de segurança e outros comportamentos prejudiciais antes do lançamento.

Esses grupos influenciam decisões de lançamento, níveis de acesso e políticas de uso para modelos como GPT‑4 e DALL·E.

Técnicas: RLHF e além

Uma abordagem técnica definidora tem sido o reinforcement learning from human feedback (RLHF). Avaliadores humanos revisam saídas do modelo, as ranqueiam e treinam um modelo de recompensa. O modelo principal é então otimizado para produzir respostas mais próximas do comportamento preferido por humanos, reduzindo saídas tóxicas, tendenciosas ou inseguras.

Com o tempo, a OpenAI combinou o RLHF com técnicas adicionais: políticas de segurança em nível de sistema, filtros de conteúdo, fine‑tuning para domínios específicos e ferramentas de monitoramento que podem restringir ou sinalizar usos de alto risco.

Colaboração externa e frameworks públicos

A OpenAI tem participado de frameworks públicos de segurança, como compromissos voluntários com governos, práticas de relato de modelos e padrões de segurança para modelos de fronteira. Colaborou com acadêmicos, organizações da sociedade civil e pesquisadores de segurança em avaliações, red‑teaming e auditorias.

Essas colaborações, combinadas com documentos formais como a Carta e políticas de uso em evolução, formam a espinha dorsal da abordagem da OpenAI para governar sistemas de IA cada vez mais poderosos.

Controvérsias, críticas e tensões internas

Gere APIs a partir dos requisitos

Crie um backend em Go com PostgreSQL descrevendo endpoints e necessidades de dados.

A ascensão rápida da OpenAI tem sido acompanhada por críticas e tensões internas, muitas centradas em quão alinhada a organização permanece com sua missão original de benefício amplo e seguro.

De ciência “aberta” a modelos fechados

No início, a OpenAI enfatizava publicação e compartilhamento. Com o tempo, à medida que modelos como GPT‑2, GPT‑3 e GPT‑4 tornaram‑se mais capazes, a empresa mudou para liberações limitadas, acesso apenas via API e menos detalhes técnicos públicos.

Críticos argumentaram que essa mudança conflita com a promessa implícita pelo nome “OpenAI”. Defensores dentro da empresa sustentam que reter pesos completos e detalhes de treinamento é necessário para gerenciar riscos de uso indevido e preocupações de segurança.

A OpenAI respondeu publicando avaliações de segurança, fichas de sistema e documentos de políticas, enquanto mantém os pesos centrais proprietários. Apresenta isso como um equilíbrio entre abertura, segurança e pressão competitiva.

Poder, dados e comercialização

À medida que a OpenAI aprofundou sua parceria com a Microsoft — integrando modelos ao Azure e a produtos como o Copilot — observadores levantaram preocupações sobre concentração de computação, dados e poder decisório.

Críticos temem que poucas empresas controlem agora os modelos gerais mais avançados e a vasta infraestrutura por trás deles. Outros argumentam que a comercialização agressiva (ChatGPT Plus, ofertas empresariais e licenciamento exclusivo) se afasta da missão original do sem fins lucrativos de benefício amplamente compartilhado.

A liderança da OpenAI enquadra a geração de receita como necessária para financiar pesquisas caras, mantendo uma estrutura de lucro limitado e uma carta que prioriza os interesses da humanidade sobre retornos financeiros. Também lançou programas como camadas de acesso gratuito, parcerias de pesquisa e algumas ferramentas de código aberto para demonstrar benefício público.

Tensões de liderança e saídas de alto perfil

Desacordos internos sobre a velocidade de progresso, quão aberta ser e como priorizar segurança surgiram repetidamente.

Dario Amodei e outros saíram em 2020 para fundar a Anthropic, citando visões diferentes sobre segurança e governança. Posteriormente, renúncias de pesquisadores-chave de segurança, incluindo Jan Leike em 2024, destacaram publicamente preocupações de que metas de produto de curto prazo estivessem sobrepondo o trabalho de segurança de longo prazo.

A ruptura mais visível ocorreu em novembro de 2023, quando o conselho removeu brevemente o CEO Sam Altman, citando perda de confiança. Após reação intensa de funcionários e negociações envolvendo a Microsoft e outros interessados, Altman retornou, o conselho foi reconstituído e a OpenAI prometeu reformas de governança, incluindo um novo Comitê de Segurança e Proteção.

Esses episódios evidenciaram que a organização ainda lida com como conciliar implantação rápida, sucesso comercial e suas responsabilidades declaradas em relação à segurança e ao benefício amplo.

O papel em evolução da OpenAI no futuro da IA

A OpenAI mudou de um pequeno laboratório focado em pesquisa para um provedor central de infraestrutura de IA, influenciando como novas ferramentas são construídas, regulamentadas e entendidas.

Em vez de apenas publicar modelos, a OpenAI agora opera uma plataforma completa usada por startups, empresas e desenvolvedores individuais. Através de APIs para modelos como GPT‑4, DALL·E e sistemas futuros, ela se tornou:

- Uma base técnica para produtos em saúde, educação, ferramentas de desenvolvedor e indústrias criativas

- Um ponto de referência para benchmarks, boas práticas e recursos de segurança que outros laboratórios adotam ou criticam

Esse papel de plataforma significa que a OpenAI não está apenas avançando a pesquisa — está definindo padrões de experiência para como milhões de pessoas têm o primeiro contato com IA poderosa.

Moldando pesquisa, indústria e políticas

O trabalho da OpenAI impulsiona competidores e comunidades de código aberto a responder com novos modelos, métodos de treinamento e abordagens de segurança. Essa competição acelera o progresso ao mesmo tempo em que intensifica debates sobre abertura, centralização e comercialização da IA.

Governos e reguladores cada vez mais observam as práticas, relatórios de transparência e pesquisas de alinhamento da OpenAI ao redigir regras para implantação, avaliações de segurança e uso responsável. Conversas públicas sobre ChatGPT, GPT‑4 e sistemas futuros influenciam fortemente como a sociedade imagina riscos e benefícios da IA.

Questões em aberto: poder, equidade, responsabilidade

À medida que os modelos se tornam mais capazes, questões não resolvidas sobre o papel da OpenAI ficam mais importantes:

- Quão concentrado deve ser o controle sobre modelos de fronteira?

- Quem recebe acesso antecipado ou preferencial — e em quais termos?

- Como são governados os dados de treinamento, os impactos ambientais e auditorias externas de segurança?

- Quais obrigações a OpenAI tem com pessoas e países que não são clientes, mas são afetados por suas tecnologias?

Essas perguntas moldarão se sistemas futuros de IA amplificam desigualdades existentes ou ajudam a reduzi‑las.

Desenvolvedores e empresas podem:

- Construir sobre as APIs da OpenAI enquanto adotam verificações independentes de segurança, red‑teaming e monitoramento

- Combinar modelos da OpenAI com ferramentas de código aberto para evitar dependência excessiva de um único provedor

- Participar de programas de feedback, consultas de políticas e colaborações de pesquisa quando possível

Indivíduos podem:

- Aprender como os modelos funcionam, quais são suas limitações e como os dados são usados

- Usar ferramentas de IA de forma crítica — verificando outputs, evitando dependência excessiva e reportando comportamentos prejudiciais

A influência futura da OpenAI dependerá não apenas de suas decisões internas, mas de como governos, concorrentes, sociedade civil e usuários cotidianos escolhem se engajar, criticar e exigir responsabilização dos sistemas que ela constrói.