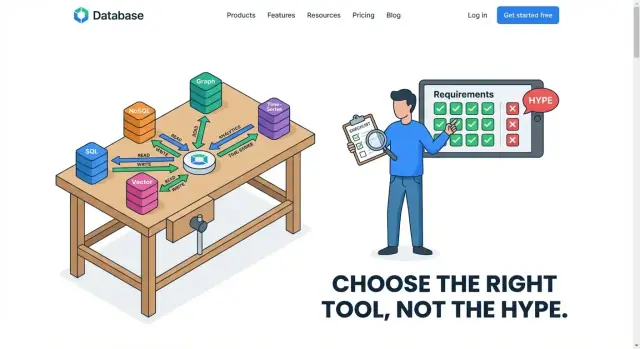

Comece pelo workload, não pelo hype

Escolher um banco de dados porque ele está “na moda” é como comprar um veículo porque todo mundo fala nele—sem checar se você precisa de uma scooter, uma caminhonete ou um ônibus. Tendências refletem o que funcionou para o produto, tamanho da equipe, orçamento e tolerância a risco de outra pessoa. Seu banco de dados precisa caber no seu workload: o que sua aplicação realmente faz o dia todo.

Um workload é o comportamento real do seu sistema em produção:

- Como os dados são escritos: atualizações pequenas e frequentes, inserções em lote grandes, eventos append-only, ou edições ocasionais.\n- Como os dados são lidos: buscas por registro único, feeds “últimos N”, busca por texto completo, ou varreduras grandes.\n- Como é consultado: leituras simples por chave, filtros multi-campo, joins, agregações, relatórios por janela temporal ou queries geoespaciais.\n- Como muda ao longo do tempo: picos de tráfego, sazonalidade, backfills e crescimento do volume de dados.

Esses comportamentos são seus padrões de acesso—as maneiras repetíveis com que sua app toca os dados. Se você consegue descrever padrões de acesso claramente, a escolha do banco deixa de ser um mistério.

Defina a expectativa certa cedo

Tamanho único raramente funciona. Muitos sistemas bem-sucedidos usam uma abordagem híbrida: um banco otimizado para transações, outro para análises, e às vezes um mecanismo de busca ou cache dedicado. Isso não é “complexidade extra por si só”—é reconhecer que padrões de acesso diferentes se beneficiam de engines de armazenamento e consulta diferentes.

Antes de comparar “SQL vs NoSQL” ou correr atrás do que está em alta, escreva suas 5–10 principais leituras e escritas. Comece por aí; todo o resto são detalhes.

O que “padrão de acesso” realmente significa

Um padrão de acesso é a descrição prática de como sua aplicação toca os dados no dia a dia: o que lê, o que escreve, com que frequência, quão rápido e em que formatos. É menos sobre o que seus dados são (“pedidos” ou “usuários”) e mais sobre o que você faz com eles (“buscar um pedido por ID 10.000 vezes por minuto” ou “varrer todos os pedidos do mês passado para gerar um relatório”).

A maior parte do tráfego de leitura cai em alguns buckets reconhecíveis:

- Consultas pontuais: “Mostre o pedido #12345” ou “Carregar este perfil de usuário.” Normalmente são rápidas se o banco puder usar um índice ou chave.\n- Consultas complexas: “Encontrar clientes que compraram X, na região Y, com devoluções > 2.” Dependem de joins, filtros, ordenações e bom planejamento de query.\n- Varreduras / leituras por intervalo: “Obter todos os logs das últimas 24 horas” ou “Listar as últimas 50 transações.” Isso pode significar ler muitas linhas/documentos, mesmo se você só mostrar um recorte pequeno.

Um feed social é um bom exemplo de formatos mistos de leitura: você pode fazer buscas pontuais por perfis, leituras por intervalo para “últimas postagens” e agregações para contagens.

Escritas: inserções, ingestão e atualizações

Padrões de escrita importam tanto quanto:

- Inserções por linha: criar um pedido, adicionar um comentário, cadastrar um usuário.\n- Ingestão em alto volume: coletar eventos de clique ou logs de aplicação continuamente.\n- Atualizações: mudar contagem de inventário, atualizar status de pedido, editar um post.

Logs costumam ser “escrita intensa e append-only” (muitas inserções, poucas atualizações). Pedidos geralmente são “escreve-depois-atualiza” (cria, depois muda status).

Workloads mistos (e por que são complicados)

Muitos produtos querem tudo ao mesmo tempo: leituras pontuais rápidas para o app, consultas complexas para suporte ao cliente e varreduras grandes para analytics. Um banco pode lidar bem com alguns mixes, mas certas combinações brigam entre si—por exemplo, varreduras analíticas pesadas podem desacelerar leituras sensíveis à latência que alimentam checkout ou um feed.

Quando você consegue nomear claramente seus padrões de acesso, dá para avaliar bancos por comportamento real em vez de popularidade.

Tipos comuns de workload para identificar cedo

Antes de comparar marcas de bancos, nomeie o workload que você realmente atende. A maioria dos produtos não é “um único workload”—são alguns workloads distintos lado a lado (e às vezes concorrendo). Acertar essa classificação cedo evita forçar um banco a uma função para a qual ele não foi otimizado.

OLTP (Online Transaction Processing)

OLTP é o pulso do dia a dia da maioria das apps: muitas leituras e escritas pequenas, muitos usuários concorrentes e requisições que precisam terminar rápido.

Pense: “atualizar um carrinho”, “criar um pedido”, “mudar um endereço”, “checar inventário.” Essas operações são curtas, direcionadas e sensíveis à correção. Se um pagamento for capturado, não pode sumir; se um assento for reservado, duas pessoas não devem obter o mesmo assento.

OLTP normalmente leva você a sistemas que lidam bem com alta concorrência e oferecem garantias claras sobre transações e integridade dos dados.

Analytics / OLAP (relatórios e agregações)

Analytics inverte a forma do trabalho: menos consultas, mas cada uma toca muito mais dados.

Pense: “receita por região no último trimestre”, “conversão por canal”, “top produtos por categoria”, “tendência de usuários ativos diários.” Essas consultas costumam varrer muitas linhas, agrupar, agregar e ordenar. Expectativas de latência podem ser mais frouxas (segundos podem ser aceitáveis), mas o custo de varreduras pesadas importa—especialmente se dashboards rodarem o dia todo.

Se você tentar rodar varreduras OLAP no mesmo sistema que dá suporte ao checkout, frequentemente um dos dois sofre.

Séries temporais e logging

Séries temporais e logs costumam ser append-heavy: novos eventos chegam constantemente, e você geralmente consulta por intervalos de tempo.

Pense: métricas, clickstreams, telemetria de dispositivos, logs de auditoria. Necessidades comuns incluem políticas de retenção (deletar/expirar dados antigos), rollups (manter eventos brutos por 7 dias, agregados por 12 meses) e gravação rápida durante picos.

Esse workload é menos sobre joins complexos e mais sobre ingerir eficientemente muitos registros timestamped e manter o armazenamento previsível ao longo do tempo.

Workloads de busca

Buscar não é apenas “achar linhas”. É correspondência de texto, ranking por relevância, correspondência parcial e filtros amigáveis ao usuário.

Pense: buscar produtos por palavras-chave, encontrar tickets por frases, filtrar por facets (marca, faixa de preço, cor) e ordenar por “melhor resultado”. Esses recursos frequentemente exigem indexação especializada e capacidades de query que bancos gerais podem aproximar—mas raramente exceder.

Se busca é uma função central do produto, trate-a como um workload próprio desde o início, não como um detalhe “vamos adicionar depois”.

Performance não é um número só. Dois bancos podem ser “rápidos” e, ainda assim, dar sensações completamente diferentes para usuários e operadores. Para escolher bem, separe o que humanos percebem (latência) do que o sistema deve sustentar (throughput), e então estresse suas suposições com picos.

Latência vs throughput: o que usuários notam vs o que o sistema aguenta

Latência é quanto tempo uma única requisição leva—“tocar o botão, obter resultado.” Usuários sentem latência diretamente.

Throughput é quantas requisições você pode processar por segundo—quanto tráfego o sistema aguenta no total.

Um banco pode entregar alto throughput agrupando trabalho eficientemente, mas ainda apresentar atraso perceptível por requisição. Outro pode otimizar leituras pontuais rápidas, mas ter problemas quando muitas escritas chegam ao mesmo tempo.

Por que o 1% mais lento importa (P99)

A média de latência esconde dor. Se 99 requisições terminam em 50 ms e 1 leva 2 segundos, a média parece ok—mas esse 1% vira o momento em que “o app está lento”.

Isso é o que latência P99 significa: o tempo que as requisições mais lentas (1%) levam. Para recursos voltados ao usuário (checkout, login, resultados de busca), o P99 frequentemente decide se seu design de banco parece confiável.

Pico vs carga média: projetando para picos

A maioria dos sistemas não falha na média; falha nos picos: um e-mail de marketing, um momento de notícia, dia de pagamento, fim de mês.\n\nPicos mudam a conversa do banco:

- Índices aceitáveis a 200 writes/s podem virar gargalo a 2000 writes/s.\n- Trabalhos em background (compactação, vacuum, replicação) competem com queries de usuário exatamente quando você menos pode arcar com isso.

O cache pode fazer workloads read-heavy parecerem menores—até faltar um cache ou ocorrer uma limpeza.

Se a maioria das leituras bate no cache, seu banco pode passar a servir principalmente escritas e leituras caras ocasionais. Isso favorece escolhas diferentes do que um sistema em que toda leitura atinge o banco. Planeje para eventos de “cache frio” e para a latência de cauda dos misses, não apenas para o caminho feliz.

Correção, disponibilidade e restrições de localização

Escolher um banco não é só sobre velocidade. Também é sobre o que pode estar errado, quanto tempo de inatividade você tolera e onde seus usuários estão.

Correção: o que nunca pode estar errado

Comece nomeando os dados que têm de estar corretos sempre. Pagamentos, saldos e contagens de inventário são exemplos clássicos. Se um cliente é cobrado duas vezes, ou você vende mais do que tem, o “custo” não é só um app mais lento—são reembolsos, tickets de suporte e perda de confiança.

Para essas partes do sistema, geralmente você quer garantias fortes: escritas confirmadas antes de serem consideradas concluídas, e leitores que não veem atualizações pela metade. O trade-off é que correção mais forte costuma reduzir flexibilidade: algumas estratégias de escala ficam mais difíceis, e escritas cross-region podem ficar mais lentas.

Disponibilidade: quanto custa downtime

Decida o que acontece se o banco ficar indisponível por 5 minutos.

Se downtime significa “pedidos param e receita para”, você precisa de maior disponibilidade: failover automático, bons backups e um plano de manutenção sem tirar o app do ar. Se downtime significa “dashboards internos atrasam”, você pode aceitar setups mais simples.

Maior disponibilidade geralmente aumenta custo e complexidade operacional (mais réplicas, mais monitoramento, upgrades cuidadosos). A chave é casar esse investimento com o impacto no negócio.

Localização: usuários em uma região vs multi-região

Se seus usuários estão concentrados em uma região, manter dados em um lugar pode ser mais barato e rápido. Se você tem usuários globais—ou requisitos regulatórios sobre residência de dados—pode precisar de replicação multi-região.

Designs multi-região melhoram a experiência e resiliência, mas forçam escolhas difíceis: permitir leituras ligeiramente defasadas, ou aceitar escritas mais lentas para manter tudo perfeitamente sincronizado? A resposta certa depende do que seu workload tolera.

Evite ficar preso

Tenha sua base de código e mova-a para onde precisar quando os requisitos mudarem.

Muitas “debates sobre bancos” são, na verdade, discussões sobre forma de query. Se você sabe que perguntas sua app precisa fazer—joins, agregações, filtros, janelas temporais—você costuma conseguir reduzir as opções rapidamente.

Um modelo relacional brilha quando você precisa de filtragem flexível e joins entre múltiplas entidades (clientes → pedidos → itens), especialmente quando os requisitos evoluem. Se seu produto precisa de relatórios ad-hoc (“mostrar todos os clientes que compraram X e também devolveram Y”), SQL e joins tendem a permanecer mais simples ao longo do tempo.

Se suas queries são previsíveis e majoritariamente por chave primária (“buscar perfil por user_id”), um modelo de documento ou key-value pode funcionar bem—frequentemente armazenando dados já agrupados do jeito que você os lê. O trade-off é que você pode duplicar dados para evitar joins, o que empurra complexidade para escritas e atualizações.

Índices: o verdadeiro contrato de desempenho

Índices são como você diz ao banco quais são seus padrões de acesso. Uma query que parece ok em um mockup pode ficar lenta se filtrar ou ordenar por campos não indexados.

Uma regra útil: todo filtro, ordenação ou chave de join frequente deveria ter um plano de índice. Mas índices não são grátis: consomem armazenamento e tornam escritas mais pesadas.

Amplificação de escrita: quando “escritas rápidas” viram lentas

Afirmações de “escritas rápidas” frequentemente ignoram a amplificação de escrita—trabalho extra criado por índices secundários, compactação, replicação ou atualização de múltiplas cópias de dados denormalizados. Um design que otimiza leituras adicionando índices ou duplicando documentos pode, silenciosamente, transformar um workload de alta escrita em um gargalo.

Flexibilidade de esquema vs manutenibilidade

Schema-less não significa sem estrutura. Esquemas flexíveis aceleram iteração inicial, mas sem convenções criam campos inconsistentes, consultas difíceis de depurar e migrações caras depois. Quando você espera muitas equipes, muitas features ou retenção longa, um esquema mais rígido e restrições claras frequentemente reduzem o custo total—mesmo que pareça mais lento no começo.

Operação e custo: o que as tendências ignoram

Escolher um banco pela moda costuma dar problema nas partes pouco glamourosas da posse: mantê-lo rodando, mantê-lo seguro e pagar a conta mês a mês. Dois bancos podem atender aos mesmos requisitos funcionais e, ainda assim, divergir muito no esforço operacional e custo total.

Esforço operacional é uma característica

Pergunte cedo quem vai rodar esse sistema às 2 da manhã. Backups, recovery pontual, upgrades, patching, drills de failover e monitoramento não são tarefas “depois”—elas moldam seu risco e necessidade de equipe.

Serviços gerenciados reduzem o toil, mas não eliminam. Alguns sistemas exigem compactação regular, tuning cuidadoso ou expertise profunda para evitar lentidões. Outros tornam mudanças de esquema dolorosas, ou requerem playbooks especiais de migração. Se sua equipe é pequena, um banco mais fácil de operar pode vencer um “encaixe perfeito” apenas no papel.

Saiba o que realmente dirige o custo

Custos de banco normalmente vêm de:

- Armazenamento (especialmente com múltiplas réplicas, índices ou retenção longa)\n- Compute (baseline estável mais headroom para picos)\n- I/O (leituras/escritas randômicas, volume de logs, compactions)\n- Egress de rede (replicação cross-region, exports para analytics, backups)

Um padrão de acesso pesado em escritas e índices secundários pode multiplicar I/O e armazenamento mesmo com dataset pequeno.

Lock-in, portabilidade e risco

Linguagens de consulta proprietárias, recursos de consistência únicos ou “mágica” serverless podem acelerar entrega—mas limitar movimentos futuros. Considere se você pode exportar dados, rodar localmente para testes ou trocar de provedor sem reescrever sua app.

No mínimo, confirme criptografia em trânsito/em repouso, opções de gerenciamento de chaves, auditoria, controles de acesso e políticas de retenção. Necessidades de compliance frequentemente decidem entre “funciona” e “aceitável”, independentemente da moda.

Valide suas principais consultas

Construa um PoC rápido no Koder.ai e teste suas leituras e gravações reais.

Uma vez que você descreveu seus padrões de acesso (o que lê, o que escreve, com que frequência e sob quais picos), a família de banco “certa” geralmente fica mais clara. O objetivo não é escolher a ferramenta mais popular—é escolher o sistema mais simples que permaneça correto sob seu workload.

Relacionais (SQL): a escolha correta e mais simples

Escolha um banco relacional quando você precisa de consistência forte, relacionamentos claros e transações confiáveis—pedidos, pagamentos, inventário, permissões, agendamento. Se você consulta frequentemente entre entidades (“clientes com faturas abertas nos últimos 30 dias”) ou precisa impor constraints (email único, chaves estrangeiras), SQL tende a reduzir a complexidade da aplicação.

Uma heurística comum: se sua equipe está prestes a reimplementar joins, constraints e transações no código, provavelmente você quer um banco relacional.

Um banco de documentos encaixa melhor quando você geralmente lê e escreve objetos inteiros que podem variar em estrutura, como perfis de usuário, páginas de conteúdo, catálogos de produto com campos opcionais ou configurações. Se sua consulta típica é “buscar o perfil por user_id” e atualizar partes dele, documentos podem manter os dados que você usa juntos.

Cuidado quando suas queries se tornarem altamente relacionais (muitas consultas entre documentos) ou quando precisar de garantias transacionais multi-entidade.

Key-value: buscas ultra-rápidas para dados efêmeros

Sistemas key-value brilham para cache, sessões, limites de taxa, feature flags e estado de curta duração onde o padrão de acesso é “get/set por chave” e latência importa. São frequentemente complemento, não sistema primário de registro.

Se você armazena dados duráveis de negócio, pergunte o que acontece durante evicções, reinícios ou atrasos de replicação.

Armazenamento columnar / data warehouses: agregação pesada e BI

Para analytics—dashboards, coorte, rollups de receita, group-bys sobre histórico—sistemas columnar/warehouse vencem porque são otimizados para varreduras e agregações eficientes de muitas linhas.

Uma divisão prática: mantenha escritas OLTP no banco primário e alimente um warehouse para reporting. Isso evita desacelerar consultas voltadas ao cliente com workloads de BI.

Exemplos do mundo real: um produto, múltiplos bancos

Muitos produtos bem-sucedidos não “escolhem um banco”. Eles mapeiam cada padrão de acesso principal para o armazenamento mais simples que o atende bem, mesmo que isso signifique usar dois ou três bancos lado a lado.

Exemplo 1: E‑commerce — pedidos, busca no catálogo e analytics

Uma loja online costuma ter três workloads muito diferentes:

- Pedidos e pagamentos (OLTP): muitas leituras/escritas pequenas, correção estrita, atualizações transacionais (estoque, status do pedido). Um relacional é comum aqui.\n- Busca e filtro do catálogo: usuários esperam busca por texto rápida, facets, tolerância a erros de digitação e ranking por relevância. Geralmente melhor atendido por um motor de busca do que forçar SQL a se comportar como tal.\n- Analytics de negócio: “Como a conversão mudou após a campanha?” precisa de varreduras e agregações grandes ao longo do tempo. Um data warehouse columnar pode servir isso sem prejudicar o checkout.

O produto parece unificado, mas o armazenamento é especializado por padrão de acesso.

Exemplo 2: App SaaS — tenancy, reporting e logs de auditoria

Uma ferramenta B2B pode guardar entidades centrais (projetos, faturas, tickets) num banco transacional, mas ainda precisar de:

- Queries cientes por tenant: índices por tenant e formas de query previsíveis para manter performance consistente.\n- Reporting: queries longas e agregadas que não devem competir com requests interativas; frequentemente offloaded para réplica, warehouse ou store de reporting.\n- Audit logs: append-only, alto volume e regras de retenção. Um store otimmizado para logs (ou mesmo storage de objetos + camada de query) pode ser mais barato e simples que inflar o banco OLTP.

Exemplo 3: IoT/logging — ingestão, retenção, dashboards

Plataformas IoT recebem rajadas de telemetria e depois leem para dashboards por janelas de tempo.

Uma divisão comum é: um store de ingestão rápido para dados recentes, armazenamento de longo prazo mais barato para retenção e um engine analítico para agregados.

A lição-chave: componentes diferentes podem — e muitas vezes devem — usar bancos diferentes quando padrões de acesso divergem.

Sinais de alerta de que você escolheu o banco errado

Um desalinhamento normalmente aparece como uma pilha crescente de “pequenas” correções. Se sua equipe gasta mais tempo brigando com o banco do que construindo features, preste atenção—frequentemente são problemas de padrão de acesso, não tuning.

Sintomas de que você está compensando um encaixe ruim

Alguns sinais recorrentes:

- Muitas gambiarras no código da aplicação (cacheando tudo, escrevendo várias versões da mesma query, denormalizando “só pra ficar rápido”).\n- Reindexações constantes ou churn de índices porque novas queries chegam e as antigas quebram.\n- Queries lentas difíceis de explicar: parecem simples, mas o desempenho varia muito com o tamanho dos dados ou hora do dia.\n- Indisponibilidades amarradas a eventos rotineiros—deploys, jobs em lote, backfills ou picos do fim do mês.

Se o banco exige esforço heróico para sustentar operações normais, o workload e a família do banco provavelmente não casam.

Escolhas guiadas por tendências são caras depois

Escolher um banco só porque está na moda pode travar você em custos de longo prazo:

- Você acaba construindo features faltantes internamente (joins, constraints, migrações, auditabilidade, reporting), e esse código customizado torna-se difícil de desfazer.\n- Migração é adiada por ser arriscada—logo o “temporário” vira permanente.\n- O formato dos dados se ajusta à ferramenta, não ao produto, dificultando analytics, compliance e integrações.

A conta chega quando a escala aumenta ou requisitos mudam, e o conserto realista é uma replatform dolorosa.

Métricas de alerta iniciais para monitorar

Você não precisa de observabilidade perfeita, mas precisa de alguns sinais:\n\n- Percentis de latência de query (p95/p99), não apenas médias.\n- Contenção de locks / deadlocks (ou conflitos equivalentes de concorrência).\n- Saturação do pool de conexões e timeouts.\n- Atraso de replicação e surpresas de leitura após escrita.\n- Taxa de crescimento de armazenamento e relação índice-dados.

O que documentar para não repetir o erro

Registre os principais padrões de acesso (leituras/escritas, queries-chave, taxas de pico), suposições de volume de dados e os “inegociáveis” (consistência, disponibilidade, restrições de região). Adicione links a dashboards e exemplos das piores queries. Esse registro curtinho acelera decisões futuras—e deixa claro quando um banco não corresponde mais à realidade.

Checklist prático que você pode reaplicar

Itere com segurança nas mudanças

Use snapshots e rollback para testar alterações no modelo de dados sem medo.

Escolher um banco fica mais fácil quando você trata isso como levantamento de requisitos, não concurso de popularidade. Use esta checklist para transformar “precisamos de algo escalável” em entradas concretas que você pode comparar.

Responda primeiro em linguagem simples, depois some números quando puder:

- Consultas primárias: Quais as 3–5 coisas principais que o app precisa fazer (ex.: “buscar usuário por email”, “listar últimos 50 pedidos”, “buscar por palavra-chave”, “agregar receita diária”)?\n- Taxa de escrita: Quantas escritas por segundo agora e no pico? Escritas pequenas e frequentes ou lotes grandes?\n- Tamanho e crescimento dos dados: Tamanho atual, crescimento mensal, regras de retenção (guardar pra sempre, 90 dias, arquivar?).\n- SLAs: Metas de p95/p99, uptime, expectativas de recuperação (RTO/RPO) e quão ruim é ter dados levemente desatualizados.

2) Use uma matriz simples de pontuação

Faça uma página com critérios na esquerda e candidatos no topo. Marque cada critério como obrigatório ou desejável, então pontue cada banco (por exemplo 0–2).

Inclua pelo menos: adequação à query, abordagem de escala, necessidades de consistência, esforço operacional, ecossistema/ferramentas e previsibilidade de custo.

3) Faça um pequeno PoC

Teste com dados representativos e queries reais, não exemplos toy. Recrie as “top queries” e um padrão de escrita realista (incluindo picos).

Se você itera rápido em ideias de produto, um ambiente vibe-coding como Koder.ai pode ajudar a montar um app funcional e validar padrões de acesso cedo: gere um frontend React com backend Go + PostgreSQL, modele alguns endpoints reais e meça como suas “top 5 queries” se comportam antes de se comprometer com arquitetura de longo prazo. A possibilidade de exportar código-fonte e manter controle de esquema e migrações também ajuda a evitar se enfiar em um beco sem saída.

4) Defina critérios de sucesso antes do teste

Escreva o que “passa” antes de rodar: metas de latência, taxas de erro aceitáveis, passos operacionais necessários (backups, alterações de esquema) e um custo mensal estimado no uso esperado. Se um candidato não cumprir um must-have no PoC, elimine-o cedo.

Como se preparar para o futuro sem exagerar

Preparar-se para o futuro não é escolher o “mais escalável” no dia 1. É tomar decisões deliberadas que mantenham você ágil quando padrões de acesso mudarem.

Se seu workload é majoritariamente transacional com queries diretas, um banco relacional costuma ser o caminho mais rápido para um produto confiável. O objetivo é lançar com confiança: performance previsível, garantias claras de correção e ferramentas que sua equipe já conhece.

“Futuro-prova” aqui significa evitar compromissos irreversíveis cedo—como adotar um store especializado antes de provar que você precisa dos trade-offs.

Projete para mudança: limites, acesso modular e migrações

Construa uma camada explícita de acesso a dados (ou boundary de serviço) para que o resto do app não dependa de peculiaridades do banco. Centralize lógica de query, defina contratos (inputs/outputs) e trate mudanças de esquema como parte normal do desenvolvimento.

Há alguns hábitos práticos que ajudam migrações futuras:

- Prefira mudanças aditivas (novas colunas/tabelas) a reescritas arriscadas.\n- Backfills em lotes e mudanças compatíveis com código antigo e novo durante deploys.\n- Log e mensure padrões de query para detectar deriva cedo.

Separe workloads quando padrões de acesso divergirem

Muitos produtos eventualmente precisam de dois caminhos: OLTP para transações diárias e analytics para reporting, experimentação ou agregados pesados. Separe quando queries analíticas começarem a prejudicar a latência de produção, ou quando você precisar de retenção/particionamento distintos.

Para mantê-los alinhados, padronize definições de eventos/dados, automatize pipelines e reconcilie totais (ex.: vendas diárias) entre sistemas para que a “verdade” não se fragmente.

Se quiser um próximo passo concreto, construa um template leve de plano de migração que seu time possa reaplicar: /blog/database-migration-checklist.