Por que código gerado por IA e testes auto-gerados pertencem juntos

Lógica de aplicação escrita por IA significa que as partes “funcionais” do seu código são esboçadas com a ajuda de um assistente: novas funções, pequenas features, refactors, tratamento de casos de borda e até reescritas de módulos existentes. Você ainda decide o que construir, mas a primeira versão da implementação costuma chegar mais rápido — e às vezes com suposições que você só notará depois.

Geração automatizada de testes é a capacidade complementar do lado da verificação. Em vez de escrever todo teste à mão, ferramentas podem propor casos de teste e asserções com base no seu código, numa spec ou em padrões aprendidos a partir de bugs anteriores. Na prática, isso pode parecer:

- “Dada esta assinatura de função e ramificações, aqui estão testes que cobrem entradas típicas, limites e caminhos de erro.”

- “Aqui estão testes de regressão que reproduzem o crash que vimos em produção.”

A expectativa-chave: testes gerados não são automaticamente “bons”

Um teste gerado pode ser enganoso: pode afirmar o comportamento atual mesmo que ele esteja errado, ou pode não cobrir regras de produto que vivem na cabeça das pessoas e em comentários de ticket. Por isso a revisão humana importa. Alguém precisa confirmar que o nome do teste, o setup e as asserções refletem a intenção real — não apenas o que o código faz hoje.

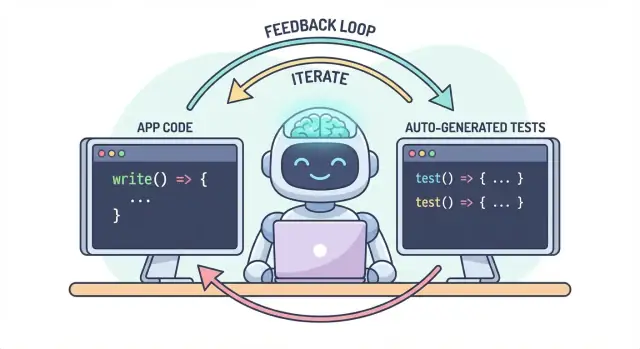

Um fluxo, duas saídas

A ideia central é simples: código e testes devem evoluir juntos como um único fluxo. Se a IA te ajuda a mudar a lógica rapidamente, a geração automatizada de testes ajuda a consolidar o comportamento pretendido com a mesma rapidez — assim a próxima mudança (humana ou por IA) tem uma definição executável de “ainda correto.”

Na prática, essa abordagem de “saída emparelhada” é mais fácil de manter quando seu fluxo de desenvolvimento já é orientado por chat. Por exemplo, no Koder.ai (uma plataforma vibe-coding para construir apps web, backend e mobile via chat), é natural tratar “feature + testes” como uma única entrega: você descreve o comportamento, gera a implementação, depois gera e revisa os testes no mesmo loop conversacional antes de deployar.

O problema: código mais rápido pode significar bugs mais rápidos

Código escrito por IA pode parecer um superpoder: features surgem rapidamente, boilerplate desaparece e refactors que antes levavam horas podem acontecer antes do seu café esfriar. O porém é que a velocidade muda a forma do risco. Quando código é mais fácil de produzir, também é mais fácil enviar erros — às vezes sutis.

Modos comuns de falha da lógica gerada por IA

Assistentes de IA são bons em gerar implementações “razoáveis”, mas razoável não é o mesmo que correto para o seu domínio específico.

Casos de borda são as primeiras vítimas. Lógica gerada por IA frequentemente lida bem com o caminho feliz e tropeça em condições de limite: entradas vazias, quirks de fuso horário, arredondamento, valores nulos, comportamento de retry, ou estados “isso nunca deve acontecer” que acontecem em produção.

Suposições erradas são outro problema frequente. Um assistente pode inferir requisitos não declarados (“usuários estão sempre autenticados”, “IDs são numéricos”, “este campo está sempre presente”), ou pode implementar um padrão familiar que não combina com as regras do seu sistema.

Regressões silenciosas costumam ser as mais caras. Você pede uma pequena mudança, o assistente reescreve um pedaço de lógica e algo não relacionado quebra — sem erros óbvios. O código ainda compila, a UI ainda carrega, mas uma regra de precificação, verificação de permissão ou conversão de dados ficou levemente errada.

Quando as mudanças de código aceleram, testes manuais se tornam um gargalo e um risco. Ou você passa mais tempo clicando por aí (lentificando a entrega) ou testa menos (aumentando escapes). Mesmo times de QA disciplinados não conseguem cobrir manualmente todas as variantes quando mudanças são frequentes e abrangentes.

Pior: checagens manuais são difíceis de repetir de forma consistente. Ficam na memória de alguém ou em um checklist, e são fáceis de pular quando prazos apertam — exatamente quando o risco é maior.

Testes como rede de segurança e ferramenta de comunicação

Testes automatizados criam uma rede de segurança durável: transformam expectativas em executável. Um bom teste diz: “Dadas essas entradas e este contexto, este é o resultado no qual confiamos.” Isso não é só verificação; é comunicação para você no futuro, colegas e até para o assistente IA.

Quando testes existem, mudanças ficam menos assustadoras porque o feedback é imediato. Em vez de descobrir problemas após code review, em staging ou pelos clientes, você os encontra minutos depois da mudança.

Capturar problemas cedo para reduzir retrabalho

Quanto mais cedo um bug é detectado, mais barato é corrigi-lo. Testes encurtam o loop de feedback: fazem surgir suposições desencontradas e casos de borda esquecidos enquanto a intenção ainda está fresca. Isso reduz retrabalho, evita patches “fix-forward” e impede que a velocidade da IA vire churn conduzido por IA.

Como testes criam um loop de feedback para lógica gerada por IA

Código escrito por IA é mais rápido quando você o trata como uma conversa, não como uma entrega única. Testes são o que tornam essa conversa mensurável.

O loop “spec → código → testes” (em linguagem simples)

-

Spec: Você descreve o que deve acontecer (entradas, saídas, casos de borda).

-

Código: A IA escreve a implementação que diz corresponder a essa descrição.

-

Testes: Você (ou a IA) gera checagens que provam que o comportamento é realmente verdadeiro.

Repita esse loop e você não estará apenas produzindo mais código — estará apertando continuamente a definição de “pronto”.

Testes forçam requisitos e interfaces mais claras

Um requisito vago como “lidar graciosamente com usuários inválidos” é fácil de ser esquecido no código. Um teste não pode ser vago. Ele força especificidade:

- O que conta como “inválido”? ID ausente, status banido, email malformado?

- O que significa “graciosamente”? Mensagem de erro, código de status, valor de fallback?

- Qual é a interface? Assinatura da função, formato de retorno, exceções?

Assim que você tenta expressar esses detalhes em um teste, as partes incertas aparecem imediatamente. Essa clareza melhora o prompt que você dá à IA e muitas vezes leva a interfaces mais simples e estáveis.

Testes gerados validam o que o código alega

Código de IA pode parecer correto enquanto esconde suposições. Testes gerados são uma forma prática de verificar as afirmações que o código faz:

- “Esta função é pura” → teste para ausência de efeitos colaterais externos.

- “Lida com casos de borda” → teste nulos, listas vazias, valores de limite.

- “Compatível retroativamente” → teste entradas antigas e saídas esperadas.

O objetivo não é confiar cegamente nos testes gerados — é usá-los como ceticismo estruturado e rápido.

Testes que falham viram o próximo prompt

Um teste que falha é feedback acionável: aponta uma discrepância específica entre spec e implementação. Em vez de pedir à IA para “consertar”, você pode colar a falha e dizer: “Atualize o código para que este teste passe sem mudar a API pública.” Isso transforma depuração em uma iteração focada em vez de um jogo de adivinhação.

Onde a geração automatizada de testes se encaixa na sua pirâmide de testes

A geração automatizada de testes é mais útil quando apoia sua estratégia de testes existente — especialmente a clássica “pirâmide de testes”. A pirâmide não é uma regra por si só; é uma forma de manter o feedback rápido e confiável ao mesmo tempo que captura falhas do mundo real.

A IA pode ajudar a criar testes em todas as camadas, mas você terá melhores resultados quando gerar mais dos testes baratos (base da pirâmide) e menos dos caros (topo). Esse equilíbrio mantém seu pipeline de CI rápido enquanto protege a experiência do usuário.

Testes unitários: rápidos, focados e muito geráveis

Testes unitários são checagens pequenas para funções, métodos ou módulos individuais. Rodam rápido, não precisam de sistemas externos e são ideais para cobertura gerada por IA de casos de borda.

Um bom uso de geração automatizada aqui é:

- Exercitar validação de entrada e valores limite “estranhos”

- Validar regras de negócio (descontos, permissões, transições de estado)

- Trancar correções de bugs com testes de regressão que são fáceis de esquecer

Como testes unitários são escopados, são mais fáceis de revisar e menos propensos a flakiness.

Testes de integração: menos, mas de alto valor

Testes de integração validam como peças funcionam juntas: sua API com o banco, um serviço chamando outro, processamento de filas, autenticação, etc.

Testes de integração gerados por IA podem ser valiosos, mas exigem mais disciplina:

- Setup/teardown claro para que testes não vazem dados

- Ambientes de teste estáveis (containers, bancos de teste, mocks quando apropriado)

- Asserções que foquem em resultados, não em detalhes de implementação

Pense neles como checagens de contrato que provam que as costuras entre componentes ainda estão firmes.

E2E validam fluxos-chave do usuário. Também são os mais caros: mais lentos, mais frágeis e mais difíceis de debugar.

Geração automatizada pode ajudar a rascunhar cenários E2E, mas você deve curá-los agressivamente. Mantenha um conjunto pequeno de caminhos críticos (cadastro, checkout, fluxo principal) e evite gerar E2E para cada feature.

Recomendação prática: gere uma mistura balanceada

Não tente gerar tudo. Em vez disso:

- Gere muitos testes unitários para manter a lógica gerada por IA honesta no nível de função

- Adicione testes de integração direcionados para proteger as junções de maior risco (DB, auth, pagamentos)

- Mantenha uma suíte E2E mínima para as poucas jornadas que você não pode quebrar

Essa abordagem mantém a pirâmide intacta — e faz da geração automatizada de testes um multiplicador de força em vez de fonte de ruído.

O que pode ser gerado: a partir de código, specs e bugs reais

Geração automatizada de testes não se limita a “escrever testes unitários para esta função”. Os geradores mais úteis puxam de três fontes: o código que você tem, a intenção por trás dele e as falhas que você já viu.

1) A partir da estrutura do código: exercite comportamento, não apenas linhas

Dada uma função ou módulo, ferramentas podem inferir casos de teste a partir de entradas/saídas, ramificações e caminhos de exceção. Isso normalmente significa:

- Entradas de “caminho feliz” que devem produzir um resultado conhecido

- Valores de limite (strings vazias, zero, comprimentos máximos)

- Cobertura de ramificação (if/else)

- Tratamento de erro (entradas inválidas, campos ausentes, timeouts)

Esse estilo é ótimo para rapidamente cercar lógica gerada por IA com checagens que confirmem o que ela realmente faz hoje.

Se você tem critérios de aceitação, user stories ou tabelas de exemplo, geradores podem convertê-los em testes que leem como a spec. Isso frequentemente traz mais valor do que testes derivados do código porque tranca “o que deve acontecer”, não “o que acontece hoje”.

Um padrão prático: forneça alguns exemplos concretos (entradas + resultados esperados) e peça ao gerador para adicionar casos de borda consistentes com essas regras.

3) A partir de relatórios de bug: reproduza primeiro, depois previna

Geração baseada em bugs é a maneira mais rápida de construir uma suíte de regressão significativa. Alimente os passos para reproduzir (ou logs e um payload mínimo) e gere:

- um teste que falha no comportamento atual bugado, depois

- o mesmo teste passando uma vez consertado — guardando para sempre contra reintroduções.

Snapshot (golden) tests podem ser eficientes para saídas estáveis (UI renderizada, respostas serializadas). Use-os com cuidado: snapshots grandes podem “aprovar” erros sutis. Prefira snapshots pequenos e focados e combine-os com asserções em campos-chave que devem estar corretos.

Escolhendo o que testar primeiro (sem ferver o oceano)

Geração automatizada de testes é mais eficaz quando você dá prioridades claras. Se você apontar para um código inteiro e pedir “todos os testes”, terá ruído: muitas checagens de baixo valor, cobertura duplicada e testes frágeis que tornam a entrega mais lenta.

Comece onde o negócio sentiria dor

Comece pelos fluxos que seriam mais caros de quebrar — financeiramente, legalmente ou reputacionalmente. Um filtro baseado em risco mantém o escopo realista enquanto melhora a qualidade rapidamente.

Foque primeiro em:

- Caminhos críticos de negócio (cadastro, checkout, fluxos centrais) e áreas que mudam com frequência (features ativas, refactors, integrações novas).

- Domínios de alto risco: pagamentos, autenticação, integridade de dados, permissões/papéis e qualquer coisa que afete o que usuários podem ver ou fazer.

Para cada fluxo escolhido, gere testes em camadas: alguns testes unitários rápidos para a lógica complicada, mais um ou dois testes de integração que confirmem que todo o caminho funciona.

“Caminho feliz + principais casos de borda” vence combinações exaustivas

Peça cobertura que corresponda a falhas reais, não a permutações teóricas. Um bom conjunto inicial é:

- Um teste de caminho feliz que prove o comportamento esperado.

- Os principais casos de borda que você realmente teme: entrada faltante/inválida, tokens expirados, permissões insuficientes, conflitos de concorrência e estado “vazio”.

Você pode sempre expandir depois com base em bugs, relatórios de incidentes ou feedback de usuários.

Defina “pronto” para que permaneça pronto

Torne a regra explícita: uma feature não está completa até que existam testes. Essa definição de pronto importa ainda mais com código escrito por IA, porque impede que “envio rápido” vire “regressões rápidas”.

Se quiser que isso fixe, conecte ao seu fluxo (por exemplo, exija testes relevantes antes do merge no seu CI) e linke a expectativa na documentação da equipe (ex.: /engineering/definition-of-done).

Padrões de prompting que produzem testes melhores

A IA pode gerar testes rapidamente, mas a qualidade depende muito de como você pede. O objetivo é guiar o modelo para testes que protejam comportamento — não testes que apenas executem código.

Coloque seu padrão de codificação diretamente no prompt

Comece fixando a “forma” dos testes para que a saída combine com seu repositório.

Inclua:

- Linguagem + framework de teste (ex.: TypeScript + Jest, Python + pytest)

- Regras de nomeação (ex.:

should_<behavior>_when_<condition>)

- Local e estrutura de arquivos (ex.:

src/ e tests/, ou __tests__/)

- Convenções (fixtures, factory helpers, biblioteca de mocking)

Isso evita que o modelo invente padrões que seu time não usa.

Forneça 1–2 exemplos reais de teste para copiar

Cole um arquivo de teste existente (ou um pequeno trecho) e diga explicitamente: “Imite este estilo.” Isso ancora decisões como arranjo de dados de teste, nome de variáveis e preferência por testes orientados por tabela.

Se seu projeto tem helpers (ex.: buildUser() ou makeRequest()), inclua esses trechos também para que os testes gerados os reutilizem em vez de reimplementarem.

Peça asserções significativas (não apenas “roda sem erro”)

Seja explícito sobre o que é “bom”:

- Asserte saídas e mudanças de estado

- Verifique efeitos colaterais (ex.: escritas no banco, eventos emitidos)

- Asserte tipos/ mensagens de erro quando apropriado

Uma linha útil de prompt: “Cada teste deve conter pelo menos uma asserção sobre comportamento de negócio (não apenas ‘nenhuma exceção lançada’).”

Exija testes negativos e de limite

A maioria das suítes geradas pende para o caminho feliz. Contra isso, solicite:

- Entradas inválidas e falhas esperadas

- Valores de limite (strings vazias, zero, tamanho máximo)

- Falhas de permissão/autorização

- Dependências ausentes (ex.: respostas nulas, timeouts)

Um template prático de prompt

Generate unit tests for \u003cfunction/module\u003e.

Standards: \u003clanguage\u003e, \u003cframework\u003e, name tests like \u003cpattern\u003e, place in \u003cpath\u003e.

Use these existing patterns: \u003cpaste 1 short test example\u003e.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Revisão humana: garantir que testes gerados realmente ajudem

A IA pode rascunhar muitos testes rapidamente, mas não pode ser o veredito final sobre se esses testes representam sua intenção. Uma revisão humana transforma “testes que rodam” em “testes que nos protegem.” O objetivo não é discutir estilo — é confirmar que a suíte de testes vai pegar regressões significativas sem virar um ônus de manutenção.

Revisar por correção e relevância

Comece fazendo duas perguntas:

- O teste afirma comportamento que o produto realmente precisa?

- Você ficaria satisfeito se esse teste falhasse numa mudança futura — porque ele sinalizou um problema real?

Testes gerados às vezes consolidam comportamento acidental (detalhes de implementação) em vez da regra pretendida. Se um teste lê como uma cópia do código em vez de descrever resultados esperados, empurre-o para asserções de nível mais alto.

Fique de olho na fragilidade (o silencioso assassino de produtividade)

Fontes comuns de flakiness: mocking excessivo, timestamps codificados e valores aleatórios. Prefira entradas determinísticas e asserções estáveis (por exemplo, verificar uma data parseada ou um intervalo em vez de uma string exata de Date.now()). Se um teste exige mocking excessivo para passar, talvez esteja testando ligação em vez de comportamento.

Garanta que falhas ocorram pelo motivo certo

Um teste “passando” pode ser inútil se também passaria quando a feature estiver quebrada (falso positivo). Procure asserções fracas como “não lança” ou verificar apenas que uma função foi chamada. Fortaleça-as afirmando saídas, mudanças de estado, erros retornados ou dados persistidos.

Use um checklist leve de code review

Um checklist simples mantém as revisões consistentes:

- Legibilidade: nomes claros, setup mínimo, intenção óbvia

- Cobertura da intenção: casos chave e caminhos de erro incluídos

- Manutenibilidade: evita especificar demais internals; mocking mínimo

- Qualidade do sinal: falharia numa regressão real, não em refactors inofensivos

Trate testes gerados como qualquer outro código: faça merge apenas do que você toparia manter em seis meses.

Fazer isso valer: checagens de CI que mantêm o código de IA honesto

A IA pode ajudar a escrever código rápido, mas a vitória real é manter esse código correto ao longo do tempo. A forma mais simples de “trancar” qualidade é fazer testes e checagens rodarem automaticamente em toda mudança — assim regressões são pegas antes de irem ao ar.

Um fluxo prático que funciona

Um fluxo leve que muitas equipes adotam:

- Gere ou edite o código da feature (assistido por IA ou não).

- Gere testes para o novo comportamento (e para o bug que você acabou de consertar).

- Rode tudo localmente para confirmar que está verde.

- Faça commit do código + testes juntos.

Esse último passo importa: código escrito por IA sem testes tende a divergir. Com testes, você registra o comportamento pretendido de forma que o CI possa impor.

CI como rede de segurança inegociável

Configure seu pipeline de CI para rodar em cada pull request (e idealmente nos merges para main). No mínimo, ele deve:

- Instalar dependências em um ambiente limpo

- Rodar testes unitários/integrados

- Falhar o build em qualquer falha de teste

Isso evita “funcionou na minha máquina” e pega quebras acidentais quando um colega (ou um prompt de IA posterior) muda código em outro lugar.

Adicione alguns gates de qualidade (mantenha leves)

Testes são essenciais, mas não pegam tudo. Adicione gates rápidos que complementem a geração de testes:

- Linting (estilo + erros comuns)

- Checagens de tipos (quando aplicável)

- Formatação (para manter diffs legíveis)

Mantenha essas checagens rápidas — se o CI ficar lento ou barulhento, as pessoas procuram formas de contorná-lo.

Planejamento de custo e capacidade

Se você expandir execuções de CI porque está gerando mais testes, confirme que seu orçamento acompanha a nova cadência. Se você monitora minutos de CI, vale revisar limites e opções (veja /pricing).

Usar testes que falham para guiar a próxima iteração da IA

Uma forma surpreendentemente eficaz de trabalhar com código gerado por IA é tratar testes que falham como seu “próximo prompt”. Em vez de pedir ao modelo para “melhorar a feature” de forma ampla, você fornece uma falha concreta e deixa essa falha limitar a mudança.

O fluxo: falha → prompt → conserto → repita

- Rode a suíte (ou o CI) e capture uma falha. Copie o nome do teste que falhou e a mensagem de asserção/stack trace relevante.

- Peça à IA para resolver apenas essa falha. Forneça o contexto mínimo de código (o teste que falhou e a função/módulo relevante), além de qualquer regra de negócio que possa estar sendo violada.

- Exija um teste de regressão primeiro. Se a falha vier de um bug ou produção, solicite que a IA adicione/ajuste um teste que reproduza o bug antes de mudar a implementação.

- Aplique a menor mudança que faça o teste passar. Rode os testes imediatamente.

- Passe para a próxima falha. Uma falha por vez mantém a iteração enxuta e compreensível.

Padrão de prompting: mantenha pequeno e verificável

Em vez de:

- “Corrija a lógica de login e atualize os testes.”

Use:

- “Este teste falha:

shouldRejectExpiredToken. Aqui está a saída de falha e o código relevante. Atualize a implementação para que este teste passe sem mudar comportamento não relacionado. Se necessário, adicione um teste de regressão que capture o bug.”

Por que isso reduz idas-e-vindas

Testes que falham eliminam suposições. Eles definem o que é “correto” em forma executável, então você não negocia requisitos no chat. Também evita edições amplas: cada prompt é delimitado a um resultado mensurável, tornando a revisão humana mais rápida e mais fácil identificar quando a IA “consertou” o sintoma mas quebrou outra coisa.

Isso também é onde um fluxo estilo agente pode valer a pena: um agente foca na mudança mínima de código, outro propõe o ajuste mínimo do teste, e você revisa o diff. Plataformas como Koder.ai são construídas em torno desse tipo de fluxo iterativo e orientado por chat — fazendo de “testes como próximo prompt” um modo padrão em vez de técnica especial.

Medir sucesso sem perseguir métricas de vaidade

Geração automatizada de testes pode inflar sua suíte da noite para o dia — mas “maior” não é o mesmo que “melhor”. O objetivo é confiança: pegar regressões cedo, reduzir defeitos em produção e manter o time em movimento.

Métricas que realmente refletem qualidade

Comece com sinais que mapeiam para resultados que você valoriza:

- Taxa de builds passados (no main): se merges frequentemente quebram, testes gerados podem estar fracos ou seus prompts estão produzindo suposições incorretas.

- Taxa de testes instáveis: acompanhe com que frequência testes falham e passam ao reexecutar. Uma taxa crescente de flakiness é um imposto sobre a confiança dos devs.

- Tempo para detectar regressões: meça o tempo entre introduzir um bug e uma execução de CI que o pegue. Testes gerados devem encurtar essa janela cobrindo casos de borda e mudanças recentes.

Trate cobertura como uma pista, não uma pontuação

Cobertura pode ser um alarme útil — especialmente para achar caminhos críticos sem teste — mas é fácil manipular. Testes gerados podem inflar cobertura enquanto afirmam pouco (ou afirmam o errado). Prefira indicadores como:

- Asserções por teste (checagem de sanidade, não KPI)

- Resultados de mutation testing (se você usar)

- Se os testes falham quando você quebra deliberadamente o comportamento

Foque em “defeitos pegos antes do release”

Se você acompanhar apenas contagem de testes ou cobertura, vai otimizar para volume. Meça defeitos pegos antes do release: bugs encontrados no CI, QA ou staging que teriam alcançado usuários. Quando a geração automatizada funciona, esse número sobe enquanto incidentes em produção caem.

Agende limpeza para manter os ganhos reais

Suítes geradas precisam de manutenção. Coloque uma tarefa recorrente no calendário para:

- Remover testes redundantes que não oferecem proteção única

- Estabilizar ou excluir testes flakey

- Consolidar casos sobrepostos em testes mais claros e com intenção

Sucesso é um CI mais calmo, feedback mais rápido e menos surpresas — não um dashboard impressionante.

Armadilhas comuns e um plano de rollout prático

Geração automatizada de testes pode elevar a qualidade rapidamente — mas só se você tratá-la como auxiliar, não autoridade. As maiores falhas tendem a se repetir entre times, e elas são evitáveis.

Armadilhas comuns a observar

Excesso de confiança é a clássica: testes gerados podem criar a ilusão de segurança enquanto perdem riscos reais. Se pessoas pararem de pensar criticamente (“a ferramenta escreveu testes, então estamos cobertos”), você vai entregar bugs mais rápido — só com mais checks verdes.

Outro problema frequente é testar detalhes de implementação ao invés de comportamento. Ferramentas de IA costumam se agarrar a nomes de métodos, helpers internos ou mensagens exatas de erro. Esses testes ficam frágeis: refactors os quebram mesmo quando a feature continua funcionando. Prefira testes que descrevam o que deve acontecer, não como acontece.

Segurança e privacidade: não vaze o que não deve compartilhar

Geração de testes muitas vezes envolve colar código, stack traces, logs ou specs em um prompt. Isso pode expor segredos (chaves), dados de clientes ou lógica proprietária.

Mantenha prompts e fixtures livres de informação sensível:

- Redija tokens, credenciais e URLs internas.

- Evite colar logs de produção com dados pessoais.

- Use exemplos sintéticos (contas fake, IDs fictícios) para dados de teste.

- Se precisar compartilhar casos reais, minimize e anonimizar.

Se você usa uma plataforma de IA hospedada, aplique a mesma disciplina. Mesmo quando a plataforma oferece deploys modernos e hospedagem regional, seus prompts e fixtures ainda fazem parte da postura de segurança.

Um plano de rollout prático (que times realmente seguem)

Comece pequeno e torne rotina:

- Escolha um serviço ou módulo com mudanças frequentes.

- Gere testes unitários para os caminhos de maior risco (movimentação de dinheiro, permissões, transformações de dados).

- Adicione uma regra CI simples: novas features assistidas por IA devem incluir testes (veja /blog/ci-checks-for-ai-code).

- Exija uma revisão rápida com checklist: “Este teste afirma comportamento? Falharia pelo motivo certo?”

- Acompanhe regressões prevenidas (não só cobertura) e então expanda para testes de integração quando unitários estiverem estáveis.

O objetivo não é máximo de testes — é feedback confiável que mantém a lógica gerada por IA honesta.