Por que a implantação e o SSR viraram produtos

Não faz tanto tempo, publicar um app web normalmente significava: construir, achar um host, configurar e manter funcionando. Mesmo que o código fosse simples, colocá‑lo no ar frequentemente exigia decisões sobre servidores, cache, pipelines de build, certificados TLS e monitoramento. Nada disso era glamouroso, mas era inevitável — e rotineiramente desviava equipes do produto que estavam tentando entregar.

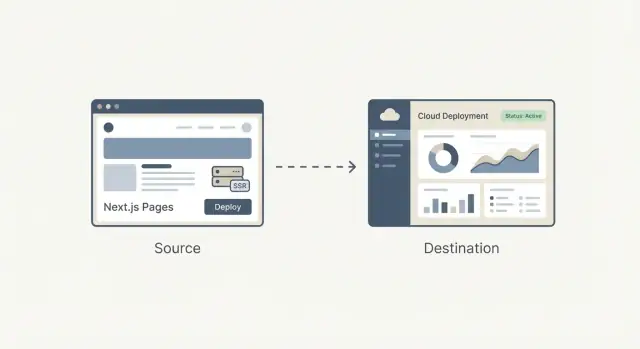

De “hospedagem” a um fluxo de trabalho repetível

A grande mudança é que a implantação deixou de ser um projeto técnico pontual e virou um fluxo de trabalho que você repete todos os dias. As equipes queriam URLs de preview para cada pull request, rollbacks que não exigissem trabalho de detetive e um caminho confiável do código local até a produção.

Quando essas necessidades se tornaram comuns em startups, agências e empresas, a implantação passou a parecer menos engenharia customizada e mais algo que podia ser empacotado: um produto com padrões claros, uma interface, automações sensatas e resultados previsíveis.

Por que implantação e SSR pareciam especializados

A renderização no servidor (SSR) adicionou outra camada de complexidade. Não é apenas “servir arquivos”; é “executar código no servidor para gerar HTML, fazer cache de forma segura e atualizar sem quebrar os usuários.” Fazer SSR bem exigia entender:

- Ambientes de execução (Node, funções serverless)

- Regras de cache e invalidação

- Compromissos de performance e cold starts

- Roteamento, rewrites e headers

Isso era administrável por especialistas, mas fácil de configurar errado — e difícil de manter conforme um projeto crescia.

A pergunta central que este artigo responde

O que significa productizar a infraestrutura de frontend?

Significa transformar as partes bagunçadas e propensas a erro de entregar um front — builds, deploys, previews, tratamento SSR/SSG, cache e entrega na borda — em um sistema padronizado e em grande parte automático que funciona do mesmo modo em diferentes projetos.

Nas seções a seguir, o objetivo é prático: entender o que está sendo simplificado, o que você ganha e quais trade‑offs você aceita — sem precisar se tornar um especialista em ops.

O papel de Guillermo Rauch na pilha moderna de frontend

Guillermo Rauch é hoje mais conhecido como CEO da Vercel e como uma voz influente por trás do Next.js. Sua influência é menos sobre uma única invenção e mais sobre uma obsessão consistente: fazer o desenvolvimento web parecer “óbvio” para quem constrói produtos.

Construtor + líder de open source (a parte factual)

Rauch passou grande parte da carreira lançando ferramentas para desenvolvedores em público. Antes da Vercel, manteve projetos open source populares (notavelmente o Socket.IO) e ajudou a cultivar uma cultura em que documentação, exemplos e padrões sensatos são parte do produto — não apenas detalhes posteriores.

Depois fundou a ZEIT (renomeada para Vercel), uma empresa focada em transformar a implantação em um fluxo de trabalho enxuto. O Next.js, originado nesse ecossistema, tornou‑se o framework carro‑chefe que combinou uma experiência moderna de frontend com recursos prontos para produção.

Experiência do desenvolvedor como decisão de produto

Uma maneira útil de entender o impacto de Rauch é pelas escolhas que se repetiam:

- Reduzir o número de passos “só para especialistas” entre o código e uma URL ao vivo.

- Tornar opções de performance e renderização acessíveis por convenções.

- Preferir fluxos fim a fim (framework + hospedagem) quando isso reduz atrito.

Esse foco moldou tanto o framework quanto a plataforma: o Next.js incentivou equipes a adotar SSR e geração estática sem exigir um novo manual operacional, enquanto a Vercel empurrou a implantação para um padrão previsível e repetível.

Fato vs interpretação (sem mitos de herói)

É fácil transformar essa história em um relato de uma única pessoa. Uma interpretação mais precisa é que Rauch ajudou a alinhar uma mudança mais ampla que já acontecia: equipes de frontend queriam iteração mais rápida, menos handoffs e infraestrutura que não exigisse um especialista em ops a cada alteração.

Vercel e Next.js funcionam como um estudo de caso em pensamento de produto porque embalaram esses desejos em padrões que equipes comuns realmente podiam usar.

Next.js em termos simples: o que ele resolve

Next.js é um framework React que te dá um “kit inicial completo” por cima do React. Você continua construindo componentes da mesma maneira, mas o Next.js adiciona as peças que a maioria das equipes acaba montando: pages, roteamento, formas de buscar dados e padrões de performance prontos para produção.

Os problemas que ele resolve

Roteamento e pages: Num app React simples, normalmente você adiciona uma biblioteca de roteamento, decide convenções de URL e liga tudo. O Next.js torna URLs e pages uma feature de primeira classe, então a estrutura da sua aplicação mapeia naturalmente para rotas.

Carregamento de dados: Apps reais precisam de dados — listas de produtos, contas de usuário, conteúdo de CMS. O Next.js fornece padrões comuns para carregar dados no servidor, no build ou no navegador, sem forçar cada time a inventar uma configuração própria.

Padrões de performance: Next.js incorpora otimizações práticas — code splitting, tratamento de assets mais inteligente e escolhas de renderização — para que você tenha boa velocidade sem caçar uma longa lista de plugins.

Como difere de um “React puro”

Um app React puro costuma ser “React + um monte de decisões”: biblioteca de roteamento, configuração de build, ferramentas SSR/SSG (se precisar) e convenções que só existem no seu repositório.

Next.js é mais opinativo: ele padroniza as decisões comuns para que novos desenvolvedores entendam o projeto mais rápido e as equipes gastem menos tempo mantendo infraestrutura.

Quando o Next.js pode ser desnecessário

Next.js pode ser exagero se você está construindo um site pequeno e principalmente estático com poucas páginas, ou uma ferramenta interna simples onde SEO e primeiro carregamento não são prioridades.

Se você não precisa de múltiplas opções de renderização, roteamento estruturado ou carregamento de dados no servidor, uma configuração React leve (ou nem usar React) pode ser a escolha mais simples e barata.

SSR, SSG e Renderização no Cliente: diferenças práticas

Apps modernos podem parecer misteriosos porque “onde a página é montada” muda conforme a abordagem. Uma forma simples de pensar sobre SSR, SSG e client‑side rendering (CSR) é: quando e onde o HTML é criado?

SSR (Server‑Side Rendering)

Com SSR, o servidor gera o HTML por requisição (ou para muitas requisições se houver cache). Isso ajuda no SEO e faz a primeira visualização parecer rápida — especialmente em dispositivos mais lentos — porque o navegador recebe conteúdo real cedo.

Um equívoco comum: SSR não é automaticamente mais rápido. Se cada requisição disparar consultas lentas ao banco, o SSR pode parecer devagar. A velocidade real frequentemente vem do cache (no servidor, CDN ou edge) para que visitas repetidas não refaçam o trabalho.

SSG (Static Site Generation)

Com SSG, as páginas são pré‑construídas antes do tempo de execução (durante o build) e servidas como arquivos estáticos. Isso é excelente para confiabilidade e custo, e costuma entregar tempos de carregamento muito bons porque a página já está “pronta” antes do usuário chegar.

SSG se destaca em páginas de marketing, docs e conteúdo que não muda a todo momento. A contrapartida é frescor: atualizar conteúdo pode exigir um rebuild ou uma estratégia de atualização incremental.

CSR (Client‑Side Rendering)

No CSR, o navegador baixa o JavaScript e monta a UI no dispositivo do usuário. Isso é perfeito para partes muito interativas e personalizadas (dashboards, editores), mas pode atrasar a primeira visualização significativa e complicar SEO se o conteúdo não estiver disponível como HTML inicialmente.

Por que as equipes misturam os três

A maioria dos produtos reais combina modos: SSG para landing pages (SEO e velocidade), SSR para páginas dinâmicas que ainda precisam ser indexáveis (páginas de produto, listagens) e CSR para experiências autenticadas.

Escolher bem conecta diretamente a resultados: SEO (descobribilidade), velocidade (conversão) e confiabilidade (menos incidentes, receita mais estável).

Antes da productização: como era implantar apps web

Antes das plataformas fazerem a implantação parecer um clique, publicar um app web frequentemente significava montar um mini “projeto de infraestrutura”. Mesmo um site de marketing simples com um formulário dinâmico podia virar uma cadeia de servidores, scripts e serviços que precisavam permanecer em sincronia.

O fluxo típico

Uma configuração comum era: provisionar um ou mais servidores (ou uma VM), instalar um web server e configurar um pipeline de CI que construía o app e copiava artefatos via SSH.

Acima disso, você podia configurar um proxy reverso (como Nginx) para rotear requisições, terminar TLS e lidar com compressão. Depois vinha o cache: talvez uma configuração de HTTP cache, um CDN e regras sobre quais páginas eram seguras para cachear e por quanto tempo.

Se você precisava de SSR, estava operando um processo Node que precisava ser iniciado, monitorado, reiniciado e escalado.

Pontos dolorosos que atrasavam equipes

Os problemas não eram teóricos — apareciam a cada release:

- Drift de configuração: staging é “bom o bastante” até que não é. Uma diferença menor de pacote do SO podia quebrar builds ou o runtime.

- Releases lentos: cada deploy exigia coordenação entre scripts de CI, estado do servidor, variáveis de ambiente e invalidação de cache.

- Rollbacks difíceis: reverter muitas vezes significava re‑deployar um build antigo e torcer para o estado do servidor e dependências estarem iguais.

Por que “funciona na minha máquina” era tão comum

O desenvolvimento local esconde as partes bagunçadas: cache aquecido, versão diferente do Node, variáveis de ambiente distintas e nenhum tráfego real.

Quando implantado, essas diferenças surgem imediatamente — muitas vezes como mismatches de SSR sutis, segredos faltando ou regras de roteamento que se comportam diferente atrás de um proxy.

O imposto oculto para equipes pequenas

Configurações avançadas (SSR, multi‑região, previews seguros) eram possíveis, mas exigiam tempo operacional. Para muitas equipes pequenas, isso significava adotar uma arquitetura mais simples — não porque fosse melhor, mas porque o overhead de implantação era alto demais.

A ideia central da Vercel: implantação como fluxo padrão

Teste o fluxo de trabalho pronto para produto

Crie seu primeiro app web no plano gratuito e itere em um fluxo por chat.

A Vercel não apenas automatizou o deploy — ela o empacotou em um fluxo padrão que faz parte do ato de escrever código. A ideia de produto é simples: implantar não deveria ser uma tarefa de ops separada; deveria ser o resultado normal do desenvolvimento diário.

“Git push para deploy” como produto

“Git push para deploy” frequentemente é descrito como um script arrumadinho. A Vercel trata isso mais como uma promessa: se seu código está no Git, ele é deployável — consistentemente, repetidamente e sem uma lista de verificações manuais.

Essa diferença importa porque muda quem se sente confiante para enviar mudanças. Você não precisa de um especialista para interpretar configurações de servidor, regras de cache ou passos de build a cada vez. A plataforma transforma essas decisões em padrões e guardrails.

Deploys de preview mudam a colaboração

Deploys de preview são uma grande parte de por que isso parece um fluxo, não uma ferramenta. Cada pull request pode gerar uma URL compartilhável que reproduz de perto o comportamento de produção.

Designers podem revisar espaçamento e interações em um ambiente real. QA testa o build exato que iria para produção. PMs clicam na feature e deixam feedback concreto — sem esperar por um push para staging ou pedir alguém para rodar a branch localmente.

Rollbacks e paridade de ambiente como ferramentas de segurança

Quando implantar vira algo frequente, segurança vira uma necessidade diária. Rollbacks rápidos significam que um release ruim é um inconveniente, não um incidente.

A paridade de ambiente — manter previews, staging e produção comportando‑se de forma semelhante — reduz o problema do “funciona na minha máquina” que atrasa equipes.

Uma história de usuário simples: marketing + atualização do app

Imagine que você está lançando uma nova página de preços e uma pequena alteração no fluxo de cadastro. Com preview deploys, o time de marketing revisa a página, QA testa o fluxo e a equipe faz merge com confiança.

Se a análise mostra um problema após o lançamento, você faz rollback em minutos enquanto corrige — sem travar todo o resto do trabalho.

Do CDN à edge: infraestrutura frontend sem time de ops

Um CDN (Content Delivery Network) é um conjunto de servidores pelo mundo que armazenam (e entregam) cópias dos arquivos do seu site — imagens, CSS, JavaScript e às vezes HTML — para que usuários baixem de um ponto próximo.

Cache é o conjunto de regras sobre por quanto tempo essas cópias podem ser reutilizadas. Bom cache significa páginas mais rápidas e menos acesso ao servidor de origem. Cache ruim significa usuários vendo conteúdo desatualizado — ou sua equipe com medo de cachear qualquer coisa.

A edge é o próximo passo: em vez de apenas servir arquivos de locais globais, você pode executar pequenos trechos de código perto do usuário, no tempo da requisição.

É aí que “infraestrutura frontend sem o time de ops” vira realidade: muitas equipes ganham distribuição global e tratamento inteligente de requisições sem gerir servidores em múltiplas regiões.

Para que as funções na edge são úteis

Funções na edge brilham quando você precisa tomar decisões rápidas antes de servir uma página:

- Personalização: escolher conteúdo por localização, dispositivo ou segmento de usuário.

- Checagens de auth: redirecionar usuários não autenticados, validar sessão ou setar headers.

- Testes A/B: direcionar usuários para experimentos de forma consistente (sem viagens extras).

Quando a edge é exagero

Se seu site é majoritariamente estático, tem pouco tráfego ou restrições sobre onde o código pode executar (por requisitos legais ou de residência de dados), a edge pode acrescentar complexidade sem ganho claro.

Trade‑offs a entender

Executar código em muitos locais pode tornar observabilidade e depuração mais difíceis: logs e traces ficam mais distribuídos, e reproduzir um erro que acontece só em uma região pode levar tempo.

Também há comportamentos específicos do fornecedor (APIs, limites, diferenças de runtime) que afetam portabilidade.

Usadas com critério, capacidades de edge permitem que equipes tenham desempenho global por padrão — sem contratar um time de ops para juntar tudo.

Da ideia à pré-visualização ao vivo

Crie um app React via chat e lance uma pré-visualização funcional sem configurar infraestrutura antes.

Um framework e uma plataforma “se encaixam” quando o host entende o que o framework produz no build e o que ele precisa no tempo de requisição.

Isso significa que o host consegue interpretar a saída do build (arquivos estáticos vs. funções de servidor), aplicar as regras de roteamento corretas (rotas dinâmicas, rewrites) e definir cache sensato (o que pode ficar na borda, o que precisa ser sempre fresco).

O que a integração simplifica

Quando a plataforma conhece as convenções do framework, muito trabalho some:

- Otimização de imagens pode ser automática: o framework gera um pipeline previsível e o host processa perto dos usuários, cacheando resultados e lidando com formatos.

- Headers e redirects viram configuração em vez de código de servidor customizado. Você declara a intenção (headers de segurança, cache, redirects canônicos) e a plataforma aplica consistentemente.

- Deploys de preview e configurações de ambiente tendem a “simplesmente funcionar” porque o host mapeia branches, builds e settings às expectativas do framework.

O benefício líquido é menos scripts bespoke e menos surpresas de deploy do tipo “funciona na minha máquina”.

Os trade‑offs do acoplamento apertado

O lado negativo é o lock‑in pela conveniência. Se seu app depende de recursos específicos da plataforma (APIs de funções na edge, regras proprietárias de cache, plugins de build), mudar depois pode exigir reescrever partes do roteamento, middleware ou pipeline de implantação.

Para manter portabilidade em mente: separe preocupações — mantenha lógica de negócio framework‑nativa, documente comportamento específico do host e prefira padrões quando possível (headers HTTP, redirects, variáveis de ambiente).

Como avaliar alternativas

Não presuma que exista uma escolha única. Compare plataformas por: fluxo de deploy, modos de renderização suportados, controle de cache, suporte a edge, observabilidade, previsibilidade de preço e facilidade de saída.

Um pequeno proof‑of‑concept — deployar o mesmo repositório em dois provedores — geralmente revela diferenças reais mais rápido que a documentação.

Performance não é só para exibir resultados em um teste. É uma funcionalidade do produto: páginas mais rápidas reduzem bounce e melhoram conversões, e builds mais rápidos deixam as equipes enviarem mais sem ficar esperando.

Dois tipos de “rápido” que importam

Para usuários, “rápido” significa que a página fica utilizável rapidamente — especialmente em celulares medianos e redes lentas. Para equipes, “rápido” significa que deploys terminam em minutos (ou segundos) para que mudanças entrem em produção com confiança.

A Vercel popularizou a ideia de que você pode otimizar ambos ao mesmo tempo, tornando a performance parte do fluxo padrão em vez de um projeto especial.

Builds incrementais e cache (em termos simples)

Um build tradicional costuma reconstruir tudo, mesmo se você editou uma linha numa página. Builds incrementais buscam reconstruir apenas o que mudou — como atualizar um capítulo de um livro em vez de reimprimir o livro inteiro.

O cache ajuda reaproveitando resultados já computados:

- Cache de build reaproveita partes de builds anteriores para acelerar o próximo deploy.

- Cache de renderização mantém páginas pré‑computadas perto dos usuários, para que visitas repetidas não refaçam o trabalho.

No Next.js, padrões como incremental static regeneration (ISR) seguem essa mentalidade: servir uma página pré‑construída e atualizá‑la em segundo plano quando o conteúdo muda.

Um orçamento de performance é um limite simples que você concorda — tipo “manter a homepage abaixo de 200KB de JavaScript” ou “Largest Contentful Paint abaixo de 2.5s em mobile típico.” O objetivo não é perfeição; é evitar que a lentidão entre sorrateiramente.

Checks simples para adicionar ao seu fluxo

Mantenha leve e consistente:

- Rodar Lighthouse no CI para páginas-chave e falhar o build se o orçamento for quebrado.

- Rastrear métricas reais de usuários (RUM) para medir experiência real, não só resultados de laboratório.

- Revisar mudanças no tamanho do bundle em PRs para pegar dependências “só mais uma” cedo.

Quando velocidade é tratada como feature, você melhora a experiência do usuário — e a cadência da equipe — sem transformar cada release em um incêndio de performance.

Tornando‑se mainstream: padrões, templates e curvas de aprendizado

A maioria das ferramentas não vira mainstream por ser a mais flexível — elas vencem porque um usuário novo consegue ter sucesso rápido.

Como builders mainstream escolhem

Builders mainstream (times pequenos, agências, desenvolvedores de produto sem infra profunda) tendem a avaliar plataformas com perguntas simples:

- Conseguimos publicar um site real esta semana?

- Vai ser rápido por padrão?

- Dá para mudar com segurança depois?

É aí que templates, docs claros e fluxos “happy path” importam. Um template que deploya em minutos e demonstra roteamento, fetch de dados e auth costuma ser mais persuasivo que uma matriz de recursos.

Documentação que mostra uma abordagem recomendada (e explica quando se desviar) reduz o tempo gasto em suposições.

Por que defaults sensatos superam opções infinitas

Uma longa lista de toggles pode parecer poderosa, mas força cada time a virar especialista só para tomar decisões básicas. Defaults sensatos reduzem carga cognitiva:

- Bom comportamento de cache por padrão

- Uma abordagem de renderização recomendada por tipo de página

- Tratamento seguro de variáveis de ambiente

- Passos padrão de build/deploy que raramente precisam de customização

Quando os defaults estão certos, as equipes gastam tempo no produto em vez de configuração.

Necessidades comuns que templates deveriam cobrir

Builders do mundo real costumam começar com padrões familiares:

- E‑commerce: páginas de produto, busca, integrações de checkout, SEO

- Sites de conteúdo: páginas puxadas de CMS, previews, otimização de imagem

- Dashboards: auth, acesso por função, navegação rápida, páginas pesadas em API

Os melhores templates não só “ficam bonitos” — eles codificam estrutura comprovada.

Armadilhas para iniciantes

Duas falhas aparecem repetidamente:

- Over‑engineering cedo: adicionar lógica de edge, cache complexo ou múltiplas camadas de dados antes do tráfego justificar.

- Confusão nas escolhas de renderização: misturar SSR/SSG/CSR sem motivo claro, levando a páginas lentas ou builds frágeis.

Uma curva de aprendizado bem projetada empurra equipes para um ponto de partida claro e faz opções avançadas parecerem upgrades deliberados, não deveres obrigatórios.

Productização além do deploy: construir apps a partir da intenção

Plataformas de deploy productizaram o caminho do Git à produção. Uma tendência paralela surge upstream: productizar o caminho da ideia para um código funcional.

Koder.ai é um exemplo dessa direção de “vibe‑coding”: você descreve o que quer numa interface de chat e a plataforma usa um workflow baseado em agentes LLM para gerar e iterar um app real. É voltado para web, servidor e mobile (React no frontend, Go + PostgreSQL no backend, Flutter no mobile), com recursos práticos como exportação de código, deployment/hosting, domínios customizados, snapshots e rollback.

Na prática, isso combina naturalmente com o fluxo descrito aqui: apertar o ciclo de intenção → implementação → URL de preview → produção, mantendo uma saída (exportação de código) quando você ultrapassa os defaults.

Mantenha uma rota de saída

Mantenha o controle exportando o código-fonte quando precisar migrar ou customizar depois.

Escolher uma plataforma de frontend não é só “onde hospedar”. É escolher o fluxo padrão onde sua equipe vai viver: como código vira URL, como mudanças são revisadas e como incidentes são tratados.

1) Modelo de custos: pelo que você realmente paga

Plataformas parecem semelhantes na home, depois divergem nos detalhes de cobrança. Compare as unidades que se mapeiam ao seu uso real:

- Modelo de preço: plano fixo vs. baseado em uso e o que está incluído em cada nível.

- Minutos de build: como o tempo de CI/CD é contado, se previews consomem o mesmo pool e o que acontece ao exceder limites.

- Largura de banda e requisições: como o egress é cobrado, se tráfego de CDN está inclusa e como picos são tratados.

- Assentos de equipe: quem conta como usuário cobrável (devs, designers, contratados) e se existem papéis apenas leitura.

Dica prática: estime custos para um mês normal e para uma “semana de lançamento”. Se você não consegue simular os dois, vai se surpreender no pior momento.

2) Confiabilidade, regiões e escalabilidade

Você não precisa ser especialista em infra, mas faça perguntas diretas:

- Onde dá para implantar (regiões/locais de edge) e dá para controlar isso?

- O que acontece em picos de tráfego — a plataforma faz throttle, enfileira ou falha?

- Como incidentes são comunicados, existe status page pública?

- Qual é a história de rollback: um clique, automático ou manual?

Se seus clientes são globais, cobertura regional e comportamento de cache podem importar tanto quanto desempenho bruto.

3) Noções básicas de segurança que não são negociáveis

Procure salvaguardas do dia a dia em vez de promessas vagas:

- Gerenciamento de segredos: como variáveis de ambiente são armazenadas, rotacionadas e escopadas (prod vs preview).

- Controle de acesso: permissões por papel, suporte a SSO e separação entre projetos.

- Trilhas de auditoria: visibilidade de deploys, mudanças de configuração e quem fez o quê.

4) Checklist leve de seleção

Use isto como filtro rápido antes de avaliar mais a fundo:

- Podemos criar deploys de preview para cada PR com setup mínimo?

- Suporta nossos modos de renderização (estático, server, funções na edge) sem cola extra?

- Logs, métricas e rastreamento de erros são fáceis de achar quando algo quebra?

- Dá para exportar/migrar depois sem reescrever o app?

Escolha a plataforma que reduz decisões de implantação que sua equipe precisa tomar semanalmente — mantendo controle suficiente quando importar.

Conclusões: um playbook simples para equipes que entregam na web

A productização transforma decisões de implantação e renderização de engenharia bespoke em defaults repetíveis. Isso reduz atrito em dois pontos que normalmente atrasam equipes: colocar mudanças no ar e manter performance previsível.

Quando o caminho commit → preview → produção é padronizado, a iteração acelera porque menos releases dependem de um especialista (ou de uma tarde de sorte para debugar).

Um caminho prático de migração (comece pequeno, meça, expanda)

Comece pela menor superfície que te dá feedback:

- Adicione deploys de preview primeiro. Trate cada pull request como algo que dá para clicar e revisar.

- Migre uma página ou rota para um padrão do framework (por exemplo, uma página de marketing para geração estática, ou uma página autenticada para renderização no servidor) e compare os resultados.

- Meça o que importa: tempo de build, frequência de deploy, tempo de rollback, Core Web Vitals e “tempo para revisão” por stakeholders.

Quando isso funcionar, expanda gradualmente:

- Consolide ambientes (preview/staging/prod) e defina quem pode promover.

- Introduza edge ou funções serverless só onde latência ou personalização justificarem.

- Padronize templates para que novos projetos comecem com auth, analytics e padrões de cache funcionando.

Mantenha caminhos de aprendizado leves

Se quiser ir mais a fundo sem se perder, leia padrões e estudos de caso em /blog e confira custos e limites em /pricing.

Se você também experimenta formas mais rápidas de ir de requisito a base funcional (especialmente para times pequenos), o Koder.ai pode ser útil como ferramenta complementar: gere uma primeira versão via chat, itere com stakeholders e mantenha o mesmo caminho productizado até previews, rollbacks e produção.

Conveniência vs controle: como decidir

Plataformas integradas otimizam velocidade de entrega e menos decisões operacionais. O trade‑off é menos controle de baixo nível (infra customizada, requisitos de compliance únicos, redes bespoke).

Escolha a configuração “mais productizada” que ainda atende suas restrições — e mantenha um plano de saída (arquitetura portátil, passos de build claros) para decidir com força, não por aprisionamento.