03 de nov. de 2025·8 min

Leslie Lamport e Sistemas Distribuídos: Tempo, Ordem, Corretude

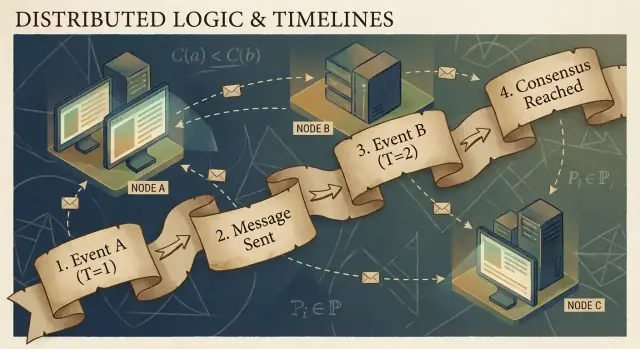

Entenda as ideias centrais de Lamport para sistemas distribuídos — relógios lógicos, ordenamento, consenso e corretude — e por que elas ainda guiam infraestruturas modernas.

Por que Lamport ainda importa para sistemas distribuídos modernos

Leslie Lamport é um dos raros pesquisadores cujo trabalho “teórico” aparece sempre que você entrega um sistema real. Se você já operou um cluster de banco de dados, uma fila de mensagens, um motor de workflows ou qualquer coisa que faça retries e sobreviva a falhas, você tem vivido problemas que Lamport ajudou a nomear e resolver.

O que faz suas ideias persistirem é que elas não estão presas a uma tecnologia específica. Elas descrevem verdades incômodas que aparecem sempre que várias máquinas tentam agir como um único sistema: relógios discordam, redes atrasam e perdem mensagens, e falhas são normais — não excepcionais.

Três temas que usaremos ao longo do texto

Tempo: Em um sistema distribuído, “que horas são?” não é uma pergunta simples. Relógios físicos derivam, e a ordem que você observa eventos pode diferir entre máquinas.

Ordenamento: Uma vez que você não confia em um único relógio, precisa de outras formas de falar sobre quais eventos aconteceram primeiro — e quando você deve forçar todo mundo a seguir a mesma sequência.

Corretude: “Geralmente funciona” não é um projeto. Lamport empurrou a área para definições nítidas (segurança vs. vivacidade) e especificações sobre as quais você pode raciocinar, não apenas testar.

O que esperar (sem matemática pesada)

Focaremos em conceitos e intuição: os problemas, as ferramentas mínimas para pensar claramente, e como essas ferramentas moldam designs práticos.

Aqui está o mapa:

- Por que não haver um relógio compartilhado significa não haver uma única história global de eventos

- Como causalidade ("happened-before") leva a relógios lógicos e carimbos de Lamport

- Quando ordem parcial não basta e você precisa de uma única linha do tempo

- Como consenso e Paxos se relacionam com concordar sobre uma ordem

- Por que replicação de máquina de estados funciona quando o ordenamento é compartilhado

- Como falar sobre corretude em specs — e como ferramentas de modelagem como TLA+ ajudam

O problema central: sem relógio compartilhado, sem uma realidade única

Um sistema é “distribuído” quando é feito de múltiplas máquinas que coordenam pela rede para fazer um trabalho. Isso soa simples até você aceitar duas constatações: máquinas podem falhar independentemente (falhas parciais) e a rede pode atrasar, perder, duplicar ou reordenar mensagens.

Em um programa único em um computador, você geralmente pode apontar “o que aconteceu primeiro”. Em um sistema distribuído, máquinas diferentes podem observar sequências de eventos diferentes — e ambas podem estar corretas do ponto de vista local.

Por que você não pode confiar em um relógio global

É tentador resolver coordenação carimbando tudo com timestamp. Mas não existe um único relógio em que você possa confiar entre máquinas:

- O relógio de hardware de cada servidor deriva em sua própria taxa.

- A sincronização de relógios (como NTP) é best-effort, não uma garantia.

- Virtualização, carga de CPU ou pausas podem fazer o tempo pular ou travar.

Portanto, “evento A aconteceu às 10:01:05.123” em um host não compara de forma confiável com “10:01:05.120” em outro.

Como atrasos embaralham a realidade

Atrasos de rede podem inverter o que você acha que viu. Um write pode ser enviado primeiro mas chegar depois. Um retry pode chegar depois do original. Dois datacenters podem processar a “mesma” requisição em ordens opostas.

Isso torna o debug singularmente confuso: logs de máquinas diferentes podem discordar, e “ordenar por timestamp” pode criar uma história que nunca aconteceu.

Consequências reais

Quando você assume uma única linha do tempo que não existe, você obtém falhas concretas:

- Processamento duplo (um pagamento cobrado duas vezes após retries)

- Inconsistências (dois usuários “conseguem” o mesmo último item)

- Aparente perda de dados (uma atualização que chega depois sobrescreve uma mais nova)

A ideia-chave de Lamport começa aqui: se você não pode compartilhar tempo, deve raciocinar sobre ordem de forma diferente.

Causalidade e a relação happened-before

Programas distribuídos são feitos de eventos: algo que acontece em um nó específico (um processo, servidor ou thread). Exemplos incluem “recebeu uma requisição”, “escreveu uma linha” ou “enviou uma mensagem”. Uma mensagem é o conector entre nós: um evento é o envio, outro é o recebimento.

A visão central de Lamport é que, em um sistema sem um relógio compartilhado confiável, a coisa mais dependável que você pode rastrear é a causalidade — quais eventos poderiam ter influenciado outros eventos.

A relação happened-before (→)

Lamport definiu uma regra simples chamada happened-before, escrita A → B (o evento A aconteceu antes do evento B):

- Ordem no mesmo processo: Se A e B ocorrem no mesmo processo/máquina, e A é observado como ocorrendo antes naquele processo, então A → B.

- Ordem por mensagem: Se A é “enviar mensagem m” e B é “receber mensagem m”, então A → B.

- Transitividade: Se A → B e B → C, então A → C.

Essa relação lhe dá uma ordem parcial: ela diz que alguns pares estão ordenados, mas nem todos.

Uma história concreta: usuário → requisição → BD → cache

Um usuário clica em “Comprar”. Esse clique aciona uma requisição a um servidor API (evento A). O servidor escreve uma linha de pedido no banco de dados (evento B). Depois que a escrita termina, o servidor publica uma mensagem “pedido criado” (evento C), e um serviço de cache recebe e atualiza uma entrada (evento D).

Aqui, A → B → C → D. Mesmo se os relógios divergirem, a mensagem e a estrutura do programa criam ligações causais reais.

O que “concorrente” realmente significa

Dois eventos são concorrentes quando nenhum causou o outro: nem (A → B) nem (B → A). Concorrência não significa “mesmo tempo” — significa “nenhum caminho causal os conecta”. Por isso dois serviços podem cada um alegar que agiu “primeiro”, e ambos podem estar corretos, a menos que você acrescente uma regra de ordenamento.

Relógios lógicos: carimbos de Lamport em linguagem simples

Se você já tentou reconstruir “o que aconteceu primeiro” entre várias máquinas, já bateu no problema básico: computadores não compartilham um relógio perfeitamente sincronizado. O artifício de Lamport é parar de perseguir tempo perfeito e, em vez disso, rastrear ordem.

A ideia: um contador anexado a cada evento

Um carimbo de Lamport é só um número que você anexa a cada evento significativo em um processo (uma instância de serviço, um nó, uma thread — o que você escolher). Pense nisso como um “contador de eventos” que dá uma forma consistente de dizer “este evento ocorreu antes daquele”, mesmo quando o relógio de parede é pouco confiável.

As duas regras (e elas realmente são assim de simples)

-

Incrementar localmente: antes de registrar um evento (por exemplo, “escreveu no BD”, “enviou requisição”, “apendou entrada no log”), incremente seu contador local.

-

Ao receber, pegar max + 1: quando você recebe uma mensagem que inclui o timestamp do remetente, defina seu contador como:

max(local_counter, received_counter) + 1

Então carimbe o evento de recebimento com esse valor.

Essas regras garantem que os timestamps respeitem a causalidade: se o evento A pôde influenciar o evento B (porque informação fluiu via mensagens), então o timestamp de A será menor que o de B.

O que carimbos de Lamport podem — e não podem — dizer

Eles podem dizer sobre ordenamento causal:

- Se

TS(A) < TS(B), A pode ter acontecido antes de B. - Se A causou B (direta ou indiretamente), então necessariamente

TS(A) < TS(B).

Eles não podem dizer sobre tempo real:

- Um timestamp menor não significa “mais cedo em segundos.”

- Dois eventos podem ser concorrentes (nenhum causou o outro) e ainda acabar com timestamps diferentes por causa de padrões de mensagens.

Portanto, carimbos de Lamport são ótimos para ordenamento, não para medir latência ou responder “que horas eram?”.

Exemplo prático: ordenando entradas de log entre serviços

Imagine que o Serviço A chama o Serviço B, e ambos escrevem logs de auditoria. Você quer uma visão unificada de logs que preserve causa e efeito.

- Serviço A incrementa seu contador, registra “iniciando pagamento”, envia requisição a B com timestamp 42.

- Serviço B recebe a requisição com 42, define seu contador para

max(local, 42) + 1, digamos 43, e registra “cartão validado”. - B responde com 44; A recebe, atualiza para 45, e registra “pagamento concluído”.

Agora, ao agregar logs de ambos os serviços, ordenar por (lamport_timestamp, service_id) dá uma linha do tempo estável e explicável que corresponde à cadeia real de influência — mesmo se os relógios de parede divergiram ou a rede atrasou mensagens.

De ordem parcial a ordem total: quando você precisa de uma única linha do tempo

A causalidade lhe dá uma ordem parcial: alguns eventos estão claramente “antes” de outros (porque uma mensagem ou dependência os conecta), mas muitos eventos são simplesmente concorrentes. Isso não é um bug — é a forma natural da realidade distribuída.

Ordem parcial: suficiente para muitas perguntas

Se você está debugando “o que poderia ter influenciado isso?”, ou aplicando regras como “uma resposta deve seguir sua requisição”, a ordem parcial é exatamente o que você quer. Você só precisa respeitar as arestas happened-before; o resto pode ser tratado como independente.

Ordem total: necessária quando o sistema precisa escolher uma única história

Alguns sistemas não toleram “qualquer ordem serve”. Eles precisam de uma sequência única de operações, especialmente para:

- Escritas em um objeto compartilhado (“definir saldo”, “atualizar perfil”, “apendar ao log”)

- Comandos que devem ser aplicados idêntica e determinísticamente em todo lugar (replicação de máquina de estados)

- Resolução de conflitos onde “última escrita vence” precisa significar a mesma coisa para todo nó

Sem uma ordem total, duas réplicas podem ambas estar “corretas” localmente e ainda divergir globalmente: uma aplica A então B, outra aplica B então A, e você obtém resultados diferentes.

Como obter uma única linha do tempo?

Você introduz um mecanismo que cria ordem:

- Um sequenciador/líder que atribui uma posição monotonicamente crescente a cada comando.

- Ou consenso (por exemplo, abordagens ao estilo Paxos) para que o cluster concorde sobre a próxima entrada do log mesmo com atrasos e falhas.

Os trade-offs que você não pode evitar

Uma ordem total é poderosa, mas custa algo:

- Latência: você pode esperar por coordenação antes de confirmar.

- Throughput: um log ordenado pode se tornar um gargalo.

- Disponibilidade durante falhas: se você não consegue alcançar nós suficientes para concordar, o progresso pode pausar para proteger a corretude.

A escolha de projeto é simples de afirmar: quando a corretude requer uma narrativa compartilhada, você paga custos de coordenação para obtê-la.

Consenso: concordando na presença de atraso e falha

Experimente consenso

Projete um serviço de eleição de líder e teste casos de falha rapidamente com snapshots e rollback.

Consenso é o problema de fazer várias máquinas concordarem sobre uma decisão — um valor a ser confirmado, um líder a seguir, uma configuração a ativar — mesmo que cada máquina só veja seus próprios eventos locais e as mensagens que chegam.

Isso parece simples até você lembrar o que um sistema distribuído pode fazer: mensagens podem ser atrasadas, duplicadas, reordenadas ou perdidas; máquinas podem travar e reiniciar; e raramente você tem um sinal limpo de que “este nó está definitivamente morto”. Consenso trata de tornar o acordo seguro nessas condições.

Por que concordar é complicado

Se dois nós temporariamente não conseguem se comunicar (partição de rede), cada lado pode tentar “seguir em frente” por conta própria. Se ambos decidirem valores diferentes, você pode acabar com comportamento de split-brain: dois líderes, duas configurações diferentes, ou duas histórias concorrentes.

Mesmo sem partições, apenas atraso causa problemas. Quando um nó fica sabendo de uma proposta, outros nós podem já ter avançado. Sem um relógio compartilhado, você não pode afirmar com segurança que “proposta A aconteceu antes da proposta B” só porque A tem timestamp anterior — tempo físico não é autoritativo aqui.

Onde você encontra consenso em sistemas reais

Você talvez não chame de “consenso” no dia a dia, mas aparece em tarefas comuns de infraestrutura:

- Eleição de líder (quem está no comando agora?)

- Logs replicados (qual é a próxima entrada na história compartilhada?)

- Mudanças de configuração (qual conjunto de nós pode votar/confirmar?)

Em cada caso, o sistema precisa de um resultado único no qual todos possam convergir, ou ao menos uma regra que impeça resultados conflitantes de serem ambos considerados válidos.

Paxos como a resposta de Lamport

Paxos de Lamport é uma solução fundamental para esse problema de “acordo seguro”. A ideia-chave não é um timeout mágico ou um líder perfeito — são um conjunto de regras que asseguram que apenas um valor possa ser escolhido, mesmo quando mensagens chegam atrasadas e nós falham.

Paxos separa segurança (“nunca escolher dois valores diferentes”) de progresso (“eventualmente escolher algo”), tornando-o um roteiro prático: você pode ajustar para desempenho no mundo real enquanto mantém a garantia central intacta.

Paxos, sem a dor de cabeça: a intuição-chave de segurança

Paxos tem a reputação de ser ilegível, mas muito disso vem do fato de que “Paxos” não é um algoritmo único e simples. É uma família de padrões intimamente relacionados para fazer um grupo concordar, mesmo quando mensagens são atrasadas, duplicadas ou máquinas falham temporariamente.

Os papéis: propositores, aceitadores e quóruns

Um modelo mental útil é separar quem sugere de quem valida.

- Propositores tentam fazer com que um valor seja escolhido (por exemplo: “a próxima entrada do log é X”).

- Aceitadores votam em propostas.

- Um quórum é “aceitadores suficientes” para fazer progresso — tipicamente uma maioria.

A ideia estrutural para manter em mente: duas maiorias quaisquer se sobrepõem. É nessa sobreposição que a segurança vive.

O objetivo de segurança: nunca decidir dois valores diferentes

A segurança do Paxos é simples de enunciar: uma vez que o sistema decide um valor, ele nunca deve decidir outro — nada de decisões em split-brain.

A intuição chave é que propostas carregam números (pense: IDs de cédula). Aceitadores prometem ignorar propostas com número mais antigo depois que viram uma mais nova. E quando um proponente tenta com um novo número, ele primeiro pergunta a um quórum o que já foi aceito.

Como quóruns se sobrepõem, um novo proponente inevitavelmente ouvirá ao menos um aceitador que “lembra” o valor mais recentemente aceito. A regra é: se alguém no quórum aceitou algo, você deve propor esse valor (ou o mais novo entre os relatados). Essa restrição impede que dois valores diferentes sejam escolhidos.

Vivacidade, em alto nível

Vivacidade significa que o sistema eventualmente decide algo sob condições razoáveis (por exemplo, um líder estável emerge e a rede eventualmente entrega mensagens). Paxos não promete velocidade no caos; promete corretude e progresso uma vez que as coisas se acalmem.

Replicação de máquina de estados: corretude através de ordenamento compartilhado

Prototipe um log replicado

Prototipe uma API de log replicado com UI em React e backend em Go e PostgreSQL.

Replicação de máquina de estados (SMR) é o padrão de trabalho por trás de muitos sistemas de alta disponibilidade: em vez de um servidor tomar decisões, você roda várias réplicas que processam todas a mesma sequência de comandos.

A ideia do log replicado

No centro está um log replicado: uma lista ordenada de comandos como “put key=K value=V” ou “transferir $10 de A para B.” Clientes não enviam comandos para cada réplica esperando pelo melhor. Eles submetem comandos ao grupo, e o sistema concorda sobre uma ordem para esses comandos; então cada réplica os aplica localmente.

Por que ordenamento dá corretude

Se cada réplica começa do mesmo estado inicial e executa os mesmos comandos na mesma ordem, elas terminarão no mesmo estado. Essa é a intuição central de segurança: você não tenta manter várias máquinas “sincronizadas” por tempo; você as torna idênticas por determinismo e ordenamento compartilhado.

É por isso que consenso (como protocolos ao estilo Paxos/Raft) é frequentemente emparelhado com SMR: consenso decide a próxima entrada do log, e SMR transforma essa decisão em estado consistente entre as réplicas.

Onde você vê isso em sistemas reais

- Serviços de coordenação (por exemplo, para configuração e eleição de líder)

- Bancos de dados com logs replicados de escrita (write-ahead logs)

- Sistemas de mensagens que exigem ordenamento estrito por partição

Preocupações práticas que engenheiros não podem ignorar

O log cresce para sempre a menos que você o gerencie:

- Snapshots: capture periodicamente o estado atual para que nós novos possam se atualizar sem reproduzir todo o histórico.

- Compactação de log: descarte com segurança entradas antigas do log uma vez que elas estejam refletidas em um snapshot e não sejam mais necessárias.

- Mudanças de membresia: adicionar/remover réplicas também deve ser ordenado; caso contrário, nós diferentes podem discordar sobre quem está “no grupo”, levando a split-brain.

SMR não é mágica; é uma maneira disciplinada de transformar “acordo sobre ordem” em “acordo sobre estado”.

Corretude: segurança, vivacidade e escrever uma especificação clara

Sistemas distribuídos falham de maneiras estranhas: mensagens chegam atrasadas, nós reiniciam, relógios discordam e redes se dividem. “Corretude” não é um sentimento — é um conjunto de promessas que você pode declarar com precisão e então checar contra toda situação, incluindo falhas.

Segurança vs. vivacidade (com exemplos concretos)

Segurança significa “nada de ruim jamais acontece.” Exemplo: em um store replicado de chave-valor, dois valores diferentes nunca devem ser confirmados para o mesmo índice do log. Outro: um serviço de locks nunca deve conceder o mesmo lock para dois clientes ao mesmo tempo.

Vivacidade significa “algo bom eventualmente acontece.” Exemplo: se uma maioria de réplicas está ativa e a rede eventualmente entrega mensagens, uma escrita eventualmente completa. Uma requisição de lock eventualmente recebe um sim ou um não (não ficar esperando para sempre).

Segurança trata de prevenir contradições; vivacidade trata de evitar paradas permanentes.

Invariantes: seus inegociáveis

Uma invariante é uma condição que deve sempre valer, em todo estado alcançável. Por exemplo:

- “Cada índice do log tem no máximo um valor confirmado.”

- “O número de termo de um líder nunca diminui.”

Se uma invariante pode ser violada durante um crash, timeout, retry ou partição, ela não estava realmente sendo aplicada.

O que “prova” significa aqui

Uma prova é um argumento que cobre todas as execuções possíveis, não apenas o caminho “normal”. Você raciocina sobre todo caso: perda, duplicação, reordenação de mensagens; crashes e reinícios de nós; líderes concorrentes; clients fazendo retry.

Specs previnem comportamentos-surpresa

Uma especificação clara define estado, ações permitidas e propriedades exigidas. Isso evita requisitos ambíguos como “o sistema deve ser consistente” se transformarem em expectativas conflitantes. Specs forçam você a dizer o que acontece durante partições, o que “confirmar” significa e no que os clientes podem confiar — antes que a produção ensine do jeito difícil.

Da teoria à prática: modelagem com TLA+

Uma das lições práticas de Lamport é que você pode (e frequentemente deve) projetar um protocolo distribuído em um nível mais alto que código. Antes de se preocupar com threads, RPCs e loops de retry, você pode escrever as regras do sistema: quais ações são permitidas, qual estado pode mudar e o que jamais deve acontecer.

Para que serve o TLA+

TLA+ é uma linguagem de especificação e um conjunto de ferramentas de model checking para descrever sistemas concorrentes e distribuídos. Você escreve um modelo simples, parecido com matemática, do seu sistema — estados e transições — além das propriedades que lhe interessam (por exemplo, “no máximo um líder” ou “uma entrada confirmada nunca desaparece”).

Então o model checker explora interleavings possíveis, atrasos de mensagens e falhas para encontrar um contraexemplo: uma sequência concreta de passos que quebra sua propriedade. Em vez de debater casos de borda em reuniões, você obtém um argumento executável.

Um bug que um modelo pode pegar

Considere um passo de “commit” em um log replicado. Em código, é fácil permitir por acidente que dois nós marquem dois valores diferentes como confirmados no mesmo índice em um timing raro.

Um modelo em TLA+ pode revelar um traço como:

- Nó A confirma a entrada X no índice 10 depois de ouvir um quórum.

- Nó B (com dados obsoletos) também forma um quórum e confirma a entrada Y no índice 10.

Isso é um commit duplicado — uma violação de segurança que pode aparecer apenas uma vez por mês em produção, mas surge rapidamente sob busca exaustiva. Modelos semelhantes muitas vezes detectam updates perdidos, double-applies ou “ack sem durabilidade”.

Quando vale a pena modelar

TLA+ é mais valioso para lógica de coordenação crítica: eleição de líder, mudanças de membresia, fluxos do tipo consenso, e qualquer protocolo onde ordenamento e tratamento de falhas interajam. Se um bug corromperia dados ou exigiria recuperação manual, um pequeno modelo costuma ser mais barato do que depurar depois.

Se você está construindo ferramentas internas em torno dessas ideias, um fluxo prático é escrever uma spec leve (mesmo informal), depois implementar o sistema e gerar testes a partir das invariantes da spec. Plataformas como Koder.ai podem ajudar aqui acelerando o ciclo build-test: você descreve o comportamento de ordenamento/consenso em linguagem natural, itera no scaffolding do serviço (frontends React, backends Go com PostgreSQL, ou clientes Flutter) e mantém “o que nunca deve acontecer” visível enquanto entrega.

Lições práticas para construir e operar sistemas confiáveis

Crie uma demo de pedidos

Transforme suas ideias de pedidos em um serviço Go funcional e itere a partir de um chat simples.

O grande presente de Lamport para praticantes é uma mentalidade: trate tempo e ordenamento como dados que você modela, não suposições herdadas do relógio de parede. Essa mentalidade vira um conjunto de hábitos que você pode aplicar já na segunda-feira.

Transforme teoria em práticas de engenharia do dia a dia

Se mensagens podem ser atrasadas, duplicadas ou chegar fora de ordem, projete cada interação para ser segura nessas condições.

- Idempotência por padrão: faça “fazer de novo” inofensivo. Use chaves de idempotência para pagamentos, provisionamento ou qualquer escrita que possa ser reexecutada.

- Retries com deduplicação: retries são necessários, mas sem dedup você cria double-writes. Rastreie IDs de requisição e armazene marcadores de “já processado”.

- Entrega ao menos uma vez + efeitos exatamente-uma-vez: aceite que a rede pode entregar duas vezes; garanta que suas mudanças de estado não o façam.

Tenha cuidado com timeouts e relógios

Timeouts não são a verdade; são política. Um timeout apenas diz “não ouvi de volta a tempo”, não “o outro lado não agiu”. Duas implicações concretas:

- Não trate timeout como falha definitiva. Projete caminhos de compensação e reconciliação.

- Evite usar tempo local para ordenar eventos entre nós. Use números de sequência, contadores monotônicos ou metadados causais explícitos (por exemplo, “esta atualização substitui a versão X”).

Observabilidade que respeita causalidade

Boas ferramentas de debug codificam ordenamento, não apenas timestamps.

- Trace IDs em todo lugar: propague um ID de correlação/trace por cada hop e linha de log.

- Pistas causais nos logs: registre IDs de mensagem, IDs de requisição pai e “o que eu acreditava ser a versão mais recente” ao tomar decisões.

- Replays determinísticos: grave inputs (comandos) para poder reproduzir comportamento e confirmar se um bug é dependente de timing ou de lógica.

Perguntas de projeto para fazer antes de entregar

Antes de adicionar uma feature distribuída, exija clareza com algumas perguntas:

- O que acontece se a mesma requisição for processada duas vezes?

- Que ordenamento nós precisamos (se houver), e onde ele é imposto?

- Quais falhas são “seguras” (sem estado ruim) vs. “estridentes” (visíveis ao usuário) vs. “silenciosas” (corrupção escondida)?

- Qual é o caminho de recuperação após uma queda parcial ou partição de rede?

- O que vamos logar para reconstruir a história happened-before em produção?

Essas perguntas não exigem PhD — apenas disciplina para tratar ordenamento e corretude como requisitos de produto de primeira classe.

Conclusão e próximos passos sugeridos

O legado duradouro de Lamport é uma maneira de pensar claramente quando sistemas não compartilham um relógio e não concordam por padrão sobre “o que aconteceu”. Em vez de perseguir tempo perfeito, você rastreia causalidade (o que poderia ter influenciado o que), a representa com tempo lógico (carimbos de Lamport) e — quando o produto exige uma história única — constrói acordo (consenso) para que toda réplica aplique a mesma sequência de decisões.

Esse fio conduz a uma mentalidade prática de engenharia:

Especifique primeiro, depois construa

Escreva as regras que você precisa: o que jamais deve acontecer (segurança) e o que deve eventualmente acontecer (vivacidade). Depois implemente de acordo com essa spec e teste o sistema sob atraso, partições, retries, mensagens duplicadas e reinícios de nós. Muitas “quedas misteriosas” são, na verdade, declarações ausentes como “uma requisição pode ser processada duas vezes” ou “líderes podem mudar a qualquer momento”.

Aprenda mais, com passos focados

Se quiser se aprofundar sem afogar-se em formalismo:

- Leia “Time, Clocks, and the Ordering of Events in a Distributed System” de Lamport para internalizar o happened-before.

- Passe os olhos em “Paxos Made Simple” para a intuição de segurança: uma vez que um valor é escolhido, o progresso futuro não pode contradizê-lo.

- Assista a uma introdução ao TLA+, então modele um protocolo minúsculo (um serviço de locks ou um registro de duas réplicas) e verifique-o.

Experimente um exercício prático

Escolha um componente que você gerencia e escreva um “contrato de falha” de uma página: o que você assume sobre rede e armazenamento, quais operações são idempotentes e quais garantias de ordenamento você fornece.

Se quiser tornar este exercício mais concreto, construa um pequeno serviço de “demonstração de ordenamento”: uma API que apende comandos a um log, um worker em background que os aplica, e uma visão administrativa mostrando metadados de causalidade e retries. Fazer isso no Koder.ai pode ser uma maneira rápida de iterar — especialmente se você quer scaffolding rápido, deploy/hosting, snapshots/rollback para experimentos e exportação de código quando estiver satisfeito.

Feito direito, essas ideias reduzem quedas porque menos comportamentos ficam implícitos. Elas também simplificam o raciocínio: você para de discutir tempo e começa a provar o que ordenamento, acordo e corretude realmente significam para seu sistema.