O que “o modelo de software do PC” significa — e por que importou

O “modelo de software do PC” não era um produto único ou um truque de licenciamento esperto. Era uma maneira repetível de o mercado funcionar: como os desenvolvedores construíam software, como eles o entregavam aos usuários e como ganhavam dinheiro com ele.

Isso soa básico — até lembrar como era incomum no começo da computação pessoal. Computadores iniciais eram frequentemente vendidos como sistemas autocontidos com hardware proprietário, ambientes operacionais pontuais e caminhos pouco claros para desenvolvedores terceiros. A era do PC mudou isso ao transformar software em algo que podia escalar além de uma única máquina — ou uma única empresa.

Uma definição em linguagem simples do “modelo de software”

Na prática, um modelo de software é o conjunto de suposições que responde:

- Para qual alvo estou construindo? (uma base estável de SO e hardware)

- Como eu o construo de forma eficiente? (ferramentas, linguagens, documentação)

- Como alcanço clientes e recebo pagamento? (distribuição e termos comerciais)

Quando essas respostas são previsíveis, os desenvolvedores investem. Quando não são, hesitam.

Os três pilares que se reforçavam mutuamente

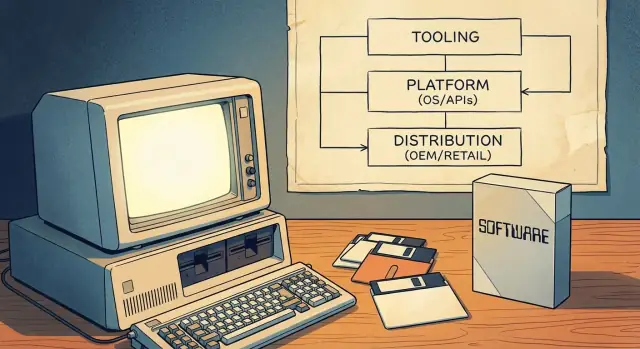

O modelo do PC funcionou porque ligou três pilares em um ciclo virtuoso:

- Ferramentas de desenvolvimento: linguagens acessíveis, compiladores, IDEs e exemplos que reduziram o custo de começar.

- Superfície da plataforma: APIs e SDKs consistentes que permitiam ao software de terceiros integrar-se com o SO (e com outros apps).

- Canais de go-to-market: maneiras claras de distribuir — via pré-instalação OEM, varejo e, mais tarde, shareware — para que o software pudesse realmente virar um negócio.

Juntos, tornaram o PC um “lugar para construir” confiável. Essa confiabilidade transformou a computação pessoal em um ecossistema de desenvolvedores mainstream — não apenas uma cena de hobbyistas.

Antes dos PCs mainstream: alvos fragmentados e alcance limitado

Antes dos PCs de massa, “computação” geralmente significava mainframes e minicomputadores de governos, universidades e grandes empresas. O acesso era escasso, caro e frequentemente mediado por departamentos de TI. Se você fosse desenvolvedor, escrevia software para uma organização específica — não para um mercado público amplo.

Muitas máquinas, muitas incompatibilidades

Sistemas pessoais e hobbyistas existiam, mas não formavam um mercado único e confiável. O hardware variava amplamente (famílias de CPU, formatos de disco, gráficos, periféricos) e sistemas operacionais eram inconsistentes ou proprietários. Um programa que rodava em uma máquina frequentemente precisava ser reescrito para outra.

Essa fragmentação moldou a economia do software:

- Software era comumente empacotado com hardware ou entregue como parte de uma compra maior.

- Muito do software era feito sob medida para o fluxo de trabalho de um cliente.

- Vendedores acoplavam apps às suas próprias máquinas para proteger vendas de hardware.

Alcance limitado significava incentivo limitado

Como a audiência endereçável para qualquer configuração única era pequena, desenvolvedores independentes tinham dificuldade de justificar tempo e custo para criar produtos polidos e com suporte amplo. A distribuição também era restrita: era comum enviar fitas ou disquetes diretamente ao cliente, depender de grupos de usuários ou compartilhar código informalmente. Nada disso parecia um negócio escalável.

O que mudou quando os PCs entraram na massa

Quando os PCs se tornaram produtos de consumo e escritório comuns, o valor passou de implantações pontuais para vendas repetíveis de software. A ideia-chave foi um alvo padrão: uma combinação previsível de expectativas de hardware, convenções de sistema operacional e caminhos de distribuição em que os desenvolvedores podiam apostar.

Uma vez que uma massa crítica de compradores e máquinas compatíveis existiu, escrever software deixou de ser “Isso vai rodar em outro lugar?” e passou a ser “Com que rapidez alcançamos todos usando esse padrão?”

Ferramentas primeiro: linguagens como porta de entrada para desenvolvedores

Antes de a Microsoft ser sinônimo de sistemas operacionais, ela era fortemente identificada com linguagens de programação — especialmente o BASIC. Essa escolha não foi incidental. Se você quer um ecossistema, primeiro precisa de pessoas que possam construir coisas, e linguagens são a rampa de entrada de menor atrito.

BASIC como “kit inicial”

Microcomputadores iniciais frequentemente vinham com BASIC em ROM, e versões da Microsoft se tornaram um ponto de entrada familiar em muitas máquinas. Para um estudante, hobbyista ou pequeno empresário, o caminho era simples: ligar a máquina, obter um prompt, digitar código, ver resultados. Essa imediaticidade importava mais que elegância. Fez com que programar parecesse um uso normal do computador, não uma profissão especializada.

Acessibilidade amplia o pool de criadores

Ao focar em ferramentas acessíveis, a Microsoft ajudou a alargar o funil de desenvolvedores potenciais. Mais pessoas escrevendo pequenos programas significava mais experimentos, mais “apps” locais e mais demanda por ferramentas melhores. É um exemplo inicial de participação mental dos desenvolvedores agindo como juros compostos: uma geração que aprende numa linguagem e conjunto de ferramentas tende a continuar construindo — e comprando — dentro dessa órbita.

Consistência entre máquinas gera confiança

A era dos microcomputadores era fragmentada, mas a Microsoft levou ideias consistentes de plataforma para plataforma: sintaxe de linguagem parecida, expectativas de ferramentas semelhantes e um senso crescente de que “se você consegue programar aqui, provavelmente consegue programar lá também.” Essa previsibilidade reduziu o risco percebido de aprender a programar.

A lição estratégica é direta: plataformas não começam com marketplaces ou monetização. Começam com ferramentas que tornam a criação possível — e depois ganham lealdade tornando essa experiência repetível.

MS‑DOS e a padronização do alvo PC

Um grande desbloqueio na computação pessoal inicial foi a ideia de “camada de SO padrão”: em vez de escrever uma versão separada do seu app para cada combinação de hardware, você podia mirar em uma interface comum. Para desenvolvedores, isso significava menos ports, menos chamadas de suporte e um caminho mais claro para lançar algo que funcionasse para muitos clientes.

Um lugar para mirar seu software

MS‑DOS ficava entre aplicações e a variedade bagunçada de hardware de PC. Ainda havia diferentes placas de vídeo, impressoras, controladores de disco e configurações de memória — mas o MS‑DOS oferecia uma base compartilhada para acesso a arquivos, carregamento de programas e interação básica com dispositivos. Essa camada comum transformou “o PC” em um mercado único e endereçável em vez de uma coleção de máquinas quase compatíveis.

O que “compatibilidade” significava na prática

Para clientes, compatibilidade significava confiança: se um programa dizia que rodava em MS‑DOS (e, por extensão, em compatíveis IBM PC), havia maior probabilidade de rodar na máquina deles também. Para desenvolvedores, compatibilidade significava comportamento previsível — chamadas de sistema documentadas, modelo de execução estável e convenções sobre como programas eram instalados e iniciados.

Essa previsibilidade tornou racional investir em acabamento, documentação e atualizações contínuas, porque a audiência não estava limitada aos usuários de um único fornecedor de hardware.

O trade-off central: progresso vs preservação

A padronização também criou uma restrição: manter software antigo funcionando virou prioridade. Essa pressão por compatibilidade retroativa pode desacelerar mudanças significativas, porque quebrar programas populares quebra a confiança na plataforma. O lado positivo é uma biblioteca de software que se compõe ao longo do tempo; o lado negativo é uma faixa mais estreita para inovações radicais no nível do SO sem planos de transição cuidadosos.

O Windows não apenas “ficou sobre” o MS‑DOS — ele mudou o que os desenvolvedores podiam assumir sobre a máquina. Em vez de cada programa inventar sua própria forma de desenhar telas, lidar com entrada e conversar com periféricos, o Windows ofereceu um modelo de UI compartilhado e um conjunto crescente de serviços do sistema.

O que o Windows adicionou além do DOS

A mudança de destaque foi a interface gráfica: janelas, menus, diálogos e fontes que pareciam e se comportavam de forma consistente entre apps. Isso importou porque a consistência reduziu o custo de “reinventar o básico”. Desenvolvedores puderam gastar tempo em recursos que importavam para os usuários, não em construir mais uma biblioteca de UI.

O Windows também ampliou serviços comuns que eram dolorosos na era DOS:

- Uma forma padronizada de trabalhar com arquivos e pastas

- Impressão via drivers compartilhados e diálogos de impressão

- Suporte a redes que não exigia a abordagem customizada de cada fornecedor

Convenções de GUI e componentes compartilhados

Convenções do Windows — como atalhos de teclado padrão, layouts de diálogo e controles comuns (botões, listas, caixas de texto) — reduziram esforço de desenvolvimento e treinamento de usuários ao mesmo tempo. Componentes compartilhados significaram menos soluções sob medida e menos surpresas de compatibilidade quando o hardware mudava.

Versões, compatibilidade e planejamento

À medida que o Windows evoluiu, os desenvolvedores tiveram que escolher: suportar versões antigas para alcance ou adotar APIs mais novas por melhores capacidades. Esse planejamento moldou roadmaps, testes e marketing.

Com o tempo, ferramentas, documentação, bibliotecas de terceiros e expectativas de usuários passaram a se centralizar no Windows como alvo padrão — não apenas um sistema operacional, mas uma plataforma com normas e momentum.

Experiência do desenvolvedor: IDEs, compiladores, docs e exemplos

Uma plataforma não parece “real” para desenvolvedores até que seja fácil enviar software nela. Na era do PC, essa facilidade foi moldada menos pelo marketing e mais pela experiência diária de escrever, compilar, depurar e empacotar programas.

Ferramentas são multiplicadores de produtividade

Compiladores, linkers, depuradores e sistemas de build definem silenciosamente o ritmo de um ecossistema. Quando tempos de compilação caem, mensagens de erro melhoram e depuração fica confiável, desenvolvedores podem iterar mais rápido — e iteração é o que transforma uma ideia meia pronta em produto.

IDEs integraram ainda mais ao agrupar edição, build, depuração e gerenciamento de projeto em um fluxo de trabalho único. Um bom IDE reduzia o “trabalho de cola” que consumiria horas: configurar caminhos de includes, gerenciar bibliotecas, manter builds consistentes e localizar crashes em runtime.

Menor risco para equipes pequenas

Ferramentas melhores não são apenas “agradáveis” — elas mudam a economia para equipes pequenas. Se um ou dois desenvolvedores conseguem construir e testar com confiança, podem assumir projetos que antes exigiriam pessoal maior. Isso reduz custo, encurta cronogramas e torna menos arriscado para um ISV pequeno apostar em um novo produto.

Docs e exemplos frequentemente valem mais que recursos

Documentação e exemplos executáveis atuam como um segundo produto: ensinam o modelo mental, mostram boas práticas e evitam erros comuns. Muitos desenvolvedores não adotam uma API porque ela é poderosa — adotam porque existe um exemplo claro que funciona no primeiro dia.

Ferramentas moldam o que parece “fácil” (e portanto “padrão”)

Vendedores de ferramentas influenciam quais modelos de programação vencem ao tornar certos caminhos sem atrito. Se templates, assistentes, bibliotecas e vistas de depuração apontam para uma abordagem, essa se torna o padrão — não porque seja superior em teoria, mas porque é mais rápido de aprender e mais seguro para enviar.