10 de nov. de 2025·8 min

Mudanças de Esquema e Migrações em Sistemas Gerados por IA: Um Guia

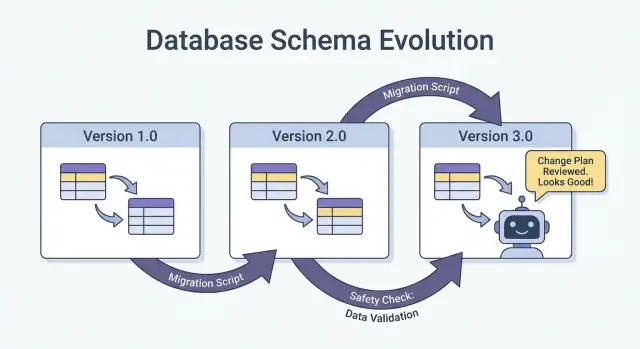

Aprenda como sistemas gerados por IA lidam com mudanças de esquema de forma segura: versionamento, rollouts compatíveis, migrações de dados, testes, observabilidade e estratégias de rollback.

O que “esquema” significa em sistemas gerados por IA

Um esquema é simplesmente o acordo compartilhado sobre a forma dos dados e o que cada campo significa. Em sistemas gerados por IA, esse acordo aparece em mais lugares do que apenas tabelas de banco de dados — e muda com mais frequência do que as equipes esperam.

Esquema não é só coisa de banco de dados

Você vai encontrar esquemas em pelo menos quatro camadas comuns:

- Bancos de dados: nomes de tabelas/colunas, tipos de dados, constraints, índices e relacionamentos.

- APIs: formato JSON de requisição/resposta, campos obrigatórios vs. opcionais, enums, formatos de erro, convenções de paginação.

- Eventos e mensagens: payloads enviados por streams, filas e webhooks (frequentemente versionados implicitamente pelos consumidores).

- Configs e contratos: feature flags, variáveis de ambiente, configs YAML/JSON e “contratos ocultos” como formatos de arquivo e convenções de nomenclatura.

Se duas partes do sistema trocam dados, existe um esquema — mesmo que ninguém o tenha escrito.

Por que sistemas gerados por IA veem mudanças de esquema com mais frequência

Código gerado por IA pode acelerar muito o desenvolvimento, mas também aumenta a rotatividade:

- Código gerado reflete o prompt e o contexto mais recentes, então pequenas mudanças no prompt podem alterar nomes de campos, aninhamentos, valores padrão ou validações.

- Requisitos evoluem mais rápido quando é barato lançar um novo endpoint ou etapa de pipeline.

- Convenções inconsistentes (snake_case vs. camelCase,

idvs.userId) aparecem quando há múltiplas gerações ou refatorações entre equipes.

O resultado é um “drift de contrato” mais frequente entre produtores e consumidores.

Se você usa um fluxo de trabalho baseado em vibe-coding (por exemplo, gerando handlers, camadas de acesso ao BD e integrações por chat), vale incorporar disciplina de esquema nesse fluxo desde o primeiro dia. Plataformas como Koder.ai ajudam times a avançar rápido gerando apps React/Go/PostgreSQL e Flutter a partir de uma interface de chat — mas quanto mais rápido você puder enviar mudanças, mais importante fica versionar interfaces, validar payloads e fazer rollouts deliberados.

Objetivo deste guia

Este post foca em maneiras práticas de manter produção estável enquanto se itera rapidamente: manter compatibilidade retroativa, lançar mudanças com segurança e migrar dados sem surpresas.

O que não vamos cobrir

Não vamos mergulhar em modelagem teórica pesada, métodos formais ou recursos específicos de fornecedores. A ênfase é em padrões aplicáveis em qualquer stack — seja seu sistema escrito à mão, assistido por IA ou majoritariamente gerado por IA.

Por que mudanças de esquema acontecem mais com código gerado por IA

Código gerado por IA tende a fazer mudanças de esquema parecerem “normais” — não porque as equipes sejam descuidadas, mas porque as entradas do sistema mudam com mais frequência. Quando o comportamento da aplicação é parcialmente dirigido por prompts, versões de modelo e código gerado como cola, a forma dos dados tende a derivar ao longo do tempo.

Gatilhos comuns na prática

Alguns padrões frequentemente causam churn de esquema:

- Novas funcionalidades: adicionar um campo novo (por ex.,

risk_score,explanation,source_url) ou dividir um conceito em vários (por ex.,addressemstreet,city,postal_code). - Mudanças na saída do modelo: um modelo mais novo pode produzir estruturas mais detalhadas, valores de enum diferentes ou nomes ligeiramente alterados (“confidence” vs. “score”).

- Atualizações de prompt: ajustes no prompt feitos para melhorar qualidade podem, sem querer, alterar formatação, campos obrigatórios ou aninhamento.

Padrões arriscados que tornam sistemas de IA frágeis

Código gerado por IA frequentemente “funciona” rápido, mas pode codificar suposições frágeis:

- Suposições implícitas: o código assume silenciosamente que um campo sempre está presente, sempre é numérico ou sempre está dentro de um intervalo.

- Acoplamento oculto: um serviço depende dos nomes internos de campos ou da ordenação de outro serviço em vez de uma interface definida.

- Campos não documentados: o modelo começa a emitir uma nova propriedade e o código a jusante passa a depender dela sem que ninguém concorde explicitamente que faz parte do contrato.

Por que a IA amplifica a frequência de mudanças

Geração de código incentiva iteração rápida: você regenera handlers, parsers e camadas de acesso ao banco conforme os requisitos evoluem. Essa velocidade é útil, mas também facilita enviar pequenas mudanças de interface repetidamente — às vezes sem perceber.

A mentalidade mais segura é tratar cada esquema como um contrato: tabelas do banco, payloads de API, eventos e até respostas estruturadas de LLMs. Se um consumidor depende disso, versiona, valida e muda deliberadamente.

Tipos de mudanças de esquema: aditivas vs. breaking

Mudanças de esquema não são todas iguais. A pergunta mais útil é: os consumidores existentes continuarão funcionando sem alterações? Se sim, normalmente é aditiva. Se não, é breaking — e precisa de um plano de rollout coordenado.

Mudanças aditivas (geralmente seguras)

Mudanças aditivas estendem o que já existe sem alterar o significado existente.

Exemplos comuns em banco de dados:

- Adicionar uma coluna com um default ou permitir NULLs (ex.:

preferred_language). - Adicionar uma nova tabela ou índice.

- Adicionar um campo opcional a um blob JSON armazenado em uma coluna.

Exemplos fora do banco:

- Adicionar uma nova propriedade a uma resposta de API (clientes que ignoram campos desconhecidos continuam funcionando).

- Adicionar um novo campo de evento em uma fila/stream.

- Adicionar um novo valor em uma feature flag mantendo o comportamento antigo como padrão.

Aditivo é “seguro” apenas se consumidores antigos forem tolerantes: eles devem ignorar campos desconhecidos e não exigir novos.

Mudanças breaking (arriscadas)

Mudanças breaking alteram ou removem algo do qual consumidores já dependem.

Exemplos típicos em banco de dados:

- Mudar o tipo de uma coluna (string → inteiro, mudança de precisão de timestamp).

- Renomear um campo/coluna (tudo que lê o nome antigo falha).

- Remover uma coluna/tabela que ainda é consultada.

Exemplos fora do banco:

- Renomear/remover campos JSON em payloads de request/response.

- Mudar a semântica de um campo (mesmo nome, novo significado).

- Modificar a estrutura de um webhook sem bump de versão.

Sempre documente o impacto para consumidores

Antes de fazer merge, documente:

- Quem consome isso (serviços, dashboards, pipelines de dados, parceiros).

- Compatibilidade (backward/forward, e por quanto tempo).

- Modo de falha (erros de parsing, corrupção silenciosa de dados, lógica de negócio errada).

Essa nota curta de impacto força clareza — especialmente quando código gerado por IA introduz mudanças de esquema implicitamente.

Estratégias de versionamento para esquemas e interfaces

Versionamento é como você diz a outros sistemas (e a você no futuro) “isso mudou, e aqui está o quão arriscado é”. O objetivo não é papelada — é prevenir quebras silenciosas quando clientes, serviços ou pipelines atualizam em velocidades diferentes.

Mentalidade semântica em linguagem simples

Pense em termos de major / minor / patch, mesmo que você não publique 1.2.3 literalmente:

- Major: mudança breaking. Consumidores antigos podem falhar ou se comportar mal sem alterações.

- Minor: adição segura. Consumidores antigos ainda funcionam; consumidores novos podem usar capacidades novas.

- Patch: correção de bug ou esclarecimento que não muda o significado.

Uma regra simples que salva times: nunca mude o significado de um campo existente silenciosamente. Se status="active" antes significava “cliente pagante”, não o reaproveite para significar “conta existe”. Adicione um novo campo ou uma nova versão.

Endpoints versionados vs. campos versionados

Você geralmente tem duas opções práticas:

- Endpoints versionados (ex.:

/api/v1/orderse/api/v2/orders):

Bom quando mudanças são realmente breaking ou amplas. É claro, mas pode gerar duplicação e manutenção de longo prazo se você mantiver múltiplas versões.

- Campos versionados / evolução aditiva (ex.: adicionar

new_field, manterold_field):

Bom quando você pode mudar aditivamente. Clientes antigos ignoram o que não entendem; clientes novos leem o campo novo. Com o tempo, depreque e remova o campo antigo com um plano explícito.

Schemas de eventos e registries

Para streams, filas e webhooks, consumidores muitas vezes estão fora do seu controle de deploy. Um schema registry (ou qualquer catálogo centralizado de esquemas com checagens de compatibilidade) ajuda a aplicar regras como “apenas mudanças aditivas permitidas” e deixa claro quais produtores e consumidores dependem de quais versões.

Rollouts seguros: Expand/Contract (o padrão mais confiável)

A forma mais segura de enviar mudanças de esquema — especialmente quando você tem vários serviços, jobs e componentes gerados por IA — é o padrão expand → backfill → switch → contract. Ele minimiza downtime e evita deploys “tudo ou nada” onde um consumidor atrasado quebra a produção.

Os quatro passos (e por que funcionam)

1) Expandir: Introduza o novo esquema de maneira compatível com versões anteriores. Leitores e escritores existentes devem continuar funcionando sem alterações.

2) Backfill: Popule campos novos para dados históricos (ou reprocese mensagens) para que o sistema fique consistente.

3) Switch: Atualize escritores e leitores para usar o campo/formato novo. Isso pode ser gradual (canary, rollout por porcentagem) porque o esquema suporta ambos.

4) Contractar: Remova o campo/formato antigo somente depois de ter certeza de que ninguém depende mais dele.

Rollouts em duas fases (expand → switch) e três fases (expand → backfill → switch) reduzem downtime porque evitam acoplamento apertado: escritores podem mudar primeiro, leitores podem mudar depois, e vice-versa.

Exemplo: adicionar uma coluna, backfill, depois torná-la obrigatória

Suponha que você queira adicionar customer_tier.

- Expandir: Adicione

customer_tiercomo nullable com defaultNULL. - Backfill: Rode um job para computar tiers para linhas existentes.

- Switch: Atualize o app e pipelines para sempre gravar

customer_tier, e atualize leitores para preferi-lo. - Contractar: Após monitoramento, torne NOT NULL (e opcionalmente remova lógica legada).

Coordenação: escritores e leitores devem concordar

Trate todo esquema como um contrato entre produtores (escritores) e consumidores (leitores). Em sistemas gerados por IA, isso é fácil de perder porque novos caminhos de código aparecem rapidamente. Faça rollouts explícitos: documente qual versão escreve o quê, quais serviços podem ler ambos e a exata “data de contrato” quando campos antigos podem ser removidos.

Migrações de banco de dados: como mudar dados sem quebrar produção

Envie com rollback pronto

Faça um snapshot antes de migrações arriscadas para recuperar rapidamente se algo falhar.

Migrações de banco de dados são o “manual de instruções” para mover dados e estrutura de produção de um estado seguro para o próximo. Em sistemas gerados por IA, elas importam ainda mais porque código gerado pode assumir que uma coluna existe, renomear campos de forma inconsistente ou alterar constraints sem considerar linhas já existentes.

Arquivos de migração vs. auto-migrations

Arquivos de migração (commitados no source control) são passos explícitos como “adicionar coluna X”, “criar índice Y” ou “copiar dados de A para B”. Eles são auditáveis, revisáveis e podem ser reproduzidos em staging e produção.

Auto-migrations (geradas por um ORM/framework) são convenientes para desenvolvimento inicial e prototipagem, mas podem produzir operações arriscadas (drop de colunas, rebuild de tabelas) ou reordenar mudanças de forma inesperada.

Uma regra prática: use auto-migrations para rascunhar mudanças e depois converta-as para arquivos de migração revisados para qualquer coisa que toque produção.

Idempotência e ordenação

Torne migrações idempotentes quando possível: reexecutá-las não deve corromper dados nem falhar no meio. Prefira “create if not exists”, adicione novas colunas como nullable primeiro e proteja transformações de dados com checagens.

Mantenha também uma ordem clara. Cada ambiente (local, CI, staging, prod) deve aplicar a mesma sequência de migrações. Não “conserte” produção com SQL manual sem capturá-lo em uma migração depois.

Migrações longas sem travar a tabela

Algumas mudanças podem bloquear writes (ou até reads) se travarem uma tabela grande. Maneiras de reduzir risco:

- Use operações online/minimizadoras de lock suportadas pelo seu banco (ex.: builds concorrentes de índice).

- Divida mudanças em passos: adicione novas estruturas primeiro, backfill em lotes, depois troque o app.

- Agende operações pesadas em janelas de baixa carga, com timeouts e monitoramento.

Ambientes multi-tenant e sharded

Para bancos multi-tenant, rode migrações em um loop controlado por tenant, com rastreamento de progresso e retries seguros. Para shards, trate cada shard como um sistema de produção separado: aplique migrações shard a shard, verifique a saúde e então prossiga. Isso limita blast radius e torna rollback viável.

Backfills e reprocessamento: atualizar dados existentes

Um backfill é quando você popula campos recém-adicionados (ou valores corrigidos) para registros existentes. Reprocessamento é quando você roda dados históricos novamente por um pipeline — tipicamente porque regras de negócio mudaram, um bug foi corrigido ou o formato de saída de um modelo foi atualizado.

Ambos são comuns após mudanças de esquema: é fácil começar a gravar a nova forma para “dados novos”, mas sistemas de produção também dependem de dados antigos serem consistentes.

Abordagens comuns

Backfill online (em produção, gradualmente). Você roda um job controlado que atualiza registros em pequenos lotes enquanto o sistema continua ativo. É mais seguro para serviços críticos porque você pode limitar carga, pausar e retomar.

Backfill em batch (offline ou agendado). Processa grandes blocos durante janelas de baixa atividade. É operacionalmente mais simples, mas pode criar picos de carga no banco e levar mais tempo para recuperar de erros.

Backfill preguiçoso na leitura. Quando um registro antigo é lido, a aplicação calcula/popula os campos faltantes e grava de volta. Isso espalha o custo ao longo do tempo e evita um job grande, mas torna a primeira leitura mais lenta e pode deixar dados antigos não convertidos por muito tempo.

Na prática, equipes combinam essas abordagens: backfill preguiçoso para cauda longa e um job online para dados mais frequentemente acessados.

Como validar um backfill

A validação deve ser explícita e mensurável:

- Contagens: quantas linhas/eventos deveriam ser atualizados vs. quantas foram atualizadas.

- Checksums/aggregates: compare totais (ex.: soma de valores, IDs distintos) antes/depois.

- Amostragem: verifique uma amostra estatisticamente significativa, incluindo casos de borda.

Também valide efeitos a jusante: dashboards, índices de busca, caches e quaisquer exports que dependam dos campos atualizados.

Custo, tempo e critérios de aceitação

Backfills trocam velocidade (terminar rapidamente) por risco e custo (carga, compute e overhead operacional). Defina critérios de aceitação antes: o que significa “feito”, tempo de execução esperado, taxa máxima de erro permitida e o que fará se a validação falhar (pausar, tentar de novo ou reverter).

Evolução de esquemas de eventos e mensagens (streams, filas, webhooks)

Vá ao vivo com confiança

Lance com um domínio personalizado assim que a nova versão do esquema funcionar de ponta a ponta.

Esquemas não vivem apenas em bancos. Toda vez que um sistema envia dados a outro — tópicos Kafka, filas SQS/RabbitMQ, payloads de webhook, até “eventos” escritos em object storage — você criou um contrato. Produtores e consumidores se movem independentemente, então esses contratos tendem a quebrar mais do que as tabelas internas de um app.

O padrão mais seguro: evoluir eventos de forma backward-compatible

Para streams de eventos e payloads de webhook, prefira mudanças que consumidores antigos possam ignorar e consumidores novos possam adotar.

Uma regra prática: adicione campos, não remova nem renomeie. Se precisar depreciar algo, continue enviando por um tempo e documente como deprecated.

Exemplo: estender um evento OrderCreated adicionando campos opcionais.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Consumidores antigos leem order_id e created_at e ignoram o resto.

Contratos dirigidos por consumidores (versão em linguagem simples)

Em vez de o produtor adivinhar o que pode quebrar outros, consumidores publicam do que dependem (campos, tipos, regras de obrigatório/opcional). O produtor então valida mudanças contra essas expectativas antes de enviar. Isso é especialmente útil em codebases geradas por IA, onde um modelo pode “ajudar” renomeando um campo ou mudando um tipo.

Lidar com “campos desconhecidos” com segurança

Faça parsers tolerantes:

- Ignore campos desconhecidos por padrão (não falhe só porque uma nova chave apareceu).

- Trate novos campos como opcionais até você realmente precisar deles.

- Logue campos inesperados em nível baixo para detectar adoção sem gerar pages.

Quando precisar de uma mudança breaking, use um novo tipo de evento ou nome versionado (por ex., OrderCreated.v2) e rode ambos em paralelo até todos os consumidores migrarem.

Saídas de IA como um esquema: prompts, modelos e respostas estruturadas

Quando você adiciona um LLM a um sistema, suas saídas rapidamente viram um esquema de fato — mesmo que ninguém tenha escrito uma especificação formal. Código a jusante começa a assumir “haverá um campo summary”, “a primeira linha é o título” ou “bullets são separados por traços”. Essas suposições se solidificam e uma pequena mudança no comportamento do modelo pode quebrá-las como um rename de coluna.

Prefira estrutura explícita (e valide)

Em vez de parsear “texto bonitinho”, peça saídas estruturadas (tipicamente JSON) e valide antes de deixar entrarem no resto do seu sistema. Pense nisso como mover de “melhor esforço” para um contrato.

Uma abordagem prática:

- Defina um JSON schema (ou uma interface tipada) para a resposta do modelo.

- Rejeite ou coloque em quarentena respostas inválidas (não as coercione silenciosamente).

- Logue erros de validação para ver o que está mudando.

Isso é especialmente importante quando respostas de LLM alimentam pipelines de dados, automação ou conteúdo para usuários.

Planeje drift de modelo

Mesmo com o mesmo prompt, as saídas podem variar ao longo do tempo: campos podem ser omitidos, chaves extras podem aparecer e tipos podem mudar ("42" vs 42, arrays vs strings). Trate esses eventos como evolução de esquema.

Mitigações eficazes:

- Torne campos opcionais quando razoável e defina defaults explicitamente.

- Permita chaves desconhecidas e as ignore com segurança (a menos que você seja estrito por compliance).

- Adicione checagens “guardrails” (ex.: campos obrigatórios, comprimentos máximos, valores de enum).

Trate mudanças de prompt como mudanças de API

Um prompt é uma interface. Se você editá-lo, versiona. Mantenha prompt_v1, prompt_v2 e faça rollout gradualmente (feature flags, canaries ou toggles por tenant). Teste com um conjunto de avaliação fixo antes de promover mudanças e mantenha versões antigas rodando até que consumidores a jusante se adaptem. Para mais sobre mecânicas de rollout seguro, vincule sua abordagem a /blog/safe-rollouts-expand-contract.

Testes e validação para mudanças de esquema

Mudanças de esquema geralmente falham de maneiras chatas e caras: uma nova coluna falta em um ambiente, um consumidor ainda espera um campo antigo, ou uma migração funciona em dados vazios mas dá timeout em produção. Testes transformam essas “surpresas” em trabalho previsível e corrigível.

Três níveis de testes (e o que cada um pega)

Testes unitários protegem lógica local: funções de mapeamento, serializers/deserializers, validadores e builders de query. Se um campo for renomeado ou um tipo mudar, testes unitários devem falhar próximos ao código que precisa ser atualizado.

Testes de integração garantem que seu app funciona com dependências reais: o engine de banco real, a ferramenta de migração real e formatos de mensagem reais. É aqui que você pega problemas como “o modelo ORM mudou mas a migração não” ou “o nome do novo índice conflita”.

Testes end-to-end simulam resultados de usuário ou fluxos entre serviços: crie dados, migre, leia via APIs e verifique se consumidores a jusante ainda se comportam corretamente.

Testes de contrato para produtores e consumidores

Evolução de esquema costuma quebrar nas fronteiras: APIs entre serviços, streams, filas e webhooks. Adicione testes de contrato que rodem em ambos os lados:

- Produtores provam que conseguem emitir eventos/respostas que batem com um contrato acordado.

- Consumidores provam que conseguem parsear tanto a versão antiga quanto a nova durante um rollout.

Teste de migração: aplicar e reverter em ambientes frescos

Teste migrações como se você as deployasse:

- Comece a partir de um snapshot limpo do banco.

- Aplique todas as migrações em ordem.

- Verifique que o app pode ler/gravar.

- Rode um rollback (se suportado) ou uma migração “down” e confirme que retorna a um estado funcional.

Fixtures para versões antiga e nova do esquema

Mantenha um conjunto pequeno de fixtures representando:

- Dados escritos sob o esquema anterior (linhas/eventos legados).

- Dados escritos sob o esquema novo.

Esses fixtures tornam regressões óbvias, especialmente quando código gerado por IA muda sutilmente nomes de campo, opcionalidade ou formatação.

Observabilidade: detectar quebras cedo

Implante mudanças com segurança

Faça deploy e hospede sua aplicação quando leitores e escritores concordarem com o novo esquema.

Mudanças de esquema raramente falham de forma estrondosa no momento exato do deploy. Mais frequentemente, a quebra aparece como um aumento lento em erros de parsing, avisos de “campo desconhecido”, dados faltantes ou jobs em background ficando para trás. Boa observabilidade transforma esses sinais fracos em feedback acionável enquanto você ainda pode pausar o rollout.

O que monitorar durante um rollout

Comece com o básico (saúde do app), depois adicione sinais específicos de esquema:

- Erros: picos em 4xx/5xx, mas também erros “suaves” como falhas de parsing JSON, desserialização e retries.

- Latência: p95/p99 de resposta e tempo de processamento de filas. Mudanças de esquema podem adicionar joins, payloads maiores ou validação extra.

- Sinais de qualidade de dados: aumento da taxa de null em colunas importantes, quedas súbitas no volume de eventos, novos valores default aparecendo frequentemente ou divergência entre representações antiga e nova.

- Atraso no pipeline: lag de consumidores em streams/filas, backlog de entrega de webhooks e throughput de jobs de migração.

O importante é comparar antes vs. depois e fatiar por versão do cliente, versão do esquema e segmento de tráfego (canary vs. estável).

Dashboards que realmente ajudam

Crie duas visões de dashboard:

-

Comportamento da aplicação

- Taxa de requisições, taxa de erro, latência (RED)

- Top exceções (agrupadas por mensagem)

- Contagem e porcentagem de erros de validação/parsing

- Distribuição do tamanho do payload (para detectar mensagens inesperadamente grandes)

-

Migração e jobs em background

- Progresso do job de migração (% completo), linhas processadas/segundo, ETA

- Taxa de falha e contagem de retries

- Profundidade de filas / lag do consumidor

- Volume de dead-letter queue (se aplicável)

Se você executar um rollout expand/contract, inclua um painel que mostre leituras/escritas divididas por esquema antigo vs. novo para ver quando é seguro avançar para a próxima fase.

Alertas para falhas específicas de esquema

Faça paging em problemas que indiquem perda ou leitura incorreta de dados:

- Taxa de erro de validação de esquema acima de um limiar baixo (frequentemente <0.1% já é significativo)

- Falhas de parsing/desserialização (especialmente se concentradas em um produtor/consumidor)

- Avisos de campo inesperado / campo obrigatório faltando que aumentem com o tempo

- Job de migração travado (sem progresso por N minutos) ou lag crescendo mais rápido que throughput

Evite alertas barulhentos em 500s brutos sem contexto; ligue alertas ao rollout de esquema usando tags como versão do esquema e endpoint.

Logue a versão para depurar rápido

Durante a transição, inclua e faça log de:

- Versão do esquema (ex.: header

X-Schema-Version, campo de metadata na mensagem) - Versão do app produtor e consumidor

- Versão do modelo / versão do prompt quando saídas geradas por IA alimentam dados estruturados

Esse detalhe torna “por que esse payload falhou?” respondível em minutos, não dias — especialmente quando diferentes serviços (ou diferentes versões de modelo) estão ativos ao mesmo tempo.

Rollback, recuperação e gestão de mudanças

Mudanças de esquema falham de duas formas: a mudança em si está errada, ou o sistema ao redor dela se comporta de maneira diferente do esperado (especialmente quando código gerado por IA introduz suposições sutis). De qualquer forma, toda migração precisa de uma história de rollback antes de ser enviada — mesmo que essa história seja explicitamente “sem rollback”.

Escolher “sem rollback” pode ser válido quando a mudança é irreversível (por exemplo, dropar colunas, reescrever identificadores ou deduplicar registros de forma destrutiva). Mas “sem rollback” não é ausência de plano; é uma decisão que desloca o plano para correções adiante, restaurações e contenção.

Opções práticas de rollback que realmente funcionam

Feature flags / gates de configuração: proteja novos leitores, escritores e campos de API atrás de uma flag para que você possa desligar o comportamento novo sem redeployar. Isso é especialmente útil quando código gerado por IA pode estar sintaticamente correto mas semanticamente errado.

Desabilitar dual-write: Se você grava no esquema antigo e no novo durante um rollout expand/contract, mantenha um kill switch. Desligar o caminho de escrita novo para de gerar mais divergência enquanto você investiga.

Reverter leitores (não só escritores): Muitos incidentes ocorrem porque consumidores começam a ler campos/tabelas novos cedo demais. Facilite apontar serviços de volta para a versão anterior do esquema ou para ignorar campos novos.

Conheça os limites da reversibilidade

Algumas migrações não podem ser desfeitas limpidamente:

- Transformações destrutivas (ex.: hashing, normalização com perda).

- Drops/renames sem cópia preservada.

- Backfills que sobrescrevem a “fonte da verdade”.

Para esses casos, planeje restore a partir de backup, replay a partir de eventos ou recomputar a partir das entradas brutas — e verifique se você ainda tem essas entradas.

Checklist pré-voo (antes de enviar)

- Decisão de rollback documentada (“reverter”, “correção futura” ou “sem rollback + caminho de restauração”).

- Botão de parada claro: flags e/ou switch para desabilitar dual-write.

- Backups/snapshots verificados; restore testado pelo menos uma vez.

- Migração idempotente; reruns não corrompem dados.

- Monitoramento e alertas para taxas de erro, falhas de validação de esquema e lag.

- Responsabilidades: quem aprova, quem executa, quem está on-call durante o rollout.

Boa gestão de mudanças torna rollbacks raros — e torna a recuperação entediante quando eles acontecem.

Se sua equipe itera rápido com desenvolvimento assistido por IA, ajuda combinar essas práticas com ferramentas que suportem experimentação segura. Por exemplo, Koder.ai inclui planning mode para design prévio de mudanças e snapshots/rollback para recuperação rápida quando uma mudança gerada acidentalmente altera um contrato. Usadas juntas, geração rápida de código e disciplina de evolução de esquema permitem avançar mais rápido sem tratar produção como ambiente de testes.