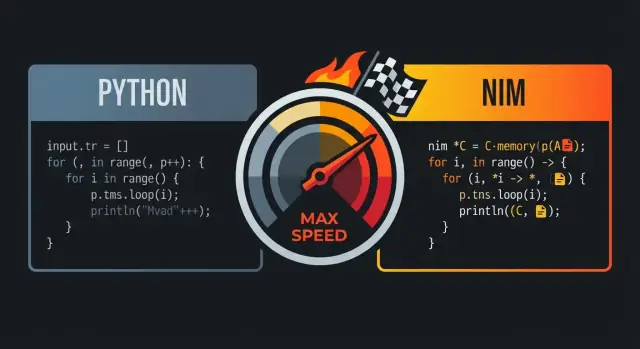

Nim é comparado a Python e C porque busca um ponto de equilíbrio: código que se lê como uma linguagem de alto nível, mas que compila para executáveis nativos rápidos.

A promessa central: legibilidade mais velocidade

À primeira vista, Nim frequentemente parece “Pythonic”: indentação clara, fluxo de controle direto e recursos da biblioteca padrão que incentivam código conciso e legível. A diferença chave é o que acontece depois de escrever o código — Nim foi projetado para compilar para código de máquina eficiente em vez de rodar sobre um runtime pesado.

Para muitas equipes, essa combinação é o objetivo: escrever algo próximo ao que você prototiparia em Python e ainda assim entregar como um binário nativo único.

Para quem isso importa

Essa comparação ressoa mais com:

- desenvolvedores Python que atingem limites de performance (tarefas intensivas em CPU, loops apertados, processamento de dados)

- times de produto que querem iteração rápida sem depender de um runtime lento

- engenheiros que gostam da velocidade do C, mas não querem a cerimônia de baixo nível para o dia a dia

O que “desempenho ao nível do C” significa na prática

“Desempenho ao nível do C” não quer dizer que todo programa Nim iguala automaticamente C otimizado. Quer dizer que Nim pode gerar código competitivo com C para muitas cargas de trabalho—especialmente onde overhead importa: loops numéricos, parsing, algoritmos e serviços que precisam de latência previsível.

Você tende a ver os maiores ganhos quando remove overhead do interpretador, minimiza alocações e mantém caminhos quentes de código simples.

Expectativas: a velocidade ainda depende de escolhas

Nim não salva um algoritmo ineficiente, e você ainda pode escrever código lento se alocar excessivamente, copiar grandes estruturas ou ignorar profiling. A promessa é que a linguagem oferece um caminho do código legível ao código rápido sem reescrever tudo em outro ecossistema.

O resultado: uma linguagem que parece amigável como Python, mas disposta a ficar “próxima do metal” quando a performance realmente importa.

Nim é frequentemente descrito como “parecido com Python” porque o código parece e flui de forma familiar: blocos por indentação, pontuação mínima e preferência por construções de alto nível legíveis. A diferença é que Nim permanece estático e compilado—então você ganha essa superfície limpa sem pagar um “imposto” de runtime por isso.

Blocos por indentação e estrutura limpa

Como Python, Nim usa indentação para definir blocos, o que facilita escanear o fluxo de controle em revisões e diffs. Você não precisa de chaves em todo lugar e raramente precisa de parênteses a menos que melhorem a clareza.

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

Essa simplicidade visual importa quando você escreve código sensível à performance: você gasta menos tempo lutando com sintaxe e mais tempo expressando intenção.

Blocos familiares: loops, slices, strings

Muitas construções do dia a dia mapeiam bem ao que usuários de Python esperam.

- Loops:

for sobre ranges e coleções é natural.

- Slices: sequências e strings suportam operações no estilo slice.

- Strings: manipulação de strings é direta, com uma biblioteca padrão prática.

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

A diferença chave em relação ao Python é o que acontece por trás das cenas: essas construções compilam para código nativo eficiente em vez de serem interpretadas por uma VM.

Tipagem estática que não atrapalha

Nim é fortemente tipado estaticamente, mas depende bastante de inferencia de tipos, então você não precisa escrever anotações verbosas só para trabalhar.

var total = 0 # inferred as int

let name = "Nim" # inferred as string

Quando você quer tipos explícitos (APIs públicas, clareza, ou limites sensíveis à performance), Nim suporta isso de forma limpa—sem forçar anotações em todo lugar.

Erros e avisos do compilador úteis

Parte importante da “legibilidade” é manter o código seguro para manutenção. O compilador do Nim é rigoroso de formas úteis: ele indica incompatibilidades de tipo, variáveis não usadas e conversões suspeitas cedo, frequentemente com mensagens acionáveis. Esse feedback ajuda a manter o código simples como em Python, beneficiando-se ao mesmo tempo de checagens em tempo de compilação.

Se você gosta da legibilidade do Python, a sintaxe do Nim fará você se sentir em casa. A diferença é que o compilador do Nim pode validar suposições e então produzir binários nativos rápidos e previsíveis—sem transformar seu código em boilerplate.

Como o Nim compila: do código-fonte para binários nativos

Nim é uma linguagem compilada: você escreve arquivos .nim e o compilador transforma em um executável nativo que pode rodar diretamente na sua máquina. A rota mais comum é via backend C do Nim (também é possível direcionar para C++ ou Objective-C), onde o código Nim é traduzido para código-fonte do backend e então compilado por um compilador do sistema como GCC ou Clang.

O que “binário nativo” realmente significa

Um binário nativo roda sem máquina virtual e sem um interpretador percorrendo seu código linha a linha. Isso ajuda muito a explicar por que Nim pode parecer de alto nível e ainda evitar muitos dos custos de runtime associados a VMs ou interpretadores: o tempo de inicialização é tipicamente rápido, chamadas de função são diretas e loops quentes podem executar próximos ao hardware.

Oportunidades de otimização de programa inteiro

Como Nim compila ahead-of-time, a cadeia de ferramentas pode otimizar através do programa inteiro. Na prática isso possibilita melhor inlining, eliminação de código morto e otimizações em link-time (dependendo de flags e do compilador C/C++). O resultado frequentemente são executáveis menores e mais rápidos—especialmente comparado ao envio de um runtime junto ao código-fonte.

Fluxo típico: compilar, rodar, distribuir

Durante o desenvolvimento você normalmente itera com comandos como nim c -r yourfile.nim (compila e executa) ou usa modos de build diferentes para debug vs release. Na hora de distribuir, você entrega o executável produzido (e bibliotecas dinâmicas necessárias, se houver linkagens). Não existe uma etapa separada “deploy do interpretador” — seu output já é um programa que o SO pode executar.

Poder em tempo de compilação: fazer trabalho antes de o programa rodar

Uma das maiores vantagens de velocidade do Nim é poder fazer certo trabalho em tempo de compilação (às vezes chamado CTFE: compile-time function execution). Em termos simples: em vez de calcular algo toda vez que o programa roda, você pede ao compilador para calcular uma vez durante a build e incorporar o resultado no binário final.

Por que trabalho em tempo de compilação importa

A performance em runtime muitas vezes é consumida por “custos de setup”: construir tabelas, parsear formatos conhecidos, checar invariantes ou pré-computar valores que não mudam. Se esses resultados são previsíveis a partir de constantes, Nim pode deslocar esse esforço para a compilação.

Isso significa:

- menos tempo de inicialização (sem etapa de "warm-up")

- menos alocações e branches em tempo de execução

- caminhos de código em runtime mais simples (geralmente fáceis para o compilador otimizar)

Exemplos práticos

Gerar tabelas de lookup. Se você precisa de uma tabela para mapeamento rápido (por exemplo, classes ASCII ou um pequeno hash map de strings conhecidas), pode gerar a tabela em tempo de compilação e armazená-la como um array constante. O programa então faz buscas O(1) sem setup.

Validar constantes cedo. Se uma constante está fora do intervalo (um número de porta, tamanho fixo de buffer, versão de protocolo), você pode falhar a build ao invés de entregar um binário que só detecta o problema em produção.

Pré-computar constantes derivadas. Máscaras, padrões de bits ou defaults normalizados podem ser computados uma vez e reutilizados.

Nota de cautela: mantenha a legibilidade

Lógica de tempo de compilação é poderosa, mas ainda é código que alguém precisa entender. Prefira helpers pequenos e bem nomeados; comente explicando “por que agora” (tempo de compilação) vs “por que depois” (runtime). E teste os helpers de CTFE como você testa funções normais—para que otimizações não se convertam em erros de build difíceis de depurar.

As macros do Nim são melhor entendidas como “código que escreve código” durante a compilação. Em vez de rodar lógica reflexiva em runtime (e pagar por isso a cada execução), você pode gerar código Nim especializado uma vez e então distribuir o binário rápido resultante.

Removendo boilerplate (e checagens em tempo de execução)

Um uso comum é substituir padrões repetitivos que inflariam sua base de código ou adicionariam overhead por chamada. Por exemplo, você pode:

- gerar funções de serialização/deserialização para um tipo, em vez de escrever campo a campo

- produzir validação de entrada baseada em um esquema compacto, em vez de espalhar

ifs por todo o código

- construir código de dispatch otimizado (mapear comandos para handlers) sem tabelas de lookup em runtime

Como a macro expande para código Nim normal, o compilador ainda pode inlinear, otimizar e remover ramos mortos—portanto a abstração muitas vezes desaparece no executável final.

Sintaxe específica de domínio (sem precisar de um compilador customizado)

Macros também permitem sintaxes DSL leves. Times usam isso para expressar intenção claramente:

- parsers rápidos: escreva uma descrição declarativa e a macro emite código de parsing enxuto

- serializers: especifique tags/formatos de campo e gere código de packing/unpacking

- mini-DSLs para routing, construção de queries SQL ou mapeamentos de configuração

Feito bem, isso torna o call site parecido com Python—limpo e direto—enquanto compila para loops eficientes e operações seguras com ponteiros.

Mantendo macros sustentáveis

Metaprogramação pode ficar complicada se virar uma linguagem oculta dentro do projeto. Algumas regras:

- Documente o que a macro gera e mostre um exemplo pequeno do código expandido.

- Mantenha macros estreitas: resolva um problema claro em vez de virar um “framework”.

- Prefira generics/templates quando funcionarem; recorra a macros ao nível de AST somente quando necessário.

Lance um app com Nim

Crie rapidamente uma UI React e uma API Go em torno do seu binário Nim sem começar do zero.

O gerenciamento de memória do Nim é uma grande razão pela qual ele pode parecer “Pythonic” enquanto ainda se comporta como uma linguagem de sistemas. Em vez de um coletor de lixo por varredura que periodicamente caminha por objetos para decidir o que liberar, Nim normalmente usa ARC (Automatic Reference Counting) ou ORC (Optimized Reference Counting).

ARC/ORC vs GC por varredura (visão geral)

Um GC por varredura trabalha em rajadas: pausa o trabalho normal para percorrer objetos e decidir o que pode ser liberado. Esse modelo pode ser ótimo para ergonomia do desenvolvedor, mas as pausas podem ser difíceis de prever.

Com ARC/ORC, a maioria da memória é liberada no momento em que a última referência some. Na prática, isso tende a produzir latência mais consistente e facilita raciocinar sobre quando recursos são liberados (memória, handles de arquivo, sockets).

Comportamento de memória previsível reduz “slowdowns surpresa”. Se alocações e liberações acontecem continuamente e localmente—em vez de ciclos globais ocasionais—o timing do seu programa é mais fácil de controlar. Isso importa para jogos, servidores, ferramentas CLI e qualquer coisa que precise ficar responsiva.

Também ajuda o compilador a otimizar: quando lifetimes são mais claros, o compilador às vezes consegue manter dados em registradores ou na stack, evitando trabalho adicional.

Stack vs heap, lifetimes e copiar vs mover

Como simplificação:

- Valores na stack são de curta duração e baratos de criar; desaparecem ao fim do escopo.

- Valores no heap vivem mais e podem ser compartilhados entre escopos, mas alocá-los é mais caro.

Nim permite escrever código de alto nível enquanto ainda se preocupa com lifetimes. Preste atenção a estar copiando grandes estruturas (duplicando dados) ou movendo (transferindo propriedade sem duplicar). Evite cópias acidentais em loops críticos.

Dicas práticas para evitar alocações desnecessárias

Se você quer “velocidade ao estilo C”, a alocação mais rápida é a que você não faz:

- Reuse buffers (strings, sequências, IO) em vez de recriá-los repetidamente.

- Prefira atualizações in-place em caminhos quentes.

- Construa dados incrementalmente com capacidade pré-alocada quando possível.

Esses hábitos combinam bem com ARC/ORC: menos objetos no heap significa menos tráfego de contagem de referências e mais tempo para fazer o trabalho real.

Nim pode parecer de alto nível, mas sua performance muitas vezes se resume a um detalhe de baixo nível: o que é alocado, onde vive e como é disposto em memória. Se você escolher as formas certas para os dados, ganha velocidade “de graça” sem escrever código ilegível.

Tipos por valor vs ref: onde a alocação acontece

A maioria dos tipos Nim são tipos por valor por padrão: int, float, bool, enum, e também object simples. Tipos por valor tipicamente vivem inline (frequentemente na stack ou embutidos em outras estruturas), o que mantém acesso à memória compacto e previsível.

Quando você usa ref (por exemplo, ref object), você adiciona um nível de indireção: o valor costuma morar no heap e você manipula um ponteiro para ele. Isso é útil para dados compartilhados, long-lived ou opcionais, mas pode adicionar overhead em loops quentes porque a CPU precisa seguir ponteiros.

Regra prática: prefira object simples para dados críticos de performance; use ref quando precisar de semântica de referência.

seq e string: convenientes, mas conheça os custos

seq[T] e string são containers dinâmicos e redimensionáveis. São ótimos para programação cotidiana, mas podem alocar e realocar conforme crescem. Padrões de custo a observar:

- Append pode desencadear redimensionamento (copiando elementos existentes)

- Muitos

seqs ou strings pequenos criam muitos blocos separados no heap

Se você conhece tamanhos antecipadamente, pré-dimensione (newSeq, setLen) e reutilize buffers para reduzir churn.

Por que o layout importa: um modelo mental simples de cache

CPUs são mais rápidas quando leem memória contígua. Um seq[MyObj] onde MyObj é um objeto por valor costuma ser favorável ao cache: elementos ficam lado a lado.

Mas um seq[ref MyObj] é uma lista de ponteiros espalhados pelo heap; iterar sobre ela significa pular pela memória, o que é mais lento.

Conselhos práticos para caminhos quentes

Para loops apertados e código sensível à performance:

- Prefira

array (tamanho fixo) ou seq de objetos por valor

- Mantenha campos frequentemente acessados juntos em um único

object

- Evite “cadeias de ponteiros” (

ref dentro de ref) a menos que necessário

Essas escolhas mantêm dados compactos e locais—exatamente o que CPUs modernas preferem.

Abstrações que não custam tempo de execução

Faça um piloto rápido

Teste o Koder.ai em um pequeno projeto relacionado a Nim antes de se comprometer com um build maior.

Uma razão pela qual Nim pode ser de alto nível sem pagar grande imposto de runtime é que muitas funcionalidades são projetadas para compilar em código direto. Você escreve código expressivo; o compilador o reduz a loops enxutos e chamadas diretas.

O que “abstração sem custo” significa no Nim

Uma abstração sem custo torna o código mais fácil de ler ou reutilizar, mas não adiciona trabalho extra em runtime comparado à versão de baixo nível feita à mão.

Um exemplo intuitivo é usar uma API no estilo iterator para filtrar valores, obtendo ainda assim um loop simples no binário final.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

Mesmo que openArray pareça flexível e “de alto nível”, isso normalmente compila para uma varredura indexada básica na memória (sem overhead de objeto como em Python). A API é agradável, mas o código gerado fica próximo ao loop C óbvio.

Inlining, generics e especialização (em linguagem simples)

Nim inlines procedimentos pequenos quando isso ajuda, fazendo o corpo desaparecer no chamador.

Com generics, você escreve uma função que funciona para vários tipos. O compilador então especializa: cria versões específicas para cada tipo concreto que você usa. Isso costuma gerar código tão eficiente quanto funções escritas manualmente por tipo—sem duplicar lógica.

APIs agradáveis que ainda viram loops enxutos

Padrões como pequenos helpers (mapIt, filterIt), tipos distinct, e checagens de range podem ser otimizados quando o compilador consegue enxergar através deles. O resultado pode ser um único loop com branching mínimo.

A grande ressalva: abstrações que forçam alocações

Abstrações deixam de ser “gratuitas” quando criam alocações no heap ou cópias escondidas. Retornar novas seqs repetidamente, construir strings temporárias em loops internos ou capturar closures grandes pode introduzir overhead.

Regra prática: se uma abstração aloca por iteração, ela pode dominar o tempo de execução. Prefira dados amigáveis à stack, reutilize buffers e fique de olho em APIs que criam seqs ou strings silenciosamente em caminhos quentes.

Uma razão prática pela qual Nim pode ser de alto nível e ainda rápido é que ele pode chamar C diretamente. Em vez de reescrever uma biblioteca C comprovada, você pode importar as definições de header, linkar a biblioteca compilada e chamar as funções quase como se fossem procs nativos Nim.

A interface foreign function (FFI) do Nim baseia-se em descrever as funções e tipos C que você quer usar. Em muitos casos você:

- declara os símbolos C em Nim com

importc (apontando para o nome exato em C), ou

- usa ferramentas para gerar declarações Nim a partir de headers C

Depois disso, o compilador Nim linka tudo no mesmo binário nativo, então o overhead de chamada é mínimo.

Por que isso importa: reaproveitar sem reescritas

Isso dá acesso imediato a ecossistemas maduros: compressão (zlib), primitivos criptográficos, codecs de imagem/áudio, clientes de banco, APIs do SO e utilitários críticos de performance. Você mantém a estrutura legível do Nim para lógica de app enquanto usa C comprovado para o trabalho pesado.

Armadilhas a observar: ownership e conversões

Bugs em FFI costumam vir de expectativas desencontradas:

- Regras de ownership: quem aloca e quem libera? Se uma função C retorna um ponteiro que você deve liberar, precisa de um caminho claro de free em Nim. Se C mantém um ponteiro para memória que você passou, você deve garantir que essa memória permaneça viva.

- Strings e buffers: strings Nim não são strings C. Converter para

cstring é fácil, mas você deve assegurar terminação nula e lifetime. Para dados binários, prefira pares explícitos ptr uint8/length.

Um bom padrão é escrever uma pequena camada wrapper Nim que:

- exponha procs e tipos idiomáticos Nim,

- centralize conversões e tratamento de erros,

- esconda ponteiros crus atrás de helpers RAII-like (

defer, destructors) quando apropriado.

Isso facilita testes e reduz a chance de vazamento de detalhes de baixo nível pelo restante do código.

Nim pode parecer rápido “por padrão”, mas os últimos 20–50% frequentemente dependem de como você builda e como você mede. A boa notícia: o compilador Nim expõe controles de performance de maneira acessível mesmo para quem não é especialista em sistemas.

Modos de build que importam

Para números reais de performance, evite benchmarks em builds de debug. Comece com um build de release e só acrescente checagens quando estiver caçando bugs.

nim c -d:release --opt:speed myapp.nim

nim c -d:danger --opt:speed myapp.nim

nim c -d:release --opt:speed --passC:-march=native myapp.nim

Regra simples: use -d:release para benchmarks e produção, e reserve -d:danger para quando já tiver confiança com testes.

Workflow de profiling: meça primeiro, otimize depois

Um fluxo prático é:

- Meça end-to-end primeiro (tempo de parede, memória, throughput). Ferramentas como

hyperfine ou um simples time muitas vezes bastam.

- Encontre hotspots a seguir. Nim tem profiling embutido (

--profiler:on) e também funciona bem com profilers externos (Linux perf, macOS Instruments, ferramentas Windows) porque você produz binários nativos.

- Otimize as 1–2 funções mais quentes e então meça de novo. Se o hotspot se mover, é progresso.

Ao usar profilers externos, compile com debug info para obter traces legíveis e símbolos durante a análise:

nim c -d:release --opt:speed --debuginfo myapp.nim

Micro-otimizações a evitar

É tentador ajustar detalhes minúsculos (unrolling manual de loops, rearranjar expressões, “truques” espertos) antes de ter dados. Em Nim, os ganhos maiores normalmente vêm de:

- escolher um algoritmo melhor,

- reduzir alocações e cópias,

- melhorar o layout de dados (usar representações contíguas quando possível),

- reduzir overhead em loops críticos.

Benchmarks em CI e checagens de regressão

Regressões de performance são mais fáceis de consertar quando detectadas cedo. Uma abordagem leve é adicionar uma suíte de benchmarks (por exemplo, uma task Nimble nimble bench) e rodá-la no CI num runner estável. Armazene baselines (mesmo em JSON simples) e falhe o build quando métricas chave desviarem além de um limite permitido. Assim você evita que “rápido hoje” vire “lento mês que vem” sem perceber.

Onde o Nim brilha (e onde pode não ser ideal)

Vá ao ar no seu domínio

Coloque seu serviço Nim em um domínio personalizado limpo para demos e usuários internos.

Nim é uma boa escolha quando você quer código que se leia como uma linguagem de alto nível, mas que seja distribuído como um executável rápido. Ele recompensa times que se importam com performance, simplicidade de deploy e controle de dependências.

Bom encaixe

Para muitos times, Nim se destaca em software “produto-like”—coisas que você compila, testa e distribui.

- CLIs e ferramentas dev: entregue um binário nativo, inicialize rápido, mantenha baixo overhead de startup.

- Ferramentas e serviços de rede: bom throughput e latência previsível, mantendo código legível.

- Ferramentas de game e pipelines: conversores de assets, build tools, editores e automações onde a velocidade importa mas você não quer a complexidade de C/C++.

Casos para cautela

Nim pode ser menos ideal quando o sucesso depende mais de dinamismo em runtime do que de performance compilada.

- Sistemas de plugin dinâmicos pesados: se você espera carregar e descarregar muitas extensões de terceiros em runtime, o modelo compilado do Nim pode adicionar atrito.

- Scripts rápidos e descartáveis: se o fluxo é “editar, rodar imediatamente, descartar”, Python (ou shell) pode ser mais rápido para tarefas pequenas.

Considerações de time

Nim é acessível, mas ainda tem curva de aprendizado.

- Concorde com convenções de estilo cedo (layout de módulos, tratamento de erros, nomes) para evitar “cada um escreve Nim como quer”.

- Planeje onboarding: pareamento e um guia interno pequeno ajudam mais que docs longas.

- Seja realista sobre lacunas no ecossistema: algumas bibliotecas existem, mas você não encontrará tudo como no vasto ecossistema Python.

Abordagem de projeto piloto

Escolha um projeto pequeno e mensurável—como reescrever um passo lento de um CLI ou uma utilidade de rede. Defina métricas de sucesso (tempo de execução, memória, tempo de build, tamanho do deploy), entregue para um público interno pequeno e decida com base nos resultados, não no hype.

Se seu trabalho em Nim precisar de superfície de produto ao redor—um dashboard admin, um runner de benchmarks, ou um gateway de API—ferramentas como Koder.ai podem ajudar a escalar essas peças rapidamente. Você pode prototipar um frontend React e um backend Go + PostgreSQL, então integrar seu binário Nim como um serviço via HTTP, mantendo o core crítico de performance em Nim enquanto acelera o resto.

Nim conquista a reputação de “parecido com Python, mas rápido” combinando sintaxe legível com um compilador nativo otimizador, gerenciamento de memória previsível (ARC/ORC) e uma cultura de atenção ao layout de dados e alocações. Se você quer os benefícios de velocidade sem transformar a base de código em spaghetti de baixo nível, use este checklist como workflow repetível.

Checklist focado em velocidade (sem sacrificar clareza)

- Compile com intenção: use um build de release para medições reais.

- Comece com

-d:release e considere --opt:speed.

- Habilite otimizações de link quando apropriado (

--passC:-flto --passL:-flto).

- Escolha estruturas de dados intencionalmente: prefira representações simples e contíguas.

seq[T] é ótimo, mas loops apertados muitas vezes se beneficiam de arrays, openArray e evitar redimensionamento desnecessário.- Mantenha dados quentes pequenos e próximos; menos ponteiros geralmente significa menos cache misses.

- Seja consciente de alocações: ARC/ORC ajuda, mas não remove trabalho que você cria.

- Reuse buffers, pré-aloque com

newSeqOfCap e evite construir strings temporárias em loops.

- Fique atento a cópias escondidas ao fatiar ou concatenar.

- Deixe as abstrações se compilarem: escreva código limpo e depois verifique.

- Prefira iterators/templates para expressividade, mas confirme que eles inlineiam em builds de release.

- Meça antes de “otimizar”: profile para achar os gargalos reais.

- Se você é novo em profiling, veja /blog/performance-profiling-basics.

Próximos passos: prove na sua máquina

- Tente um benchmark pequeno: escolha uma função que faça trabalho real (parsing, filtragem, matemática) e compare builds debug vs release.

- Entregue uma feature real: implemente um módulo pequeno fim-a-fim e aperte apenas o caminho quente (não todo o código).

Se você ainda está decidindo entre linguagens, /blog/nim-vs-python pode ajudar a enquadrar as trocas. Para times avaliando ferramentas ou opções de suporte, também pode checar /pricing.