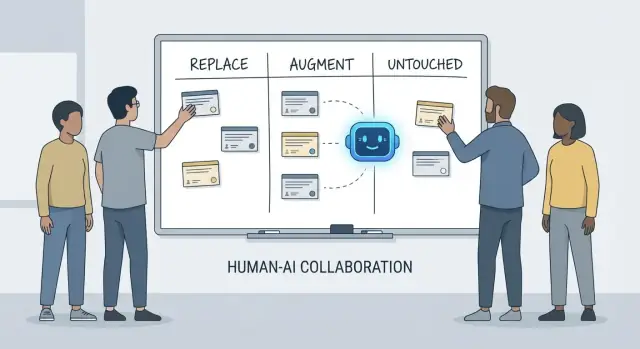

Substituir, Aumentar, Intocado: Um quadro simples

Conversas sobre o que “a IA fará com desenvolvedores” ficam confusas rápido porque frequentemente misturamos ferramentas com responsabilidades. Uma ferramenta pode gerar código, resumir um ticket ou sugerir testes. Uma responsabilidade é aquilo pelo qual a equipe ainda responde quando a sugestão está errada.

Este artigo usa um quadro simples—substituir, aumentar, intocado—para descrever o trabalho do dia a dia em equipes reais com prazos, código legado, incidentes em produção e stakeholders que esperam resultados confiáveis.

O que “substituir” significa (e o que não significa)

Substituir significa que a IA pode completar a tarefa de ponta a ponta na maioria das vezes com guardrails claros, e o papel humano muda para supervisão e checagens pontuais.

Os exemplos tendem a ser trabalhos limitados: gerar boilerplate, traduzir código entre linguagens, rascunhar casos de teste repetitivos ou produzir documentação de primeira versão.

Substituir não significa “sem responsabilidade humana”. Se a saída quebra a produção, vaza dados ou viola padrões, continua sendo responsabilidade da equipe.

O que “aumentar” significa

Aumentar significa que a IA torna um desenvolvedor mais rápido ou mais abrangente, mas não finaliza o trabalho de forma confiável sem julgamento humano.

Este é o caso comum na engenharia profissional: você vai receber rascunhos úteis, abordagens alternativas, explicações rápidas ou uma lista de bugs prováveis—mas um desenvolvedor ainda decide o que é correto, seguro e apropriado para o produto.

O que permanece “intocado”

Intocado significa que a responsabilidade central continua liderada por humanos porque requer contexto, trade-offs e responsabilidade que não se comprimem bem em prompts.

Pense: negociar requisitos, escolher restrições a nível de sistema, lidar com incidentes, definir níveis de qualidade e tomar decisões onde não existe uma única resposta “certa”.

Por que responsabilidades são a unidade de análise

Ferramentas mudam rápido. Responsabilidades mudam devagar.

Então, em vez de perguntar “Uma IA pode escrever este código?”, pergunte “Quem é responsável pelo resultado?” Esse enquadramento mantém expectativas ancoradas em precisão, confiabilidade e responsabilização—coisas que importam mais do que demos impressionantes.

O que entendemos por “responsabilidades do desenvolvedor”

Quando as pessoas perguntam o que a IA “substitui” no desenvolvimento, muitas vezes querem dizer tarefas: escrever uma função, gerar testes, rascunhar documentação. Equipes, porém, não liberam tarefas—elas entregam resultados. É aí que as responsabilidades do desenvolvedor importam.

O conjunto usual de responsabilidades

O trabalho de um desenvolvedor normalmente abrange mais do que o tempo de codificação:

- Entrega: transformar uma ideia vaga em software funcionando que é lançado dentro do prazo.

- Qualidade: correção, manutenibilidade e prevenção de regressões.

- Segurança e privacidade: padrões seguros por padrão, tratamento de dados e consciência de ameaças.

- Operações: manter serviços no ar, entender modos de falha e responder a incidentes.

- Comunicação: alinhar com produto, design, suporte e outros engenheiros.

Essas responsabilidades se espalham por todo o ciclo de vida—from “o que devemos construir?” até “é seguro?” e “o que acontece às 3 da manhã quando quebra?”.

Por que é mais que uma checklist

Cada responsabilidade é realmente muitas pequenas decisões: quais casos de borda importam, quais métricas indicam saúde, quando cortar escopo, se uma correção é segura para liberar, como explicar um trade-off para stakeholders. A IA pode ajudar a executar pedaços desse trabalho (rascunhar código, propor testes, resumir logs), mas responsabilidade é sobre assumir o resultado.

Onde os handoffs falham

Falhas frequentemente acontecem nas bordas de handoff:

- “QA vai pegar” (mas ninguém definiu o que significa qualidade).\

- “Segurança vai revisar” (mas o design já travou escolhas arriscadas).\

- “Operações resolve” (mas o serviço não foi construído para ser operável).

Quando a propriedade está pouco clara, o trabalho cai nos vãos.

Direitos de decisão: quem decide vs. quem executa

Uma forma útil de falar sobre responsabilidades são os direitos de decisão:

- Quem decide requisitos, trade-offs e risco aceitável?\

- Quem executa implementação e verificação?

A IA pode acelerar a execução. Os direitos de decisão—e a responsabilização pelos resultados—ainda precisam de um nome humano ao lado.

Assistentes de programação por IA são genuinamente úteis quando o trabalho é previsível, de baixo impacto e fácil de verificar. Pense neles como um colega júnior rápido: ótimo para produzir a primeira versão, mas ainda precisando de instruções claras e uma checagem cuidadosa.

Na prática, algumas equipes usam cada vez mais plataformas de “vibe-coding” (como Koder.ai) para acelerar esses pedaços substituíveis: gerar scaffolds, ligar fluxos CRUD e produzir rascunhos iniciais de UI e backend via chat. A chave é a mesma: guardrails, revisão e propriedade clara.

Boilerplate de baixo risco

Muito do tempo de desenvolvedor vai para scaffolding de projetos e ligações entre camadas. A IA pode frequentemente gerar:

- arquivos e pastas iniciais (controllers, rotas, DTOs)

- código repetitivo de “cola” entre camadas

- endpoints CRUD simples que seguem um padrão estabelecido

O guardrail aqui é consistência: garanta que combine com suas convenções existentes e não invente novos padrões ou dependências.

Refatores mecânicos e migrações

Quando uma mudança é principalmente mecânica—renomear um símbolo em todo o código, reformatar ou atualizar um uso de API direto— a IA pode acelerar o trabalho braçal.

Ainda assim, trate como uma edição em massa: execute a suíte completa de testes, escaneie diffs por mudanças indesejadas e evite que ela “melhore” coisas além do refactor solicitado.

Rascunhos de documentação (revisão obrigatória)

A IA pode rascunhar READMEs, comentários inline e entradas de changelog com base no código e nas notas de commit. Isso acelera a clareza, mas também pode criar imprecisões com tom confiante.

Boa prática: use IA para estrutura e redação, depois verifique cada afirmação—especialmente passos de setup, padrões de configuração e casos de borda.

Geração básica de testes como ponto de partida

Para funções puras e bem especificadas, testes unitários gerados por IA podem fornecer cobertura inicial e lembrar casos de borda. O guardrail é propriedade: você ainda escolhe o que importa, adiciona asserções que reflitam requisitos reais e garante que os testes falhem pelos motivos corretos.

Resumos de threads e logs

Quando há longos threads no Slack, tickets ou logs de incidentes, a IA pode convertê-los em notas concisas e itens de ação. Mantenha no chão pedindo o contexto completo e verificando fatos-chave, timestamps e decisões antes de compartilhar.

Trabalho que a IA mais aumenta: mais rápida, não finaliza

Assistentes de programação por IA são melhores quando você já sabe o que quer e precisa de ajuda para avançar. Eles podem reduzir o tempo gasto em “digitação” e trazer contexto útil, mas não eliminam a necessidade de propriedade, verificação e julgamento.

Acelerando a implementação (uma boa primeira versão)

Dada uma especificação clara—entradas, saídas, casos de borda e constraints— a IA pode rascunhar uma implementação inicial razoável: boilerplate, mapeamento de dados, handlers de API, migrations ou um refactor direto. O ganho é momentum: você obtém algo executável rapidamente.

A pegadinha é que o código de primeira versão frequentemente perde requisitos sutis (semântica de erros, restrições de desempenho, compatibilidade retroativa). Trate como rascunho de estagiário: útil, mas não autoritativo.

Ao escolher entre abordagens (ex.: cache vs. batching, locking otimista vs. pessimista), a IA pode propor alternativas e listar trade-offs. Isso é valioso para brainstorming, mas os trade-offs devem ser checados com a realidade do seu sistema: formato de tráfego, necessidades de consistência de dados, restrições operacionais e convenções da equipe.

Compreensão de código e navegação na base

A IA também é forte em explicar código desconhecido, apontar padrões e traduzir “o que isso faz?” para linguagem simples. Em conjunto com ferramentas de busca, pode ajudar a responder “Onde X é usado?” e gerar uma lista de impacto de possíveis call sites, configs e testes a revisar.

Ergonomia do desenvolvedor: ciclos de feedback melhores

Espere melhorias práticas de qualidade de vida: mensagens de erro mais claras, pequenos exemplos e snippets prontos para colar. Isso reduz atrito, mas não substitui revisão cuidadosa, execuções locais e testes direcionados—especialmente para mudanças que afetam usuários ou sistemas em produção.

Entendimento do produto e requisitos: ainda liderado por humanos

A IA pode ajudar a escrever e refinar requisitos, mas não pode decidir de forma confiável o que você deve construir ou por que isso importa. Entendimento de produto está enraizado em contexto: metas de negócio, dor do usuário, restrições organizacionais, casos de borda e custo de acertar ou errar. Essas entradas vivem em conversas, histórico e responsabilização—coisas que um modelo pode resumir, mas não possuir.

Pedidos iniciais frequentemente soam como “melhorar o onboarding” ou “reduzir tickets de suporte”. O trabalho do desenvolvedor é traduzir isso em requisitos claros e critérios de aceitação.

Essa tradução é majoritariamente trabalho humano porque depende de perguntas de sondagem e julgamento:

- Qual segmento de usuário estamos otimizando, e qual comportamento deve mudar?\

- O que conta como “concluído”, e como vamos medir?\

- Quais restrições são inegociáveis (privacidade, desempenho, prazos)?

A IA pode sugerir métricas ou rascunhar critérios de aceitação, mas não saberá quais restrições são reais a menos que alguém as forneça—e não vai contestar quando um pedido é auto-contraditório.

Trade-offs e gestão de expectativas

Trabalhar requisitos é onde trade-offs desconfortáveis aparecem: tempo vs. qualidade, velocidade vs. manutenibilidade, novas funcionalidades vs. estabilidade. Equipes precisam de uma pessoa para explicitar riscos, propor opções e alinhar stakeholders sobre as consequências.

Um bom spec não é só texto; é um registro de decisão. Deve ser testável e implementável, com definições nítidas (entradas, saídas, casos de borda e modos de falha). A IA pode ajudar a estruturar o documento, mas a responsabilidade pela correção—e por dizer “isso é ambíguo, precisamos decidir”—fica com humanos.

Design de sistema e decisões de arquitetura

Design de sistema é onde “o que devemos construir?” vira “em que vamos construir e como se comportará quando der errado?” A IA pode ajudar a explorar opções, mas não pode assumir as consequências.

Escolher uma arquitetura que caiba na realidade

Escolher entre monólito, monólito modular, microsserviços, serverless ou plataformas gerenciadas não é uma prova com uma resposta certa. É um problema de ajuste: escala esperada, limites orçamentários, tempo para o mercado e habilidades da equipe.

Um assistente pode resumir padrões e sugerir arquiteturas de referência, mas não saberá que sua equipe entra em plantão semanal, que contratação é demorada ou que o contrato com o fornecedor de banco de dados renova no próximo trimestre. Esses detalhes muitas vezes decidem se uma arquitetura vai vingar.

Tornar trade-offs explícitos

Boa arquitetura é, em sua essência, trade-offs: simplicidade vs. flexibilidade, desempenho vs. custo, velocidade hoje vs. manutenibilidade depois. A IA pode produzir listas de prós/contras rapidamente, o que é útil—especialmente para documentar decisões.

O que não faz é priorizar quando trade-offs doem. Por exemplo, “aceitamos respostas um pouco mais lentas para manter o sistema mais simples e fácil de operar” é uma escolha de negócio, não apenas técnica.

Limites, propriedade de dados e modos de falha

Definir limites de serviço, quem possui quais dados e o que acontece durante falhas parciais requer contexto profundo do produto e operacional. A IA pode ajudar a brainstormar modos de falha (“e se o provedor de pagamentos cair?”), mas você ainda precisa decidir o comportamento esperado, a comunicação ao cliente e o plano de rollback.

APIs que permanecem usáveis

Projetar APIs é projetar um contrato. A IA pode gerar exemplos e apontar inconsistências, mas você precisa decidir versionamento, compatibilidade retroativa e o que estará disposto a suportar a longo prazo.

Decidir quando não construir (ou quando deletar)

Talvez a decisão arquitetural mais importante seja dizer “não”—ou remover uma funcionalidade. A IA não mede custo de oportunidade ou risco político. As equipes sim, e devem fazê-lo.

Depuração e análise da causa raiz na prática

Depuração é onde a IA frequentemente parece impressionante—e onde pode desperdiçar mais tempo silenciosamente. Um assistente pode escanear logs, apontar caminhos de código suspeitos ou sugerir um conserto que “parece certo”. Mas análise de causa raiz não é só gerar explicações; é provar uma delas.

A IA pode sugerir; você confirma a causa raiz

Trate a saída da IA como hipóteses, não conclusões. Muitos bugs têm múltiplas causas plausíveis, e a IA tende a escolher uma história arrumada que bate com o trecho de código que você colou, não com a realidade do sistema em execução.

Um fluxo prático é:

- Peça à IA possíveis causas e quais evidências as distinguiriam.\

- Reproduza o problema e colete essa evidência.\

- Só então aceite uma correção (e verifique que ela realmente remove a condição de falha).

Reproduzir e coletar evidências continua sendo liderado por humanos

Reprodução confiável é uma superpotência de depuração porque transforma um mistério em um teste. A IA pode ajudar a escrever um repro mínimo, rascunhar um script diagnóstico ou propor logs extras, mas você decide quais sinais importam: request IDs, tempos, diferenças de ambiente, feature flags, formato dos dados ou concorrência.

Quando usuários relatam sintomas (“o app travou”), você ainda precisa traduzir isso para comportamento do sistema: qual endpoint travou, quais timeouts dispararam, quais sinais do orçamento de erro mudaram. Isso exige contexto: como o produto é usado e o que é “normal”.

Evite explicações “plausíveis mas erradas”

Se uma sugestão não puder ser validada, assuma que está errada até prova em contrário. Prefira explicações que façam uma previsão testável (ex.: “isso só acontecerá com payloads grandes” ou “apenas após o aquecimento do cache”).

Corrigir, reverter ou redesenhar?

Mesmo após achar a causa, a decisão difícil permanece. A IA pode esboçar trade-offs, mas humanos escolhem a resposta:

- Corrigir rapidamente para estancar o problema.\

- Reverter para restaurar comportamento conhecido.\

- Redesenhar se a falha revela um desalinhamento mais profundo (desempenho, modelo de dados ou pressupostos).

Análise de causa raiz é, no fim, responsabilização: assumir a explicação, a correção e a confiança de que não vai voltar.

Revisão de código: julgamento e padrões não se automatizam

Revisão de código não é só checklist de estilo. É o momento em que a equipe decide o que está disposta a manter, suportar e assumir responsabilidade. A IA pode ajudar você a ver mais, mas não pode decidir o que importa, o que se encaixa na intenção do produto ou quais trade-offs sua equipe aceita.

No que a IA é boa nas reviews

Assistentes de programação por IA podem atuar como um par de olhos incansável. Eles podem rapidamente:

- sinalizar bugs prováveis, padrões suspeitos, checagens de null faltantes ou manipulação insegura de strings

- sugerir nomes mais claros, refatores ou fluxos de controle mais simples

- apontar formatação inconsistente ou duplicação óbvia

- gerar perguntas de revisão (“O que acontece se esta API retornar uma lista vazia?”)

Usada dessa forma, a IA encurta o tempo entre “PR aberto” e “risco notado”.

O que ainda exige julgamento humano

Revisar para correção não é só verificar se o código compila. Humanos conectam mudanças ao comportamento real do usuário, às restrições de produção e à manutenção a longo prazo.

Um revisor ainda precisa decidir:

- O que liberar: a IA pode listar problemas, mas não escolher quais são bloqueadores de release.\

- Legibilidade e manutenção: código “tecnicamente correto” pode ser confuso, frágil ou difícil de estender.\

- Casos de borda e lacunas de ambiente: muitas falhas são “funciona na minha máquina”—config, quirks de dados, concorrência ou tempo de deploy. A IA não infere seu runtime com confiabilidade.\

- Padrões e intenção: só a equipe conhece suas convenções e tolerância a risco. Uma mudança pode ser código limpo e ainda assim comportamento errado.

Fluxo prático: IA como co-revisor

Trate a IA como um segundo revisor, não como aprovador final. Peça uma passada direcionada (checagens de segurança, casos de borda, compatibilidade retroativa) e então faça uma decisão humana sobre escopo, prioridade e alinhamento com padrões e intenção do produto.

Estratégia de testes e propriedade da qualidade

Assistentes de programação por IA podem gerar testes rapidamente, mas não são donos da qualidade. Uma suíte de testes é um conjunto de apostas sobre o que pode quebrar, o que nunca deve quebrar e o que você está disposto a liberar sem provar cada caso de borda. Essas apostas são decisões de produto e engenharia—ainda tomadas por pessoas.

Assistentes são bons em produzir scaffolding de testes unitários, mockar dependências e cobrir comportamentos “happy path” a partir de uma implementação. O que não fazem de forma confiável é decidir qual cobertura importa.

Humanos definem:

- quais módulos precisam de cobertura profunda por serem críticos ou frequentemente alterados

- o que significa “pronto” para um refactor arriscado vs. um bug pequeno

- quando investir em testes de regressão vs. monitoramento e planos de rollback

Escolhendo a mistura certa de tipos de teste

A maioria das equipes precisa de uma estratégia em camadas, não “mais testes”. A IA pode ajudar a escrever muitos desses testes, mas a seleção e os limites são definidos por humanos:

- Testes unitários para regras de negócio e casos de borda complicados.\

- Testes de integração para interações com banco/filas/serviços.\

- Testes end-to-end para jornadas críticas de usuário (poucos, estáveis, alto valor).\

- Testes de contrato para manter compatibilidade entre times/serviços.\

- Testes de desempenho para proteger latência e custo sob carga.

Evitar testes instáveis e confiança falsa

Testes gerados por IA frequentemente espelham demais o código, criando asserções frágeis ou setups excessivamente mockados que passam mesmo quando o comportamento real falha. Desenvolvedores evitam isso:

- testando comportamento observável, não detalhes internos de implementação

- mantendo dados determinísticos e controlando tempo, aleatoriedade e chamadas de rede

- revisando falhas para decidir: bug real, bug no teste ou problema de ambiente

Uma boa estratégia combina com a forma como você entrega. Releases mais rápidas precisam de checagens automáticas mais fortes e caminhos de rollback claros; releases mais lentos podem permitir validações pré-merge mais pesadas. O dono da qualidade é a equipe, não a ferramenta.

Medir os resultados que importam

Qualidade não é porcentagem de cobertura. Meça se os testes melhoram resultados: menos incidentes em produção, recuperação mais rápida e mudanças mais seguras (reversões menores, deploys mais confiantes). A IA acelera o trabalho, mas a responsabilização fica com os desenvolvedores.

Trabalho de segurança é menos sobre gerar código e mais sobre fazer trade-offs sob restrições reais. A IA pode ajudar a apontar checklists e erros comuns, mas a responsabilidade por decisões de risco permanece com a equipe.

Modelagem de ameaças precisa de contexto

Modelagem de ameaças não é exercício genérico—o que importa depende das prioridades do negócio, dos usuários e dos modos de falha. Um assistente pode sugerir ameaças típicas (injeção, autenticação quebrada, padrões inseguros), mas não saberá o que é realmente caro para seu produto: sequestro de conta vs. vazamento de dados vs. interrupção de serviço, ou quais ativos são legalmente sensíveis.

Riscos específicos do app não são padrões

A IA é boa em reconhecer antipadrões conhecidos, mas muitos incidentes vêm de detalhes específicos do app: uma borda de permissões, um endpoint administrativo “temporário” ou um fluxo que contorna aprovações. Esses riscos requerem ler a intenção do sistema, não só o código.

Segredos, permissões e retenção são escolhas intencionais

Ferramentas podem lembrar você de não codificar chaves, mas não podem assumir a política completa:

- onde segredos ficam (vault, CI, runtime) e como rotacionam\

- papéis de menor privilégio e revisões de acesso\

- retenção de dados: o que armazenar, por quanto tempo e quem pode exportar

Dependências e risco da cadeia de fornecimento

A IA pode sinalizar bibliotecas desatualizadas, mas as equipes ainda precisam de práticas: travar versões, verificar procedência, revisar dependências transitivas e decidir quando aceitar risco vs. investir em remediação.

Conformidade não é “adicionar criptografia”. São controles, documentação e responsabilização: logs de acesso, trilhas de aprovação, procedimentos de incidente e prova de que você os seguiu. A IA pode rascunhar templates, mas humanos validam evidências e assinam—porque é nisso que auditores (e clientes) confiam.

Operações, confiabilidade e resposta a incidentes

A IA pode acelerar trabalho de ops, mas não assume propriedade. Confiabilidade é uma cadeia de decisões sob incerteza, e o custo de uma decisão errada costuma ser maior que o de uma decisão lenta.

Onde a IA ajuda no dia a dia

A IA é útil para rascunhar e manter artefatos operacionais—runbooks, checklists e playbooks “se X então Y”. Também pode resumir logs, agrupar alertas similares e propor hipóteses iniciais.

Para trabalho de confiabilidade, isso se traduz em iteração mais rápida sobre:

- dashboards de monitoramento e descrições de alertas\

- notas de capacidade e heurísticas de escalonamento\

- templates de reporte de orçamento de erro

São grandes aceleradores, mas não fazem o trabalho por si só.

As partes que permanecem humanas

Incidentes raramente seguem o script. Engenheiros de plantão lidam com sinais confusos, falhas parciais e trade-offs em tempo real. A IA pode sugerir causas prováveis, mas não decide de forma confiável se deve chamar outro time, desabilitar uma funcionalidade ou aceitar impacto curto no cliente para preservar integridade de dados.

Segurança no deploy é outra responsabilidade humana. Ferramentas podem recomendar reverts, feature flags ou lançamentos em etapas, mas as equipes precisam escolher o caminho mais seguro dado o contexto de negócio e o blast radius.

Postmortems: aprender é o objetivo

A IA pode rascunhar timelines e extrair eventos-chave de chat, tickets e monitoramento. Humanos ainda fazem partes críticas: decidir o que é um bom remédio, priorizar correções e implementar mudanças que previnam repetições (não apenas o mesmo sintoma).

Se você tratar a IA como copiloto para papelada de ops e descoberta de padrões—não como comandante de incidentes—você ganha velocidade sem ceder responsabilidade.

Comunicação da equipe, mentoria e propriedade

A IA pode explicar conceitos de forma clara e sob demanda: “O que é CQRS?”, “Por que isso causa deadlock?”, “Resuma este PR.” Isso ajuda equipes a avançar mais rápido. Mas comunicação no trabalho não é só transferir informação—é construir confiança, estabelecer hábitos compartilhados e fazer compromissos que pessoas possam confiar.

Onboarding: mais que documentação

Novos desenvolvedores não precisam apenas de respostas; precisam de contexto e relações. A IA pode ajudar resumindo módulos, sugerindo trilhas de leitura e traduzindo jargões. Humanos ainda ensinam o que importa aqui: quais trade-offs a equipe prefere, o que é “bom” neste codebase e com quem falar quando algo parece errado.

Alinhamento entre papéis

A maior parte do atrito de projeto aparece entre papéis: produto, design, QA, segurança, suporte. A IA pode rascunhar notas de reunião, propor critérios de aceitação ou reescrever feedback de maneira mais neutra. Pessoas ainda precisam negociar prioridades, resolver ambiguidade e notar quando um stakeholder “concorda” sem realmente concordar.

Definição de pronto e limites de propriedade

Equipes falham quando responsabilidade é difusa. A IA pode gerar checklists, mas não faz cumprir responsabilização. Humanos devem definir o que significa “pronto” (testes? docs? plano de rollout? monitoramento?) e quem é dono depois do merge—especialmente quando código gerado por IA esconde complexidade.

Checklist: IA responsável nos fluxos de trabalho da equipe

- Divulgue o uso de IA quando isso afetar decisões, estimativas ou código autoral.

- Verifique fatos: links, APIs, afirmações de segurança e “melhores práticas” antes de compartilhar.

- Mantenha prompts livres de segredos (chaves, dados de clientes, detalhes de incidentes).

- Trate saídas da IA como rascunhos; atribua um dono humano para cada decisão.

- Escreva normas de equipe: quando a IA é permitida, quando não é, e revise expectativas.

- Prefira mudanças pequenas e revisáveis—evite refatores de “tudo de uma vez” gerados por IA.