Como é uma “Arquitetura Mais Limpa” no Trabalho Assistido por IA

“Arquitetura mais limpa” neste post não significa um framework específico ou um diagrama perfeito. Significa que você consegue explicar o sistema de forma simples, mudá-lo sem quebrar partes não relacionadas e verificar o comportamento sem testes heroicos.

Uma definição prática: clareza, modularidade, testabilidade

Clareza significa que o propósito e a forma do sistema são óbvios a partir de uma descrição curta: o que faz, quem usa, que dados lida e o que nunca deve fazer. No trabalho assistido por IA, clareza também significa que o modelo pode reescrever os requisitos de volta para você de uma forma que você assinaria.

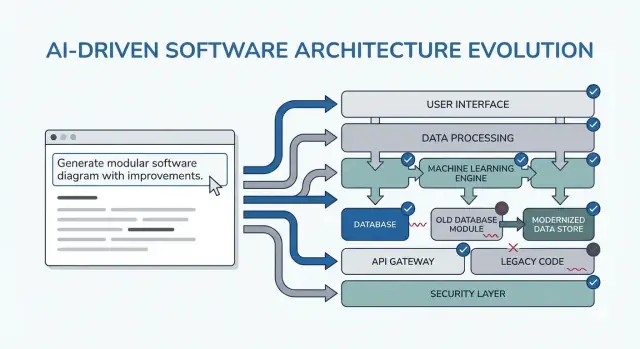

Modularidade significa que as responsabilidades têm fronteiras limpas. Cada módulo tem um trabalho, entradas/saídas e conhecimento mínimo dos internos de outros módulos. Quando a IA gera código, a modularidade evita que regras de negócio se espalhem por controllers, UI e acesso a dados.

Testabilidade significa que a arquitetura torna “provar que funciona” barato. Regras de negócio podem ser testadas sem um sistema rodando por completo, e testes de integração focam em alguns contratos em vez de todos os caminhos do código.

Por que reescritas acontecem (e por que a IA pode amplificá-las)

Reescritas geralmente não são causadas por “código ruim” — são causadas por restrições faltantes, escopo vago e pressupostos ocultos. Exemplos:

- Uma funcionalidade é construída para um tipo de usuário, depois descobrem que existem três papéis e permissões diferentes.

- Regras de desempenho, auditoria ou retenção de dados aparecem tarde.

- Uma API externa se comporta diferente do esperado, forçando mudanças em toda parte.

A IA pode acelerar esse modo de falha produzindo saída convincente rapidamente, o que facilita construir em cima de fundações instáveis.

O que esperar dos padrões neste guia

Os padrões à frente são modelos para adaptar, não prompts mágicos. O objetivo real é forçar as conversas certas cedo: esclarecer restrições, comparar opções, documentar suposições e definir contratos. Se você pular esse pensamento, o modelo alegremente preencherá as lacunas — e você pagará por isso depois.

Onde esses padrões se encaixam no seu fluxo de trabalho

Você os usará ao longo de todo o ciclo de entrega:

- Planejamento: apertar requisitos e critérios de sucesso

- Design: escolher fronteiras, fluxos de dados e contratos

- Codificação: manter responsabilidades separadas à medida que a implementação cresce

- Revisão: detectar riscos e desencontros antes que virem reescritas

Se você usa um fluxo vibe-coding (onde o sistema é gerado e iterado via chat), esses checkpoints importam ainda mais. Por exemplo, no Koder.ai você pode rodar um loop em “modo de planejamento” para fechar requisitos e contratos antes de gerar código React/Go/PostgreSQL, então usar snapshots/rollback para iterar com segurança quando suposições mudam — sem transformar cada mudança em uma reescrita.

Como Usar Padrões de Prompt Sem Criar Mais Trabalho

Padrões de prompting são mais valiosos quando reduzem a oscilação de decisões. O truque é usá-los como checkpoints curtos e repetíveis — antes de codar, durante o design e na revisão — para que a IA produza artefatos reutilizáveis, não texto extra que você precisa filtrar.

Quando usar padrões

Antes de codar: rode um loop de “alinhamento” para confirmar objetivos, usuários, restrições e métricas de sucesso.

Durante o design: use padrões que forcem trade-offs explícitos (por exemplo, alternativas, riscos, fronteiras de dados) antes de começar a implementar.

Durante a revisão: use um prompt em formato de checklist para identificar lacunas (casos de borda, monitoramento, segurança, desempenho) enquanto as mudanças ainda são baratas.

Reúna entradas primeiro (mantenha leve)

Você obterá melhores resultados com um conjunto pequeno e consistente de entradas:

- Objetivos: o que significa “pronto” (metas de latência, resultados de UX, limites de custo)

- Usuários: papéis, fluxos-chave e principais pontos de dor

- Restrições: stack técnico, prazos, conformidade/segurança

- Dados & integrações: fontes, propriedade, APIs, dependências de terceiros

Se você não souber algo, diga explicitamente e peça que a IA liste suposições.

Em vez de “explique o design”, solicite artefatos que você possa colar em docs ou tickets:

- Um registro de decisão (opções → prós/cons → escolhido → por quê)

- Uma tabela de componentes com responsabilidades e fronteiras

- Um checklist para confiabilidade e testes

- Uma descrição de diagrama simples (por exemplo, texto Mermaid) para renderizar depois

Faça loop de 10–15 minutos: prompt → leitura rápida → ajuste. Sempre inclua critérios de aceitação (o que deve ser verdade para o design ser aceitável), depois peça à IA para auto-verificar contra eles. Isso impede que o processo vire redesign sem fim e torna os padrões das próximas seções rápidos de aplicar.

Padrão 1: Esclareça os Requisitos Antes de Qualquer Design

A maioria das “reescritas de arquitetura” não é causada por diagramas ruins — é causada por construir a coisa certa para o problema errado (ou incompleto). Quando você usa uma LLM cedo, não peça uma arquitetura primeiro. Peça que ela exponha ambiguidades.

Use o modelo como um analista de requisitos. Seu objetivo é uma especificação curta e priorizada que você possa confirmar antes que alguém desenhe componentes, escolha bancos de dados ou se comprometa com APIs.

Aqui está um template para copiar e colar que você pode reutilizar:

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

O que procurar na saída

Você quer perguntas que forcem decisões (não o genérico “me diga mais”), além de uma lista de must-have que realmente caiba no seu prazo.

Trate a reafirmação em “10 bullets” como um contrato: cole-a no seu ticket/PRD, peça um rápido sim/não dos stakeholders e só então avance para a arquitetura. Esse passo previne a causa mais comum de refatorações tardias: construir recursos que nunca foram realmente necessários.

Padrão 2: Jornadas de Usuário Primeiro, Depois Escolhas Técnicas

Quando você começa pelas ferramentas (“Devemos usar event sourcing?”) frequentemente acaba desenhando para a arquitetura em vez do usuário. Um caminho mais rápido para estrutura limpa é fazer a IA descrever as jornadas de usuário primeiro, em linguagem simples, e só então traduzir essas jornadas em componentes, dados e APIs.

Um template simples orientado a jornadas

Use isto como ponto de partida para copiar e colar:

- Papéis: usuário / administrador / sistema

- Ações-chave: o que cada papel tenta realizar

- Casos de borda: o que pode dar errado (entrada inválida, permissões ausentes, conclusão parcial)

Depois peça:

-

“Descreva o fluxo passo a passo para cada ação em linguagem simples.”

-

“Forneça um diagrama de estados simples ou uma lista de estados (por exemplo, Draft → Submitted → Approved → Archived).”

-

“Liste cenários fora do caminho feliz: timeouts, retries, requisições duplicadas, cancelamentos e entradas inválidas.”

Uma vez que os fluxos estejam claros, você pode pedir à IA para mapeá-los para escolhas técnicas:

- Onde precisamos de validação vs regras de negócio?

- Quais etapas requerem idempotência (retries seguros)?

- Que dados precisam ser armazenados, o que pode ser derivado e o que precisa de trilha de auditoria?

Só então peça um esboço de arquitetura (serviços/módulos, fronteiras e responsabilidades) diretamente ligado aos passos do fluxo.

Converta fluxos em critérios de aceitação testáveis

Finalize pedindo que a IA converta cada jornada em critérios de aceitação que você possa testar de fato:

- “Given/When/Then para cada passo e caso de falha.”

- “O que o sistema deve retornar ou exibir?”

- “O que deve ser logado e o que deve acionar retry vs erro visível ao usuário?”

Esse padrão reduz reescritas porque a arquitetura cresce a partir do comportamento do usuário — não de suposições sobre tecnologia.

Padrão 3: Registro de Suposições para Evitar Reescritas Surpresa

A maior parte do retrabalho de arquitetura não é causada por “design ruim” — é causada por suposições ocultas que se revelam erradas. Quando você pede uma arquitetura a uma LLM, ela frequentemente preenche lacunas com palpites plausíveis. Um registro de suposições torna esses palpites visíveis cedo, quando as mudanças são baratas.

O que pedir ao modelo para fazer

Seu objetivo é forçar uma separação clara entre fatos que você forneceu e suposições que ele inventou.

Use este padrão de prompt:

Template prompt

“Before proposing any solution: list your assumptions. Mark each as validated (explicitly stated by me) or unknown (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design.”

Mantenha curto para que as pessoas realmente usem:

- Assumption: …

- Status: validated / unknown

- Why it matters: que decisão afeta

- How to validate: pergunta, checagem ou spike

- If wrong, likely change: o que você redesenharia

Gatilhos “o que mudaria sua resposta?”

Adicione uma linha que faça o modelo te contar os pontos de virada:

- “Liste 5 gatilhos: o que mudaria sua resposta? (por exemplo, volume de usuários, metas de latência, necessidades de conformidade, regras de retenção de dados).”

Esse padrão transforma arquitetura em um conjunto de decisões condicionais. Você não recebe apenas um diagrama — recebe um mapa do que precisa ser confirmado antes de se comprometer.

Padrão 4: Compare Múltiplas Arquiteturas Antes de Escolher Uma

Planeje antes de construir

Use o modo de planejamento para transformar requisitos em contratos claros antes de gerar qualquer código.

Ferramentas de IA são ótimas em produzir um único design “melhor” — mas isso costuma ser só a primeira opção plausível. Uma arquitetura mais limpa geralmente surge quando você força uma comparação cedo, enquanto mudanças ainda são baratas.

O template central do prompt

Use um prompt que exija múltiplas arquiteturas e uma tabela de trade-offs estruturada:

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

Por que isso reduz reescritas

Uma comparação força o modelo (e você) a expor suposições ocultas: onde o estado fica, como serviços se comunicam, o que precisa ser síncrono e o que pode ficar para depois.

A tabela de critérios importa porque evita debates do tipo “microservices vs monolito” baseados só em opinião. Ela ancorará a decisão no que realmente importa pra você — lançar rápido, reduzir overhead operacional ou melhorar confiabilidade.

Exija recomendação e uma fronteira

Não aceite “depende”. Peça uma recomendação clara e as restrições específicas que ela otimiza.

Insista também em “o que não estamos construindo.” Exemplos: “Sem failover multi-região”, “Sem sistema de plugins”, “Sem notificações em tempo real”. Isso evita que a arquitetura se expanda silenciosamente para suportar funcionalidades que você não se comprometeu a entregar ainda — e previne reescritas-surpresa quando o escopo mudar mais tarde.

Padrão 5: Prompts de Fronteiras Modulares e Responsabilidade

A maioria das reescritas acontece porque fronteiras eram vagas: tudo “se conecta com tudo” e uma pequena mudança reverbera por todo o código. Este padrão usa prompts que forçam propriedade modular clara antes de alguém discutir frameworks ou diagramas de classes.

A ideia central

Peça à IA para definir módulos e responsabilidades, além do que explicitamente NÃO pertence a cada módulo. Depois solicite interfaces (entradas/saídas) e regras de dependência, não um plano de build ou detalhes de implementação.

Template para copiar e colar

Use isto ao esboçar uma nova funcionalidade ou refatorar uma área bagunçada:

- Contexto: <um parágrafo sobre o produto/funcionalidade>

- Objetivo: Propor uma arquitetura modular com 4–8 módulos.

-

Liste módulos com:

- Propósito (1 frase)

- Responsabilidades (3–5 bullets)

- Não-responsabilidades (“NÃO manipula…”) (2–3 bullets)

-

Para cada módulo, defina somente interfaces:

- Entradas (eventos/requests/dados)

- Saídas (respostas/eventos/efeitos colaterais)

- Superfície de API pública (nomes de funções ou endpoints aceitáveis; sem classes internas)

-

Regras de dependência:

- Dependências permitidas (A → B)

- Dependências proibidas (A ↛ C) com justificativa

- Onde tipos compartilhados vivem (e o que nunca deve ser compartilhado)

-

Teste de mudança futura: Dadas estas mudanças prováveis: <liste 3>, mostre qual único módulo deve absorver cada mudança e por quê.

Como é uma boa saída

Você quer módulos que consiga descrever a um colega em menos de um minuto. Se a IA propuser um módulo “Utils” ou colocar regras de negócio em controllers, pressione: “Mova a tomada de decisão para um módulo de domínio e mantenha adaptadores finos.”

Ao terminar, você terá fronteiras que sobrevivem a novos requisitos — porque mudanças têm um lugar claro, e regras de dependência evitam acoplamento acidental.

Padrão 6: Dados & Contratos de API Primeiro (Evite Retrabalho de Integração)

Retrabalho de integração frequentemente não é causado por “código ruim” — é causado por contratos pouco claros. Se o modelo de dados e as formas de API são decididos tarde, cada equipe (ou módulo) preenche lacunas de maneira diferente, e você passa o próximo sprint reconciliando suposições incompatíveis.

Comece pedindo contratos antes de falar sobre frameworks, bancos ou microsserviços. Um contrato claro vira a referência compartilhada que mantém UI, backend e pipelines de dados alinhados.

O prompt contratual

Use este prompt inicial com seu assistente de IA:

- Template: “Describe the data model, ownership, and lifecycle for each entity”

Então siga imediatamente com:

- Peça contratos de API com exemplos (requests, responses, formatos de erro)

- Adicione expectativas de versionamento e compatibilidade retroativa

- Solicite regras de validação e casos de borda por campo

Como é uma boa saída

Você quer artefatos concretos, não prosa. Por exemplo:

- Entity:

Subscription

- Owner: Billing service

- Lifecycle: created on checkout → active → past_due → canceled (soft-delete after 90 days)

- Source of truth: billing DB; other services cache read-only copies

E um esboço de API:

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

Regras de versionamento e compatibilidade

Peça que a IA declare regras como: “Campos aditivos são permitidos sem bump de versão; renomeações exigem /v2; clientes devem ignorar campos desconhecidos.” Esse único passo evita mudanças silenciosas que quebram clientes — e as reescritas que seguiriam.

Padrão 7: Modos de Falha e Checklist de Confiabilidade

Lance app mobile pelo chat

Transforme suas jornadas em um app mobile Flutter sem começar do zero.

Arquiteturas são reescritas quando designs do “caminho feliz” encontram tráfego real, dependências instáveis e comportamento inesperado do usuário. Este padrão torna confiabilidade uma saída explícita do design, não uma correria pós-lançamento.

Template para copiar e colar

Use isto com a descrição de arquitetura escolhida:

List failure modes; propose mitigations; define observability signals.

Para cada modo de falha:

- O que o desencadeia?

- Impacto no usuário (o que o usuário experimenta)

- Mitigação (design + operacional)

- Retries, idempotency, rate limits, timeouts considerações

- Observability: logs/metrics/traces + limiares de alerta

O que pedir que o modelo cubra (não negociáveis)

Foque a resposta nomeando as interfaces que podem falhar: APIs externas, banco de dados, filas, provedor de auth e jobs em background. Depois exija decisões concretas:

- Retries: quando re-tentar, quantas vezes, estratégia de backoff, e quais erros são retryáveis.

- Idempotência: chaves de idempotência, janelas de dedupe e que estado é seguro para reexecutar.

- Limites de taxa: limites por usuário/IP/serviço, mensagens para cliente e proteção server-side.

- Timeouts: por dependência, orçamento total de request e propagação de cancelamento.

Checklist de confiabilidade (saída)

Finalize o prompt com: “Retorne um checklist simples que possamos revisar em 2 minutos.” Um bom checklist inclui itens como: timeouts de dependência configurados, retries limitados, idempotência para ações de criação/charge, presença de backpressure/limitação de taxa, caminho de degradação graciosa definido.

Observabilidade ligada a ações do usuário

Peça eventos em torno de momentos importantes do usuário (não apenas internals): “user_signed_up”, “checkout_submitted”, “payment_confirmed”, “report_generated”. Para cada um, peça:

- Campos de log (user_id, request_id, idempotency_key)

- Métricas (taxa de sucesso, latência p95/p99, contagem de retries)

- Traces (spans por chamada de dependência)

Isso transforma confiabilidade em um artefato de design que você pode validar antes do código existir.

Padrão 8: Planejamento de Slice MVP para Reduzir Overbuilding

Uma forma comum de design assistido por IA gerar reescritas é incentivar arquiteturas “completas” cedo demais. A correção é simples: force o plano a começar pelo menor slice utilizável — um que entregue valor, valide o design e mantenha opções futuras abertas.

O template do prompt

Use isto quando sentir que a solução está se expandindo mais rápido que os requisitos:

Template: “Propose the smallest usable slice; define success metrics; list follow-ups.”

Peça que o modelo responda com:

- MVP slice: o que está incluído para enviar algo real

- Success metrics: como você saberá que funcionou (visível ao usuário + técnico)

- Follow-ups: o que pode esperar sem bloquear o aprendizado

Exija um roadmap em fases (MVP → v1 → v2)

Adicione: “Dê um roadmap em fases: MVP → v1 → v2, e explique qual risco cada fase reduz.” Isso mantém ideias futuras visíveis sem forçá-las para a primeira entrega.

Resultados esperados:

- MVP valida o fluxo central e um caminho end-to-end fino.

- v1 endurece confiabilidade, adiciona usabilidade must-have.

- v2 expande amplitude (mais integrações, papéis avançados, otimizações).

Exigências explícitas de exclusões para evitar scope creep

A linha mais poderosa neste padrão é: “Liste o que está explicitamente fora do escopo para o MVP.” Exclusões protegem decisões de arquitetura da complexidade prematura.

Boas exclusões:

- “Sem failover multi-região no MVP (logar incidentes; planejar para v2).”

- “Sem sistema de plugins ainda (mantenha fronteiras limpas, mas entregue módulos fixos).”

- “Apenas um provedor de pagamento; abstrair depois se necessário.”

Finalmente: “Converta o MVP em tickets, cada um com critérios de aceitação e dependências.” Isso força clareza e revela acoplamentos ocultos.

Uma boa decomposição de tickets geralmente inclui:

- Um caminho end-to-end fino do “happy path”

- Modelo de dados mínimo + contrato de API

- Tratamento de erro básico e logging

- Um ponto de integração (se necessário) com fallback stubbed

Se quiser, peça para saída no formato do seu fluxo (por exemplo, campos estilo Jira) e mantenha as fases posteriores em backlog separado.

Padrão 9: Prompts Test-First que Moldam Melhores Designs

Entre no ar quando estiver pronto

Faça deploy e hospede seu app quando estiver pronto para compartilhar uma versão funcional.

Uma forma simples de impedir que a arquitetura descambe é forçar clareza via testes antes de pedir um design. Quando você pede a uma LLM começar por testes de aceitação, ela precisa nomear comportamentos, entradas, saídas e casos de borda. Isso expõe requisitos faltantes e puxa a implementação para fronteiras modulares limpas.

Template para copiar e colar

Use isto como um prompt-gate sempre que estiver prestes a projetar um componente:

- Template: “Write acceptance tests first; then propose implementation. You must: (1) list assumptions, (2) name unit vs integration tests, (3) define test data and mocks vs real dependencies, (4) include a definition of done.”

Peça limites de teste que correspondam aos módulos

Siga com: “Agrupe os testes pela responsabilidade do módulo (camada API, lógica de domínio, persistência, integrações externas). Para cada grupo, especifique o que é mockado e o que é real.”

Isso empurra a LLM para longe de designs entrelaçados onde tudo toca tudo. Se ela não consegue explicar onde começam os testes de integração, provavelmente sua arquitetura ainda não está clara.

Estratégia de dados de teste: evite suítes frágeis

Peça: “Proponha um plano de dados de teste: fixtures vs factories, como gerar casos de borda e como manter testes determinísticos. Liste quais dependências podem usar fakes em memória e quais exigem um serviço real no CI.”

Você frequentemente descobrirá que uma “feature simples” precisa na verdade de um contrato, um dataset seed ou IDs estáveis — melhor descobrir agora do que durante uma reescrita.

Definição de pronto (para o envio)

Finalize com um checklist leve:

- Testes passando (unit + integração) e cobertura significativa de casos de falha

- Docs mínimos: uso, configuração e uma nota curta de troubleshooting

- Monitoramento/alertas para modos de falha chave

- Plano de rollout (feature flag, passos de migração, rollback)

Padrão 10: Prompts de Revisão de Design para Captar Problemas Cedo

Revisões de design não devem acontecer só depois do código existir. Com IA, você pode rodar uma “revisão pre-mortem” no seu rascunho de arquitetura (mesmo que seja só alguns parágrafos e um diagrama em palavras) e obter uma lista concreta de fraquezas antes que virem reescritas.

O template central de revisão

Comece com uma postura dura de revisor e force especificidade:

Prompt: “Act as a reviewer; list risks, inconsistencies, and missing details in this design. Be concrete. If you can’t evaluate something, say what information is missing.”

Cole seu resumo de design, restrições (orçamento, prazo, habilidades do time) e quaisquer requisitos não funcionais (latência, disponibilidade, conformidade).

Revisões falham quando o feedback é vago. Peça uma lista priorizada de correções:

Prompt: “Give me a prioritized punch list. For each item: severity (Blocker/High/Medium/Low), why it matters, suggested fix, and the smallest validation step.”

Isso produz um conjunto de tarefas prontas para decisão em vez de um debate.

Quantifique risco de reescrita

Uma função útil é um score simples:

Prompt: “Assign a rewrite risk score from 1–10. Explain the top 3 drivers. What would reduce the score by 2 points with minimal effort?”

Você não busca precisão; busca expor suposições mais propensas a reescrita.

Finalmente, previna que a revisão expanda o escopo:

Prompt: “Provide a diff plan: minimal changes needed to reach the target design. List what stays the same, what changes, and any breaking impacts.”

Quando você repete esse padrão em cada iteração, sua arquitetura evolui por passos pequenos e reversíveis — enquanto os grandes problemas são captados cedo.

Um Pacote de Prompts para Copiar & Colar e um Fluxo de Trabalho Simples

Use este pacote como um fluxo leve que você pode repetir em cada feature. A ideia é encadear prompts para que cada etapa produza um artefato que a próxima etapa reutilize — reduzindo “contexto perdido” e reescritas-surpresa.

O fluxo de 6 passos (encadeie esses padrões)

- Requisitos (esclarecer + restrições)

- Opções de arquitetura (comparar 2–3 abordagens)

- Fronteiras (módulos + responsabilidades)

- Contratos (dados + APIs)

- Testes (aceitação test-first + testes unitários chave)

- Revisão (modos de falha + checklist de revisão de design)

Na prática, equipes costumam implementar essa cadeia como uma “receita de feature” repetível. Se você está construindo com Koder.ai, a mesma estrutura mapeia bem para um processo guiado por chat: capture os artefatos em um lugar, gere o primeiro slice funcional e depois itere com snapshots para que experimentos sejam reversíveis. Quando o MVP estiver pronto, você pode exportar código-fonte ou fazer deploy/host com domínio customizado — útil quando você quer velocidade da entrega assistida por IA sem se prender a um único ambiente.

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

Se quiser um acompanhamento mais profundo, veja /blog/prompting-for-code-reviews. Se estiver avaliando ferramentas ou adoção em time, /pricing é um próximo passo prático.