28 de ago. de 2025·8 min

O Playbook de Andy Jassy para a AWS: Transformando Trabalho Operacional em Valor

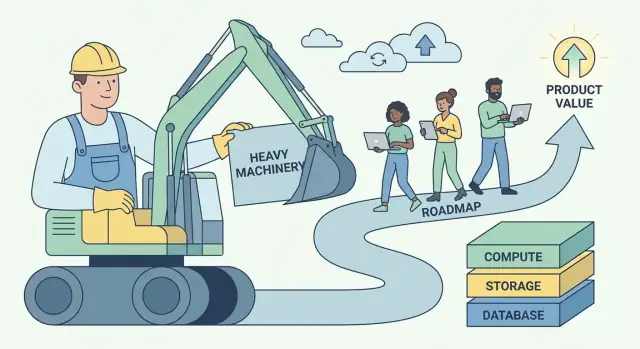

Como Andy Jassy moldou a AWS em torno do “trabalho operacional não diferenciador” e transformou isso em um modelo repetível para construir negócios de software e plataformas escaláveis.

O que “trabalho operacional não diferenciador” realmente significa

“Trabalho operacional não diferenciador” é uma ideia simples com uma ponta afiada: é o trabalho que você precisa fazer para rodar seu software, mas que não faz os clientes escolherem você.

Inclui tarefas como provisionar servidores, aplicar patches em bancos de dados, rotacionar credenciais, configurar monitoramento, lidar com failover, escalar capacidade e caçar incidentes de produção causados por encanamentos em vez de produto. Esses trabalhos são reais, importantes e frequentemente urgentes — mas raramente criam uma experiência única para os usuários.

Definição em linguagem direta

Se uma tarefa é:

- Necessária (você não pode evitá-la se quiser confiabilidade)

- Repetível (toda equipe faz uma versão semelhante dela)

- Não uma vantagem competitiva (os clientes não pagariam mais porque você a fez internamente)

…ela é trabalho operacional não diferenciador.

Por que a expressão ressoou com construtores e executivos

Construtores ouviram alívio nela: permissão para parar de tratar o esforço operacional como um distintivo de honra. Se todo mundo está reinventando os mesmos scripts de deployment e runbooks de on-call, isso não é artesanato — é foco desperdiçado.

Executivos ouviram alavanca: essa categoria de trabalho é cara, escala mal com headcount e cria risco. Reduzi-la melhora margens, confiabilidade e velocidade ao mesmo tempo.

O padrão de negócios ao qual essa ideia aponta

A AWS popularizou um playbook repetível:

- Remover o trabalho repetitivo transformando operações frágeis, feitas por time a time, em um serviço.

- Padronizar as partes comuns para que a qualidade se torne consistente.

- Escalar por meio de automação e infraestrutura compartilhada.

- Reinvestir as economias em melhores produtos e entrega mais rápida.

Isso é maior do que infraestrutura em nuvem — é “pensamento de plataforma” aplicado a qualquer negócio de software.

O que esperar deste artigo

Vamos traduzir o conceito em sinais práticos que você pode identificar no seu produto e equipe, mostrar como serviços gerenciados e plataformas internas empacotam operações como produto e cobrir as reais compensações (controle, custo e lock-in). Você sairá com um framework para decidir o que construir vs. comprar — e como transformar trabalho não diferenciador em valor de negócio que se compõe.

O insight central de Andy Jassy: clientes querem construir, não cuidar de bebês

Andy Jassy foi um dos líderes iniciais que ajudaram a transformar as capacidades de infraestrutura internas da Amazon no que virou a AWS. O trabalho dele não era apenas “vender servidores pela internet”. Era notar um problema repetível do cliente e empacotar uma solução que pudesse escalar por milhares de equipes.

A dor real: operações roubam atenção do produto

A maioria das equipes de software não acorda animada para aplicar patches de sistemas operacionais, provisionar capacidade, rotacionar credenciais ou recuperar de um disco com falha. Fazem essas coisas porque precisam — caso contrário o app não roda.

O insight central de Jassy foi que muito desse trabalho é necessário mas não diferenciador. Se você roda um site de comércio eletrônico, um app fintech ou uma ferramenta interna de RH, seus clientes valorizam suas features: checkout mais rápido, melhor detecção de fraudes, onboarding mais suave. Raramente recompensam você por manter uma frota de servidores perfeitamente ajustada.

Assim, o “cuidar” da infraestrutura vira um imposto:

- Consome tempo que poderia ser gasto entregando melhorias.

- Obriga equipes a contratar por habilidades nas quais não querem se especializar.

- Aumenta o risco porque cada empresa tem de reaprender as mesmas lições operacionais.

Por que o timing importou

Essa ideia apareceu num momento em que as demandas cresciam por todos os lados:

- Escala da internet tornava o tráfego imprevisível; planejar para o pico era caro.

- Startups precisavam mover-se rápido sem montar uma equipe de data center.

- TI corporativa enfrentava pressão para entregar mais rápido lidando com segurança e conformidade.

O princípio não era “mova tudo para a nuvem.” Era mais simples: remova encargos operacionais repetíveis para que os clientes possam gastar mais energia no que os torna diferentes. Essa mudança — tempo e atenção de volta ao build — tornou-se a base para um negócio de plataforma.

Identificando trabalho pesado na sua própria produto e equipe

O primeiro passo é separar trabalho básico (necessário para rodar um produto crível) da diferenciação (as razões pelas quais os clientes escolhem você).

Trabalho básico não é “sem importância”. Frequentemente é crítico para confiabilidade e confiança. Mas raramente cria preferência por si só — especialmente quando concorrentes conseguem atingir o mesmo patamar.

Sinais comuns de “trabalho pesado”

Se você não tem certeza do que pertence ao bucket não diferenciador, observe trabalhos que são:

- Necessários, repetitivos e inegociáveis

- Custosos quando falham, mas majoritariamente invisíveis quando funcionam

- Resolvidos de maneiras amplamente semelhantes entre empresas

Em equipes de software, isso frequentemente inclui:

- Gerenciar servidores ou clusters

- Aplicar patches de segurança e atualizar dependências

- Backups e exercícios de recuperação de desastre

- Auto-scaling e planejamento de capacidade

- Monitoramento básico, logging e alertas

- Plantões de on-call para modos de falha previsíveis

Nenhum desses é “ruim”. A questão é se fazê-los internamente faz parte do valor do seu produto — ou é apenas o preço de entrada.

O teste mais simples: os clientes pagariam por isso?

Uma regra prática é:

“Os clientes pagariam por isso especificamente, ou apenas esperam que esteja incluído?”

Se a resposta é “eles só ficariam irritados se faltasse”, provavelmente você está vendo trabalho operacional não diferenciador.

Um segundo teste: se você removesse esse trabalho amanhã adotando um serviço gerenciado, seus melhores clientes ainda valorizariam você pelo que restasse? Se sim, você encontrou um candidato para offload, automação ou productização.

“Não diferenciador” muda conforme o mercado

O que é não diferenciador em uma empresa pode ser IP central em outra. Um fornecedor de banco de dados pode se diferenciar por backup e replicação. Um produto fintech provavelmente não deveria. Seu objetivo não é copiar o limite de outra empresa — é traçar o seu com base no que seus clientes recompensam de forma única.

Ao mapear seu roadmap e trabalho operacional por essa lente, você começa a ver onde tempo, talento e atenção estão sendo gastos apenas para manter o status quo.

Por que essa ideia cria enorme valor de negócio

“Trabalho operacional não diferenciador” não é só um hack de produtividade. É um modelo de negócios: pegue um problema que muitas empresas precisam resolver, mas no qual ninguém quer se diferenciar, e transforme-o em um serviço que as pessoas pagam de bom grado.

Problemas comoditizados são combustível de plataforma

Os melhores candidatos são necessidades com baixa unicidade estratégica: provisionar servidores, aplicar patches em bancos, rotacionar credenciais, escalar filas, gerenciar backups. Toda equipe precisa deles, quase toda equipe prefere não construí-los, e a “resposta certa” é amplamente similar entre empresas.

Essa combinação cria um mercado previsível: alta demanda, requisitos recorrentes e métricas claras de sucesso (uptime, latência, conformidade, tempo de recuperação). Uma plataforma pode padronizar a solução e continuar melhorando ao longo do tempo.

Economias de escala: espalhando custos fixos entre clientes

Excelência operacional tem grandes custos fixos — SREs, especialistas em segurança, plantões, auditorias, ferramentas de incidente e monitoramento 24/7. Quando cada empresa constrói isso sozinha, os custos se duplicam milhares de vezes.

Uma plataforma espalha esses investimentos fixos por muitos clientes. O custo por cliente cai à medida que a adoção cresce, enquanto a qualidade pode subir porque o provedor justifica especialização mais profunda.

O ciclo de confiabilidade: especialização compõe uptime e segurança

Quando uma equipe de serviço roda o mesmo componente para muitos clientes, ela vê mais casos de borda, detecta padrões mais rápido e constrói automação melhor. Incidentes viram insumos: cada falha endurece o sistema, melhora playbooks e aperta guardrails.

Segurança beneficia-se de forma semelhante. Equipes dedicadas podem investir em modelagem de ameaças, patching contínuo e controles de conformidade que seriam difíceis para um time de produto sustentar sozinho.

Poder de precificação: uso + confiança + custos de troca (com cuidado)

Plataformas costumam obter poder de precificação por meio de preços baseados em uso: clientes pagam proporcionalmente ao valor consumido e podem começar pequeno. Com o tempo, a confiança torna-se um diferencial — confiabilidade e segurança fazem o serviço ser a “opção segura”.

Custos de troca também aumentam conforme integrações se aprofundam, mas a versão mais saudável é conquistada, não aprisionada: melhor desempenho, melhores ferramentas, cobrança clara e menos incidentes. Isso mantém clientes renovando mesmo quando existem alternativas. Para mais sobre como isso aparece em empacotamento e monetização, veja /pricing.

O padrão AWS: de primitivas a serviços gerenciados

A AWS não venceu oferecendo “servidores na internet”. Venceu ao tomar repetidamente um problema operacional difícil, fatiá-lo em blocos construtivos mais simples e então re-empacotar esses blocos em serviços onde a AWS roda o trabalho do dia 2 para você.

A escada repetível: primitiva → serviço → serviço gerenciado → plataforma

Pense nisso como uma escada de maturidade:

- Primitiva: Ingredientes brutos que você monta (VMs, discos, redes)

- Serviço: Uma API mais opinativa em torno de uma capacidade (armazenamento de objetos, balanceamento de carga)

- Serviço gerenciado: A AWS opera escalonamento, patching, backups e recuperação de falhas (bancos, filas)

- Plataforma: Um portfólio onde serviços se compõem de forma limpa, com identidade, faturamento, monitoramento e políticas compartilhadas

Cada passo remove decisões, manutenção e o “e se falhar às 3h da manhã?” do cliente.

Exemplos AWS (mapeamento conceitual)

A AWS aplicou o mesmo padrão em categorias centrais:

-

Compute: Comece com máquinas virtuais (EC2). Avance para compute mais alto nível onde deployment e escalonamento viram padrão (por exemplo, estilos gerenciados de contêiner/serverless). O cliente foca em código e intenção de capacidade, não no cuidado com hosts.

-

Armazenamento: De discos e sistemas de arquivos para armazenamento de objetos (S3). A abstração passa de “gerenciar volumes” para “put/get objetos”, enquanto durabilidade, replicação e escala viram problema da AWS.

-

Bancos de dados: De “instalar um banco em uma VM” para bancos gerenciados (RDS, DynamoDB). Backups, patching, réplicas de leitura e failover deixam de ser um runbook customizado e viram configuração.

-

Mensageria: De filas e workers feitos à mão para mensageria gerenciada (SQS/SNS). Semânticas de entrega, retries e tuning de throughput ficam padronizados para que equipes construam fluxos em vez de infraestrutura.

Por que abstrações reduzem carga cognitiva

Serviços gerenciados reduzem carga cognitiva de duas maneiras:

- Menos partes móveis para raciocinar. Seu diagrama de arquitetura encolhe de “instâncias + scripts + cron + alerting + backups” para “serviço + configurações”.

- Menos modos de falha que você precisa assumir. Você ainda projeta para resiliência, mas não é mais responsável pela mecânica de patching, clustering e recuperação rotineira.

O resultado é onboarding mais rápido, menos runbooks sob medida e operações mais consistentes entre equipes.

Lista de verificação (reuse isto no seu produto)

- O que os clientes estão construindo que é necessário mas não diferenciador?

- Você pode transformar runbooks recorrentes em uma API única e estável?

- Quais tarefas você pode tornar padrão (backups, escalonamento, upgrades) em vez de opcionais?

- As “arestas cortantes” foram movidas para trás de limites e guardrails sensatos?

- Várias equipes conseguem reutilizar sem conhecimento especialista?

- Isso se compõe com o resto do seu sistema (identidade, monitoramento, faturamento, políticas)?

Empacotando operações como um produto

Padronize seu front end

Gere a base de um app React sem recriar a mesma estrutura toda vez.

Uma forma útil de ler a AWS é: ela não só vende tecnologia, vende operação. O “produto” não é somente um endpoint de API — é tudo o que é necessário para rodar aquela capacidade de forma segura, previsível e em escala.

APIs vs self-service vs gestão total

Uma API te dá blocos de construção. Você pode provisionar recursos, mas ainda projeta guardrails, monitora falhas, lida com upgrades e responde “quem mudou o quê?”

Self-service adiciona uma camada que clientes podem usar sem abrir chamados: consoles, templates, defaults sensatos e provisionamento automatizado. O cliente ainda assume grande parte do trabalho do dia 2, mas é menos manual.

Gestão total é quando o provedor assume responsabilidades contínuas: patching, escalonamento, backups, failover e muitas classes de resposta a incidentes. Clientes focam em configurar o que querem, não como isso é mantido funcionando.

As features “chatas” que os clientes não podem viver sem

As capacidades em que as pessoas confiam diariamente raramente são chamativas:

- IAM e permissões: quem pode fazer o quê, e como o acesso é auditado

- Faturamento e visibilidade de custos: orçamentos, faturas, tags e alertas

- Cotas e limites de taxa: proteções que previnem acidentes — e definem expectativas claras

Isso não é missão secundária. Faz parte da promessa que os clientes compram.

Operações como feature de primeira classe

O que faz um serviço gerenciado parecer “real” é o pacote operacional ao seu redor: documentação clara, canais de suporte previsíveis e limites de serviço explícitos. Bons docs reduzem carga de suporte, mas mais importante, reduzem a ansiedade do cliente. Limites publicados e processos de quota transformam surpresas em restrições conhecidas.

Quando você empacota operações como produto, você não está só entregando features — você está entregando confiança.

Design organizacional que faz plataformas funcionarem

Uma plataforma tem sucesso ou fracassa menos por diagramas de arquitetura e mais por design organizacional. Se as equipes não tiverem clientes claros, incentivos e loops de feedback, a “plataforma” vira um backlog de opiniões.

Equipes internas como primeiros clientes (dogfooding)

A maneira mais rápida de manter uma plataforma honesta é fazer das equipes de produto internas os primeiros — e mais barulhentos — clientes. Isso significa:

- Times de plataforma entregam para equipes internas pelas mesmas interfaces e docs que usuários externos veriam.

- Adoção é conquistada (pela utilidade), não imposta (por política).

- Chamados de suporte, revisões de incidentes e decisões de roadmap tratam equipes internas como clientes reais, com SLAs claros.

Dogfooding força clareza: se suas próprias equipes evitam a plataforma, clientes externos também evitarão.

Modelos centralizados vs federados de plataforma

Dois padrões organizacionais aparecem com frequência:

Time central de plataforma: um time possui os blocos centrais (CI/CD, identidade, observabilidade, runtime, primitivas de dados). Ótimo para consistência e economias de escala, mas pode virar gargalo.

Modelo federado: um pequeno time central define padrões e primitivas compartilhadas, enquanto times de domínio possuem “fatias” da plataforma (por exemplo, plataforma de dados, plataforma de ML). Isso melhora velocidade e adequação ao domínio, mas exige governança forte para evitar fragmentação.

Métricas que importam (e armadilhas da plataforma)

Métricas úteis de plataforma são de resultado, não de atividade:

- Lead time para produção (quão rápido equipes conseguem deployar)

- Disponibilidade e taxa de incidentes dos serviços de plataforma

- Custo por workload (economia unitária, não gasto total)

Armadilhas comuns incluem incentivos desalinhados (plataforma medida por contagem de features, não adoção), over-design (construir para escala hipotética) e sucesso medido por imposição em vez de uso voluntário.

O flywheel composto por trás do crescimento de plataformas

Torne experimentos mais seguros

Use snapshots e rollback para testar alterações sem medo de quebrar sua base.

Plataformas crescem de forma diferente de produtos pontuais. A vantagem delas não é só “mais features” — é um loop de feedback onde cada novo cliente torna a plataforma mais fácil de rodar, mais fácil de melhorar e mais difícil de ignorar.

O flywheel em termos simples

Mais clientes → mais dados de uso no mundo real → padrões mais claros sobre o que quebra, o que é lento, o que confunde → defaults e automações melhores → um serviço melhor para todos → mais clientes.

A AWS se beneficiou disso porque serviços gerenciados transformam esforço operacional em capacidade compartilhada e repetível. Quando os mesmos problemas aparecem em milhares de equipes (monitoramento, patching, escalonamento, backups), o provedor pode consertá-los uma vez e distribuir a melhoria para todos os clientes.

Por que padronização acelera inovação

Padronização muitas vezes é enquadrada como “menos flexibilidade”, mas para plataformas é um multiplicador de velocidade. Quando infraestrutura e operações ficam consistentes — um conjunto de APIs, uma abordagem para identidade, uma forma de observar sistemas — construtores param de reinventar o básico.

Esse tempo recuperado vira inovação de nível superior: melhores experiências de produto, experimentos mais rápidos e novas capacidades sobre a plataforma (não ao lado dela). Padronização também reduz carga cognitiva para equipes: menos decisões, menos modos de falha, onboarding mais rápido.

A aposta de longo prazo: composição em escala

Pequenas melhorias se compõem quando aplicadas a milhões de requisições e milhares de clientes. Uma redução de 2% na taxa de incidentes, um algoritmo de autoscaling um pouco melhor ou uma configuração default mais clara não só ajuda uma empresa — eleva a linha de base da plataforma.

Como a remoção do trabalho pesado se traduz em entrega mais rápida

Remover trabalho operacional não diferenciador não só economiza horas — muda o comportamento das equipes. Quando o trabalho de “manter as luzes acesas” encolhe, roadmaps deixam de ser dominados por tarefas de manutenção (patching de servidores, rotacionar chaves, cuidar de filas) e começam a refletir apostas de produto: novas features, UX melhores, mais experimentos.

Efeitos de segunda ordem que se compõem

Menos esforço cria uma reação em cadeia:

- Onboarding fica mais fácil. Novos engenheiros conseguem entregar em dias em vez de aprender um labirinto de runbooks.

- Incidentes caem — e ficam mais simples. Menos sistemas sob medida significa menos modos de falha estranhos e menos escaladas às 3 da manhã.

- Releases viram rotina. Equipes conseguem liberar mais frequentemente porque deployment, rollback e monitoramento são padronizados.

Velocidade vs. thrash: entregar vs. apagar incêndios

Velocidade real é um ritmo constante de pequenas entregas previsíveis. Thrash é movimento sem progresso: correções urgentes, trabalho de infra emergencial e mudanças “rápidas” que acumulam dívida.

Remover trabalho pesado reduz thrash porque elimina categorias inteiras de trabalho que interrompem repetidamente a entrega planejada. Uma equipe que antes gastava 40% do tempo reagindo pode redirecionar essa capacidade para features — e mantê-la lá.

Exemplos práticos em SaaS

Autenticação: Em vez de manter armazenamento de senhas, fluxos de MFA, gerenciamento de sessões e auditorias de conformidade internamente, use um provedor de identidade gerenciado. Resultado: menos incidentes de segurança, rollouts de SSO mais rápidos e menos tempo gasto atualizando bibliotecas de auth.

Pagamentos: Externalize processamento de pagamentos, handling de impostos/VAT e checagens antifraude para um provedor especializado. Resultado: expansão regional mais rápida, menos surpresas com chargebacks e menos tempo de engenharia preso a edge cases.

Observabilidade: Padronize em uma pilha gerenciada de logging/métricas/tracing em vez de dashboards caseiros. Resultado: debug mais rápido, propriedade mais clara durante incidentes e confiança para deployar com mais frequência.

O padrão é simples: quando operações viram um produto que você consome, o tempo de engenharia volta a construir o que os clientes realmente pagam.

Compensações: lock-in, controle e custo

Remover trabalho operacional não diferenciador não é almoço grátis. Serviços gerenciados no estilo AWS frequentemente trocam esforço diário por acoplamento mais estreito, menos ajustes finos e contas que podem surpreender.

As três grandes compensações

Lock-in de fornecedor. Quanto mais você depende de APIs proprietárias (filas, políticas IAM, engines de workflow), mais difícil fica mover-se depois. Lock-in nem sempre é ruim — pode ser o preço da velocidade — mas deve ser uma escolha deliberada.

Perda de controle. Serviços gerenciados reduzem sua capacidade de ajustar desempenho, escolher versões exatas ou debugar problemas de infraestrutura profunda. Em um outage, você pode ficar esperando o cronograma do provedor.

Surpresas de custo. Precificação por consumo recompensa uso eficiente, mas pode punir crescimento rápido, arquiteturas “verbose” e defaults de “set-and-forget”. Equipes frequentemente descobrem custos após o deploy.

Quando construir é racional

Construir (ou self-host) pode ser a escolha certa quando você tem requisitos únicos (latência customizada, modelos de dados especiais), escala massiva onde a economia unitária muda, ou conformidade/residência de dados que serviços gerenciados não conseguem satisfazer.

Guardrails que mantêm velocidade sem aprisionamento

Projete fronteiras de serviço: encapsule chamadas a provedores atrás da sua própria interface para poder trocar implementações.

Mantenha um plano de portabilidade: documente o que seria mais difícil migrar e tenha um “mínimo viável de saída” (mesmo que lento).

Adote monitoramento de custo cedo: orçamentos, alertas, tagging e revisões periódicas dos maiores gastos.

Matriz de decisão copiável

| Pergunta | Preferir Gerenciado | Preferir Construir/Self-host |

|---|---|---|

| Isso é um diferenciador para clientes? | Não | Sim |

| Podemos tolerar limites/opiniões do provedor? | Sim | Não |

| Precisamos de conformidade/controle especial? | Não | Sim |

| Velocidade para o mercado é prioridade? | Sim | Não |

| O custo é previsível no nosso padrão de uso? | Sim | Não |

Um framework prático para aplicar o padrão em qualquer negócio de software

Lance a primeira versão mais rápido

Crie um projeto web, backend ou mobile a partir de um prompt claro e itere rapidamente.

Você não precisa rodar uma nuvem hiperescalável para usar o playbook “remover trabalho operacional não diferenciador”. Qualquer equipe de software — SaaS, plataformas internas, produtos de dados, até ferramentas com muito suporte — tem trabalho recorrente caro, sujeito a erro e que não é verdadeiro diferencial.

Um método passo a passo (do toil ao produto)

-

Liste o trabalho recorrente: Anote tarefas repetidas que as pessoas fazem para manter as coisas rodando — deployments manuais, triagem de tickets, backfills de dados, pedidos de acesso, handoffs de incidentes, scripts frágeis, checklists de “conhecimento tribal”.

-

Quantifique: Para cada item, estime frequência, tempo gasto e custo de falha. Uma pontuação simples funciona: horas/semana + gravidade dos erros + número de equipes afetadas. Isso transforma dor vaga em backlog ranqueado.

-

Padronize o fluxo: Antes de automatizar, defina “a melhor maneira”. Crie um template, golden path ou um conjunto mínimo de opções suportadas. Reduzir variação frequentemente é o maior ganho.

-

Automatize e empacote: Construa ferramentas self-serve (APIs, UI, runbooks-as-code) e trate isso como um produto: propriedade clara, versionamento, docs e modelo de suporte.

Uma variante moderna dessa abordagem são plataformas de “vibe-coding” que transformam scaffolding repetitivo e configuração day-1 em um fluxo guiado. Por exemplo, Koder.ai permite que equipes criem apps web, backend e mobile a partir de uma interface por chat (React na web, Go + PostgreSQL no backend, Flutter no mobile) e então exportem código-fonte ou façam deploy/hosting — útil quando seu gargalo é sair da ideia para uma baseline confiável sem refazer sempre o mesmo wiring do projeto.

Comece com um fluxo (e prove o loop)

Escolha um único fluxo de alta frequência onde o sucesso seja mensurável — deploys, pipelines de dados ou ferramentas de suporte são bons candidatos. Mire num ganho rápido: menos passos, menos páginas, menos aprovações, recuperação mais rápida.

Sequenciamento: o que fazer primeiro

- Confiabilidade primeiro: torne o processo consistente e seguro.

- Features depois: adicione capacidades que os usuários realmente pedem.

- Otimização por último: ajuste custo e performance depois que o uso estabilizar.

Principais conclusões e próximos passos

A lição reutilizável da estratégia da AWS de Andy Jassy é simples: você vence fazendo o trabalho comum desaparecer. Quando clientes (ou equipes internas) param de gastar tempo em setup, patching, escalonamento e babysitting de incidentes, eles passam a gastar tempo no que realmente os diferencia — features, experiências e novas apostas.

A conclusão para manter em mente

“Trabalho operacional não diferenciador” não é só “trabalho difícil”. É trabalho que muitas equipes repetem, que deve ser feito para operar com confiabilidade, mas que raramente rende crédito único no mercado. Transformar esse trabalho em produto — especialmente um serviço gerenciado — gera valor em dobro: você reduz o custo de rodar software e aumenta a velocidade de entrega.

Escolha uma coisa para remover neste trimestre

Não comece por uma reescrita grandiosa de plataforma. Comece com uma dor recorrente que aparece em tickets, pages de on-call ou extrapolação de sprint. Bons candidatos:

- Setup de ambientes que varia por equipe

- Releases e rollbacks manuais

- Revisões de segurança repetitivas pelos mesmos padrões

- Defaults de escalabilidade/monitoramento que todos redescobrem do jeito difícil

Escolha um, defina “pronto” em linguagem simples (ex.: “um novo serviço pode deployar com segurança em 15 minutos”) e entregue a menor versão que elimina o trabalho repetido.

Leituras internas relacionadas

Se quiser mais padrões práticos sobre pensamento de plataforma e decisões build-vs-buy, navegue por /blog. Se está avaliando o que padronizar versus o que oferecer como capacidade interna (ou paga), /pricing pode ajudar a enquadrar empacotamento e níveis.

Próximo passo: um backlog simples de plataforma

Nesta semana, faça três coisas: audite onde o tempo se perde em trabalho operacional repetido, priorize por frequência × dor × risco, e construa um backlog de plataforma simples com 3–5 itens que você possa entregar incrementalmente.