Por que versões iniciais imperfeitas são tão comuns

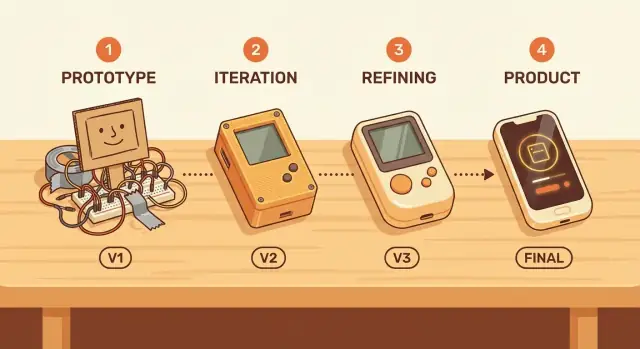

Uma “primeira versão imperfeita” não é o mesmo que baixa qualidade por descuido. É um produto que funciona o bastante para ser testado por pessoas reais, mas que ainda tem recursos faltantes, fluxos atrapalhados e muito espaço para melhorar. A diferença está na intenção: imperfeita significa focada e limitada; descuidada significa não confiável e insegura.

A perfeição é rara no começo porque a maior parte do que “perfeito” significa é desconhecida até que os usuários interajam com o produto. Equipes podem chutar quais recursos importam, qual linguagem faz sentido ou onde as pessoas vão travar — mas palpites frequentemente estão errados. Mesmo construtores experientes descobrem que o problema real que os clientes querem resolver é ligeiramente diferente do imaginado.

Imperfeito não quer dizer “lançar lixo”

O objetivo de um início imperfeito é aprender, não abaixar o padrão. Uma boa primeira versão ainda respeita o usuário:

- Resolve um problema claro de ponta a ponta.

- É estável o bastante para que falhas sejam exceção, não regra.

- Define expectativas honestas sobre o que está incluído (e o que não está).

Quando equipes adotam uma mentalidade de aprender primeiro, elas deixam de tratar o primeiro lançamento como prova final e começam a tratá-lo como um teste de campo. Essa mudança facilita estreitar o escopo, lançar mais cedo e melhorar com base em evidências em vez de opiniões.

Nas próximas seções você verá exemplos práticos — como lançamentos no estilo MVP e programas para adotantes iniciais — e guardrails para evitar erros comuns (por exemplo: como traçar uma linha clara entre “imperfeito” e “inutilizável”, e como capturar feedback sem se afundar em pedidos personalizados infinitos).

A incerteza é maior no começo

No início da vida de um produto, a confiança frequentemente é ilusão. Equipes podem escrever especificações detalhadas e roadmaps, mas as maiores perguntas não são respondidas em uma sala de reunião.

O que você não pode realmente saber antecipadamente

Antes de usuários reais tocarem no seu produto, você está chutando sobre:

- Quem são os usuários mais motivados de fato (e quais descrições de “cliente ideal” são desejo).

- Fluxos reais de trabalho: como as pessoas fazem o trabalho hoje, o que se recusam a mudar e o que aceitam delegar ao software.

- Preço e disposição a pagar: o que soa justo em entrevistas vs. o que tira o cartão de crédito.

- Canais de aquisição: onde a atenção é acessível, quais mensagens ressoam e o que é ignorado.

Você pode pesquisar tudo isso, mas não pode confirmar sem uso real.

Por que planos quebram sem dados de uso reais

O planejamento tradicional assume que você pode prever necessidades, priorizar recursos e então construir em direção a um destino conhecido. Produtos em estágio inicial estão cheios de incógnitas, então o plano é construído sobre suposições. Quando essas suposições estão erradas, você não apenas perde um prazo — você constrói a coisa errada eficientemente.

É por isso que os lançamentos iniciais importam: eles transformam debates em evidência. Dados de uso, tickets de suporte, churn, taxas de ativação e até “experimentamos e paramos” são sinais que clarificam o que é real.

Recursos “bacanas de ter” frequentemente escondem suposições

Uma lista longa de melhorias pode parecer centrada no cliente, mas muitas vezes contém apostas enterradas:

- “Usuários vão querer dashboards” supõe que checarão a ferramenta com frequência.

- “Papéis e permissões de time” supõe adoção multiusuário desde o dia um.

- “Integrações com tudo” supõe que custo de troca é seu maior bloqueador.

Construir isso cedo é comprometer-se com suposições antes de validadas.

Aprendizado validado: progresso confiável

Aprendizado validado significa que o objetivo de uma versão inicial não é parecer final — é reduzir a incerteza. Uma primeira versão imperfeita é bem-sucedida se ensinar algo mensurável sobre comportamento do usuário, valor e disposição de continuar.

Esse aprendizado vira base para a próxima iteração — uma baseada em evidência, não em esperança.

Velocidade de aprendizado vence velocidade de construção

Equipes frequentemente tratam progresso como “mais recursos entregues”. Mas cedo, o objetivo não é construir rápido — é aprender rápido. Uma versão inicial que chega a usuários reais transforma suposições em evidência.

Ciclos curtos de feedback mudam tudo

Quando você lança cedo, os ciclos de feedback encurtam de meses para dias. Em vez de debater o que os usuários podem fazer, você vê o que eles realmente fazem.

Um padrão comum:

- Meses de suposições: escrevendo longos documentos de requisitos, aperfeiçoando designs, construindo casos de borda para problemas que ninguém confirmou.

- Dias de feedback real: lançando uma versão pequena, observando onde as pessoas travam e ajustando com clareza.

Essa velocidade se compõe. Todo ciclo curto elimina incerteza e previne “construir direitinho a coisa errada”.

Aprendizado que dá para medir

“Aprender” não é um sentimento vago. Mesmo produtos simples podem rastrear sinais que mostram se a ideia funciona:

- Ativação: as pessoas chegam ao primeiro momento significativo (ex.: criar um projeto, convidar um colega, completar uma tarefa)?

- Retenção: voltam na semana seguinte sem serem perseguidas?

- Tickets e perguntas de suporte: o que confunde usuários repetidamente? O que pedem com suas próprias palavras?

Essas métricas não só validam. Elas apontam para a próxima melhoria com mais confiança do que opiniões internas.

Rápido, mas nunca imprudente

Velocidade não quer dizer ignorar segurança ou confiança. Lançamentos iniciais ainda devem proteger usuários de danos:

- Seja claro sobre o que o produto faz e o que não faz.

- Evite recursos que exponham dados sensíveis ou criem risco financeiro/legal.

- Adicione guardrails básicos (permissões, backups, desfazer) antes dos “growth hacks”.

Construa para aprender primeiro — mantendo os usuários seguros — e sua primeira versão imperfeita vira um passo proposital, não uma aposta.

MVPs: lançamentos pequenos que testam a suposição mais arriscada

Um MVP (produto mínimo viável) é a menor versão do seu produto que consegue testar se uma promessa chave é valiosa para pessoas reais. Não é “a primeira versão de tudo”. É o caminho mais curto para responder uma pergunta de alto risco, como: Alguém usará isso? Pagará por isso? Mudarão sua rotina por isso?

O que um MVP é — e o que não é

Um MVP é um experimento focado que você pode lançar, aprender e melhorar.

Um MVP não é:

- Um demo brilhoso que evita uso real

- Um lançamento “meio quebrado” que frustra pessoas

- Um monte de recursos que atrasa o aprendizado

O objetivo é viável: a experiência deve funcionar de ponta a ponta para um conjunto estreito de usuários, mesmo que o escopo seja pequeno.

Produtos diferentes podem testar o mesmo valor em formas distintas:

- Concierge MVP: você entrega o valor manualmente (high-touch) a poucos usuários. Ótimo para entender necessidades e disposição a pagar.

- “Manual nos bastidores” (Wizard-of-Oz): usuários veem uma interface simples, mas o trabalho é feito manualmente ou com ferramentas improvisadas internamente. Ótimo para validar demanda antes de automatizar.

- Produto com recursos limitados: você constrói apenas o fluxo central que prova o benefício principal, deixando intencionalmente de fora os “agradáveis de ter”. Ótimo quando a interação em si precisa de software.

Comece pela suposição mais arriscada

O escopo do MVP deve casar com sua maior incerteza. Se o risco é demanda, priorize testar uso real e sinais de pagamento. Se o risco é resultado, foque em provar que você pode entregar resultados de forma confiável — mesmo que o processo seja manual.

Uma maneira prática de apoiar essa abordagem é usar um fluxo de prototipagem que minimize o custo de implementação. Por exemplo, uma plataforma de prototipagem por chat como Koder.ai permite prototipar web, backend ou apps mobile via chat, exportar código-fonte e fazer deploy — útil quando você quer um MVP real de ponta a ponta sem se comprometer com um ciclo longo de engenharia antes de validar a promessa central.

A diferença entre “imperfeito” e “inutilizável”

Uma primeira versão imperfeita ainda pode ser um ótimo começo — se ela ajuda uma pessoa específica a realizar um trabalho específico. “Bom o bastante” não é padrão universal; depende do job-to-be-done do usuário. A jornada de protótipo para produto funciona melhor quando você define esse trabalho claramente (por exemplo: “enviar uma fatura em menos de dois minutos” ou “compartilhar um arquivo com segurança por um link”).

Uma barra de qualidade simples: confiável para a tarefa central

Um início imperfeito pode ser pequeno e meio atrapalhado. Não pode ser, porém, instável na única coisa que promete.

Uma barra prática de qualidade mínima para um MVP:

- A tarefa principal funciona de ponta a ponta, sempre, sem correções manuais.

- Erros são compreensíveis (sem falhas misteriosas).

- Usuários podem se recuperar (desfazer, tentar de novo ou receber passos claros a seguir).

Se o fluxo central quebra, adotantes iniciais não conseguem dar feedback útil — porque nunca alcançam o momento em que o produto entrega valor.

Compensações: menos recursos, mais clareza

“Lançar rápido” costuma falhar quando equipes cortam as coisas erradas. Cortar recursos extras é ok; cortar clareza não é. Um produto mínimo viável deve preferir:

- Menos opções, mas padrões mais claros

- Onboarding simples, não uma lista longa de recursos

- Um caso de uso bem definido, não cinco parcialmente suportados

Isso torna a iteração mais rápida porque o feedback é sobre o que importa, não sobre confusão.

Inegociáveis: acessibilidade e desempenho básico

Mesmo em um lançamento inicial, acessibilidade e desempenho básico não são “agradáveis de ter”. Se o texto não pode ser lido, ações não podem ser feitas via teclado, ou páginas demoram demais para carregar, você não está testando ajuste produto-mercado — está testando a paciência das pessoas. A melhoria contínua começa com uma base que respeita o tempo e as necessidades dos usuários.

Encontrar ajuste produto-mercado exige uso real

Teste uma suposição principal

Transforme uma promessa central em um app web ou backend funcional para entregar aos usuários.

A definição mais prática de product-market fit (PMF): os usuários realmente sentiriam falta do seu produto se ele desaparecesse. Não “gostam da ideia”, não “clicaram no anúncio”, mas dependência real — algo que viraram rotina.

Por que você não pode prever PMF de dentro

Equipes têm viés para suas próprias suposições. Você conhece o roadmap, entende os casos de borda e imagina todo o valor futuro. Mas clientes não compram sua intenção — vivenciam o que existe hoje.

Opiniões internas também sofrem do “tamanho da amostra = pessoas como nós”. Colegas, amigos e testadores iniciais muitas vezes compartilham seu contexto. Uso real traz as restrições bagunçadas que você não consegue simular: pressão de tempo, alternativas concorrentes e zero paciência para fluxos confusos.

Procure comportamentos que sugerem que o produto resolve um problema recorrente:

- Uso repetido: pessoas voltam sem lembretes e o uso se mantém depois que a novidade passa.

- Referências: usuários recomendam sem serem solicitados porque isso os faz parecer úteis.

- Disposição a pagar: não só dizer “eu pagaria”, mas realmente pagar, fazer upgrade ou aceitar uma troca significativa.

Não leia demais métricas de vaidade

Números iniciais podem enganar. Cuidado com:

- Visualizações de página e inscrições que não viram ativação

- Picos de trials gratuitos movidos por curiosidade ou promoções

- Engajamento social que mostra interesse no tema, não no produto

Uma primeira versão imperfeita é valiosa porque te leva a esses cheques de realidade rapidamente. PMF não é pauta de reunião — é um padrão que você observa quando usuários reais colocam o produto para funcionar.

Adotantes iniciais ajudam a moldar o produto

Adotantes iniciais não toleram bordas ásperas porque gostam de glitches — eles o fazem porque o benefício é incomumente alto para eles. São pessoas com um problema frequente e agudo, ativamente buscando uma solução. Se sua versão imperfeita remove uma dor grande (ainda que imperfeitamente), elas trocam polimento por progresso.

Por que adotantes iniciais aceitam imperfeições

Adotantes iniciais frequentemente:

- Pagam tempo ou dinheiro por alternativas atrapalhadas (planilhas, checagens manuais, copiar/colar)

- Sentem o problema mais intensamente que usuários médios

- Estão dispostos a investir esforço se isso trouxer alívio mais cedo

Quando o “antes” é doloroso o suficiente, um “depois” meio pronto ainda parece vitória.

Como achar os adotantes certos

Procure onde a dor já é discutida: grupos de Slack/Discord de nicho, subreddits, fóruns da indústria e comunidades profissionais. Outro sinal confiável: pessoas que montaram suas próprias gambiarras (templates, scripts, boards no Notion) — elas estão dizendo que precisam de uma ferramenta melhor.

Considere também nichos adjacentes — segmentos menores com o mesmo job-to-be-done, mas menos requisitos. Podem ser mais fáceis de atender primeiro.

Defina expectativas abertamente

Seja explícito sobre o que está incluído e o que não está: o que o produto faz hoje, o que é experimental, o que falta e que tipos de problemas os usuários podem enfrentar. Expectativas claras previnem decepção e aumentam confiança.

Crie canais rápidos de feedback

Torne o feedback simples e imediato: um prompt curto no app, um e-mail com reply-to e algumas chamadas agendadas com usuários ativos. Pergunte por detalhes: o que tentaram fazer, onde travaram e o que fizeram em vez disso. Esse detalhe transforma uso inicial em um roadmap focado.

Restrições podem levar a decisões melhores

Evite lock-in de longo prazo

Comece rápido no Koder.ai, depois exporte o código-fonte quando estiver pronto para assumir o repositório.

Restrições têm má reputação, mas frequentemente forçam o pensamento mais claro. Quando tempo, orçamento ou equipe são limitados, você não pode “resolver” incerteza empilhando recursos. Tem que decidir o que importa, definir sucesso e lançar algo que prove (ou desprove) o valor central.

Restrições criam simplicidade

Uma restrição apertada age como filtro: se um recurso não ajuda a validar a promessa principal, espera. É assim que você acaba com soluções simples e claras — porque o produto é construído ao redor de um trabalho que faz bem, não dez trabalhos mal feitos.

Isso é especialmente útil cedo, quando você ainda chuta o que os usuários realmente querem. Quanto mais você restringe o escopo, mais fácil conectar um resultado a uma mudança.

Adicionar “agradáveis de ter” pode mascarar o problema real: a proposta de valor não está afiada ainda. Se usuários não se empolgam com a versão mais simples, mais recursos raramente consertam — só adicionam ruído. Um produto cheio de recursos pode parecer ocupado e ainda falhar em responder a pergunta básica: “Por que eu deveria usar isso?”

Exemplos práticos de validação guiada por restrição

Algumas formas favoráveis a restrições para testar a ideia mais arriscada:

- Teste de landing page: escreva uma promessa clara e um call to action (lista de espera, pedido de demo, pré-venda). Se as pessoas não convertem, você aprendeu algo sem construir o produto inteiro.

- Protótipo em vez de plataforma: um protótipo clicável pode validar o fluxo antes de investir em engenharia.

- Ferramenta de recurso único: muitos produtos começaram como uma utilidade afiada (um relatório, uma automação, um botão) que as pessoas usavam repetidamente.

Dizer “não” protege o foco

Trate “não” como uma habilidade de produto. Diga não a funcionalidades que não suportam a hipótese atual, não a segmentos extras antes de um funcionar e não ao polimento que não muda decisões. Restrições tornam esses “nãos” mais fáceis — e mantêm seu produto inicial honesto sobre o que entrega.

Evitar a armadilha de construir demais

Construir demais ocorre quando uma equipe trata o primeiro lançamento como um veredito final. Em vez de testar a ideia central, o produto vira um amontoado de “agradáveis de ter” que parecem mais seguros do que um experimento claro de sim/não.

Por que equipes constroem demais

O medo é o maior motor: medo de feedback negativo, medo de parecer amador, medo de que um concorrente apareça mais polido.

Comparação alimenta isso. Se você se compara a produtos maduros, é fácil copiar o conjunto de recursos sem perceber que eles conquistaram esses recursos ao longo de anos de uso real.

Política interna também empurra. Recursos extras viram forma de satisfazer stakeholders (“adicione isso para o time de Vendas”, “adicione aquilo para o Suporte não reclamar”), mesmo se nada provar que o produto será desejado.

O custo oculto: custo afundado que dificulta mudar

Quanto mais você constrói, mais difícil fica mudar de direção. Esse é o efeito do custo afundado: quando tempo, dinheiro e orgulho são investidos, equipes defendem decisões que deveriam ser revisitadas.

Versões superconstruídas criam compromissos caros — código complexo, onboarding mais pesado, mais casos de borda, mais documentação, mais reuniões para coordenar. Então mesmo melhorias óbvias parecem arriscadas porque ameaçam todo esse investimento.

Como versões imperfeitas reduzem esforço desperdiçado

Uma primeira versão imperfeita limita suas opções de um jeito bom. Mantendo escopo pequeno, você aprende mais cedo se a ideia vale e evita polir recursos que não importarão.

Uma regra simples ajuda:

Construa a menor coisa que responda uma pergunta.

Exemplos de “uma pergunta”:

- As pessoas completarão essa tarefa se tirarmos a ajuda manual?

- Usuários preferem a opção A ou B quando precisam escolher?

- Esse problema é urgente o suficiente para alguém voltar amanhã?

Se seu “MVP” não responde claramente uma pergunta, provavelmente não é mínimo — é só sobreconstruído cedo.

Riscos de lançar cedo — e como gerenciá-los

Lançar cedo é útil, mas não é grátis. Uma primeira versão imperfeita pode causar danos reais se você ignorar riscos.

Os riscos mais comuns

Os maiores riscos geralmente caem em quatro categorias:

- Confiança e credibilidade: uma experiência inicial cheia de bugs pode fazer as pessoas assumirem que o produto é descuidado ou instável.

- Segurança e privacidade: código inicial costuma ter lacunas — especialmente em autenticação, permissões e manuseio de dados.

- Perda de dados: se usuários investem tempo entrando informação e ela some, talvez não voltem.

- Primeira impressão ruim: onboarding confuso ou valor pouco claro pode levar a churn do tipo “não entendi”.

Mitigações práticas que mantêm você em movimento

Você pode reduzir danos sem desacelerar até parar:

- Rotule claramente: “Beta” ou “Preview” define expectativas. Diga o que está pronto e o que não está.

- Limite acesso: comece com um grupo pequeno (só por convite, lista de espera ou um segmento específico) para conter erros.

- Backups e desfazer: mesmo salvaguardas simples — opções de exportar, histórico de versões ou backups noturnos — protegem usuários do pior cenário.

- Caminhos de suporte claros: um e-mail/ chat visível e tempos de resposta rápidos podem resgatar momentos ruins e construir boa vontade.

Se você usa uma plataforma para lançar rápido, procure recursos de segurança que suportem iteração inicial. Por exemplo, Koder.ai inclui snapshots e rollback (para recuperar de um mau lançamento) e suporta deploy/hosting — útil quando você quer ir rápido sem transformar cada mudança em um evento de alto risco.

Rollouts graduais e feature flags (em termos simples)

Em vez de liberar para todos de uma vez, faça um staged rollout: 5% dos usuários primeiro, depois 25%, depois 100% conforme ganha confiança.

Uma feature flag é um interruptor que permite ligar/desligar um recurso sem redeployar tudo. Se algo quebrar, você desliga e mantém o resto do produto funcionando.

Quando você não deve lançar cedo

Não teste em produção quando as apostas são altas: recursos relacionados à segurança, requisitos legais/compliance, pagamentos ou dados pessoais sensíveis, ou qualquer coisa que precise de confiabilidade crítica (ex.: médica, emergência, finanças centrais). Nesses casos, valide com protótipos, testes internos e pilotos controlados antes do uso público.

Lance um beta real

Tenha uma versão utilizável hospedada rapidamente para que os primeiros usuários possam testar de verdade.

Lançar uma primeira versão imperfeita só vale se você transformar reações reais em decisões melhores. O objetivo não é “mais feedback” — é um ciclo de aprendizado constante que torna o produto mais claro, rápido e fácil de usar.

O que medir (para não chutar)

Comece com alguns sinais que reflitam se as pessoas estão obtendo valor de fato:

- Ativação: que porcentagem atinge o “aha” (ex.: completa um primeiro projeto, convida um colega, publica algo)?

- Tempo-para-valor: quanto tempo leva para obter o primeiro resultado?

- Retenção: quem volta depois de 1 dia/1 semana/1 mês?

- Motivos de churn: o porquê por trás de cancelamentos ou quedas (preço, recurso faltante, confusão, mau encaixe)

Essas métricas ajudam a separar “curiosidade” de “sucesso”.

Colete feedback qualitativo que explique os números

Números dizem o que aconteceu. Feedback qualitativo diz por que.

Use uma mistura de:

- Entrevistas curtas com novos usuários (15 minutos já basta)

- Pesquisas leves após momentos-chave (“O que foi confuso?” “O que quase te parou?”)

- Logs de suporte e transcrições de chat (frequentemente o feedback mais honesto)

Capture frases exatas que os usuários usam. Essas palavras são combustível para um onboarding melhor, botões mais claros e páginas de preço mais simples.

Não faça uma lista de tarefas com todo pedido. Agrupe input em temas, depois priorize por impacto (quanto melhora ativação/retenção) e esforço (dificuldade de entrega). Uma pequena correção que elimina um ponto grande de confusão frequentemente vence um recurso grande.

Ligue o aprendizado a um ritmo regular de lançamentos — atualizações semanais ou quinzenais — para que usuários vejam progresso e você continue reduzindo incerteza a cada iteração.

Um framework prático para começar imperfeito e ter sucesso

Uma primeira versão imperfeita funciona quando é intencional: focada em provar (ou refutar) uma aposta chave, enquanto é confiável o suficiente para que pessoas reais tentem usar.

Etapa 1: Escolha uma promessa central

Escreva uma frase que explique o trabalho que seu produto fará para um usuário.

Exemplos:

- “Ajudar freelancers a enviar uma fatura em menos de 2 minutos.”

- “Permitir que times vejam as vendas de ontem em uma tela.”

Se seu MVP não consegue cumprir essa promessa, não está pronto — não importa o quão polida esteja a interface.

Etapa 2: Defina uma barra de qualidade clara (imperfeito, não inutilizável)

Decida o que precisa ser verdade para os usuários confiarem na experiência.

Checklist:

- Promessa central: qual é o único resultado que você garante?

- Barra de qualidade: o que faria isso parecer quebrado ou arriscado (totais errados, perda de dados, checkout confuso, etc.)?

- Métricas de sucesso: quais números dirão que está funcionando (taxa de ativação, uso repetido, tempo-para-valor, retenção após 7 dias)?

Etapa 3: Defina o menor teste que te ensine algo

Reduza o escopo até poder lançar rápido sem enfraquecer o teste. Uma boa regra: corte recursos que não mudam a decisão que você tomará após o lançamento.

Pergunte:

- Qual é a suposição mais arriscada?

- Qual a forma mais rápida de validá-la com uso real?

Se sua limitação é velocidade de implementação, considere uma cadeia de ferramentas que encurte o caminho ideia → software funcionando. Por exemplo, Koder.ai pode gerar um app React, um backend Go + PostgreSQL, ou um app Flutter a partir de uma especificação por chat, e depois permitir exportar o código quando você estiver pronto para ter o repositório — útil para chegar a um teste com usuários reais mais rápido.

Etapa 4: Rode um ciclo curto de feedback

Lance para um grupo pequeno e específico, depois recolha feedback em dois canais:

- Comportamento: o que eles realmente fazem (quedas, repetições, tempo-para-valor)

- Conversa: chamadas de 10–15 minutos ou pesquisas curtas que foquem no resultado, não em opiniões

Sugestão de cronograma (para um plano de artigo ~3000 palavras)

- Semana 1: escolha a promessa central + barra de qualidade, reúna 3–5 user stories

- Semana 2: construa só o que é necessário para entregar a promessa uma vez

- Semana 3: libere para usuários iniciais, meça, faça entrevistas

- Semana 4: aperfeiçoe a experiência em torno do que está sendo usado; remova o que não está

Chamada à ação

Dedique cinco minutos hoje: escreva sua promessa central, liste sua barra de qualidade e circule a suposição mais arriscada. Depois corte o escopo do seu MVP até que ele possa testar essa suposição nas próximas 2–3 semanas.

Se quiser mais templates e exemplos, navegue por posts relacionados em /blog.