12 de jun. de 2025·8 min

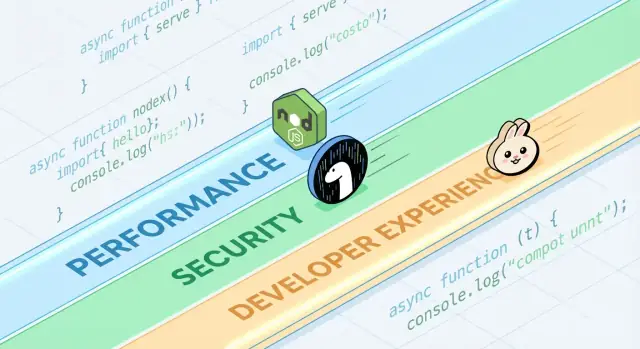

Por que os runtimes JavaScript competem em Desempenho, Segurança e DX

Entenda por que Node.js, Deno e Bun competem em desempenho, segurança e experiência do desenvolvedor — e como avaliar trade-offs para seu próximo projeto.

O que são runtimes JavaScript e por que importam

JavaScript é a linguagem. Um runtime JavaScript é o ambiente que torna a linguagem útil fora do navegador: ele incorpora um motor JavaScript (como V8) e o envolve com as funcionalidades do sistema que aplicações reais precisam — acesso a arquivos, rede, timers, gerenciamento de processos e APIs para criptografia, streams e mais.

Se o motor é o “cérebro” que entende JavaScript, o runtime é todo o “corpo” que consegue conversar com o sistema operacional e a internet.

Onde os runtimes aparecem

Runtimes modernos não servem apenas a servidores web. Eles alimentam:

- Servidores e APIs (aplicações backend tradicionais)

- Ferramentas de linha de comando (formatadores, ferramentas de build, scripts de automação)

- Funções edge (código rodando perto dos usuários, frequentemente com limites mais rígidos)

- Aplicativos desktop (muitas vezes via frameworks que empacotam um runtime)

A mesma linguagem pode rodar em todos esses lugares, mas cada ambiente tem restrições diferentes — tempo de inicialização, limites de memória, barreiras de segurança e APIs disponíveis.

Por que existem múltiplos runtimes (e por que mudam)

Runtimes evoluem porque desenvolvedores querem trade-offs diferentes. Alguns priorizam máxima compatibilidade com o ecossistema Node.js existente. Outros visam padrões de segurança mais rígidos por padrão, melhor ergonomia para TypeScript ou inicializações a frio mais rápidas para ferramentas.

Mesmo quando dois runtimes compartilham o mesmo motor, eles podem diferir dramaticamente em:

- APIs embutidas e suporte a standards

- Abordagem de gerenciamento de pacotes

- Modelo de permissões e sandboxing

- Experiência de tooling (testes, formatação, bundling)

O que “competir” realmente significa

Competição não é só sobre velocidade. Runtimes competem por adoção (comunidade e atenção), compatibilidade (o quanto código existente “simplesmente funciona”) e confiança (postura de segurança, estabilidade, manutenção a longo prazo). Esses fatores determinam se um runtime vira escolha padrão — ou uma ferramenta de nicho que você usa só em projetos específicos.

Um rápido tour pelos runtimes populares

Quando as pessoas dizem “runtime JavaScript”, geralmente querem dizer “o ambiente que roda JS fora (ou dentro) do navegador, além das APIs que você usa para realmente construir coisas.” O runtime que você escolhe molda como você lê arquivos, inicia servidores, instala pacotes, lida com permissões e depura problemas em produção.

Exemplos comuns que você vai ouvir falar

Node.js é o padrão de longa data para JavaScript no servidor. Tem o ecossistema mais amplo, tooling maduro e grande momentum da comunidade.

Deno foi projetado com padrões modernos: suporte TypeScript de primeira classe, postura de segurança mais forte por padrão e uma abordagem de biblioteca padrão mais “baterias incluídas”.

Bun foca muito em velocidade e conveniência do desenvolvedor, empacotando um runtime rápido com uma toolchain integrada (como instalação de pacotes e testes) para reduzir trabalho de setup.

Runtimes de navegador (Chrome, Firefox, Safari) continuam sendo os runtimes JS mais comuns no geral. Eles são otimizados para UI e trazem APIs Web como DOM, fetch e storage — mas não expõem acesso direto ao sistema de arquivos como runtimes de servidor.

O que é comum entre runtimes

A maioria dos runtimes combina um motor JavaScript (frequentemente V8) com um event loop e um conjunto de APIs para rede, timers, streams e mais. O motor executa o código; o event loop coordena trabalho assíncrono; as APIs são o que você realmente chama no dia a dia.

O que difere (e por que importa todo dia)

Diferenças aparecem em funcionalidades embutidas (como suporte nativo a TypeScript), tooling padrão (formatter, linter, test runner), compatibilidade com as APIs do Node e modelos de segurança (por exemplo, se acesso a arquivos/rede é irrestrito ou baseado em permissões). Por isso a “escolha do runtime” não é abstrata — ela afeta quão rápido você inicia um projeto, quão seguro é rodar scripts e quão doloroso (ou suave) é deployment e debugging.

Desempenho: as métricas pelas quais os runtimes competem

“Rápido” não é um único número. Runtimes JavaScript podem parecer incríveis num gráfico e medianos em outro, porque otimizam definições diferentes de velocidade.

Latência vs throughput

Latência é quão rápido uma única requisição termina; throughput é quantas requisições você consegue completar por segundo. Um runtime afinado para baixa latência de inicialização e respostas rápidas pode sacrificar throughput máximo sob alta concorrência, e vice-versa.

Por exemplo, uma API que serve buscas de perfil de usuário se preocupa com latência nas caudas (p95/p99). Um job em lote que processa milhares de eventos por segundo se importa mais com throughput e eficiência em estado estacionário.

Tempo de cold start (serverless e CLIs)

Cold start é o tempo entre “nada está rodando” até “pronto para trabalhar”. Importa muito para funções serverless que escalam a zero, e para CLIs que usuários executam frequentemente.

Cold starts são influenciados pelo carregamento de módulos, transpilaçao TypeScript (se houver), inicialização de APIs embutidas e quanto trabalho o runtime faz antes do seu código executar. Um runtime pode ser muito rápido quando aquecido, mas parecer lento se demorar para dar boot.

Desempenho de I/O: rede, sistema de arquivos, streams

A maior parte do JavaScript no servidor é bound a I/O: requisições HTTP, chamadas a banco, leitura de arquivos, streaming de dados. Aqui, desempenho muitas vezes é sobre eficiência do event loop, qualidade dos bindings assíncronos de I/O, implementações de streams e como o backpressure é tratado.

Pequenas diferenças — como a rapidez com que o runtime analisa headers, agenda timers ou esvazia writes — podem se traduzir em ganhos reais em servidores web e proxies.

Trabalho ligado à CPU: forças e limites do motor

Tarefas pesadas de CPU (parsing, compressão, processamento de imagens, crypto, analytics) pressionam o motor JavaScript e o compilador JIT. Motores podem otimizar caminhos quentes, mas JavaScript ainda tem limites para cargas numéricas sustentadas.

Se trabalho ligado à CPU domina, o “runtime mais rápido” pode ser aquele que facilita mover loops quentes para código nativo ou usar worker threads sem complexidade.

Checagem de realidade dos benchmarks (e armadilhas comuns)

Benchmarks são úteis, mas fáceis de interpretar mal — especialmente quando tratados como placares universais. Um runtime que “vence” um gráfico pode ainda ser mais lento para sua API, pipeline de build ou job de processamento de dados.

Microbenchmarks vs aplicações reais

Microbenchmarks normalmente testam uma operação minúscula (como parsing de JSON, regex ou hashing) em um loop apertado. Isso ajuda a medir um ingrediente, não a refeição inteira.

Aplicações reais gastam tempo em coisas que microbenchmarks ignoram: espera de rede, chamadas a banco, I/O de arquivos, overhead de framework, logging e pressão de memória. Se sua carga é majoritariamente I/O-bound, um loop de CPU 20% mais rápido pode não impactar sua latência fim-a-fim.

Resultados mudam com workload, SO e versões

Pequenas diferenças de ambiente podem inverter resultados:

- Formato da carga: muitas requisições pequenas vs poucas grandes; streaming vs buffering.

- SO e hardware: Linux vs macOS; CPUs diferentes; limites de container.

- Versões do runtime e dependências: atualizações do motor, diferenças de libc e mudanças em bibliotecas podem dominar.

Quando vir um screenshot de benchmark, pergunte quais versões e flags foram usadas — e se isso bate com seu setup de produção.

Efeitos de aquecimento (JIT) e caching

Motores JavaScript usam compilação JIT: código pode rodar mais lento no começo e acelerar quando o motor “aprende” caminhos quentes. Se um benchmark mede só os primeiros segundos, pode valorizar coisas erradas.

Caching também importa: cache de disco, cache DNS, keep-alive HTTP e caches a nível de aplicação podem fazer execuções posteriores parecerem dramaticamente melhores. Isso pode ser real, mas precisa ser controlado.

Projetando testes justos e repetíveis

Mire em benchmarks que respondam sua pergunta, não a de outra pessoa:

- Meça fim-a-fim: inclua framework + middleware típico + tamanhos reais de payload.

- Separe cold vs warm: registre startup, primeira requisição e estado estacionário.

- Rode várias tentativas: reporte mediana e variância, não só a melhor execução.

- Trave o ambiente: fixe versões, isole CPU e documente comandos.

Se precisar de um template prático, capture seu test harness num repositório e linke-o a docs internas (ou uma página /blog/runtime-benchmarking-notes) para que os resultados possam ser reproduzidos depois.

Por baixo do capô: motores, APIs e modelos de execução

Teste o cold start de uma CLI

Rascunhe uma CLI rapidamente e compare as compensações entre cold start e empacotamento.

Quando as pessoas comparam Node.js, Deno e Bun, frequentemente falam de recursos e benchmarks. Por baixo, a “sensação” de um runtime é moldada por quatro grandes peças: o motor JavaScript, as APIs embutidas, o modelo de execução (event loop + agendadores) e como código nativo está ligado.

Motores: V8, JavaScriptCore e por que importam

O motor é a parte que analisa e executa JavaScript. V8 (usado por Node.js e Deno) e JavaScriptCore (usado por Bun) fazem otimizações avançadas como JIT e garbage collection.

Na prática, a escolha do motor pode influenciar:

- Tempo de startup e comportamento de memória (quão rápido um processo fica útil)

- Performance de “código quente” após otimizações

- Quais recursos de baixo nível chegam primeiro (alguns motores lançam novas capacidades JS antes de outros)

APIs embutidas: mais que “posso dar fetch?”

Runtimes modernos competem pelo quão completa a sua biblioteca padrão parece. Ter built-ins como fetch, Web Streams, utilitários de URL, APIs de arquivos e crypto pode reduzir a proliferação de dependências e tornar código mais portátil entre servidor e navegador.

O detalhe: o mesmo nome de API nem sempre significa comportamento idêntico. Diferenças em streaming, timeouts ou file watching podem afetar aplicações reais mais do que velocidade bruta.

Modelos de execução: event loops, agendadores e bindings nativos

JavaScript é single-threaded no topo, mas runtimes coordenam trabalho em background (rede, I/O de arquivos, timers) via event loop e agendadores internos. Alguns runtimes apostam pesado em bindings nativos (código compilado) para I/O e tarefas críticas de performance, enquanto outros enfatizam interfaces padronizadas da web.

WebAssembly: quando faz sentido

WebAssembly (Wasm) é útil quando você precisa de computação rápida e previsível (parsing, processamento de imagens, compressão) ou quer reaproveitar código em Rust/C/C++. Não vai acelerar magicamente servidores I/O-heavy, mas pode ser uma ótima opção para módulos CPU-bound.

Segurança: padrões, permissões e a realidade da cadeia de suprimentos

“Seguro por padrão” em um runtime JavaScript geralmente significa que o runtime assume código não confiável até que você conceda explicitamente acesso. Isso inverte o modelo tradicional server-side (onde scripts frequentemente podem ler arquivos, chamar a rede e inspecionar variáveis de ambiente por padrão) para uma postura mais cautelosa.

Ao mesmo tempo, muitos incidentes do mundo real começam antes do seu código rodar — dentro de dependências e no processo de instalação — então segurança a nível de runtime deve ser tratada como uma camada, não como a estratégia completa.

Prompts de permissão e allowlists

Alguns runtimes podem controlar capacidades sensíveis por permissões. A versão prática disso é uma allowlist:

- Sistema de arquivos: permitir leitura/escrita apenas a caminhos específicos (ex.: um diretório de config)

- Rede: permitir requisições de saída apenas a hosts/portas aprovados

- Variáveis de ambiente: expor apenas chaves específicas ao invés de todo o processo env

Isso pode reduzir vazamentos acidentais de dados (como enviar segredos a um endpoint inesperado) e limitar o raio de impacto ao rodar scripts de terceiros — especialmente em CLIs, ferramentas de build e automações.

Sandboxing tem limites

Permissões não são uma proteção mágica. Se você concede acesso de rede a “api.minhaempresa.com”, uma dependência comprometida ainda pode exfiltrar dados para esse mesmo host. E se você permitir leitura de um diretório, está confiando em tudo que lá existe. O modelo ajuda a expressar intenção, mas ainda é necessário auditoria de dependências, lockfiles e revisão cuidadosa do que está sendo permitido.

Padrões de segurança em APIs comuns

Segurança também vive nos pequenos padrões:

- TLS/HTTPS: validação de certificados sensata e configurações de protocolo modernas por padrão

- HTTP: comportamento seguro de redirects e controle claro sobre headers/cookies

- APIs de crypto: primitivas modernas com interfaces que dificultam usos inseguros

O trade-off é atrito: padrões mais rígidos podem quebrar scripts legados ou adicionar flags que você precisa manter. A melhor escolha depende se você valoriza conveniência para serviços confiáveis ou guardrails para código de confiança mista.

Riscos da cadeia de suprimentos que você não pode ignorar

Ataques na cadeia de suprimentos frequentemente exploram como pacotes são descobertos e instalados:

- Typosquatting: um pacote malicioso com nome quase igual ao de um popular (ex.:

expresss). - Dependency confusion: um pacote público é publicado com o mesmo nome de um interno, enganando instaladores a puxarem a versão pública.

- Mantenedores comprometidos: uma conta invadida publica uma atualização “legítima” com código injetado.

Esses riscos afetam qualquer runtime que puxe do registry público — então higiene importa tanto quanto funções de runtime.

Lockfiles, checagens de integridade e proveniência

Lockfiles fixam versões exatas (incluindo dependências transitivas), tornando instalações reprodutíveis e reduzindo atualizações-surpresa. Checagens de integridade (hashes gravados no lockfile ou metadados) ajudam a detectar adulteração durante o download.

Proveniência é o próximo passo: ser capaz de responder “quem construiu este artefato, de qual fonte, usando qual workflow?” Mesmo que você não adote ferramentas completas de proveniência ainda, dá para aproximar-se com práticas como:

- preferir pacotes bem mantidos com práticas de release transparentes,

- evitar dependências Git não travadas em builds de produção,

- exigir tags/releases ao invés de instalar de commits aleatórios.

Workflows de auditoria e atualização que funcionam

Trate dependências como manutenção rotineira:

- rode auditorias automatizadas em CI a cada pull request,

- agende janelas regulares de atualização (semanal/quinzenal) para evitar upgrades “monstruosos”,

- revise changelogs antes de grandes saltos e releases relacionados à segurança.

Políticas de time que não atrasam entrega

Regras leves fazem muita diferença:

- bloquear dependências novas sem necessidade clara e um dono,

- restringir scripts de instalação quando possível (eles são um caminho comum de execução),

- usar um registry privado ou pacotes com escopo para nomes internos e reduzir confusão.

Boa higiene é menos sobre perfeição e mais sobre hábitos consistentes e chatos.

Compatibilidade e ecossistema como vantagens competitivas

Desempenho e segurança rendem manchetes, mas compatibilidade e ecossistema frequentemente decidem o que realmente é colocado em produção. Um runtime que roda seu código existente, suporta suas dependências e se comporta igual entre ambientes reduz risco mais do que qualquer recurso isolado.

Compatibilidade afeta segurança e manutenção

Compatibilidade não é só conveniência. Menos reescritas significa menos chances de introduzir bugs sutis e menos patches pontuais que você vai esquecer de atualizar. Ecossistemas maduros também tendem a ter modos de falha mais conhecidos: bibliotecas comuns foram mais auditadas, issues documentados e mitigacões mais fáceis de achar.

Por outro lado, “compatibilidade a qualquer custo” pode manter padrões legados vivos (como acesso amplo a arquivos/rede), então times ainda precisam de limites claros e boa higiene de dependências.

Camadas de compatibilidade Node vs APIs padrão web

Runtimes que buscam ser drop-in compatíveis com Node.js podem rodar a maior parte do JavaScript server-side imediatamente, o que é uma vantagem prática enorme. Camadas de compatibilidade podem suavizar diferenças, mas também podem esconder comportamentos específicos do runtime — especialmente em filesystem, rede e resolução de módulos — tornando o debug mais difícil quando algo se comporta diferente em produção.

APIs padrão web (como fetch, URL e Web Streams) empurram código para portabilidade entre runtimes e até ambientes edge. O trade-off: alguns pacotes Node-centric assumem internos do Node e não funcionarão sem shims.

Ecossistema npm: forças e trade-offs

A maior força do npm é simples: tem quase tudo. Essa amplitude acelera entregas, mas aumenta exposição a risco na cadeia de suprimentos e inchaço de dependências. Mesmo quando um pacote é “popular”, suas dependências transitivas podem surpreender você.

Quando “funciona em todo lugar” vence novos recursos

Se sua prioridade é deploys previsíveis, contratação mais fácil e menos surpresas de integração, “funciona em todo lugar” frequentemente é a característica vencedora. Capacidades novas do runtime são empolgantes — mas portabilidade e um ecossistema comprovado podem economizar semanas durante a vida de um projeto.

Experiência do desenvolvedor: tooling, tipos e debugging

Valide o runtime na implantação

Implemente um serviço piloto e veja como as escolhas de runtime afetam fluxos reais de release.

Experiência do desenvolvedor é onde runtimes ganham ou perdem silenciosamente. Dois runtimes podem rodar o mesmo código, mas se sentir totalmente diferentes ao configurar um projeto, caçar um bug ou tentar entregar um serviço pequeno rapidamente.

Suporte a TypeScript: embutido vs “traga seu próprio”

TypeScript é um bom termômetro de DX. Alguns runtimes tratam como input de primeira classe (você pode rodar arquivos .ts com pouca cerimônia), enquanto outros esperam uma toolchain tradicional (tsc, um bundler ou um loader) que você configure.

Nenhuma abordagem é universalmente “melhor":

- Suporte embutido reduz setup e pode padronizar defaults numa equipe.

- Tooling configurado dá controle mais fino sobre tsconfig, targets de emissão e output — útil para bibliotecas e monorepos maiores.

A questão é se a história TypeScript do runtime bate com o jeito que sua equipe entrega código: execução direta no dev, builds compilados no CI, ou ambos.

Bundling, transpiling e defaults de teste

Runtimes modernos cada vez mais vêm com tooling opinativa: bundlers, transpilers, linters e test runners prontos. Isso pode eliminar o “imposto de escolher sua stack” para projetos pequenos.

Mas defaults só são positivos para DX quando são previsíveis:

- Você consegue alterar facilmente formatos de saída (ESM/CJS), targets e dependências externas?

- O test runner integra bem com coverage e CI?

- A configuração é minimalista e estável entre versões?

Se você frequentemente inicia novos serviços, um runtime com bons built-ins e documentação pode economizar horas por projeto.

Debugging: stack traces, sourcemaps e inspectors

Debugging é onde o polimento do runtime fica evidente. Stack traces de qualidade, sourcemaps corretos e um inspector que “simplesmente funciona” determinam quão rápido você entende falhas.

Procure por:

- Erros claros que apontem para sua fonte (não para código gerado)

- Stack traces assíncronos confiáveis

- Boa integração com editores e inspectors ao estilo Chrome DevTools

Templates e scaffolding que removem atrito

Geradores de projeto podem ser subestimados: um template limpo para uma API, CLI ou worker muitas vezes define o tom do código. Prefira scaffolds que criem uma estrutura mínima, preparada para produção (logging, tratamento de env, testes), sem te prender num framework pesado.

Se precisar de inspiração, veja guias relacionados em /blog.

Como fluxo prático, times às vezes usam Koder.ai para prototipar um serviço pequeno ou CLI em diferentes “estilos de runtime” (Node-first vs APIs padrão web), depois exportar o código gerado para um teste de benchmark real. Não substitui testes em produção, mas pode reduzir o tempo entre ideia → comparação executável quando estiver avaliando trade-offs.

Gerenciamento de pacotes modela a DX

Gerenciamento de pacotes é onde “experiência do desenvolvedor” vira tangível: velocidade de instalação, comportamento do lockfile, suporte a workspaces e quão confiavelmente o CI reproduz um build. Runtimes cada vez mais tratam isso como um recurso de primeira classe, não algo paralelo.

Gerenciadores nativos ao runtime e metas de performance

Historicamente Node.js dependia de tooling externo (npm, Yarn, pnpm), o que é força (escolha) e fonte de inconsistência entre times. Runtimes novos trazem opiniões: Deno integra gerenciamento via deno.json (e suporta pacotes npm), enquanto Bun inclui um instalador rápido e lockfile.

Essas ferramentas nativas costumam otimizar por menos round-trips de rede, cache agressivo e integração mais apertada com o loader de módulos do runtime — útil para cold starts em CI e para onboard de novos colegas.

Monorepos, workspaces e noções básicas de cache

A maioria dos times eventualmente precisa de workspaces: pacotes internos compartilhados, versões consistentes e regras previsíveis de hoisting. npm, Yarn e pnpm suportam workspaces, mas se comportam diferente quanto a uso de disco, layout de node_modules e deduplicação. Isso afeta tempo de instalação, resolução em editores e bugs “funciona na minha máquina”.

Cache importa tanto quanto. Um baseline razoável é cachear a store do gerenciador (ou cache de download) além de passos de instalação baseados em lockfile, mantendo scripts determinísticos. Se quiser um ponto de partida simples, documente isso junto dos passos de build em /docs.

Publicação e consumo: o que times precisam saber

Publicar pacotes internos (ou consumir registries privados) força você a padronizar auth, URLs de registry e regras de versionamento. Garanta que seu runtime/tooling suporte as mesmas convenções de .npmrc, checagens de integridade e expectativas de proveniência.

Preocupações de migração: mudanças no lockfile e ajustes no CI

Trocar o gerenciador de pacotes ou adotar um instalador embutido pelo runtime normalmente altera lockfiles e comandos de instalação. Planeje churn em PRs, atualize imagens de CI e alinhe um lockfile “fonte da verdade” — caso contrário você vai depurar drift de dependências em vez de entregar features.

Escolhendo um runtime por caso de uso (não por hype)

Crie uma API para benchmarks

Gere uma API pequena pelo chat e use-a como alvo realista para benchmarks ponta a ponta.

Escolher um runtime JavaScript é menos sobre “o mais rápido no gráfico” e mais sobre o formato do seu trabalho: como você faz deploy, com o que precisa integrar e quanto risco seu time pode absorver. Uma boa escolha reduz atrito para suas restrições.

Serverless e workloads edge

Aqui, cold-start e comportamento de concorrência importam tanto quanto throughput bruto. Procure por:

- Tempo de startup (quão rápido uma função começa a atender)

- Modelo de isolamento (processos vs isolates/estilo worker)

- Disponibilidade de APIs (APIs Web, fetch, streams, crypto) na plataforma alvo

Node.js é amplamente suportado por provedores; APIs padrão web de Deno e seu modelo de permissões podem ser atraentes onde disponíveis; a velocidade do Bun pode ajudar, mas confirme suporte da plataforma e compatibilidade com edge antes de adotar.

Ferramentas CLI e automação

Para utilitários de linha de comando, distribuição pode dominar a decisão. Priorize:

- Builds em binário único e instalações previsíveis

- Comportamento cross-platform (macOS, Windows, Linux)

- Startup rápido e ergonomia do desenvolvedor

O tooling embutido do Deno e a distribuição simplificada são fortes para CLIs. Node.js é sólido quando você precisa da amplitude do npm. Bun pode ser ótimo para scripts rápidos, mas valide empacotamento e suporte Windows para seu público.

Containers e serviços de longa execução

Em containers, estabilidade, comportamento de memória e observabilidade frequentemente pesam mais que benchmarks de manchete. Avalie uso de memória em estado estacionário, comportamento do GC sob carga e maturidade das ferramentas de debug/profiling. Node.js tende a ser o “padrão seguro” para serviços long-lived pela maturidade do ecossistema e familiaridade operacional.

Restrições de time vencem novidade

Escolha o runtime que se alinha às habilidades do time, bibliotecas e operações (CI, monitoramento, resposta a incidentes). Se um runtime força reescritas, novos fluxos de debug ou práticas de dependência obscuras, qualquer ganho de desempenho pode ser apagado pelo risco de entrega.

Se a meta é entregar features mais rápido (não só discutir runtimes), considere onde JavaScript realmente importa na sua stack. Por exemplo, Koder.ai foca em construir aplicações completas por chat — frontends web em React, backends em Go com PostgreSQL e apps móveis em Flutter — então times frequentemente deixam “decisões de runtime” para lugares onde Node/Deno/Bun realmente importam (tooling, scripts edge ou serviços JS existentes), enquanto seguem rápido com uma baseline pronta para produção.

Checklist de decisão e próximos passos

Escolher um runtime é menos sobre eleger um “vencedor” e mais sobre reduzir risco enquanto melhora resultados para seu time e produto.

Um checklist curto

- Testes de desempenho: você sabe seus 3 maiores gargalos (tempo de startup, throughput de requisições, trabalho CPU-heavy, latência de I/O)? Consegue reproduzi-los localmente e no CI?

- Necessidades de segurança: você precisa de modelo de permissões (acesso a arquivos/rede/env), isolamento mais rígido ou controles de compliance?

- Prioridades de DX: qual atrito custa mais hoje — setup TypeScript, debugging, hot reload, tooling de testes ou empacotamento para deploy?

Perguntas a fazer antes de trocar de runtime

- Qual problema estamos resolvendo: custo, latência, velocidade do dev ou segurança?

- Quais partes do nosso sistema são sensíveis ao runtime (funções edge, CLIs, APIs, jobs background)?

- Estamos presos a comportamento de um ecossistema de pacotes específico (addons nativos, scripts postinstall, expectativas CommonJS/ESM)?

- Qual é nosso plano de rollback se uma dependência ou integração de plataforma se comportar diferente?

- Quem vai ser responsável por upgrades do runtime e por acompanhar breaking changes?

Um plano piloto prático

Comece pequeno e com métricas claras:

- Escolha um serviço ou ferramenta interna com entradas/saídas claras (ex.: um webhook handler, um CLI, um worker pequeno).

- Defina métricas de sucesso: latência p95, memória, CPU, tempo de build, cold start e tempo de resolução do desenvolvedor.

- Rode o piloto em dois ambientes: staging e um canário em produção (se possível).

- Compare resultados, documente surpresas, então iterate (ajuste configs, escolhas de dependência) antes de considerar migração ampla.

Se quiser acelerar o loop de feedback, você pode gerar o serviço piloto e o harness de benchmark rapidamente em Koder.ai, usar Planning Mode para esboçar o experimento (métricas, endpoints, payloads) e exportar o código para que as medições finais rodem no ambiente que você controla.

Onde aprender mais a seguir

Use fontes primárias e sinais contínuos:

- Documentação oficial e notas de compatibilidade de Node.js, Deno e Bun

- Notas de release e changelogs (fique de olho em fixes de segurança e breaking changes)

- Avisos de segurança e feeds CVE relevantes às suas dependências

- Trackers de issues da comunidade para detectar casos reais e bordas

Se quiser um guia mais profundo sobre como medir runtimes com justiça, veja /blog/benchmarking-javascript-runtimes.

Perguntas frequentes

Qual é a diferença entre um motor JavaScript e um runtime JavaScript?

Um motor JavaScript (engine) (como V8 ou JavaScriptCore) analisa e executa JavaScript. Um runtime inclui o motor mais as APIs e a integração com o sistema das quais você depende — acesso a arquivos, rede, timers, gerenciamento de processos, criptografia, streams e o loop de eventos.

Em outras palavras: o motor executa o código; o runtime torna esse código capaz de fazer trabalho útil numa máquina ou plataforma.

Por que a escolha do runtime importa se é tudo “apenas JavaScript”?

Seu runtime define fundamentos do dia a dia:

- Quais APIs você pode chamar (

fetch, APIs de arquivos, streams, crypto) - Como você instala e trava dependências

- Quão segura é a execução por padrão (permissões vs acesso irrestrito)

- Quão rápido as ferramentas iniciam (cold start) e como os serviços se comportam sob carga

- Como são o debugging, sourcemaps e testes na prática

Mesmo pequenas diferenças podem alterar risco de deploy e o tempo que a equipe leva para resolver problemas.

Por que existem vários runtimes (Node.js, Deno, Bun) em vez de apenas um?

Diversos runtimes existem porque times querem trade-offs diferentes:

- Compatibilidade com o ecossistema Node/npm vs APIs padrão web

- Padrões de segurança (acesso por permissões) vs máxima conveniência

- Ferramentas integradas (TypeScript, formatting, testes, bundling) vs usar seu próprio fluxo

- Metas de desempenho como startup rápido para CLIs ou alto throughput para servidores

Essas prioridades não podem ser todas otimizadas ao mesmo tempo.

Existe um runtime universalmente mais rápido que os outros?

Não necessariamente. “Rápido” depende do que você mede:

- Latência (incluindo percentis p95/p99)

- Throughput (requisições por segundo sob concorrência)

- Cold start (serverless e CLIs)

- Desempenho de I/O (rede, sistema de arquivos, streams)

O que é “cold start” e quando devo me importar?

Cold start é o tempo entre “nada está rodando” até “pronto para trabalhar”. Importa quando processos iniciam com frequência:

- Funções serverless/edge que escalam a zero

- CLIs que os usuários executam repetidamente

- Jobs curtos em CI

É influenciado por carregamento de módulos, custo de inicialização e qualquer transpilaçao TypeScript ou configuração feita antes do seu código executar.

Como evitar ser enganado por benchmarks de runtime?

Armadilhas comuns de benchmark incluem:

- Usar microbenchmarks que não refletem comportamento de aplicação fim-a-fim

- Comparar resultados em diferentes SO/hardware/versões do runtime

- Ignorar aquecimento do JIT e caches (DNS, disco, HTTP keep-alive)

- Reportar apenas a melhor execução ao invés da mediana + variância

Testes melhores separam cold vs warm, incluem frameworks/payloads realistas e são reprodutíveis com versões fixas e comandos documentados.

O que significa “secure by default” em um runtime JavaScript?

Em modelos “secure by default”, capacidades sensíveis são condicionadas a permissões explícitas (allowlists), tipicamente para:

- Sistema de arquivos (leitura/escrita em caminhos específicos)

- Rede (hosts/portas aprovados)

- Variáveis de ambiente (chaves específicas)

Isso ajuda a reduzir vazamentos acidentais e limita o raio de impacto ao rodar scripts de terceiros — mas não substitui a auditoria de dependências.

Como riscos na cadeia de suprimentos afetam a escolha do runtime e o dia a dia?

Muitos incidentes começam na cadeia de dependências, não no runtime:

- Typosquatting e dependency confusion exploram o fluxo de instalação

- Mantenedores comprometidos podem publicar updates maliciosos

- Dependências transitivas podem introduzir riscos e inchaço inesperados

Use lockfiles, checagens de integridade, auditorias em CI e janelas regulares de atualização para manter instalações reprodutíveis e reduzir mudanças-surpresa.

Quão importante é a compatibilidade com Node.js ao escolher um runtime?

Se você depende fortemente do ecossistema npm, a compatibilidade com Node.js costuma ser decisiva:

- Muitos pacotes assumem módulos e comportamentos específicos do Node

- Addons nativos e scripts de postinstall podem ser sensíveis ao runtime

- Diferenças CommonJS/ESM e resolução de módulos podem quebrar a expectativa de “funcionar imediato”

APIs padrão web melhoram portabilidade, mas bibliotecas centradas em Node podem precisar de shims ou substituições.

Qual é uma maneira segura de avaliar ou mudar de runtime sem comprometer todo o projeto?

Uma abordagem prática é um piloto pequeno e mensurável:

- Escolha um serviço/ferramenta (CLI, handler de webhook, worker pequeno).

- Defina métricas: latência p95, memória, CPU, tempo de build, cold start e tempo de correção do dev.

- Teste em staging e, se possível, em um canário de produção.

- Documente surpresas (diferenças de API, problemas com dependências), ajuste e decida.

Planeje também rollback e quem será responsável por upgrades do runtime e por acompanhar mudanças incompatíveis.