18 de mai. de 2025·8 min

Projeto do Esquema em Primeiro Lugar: Aplicações Mais Rápidas do que Otimização Precoce de Consultas

Ganho de performance no início geralmente vem do projeto do esquema: tabelas, chaves e restrições corretas evitam consultas lentas e refatorações caras no futuro.

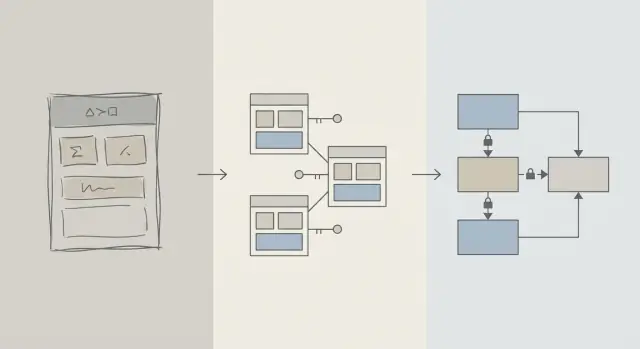

Esquema vs Otimização de Consultas: O que Queremos Dizer

Quando um app parece lento, o primeiro instinto costuma ser “consertar o SQL”. Esse impulso faz sentido: uma única consulta é visível, mensurável e fácil de culpar. Você pode rodar EXPLAIN, adicionar um índice, ajustar um JOIN e às vezes ver ganho imediato.

Mas cedo na vida de um produto, problemas de velocidade são tão prováveis de vir da forma dos dados quanto do texto da consulta. Se o esquema te obriga a brigar com o banco, o ajuste de consultas vira um ciclo de whack-a-mole.

Projeto de esquema (em linguagem simples)

Projeto de esquema é como você organiza seus dados: tabelas, colunas, relacionamentos e regras. Inclui decisões como:

- Quais “coisas” merecem sua própria tabela (usuários, pedidos, eventos)

- Como as tabelas se relacionam (um-para-muitos, muitos-para-muitos)

- O que deve ser único ou obrigatório (restrições)

- Como representar estados e histórico (timestamps, campos de status, registros de auditoria)

Um bom projeto de esquema faz com que a maneira natural de fazer perguntas seja também a maneira rápida.

Otimização de consultas (em linguagem simples)

Otimização de consultas é melhorar como você busca ou atualiza dados: reescrever consultas, adicionar índices, reduzir trabalho desnecessário e evitar padrões que disparem grandes varreduras.

Ambos importam—o timing importa mais

Este artigo não é “esquema bom, consultas ruins”. Trata-se de ordem de operações: acerte os fundamentos do esquema do banco primeiro, depois otimize as consultas que realmente precisarem.

Você vai aprender por que decisões de esquema dominam o desempenho inicial, como identificar quando o esquema é o gargalo real e como evoluí‑lo com segurança à medida que seu app cresce. Escrito para times de produto, fundadores e desenvolvedores construindo apps do mundo real—não para especialistas em banco de dados.

Por que o Projeto de Esquema Move a Maioria do Desempenho Inicial

O desempenho inicial geralmente não é sobre SQL esperto—é sobre quanto dado o banco é forçado a tocar.

A estrutura determina quanto você varre

Uma consulta só pode ser tão seletiva quanto o modelo de dados permite. Se você guarda “status”, “tipo” ou “proprietário” em campos pouco estruturados (ou espalhados por tabelas inconsistentes), o banco frequentemente precisa varrer muito mais linhas para descobrir o que bate.

Um bom esquema estreita o espaço de busca naturalmente: colunas claras, tipos de dados consistentes e tabelas bem delimitadas significam que as consultas filtram mais cedo e leem menos páginas do disco ou da memória.

Chaves ausentes criam trabalho caro

Quando chaves primárias e estrangeiras estão ausentes (ou não são aplicadas), relacionamentos viram suposições. Isso empurra trabalho para a camada de consulta:

- Joins ficam maiores porque não há caminho de junção indexado e confiável.

- Filtros ficam mais complexos porque você compensa duplicatas, nulls e valores que “quase casam”.

Sem restrições, dados ruins se acumulam—e as consultas continuam ficando mais lentas à medida que você adiciona mais linhas.

Índices seguem o esquema (e não resolvem tudo)

Índices são mais úteis quando combinam com caminhos de acesso previsíveis: junções por chaves estrangeiras, filtros por colunas bem definidas e ordenações por campos comuns. Se o esquema guarda atributos críticos na tabela errada, mistura significados numa coluna ou depende de parsing de texto, índices não te salvam—você ainda estará varrendo e transformando demais.

Rápido por padrão

Com relacionamentos limpos, identificadores estáveis e limites de tabela sensatos, muitas consultas do dia a dia ficam “rápidas por padrão” porque tocam menos dados e usam predicados simples e amigáveis a índices. Ajuste de consultas vira então um passo final—não uma briga constante.

A Realidade de Early-Stage: Mudança é Constante

Produtos em estágio inicial não têm “requisitos estáveis”—têm experimentos. Funcionalidades são lançadas, reescritas ou descartadas. Um time pequeno equilibra pressão de roadmap, suporte e infraestrutura com tempo limitado para revisitar decisões antigas.

O que muda com mais frequência

Raramente é o texto SQL que muda primeiro. É o significado dos dados: novos estados, novos relacionamentos, campos "ah, também precisamos rastrear…" e fluxos completos não imaginados no lançamento. Essa rotatividade é normal—e é exatamente por isso que escolhas de esquema importam tanto cedo.

Por que consertar esquema depois é mais difícil que consertar uma consulta

Reescrever uma consulta costuma ser reversível e local: você pode enviar a melhoria, medir e reverter se necessário.

Reescrever um esquema é diferente. Depois de armazenar dados reais de clientes, toda mudança estrutural vira um projeto:

- Migrações que travam tabelas ou deixam escritas mais lentas em picos

- Backfills para popular novas colunas ou reconstruir dados derivados

- Dual-write ou tabelas espelho para manter o app funcionando durante a transição

- Risco de downtime se uma mudança não puder ser feita online

Mesmo com boas ferramentas, mudanças de esquema introduzem custos de coordenação: atualizações de código do app, sequenciamento de deploys e validação de dados.

Como decisões iniciais se multiplicam

Quando o banco é pequeno, um esquema desajeitado pode parecer “ok”. À medida que as linhas crescem de milhares para milhões, o mesmo design cria varreduras maiores, índices mais pesados e joins mais caros—e cada nova funcionalidade é construída sobre essa base.

Então o objetivo no início não é perfeição. É escolher um esquema que absorva mudanças sem forçar migrações arriscadas toda vez que o produto aprende algo novo.

Fundamentos de Projeto que Previnem Consultas Lentas

A maioria dos problemas de “consulta lenta” no começo não é sobre truques de SQL—é sobre ambiguidade no modelo de dados. Se o esquema torna incerto o que um registro representa ou como registros se relacionam, cada consulta vira mais cara de escrever, rodar e manter.

Comece com um pequeno conjunto de entidades centrais

Comece nomeando as poucas coisas sem as quais seu produto não funciona: usuários, contas, pedidos, assinaturas, eventos, faturas—o que for realmente central. Defina relacionamentos explicitamente: um-para-muitos, muitos-para-muitos (geralmente com uma tabela de junção) e propriedade (quem “contém” o quê).

Um check prático: para cada tabela, você deveria conseguir completar a frase “Uma linha nesta tabela representa ___.” Se não conseguir, a tabela provavelmente está misturando conceitos, o que mais tarde força filtragens e joins complexos.

Torne nomes e propriedade enfadonhos e consistentes

Consistência evita joins acidentais e comportamento de API confuso. Escolha convenções (snake_case vs camelCase, *_id, created_at/updated_at) e mantenha-as.

Decida também quem “possui” um campo. Por exemplo, “billing_address” pertence a um pedido (snapshot no tempo) ou a um usuário (padrão atual)? Ambos podem ser válidos—mas misturá‑los sem intenção clara cria consultas lentas e sujeitas a erro para “descobrir a verdade”.

Escolha tipos de dados que batem com a realidade

Use tipos que evitem conversões em tempo de execução:

- Use timestamps com regras de fuso horário que você entenda.

- Use decimals para dinheiro (não floats).

- Use enums/tabelas de referência para categorias conhecidas.

Quando os tipos estão errados, bancos não conseguem comparar eficientemente, índices ficam menos úteis e consultas frequentemente precisam de casts.

Não duplique fatos sem um plano

Armazenar o mesmo fato em vários lugares (ex.: order_total e sum(line_items)) cria divergência. Se você cacheia um valor derivado, documente, defina a fonte da verdade e imponha atualizações consistentemente (frequentemente via lógica do app mais restrições).

Chaves e Restrições: Velocidade Começa com Integridade dos Dados

Um banco rápido é geralmente um banco previsível. Chaves e restrições tornam seus dados previsíveis ao impedir estados “impossíveis”—relacionamentos faltando, identidades duplicadas ou valores que não significam o que o app pensa. Essa limpeza afeta diretamente o desempenho porque o banco pode fazer melhores suposições ao planejar consultas.

Chaves primárias: toda tabela precisa de um identificador estável

Toda tabela deve ter uma chave primária (PK): uma coluna (ou pequeno conjunto) que identifica unicamente uma linha e nunca muda. Isso não é só teoria de banco de dados—é o que permite você juntar tabelas eficientemente, cachear com segurança e referenciar registros sem suposições.

Uma PK estável também evita soluções alternativas caras. Se uma tabela não tem um identificador verdadeiro, aplicações começam a “identificar” linhas por email, nome, timestamp ou um bundle de colunas—levando a índices maiores, joins mais lentos e casos de borda quando esses valores mudam.

Chaves estrangeiras: integridade que ajuda o otimizador

Chaves estrangeiras (FKs) forçam relacionamentos: um orders.user_id deve apontar para um users.id existente. Sem FKs, referências inválidas aparecem (pedidos para usuários deletados, comentários para posts ausentes) e então toda consulta precisa filtrar defensivamente, usar left-join e lidar com nulls.

Com FKs no lugar, o planejador de consultas costuma otimizar joins com mais confiança porque o relacionamento é explícito e garantido. Você também tende a evitar linhas órfãs que incham tabelas e índices ao longo do tempo.

Restrições como guarda‑rail para dados limpos e rápidos

Restrições não são burocracia—são guarda‑rails:

- UNIQUE previne duplicatas que forçam o app a fazer lookups e limpezas extras. Ex.: um

users.emailcanônico. - NOT NULL evita lógica ternária e ramos surpresa no tratamento de null nas consultas.

- CHECK mantém valores dentro de um conjunto conhecido (ex.:

status IN ('pending','paid','canceled')).

Dados mais limpos significam consultas mais simples, menos condições de fallback e menos joins “só por precaução”.

Anti‑padrões comuns que te deixam lento

- Sem chaves estrangeiras: você pagará depois com jobs de limpeza de órfãos e lógica de consulta complicada.

- Campos de email duplicados (ex.:

users.emailecustomers.email): indentidades conflitantes e índices duplicados. - Strings de status livres: erros de digitação como "Cancelled" vs "canceled" criam segmentos ocultos que quebram filtros e relatórios.

Se você quer velocidade cedo, torne difícil armazenar dados ruins. O banco vai te recompensar com planos mais simples, índices menores e menos surpresas de desempenho.

Normalização vs Desnormalização: Um Equilíbrio Prático

Reverta alterações de banco de dados arriscadas

Crie um snapshot antes das migrações e reverta rapidamente se necessário.

Normalização é uma ideia simples: armazene cada “fato” em um só lugar para não duplicar dados pelo banco. Quando o mesmo valor é copiado para várias tabelas, atualizações ficam arriscadas—uma cópia muda, outra não, e seu app começa a mostrar respostas conflitantes.

Normalização (padrão): um fato, uma casa

Na prática, normalizar significa separar entidades para que updates sejam limpos e previsíveis. Por exemplo, nome e preço de um produto pertencem a products, não repetidos dentro de cada linha de pedido. O nome de uma categoria pertence a categories, referenciado por um ID.

Isso reduz:

- dados duplicados (menos armazenamento, menos inconsistências)

- erros de atualização (mude uma vez, refletido em todo lugar)

- bugs de “qual valor está correto?”

Quando a normalização excessiva atrapalha

Normalizar demais vira problema quando você divide os dados em muitas tabelas pequenas que precisam ser constantemente juntadas para telas comuns. O banco pode retornar o resultado correto, mas leituras comuns ficam mais lentas e complexas porque cada requisição precisa de múltiplos joins.

Um sintoma típico no início: uma página “simples” (como histórico de pedidos) exige juntar 6–10 tabelas, e o desempenho varia conforme tráfego e cache.

Abordagem prática: normalize fatos centrais, desnormalize leituras quentes

Um equilíbrio sensato é:

- Normalize fatos centrais e propriedade (fonte da verdade). Mantenha atributos de produto em

products, nomes de categoria emcategoriese relacionamentos via chaves estrangeiras. - Desnormalize com cuidado para as leituras mais quentes—mas somente quando você souber explicar o benefício e como manter a correção.

Desnormalizar significa duplicar intencionalmente um pequeno pedaço de dados para tornar uma consulta frequente mais barata (menos joins, listas mais rápidas). A palavra-chave é cuidado: cada campo duplicado precisa de um plano para manter-se atualizado.

Exemplo: products, categories e order_items

Uma configuração normalizada pode ser:

products(id, name, price, category_id)categories(id, name)orders(id, customer_id, created_at)order_items(id, order_id, product_id, quantity, unit_price_at_purchase)

Note a sutileza: order_items armazena unit_price_at_purchase (uma forma de desnormalização) porque você precisa de precisão histórica mesmo se o preço do produto mudar depois. Essa duplicação é intencional e estável.

Se sua tela mais comum for “pedidos com resumo de itens”, você também pode desnormalizar product_name em order_items para evitar juntar products em cada listagem—mas só se estiver preparado para mantê‑lo sincronizado (ou aceitar que é um snapshot no momento da compra).

Estratégia de Índices Segue o Esquema, Não o Contrário

Índices costumam ser tratados como um botão mágico de velocidade, mas só funcionam bem quando a estrutura da tabela faz sentido. Se você ainda está renomeando colunas, dividindo tabelas ou mudando como registros se relacionam, seu conjunto de índices vai churnar também. Índices funcionam melhor quando colunas (e o modo como o app filtra/ordena por elas) estão estáveis o suficiente para você não os reconstruir toda semana.

Comece pelas perguntas que seu app faz mais

Você não precisa prever tudo, mas precisa de uma lista curta das consultas que importam mais:

- “Encontrar um usuário por email.”

- “Mostrar pedidos recentes de um cliente.”

- “Listar faturas por status, mais novas primeiro.”

Essas declarações se traduzem diretamente em quais colunas merecem um índice. Se você não consegue dizer isso em voz alta, provavelmente é um problema de clareza de esquema—não de indexação.

Índices compostos, explicados de forma simples

Um índice composto cobre mais de uma coluna. A ordem das colunas importa porque o banco pode usar o índice eficientemente da esquerda para a direita.

Por exemplo, se você costuma filtrar por customer_id e depois ordenar por created_at, um índice em (customer_id, created_at) costuma ser útil. O inverso (created_at, customer_id) pode não ajudar tanto.

Não indexe tudo

Cada índice extra tem um custo:

- Escritas mais lentas: inserts/updates precisam atualizar cada índice.

- Mais armazenamento: índices podem virar grande parte do tamanho do banco.

- Mais complexidade: índices extras complicam manutenção e tuning.

Um esquema limpo e consistente reduz o número “certo” de índices para um conjunto pequeno que bate com padrões reais de acesso—sem pagar imposto constante de escrita e armazenamento.

Desempenho de Escrita: O Custo Oculto de um Esquema Bagunçado

Trabalhe com toda a sua equipe

Escolha um plano que se encaixe, do trabalho solo a equipes empresariais.

Apps lentos nem sempre são por leituras. Muitos problemas iniciais de desempenho aparecem durante inserts e updates—cadastros, checkouts, jobs em background—porque um esquema bagunçado faz cada escrita executar trabalho extra.

Por que escritos ficam caros

Algumas escolhas de esquema multiplicam silenciosamente o custo de cada mudança:

- Linhas largas: enfiar dezenas (ou centenas) de colunas numa tabela geralmente significa linhas maiores, mais I/O e mais churn de cache—mesmo se a maioria das colunas raramente for usada.

- Índices demais: índices aceleram leituras, mas cada insert/update também atualiza cada índice.

- Triggers e cascatas: triggers podem esconder trabalho (inserts/updates extras) atrás de um

INSERTsimples. Cascatas em chaves estrangeiras podem ser corretas e úteis, mas ainda adicionam trabalho no tempo de escrita que cresce com dados relacionados.

Read‑heavy vs Write‑heavy: escolha sua dor deliberadamente

Se sua carga é read‑heavy (feeds, páginas de busca), você pode tolerar mais indexação e às vezes desnormalização seletiva. Se é write‑heavy (ingestão de eventos, telemetria, pedidos em alto volume), priorize um esquema que mantenha escritas simples e previsíveis, e só acrescente otimizações de leitura quando necessário.

Padrões iniciais que prejudicam escritas

- Logs de auditoria grandes: ótimos para compliance, evite logar snapshots gigantes a cada update.

- Tabelas de evento: append‑only escala bem, mas incham se você armazenar payloads redundantes.

- Soft deletes: convenientes, aumentam tamanho de índice e podem deixar updates/queries mais lentos se não planejados.

Mantenha escritas simples enquanto preserva histórico

Uma abordagem prática:

- Armazene “estado atual” numa tabela e histórico numa tabela append‑only separada.

- Mantenha linhas de histórico estreitas (apenas o que realmente precisa: quem/quando/o que mudou).

- Adicione índices ao histórico baseados em padrões reais de acesso (normalmente

entity_id,created_at). - Evite triggers para auditoria no início; prefira writes explícitos da aplicação para que o custo seja visível e testável.

Caminhos de escrita limpos te dão margem—e tornam otimização de consultas muito mais simples depois.

Como ORMs e APIs Amplificam Decisões de Esquema

ORMs fazem trabalho de banco parecer sem esforço: você define modelos, chama métodos e dados aparecem. O porém é que um ORM também pode esconder SQL caro até que isso doa.

ORMs: conveniência que pode mascarar padrões lentos

Dois truques comuns:

- Joins ineficientes: um

.include()ou serializador aninhado pode virar joins largos, linhas duplicadas ou sorts grandes—especialmente se relacionamentos não estiverem bem definidos. - N+1 queries: você busca 50 registros e o ORM silenciosamente executa mais 50 consultas para carregar dados relacionados. Funciona em dev e desmorona sob tráfego real.

Um esquema bem desenhado reduz a chance desses padrões surgirem e facilita detectá‑los quando acontecem.

Relacionamentos claros tornam o uso de ORM mais seguro

Quando tabelas têm chaves estrangeiras, restrições unique e NOT NULL, o ORM pode gerar consultas mais seguras e seu código pode depender de suposições consistentes.

Por exemplo, impor que orders.user_id exista (FK) e que users.email seja único previne classes inteiras de casos de borda que virariam checagens na aplicação e trabalho extra em consultas.

APIs transformam escolhas de esquema em comportamento de produto

Seu design de API é downstream do esquema:

- IDs estáveis (e tipos de chave consistentes) facilitam URLs, cache e estado no cliente.

- Paginação funciona melhor quando é possível ordenar por uma coluna monotônica indexada (frequentemente

created_at+id). - Filtragem fica previsível quando colunas representam atributos reais (não strings sobrecarregadas ou blobs JSON) e restrições mantêm valores limpos.

Faça disso um fluxo de trabalho, não uma missão de resgate

Trate decisões de esquema como engenharia de primeira classe:

- Use migrações para cada mudança, revisadas como código (/blog/migrations).

- Adicione “revisões de esquema” leves para novos endpoints: que tabelas, que chaves, que restrições, qual formato de consulta.

- Em staging, registre queries do ORM e flague padrões N+1 antes da produção (/blog/orm-performance-checks).

Se você estiver construindo rápido com um fluxo de trabalho guiado por chat (por exemplo, gerando um app React mais um backend Go/PostgreSQL em Koder.ai), ajuda tornar a “revisão de esquema” parte da conversa cedo. Você pode iterar rápido, mas ainda quer restrições, chaves e um plano de migração deliberados—especialmente antes do tráfego chegar.

Sinais de Alerta Precoce que Seu Esquema é o Gargalo

Alguns problemas de desempenho não são “SQL ruim” tanto quanto o banco lutando contra a forma dos seus dados. Se você vê os mesmos problemas em muitos endpoints e relatórios, frequentemente é um sinal de esquema, não uma oportunidade de afinar consultas.

Sintomas comuns para observar

Filtros lentos são um clássico. Se condições simples como “encontrar pedidos por cliente” ou “filtrar por data de criação” são consistentemente lentas, o problema pode ser relacionamentos faltando, tipos incompatíveis ou colunas que não podem ser indexadas eficazmente.

Outro sinal é o crescimento exponencial de joins: uma consulta que deveria juntar 2–3 tabelas acaba encadeando 6–10 tabelas só para responder uma pergunta básica (frequentemente devido a lookups sobre‑normalizados, padrões polimórficos ou designs “tudo em uma tabela”).

Também observe valores inconsistentes em colunas que se comportam como enums—especialmente campos de status (“active”, “ACTIVE”, “enabled”, “on”). Inconsistência força consultas defensivas (LOWER(), COALESCE(), cadeias de OR) que continuam lentas não importa quanto você otimize.

Checklist de esquema (rápido de verificar)

- Índices faltando em chaves estrangeiras (joins viram scans completos conforme as tabelas crescem).

- Tipos de dados errados (ex.: IDs como strings, datas como texto, dinheiro como floats).

- Tabelas EAV (Entity–Attribute–Value) usadas para dados centrais: flexíveis no começo, mas filtros/ordenadores viram muitos joins e predicados difíceis de indexar.

Diagnósticos simples e independentes de ferramenta

Comece com checagens de realidade: contagem de linhas por tabela e cardinalidade para colunas-chave (quantos valores distintos). Se uma coluna “status” tem 4 valores esperados mas você encontra 40, o esquema já está vazando complexidade.

Depois olhe planos de consulta para seus endpoints lentos. Se você ver scans sequenciais repetidos em colunas de junção ou grandes conjuntos intermediários, esquema e indexação são a raiz provável.

Por fim, habilite e revise logs de consultas lentas. Quando muitas queries diferentes estão lentas de formas semelhantes (mesmas tabelas, mesmos predicados), é geralmente um problema estrutural que vale a pena corrigir no modelo.

Evoluindo o Esquema com Segurança Conforme Você Cresce

Crie com React e Go rapidamente

Crie um app React com backend em Go e PostgreSQL a partir de uma única conversa.

Decisões de esquema raramente sobrevivem ao primeiro contato com usuários reais. O objetivo não é “acertar perfeitamente”—é mudá‑lo sem quebrar produção, perder dados ou congelar o time por dias.

Um processo leve e repetível de mudanças

Um fluxo prático que escala de um app de uma pessoa para times maiores:

- Modelar: escreva a nova forma (tabelas/colunas, relacionamentos e o que vira fonte da verdade). Inclua registros de exemplo e casos de borda.

- Migrar: adicione novas estruturas de modo retrocompatível (colunas/tabelas novas primeiro; evite remover ou renomear imediatamente).

- Backfill: popule campos novos a partir de dados existentes em batches. Rastreie progresso para poder retomar.

- Validar: adicione restrições somente depois dos dados estarem limpos (ex.: NOT NULL, chaves estrangeiras). Rode checagens que comparem outputs antigo vs novo.

Feature flags e dual writes (use com moderação)

A maioria das mudanças de esquema não precisa de rollout complexo. Prefira “expandir e contrair”: escreva código que consiga ler tanto o velho quanto o novo, então altere as escritas quando estiver confiante.

Use feature flags ou dual writes só quando realmente precisar de corte gradual (alto tráfego, backfills longos ou múltiplos serviços). Se fizer dual write, adicione monitoramento para detectar drift e defina qual lado vence em conflitos.

Rollbacks e testes de migração que reflitam a realidade

Rollbacks seguros começam com migrações reversíveis. Pratique o caminho de desfazer: dropar uma coluna é fácil; recuperar dados sobrescritos não é.

Teste migrações em volumes de dados realistas. Uma migração que leva 2 segundos num laptop pode travar tabelas por minutos em produção. Use contagens de linhas e índices parecidos com produção e meça tempo de execução.

Aqui é onde ferramentas de plataforma reduzem risco: ter deploys confiáveis, snapshots/rollback e habilidade de exportar código torna mais seguro iterar em esquema e lógica do app juntos. Se você usa Koder.ai, apoie‑se em snapshots e no modo de planejamento ao introduzir migrações que precisam de sequenciamento cuidadoso.

Documente decisões para a próxima pessoa (incluindo você no futuro)

Mantenha um log curto do esquema: o que mudou, por que e quais trade‑offs foram aceitos. Linke isso em /docs ou no README do repo. Inclua notas como “esta coluna é intencionalmente desnormalizada” ou “foreign key adicionada após backfill em 2025-01-10” para que mudanças futuras não repitam erros antigos.

Quando Otimizar Consultas (e uma Ordem Sensata de Operações)

Otimização de consultas importa—mas rende mais quando o esquema não está te atrapalhando. Se tabelas estão sem chaves claras, relacionamentos inconsistentes ou a regra “uma linha por coisa” está violada, você pode passar horas afinando consultas que serão reescritas na semana seguinte.

Uma ordem prática de prioridade

-

Corrija bloqueadores de esquema primeiro. Comece com tudo que torna a consulta correta difícil: chaves primárias ausentes, chaves estrangeiras inconsistentes, colunas que misturam significados, fontes de verdade duplicadas ou tipos que não batem com a realidade (ex.: datas como strings).

-

Estabilize padrões de acesso. Quando o modelo de dados refletir como o app se comporta (e como provavelmente se comportará nas próximas sprints), otimizar as consultas vira algo duradouro.

-

Otimize as principais queries—não todas. Use logs/APM para identificar as consultas mais lentas e frequentes. Um endpoint acessado 10.000 vezes por dia geralmente vence um relatório admin raro.

O 80/20 do ajuste de consultas inicial

A maioria dos ganhos precoces vem de um pequeno conjunto de ações:

- Adicione o índice certo para seus filtros e joins mais comuns (e confirme que ele realmente é usado).

- Retorne menos colunas (evite

SELECT *, especialmente em tabelas largas). - Evite joins desnecessários—às vezes um join existe só porque o esquema te força a “descobrir” atributos básicos.

Defina expectativas: é contínuo, mas fundações vêm primeiro

Trabalho de performance nunca acaba, mas o objetivo é torná‑lo previsível. Com um esquema limpo, cada nova feature adiciona carga incremental; com um esquema bagunçado, cada feature adiciona confusão composta.

Checklist para esta semana

- Liste as 5 queries mais lentas e as 5 mais frequentes.

- Para cada uma, confirme: chave primária presente, joins são chave‑a‑chave, e tipos estão corretos.

- Adicione um índice que corresponda ao filtro/ordem dominante.

- Substitua

SELECT *em um caminho quente. - Re‑meça e mantenha uma nota simples de “antes/depois” para a próxima sprint.