O que “Vibe Coding” vs. “Endurecimento para Produção” Realmente Significa

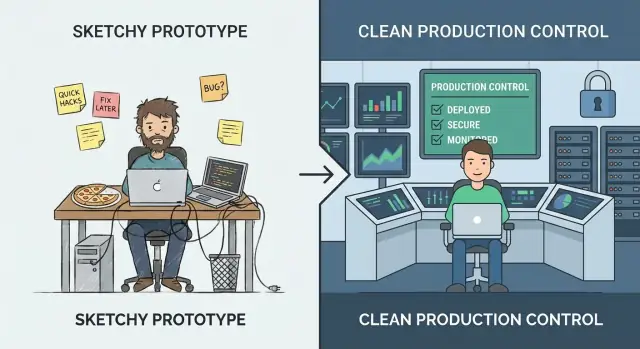

“Vibe coding” é a fase em que velocidade vence precisão. Você está experimentando, aprendendo o que os usuários realmente querem e testando ideias que podem não durar a semana. O objetivo é insight: validar um fluxo, provar uma proposição de valor ou confirmar que os dados necessários existem. Nesse modo, cantos cortados são normais—passos manuais, tratamento de erros fraco e código otimizado para chegar ao “funciona” rápido.

“Endurecimento para produção” é diferente. É o trabalho de tornar o comportamento previsível sob uso real: entradas sujas, quedas parciais, picos de tráfego e pessoas fazendo coisas que você não antecipou. Endurecer é menos sobre adicionar funcionalidades e mais sobre reduzir surpresas—para que o sistema falhe de forma segura, recupere-se limpo e seja compreensível para a próxima pessoa que tiver que operá-lo.

Trocar cedo demais vs. tarde demais

Se você endurece cedo demais, pode frear o aprendizado. Pode investir em escalabilidade, automação ou arquitetura polida para uma direção de produto que muda na semana seguinte. Isso é caro e pode fazer uma equipe pequena se sentir travada.

Se você endurece tarde demais, cria risco. Os mesmos atalhos que eram aceitáveis em uma demo se tornam incidentes perante clientes: inconsistência de dados, lacunas de segurança e downtime que danificam a confiança.

Você não precisa escolher um para sempre

Uma abordagem prática é continuar experimentando enquanto endurece a “cintura estreita” do sistema: os poucos caminhos-chave que devem ser confiáveis (cadastro, pagamentos, gravações de dados, integrações críticas). Você ainda pode iterar rapidamente em recursos periféricos—apenas não deixe suposições de protótipo governarem as partes das quais usuários reais dependem todo dia.

Aqui também é onde escolhas de ferramentas importam. Plataformas feitas para iteração rápida podem ajudar você a permanecer no modo “vibe” sem perder a capacidade de profissionalizar depois. Por exemplo, Koder.ai é projetado para vibe-coding via chat para criar apps web, backend e móveis, mas também suporta exportação de código-fonte, deploy/hosting, domínios customizados e snapshots/rollback—recursos que mapeiam diretamente para a mentalidade da “cintura estreita” (entregar rápido, mas proteger caminhos críticos e recuperar rápido).

Um Modelo Simples de Maturidade: De Demo a Confiável

Vibe coding brilha quando você está tentando aprender rápido: essa ideia funciona? O erro é supor que os mesmos hábitos aguentarão quando pessoas reais (ou processos reais de negócio) dependerem do resultado.

Os estágios que a maioria das equipes percorre

Uma forma útil de decidir o que endurecer é nomear o estágio em que você está:

- Ideia: explorando viabilidade; código descartável é aceitável.

- Demo: prova clicável/rodável; sucesso é “mostra o conceito”.

- Piloto: pequeno fluxo real; sucesso é “ajuda umas poucas pessoas de forma confiável”.

- Beta: acesso mais amplo; sucesso é “funciona na maior parte do tempo, com suporte”.

- Produção: ferramenta padrão para uma tarefa; sucesso é “é confiável, segura e mantível”.

Como os requisitos mudam quando o resultado importa

À medida que você avança, a pergunta muda de “Funciona?” para “Podemos confiar?”. Isso adiciona expectativas como desempenho previsível, tratamento claro de erros, auditabilidade e habilidade de reverter mudanças. Também obriga a definir propriedade: quem responde quando algo quebra?

A curva de custo que ninguém gosta

Bugs corrigidos durante ideia/demo são baratos porque você muda código que ninguém depende. Depois do lançamento, o mesmo bug pode gerar tempo de suporte, limpeza de dados, churn de clientes ou prazos perdidos. Endurecer não é perfeccionismo—é reduzir o raio de impacto de erros inevitáveis.

“Produção” não é só voltado ao cliente

Uma ferramenta interna que aciona faturas, roteia leads ou controla acesso já é produção se o negócio depende dela. Se uma falha pararia o trabalho, exporia dados ou criaria risco financeiro, trate como produção—mesmo que só 20 pessoas usem.

Sinais de que Você Superou a Fase de Protótipo

Um protótipo pode ser frágil. Ele prova uma ideia, abre uma conversa e ajuda você a aprender rápido. O momento em que pessoas reais começam a depender dele, o custo de “gambiarras rápidas” sobe—e os riscos mudam de inconveniente para impactante ao negócio.

Os sinais mais claros a observar

Seu público está mudando. Se o número de usuários sobe de forma constante, você adicionou clientes pagantes ou assinou algo com expectativas de uptime/resposta, você não está mais experimentando—está entregando um serviço.

Os dados ficaram mais sensíveis. No dia em que seu sistema começa a tocar PII (nomes, e-mails, endereços), dados financeiros, credenciais ou arquivos privados, você precisa de controles de acesso mais fortes, trilhas de auditoria e padrões seguros. Um protótipo pode ser “seguro o suficiente para uma demo.” Dados reais não podem.

Uso vira rotineiro ou crítico. Quando a ferramenta entra no fluxo diário de alguém—ou quando falhas bloqueiam pedidos, relatórios, onboarding ou suporte—downtime e casos de borda estranhos deixam de ser aceitáveis.

Outras equipes dependem das suas saídas. Se equipes internas constroem processos em cima dos seus dashboards, exports, webhooks ou APIs, cada mudança vira possível quebra. Você sentirá pressão para manter comportamento consistente e comunicar alterações.

Quebras se tornam recorrentes. Um fluxo constante de mensagens “quebrou”, pings no Slack e tickets de suporte indica que você gasta mais tempo reagindo do que aprendendo. Esse é seu sinal para investir em estabilidade ao invés de mais recursos.

Um checape rápido de intuição

Se uma hora de indisponibilidade seria embaraçosa, você está perto da produção. Se seria cara—perda de receita, promessas quebradas ou confiança abalada—you já está lá.

Se você está discutindo se o app está “pronto”, está fazendo a pergunta errada. A pergunta melhor é: qual o custo de estar errado? Endurecer para produção não é troféu—é resposta ao risco.

Comece definindo “falha” em termos simples

Anote como falha parece para seu sistema. Categorias comuns:

- Indisponibilidade: o serviço não pode ser usado

- Resultados errados: roda, mas produz saídas incorretas (às vezes pior que indisponibilidade)

- Respostas lentas: usuários abandonam tarefas, automações expiram, tickets de suporte subem

Seja específico. “Busca demora 12s para 20% dos usuários no pico” é acionável; “problemas de performance” não é.

Estime impacto no negócio (mesmo que por cima)

Você não precisa de números perfeitos—use faixas.

- Receita: vendas perdidas, renovações perdidas, penalidades de SLA

- Churn e confiança: usuários que não voltam após má experiência

- Perda de produtividade: times internos bloqueados, workarounds manuais

- Compliance: achados em auditoria, quebras contratuais, obrigações de reporte

Se o impacto é difícil de quantificar, pergunte: Quem recebe o pager? Quem pede desculpas? Quem paga?

Liste os principais riscos que você carrega

A maioria das falhas de protótipo→produção se agrupa em alguns buckets:

- Perda ou corrupção de dados (sem backups, migrações inseguras, controles de acesso fracos)

- Brecha de segurança (tokens expostos, permissões amplas, endpoints expostos)

- Automação incorreta (ações de LLMs ou scripts que fazem a mudança errada em escala)

Rankeie riscos por probabilidade × impacto. Isso vira seu roadmap de hardening.

Evite perfeição. Escolha alvo que combine com os riscos atuais—ex.: “disponibilidade durante horário comercial”, “99% de sucesso para fluxos centrais” ou “recuperar em 1 hora.” À medida que uso e dependência crescem, eleve a meta deliberadamente em vez de reagir em pânico.

“Endurecer para produção” costuma falhar por motivo simples: ninguém consegue dizer quem é responsável pelo sistema ponta-a-ponta, e ninguém sabe o que significa “pronto”.

Antes de adicionar rate limits, testes de carga ou nova pilha de logging, garanta dois básicos: propriedade e escopo. Eles transformam um projeto de engenharia aberto em um conjunto manejável de compromissos.

Nomeie um Dono (ponta-a-ponta)

Anote quem possui o sistema ponta-a-ponta—não apenas o código. O dono é responsável por disponibilidade, qualidade de dados, releases e impacto no usuário. Isso não significa que ele faz tudo; significa que toma decisões, coordena trabalho e garante que alguém esteja à frente quando algo quebra.

Se propriedade é compartilhada, ainda nomeie um primário: uma pessoa/time que possa dizer “sim/não” e manter prioridades consistentes.

Defina Caminhos Críticos Primeiro

Identifique jornadas de usuário primárias e caminhos críticos. São fluxos onde a falha cria dano real: signup/login, checkout, envio de mensagem, importação de dados, geração de relatório, etc.

Com os caminhos críticos definidos, você pode endurecer seletivamente:

- Estabeleça metas de confiabilidade ao redor desses caminhos primeiro.

- Decida quais dados nunca podem ser perdidos.

- Escolha poucas métricas que definem “funcionando”.

Defina Escopo para Evitar Hardening Sem Fim

Documente o que está em escopo agora vs. depois para evitar endurecer infinitamente. Prontidão para produção não é “software perfeito”; é “seguro o suficiente para este público, com limites conhecidos.” Seja explícito sobre o que você não está suportando ainda (regiões, browsers, pico de tráfego, integrações).

Comece um Esqueleto de Runbook

Crie um runbook leve: como fazer deploy, rollback, debug. Mantenha curto e usável às 2h da manhã—uma checklist, dashboards chave, modos comuns de falha e quem contatar. Você pode evoluir com o tempo, mas não dá para improvisar no primeiro incidente.

Confiabilidade: Torne o Sistema Previsível Sob Carga

Confiabilidade não é tornar falhas impossíveis—é tornar o comportamento previsível quando algo dá errado ou quando há muita carga. Protótipos muitas vezes “funcionam na minha máquina” porque o tráfego é baixo, entradas são amistosas e ninguém está batendo no mesmo endpoint simultaneamente.

Coloque guardrails em cada requisição

Comece com defesas chatas e de alto impacto:

- Validação de entrada nas bordas (API, formulários UI, payloads de webhook). Rejeite dados ruins cedo com mensagem de erro clara.

- Timeouts em toda chamada lenta ou externa (bancos, APIs de terceiros, filas). Falta de timeout transforma um pequeno hiccup em acúmulo.

- Retentativas, com cuidado: só para operações seguras, use backoff exponencial + jitter e limite tentativas. Retentativas cegas amplificam quedas.

- Circuit breakers para parar de chamar dependências que estão falhando e recuperar automaticamente quando estabilizam.

Quando o sistema não pode fazer o trabalho completo, deve ainda fazer o trabalho mais seguro. Isso pode significar servir um valor em cache, desabilitar funcionalidade não crítica ou retornar um “tente novamente” com um request ID. Prefira degradação graciosa ao invés de gravações parciais silenciosas ou erros genéricos confusos.

Concorrência e idempotência não são opcionais

Sob carga, requisições duplicadas e jobs sobrepostos acontecem (double-clicks, retries de rede, redelivery de fila). Projete para isso:

- Torne ações chave idempotentes (mesma requisição processada duas vezes gera mesmo resultado).

- Use locks ou concorrência otimista quando necessário para evitar condições de corrida.

Proteja a integridade dos dados

Confiabilidade inclui “não corromper dados.” Use transações para gravações multi-etapas, adicione restrições (chaves únicas, foreign keys) e pratique disciplina de migração (mudanças compatíveis com versões anteriores, rollouts testados).

Imponha limites de recurso

Defina limites em CPU, memória, pools de conexão, tamanhos de filas e payloads de requisição. Sem limites, um tenant barulhento—ou uma query ruim—pode starve tudo o mais.

Segurança: Barra Mínima Antes de Usuários Reais

Endurecer segurança não significa transformar protótipo em fortaleza. Significa atingir um padrão mínimo onde um erro normal—um link exposto, um token vazado, um usuário curioso—não vira incidente com impacto ao cliente.

Se você tem “um ambiente”, tem um raio de explosão só. Crie dev/staging/prod separados com segredos minimamente compartilhados. Staging deve ser próximo o suficiente da produção para revelar problemas, mas não deve reutilizar credenciais de produção ou dados sensíveis.

Autenticação e autorização (authn/authz)

Muitos protótipos ficam em “login funciona”. Produção precisa de menor privilégio:

- Defina papéis claros (ex.: admin, suporte, usuário padrão) e aplique limites no servidor.

- Tranque ferramentas internas e endpoints admin.

- Mantenha trilhas de auditoria para ações sensíveis (login, reset de senha, mudanças de papel, exports, deletes). Você não precisa de analytics perfeitos—apenas o suficiente para responder “quem fez o quê, e quando?”

Gestão de segredos: tire chaves do código e dos logs

Mova chaves API, senhas de BD e segredos de assinatura para um gerenciador de segredos ou variáveis de ambiente seguras. Depois garanta que não vazem:

- Não imprima tokens nos logs da aplicação.

- Evite enviar segredos para código cliente.

- Roteie qualquer credencial que já foi comprometida no repo.

Ameaças que valem priorizar cedo

Você terá mais valor ao atacar alguns vetores comuns:

- Injeção (SQL/command): use queries parametrizadas e bibliotecas seguras.

- Controle de acesso quebrado: verifique permissões em toda requisição, não apenas na UI.

- Exposição de dados: criptografe em trânsito, limite dados retornados por padrão e evite exports amplos.

Plano de atualização para dependências

Decida quem é dono das atualizações e com que frequência você faz patch. Um plano simples (checagem semanal + upgrades mensais, fixes urgentes em 24–72h) vence o “a gente faz mais tarde”.

Testes: Pegue Quebras Antes dos Clientes

Testes transformam “funciona na minha máquina” em “continua funcionando para clientes.” O objetivo não é cobertura perfeita—é confiança nos comportamentos que seriam mais caros de quebrar: billing, integridade de dados, permissões, fluxos-chave e qualquer coisa difícil de debugar em produção.

Uma pirâmide prática costuma ser:

- Testes unitários para lógica pura (rápidos, muitos)

- Testes de integração para bordas (DB, filas, APIs de terceiros atrás de mocks)

- E2E para alguns fluxos críticos de usuário (lentos, mantenha mínimos)

Se seu app é basicamente API + banco, incline-se mais aos testes de integração. Se é UI-heavy, mantenha um pequeno conjunto de fluxos E2E que espelhem como usuários têm sucesso (e falham).

Testes de regressão onde dói mais

Quando um bug custa tempo, dinheiro ou confiança, adicione um teste de regressão imediatamente. Priorize comportamentos como “cliente não consegue finalizar compra”, “job cobra em dobro” ou “update corrompe registros”. Isso cria uma rede de segurança crescente ao redor das áreas de maior risco em vez de espalhar testes por todo lado.

Testes de integração devem ser determinísticos. Use fixtures e dados seed para que execuções não dependam do que está no banco dev. Resete estado entre testes e mantenha dados de teste pequenos, porém representativos.

Você não precisa de um programa completo de load testing ainda, mas deve ter checagens rápidas de performance para endpoints e jobs chave. Um teste de fumaça com thresholds simples (ex.: p95 < X ms com pequena concorrência) pega regressões óbvias cedo.

Automatize checagens no CI

Toda mudança deve rodar portões automáticos:

- linting e formatação

- checagens de tipo (se aplicável)

- suíte unitária + de integração

- scans básicos de segurança (vulnerabilidades de dependência)

Se testes não forem automáticos, são opcionais—e produção eventualmente provará isso.

Observabilidade: Saber o Que Está Acontecendo sem Chutar

Quando um protótipo quebra, normalmente você pode “tentar de novo”. Em produção, esse palpite vira downtime, churn e noites longas. Observabilidade encurta o tempo entre “algo parece errado” e “aqui está exatamente o que mudou, onde e quem é impactado.”

Logue o que importa, não tudo. Você quer contexto suficiente para reproduzir um problema sem despejar dados sensíveis.

- Inclua um request ID em cada requisição e carregue-o por todo o sistema.

- Adicione identificadores de usuário/sessão de forma segura (hash ou IDs internos; nunca senhas, dados de pagamento ou segredos crus).

- Registre resultados: sucesso/falha, códigos de status e razões de erro significativas.

Uma boa regra: cada log de erro deve tornar óbvio o que falhou e o que checar a seguir.

Meça os “sinais dourados”

Métricas dão pulso ao vivo. No mínimo, meça os sinais dourados:

- Latência (quão lento)

- Erros (quão quebrado)

- Tráfego (quão grande)

- Saturação (quão perto da capacidade)

Essas métricas ajudam a diferenciar “mais usuários” de “algo está errado”.

Adicione tracing quando requisições cruzam fronteiras

Se uma ação de usuário dispara múltiplos serviços, filas ou chamadas externas, tracing transforma mistério em linha do tempo. Mesmo tracing distribuído básico mostra onde o tempo é gasto e qual dependência está falhando.

Alertas devem ser acionáveis, não barulhentos

Spam de alertas acostuma as pessoas a ignorar. Defina:

- Quais condições merecem pager (impacto visível ao usuário)

- Quem está on-call e tempos de resposta esperados

- Como “bom” parece (thresholds ligados a SLAs/SLOs)

Um dashboard que responde as três grandes

Monte um dashboard simples que responda instantaneamente: Está fora do ar? Está lento? Por quê? Se não responde, é decoração—não operações.

Releases e Operações: Entregar Mudanças sem Drama

Endurecer não é só qualidade de código—é também como você muda o sistema quando pessoas dependem dele. Protótipos toleram “push para main e torcer”. Produção não.

Padronize builds e deploys (CI/CD)

Faça builds e deploys repetíveis, scriptados e enfadonhos. Um pipeline CI/CD simples deve: rodar checagens, construir o artefato do mesmo jeito sempre, deployar para um ambiente conhecido e registrar exatamente o que mudou.

O ganho é consistência: você pode reproduzir um release, comparar versões e evitar surpresas de “funciona na minha máquina”.

Feature flags separam deploy (colocar código em produção) de release (ligar para usuários). Assim você pode entregar mudanças pequenas frequentemente, habilitar gradualmente e desligar rápido se algo falhar.

Mantenha flags disciplinadas: nomeie claramente, tenha responsáveis e remova quando o experimento acabar. Flags “misteriosas permanentes” viram risco operacional.

Defina rollback—e pratique

Uma estratégia de rollback só é real se você a testou. Decida o que “rollback” significa para seu sistema:

- Redeploy da versão anterior?

- Desligar uma feature flag?

- Avançar com um fix?

- Restaurar dados de backups (lento, arriscado, às vezes necessário)?

Depois ensaie em ambiente seguro. Meça o tempo e documente passos exatos. Se rollback exige um especialista de férias, não é estratégia.

Se sua plataforma já suporta reversão segura, aproveite. Por exemplo, snapshots e workflow de rollback do Koder.ai podem transformar “estancar a hemorragia” em ação repetível enquanto você mantém iteração rápida.

Versione APIs e registre mudanças em dados

Quando outros sistemas ou clientes dependem de suas interfaces, mudanças precisam de guardrails.

Para APIs: introduza versionamento (mesmo um simples /v1) e publique changelog para consumidores entenderem diferenças e prazos.

Para mudanças de dados/esquema: trate como releases. Prefira migrações compatíveis (adicione campos antes de remover os antigos) e documente junto com releases de aplicação.

Noções básicas de capacidade: quotas, rate limits, thresholds de escalonamento

“Funcionou ontem” frequentemente quebra porque tráfego, jobs em lote ou uso do cliente cresceram.

Defina proteções e expectativas básicas:

- Quotas e rate limits para evitar que um usuário/tenant sobrecarregue o sistema

- Thresholds de escalonamento claros (CPU, profundidade de fila, latência) que disparem ações

- Um plano leve para quando bater nos limites (throttle, shed load, ou scale)

Feito direito, disciplina de release e operações faz o deploy parecer seguro—mesmo quando você se move rápido.

Incidentes: Prepare-se para o Primeiro Dia Ruim

Incidentes são inevitáveis quando usuários reais dependem do sistema. A diferença entre “um dia ruim” e “uma crise de negócio” é decidir—antes—quem faz o quê, como comunicar e como aprender.

Checklist de incidente leve

Mantenha isso como doc curto e acessível (pino no Slack, link no README ou em /runbooks). Um checklist prático cobre:

- Identificar: confirmar impacto, hora de início, usuários afetados e sintomas atuais.

- Mitigar: estancar a hemorragia primeiro (rollback, desativar feature flag, escalar, failover).

- Comunicar: um dono posta atualizações em cadência definida (ex.: a cada 15–30 minutos) para stakeholders internos e, se necessário, clientes.

- Aprender: registre o ocorrido enquanto está fresco; agende postmortem.

Postmortems sem culpa

Escreva postmortems focando em consertos, não culpa. Bons postmortems geram follow-ups concretos: alerta ausente → adicionar alerta; propriedade obscura → atribuir on-call; deploy arriscado → adicionar canary. Mantenha tom factual e facilite contribuições.

Rastreie repetições explicitamente: o mesmo timeout toda semana não é “azar”, é item de backlog. Mantenha lista de problemas recorrentes e converta os maiores em trabalho planejado com donos e prazos.

Defina SLAs/SLOs só quando estiver pronto para medir e manter. Se ainda não tem monitoramento consistente e alguém responsável por resposta, comece com metas internas e alertas básicos; formalize promessas depois.

Checklist prático de decisão e próximos passos

Você não precisa endurecer tudo de uma vez. Precisa endurecer partes que podem ferir usuários, dinheiro ou reputação—e manter o resto flexível para continuar aprendendo.

Deve endurecer agora (caminhos críticos)

Se algum destes está na jornada do usuário, trate como “caminho de produção” e endureça antes de ampliar acesso:

- Auth & permissões: login, reset de senha, checagens de papel, exclusão de conta.

- Dinheiro & compromissos: billing, reembolsos, mudanças de plano, checkout, faturas.

- Integridade de dados: gravações de registros primários, idempotência, migrações, backups/restore.

- Confiabilidade voltada ao usuário: timeouts de requisição, retries, rate limits, degradação graciosa.

- Noções básicas de segurança: manejo de segredos, menor privilégio, validação de entradas, trilha de auditoria para ações sensíveis.

- Noções operacionais: monitoramento de SLIs chave (taxa de erro, latência, saturação), alertas que paginam humano, runbooks para modos de falha tops.

Pode continuar vibey (por enquanto)

Mantenha leves enquanto você busca product–market fit:

- Ferramentas internas usadas por pequena equipe treinada.

- Experimentos e protótipos descartáveis atrás de feature flags.

- Aparência da UI que não altera fluxos centrais.

- Automações não críticas com fallbacks manuais fáceis.

Tente 1–2 semanas focadas apenas no caminho crítico. Critérios de saída devem ser concretos:

- Fluxos principais têm testes básicos e uma execução de teste repetível.

- Dashboards + alertas existem para os fluxos que importam.

- Rollback ou deploy seguro está provado (mesmo que manual).

- Riscos conhecidos estão documentados com dono e plano de mitigação.

Portas simples de go/no-go

- Gate de lançamento (acesso limitado): “Detectamos falhas rápido, estancamos a hemorragia e protegemos dados.”

- Gate de expansão (mais usuários/tráfego): “Conseguimos lidar com aumentos previsíveis de carga e recuperar de deploy ruim sem heroísmo.”

Uma cadência sustentável

Para evitar oscilar entre caos e over-engineering, alterne:

- Semanas de experimento: entregar mudanças focadas em aprendizado rápido.

- Semanas de estabilização: pagar dívida de confiabilidade/segurança/testes descoberta durante experimentos.

Se quiser uma versão de uma página, transforme os bullets acima em checklist e revise em cada lançamento ou ampliação de acesso.