05 de out. de 2025·8 min

RabbitMQ para suas aplicações: padrões, configuração e operações

Aprenda a usar RabbitMQ nas suas aplicações: conceitos centrais, padrões comuns, dicas de confiabilidade, escala, segurança e monitoramento para produção.

Aprenda a usar RabbitMQ nas suas aplicações: conceitos centrais, padrões comuns, dicas de confiabilidade, escala, segurança e monitoramento para produção.

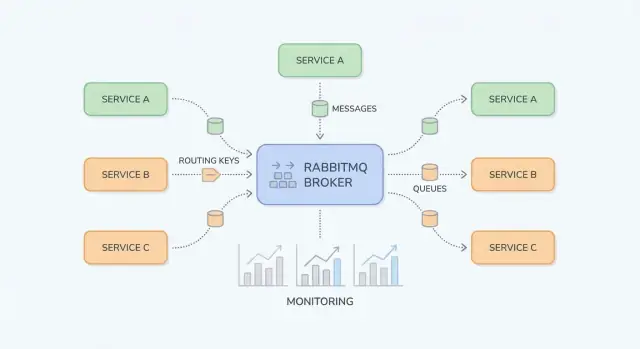

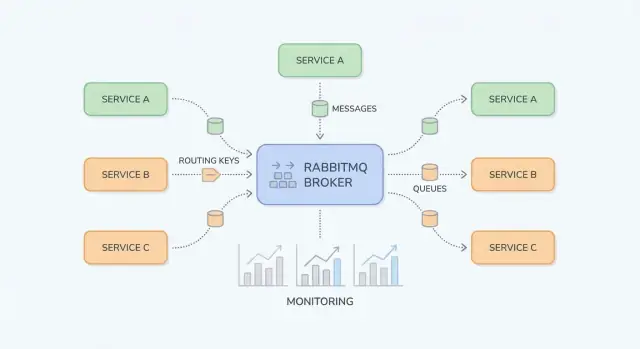

RabbitMQ é um broker de mensagens: ele fica entre partes do seu sistema e move de forma confiável “trabalho” (mensagens) de produtores para consumidores. Equipes de aplicação normalmente recorrem a ele quando chamadas diretas e síncronas (HTTP entre serviços, bancos de dados compartilhados, cron jobs) começam a criar dependências frágeis, carga desigual e cadeias de falha difíceis de depurar.

Picos de tráfego e cargas desiguais. Se sua aplicação recebe 10× mais cadastros ou pedidos em uma janela curta, processar tudo imediatamente pode sobrecarregar serviços a jusante. Com RabbitMQ, os produtores enfileiram tarefas rapidamente e os consumidores as processam em um ritmo controlado.

Acoplamento apertado entre serviços. Quando o Serviço A precisa chamar o Serviço B e esperar, falhas e latência se propagam. Mensageria os desacopla: A publica uma mensagem e segue; B processa quando estiver disponível.

Tratamento de falhas mais seguro. Nem toda falha deve virar um erro mostrado ao usuário. RabbitMQ ajuda a tentar novamente o processamento em segundo plano, isolar mensagens “venenosas” e evitar perda de trabalho durante quedas temporárias.

As equipes geralmente obtêm fluxos de trabalho mais suaves (amortecendo picos), serviços desacoplados (menos dependências em tempo de execução) e retries controlados (menos reprocesamento manual). Igualmente importante, fica mais fácil raciocinar sobre onde o trabalho está preso — no produtor, em uma fila ou no consumidor.

Este guia foca em RabbitMQ prático para equipes de aplicação: conceitos centrais, padrões comuns (pub/sub, work queues, retries e dead-letter queues) e preocupações operacionais (segurança, escala, observabilidade, troubleshooting).

Ele não pretende ser um walkthrough completo da especificação AMQP nem um mergulho em todos os plugins do RabbitMQ. O objetivo é ajudá-lo a projetar fluxos de mensagens que permaneçam manejáveis em sistemas reais.

RabbitMQ é um broker de mensagens que roteia mensagens entre partes do seu sistema, de modo que produtores podem delegar trabalho e consumidores podem processá-lo quando estiverem prontos.

Com uma chamada HTTP direta, o Serviço A envia uma requisição ao Serviço B e normalmente espera por uma resposta. Se o Serviço B está lento ou indisponível, o Serviço A falha ou fica bloqueado, e você precisa lidar com timeouts, retries e backpressure em todo chamador.

Com RabbitMQ (comumente via AMQP), o Serviço A publica uma mensagem no broker. O RabbitMQ armazena e roteia para a(s) fila(s) correta(s), e o Serviço B consome de forma assíncrona. A diferença chave é que você se comunica através de uma camada intermediária durável que tamponiza picos e suaviza cargas desiguais.

Mensageria é uma boa escolha quando você:

Mensageria é uma má escolha quando você:

Síncrono (HTTP):

Um serviço de checkout chama um serviço de fatura via HTTP: “Crie fatura.” O usuário espera enquanto a geração da fatura ocorre. Se a faturação está lenta, a latência do checkout aumenta; se está down, o checkout falha.

Assíncrono (RabbitMQ):

O checkout publica invoice.requested com o id do pedido. O usuário recebe confirmação imediata de que o pedido foi recebido. A faturação consome a mensagem, gera a fatura e, então, publica invoice.created para que e-mail/notificações realizem o envio. Cada etapa pode re- tentar independentemente e quedas temporárias não quebram automaticamente o fluxo inteiro.

RabbitMQ é mais fácil de entender se você separar “onde as mensagens são publicadas” de “onde as mensagens são armazenadas”. Produtores publicam em exchanges; exchanges roteiam para filas; consumidores leem das filas.

Uma exchange não armazena mensagens. Ela avalia regras e encaminha mensagens para uma ou mais filas.

billing ou email).region=eu E tier=premium), mas reserve para casos especiais pois é mais difícil de raciocinar.Uma fila é onde mensagens ficam até que um consumidor as processe. Uma fila pode ter um ou muitos consumidores (consumidores competidores), e mensagens tipicamente são entregues a um consumidor por vez.

Um binding conecta uma exchange a uma fila e define a regra de roteamento. Pense assim: “Quando uma mensagem atingir a exchange X com routing key Y, entregue-a na fila Q.” Você pode ligar múltiplas filas à mesma exchange (pub/sub) ou ligar uma única fila várias vezes para diferentes routing keys.

Para direct exchanges, o roteamento é exato. Para topic exchanges, as routing keys se parecem com palavras separadas por ponto, por exemplo:

orders.createdorders.eu.refundedBindings podem incluir curingas:

* corresponde exatamente a uma palavra (ex.: orders.* casa com orders.created)# corresponde a zero ou mais palavras (ex.: orders.# casa com orders.created e orders.eu.refunded)Isso dá uma maneira limpa de adicionar novos consumidores sem mudar produtores — crie uma nova fila e ligue-a com o padrão necessário.

Depois que o RabbitMQ entrega uma mensagem, o consumidor reporta o que aconteceu:

Cuidado com requeue: uma mensagem que sempre falha pode girar em loop e bloquear a fila. Muitas equipes combinam nacks com estratégia de retries e uma dead-letter queue (coberta abaixo) para que falhas sejam tratadas de forma previsível.

RabbitMQ brilha quando você precisa mover trabalho ou notificações entre partes do sistema sem fazer tudo esperar por uma etapa lenta. Abaixo estão padrões práticos que surgem em produtos do dia a dia.

Quando múltiplos consumidores devem reagir ao mesmo evento — sem que o publicador saiba quem são — pub/sub é uma escolha limpa.

Exemplo: quando um usuário atualiza o perfil, você pode notificar indexação de busca, analytics e sincronização com CRM em paralelo. Com uma fanout exchange você broadcast para todas as filas ligadas; com uma topic exchange você roteia seletivamente (ex.: user.updated, user.deleted). Isso evita acoplamento rígido e permite que equipes adicionem novos assinantes sem mudar o produtor.

Se uma tarefa leva tempo, empurre para uma fila e deixe workers processarem de forma assíncrona:

Isso mantém requisições web rápidas enquanto permite escalar workers independentemente. Também é uma forma natural de controlar concorrência: a fila vira sua “lista de afazeres” e o número de workers, o “botão de vazão”.

Muitos fluxos de trabalho cruzam fronteiras de serviço: order → billing → shipping é o exemplo clássico. Em vez de um serviço chamar o próximo e bloquear, cada serviço pode publicar um evento ao terminar sua etapa. Serviços a jusante consomem eventos e continuam o fluxo.

Isso melhora resiliência (uma queda temporária no shipping não quebra o checkout) e deixa a ownership mais clara: cada serviço reage a eventos que lhe interessam.

RabbitMQ é também um buffer entre sua aplicação e dependências lentas/flaky (APIs de terceiros, sistemas legados, bancos em batch). Você enfileira requisições rapidamente e as processa com retries controlados. Se a dependência estiver down, o trabalho se acumula com segurança e é drenado depois — em vez de causar timeouts por toda a aplicação.

Se planeja introduzir filas gradualmente, um pequeno “outbox assíncrono” ou uma fila única de background jobs é um bom primeiro passo (veja /blog/next-steps-rollout-plan).

Uma configuração RabbitMQ permanece agradável quando rotas são previsíveis, nomes são consistentes e payloads evoluem sem quebrar consumidores antigos. Antes de adicionar outra fila, certifique-se de que a “história” de uma mensagem seja óbvia: onde ela se origina, como é roteada e como um colega pode depurá-la fim-a-fim.

Escolher a exchange certa reduz bindings únicos e fan-outs-surpresa:

billing.invoice.created).billing.*.created, *.invoice.*). É a escolha mais comum para roteamento estilo evento sustentável.Uma boa regra: se você está “inventando” lógica complexa de roteamento em código, talvez ela deva estar em um topic exchange em vez disso.

Trate corpos de mensagem como APIs públicas. Use versionamento explícito (por exemplo, um campo no topo schema_version: 2) e busque compatibilidade retroativa:

Isso mantém consumidores antigos funcionando enquanto novos adotam a nova versão no seu próprio ritmo.

Torne o troubleshooting barato padronizando metadados:

correlation_id: liga comandos/eventos que pertencem à mesma ação de negócio.trace_id (ou traceparent W3C): conecta mensagens ao tracing distribuído através de HTTP e fluxos assíncronos.Quando todo publicador define esses campos consistentemente, você pode seguir uma única transação por vários serviços sem adivinhações.

Use nomes previsíveis e pesquisáveis. Um padrão comum:

<domínio>.<tipo> (ex.: billing.events)<domínio>.<entidade>.<verbo> (ex.: billing.invoice.created)<serviço>.<propósito> (ex.: reporting.invoice_created.worker)Consistência vence esperteza: o futuro você (e seu time de plantão) agradecerá.

Mensageria confiável é principalmente planejar para falhas: consumidores caem, APIs a jusante time-outam e alguns eventos são simplesmente malformados. RabbitMQ fornece as ferramentas, mas seu código precisa cooperar.

Uma configuração comum é at-least-once: uma mensagem pode ser entregue mais de uma vez, mas não deve ser perdida silenciosamente. Isso normalmente ocorre quando um consumidor recebe uma mensagem, começa o trabalho e então falha antes de dar ack — o RabbitMQ reencaminhará.

A lição prática: duplicatas são normais, então seu handler deve ser seguro para rodar múltiplas vezes.

Idempotência significa “processar a mesma mensagem duas vezes tem o mesmo efeito que processá-la uma vez”. Abordagens úteis incluem:

message_id estável (ou chave de negócio como order_id + event_type + version) e armazene em uma tabela/cache de “processados” com TTL.PENDING) ou restrições de unicidade no banco para evitar criações duplicadas.Retries funcionam melhor como um fluxo separado, não como um loop apertado no consumidor.

Um padrão comum é:

Isso cria backoff sem manter mensagens “presas” como não confirmadas.

Algumas mensagens nunca vão ter sucesso (schema inválido, dados referenciados ausentes, bug de código). Detecte-as por:

Roteie essas para uma DLQ para quarentena. Trate a DLQ como uma caixa operacional: inspecione payloads, corrija o problema subjacente e então reproduza manualmente mensagens selecionadas (idealmente por uma ferramenta/script controlado) em vez de devolver tudo automaticamente à fila principal.

O desempenho do RabbitMQ normalmente é limitado por alguns fatores práticos: como você gerencia conexões, a velocidade com que consumidores processam trabalho e se filas estão sendo usadas como “armazenamento”. O objetivo é vazão estável sem construir backlog crescente.

Um erro comum é abrir uma nova conexão TCP para cada publisher ou consumidor. Conexões são mais pesadas do que parecem (handshakes, heartbeats, TLS), então mantenha-as de longa duração e reaproveite.

Use canais para multiplexar trabalho sobre um número menor de conexões. Regra prática: poucas conexões, muitos canais. Ainda assim, não crie milhares de canais sem critério — cada canal tem overhead e sua biblioteca cliente pode ter limites. Prefira um pequeno pool de canais por serviço e reuse canais para publicar.

Se consumidores puxam mensagens demais de uma vez, você verá picos de memória, tempos longos de processamento e latência desigual. Defina um prefetch (QoS) para que cada consumidor segure um número controlado de mensagens não acked.

Orientações práticas:

Mensagens grandes reduzem throughput e aumentam pressão de memória (em publishers, broker e consumidores). Se seu payload é grande (documentos, imagens, JSONs enormes), considere armazená-lo em outro lugar (object storage ou banco) e enviar apenas um ID + metadados pelo RabbitMQ.

Uma heurística útil: mantenha mensagens na ordem de KB, não MB.

Crescimento de fila é um sintoma, não uma estratégia. Aplique backpressure para que produtores desacelerem quando consumidores não conseguem seguir o ritmo:

Em dúvida, mude um controle por vez e meça: taxa de publicação, taxa de ack, comprimento da fila e latência fim-a-fim.

Segurança para RabbitMQ é em grande parte reforçar as “bordas”: como clientes se conectam, quem pode fazer o quê e como manter credenciais longe de lugares errados. Use este checklist como base e adapte às suas exigências de compliance.

Permissões do RabbitMQ são poderosas quando usadas de forma consistente.

Para hardening operacional (portas, firewalls e auditoria), mantenha um runbook interno curto e linke-o a partir de /docs/security para que as equipes sigam um padrão único.

Quando RabbitMQ se comporta mal, sintomas aparecem primeiro na aplicação: endpoints lentos, timeouts, atualizações faltando ou jobs que “nunca terminam”. Boa observabilidade permite confirmar se o broker é a causa, identificar o gargalo (publicador, broker ou consumidor) e agir antes que usuários notem.

Comece com um conjunto pequeno de sinais que mostram se as mensagens estão fluindo.

Alerta em tendências, não apenas em thresholds absolutos.

Logs do broker ajudam a separar “RabbitMQ caiu” de “clientes estão usando errado”. Procure falhas de autenticação, conexões bloqueadas (resource alarms) e erros frequentes de canal. No lado da aplicação, garanta que cada tentativa de processamento logue um correlation ID, nome da fila e resultado (acked, rejected, retried).

Se usar tracing distribuído, propague cabeçalhos de trace através das propriedades da mensagem para conectar “requisição API → mensagem publicada → trabalho do consumidor”.

Crie um dashboard por fluxo crítico: taxa de publicação, taxa de ack, profundidade, unacked, requeues e contagem de consumidores. Adicione links diretos no dashboard para seu runbook interno, ex.: /docs/monitoring, e uma checklist “o que checar primeiro” para quem estiver de plantão.

Quando algo “simplesmente para de andar” no RabbitMQ, resista ao impulso de reiniciar primeiro. A maioria dos problemas vira óbvia assim que você olha para (1) bindings e roteamento, (2) saúde dos consumidores e (3) alarms de recurso.

Se publishers reportam “enviado com sucesso” mas filas ficam vazias (ou a fila errada enche), verifique o roteamento antes do código.

Comece na UI de Management:

topic).Se a fila tem mensagens mas ninguém consome, confirme:

Duplicatas vêm tipicamente de retries (consumidor cai após processamento mas antes do ack), interrupções de rede ou requeues manuais. Mitigue tornando handlers idempotentes (por ex., dedupe por message ID no banco).

Entrega fora de ordem é esperado quando há múltiplos consumidores ou requeues. Se ordem importa, use um único consumidor para essa fila ou particione por chave em múltiplas filas.

Alarms significam que RabbitMQ está se protegendo.

Antes de reproduzir, corrija a causa-raiz e previna loops de mensagem venenosa. Re-enfileire em pequenos lotes, adicione um limite de retries e marque falhas com metadata (contagem de tentativas, último erro). Considere enviar mensagens reexecutadas a uma fila separada primeiro, para poder parar rapidamente se o erro repetir.

Escolher uma ferramenta de mensageria é mais sobre casar padrão de tráfego, tolerância a falhas e conforto operacional do que sobre “o melhor”.

RabbitMQ brilha quando você precisa de entrega confiável de mensagens e roteamento flexível entre componentes de aplicação. É uma boa escolha para workflows assíncronos clássicos — comandos, jobs em background, notificações fan-out e padrões request/response — especialmente quando você precisa:

Se suas aplicações são orientadas a eventos mas o objetivo principal é mover trabalho em vez de manter um longo histórico de eventos, RabbitMQ é frequentemente um default confortável.

Kafka e plataformas similares são construídas para streaming de alto throughput e logs de evento de longa retenção. Escolha um sistema tipo Kafka quando precisar de:

Compromisso: sistemas estilo Kafka podem ter maior overhead operacional e forçar designs orientados a throughput (batching, estratégia de particionamento). RabbitMQ tende a ser mais fácil para throughput baixo-médio com latência fim-a-fim menor e roteamento complexo.

Se você tem um app produzindo jobs e um pool de workers consumindo — e está satisfeito com semântica simples — uma fila baseada em Redis (ou um serviço gerenciado de task queue) pode ser suficiente. Equipes normalmente superam essa solução quando precisam de garantias mais fortes de entrega, dead-lettering, múltiplos padrões de roteamento ou separação clara entre produtores e consumidores.

Projete contratos de mensagem como se você pudesse migrar depois:

Se mais tarde precisar de streams reprocessáveis, você pode espelhar eventos do RabbitMQ para um sistema log-based enquanto mantém RabbitMQ para workflows operacionais. Para um plano de rollout prático, veja /blog/rabbitmq-rollout-plan-and-checklist.

Implantar RabbitMQ funciona melhor quando você o trata como um produto: comece pequeno, defina propriedade e prove confiabilidade antes de expandir para mais serviços.

Escolha um fluxo que se beneficie de processamento assíncrono (ex.: envio de e-mails, geração de relatórios, sincronização com API externa).

Se precisar de um template de referência para nomes, tiers de retry e políticas básicas, centralize em /docs.

À medida que implementar esses padrões, considere padronizar o scaffolding entre equipes. Por exemplo, times usando Koder.ai frequentemente geram um esqueleto pequeno de produtor/consumidor a partir de um prompt de chat (incluindo convenções de nomes, wiring de retry/DLQ e cabeçalhos de trace/correlation), exportam o código para revisão e iteram em "planning mode" antes do rollout.

RabbitMQ funciona quando “alguém é dono da fila”. Decida isso antes de ir para produção:

Se estiver formalizando suporte ou hospedagem gerenciada, alinhe expectativas cedo (veja /pricing) e defina um canal de contato para incidentes e onboarding em /contact.

Execute exercícios pequenos e com prazo para ganhar confiança:

Uma vez que um serviço esteja estável por algumas semanas, replique os mesmos padrões — não reinventem por time.

Use RabbitMQ quando você quiser desacoplar serviços, absorver picos de tráfego ou mover trabalho lento para fora do caminho da requisição.

Casos adequados incluem jobs em background (e-mails, PDFs), notificações de evento para múltiplos consumidores e fluxos que devem continuar durante quedas temporárias de dependências a jusante.

Evite quando você realmente precisa de uma resposta imediata (leitura/validação simples) ou quando não há compromisso com versionamento, retries e monitoramento — esses itens não são opcionais em produção.

Publique em uma exchange e roteie para filas:

orders.* ou orders.#.A maioria das equipes adota topic exchanges por padrão para roteamento estilo evento mais sustentável.

Uma fila armazena mensagens até que um consumidor as processe; um binding é a regra que conecta uma exchange a uma fila.

Para depurar problemas de roteamento:

Essas três verificações explicam a maioria dos incidentes “publicado mas não consumido”.

Use uma work queue quando você quer que uma dentre muitas workers processe cada tarefa.

Dicas práticas:

Entrega "at-least-once" significa que uma mensagem pode ser entregue mais de uma vez (por exemplo, se o consumidor cair depois de executar o trabalho, mas antes do ack).

Torne os consumidores seguros assim:

message_id estável (ou chave de negócio) e registre IDs processados com TTL.PENDING, use restrições de unicidade).Evite loops de requeue apertados. Uma abordagem comum é filas de retry + DLQ:

Reproduza da DLQ somente após corrigir a causa-raiz e faça replays em pequenos lotes.

Comece com nomes previsíveis e trate mensagens como APIs públicas:

schema_version ao payload.Padronize também metadados:

Concentre-se em alguns sinais que mostram se o trabalho está fluindo:

Alerta em tendências (por exemplo, “backlog crescendo por 10 minutos”), e use logs que incluam nome da fila, correlation_id e o resultado do processamento (acked/retried/rejected).

Faça o básico de forma consistente:

Mantenha um runbook interno curto para que as equipes sigam um padrão único (por exemplo, link em /docs/security).

Comece localizando onde o fluxo para:

Reiniciar raramente é a primeira ou melhor ação.

Presuma que duplicatas são normais e projete para elas.

correlation_id para ligar eventos/comandos à mesma ação de negócio.trace_id (ou cabeçalhos W3C) para conectar trabalho assíncrono a traces distribuídos.Isso facilita onboarding e resposta a incidentes.