Comece pelo problema: que trabalho manual você está rastreando?

Antes de desenhar telas ou escolher um banco de dados, fique claro sobre o que você quer medir. O objetivo não é “rastrear tudo o que os funcionários fazem”. É capturar trabalho manual com confiabilidade suficiente para decidir o que automatizar primeiro—com base em evidências, não em opiniões.

Defina o trabalho manual em termos simples

Anote as atividades recorrentes realizadas manualmente (copiar/colar entre sistemas, digitar dados novamente, checar documentos, cobrar aprovações, reconciliar planilhas). Para cada atividade, descreva:

- O que a dispara (um novo pedido, um e-mail, um prazo semanal)

- Como é “concluído” (enviado, verificado, pago, despachado)

- Onde ocorre (quais ferramentas, pastas, caixas de entrada)

Se você não consegue descrever em duas frases, provavelmente está misturando vários fluxos.

Identifique os usuários-alvo (e seus incentivos)

Um app de rastreamento funciona quando atende todos que tocam o trabalho—não apenas quem quer o relatório.

- Operadores / equipe de linha de frente: precisam registrar rápido com mínima interrupção.

- Líderes de time: precisam visibilidade sobre gargalos e exceções.

- Gerentes: precisam sinais de priorização para automação e dimensionamento.

- Financeiro: precisa de números críveis para custo, ROI e orçamento.

- TI / time de automação: precisa de entradas limpas para construir automações com segurança.

Espere motivações diferentes: operadores querem menos burocracia; gerentes querem previsibilidade; TI quer requisitos estáveis.

Decida quais resultados você vai medir

Rastreamento só é útil se conectado a resultados. Escolha um pequeno conjunto que você consiga calcular de forma consistente:

- Tempo economizado: minutos manuais por tarefa como baseline, depois comparar após mudanças.

- Erros reduzidos: contagem de retrabalhos, correções, verificações falhas.

- Tempo de resposta: do gatilho à conclusão, incluindo estados de espera.

- Conformidade / auditabilidade: evidência de que passos obrigatórios aconteceram (quem, o quê, quando).

Esclareça o que o app não é

Defina limites cedo para evitar construir um monstro por acidente.

Este app tipicamente não é:

- Substituição completa de um ERP

- Um sistema abrangente de tickets

- Uma ferramenta de monitoramento da força de trabalho

Ele pode complementar esses sistemas—e às vezes substituir uma fatia estreita—se isso for intenção explícita. Se você já usa tickets, seu app de rastreamento pode simplesmente anexar dados estruturados de “esforço manual” a itens existentes (veja /blog/integrations).

Escolha os workflows e defina um escopo claro

Um app de rastreamento ganha ou perde pela focagem. Se você tentar capturar todo “trabalhinho” que as pessoas fazem, vai coletar dados ruidosos, frustrar usuários e ainda assim não saber o que automatizar primeiro. Comece com um escopo pequeno e explícito que possa ser medido com consistência.

Escolha os primeiros 3–5 workflows

Escolha fluxos que sejam comuns, repetíveis e já dolorosos. Um bom conjunto inicial costuma abranger tipos diferentes de esforço manual, por exemplo:

- Copiar/colar entre sistemas (ex.: CRM → planilha → e-mail)

- Entrada e reformatação de dados (ex.: faturas, atualizações de clientes)

- Aprovações (ex.: descontos, reembolsos, pedidos de acesso)

- Reconciliações (ex.: bater pagamentos, checagens de estoque)

- Relatórios (ex.: status semanais montados manualmente)

Defina o que conta como “trabalho manual”

Escreva uma definição simples que todos possam aplicar do mesmo jeito. Por exemplo: “Qualquer passo em que uma pessoa move, verifica ou transforma informação sem que um sistema faça isso automaticamente.” Inclua exemplos e algumas exclusões (ex.: chamadas com clientes, escrita criativa, gestão de relacionamento) para que as pessoas não registrem tudo.

Estabeleça limites que previnam creep de escopo

Seja explícito sobre onde o fluxo começa e termina:

- Departamentos/equipes incluídos (e excluídos)

- Regiões e canais (telefone, e-mail, presencial)

- Sistemas envolvidos (e quaisquer sistemas que você não vai integrar ainda)

Combine uma janela de medição

Decida como o tempo será registrado: por tarefa, por turno ou por semana. “Por tarefa” dá o melhor sinal para automação, mas “por turno/semana” pode ser um MVP prático se as tarefas forem muito fragmentadas. A chave é consistência, não precisão.

Mapeie o processo atual antes de desenhar qualquer coisa

Antes de escolher campos, telas ou dashboards, obtenha uma imagem clara de como o trabalho realmente acontece hoje. Um mapa leve vai revelar o que você deve rastrear e o que pode ignorar.

Construa um mapa de fluxo simples

Comece com um único fluxo e escreva em linha reta:

Gatilho → passos → repasses → resultado

Seja concreto. “Pedido chega numa caixa de entrada compartilhada” é melhor que “ocorre a triagem”. Para cada passo, anote quem faz, qual ferramenta usa e o que significa “feito”. Se houver repasses (de Vendas para Operações, de Operações para Financeiro), destaque—repasses são onde o trabalho desaparece.

Capture onde ocorrem atrasos e retrabalhos

Seu app de rastreamento deve destacar atrito, não só atividade. Enquanto você mapeia o fluxo, marque:

- Espera por informação ausente (detalhes do cliente, anexos, confirmação)

- Aprovações (quem aprova, quanto tempo normalmente demora, o que é rejeitado)

- Restrições de acesso a sistemas (permissões, filas, limites)

- Loops de retrabalho (tarefa volta a um passo anterior)

Esses pontos de atraso depois viram campos de alto valor (ex.: “motivo do bloqueio”) e candidatos prioritários para automação.

Identifique fontes de verdade

Liste os sistemas que as pessoas usam para completar o trabalho: threads de e-mail, planilhas, ferramentas de ticketing, drives compartilhados, apps legados, mensagens de chat. Quando múltiplas fontes discordam, anote qual vence. Isso é essencial para integrações futuras e para evitar entrada de dados duplicada.

Documente variabilidade e exceções

A maior parte do trabalho manual é bagunçada. Anote motivos comuns pelos quais tarefas desviam: termos especiais de clientes, documentos faltando, regras regionais, aprovações únicas. Você não está tentando modelar todo edge case—apenas registrar categorias que expliquem por que uma tarefa demorou mais ou exigiu passos extras.

Projete os dados que você precisa capturar (sem exagerar)

Um rastreador de trabalho manual vence ou perde por uma coisa: se as pessoas conseguem registrar o trabalho rapidamente enquanto ainda geram dados acionáveis. O objetivo não é “coletar tudo”. É capturar estrutura suficiente para identificar padrões, quantificar impacto e transformar dor repetida em candidatos à automação.

Mantenha o modelo de dados central simples e consistente entre times:

- Work Item: a coisa sendo processada (pedido, solicitação, ticket, reclamação). Inclua um ID de referência externo se existir.

- Process e Step: onde o trabalho está (ex.: “Reembolsos” → “Validar comprovante”). Steps ajudam a mostrar gargalos sem analytics complexos.

- Task: uma unidade de esforço manual realizada num momento (frequentemente ligada a um Work Item + Step).

- Assignee: quem fez (e opcionalmente time/função).

- System: quais ferramentas foram envolvidas (CRM, planilha, e-mail, portal).

- Evidence (opcional): anexos ou links para screenshots/arquivos quando necessários para auditoria.

Essa estrutura suporta registro diário e análises posteriores sem forçar os usuários a responderem um questionário longo.

Tempo é essencial para priorizar automação, mas precisa ser fácil:

- Timer start/stop para quem faz trabalho focado.

- Entrada manual quando tarefas ocorrem em rajadas curtas.

- Edições em lote para ações repetitivas (“fiz isso 12 vezes hoje”).

Se o tempo parecer “policiado”, a adoção cai. Posicione como uma forma de remover trabalho, não de monitorar indivíduos.

Adicione um campo obrigatório que explique por que o trabalho não foi automatizado:

- Integração ausente

- Requisito de política/conformidade

- Regras pouco claras / edge cases

- Limitações da ferramenta ou UX ruim

Use um dropdown curto mais uma nota opcional. O dropdown permite relatórios; a nota dá contexto para exceções.

Armazene resultados estruturados (para que logs virem acionáveis)

Toda Task deve terminar com alguns desfechos consistentes:

- Status (concluído, bloqueado, escalado)

- Tipo de erro (se relevante)

- Contagem de retrabalho (0, 1, 2+)

- Notas de conclusão (curtas, opcionais)

Com esses campos você pode quantificar desperdício (retrabalho), identificar modos de falha (tipo de erro) e construir um backlog de automação crível a partir do trabalho real—não de opiniões.

Se registrar um work item for mais lento do que simplesmente fazer o trabalho, as pessoas pularão—ou colocarão dados vagos que não servem depois. Seu objetivo de UX é simples: capturar o mínimo útil com o menor atrito.

Telas essenciais (mantenha simples)

Comece com um conjunto pequeno de telas que cubram o ciclo completo:

- Task intake: modo rápido de adicionar trabalho (entrada manual ou “criar a partir de template”).

- Work queue: lista priorizada com filtros (novo, em progresso, bloqueado, concluído).

- Detalhe do work item: contexto, status, notas e uma “próxima ação” clara.

- Captura de tempo/evidência: timer start/stop, entrada rápida de duração, anexar arquivos ou colar links.

- Relatórios: visão leve de volume, tempo gasto e principais motivos/desfechos.

Faça ser rápido: menos cliques, mais fluxo

Projete para velocidade em vez de completude. Use atalhos de teclado para ações comuns (criar item, mudar status, salvar). Forneça templates para trabalhos repetidos para que usuários não reescrevam descrições e passos.

Sempre que possível, use edição in-place e padrões sensatos (ex.: autoatribuir ao usuário atual, definir “iniciado em” quando abrem um item).

Campos guiados que padronizam dados

Texto livre é útil, mas não agrega bem. Adicione campos guiados que tornem o reporting confiável:

- Dropdowns para motivo, desfecho, tipo de erro e canal (e-mail/chat/telefone).

- Campos obrigatórios só quando evitam ambiguidade—não “porque podemos”.

Noções básicas de acessibilidade que você não deve pular

Torne o app legível e utilizável por todos: contraste forte, rótulos claros (não só placeholder), estados de foco visíveis para navegação por teclado e layouts mobile-friendly para registro rápido em movimento.

Permissões, aprovações e auditabilidade

Crie o MVP pelo chat

Transforme notas do fluxo de trabalho em um app de rastreamento funcional com um chat simples.

Se seu app deve orientar decisões de automação, as pessoas precisam confiar nos dados. Essa confiança se rompe quando qualquer um pode editar tudo, aprovações são obscuras ou não há registro do que mudou. Um modelo simples de permissões e um rastro de auditoria leve resolvem a maior parte disso.

Defina papéis claros (e mantenha simples)

Comece com quatro papéis que mapeiam como o trabalho é registrado:

- Contributor: registra trabalho (tempo, passos, evidências) e edita seus próprios rascunhos.

- Reviewer/Approver: valida entradas, pede esclarecimentos e aprova ou rejeita.

- Manager: vê atividade do time, resolve disputas e pode sobrescrever aprovações quando preciso.

- Admin: configura workflows, permissões, retenção e integrações.

Evite regras customizadas por usuário no começo; acesso por papéis é mais fácil de explicar e manter.

Regras de edição após submissão

Decida quais campos são “fatos” e quais são “notas”, e bloqueie os fatos depois da revisão.

Uma abordagem prática:

- Contributors podem editar rascunhos livremente.

- Após submissão, contributors só podem editar campos não críticos (ex.: descrição) até começar a revisão.

- Após aprovação, edições em entradas de tempo, workflow/status, custo ou evidências anexadas devem ser limitadas a reviewers/managers e, idealmente, exigir um motivo.

Isso mantém os relatórios estáveis e ainda permite correções legítimas.

Rastro de auditoria que responda “quem mudou o quê?”

Adicione um log de auditoria para eventos chave: mudanças de status, ajustes de tempo, aprovações/rejeições, evidências adicionadas/removidas e mudanças de permissão. Armazene pelo menos: ator, timestamp, valor antigo, valor novo e (opcionalmente) um comentário curto.

Mostre isso em cada registro (ex.: aba “Atividade”) para que disputas não virem arqueologia no Slack.

Retenção e manejo de evidências

Defina regras de retenção cedo: por quanto tempo manter logs e evidências relacionadas (imagens, arquivos, links). Muitas equipes fazem 12–24 meses para logs e menos para anexos volumosos.

Se permitir uploads, trate-os como parte da história de auditoria: versionar arquivos, registrar exclusões e restringir acesso por papel. Isso importa quando uma entrada vira base para um projeto de automação.

Arquitetura técnica para um MVP prático

Um MVP prático deve ser fácil de construir, fácil de mudar e chato de operar. O objetivo não é prever sua futura plataforma de automação—é capturar evidência de trabalho manual com mínimo atrito.

Uma base simples e escalável

Comece com uma arquitetura direta:

- Cliente web (UI no navegador)

- API (lógica de negócio + validação)

- Banco de dados (registros estruturados)

- Armazenamento de arquivos (screenshots, PDFs, e-mails exportados)

Essa separação mantém a UI rápida para iterar enquanto a API continua sendo a fonte de verdade.

Escolha componentes comprovados

Use uma stack que seu time consiga entregar rapidamente com boa comunidade. Combinações comuns:

- Frontend: React ou Vue

- Backend: Node (Express/Nest), Django ou Rails

- Banco: Postgres

- Armazenamento de arquivos: armazenamento compatível com S3 (ou equivalente gerenciado)

Evite tecnologia exótica cedo—seu maior risco é a incerteza do produto, não performance.

Se quiser acelerar o MVP sem se amarrar, uma plataforma de "vibe-coding" como Koder.ai pode ajudar a ir de um especificação escrita para um app React com API em Go e PostgreSQL—via chat—enquanto mantém a opção de exportar o código-fonte, fazer deploy/host e reverter com snapshots. Isso é especialmente útil para ferramentas internas como rastreadores de trabalho manual, onde os requisitos mudam rápido após o primeiro piloto.

Defina a API em torno de ações de usuário

Projete endpoints que espelhem o que os usuários realmente fazem, não como suas tabelas de banco. Capacidades típicas em forma de verbo:

- Criar um work item (task/case)

- Registrar tempo (start/stop ou duração + notas)

- Anexar evidência (upload de arquivo + descrição curta)

- Mudar status (ex.: New → In Progress → Done)

Isso facilita suportar clientes futuros (mobile, integrações) sem reescrever o core.

POST /work-items

POST /work-items/{id}/time-logs

POST /work-items/{id}/attachments

POST /work-items/{id}/status

GET /work-items?assignee=me&status=in_progress

Planeje importação/exportação CSV desde o primeiro dia

Mesmo adotantes iniciais vão perguntar “Posso subir o que já tenho?” e “Posso tirar meus dados?” Adicione:

- Importação CSV para migração inicial ou criação em massa

- Exportação CSV para relatórios, auditorias e confiança

Isso reduz retrabalho, acelera onboarding e evita que seu MVP pareça um beco sem saída.

Integrações que reduzem o esforço de registro

Compense seus custos de desenvolvimento

Ganhe créditos compartilhando o que você constrói ou indicando colegas para o Koder.ai.

Se seu app depender das pessoas lembrarem de registrar tudo, a adoção vai decair. Uma abordagem prática é começar com entrada manual (para clarear o fluxo) e depois adicionar conectores apenas onde realmente reduzem esforço—especialmente em trabalho de alto volume e repetitivo.

Onde integrações ajudam mais

Procure passos onde as pessoas já deixam rastros em outro lugar. Integrações “baixo atrito” comuns incluem:

- Ingestão de e-mail: encaminhar mensagens para um endereço especial para criar/atualizar um work item.

- Planilhas: importar linhas (ou sincronizar) da planilha que as equipes já mantêm.

- Notificações Slack/Teams: lembretes rápidos (“registre o desfecho”) e atualizações de status quando um item é aprovado ou reatribuído.

- Webhooks: receber eventos de outras ferramentas (submissões de formulários, updates de tickets, falhas de pagamento) para criar um rascunho automaticamente.

Use identificadores únicos para conectar pontos

Integrações ficam bagunçadas rápido se você não consegue casar itens entre sistemas. Crie um identificador único (ex.: MW-10482) e armazene IDs externos ao lado (ID da mensagem de e-mail, chave da linha da planilha, ID do ticket). Mostre esse identificador em notificações e exportações para que pessoas referenciem o mesmo item em todo lugar.

Projete para automação parcial (não tudo-ou-nada)

O objetivo não é eliminar humanos imediatamente—é reduzir digitação e evitar retrabalho.

Pré-preencha campos via integrações (solicitante, assunto, timestamps, anexos), mas mantenha override humano para que o log reflita a realidade. Por exemplo, um e-mail pode sugerir categoria e esforço estimado, enquanto a pessoa confirma o tempo real gasto e o desfecho.

Uma boa regra: integrações devem criar rascunhos por padrão, e humanos devem “confirmar e submeter” até você confiar no mapeamento.

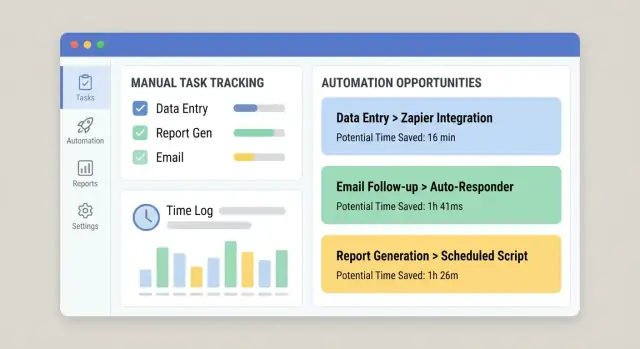

Rastrear trabalho manual só vale se virar decisões. O objetivo do app deve ser converter logs brutos em uma lista priorizada de oportunidades de automação—seu “backlog de automação”—fácil de revisar numa reunião semanal de operações ou melhoria.

Crie critérios de pontuação que as pessoas confiem

Comece com uma pontuação simples e explicável para que stakeholders vejam por que algo sobe no ranking. Um conjunto prático de critérios:

- Volume: frequência (por dia/semana/mês)

- Tempo por tarefa: minutos medianos por conclusão (não o máximo)

- Taxa de erro: com que frequência há retrabalho, correções ou escalonamentos

- Impacto no negócio: custo, impacto ao cliente, risco de conformidade, violação de SLA

- Viabilidade: clareza das regras, acesso a sistemas, estabilidade das entradas, número de exceções

Mantenha a pontuação visível ao lado dos números subjacentes para não parecer caixa-preta.

Gere um “backlog de automação” a partir da atividade real

Adicione uma visão dedicada que agrupe logs em “work items” repetíveis (por exemplo: “Atualizar endereço do cliente no Sistema A e confirmar no Sistema B”). Classifique automaticamente por pontuação e mostre:

- Tempo total gasto (últimos 30/90 dias)

- Tendência de frequência

- Principais times/funções envolvidos

- Pontos comuns de falha (onde usuários marcam “bloqueado” ou “retrabalho”)

Marque padrões repetidos para achar o que é automatizável

Torne tagging leve: tags de um clique como sistema, tipo de entrada e tipo de exceção. Com o tempo, isso revela padrões estáveis (bons para automação) versus edge cases bagunçados (melhor treinar ou ajustar processo).

Adicione uma estimativa básica de ROI

Uma estimativa simples basta:

ROI (tempo) = (tempo economizado × frequência) − suposição de manutenção

Para manutenção, use uma estimativa fixa mensal (ex.: 2–6 hrs/mês) para que as equipes comparem oportunidades de forma consistente. Isso mantém o backlog focado em impacto, não opiniões.

Relatórios e dashboards que as pessoas realmente usarão

Dashboards só são úteis se responderem perguntas reais rápido: “Onde estamos gastando tempo?” “O que está nos deixando lentos?” e “Nossa última mudança ajudou mesmo?” Projete relatórios em torno de decisões, não de gráficos vaidosos.

A maioria dos líderes não quer todo detalhe—quer sinais claros. Um baseline prático inclui:

- Horas gastas em trabalho manual, por time, workflow e categoria

- Principais processos manuais (ranqueados por tempo total, frequência ou ambos)

- Tempo de ciclo (do início à conclusão) e onde há espera

- Retrabalho (itens reabertos, devolvidos ou editados após submissão)

Mantenha cada cartão clicável para que um líder vá do número destaque ao que o está impulsionando.

Mostre tendências e comparações antes/depois

Uma semana pode enganar. Adicione linhas de tendência e filtros simples de data (últimos 7/30/90 dias). Quando você muda um workflow—como adicionando uma integração ou simplificando um formulário—facilite comparar antes vs depois.

Uma abordagem leve: armazene um “marcador de mudança” (data e descrição) e mostre uma linha vertical nos gráficos. Isso ajuda a ligar melhorias a intervenções reais em vez de chutes.

Evite métricas enganosas

Rastreamento mistura dados duros (timestamps, contagens) e inputs mais suaves (tempo estimado). Rotule métricas claramente:

- Medido: capturado automaticamente (start/end times, número de itens)

- Reportado: inserido por usuários (tempo gasto, códigos de motivo)

- Derivado: calculado (tempo de ciclo, taxa de retrabalho)

Se o tempo for estimado, indique isso na UI. Melhor ser honesto do que parecer preciso e estar errado.

Permita aprofundamento até os work items

Cada gráfico deve permitir “mostrar os registros”. O drill-down gera confiança e acelera ação: usuários filtram por workflow, time e período, e abrem os work items subjacentes para ver notas, repasses e bloqueios comuns.

Vincule dashboards à visão de “backlog de automação” para que os maiores drenos de tempo virem candidatos enquanto o contexto ainda está fresco.

Noções básicas de segurança e confiabilidade

Prototipe o rastreador rapidamente

Crie um app web em React com API em Go e PostgreSQL sem começar do zero.

Se seu app captura como o trabalho é feito, ele logo juntará detalhes sensíveis: nomes de clientes, notas internas, anexos e “quem fez o quê quando”. Segurança e confiabilidade não são extras—você perde confiança (e adoção) sem elas.

Comece com acesso por papel que reflita responsabilidades reais. A maioria dos usuários só deve ver seus próprios registros ou os do time. Limite poderes de admin a um grupo pequeno e separe “pode editar entradas” de “pode aprovar/exportar dados”.

Para uploads, trate cada anexo como não confiável:

- Faça scan de uploads (ou use um provedor que faça)

- Armazene arquivos em object storage privado, não no filesystem do servidor web

- Use URLs assinadas de curta duração para download

Defesas básicas da aplicação

Você não precisa de segurança de nível enterprise para lançar um MVP, mas precisa do básico:

- Autenticação (SSO se possível, senão senha forte + MFA)

- Rate limiting em login e endpoints de escrita para reduzir abuso

- Validação de entrada em todos os campos (server-side), especialmente texto livre e IDs

- Backups regulares com procedimento de restauração testado (um backup que você não consegue restaurar não vale)

Logs que ajudam (sem vazar segredos)

Capture eventos do sistema para troubleshooting e auditoria: logins, mudanças de permissão, aprovações, jobs de importação e integrações que falharam. Mantenha logs estruturados e pesquisáveis, mas não grave segredos—nunca escreva tokens API, senhas ou conteúdos completos de anexos em logs. Redija campos sensíveis por padrão.

Se você lida com dados pessoais, decida cedo:

- Regras de retenção (por quanto tempo manter logs e arquivos)

- Fluxos de exportação e exclusão para pedidos de acesso

- Onde os dados são armazenados e quem pode acessá-los

Essas escolhas afetam seu schema, permissões e backups—mais fácil planejar agora do que retrofitar depois.

Plano de rollout, adoção e melhoria contínua

Um app de rastreamento vence ou perde pela adoção. Trate o rollout como um lançamento de produto: comece pequeno, meça comportamento e itere rápido.

Pilote com um time—idealmente um grupo que já sinta a dor do trabalho manual e tenha um fluxo claro. Mantenha escopo estreito (um ou dois tipos de trabalho) para apoiar usuários de perto e ajustar o app sem atrapalhar a organização inteira.

No piloto, colete feedback no momento: um botão “Algo foi difícil” após o registro e uma reunião semanal de 15 minutos. Quando a adoção estabilizar, expanda para o próximo time com padrões de trabalho similares.

Defina métricas de sucesso cedo

Estabeleça metas simples e visíveis para que todos saibam o que é “bom”:

- % do trabalho registrado (cobertura)

- Qualidade dos dados (ex.: campos obrigatórios preenchidos, menos entradas “Outro”)

- Horas manuais reduzidas (auto-reportadas ou inferidas por menos tarefas repetidas)

Acompanhe num dashboard interno e reveja com líderes de time.

Facilite aprender fazendo

Adicione orientação in-app onde as pessoas hesitam:

- Exemplos sob cada campo (“Boa descrição: ‘Reconciliar fatura #1842’”)

- Tooltips para categorias e tags

- Um onboarding curto na primeira vez que alguém registra (2–3 passos máx.)

Mantenha a melhoria contínua (e visível)

Estabeleça uma cadência de revisão (mensal funciona bem) para decidir o que automatizar em seguida e por quê. Use os dados de logs para priorizar: tarefas de alta frequência + alto tempo primeiro, com donos claros e impacto esperado.

Feche o ciclo mostrando resultados: “Porque você registrou X, automatizamos Y.” Essa é a forma mais rápida de manter as pessoas registrando.

Se estiver iterando rápido entre times, considere ferramenta que suporte mudanças rápidas sem desestabilizar o app. Por exemplo, o modo de planejamento do Koder.ai ajuda a definir escopo e fluxos antes de gerar mudanças, e snapshots/rollback tornam mais seguro ajustar workflows, campos e permissões conforme você aprende com o piloto.