O que faz um site de registro de experimentação de produto

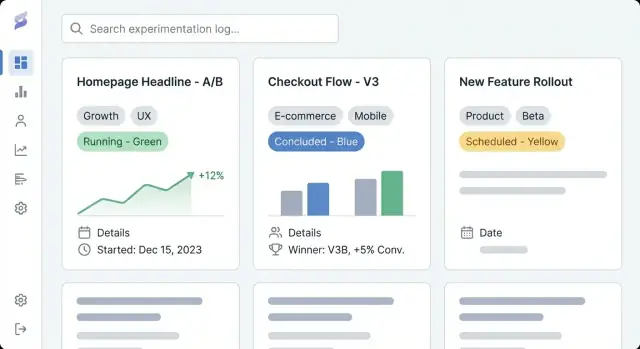

Um site de registro de experimentação de produto é um lugar compartilhado para documentar todo experimento que sua equipe executa — testes A/B, experimentos de preço, ajustes de onboarding, feature flags, experimentos de e-mail e até ideias “falhas” que ainda ensinaram algo. Pense nisso como um repositório de experimentos e um registro de aprendizados de produto combinados: um histórico do que foi tentado, por que, o que aconteceu e qual foi a decisão seguinte.

Por que equipes usam um desses

A maioria das equipes já tem fragmentos de rastreamento de experimentos espalhados por documentos, dashboards e conversas. Um site dedicado de rastreamento de experimentos reúne esses artefatos em um histórico único e navegável.

Os resultados práticos são:

- Visibilidade: qualquer pessoa consegue ver rapidamente o que está rodando agora, o que foi lançado, o que foi interrompido e o que está planejado — sem procurar por ferramentas.\n- Repetibilidade: equipes podem reutilizar modelos de experimento, evitar re-testar a mesma hipótese e copiar métodos comprovados (segmentação, métricas, duração).\n- Aprendizado compartilhado: resultados e contexto ficam disponíveis muito depois do fim do projeto, para que novos colegas entendam decisões passadas e possam construir sobre elas.

O que você verá neste guia

Este guia foca em como construir um site que torne a documentação de experimentos fácil de criar e fácil de usar. Vamos cobrir como planejar estrutura e navegação, definir um modelo de dados para entradas de experimento (para manter consistência), criar templates de página legíveis, configurar marcação e pesquisa para descoberta rápida e escolher a abordagem de implementação certa (CMS vs app customizado).

Ao final, você terá um plano claro para um site de documentação de testes A/B que apoie o trabalho diário de produto — capturando hipóteses, métricas e relatórios de resultados, e decisões de forma pesquisável, confiável e útil ao longo do tempo.

Defina objetivos, público e nível de acesso

Antes de escolher ferramentas ou desenhar templates, deixe claro por que esse site de rastreamento de experimentos existe e para quem ele serve. Um registro de experimentação de produto só é útil se combinar com a forma como suas equipes tomam decisões.

Anote 2–4 resultados mensuráveis para o repositório de experimentos. Definições comuns de sucesso incluem:

- Descoberta mais rápida: pessoas conseguem encontrar documentação relevante de testes A/B em minutos, não horas.

- Menos testes duplicados: equipes veem o que já foi tentado e evitam reexecutar a mesma ideia.

- Melhores decisões: métricas e relatórios de resultados mais consistentes, com ligações claras entre hipóteses, mudanças e desfechos.

Esses objetivos devem influenciar tudo o que vem depois: quais campos exigir em cada entrada, quão rígido será o workflow e quão avançada precisa ser a sua marcação e pesquisa.

Identifique usuários primários e suas necessidades

Liste seus públicos principais e o que cada um precisa fazer no registro de aprendizados:

- Produto: revisar experimentos passados, comparar resultados, reutilizar padrões bem-sucedidos.

- Design: entender quais mudanças foram testadas e por quê; revisar screenshots ou especificações.

- Engenharia: confirmar detalhes de implementação, guardrails e restrições técnicas.

- Liderança: revisar impacto e qualidade do aprendizado sem ler todo o detalhe.

- Suporte/Times de atendimento: saber o que mudou e o que informar aos usuários.

Uma forma simples de validar: pergunte a cada grupo “Que pergunta você quer respondida em 30 segundos?” e então garanta que seus templates e o layout da página suportem isso.

Escolha um modelo de acesso: interno, público ou misto

Decida desde cedo se seu CMS para registros de experimentos será:

- Somente interno: melhor para métricas sensíveis, detalhes de roadmap ou dados de usuário.

- Público: útil para transparência e recrutamento, mas exige revisão e redação mais rígidas.

- Misto: um log privado interno mais um subconjunto público curado.

Se escolher misto, defina o que é permitido em entradas públicas (por exemplo, sem métricas brutas, segmentos anonimizados, sem nomes de funcionalidades não lançadas) e quem aprova a publicação. Isso evita retrabalho quando a equipe quiser compartilhar aprendizados externamente.

Planeje a estrutura do site e a navegação

Um registro de experimentação só funciona se as pessoas conseguirem encontrar o experimento certo em menos de um minuto. Antes de escolher ferramentas ou desenhar telas, decida como alguém vai navegar no site quando não souber exatamente o que procura.

Escolha uma navegação de topo clara

Mantenha a navegação principal limitada e previsível. Um ponto de partida prático é:

- Experimentos (seu repositório de experimentos)

- Playbooks (guias, modelos de experimento, checklists)

- Métricas (definições, responsáveis, notas de rastreamento)

- Times (quem está executando o quê)

Se “Métricas” parecer pesado, você pode linkar a partir de Experimentos no começo e expandir depois.

Escolha a lógica primária de organização

Decida a forma principal de navegação. A maioria dos registros de aprendizados funciona melhor com uma visão primária e o resto tratado por filtros:

- Por área do produto (por exemplo, Checkout, Busca, Onboarding)

- Por estágio do funil (Aquisição → Ativação → Retenção)

- Por time (Growth, Core, Mobile)

Escolha a opção que seus stakeholders já usam nas conversas. Todo o resto pode ser tag (por exemplo, plataforma, tema da hipótese, segmento, tipo de experimento).

Planeje URLs, breadcrumbs e caminhos de “voltar para a lista”

Torne URLs legíveis e estáveis para que as pessoas possam compartilhá-las no Slack e em tickets:

/experiments/2025-12-checkout-free-shipping-threshold

Adicione breadcrumbs como Experiments → Checkout → Free shipping threshold para evitar pontos sem saída e manter a escaneabilidade.

Crie um inventário leve de conteúdo

Liste o que será publicado no dia do lançamento versus o que virá depois: experimentos recentes, playbooks principais, um glossário de métricas básico e páginas de times. Priorize entradas que serão referenciadas com frequência (testes de alto impacto, templates canônicos e definições de métricas usadas em relatórios de resultados).

Desenhe o modelo de dados da entrada de experimento

Um registro de experimentação útil não é apenas uma lista de links — é um banco de dados de aprendizados. O modelo de dados é a “forma” desse banco: o que você guarda, como entradas se relacionam e quais campos devem estar presentes para que experimentos sejam comparáveis ao longo do tempo.

Tipos de conteúdo principais (o que você vai armazenar)

Comece com um conjunto pequeno de tipos que reflitam como as equipes realmente trabalham:

- Experimento: o registro principal (o que você testou e o que aconteceu).

- Métrica: uma medida definida que você reutiliza entre experimentos (por exemplo, taxa de ativação, churn, receita por usuário).

- Insight: um aprendizado reutilizável que pode sobreviver a um teste (por exemplo, “remover atrito no passo 2 aumenta a conclusão”).

- Decisão: o que foi decidido após os resultados (lançar, iterar, reverter ou arquivar).

Manter esses elementos separados evita que cada experimento invente novos nomes de métricas ou enterre decisões em texto livre.

Campos mínimos para cada entrada de experimento

Torne a “entrada mínima viável” fácil de preencher. No mínimo, exija:

- Título (claro e específico)

- Hipótese (o que você esperava e por quê)

- Responsável (uma pessoa responsável)

- Data de início / Data de fim (ou datas planejadas)

- Status (de um conjunto padrão)

Campos opcionais — mas valiosos — incluem público-alvo, alocação de tráfego, tipo de teste (A/B, multivariado) e links para tickets ou designs.

Campos de resultado que capturam o aprendizado

Resultados são onde os registros frequentemente falham, então padronize-os:

- Métrica primária (selecionada da sua lista de Métricas)

- Impacto (direção + magnitude; inclua unidades)

- Notas de confiança (explicação em linguagem simples sobre certeza e caveats de qualidade de dados)

- Evidência de suporte (screenshots, gráficos ou um resumo curto do que foi analisado)

Se permitir anexos, mantenha um slot consistente para screenshots para que os leitores saibam onde procurar.

Relações e status

Modele relacionamentos explicitamente para que descoberta e relatórios funcionem depois:

- Experimentos ↔ Métricas (primária + secundárias)

- Experimentos ↔ Funcionalidades/Áreas (qual parte do produto mudou)

- Experimentos ↔ Responsáveis/Times (contabilidade e roteamento)

Padronize status para que ordenação e dashboards façam sentido: proposto, rodando, concluído, lançado, arquivado. Isso evita que “feito”, “completo” e “finalizado” se transformem em três estados diferentes.

Crie templates de página que facilitem a leitura dos experimentos

Buenos templates transformam “notas de alguém” em um registro compartilhado que toda a empresa consegue escanear, confiar e reutilizar. O objetivo é consistência sem fazer os autores sentirem que estão preenchendo burocracia.

Página de detalhe do experimento: seções recomendadas (na ordem)

Comece com a informação que o leitor precisa para decidir se vai continuar lendo.

- Resumo (TL;DR): um parágrafo: o que você mudou, quem foi afetado e o resultado.

- Status e metadados chave: status, responsável, time, datas, link para PRD/ticket (

/docs/...) e métrica primária.

- Hipótese: uma única declaração testável (evite metas vagas como “melhorar engajamento”).

- Design: variantes, segmentação, alocação, guardrails e suposições de duração.

- Resultados: métrica primária primeiro, depois métricas secundárias/guardrails, com interpretação em linguagem simples.

- Decisão: lançar/iterar/reverter, mais o que mudou no produto.

- Aprendizados e follow-ups: o que você aprendeu, perguntas abertas e próximos experimentos.

- Apêndice: screenshots, trechos SQL, gráficos brutos e links.

Página de lista: campos e controles para escaneamento rápido

Sua página índice deve se comportar como um dashboard. Inclua filtros por status, time, tag, intervalo de datas e plataforma; ordenação por atualizado recentemente, data de início e (se puder quantificar) impacto; e campos de escaneamento rápido como status, responsável, datas de início/fim e uma linha com o resultado.

Templates para consistência entre times

Crie um template padrão e variantes opcionais (por exemplo, “Teste A/B”, “Teste de preço”, “Experimento de onboarding”). Prefira cabeçalhos preenchidos, texto de exemplo e campos obrigatórios para que os autores não comecem do zero.

Mobile-friendly e legível para notas longas

Use layout de coluna única, espaçamento generoso e tipografia clara. Mantenha fatos chave em um bloco de resumo fixo (quando fizer sentido) e torne tabelas roláveis horizontalmente para que resultados permaneçam legíveis em celulares.

Compense custos enquanto constrói

Ganhe créditos compartilhando conteúdo da Koder.ai ou convidando colegas com seu link de indicação.

Um registro de experimentação só é útil se as pessoas encontrarem aprendizados relevantes com rapidez. Tags e taxonomia transformam um monte de páginas em algo que você pode navegar, filtrar e reutilizar.

Defina alguns grupos de tags que coincidam com a forma como sua equipe naturalmente busca. Uma linha de base prática é:

- Área do produto (por exemplo, Onboarding, Checkout, Notificações)

- Tipo de hipótese (por exemplo, redução de atrito, sensibilidade a preço, sinal de confiança)

- Métrica primária (por exemplo, taxa de ativação, taxa de conversão, retenção)

- Segmento (por exemplo, novos usuários, PMEs, apenas mobile)

Mantenha o número de grupos limitado. Muitas dimensões tornam filtros confusos e incentivam marcação inconsistente.

Tags sem controle viram rapidamente “signup”, “sign-up” e “registration”. Crie um vocabulário controlado:

- Escolha um formato (singular vs plural, capitalização, uso de siglas)

- Defina quem pode criar novas tags e como são aprovadas

- Adicione descrições curtas para tags ambíguas (quando usar)

Uma abordagem simples é uma página de “registro de tags” que a equipe mantém (por exemplo, /experiment-tags) e uma revisão leve durante a escrita do experimento.

Use campos estruturados para o que não deve ser texto livre

Tags são ótimas para descoberta, mas alguns atributos devem ser campos estruturados para manter consistência:

- Status (Proposto, Rodando, Lançado, Parado)

- Time/Responsável (escolha de uma lista)

- Tipo de experimento (A/B, multivariado, holdout)

Campos estruturados alimentam filtros e dashboards confiáveis, enquanto tags capturam nuances.

Suporte cross-links: experimentos relacionados e semelhantes

Ajude leitores a saltar entre trabalhos conectados. Adicione seções como Experimentos relacionados (mesma feature ou métrica) e Hipóteses similares (mesma suposição testada em outro lugar). Isso pode ser manual no começo e depois automatizado com regras de “tags compartilhadas” para sugerir vizinhos.

Escolha entre um CMS e uma aplicação customizada

Essa decisão define o teto do que seu registro pode se tornar. Um CMS permite publicar rapidamente; um app customizado transforma o log em um sistema integrado de tomada de decisão.

Quando um CMS basta

Um CMS serve bem quando sua necessidade principal é documentação consistente e legível de testes A/B com pouca estrutura.

Use um CMS se você quer:

- Publicação simples: criar, editar, revisar e publicar entradas como artigos

- Editor familiar para PMs, designers e marketers

- Permissões embutidas (quem pode rascunhar vs aprovar vs publicar)

- Marcação e categorias básicas sem regras complexas

Padrão comum: headless CMS (conteúdo armazenado no CMS, apresentado pelo seu site) acoplado a um gerador de site estático. Mantém o repositório rápido, fácil de hospedar e acessível para contribuidores não técnicos.

Quando um build customizado faz sentido

Um app customizado é indicado quando o log precisa se conectar diretamente aos dados do produto e ferramentas internas.

Considere um app customizado se precisar de:

- Integrações profundas (feature flags, ferramentas de analytics, data warehouse, ticketing)

- Busca e filtros avançados (views salvas por time, métrica, plataforma, nível de confiança)

- Regras de workflow (campos obrigatórios, aprovações por dono de área, mudanças automáticas de status)

- Relatórios automáticos de métricas e resultados (puxando resultados em vez de copiar screenshots)

Se quiser prototipar rápido, uma plataforma de desenvolvimento acelerado como Koder.ai pode ser um atalho prático: descreva o modelo de dados (experimentos, métricas, decisões), templates de página e workflows no chat e itere em um app React + Go + PostgreSQL funcional, com deploy/hosting, exportação de código e snapshots/rollback para mudanças seguras.

Decida sua “fonte da verdade”

Seja explícito sobre onde os dados do experimento residem.

- Se o CMS for a fonte da verdade, seus links de analytics e resumos de resultados devem apontar de volta à entrada no CMS.

- Se o banco de dados/app for a fonte da verdade, o site deve ser uma camada de visualização sobre registros estruturados, com comentário narrativo armazenado separadamente (opcionalmente em um CMS).

Anote isso cedo — caso contrário equipes criam entradas duplicadas em docs, planilhas e ferramentas, e o registro deixa de ser confiável.

Escolha stack tecnológico e hospedagem

Comece com o modo de planejamento

Rascunhe seu modelo de dados, templates e fluxo de trabalho antes de gerar o código.

Seu registro de experimentação não precisa de tecnologia exótica. A melhor stack é aquela que sua equipe pode operar com confiança, manter segura e evoluir sem atrito.

Site estático vs servidor-renderizado vs single-page app

Um site estático (páginas pré-geradas) costuma ser a opção mais simples: rápido, barato de hospedar e com pouca manutenção. Funciona bem se os experimentos forem em grande parte leitura e atualizações acontecerem via CMS ou pull requests.

Um app servidor-renderizado (páginas geradas sob demanda) é indicado quando você precisa de controle de acesso mais forte, filtros dinâmicos ou views por time sem lógica cliente complexa. Também é mais fácil aplicar permissões no servidor.

Um single-page app (SPA) pode parecer mais responsivo para filtros e dashboards, mas adiciona complexidade em SEO, autenticação e tempo de carregamento inicial. Escolha SPA só se realmente precisar de interações tipo app.

Se estiver construindo um app customizado, decida entre um pipeline convencional ou uma abordagem acelerada. Por exemplo, Koder.ai pode gerar scaffolding (UI em React, API em Go, esquema PostgreSQL) a partir de uma especificação escrita, útil quando estiver iterando em templates e workflows com múltiplos stakeholders.

Noções básicas de hospedagem que evitam surpresas

Priorize confiabilidade (uptime, monitoramento, alertas) e backups (automatizados e com restaurações testadas). Mantenha separação de ambientes: ao menos um staging para testar mudanças de taxonomia, templates e regras de permissão antes da produção.

Autenticação e áreas privadas

A maioria das equipes vai precisar de SSO (Okta, Google Workspace, Azure AD), além de papéis (visualizador, editor, admin) e áreas privadas para aprendizados sensíveis (receita, dados de usuário, notas legais). Planeje isso cedo para não re-arquitetar depois.

Use caching (CDN e cache do navegador), mantenha páginas leves e otimize mídia (imagens comprimidas, carregamento tardio quando apropriado). Velocidade importa: pessoas não vão usar um log que pareça lento — especialmente quando procuram um teste antigo durante uma reunião.

Implemente busca, filtros e views salvas

Um registro de experimentação fica realmente útil quando as pessoas conseguem achar “aquele teste” em segundos — sem conhecer o título exato.

Busca no site vs serviço de busca externo

A busca embutida (no CMS ou na base do app) costuma bastar quando você tem algumas centenas de experimentos, equipe pequena e necessidades simples como buscar títulos, resumos e tags. É mais fácil de manter e evita configurar um fornecedor extra.

Um serviço externo de busca (Algolia/Elastic/OpenSearch) vale a pena quando você tem milhares de entradas, precisa de resultados ultra-rápidos, tolerância a erros de digitação e sinônimos (por exemplo, “checkout” = “purchase”), ou ranking avançado para relevância. Busca externa também ajuda se o conteúdo estiver espalhado entre fontes (docs + log + wiki).

Filtros obrigatórios que correspondam ao trabalho real

Busca não basta. Adicione filtros que reflitam decisões reais:

- Status: proposto, rodando, pausado, concluído, lançado, invalidado

- Intervalo de datas: início, fim e última atualização

- Responsável e time: quem pode responder perguntas rapidamente

- Tags: área da feature, segmento, tipo de hipótese

- Métrica primária (e opcionalmente guardrails): ajuda a comparar experimentos similares

Permita combinar filtros (por exemplo, “Concluídos + Últimos 90 dias + Time Growth + Métrica Ativação”).

Views salvas que as pessoas realmente usam

Views salvas transformam perguntas recorrentes em respostas com um clique:

- Executando agora (status = rodando)

- Alto impacto (lift acima de um limiar, ou decisão = lançar)

- Concluídos recentemente (terminaram nos últimos 30 dias)

Permita que times fixem views compartilhadas na navegação e que indivíduos salvem views pessoais.

Torne resultados escaneáveis na listagem

Nos resultados, mostre um snippet curto: hipótese, variante, público e o resultado principal. Destaque palavras-chave encontradas no título e no resumo, e exiba alguns campos chave (status, responsável, métrica primária) para que usuários decidam abrir sem clicar em várias páginas.

Defina workflow, propriedade e governança

Um ótimo registro de experimentação não é só páginas e tags — é um processo compartilhado. Propriedade clara e um workflow leve previnem entradas pela metade, resultados ausentes e “decisões misteriosas” meses depois.

Papéis e permissões

Decida quem pode criar, editar, revisar e publicar entradas. Um modelo simples funciona para a maioria:

- Autores (PMs, analistas, designers): criam rascunhos e atualizam resultados

- Revisores (dados/analytics, pesquisa, engenharia): verificam métricas, instrumentação e interpretação

- Aprovadores (líder de produto ou conselho de experimentação): confirmam decisão e plano de rollout

- Publicadores (opcional): checagem final de formatação e redações

Mantenha permissões consistentes com suas decisões de acesso (público vs interno vs restrito). Se suportar experimentos privados, exija um responsável para cada entrada.

Checklist editorial (o que significa “concluído”)

Defina um checklist curto que todo experimento deve satisfazer antes de publicar:

- Hipótese específica e falseável (o que muda, para quem, direção esperada)

- Métrica primária definida (nome exato, fonte, janela de cálculo)

- Guardrails listados (por exemplo, receita, taxa de erro, chamados ao suporte)

- Decisão de rollout documentada (lançar, iterar, parar) com justificativa

Esse checklist pode ser uma seção obrigatória dentro dos templates de experimento.

Histórico de versão e notas de mudança

Trate entradas como documentos vivos. Habilite histórico de versão e exija notas de mudança breves para atualizações materiais (correção de métrica, ajuste de análise, reversão de decisão). Isso mantém a confiança alta e facilita auditorias.

Decida previamente como armazenar informações sensíveis:

- Redações para nomes de clientes, termos de parceiros ou detalhes de segurança

- Notas privadas visíveis apenas a um grupo restrito

- Páginas divididas: resumo público + página restrita de “análise e dados”

Governança não precisa ser pesada — só explícita.

Transforme seu template em um app

Gere uma UI em React, backend em Go e esquema PostgreSQL a partir da sua especificação.

Um registro de experimentação é útil quando as pessoas conseguem achar, confiar e reutilizar o conteúdo. Analytics leve ajuda a identificar onde o log está funcionando — e onde está falhando — sem transformar o site numa ferramenta de vigilância.

Monitore uso sem coletar demais

Comece com sinais práticos:

- Principais buscas e buscas sem resultados: se as pessoas buscam “teste de preço” e não acham nada, sua taxonomia ou nomenclatura precisa de ajuste.

- Experimentos mais vistos e tags mais acessadas: mostram o que importa para a equipe.

- Links quebrados e 404s: referências a specs, dashboards ou tickets quebrados reduzem a confiança rapidamente.

Se a ferramenta de analytics permitir, desative logging de IP e evite identificadores por usuário. Prefira relatórios agregados por página.

Meça a saúde do conteúdo (qualidade, não cliques)

Métricas de uso não dizem se as entradas estão completas. Adicione checagens de “saúde do conteúdo” que reportem no repositório:

- Campos obrigatórios faltando (por exemplo, hipótese, métrica primária, decisão, responsável)

- Status obsoletos (por exemplo, Rodando por mais de 90 dias)

- Resultados desatualizados (por exemplo, TBD após a data de decisão)

Isso pode ser um relatório semanal do CMS/banco ou um script simples que sinaliza entradas. O objetivo é tornar gaps visíveis para que responsáveis corrijam.

Princípios de privacidade para entradas de experimento

Anotações de experimento quase nunca devem conter dados pessoais. Mantenha entradas sem:

- nomes, e-mails, IDs de usuário, replays de sessão, logs brutos de eventos

- screenshots com informações pessoais

Linke para dashboards agregados em vez de incorporar datasets brutos e armazene análises sensíveis em sistemas aprovados.

Adicione um aviso de interpretação claro

Resultados de testes A/B são fáceis de ler fora de contexto. Adicione um aviso curto no template (e/ou no rodapé) explicando que:

- resultados dependem da população definida, período e instrumentação

- limiares de confiança/significância podem variar por time

- decisões devem referenciar a métrica primária documentada e os guardrails

Isso mantém o log honesto e reduz reutilizações indevidas de resultados fora de contexto.

Prepare o lançamento, migração e manutenção contínua

Um ótimo registro não está “pronto” quando o site vai ao ar. O valor real aparece quando equipes confiam nele, o mantêm atualizado e conseguem achar aprendizados seis meses depois.

Migre experimentos existentes (sem caos)

A maioria começa com planilhas, slides ou docs espalhados. Escolha um lote piloto (por exemplo, experimentos do último trimestre) e mapeie cada campo de origem para o novo template.

Se possível, importe em massa: exporte planilhas para CSV e utilize um script ou importador do CMS para criar entradas no novo formato. Para documentos, migre primeiro os campos de resumo (objetivo, mudança, resultados, decisão) e linke o arquivo original para detalhes de apoio.

Faça uma revisão de qualidade antes do lançamento

Execute uma passada focada em consistência, não perfeição. Problemas comuns:

- Tags duplicadas ou quase duplicadas (por exemplo, onboarding vs on-boarding)

- Responsáveis ausentes (cada experimento precisa de um nome, não “time”) e datas faltantes

- Status inconsistentes (rascunho, rodando, parado, lançado, invalidado) e resultados pouco claros

Também é um momento bom para concordar os campos obrigatórios para algo marcado como concluído.

Checklist de lançamento

Antes de anunciar, verifique:

- Permissões: quem pode ver, editar e publicar

- Indexação de busca: páginas principais e tags devem ser descobertas

- Redirecionamentos: se substituir um espaço de wiki antigo, configure redirects para preservar links

- Backups: confirme backups automatizados e teste de restauração (mesmo que simples)

Ritmo de manutenção pós-lançamento

Adote uma rotina leve: limpeza mensal (rascunhos obsoletos, resultados faltando) e revisão trimestral de taxonomia (fundir tags, adicionar categorias com cuidado).

Próximos passos opcionais

Quando o básico estiver estável, considere integrações: link automático de experimentos a trackers de issues ou puxar contexto analítico para que cada entrada aponte ao dashboard exato usado na análise de resultados.

Se for evoluir para um app customizado, você pode iterar em “modo de planejamento” primeiro — escrevendo workflows, campos obrigatórios e regras de aprovação — e então implementar. Plataformas como Koder.ai suportam esse ciclo iterativo de construir e refinar (com deploys, snapshots e rollback) para que seu log amadureça sem grande reescrita.