O que esta história explica (e por que importa)

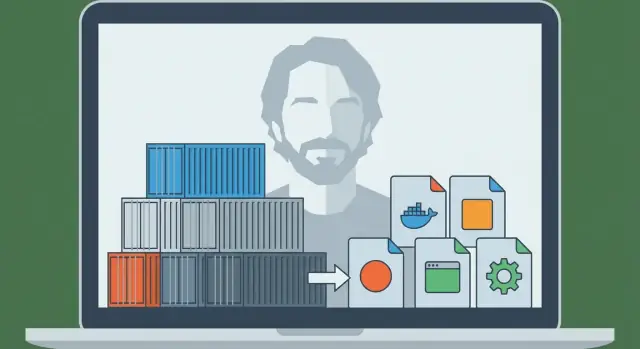

Solomon Hykes é o engenheiro que ajudou a transformar uma ideia antiga — isolar software para que rode igual em qualquer lugar — em algo que equipes pudessem realmente usar no dia a dia. Em 2013, o projeto que ele apresentou ao mundo tornou‑se o Docker, e rapidamente mudou a forma como empresas entregam aplicações.

Na época, a dor era simples e familiar: uma app funcionava no laptop do desenvolvedor, depois se comportava diferente na máquina de um colega e quebrava novamente em staging ou produção. Esses “ambientes inconsistentes” não eram apenas irritantes — desaceleravam releases, tornavam bugs difíceis de reproduzir e geravam trocas intermináveis entre desenvolvimento e operações.

O problema que o Docker resolveu (em termos simples)

O Docker deu às equipes uma maneira repetível de empacotar uma aplicação junto com as dependências que ela espera — para que a app possa rodar do mesmo jeito no laptop, em um servidor de teste ou na nuvem.

Por isso dizem que os contêineres se tornaram a “unidade padrão de empacotamento e implantação”. Simplificando:

- Unidade de empacotamento: a coisa que você constrói e armazena (uma imagem de contêiner)

- Unidade de implantação: a coisa que você executa em um ambiente (um contêiner)

Em vez de implantar “um ZIP e uma página wiki com passos de configuração”, muitas equipes implantar uma imagem que já inclui o que a aplicação precisa. O resultado é menos surpresas e releases mais rápidos e previsíveis.

O que você vai tirar desta história

Este artigo mistura história com conceitos práticos. Você vai entender quem é Solomon Hykes nesse contexto, o que o Docker introduziu no momento certo e a mecânica básica — sem pressupor conhecimento profundo de infraestrutura.

Você também verá onde os contêineres se encaixam hoje: como eles se conectam a fluxos de trabalho de CI/CD e DevOps, por que ferramentas de orquestração como Kubernetes se tornaram importantes depois, e o que os contêineres não consertam automaticamente (especialmente em torno de segurança e confiança).

Ao final, você deve ser capaz de explicar — de forma clara e confiante — por que “envie como contêiner” virou uma suposição padrão para implantação de aplicações modernas.

Antes do Docker: por que era tão difícil distribuir aplicações

Antes de os contêineres se tornarem mainstream, levar uma aplicação do laptop de um desenvolvedor para um servidor era muitas vezes mais doloroso do que escrever a própria aplicação. As equipes não careciam de talento — faltava um modo confiável de mover “a coisa que funciona” entre ambientes.

“Funciona na minha máquina” era um problema real

Um desenvolvedor podia rodar a app perfeitamente no próprio computador e depois vê‑la falhar em staging ou produção. Não porque o código mudou, mas porque o ambiente mudou. Diferentes versões do sistema operacional, bibliotecas faltando, arquivos de configuração ligeiramente diferentes ou um banco de dados com padrões distintos podiam quebrar o mesmo build.

Conflitos de dependência e manuais de setup intermináveis

Muitos projetos dependiam de instruções longas e frágeis:

- instale este runtime de linguagem

- compile aquele pacote do sistema

- fixe uma versão específica de biblioteca

- defina variáveis de ambiente no lugar certo

Mesmo escritas com cuidado, essas guias envelheciam rapidamente. Um colega atualizando uma dependência podia quebrar inadvertidamente o onboarding de todo mundo.

Pior ainda, duas aplicações no mesmo servidor podiam requerer versões incompatíveis do mesmo runtime ou biblioteca, forçando soluções contornadas ou máquinas separadas.

Empacotamento e implantação eram separados — e não casavam

“Empacotar” muitas vezes significava gerar um ZIP, um tarball ou um instalador. “Implantar” significava um conjunto diferente de scripts e passos no servidor: provisionar uma máquina, configurá‑la, copiar arquivos, reiniciar serviços e torcer para que nada mais no servidor fosse afetado.

Essas duas preocupações raramente se alinhavam bem. O pacote não descrevia totalmente o ambiente que precisava, e o processo de implantação dependia pesadamente do servidor alvo estar preparado “do jeitinho certo”.

A peça que faltava: uma unidade portátil

O que as equipes precisavam era de uma única unidade portátil que viajasse com suas dependências e rodasse de forma consistente em laptops, servidores de teste e produção. Essa pressão — configuração repetível, menos conflitos e implantação previsível — preparou o terreno para que os contêineres virassem a forma padrão de enviar aplicações.

Solomon Hykes e o nascimento do Docker (linha do tempo em alto nível)

O Docker não começou como um plano grandioso para “mudar o software para sempre”. Cresceu a partir de trabalho de engenharia prático liderado por Solomon Hykes enquanto construíam um produto de plataforma como serviço. A equipe precisava de uma maneira repetível de empacotar e executar aplicações em diferentes máquinas sem as habituais surpresas de “funciona no meu laptop”.

Antes do Docker ser um nome conhecido, a necessidade subjacente era direta: enviar uma app com suas dependências, executá‑la de forma confiável e repetir isso para muitos clientes.

O projeto que virou Docker surgiu como uma solução interna — algo que tornava implantações previsíveis e ambientes consistentes. Quando a equipe percebeu que o mecanismo de empacotamento e execução era útil além do produto deles, resolveram liberar publicamente.

Essa liberação foi importante porque transformou uma técnica privada de implantação em uma cadeia de ferramentas compartilhada que a indústria poderia adotar, melhorar e padronizar.

“Docker” vs. “contêineres”: não é a mesma coisa

É fácil confundir, mas são diferentes:

- Contêineres são o conceito: processos isolados que usam recursos do SO (como namespaces e cgroups no Linux) para rodar apps com suas dependências.

- Docker (o projeto e depois a empresa) foi a experiência productizada que tornou contêineres acessíveis para desenvolvedores do dia a dia.

Contêineres existiam de várias formas antes do Docker. O que mudou é que o Docker empacotou o fluxo em um conjunto de comandos e convenções amigáveis — buildar uma imagem, executar um contêiner, compartilhar com outra pessoa.

Marcos que mudaram o trabalho diário do desenvolvedor

Alguns passos conhecidos ajudaram a levar o Docker de “interessante” a “padrão”:

- Um formato de build simples (Dockerfile) fez o empacotamento parecer escrever uma receita em vez de manter docs frágeis.

- Um artefato padrão (a imagem) permitiu que equipes tratassem ambientes como entregáveis versionados.

- Compartilhamento fácil via registries habilitou fluxos “pull e run” entre laptops, servidores CI e produção.

- Ecossistema e esforços de padronização ajudaram imagens e runtimes a ficarem menos presos a um fornecedor e mais como uma interface comum.

O resultado prático: desenvolvedores pararam de debater como reproduzir ambientes e começaram a enviar a mesma unidade executável em todos os lugares.

Contêineres 101: o que são (e o que não são)

Contêineres são uma forma de empacotar e executar uma aplicação para que ela se comporte igual no seu laptop, na máquina de um colega e em produção. A ideia chave é isolamento sem um computador inteiro novo.

Contêineres vs. Máquinas Virtuais (modelo mental simples)

Uma máquina virtual (VM) é como alugar um apartamento inteiro: você tem sua própria porta, suas utilidades e sua própria cópia do sistema operacional. Por isso VMs podem rodar diferentes tipos de SO lado a lado, mas são mais pesadas e geralmente demoram mais para iniciar.

Um contêiner é como alugar um quarto trancado dentro de um prédio compartilhado: você traz seus móveis (código + bibliotecas), mas as utilidades do prédio (o kernel do SO host) são compartilhadas. Você ainda tem separação dos outros quartos, mas não está iniciando um SO inteiro a cada vez.

Como contêineres isolam apps (conceitualmente)

No Linux, contêineres dependem de recursos de isolamento incorporados que:

- dão aos processos sua própria “visão” do sistema (para que a app A não veja arquivos e processos da app B)

- limitam e contabilizam recursos como CPU e memória (para que uma app barulhenta não consiga facilmente sufocar as outras)

Você não precisa conhecer detalhes do kernel para usar contêineres, mas ajuda saber que eles aproveitam recursos do SO — não são mágica.

Por que as pessoas gostam

Contêineres ficaram populares porque são:

- Leves: menores que imagens de VM porque não embalam um SO completo

- Rápidos para iniciar: frequentemente segundos (ou menos), ótimo para escalar e testar

- Consistentes: o runtime empacotado reduz problemas de “funciona na minha máquina”

O que contêineres não são

Contêineres não são uma fronteira de segurança por padrão. Como contêineres compartilham o kernel do host, uma vulnerabilidade no kernel pode potencialmente afetar vários contêineres. Também significa que você não pode rodar um contêiner Windows em um kernel Linux (e vice‑versa) sem virtualização adicional.

Portanto: contêineres melhoram empacotamento e consistência — mas você ainda precisa de práticas inteligentes de segurança, patching e configuração.

O modelo Docker: Dockerfile, imagem, contêiner

O Docker teve sucesso em parte porque deu às equipes um modelo mental simples com “peças” claras: um Dockerfile (instruções), uma imagem (artefato construído) e um contêiner (instância em execução). Uma vez que você entende essa cadeia, o resto do ecossistema Docker começa a fazer sentido.

Dockerfile: uma receita repetível

Um Dockerfile é um arquivo texto que descreve como construir seu ambiente de aplicação passo a passo. Pense nele como uma receita de cozinha: por si só não alimenta ninguém, mas diz exatamente como produzir o mesmo prato toda vez.

Passos típicos em um Dockerfile incluem: escolher uma base (como um runtime de linguagem), copiar o código da app, instalar dependências e declarar o comando a executar.

Imagem vs. contêiner: planta versus app em execução

Uma imagem é o resultado construído de um Dockerfile. É um snapshot empacotado de tudo o que é necessário para rodar: seu código, dependências e configurações padrão. Não está “viva” — é mais como uma caixa selada que você pode enviar.

Um contêiner é o que você obtém quando executa uma imagem. É um processo vivo com seu próprio filesystem isolado e configurações. Você pode iniciar, parar, reiniciar e criar múltiplos contêineres a partir da mesma imagem.

Camadas e cache: por que builds podem ser rápidos

Imagens são construídas em camadas. Cada instrução em um Dockerfile normalmente cria uma nova camada, e o Docker tenta reutilizar (“cachear”) camadas que não mudaram.

Em termos simples: se você só alterar o código da aplicação, o Docker muitas vezes pode reutilizar as camadas que instalaram pacotes do sistema e dependências, tornando rebuilds muito mais rápidos. Isso também incentiva o reuso entre projetos — muitas imagens compartilham camadas base comuns.

Um fluxo mínimo de ponta a ponta

Aqui está como o fluxo “receita → artefato → instância em execução” se parece:

FROM node:20-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

CMD ["node", "server.js"]

- Dockerfile: as instruções acima

- Build de uma imagem:

docker build -t myapp:1.0 .

- Executar um contêiner:

docker run --rm -p 3000:3000 myapp:1.0

Esta é a promessa central que o Docker popularizou: se você consegue construir a imagem, consegue executar a mesma coisa de forma confiável — no laptop, no CI ou em um servidor — sem reescrever passos de instalação toda vez.

Do laptop para a equipe: registries e compartilhamento de imagens

Rodar um contêiner no laptop já é útil — mas isso não era a grande virada. A mudança real aconteceu quando equipes puderam compartilhar exatamente o mesmo build e executá‑lo em qualquer lugar, sem discussões de “funciona na minha máquina”.

O Docker fez esse compartilhamento parecer tão normal quanto compartilhar código.

O que é um registry (em linguagem simples)

Um registry de contêiner é um repositório para imagens de contêiner. Se uma imagem é a app empacotada, um registry é o lugar onde você guarda versões empacotadas para que outras pessoas e sistemas possam buscá‑las.

Registries suportam um fluxo simples:

- Push: faça upload de uma imagem construída

- Pull: baixe uma imagem que outra pessoa construiu

- Versionamento: mantenha várias releases nomeadas para avançar ou reverter

Registries públicos (como o Docker Hub) facilitaram o início. Mas a maioria das equipes logo precisou de um registry que atendesse regras de acesso e requisitos de compliance.

Imagens geralmente são identificadas como nome:tag — por exemplo myapp:1.4.2. Essa tag é mais que um rótulo: é como humanos e automação concordam qual build executar.

Um erro comum é confiar em latest. Parece conveniente, mas é ambíguo: “latest” pode mudar sem aviso, fazendo ambientes derivarem. Um deploy pode puxar um build mais novo que o anterior — mesmo sem intenção.

Hábitos melhores:

- Use tags de versão explícitas (ex.:

1.4.2) para releases

- Considere também marcar com o hash do commit para rastreabilidade

- Trate tags como parte do processo de release, não como algo posterior

Por que registries privados importam para equipes reais

Assim que você compartilha serviços internos, dependências pagas ou código da empresa, normalmente precisa de um registry privado. Ele permite controlar quem pode puxar ou enviar imagens, integrar com single sign‑on e manter software proprietário fora de índices públicos.

Esse é o salto de “laptop para equipe”: quando imagens vivem num registry, seu sistema CI, seus colegas e seus servidores de produção podem todos puxar o mesmo artefato — e a implantação se torna repetível, não improvisada.

Por que contêineres se encaixam tão bem em CI/CD

CI/CD funciona melhor quando pode tratar sua aplicação como uma “coisa” única e repetível que avança por etapas. Contêineres fornecem exatamente isso: um artefato empacotado (a imagem) que você pode construir uma vez e executar muitas vezes, com muito menos surpresas.

Desenvolvimento local padronizado

Antes dos contêineres, equipes tentavam igualar ambientes com guias longas e scripts compartilhados. O Docker mudou o fluxo padrão: clone o repo, construa uma imagem, execute a app. Os mesmos comandos tendem a funcionar em macOS, Windows e Linux porque a aplicação roda dentro do contêiner.

Essa padronização acelera o onboarding. Novos colegas gastam menos tempo instalando dependências e mais tempo entendendo o produto.

“Build once, run everywhere” na prática

Uma boa configuração de CI/CD busca um único output de pipeline. Com contêineres, o output é uma imagem marcada com uma versão (às vezes atrelada ao SHA do commit). Essa mesma imagem é promovida de dev → test → staging → produção.

Em vez de reconstruir a app de forma diferente por ambiente, você muda configuração (como variáveis de ambiente) mantendo o artefato idêntico. Isso reduz deriva de ambiente e facilita debugar releases.

Encaixe natural para pipelines de CI

Contêineres mapeiam bem para passos de pipeline:

- Build: crie a imagem a partir de um Dockerfile

- Test: rode testes unitários/integrados dentro do contêiner

- Scan: cheque a imagem por vulnerabilidades conhecidas e pacotes inseguros

- Deploy: faça push para um registry e então puxe/execute no próximo ambiente

Como cada passo roda contra a mesma app empacotada, falhas são mais significativas: um teste que passou no CI tende a se comportar igual após a implantação.

Se você está refinando seu processo, vale definir regras simples (convenções de tagging, assinatura de imagens, scan básico) para manter o pipeline previsível. Você pode evoluir conforme a equipe cresce (veja /blog/common-mistakes-and-how-to-avoid-them).

Onde isso conecta com fluxos modernos “vibe‑coding”: plataformas como a Koder.ai podem gerar e iterar apps full‑stack (React na web, Go + PostgreSQL no backend, Flutter para mobile) via interface de chat — mas ainda é preciso uma unidade de empacotamento confiável para sair de “rode” para “entregue”. Tratar cada build como uma imagem de contêiner versionada mantém até o desenvolvimento assistido por IA alinhado com as expectativas de CI/CD: builds reprodutíveis, deploys previsíveis e releases com possibilidade de rollback.

Rodando em escala: por que o Kubernetes entrou em cena

O Docker tornou prático empacotar uma app uma vez e rodá‑la em qualquer lugar. O próximo desafio apareceu rápido: equipes não rodavam um contêiner num laptop — rodavam dezenas (depois centenas) de contêineres em várias máquinas, com versões mudando constantemente.

Nesse ponto, “iniciar um contêiner” deixa de ser o problema difícil. O difícil passa a ser gerenciar uma frota: decidir onde cada contêiner deve rodar, manter o número correto de réplicas online e recuperar automaticamente quando algo falha.

Por que surgiram os orquestradores

Quando você tem muitos contêineres em muitos servidores, precisa de um sistema que os coordene. É isso que orquestradores fazem: tratam sua infraestrutura como um pool de recursos e trabalham continuamente para manter suas aplicações no estado desejado.

O Kubernetes se tornou a resposta mais comum para essa necessidade (embora não seja a única). Ele fornece um conjunto compartilhado de conceitos e APIs que muitas equipes e plataformas padronizaram.

Docker vs. orquestração: trabalhos diferentes

Ajuda separar responsabilidades:

- Docker (e ferramentas similares) foca em construir imagens de contêiner e rodar contêineres numa única máquina.

- Kubernetes foca em rodar contêineres em escala: em muitas máquinas, zonas de disponibilidade, com updates rolantes.

Ideias centrais que o Kubernetes trouxe

Kubernetes introduziu (e popularizou) capacidades práticas que equipes precisavam quando contêineres saíram de um único host:

- Agendamento: colocar contêineres em máquinas adequadas baseado em CPU/memória e restrições.

- Escala: aumentar ou diminuir o número de cópias para acompanhar a demanda.

- Descoberta de serviço e balanceamento: dar às aplicações formas estáveis de se encontrarem mesmo quando IPs e instâncias mudam.

- Autocura: reiniciar contêineres que caíram, substituir instâncias com problemas e reprogramar trabalho quando uma máquina falha.

Em resumo, o Docker tornou a unidade portátil; o Kubernetes ajudou a torná‑la operável — de forma previsível e contínua — quando há muitas unidades em movimento.

Como os contêineres mudaram a arquitetura de aplicações

Contêineres não apenas mudaram como implantamos software — também empurraram equipes a projetar software de forma diferente.

“Microservices tornaram‑se mais fáceis de entregar” (sem banir monólitos)

Antes dos contêineres, dividir uma app em muitos serviços pequenos frequentemente significava multiplicar a dor operacional: runtimes diferentes, dependências conflitantes e scripts de implantação complicados. Contêineres reduziram esse atrito. Se todo serviço é enviado como uma imagem e roda do mesmo jeito, criar um novo serviço parece menos arriscado.

Dito isso, contêineres também funcionam bem para monólitos. Um monólito em um contêiner pode ser mais simples do que uma migração pela metade para microservices: uma unidade implantável, um conjunto de logs, uma alavanca de escala. Contêineres não forçam um estilo — tornam vários estilos mais administráveis.

Interfaces padrão viraram norma

Plataformas de contêiner encorajaram apps a se comportarem como “caixas‑pretas” bem comportadas com entradas e saídas previsíveis. Convenções comuns incluem:

- Portas: a app escuta em uma porta conhecida e a plataforma roteia o tráfego.

- Variáveis de ambiente: configuração é injetada em tempo de execução, não embutida no código.

- Volumes: dados persistentes são montados, tornando o contêiner mais fácil de substituir.

Essas interfaces facilitaram trocar versões, reverter e rodar a mesma app em laptops, CI e produção.

Novos padrões (e novas tentações)

Contêineres popularizaram blocos reutilizáveis como sidecars (um contêiner auxiliar ao lado da app principal para logging, proxies ou certificados). Também reforçaram a recomendação de um processo por contêiner — não é uma regra rígida, mas um padrão útil para clareza, escala e troubleshooting.

A principal armadilha é dividir demais. Só porque você pode transformar tudo em serviço não quer dizer que deva. Se um microservice adiciona mais coordenação, latência e overhead de implantação do que resolve, mantenha junto até haver limites claros — como necessidades de escala diferentes, propriedade distinta ou isolamento de falha.

Segurança e confiança: o que contêineres não resolvem automaticamente

Contêineres tornam o software mais fácil de empacotar, mas não o tornam automaticamente mais seguro. Um contêiner continua sendo código mais dependências, e pode estar mal configurado, desatualizado ou até ser malicioso — especialmente quando imagens são puxadas da internet sem escrutínio.

Se você não consegue responder “De onde veio essa imagem?” já está correndo risco. Equipes costumam caminhar para uma cadeia de custódia clara: construir imagens em CI controlado, assinar ou atestar o que foi construído e manter registro do que entrou na imagem (dependências, versão da imagem base, passos de build).

É aí que SBOMs (Software Bills of Materials) ajudam: tornam o conteúdo do contêiner visível e auditável.

Scan é o próximo passo prático. Escaneie imagens regularmente em busca de vulnerabilidades conhecidas, mas trate os resultados como insumos para decisões — não como garantia de segurança.

Menor privilégio e segredos: armadilhas comuns

Erro frequente é executar contêineres com permissões amplas — root por padrão, capabilities extras, rede do host ou modo privilegiado “porque funciona”. Cada um desses amplia a zona de dano se algo der errado.

Segredos são outra armadilha. Variáveis de ambiente, arquivos de configuração embutidos ou .env commitados podem vazar credenciais. Prefira cofres de segredos ou segredos gerenciados pelo orquestrador e rotacione‑os assumindo que exposição é inevitável.

Riscos de runtime que as pessoas esquecem

Mesmo imagens “limpas” podem ser perigosas em tempo de execução. Fique alerta para sockets Docker expostos, mounts de volume permissivos e contêineres que alcançam serviços internos desnecessários.

Lembre também: fazer patch do host e do kernel continua importando — contêineres compartilham o kernel.

Mentalidade de checklist simples

Pense em quatro fases:

- Build: builds controlados, SBOMs, scan, minimizar imagens base

- Store: registries privados, controle de acesso, políticas de imutabilidade

- Run: menor privilégio, limites de rede, limites de recurso, evitar espalhamento de segredos

- Monitor: logs, alertas, detecção de anomalias, rebuild‑and‑redeploy rápido

Contêineres reduzem atrito — mas a confiança ainda precisa ser conquistada, verificada e mantida continuamente.

Erros comuns e como evitá‑los

Docker torna o empacotamento previsível, mas só se você usar com um pouco de disciplina. Muitas equipes caem nas mesmas crateras — e depois culpam “contêineres” por problemas que são, na verdade, de fluxo de trabalho.

Anti‑padrões que atrasam todo mundo

Um erro clássico é construir imagens enormes: usar imagens base de SO completas, instalar ferramentas de build que não são necessárias em runtime e copiar o repositório inteiro (incluindo testes, docs e node_modules). O resultado é downloads lentos, CI mais demorado e mais superfície para problemas de segurança.

Outro problema comum é builds lentos que quebram cache. Se você copia todo o diretório antes de instalar dependências, toda pequena mudança no código força reinstalação completa das dependências.

Por fim, equipes frequentemente usam tags flutuantes ou vagas como latest ou prod. Isso torna rollbacks dolorosos e transforma deploys em trabalho de adivinhação.

“Funciona localmente mas não em prod”: causas reais

Normalmente vem de diferenças em configuração (variáveis/segredos ausentes), rede (hostnames, portas, proxies, DNS) ou armazenamento (dados escritos no filesystem do contêiner em vez de volume, ou permissões de arquivo diferentes entre ambientes).

Correções práticas que você pode aplicar hoje

Use imagens base slim quando possível (ou distroless se sua equipe estiver pronta). Prenda versões de imagens base e dependências chave para que builds sejam reprodutíveis.

Adote builds multi‑stage para manter compiladores e ferramentas de build fora da imagem final:

FROM node:20 AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

FROM node:20-slim

WORKDIR /app

COPY --from=build /app/dist ./dist

CMD ["node","dist/server.js"]

Além disso, marque imagens com algo rastreável, como um SHA do git (e opcionalmente uma tag legível por humanos).

Quando não containerizar

Se uma app é realmente simples (um binário estático único, executado raramente, sem necessidade de escala), contêineres podem adicionar overhead. Sistemas legados com forte acoplamento ao SO ou drivers de hardware especializados também podem ser opções ruins — às vezes uma VM ou um serviço gerenciado é a escolha mais limpa.

O que “unidade padrão” significa hoje — e o que fazer a seguir

Contêineres tornaram‑se o padrão porque resolveram uma dor muito específica e repetível: fazer a mesma app rodar da mesma forma em laptops, servidores de teste e produção. Empacotar a app e suas dependências juntas tornou implantações mais rápidas, rollbacks mais seguros e as trocas entre equipes menos frágeis.

Igualmente importante, contêineres padronizaram o fluxo: construir uma vez, enviar, rodar.

O que “padrão” significa na prática

“Padrão” não quer dizer que tudo execute em Docker em todo lugar. Quer dizer que a maioria dos pipelines modernos trata uma imagem de contêiner como o artefato primário — mais do que um zip, snapshot de VM ou um conjunto de passos manuais.

Esse padrão normalmente envolve três peças trabalhando juntas:

- Imagens: outputs imutáveis do build marcados com versões (e idealmente com SHA do commit).

- Registries: lugar compartilhado para armazenar e recuperar imagens (privado ou público), permitindo que equipes reutilizem o mesmo artefato entre ambientes.

- Orquestração: um agendador (frequentemente Kubernetes) que roda contêineres de forma confiável, substitui instâncias falhas e escala para cima/baixo.

Próximos passos que você pode dar nesta semana

Comece pequeno e foque na repetibilidade.

- Aprenda o básico de Dockerfile: mantenha imagens mínimas, prenda versões da imagem base e estruture camadas para que rebuilds sejam rápidos. Adicione um

.dockerignore cedo.

- Use um registry deliberadamente: publique imagens com tags significativas (ex.:

1.4.2, , ) e defina quem pode push e pull.

Se você está experimentando formas mais rápidas de construir software (inclusive com abordagens assistidas por IA), mantenha a mesma disciplina: versionar a imagem, armazená‑la em um registry e fazer deploys promovendo esse único artefato à frente. É por isso que equipes usando Koder.ai ainda se beneficiam de entrega orientada a contêiner — iteração rápida é ótima, mas reprodutibilidade e rollback é o que torna tudo seguro.

Mantenha uma visão equilibrada

Contêineres reduzem problemas de “funciona na minha máquina”, mas não substituem boas práticas operacionais. Você ainda precisa de monitoramento, resposta a incidentes, gerenciamento de segredos, patching, controle de acesso e propriedade clara.

Trate contêineres como um padrão poderoso de empacotamento — não como um atalho para pular disciplina de engenharia.