Por que Shannon ainda importa na tecnologia cotidiana

Você usa as ideias de Claude Shannon toda vez que envia uma mensagem, assiste a um vídeo ou se conecta ao Wi‑Fi. Não porque seu telefone “conheça Shannon”, mas porque os sistemas digitais modernos são construídos em torno de uma promessa simples: podemos transformar mensagens do mundo real em bits, mover esses bits por canais imperfeitos e ainda recuperar o conteúdo original com alta confiabilidade.

Teoria da informação é a matemática das mensagens: quanta escolha (incerteza) uma mensagem contém, quão eficientemente ela pode ser representada e quão confiavelmente pode ser transmitida quando ruído, interferência e congestionamento atrapalham.

Há matemática por trás disso, mas não é preciso ser matemático para ter a intuição prática. Usaremos exemplos do dia a dia — como por que algumas fotos comprimem melhor que outras, ou por que sua chamada pode soar bem mesmo com sinal fraco — para explicar as ideias sem fórmulas pesadas.

Os quatro pilares que você verá em toda parte

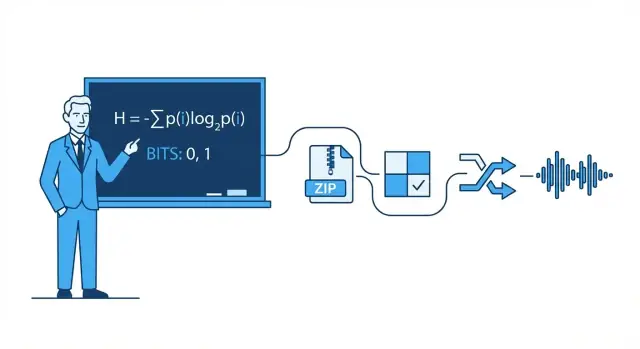

Este artigo gira em torno de quatro pilares inspirados em Shannon que aparecem na tecnologia moderna:

- Compressão: reduzir dados (áudio, vídeo, arquivos) sem perder o que importa.

- Correção de erros: adicionar apenas o suficiente de bits extras para que erros possam ser detectados e corrigidos.

- Confiabilidade em redes: lidar com pacotes perdidos usando retransmissões, ordenação e trade‑offs de throughput.

- Comunicação digital fim a fim: ver toda a cadeia da fonte (sua mensagem) ao canal (Wi‑Fi, celular, fibra) e de volta.

O que você poderá raciocinar depois

Ao final, você deverá conseguir pensar com clareza sobre trade‑offs reais: por que qualidade de vídeo maior precisa de mais largura de banda, por que “mais barras” nem sempre significa internet mais rápida, por que alguns apps parecem instantâneos enquanto outros travam, e por que todo sistema atinge limites — especialmente o famoso limite de Shannon sobre quanto dado confiável um canal pode transportar.

Claude Shannon em uma página: a grande ideia

Em 1948, o matemático e engenheiro Claude Shannon publicou um artigo com um título despretensioso — A Mathematical Theory of Communication — que redesenhou silenciosamente nossa visão de como enviar dados. Em vez de tratar comunicação como uma arte, ele a tratou como um problema de engenharia: uma fonte produz mensagens, um canal as leva, ruído as corrompe e um receptor tenta reconstruir o que foi enviado.

A jogada principal de Shannon foi definir informação de uma forma mensurável e útil para máquinas. Em seu quadro, informação não é sobre o quanto uma mensagem importa, o que ela significa ou se é verdadeira. É sobre o quão surpreendente ela é — quanta incerteza é removida quando você conhece o resultado.

Se você já sabe o que vai acontecer, a mensagem carrega quase nenhuma informação. Se você está genuinamente inseguro, aprender o resultado carrega mais.

O bit: a unidade mais simples que você pode contar

Para medir informação, Shannon popularizou o bit (abreviação de binary digit). Um bit é a quantidade de informação necessária para resolver uma incerteza simples de sim/não.

Exemplo: se eu pergunto “A luz está acesa?” e você não tem ideia antes, a resposta (sim ou não) pode ser vista como entregando 1 bit de informação. Muitas mensagens reais podem ser quebradas em longas sequências dessas escolhas binárias, por isso tudo, de texto a fotos a áudio, pode ser armazenado e transmitido como bits.

O que este post fará (e o que não fará)

Este artigo foca na intuição prática por trás das ideias de Shannon e por que elas aparecem em toda parte: compressão (arquivos menores), correção de erros (consertar corrupção), confiabilidade de redes (retransmissões e throughput) e capacidade do canal (quão rápido se pode enviar dados num enlace ruidoso).

O que ele não fará é percorrer provas complexas. Você não precisa de matemática avançada para entender o ponto principal: uma vez que você sabe medir informação, pode projetar sistemas que se aproximam da eficiência ideal — muitas vezes surpreendentemente perto dos limites teóricos que Shannon descreveu.

Bits, símbolos e códigos: um vocabulário prático

Antes de falar sobre entropia, compressão ou correção de erros, vale nomear alguns termos do dia a dia. As ideias de Shannon ficam mais fáceis quando você pode identificar as peças.

Símbolos, alfabetos e mensagens

Um símbolo é um “token” de um conjunto acordado. Esse conjunto é o alfabeto. Em texto inglês, o alfabeto pode ser letras (mais espaço e pontuação). Em um arquivo de computador, o alfabeto pode ser valores de byte 0–255.

Uma mensagem é uma sequência de símbolos desse alfabeto: uma palavra, uma sentença, um arquivo de imagem ou um fluxo de amostras de áudio.

Para manter concreto, imagine um alfabeto pequeno: {A, B, C}. Uma mensagem poderia ser:

A A B C A B A ...

Bits e códigos

Um bit é um dígito binário: 0 ou 1. Computadores armazenam e transmitem bits porque o hardware consegue distinguir de forma confiável dois estados.

Um código é uma regra para representar símbolos usando bits (ou outros símbolos). Por exemplo, com nosso alfabeto {A, B, C}, um possível código binário é:

Agora qualquer mensagem feita de A/B/C pode ser transformada em um fluxo de bits.

Codificação vs. compressão vs. criptografia

Esses termos costumam se misturar:

- Codificação: traduzir dados para um formato escolhido para que possam ser armazenados/transmitidos/processados (como mapear A/B/C em bits ou converter texto para UTF‑8).

- Compressão: codificação que usa menos bits em média, explorando padrões e frequências desiguais.

- Criptografia: embaralhar dados com uma chave para que pessoas de fora não leiam; é sobre sigilo, não tamanho.

Uma intuição rápida de probabilidade

Mensagens reais não são aleatórias: alguns símbolos aparecem com mais frequência que outros. Suponha que A ocorra 70% do tempo, B 20%, C 10%. Um bom esquema de compressão tipicamente dará padrões de bits mais curtos para símbolos comuns (A) e mais longos para os raros (C). Essa “desigualdade” é o que as seções seguintes quantificam com entropia.

Entropia: medir surpresa (e por que ela prevê compressibilidade)

A ideia mais famosa de Shannon é a entropia: uma forma de medir quanta “surpresa” há numa fonte de informação. Não surpresa como emoção — surpresa como imprevisibilidade. Quanto mais imprevisível for o próximo símbolo, mais informação ele carrega quando chega.

Entropia como “surpresa média”

Imagine que você assiste lançamentos de moeda.

- Moeda justa (50/50): cada lançamento é difícil de prever. Cara é tão provável quanto coroa, então você é regularmente “surpreendido” de qualquer forma. Essa alta imprevisibilidade significa maior entropia.

- Moeda viciada (por exemplo 95% caras, 5% coroas): a maioria dos lançamentos é cara. Depois de alguns lançamentos você passa a esperar cara, então ver cara carrega pouca informação nova. Apenas a rara coroa é surpreendente. Em média, a sequência tem entropia menor.

Esse enquadramento de “surpresa média” combina com padrões do dia a dia: um arquivo de texto com espaços repetidos e palavras comuns é mais fácil de prever que um arquivo de caracteres aleatórios.

Por que previsibilidade implica compressibilidade

A compressão funciona atribuindo códigos mais curtos a símbolos comuns e códigos mais longos aos raros. Se a fonte é previsível (baixa entropia), você pode usar bastante códigos curtos na maior parte do tempo e economizar espaço. Se é quase aleatória (alta entropia), há menos espaço para encolher porque nada aparece frequentemente o suficiente para explorar.

Entropia e o melhor comprimento médio de código possível

Shannon mostrou que a entropia define um marco conceitual: é o limite inferior no número médio de bits por símbolo que você pode alcançar ao codificar dados dessa fonte.

Importante: entropia não é um algoritmo de compressão. Ela não diz exatamente como comprimir um arquivo. Diz o que é teoricamente possível — e quando você já está perto do limite.

Compressão é o que acontece quando você pega uma mensagem que poderia ser descrita com menos bits e realmente a descreve. A sacada de Shannon é que dados com entropia menor (mais previsibilidade) têm “espaço” para encolher, enquanto dados de alta entropia (quase aleatórios) não têm.

Por que padrões e frequências desiguais comprimem bem

Padrões repetidos são o ganho óbvio: se um arquivo contém as mesmas sequências repetidas, você pode armazenar a sequência uma vez e referenciá‑la muitas vezes. Mas mesmo sem repetições claras, frequências de símbolos enviesadas ajudam.

Se um texto usa “e” muito mais do que “z”, ou um log repete timestamps e palavras‑chave, você não precisa gastar o mesmo número de bits em cada caractere. Quanto mais desiguais as frequências, mais previsível é a fonte — e mais compressível.

Codificação de comprimento variável (a intuição central)

Uma forma prática de explorar frequências enviesadas é a codificação de comprimento variável:

- símbolos frequentes recebem códigos curtos

- símbolos raros recebem códigos longos

Feito com cuidado, isso reduz o número médio de bits por símbolo sem perder informação.

Compressores lossless reais frequentemente misturam várias ideias, mas você ouvirá comumente estas famílias:

- Codificação de Huffman: constrói um dicionário eficiente “curto‑para‑comum”

- Codificação aritmética: agrupa símbolos num intervalo fracionário, muitas vezes aproximando‑se mais do limite de entropia

- Métodos LZ (Lempel–Ziv): encontram substrings repetidas e as substituem por referências (usados em muitos formatos estilo ZIP)

Lossless vs. lossy (ZIP vs. JPEG/MP3)

Compressão lossless reproduz o original perfeitamente (por exemplo, ZIP, PNG). É essencial para software, documentos e qualquer coisa onde um único bit errado importa.

Compressão lossy descarta deliberadamente informação que as pessoas geralmente não notam (por exemplo, fotos JPEG, áudio MP3/AAC). O objetivo passa a ser “mesma experiência”, e não “mesmos bits de volta”, permitindo arquivos bem menores ao remover detalhes perceptualmente menores.

Erros acontecem: por que redundância é útil

Explore a compressibilidade

Crie um fluxo de telemetria ou logging e teste o que realmente comprime bem.

Todo sistema digital repousa na suposição frágil de que um 0 permanece 0 e um 1 permanece 1. Na prática, bits podem inverter.

De onde vêm os erros

Na transmissão, interferência elétrica, sinal Wi‑Fi fraco ou ruído de rádio podem deslocar um sinal além de um limiar para que o receptor o interprete incorretamente. No armazenamento, efeitos físicos pequenos — desgaste em memória flash, riscos em mídia óptica, até radiação — podem alterar uma carga ou estado magnético.

Como erros são inevitáveis, engenheiros adicionam redundância: bits extras que não carregam “nova” informação, mas ajudam a detectar ou reparar danos.

Redundância simples que você já usou

Bit de paridade (detecção rápida). Adicione um bit extra para que o número total de 1s fique par (paridade par) ou ímpar (paridade ímpar). Se um bit único inverter, a verificação de paridade falha.

- Ponto forte: barato e rápido.

- Limite: geralmente não indica qual bit errou, e duas inversões podem se anular e parecer “ok”.

Checksum (detecção melhor para blocos). Em vez de um bit, calcule um pequeno número resumo de um pacote ou arquivo (por exemplo, checksum aditivo, CRC). O receptor recalcula e compara.

- Ponto forte: detecta muitos erros multi‑bit em um bloco.

- Limite: ainda é só detecção; se falhar, normalmente você precisa reenviar ou usar uma cópia de reserva.

Código de repetição (correção simples). Envie cada bit três vezes: 0 vira 000, 1 vira 111. O receptor usa voto majoritário.

- Ponto forte: pode corrigir uma inversão única em cada grupo de três.

- Limite: extremamente ineficiente — triplica os dados.

Detecção vs. correção (e quando usar cada)

Detecção de erro responde: “Algo deu errado?” É comum quando retransmissões são baratas — como pacotes de rede que podem ser reenviados.

Correção de erro responde: “Quais eram os bits originais?” É usada quando retransmissões são caras ou impossíveis — como streaming de áudio sobre um enlace ruidoso, comunicação no espaço profundo ou leitura de dados de armazenamento onde reler pode não resolver.

Redundância parece desperdício, mas é a razão pela qual sistemas modernos podem ser rápidos e confiáveis apesar de hardware imperfeito e canais ruidosos.

Capacidade do canal e o limite de Shannon (sem matemática pesada)

Quando você envia dados por um canal real — Wi‑Fi, celular, um cabo USB, até um disco rígido — ruído e interferência podem inverter bits ou borrar símbolos. A grande promessa de Shannon foi surpreendente: comunicação confiável é possível, mesmo em canais ruidosos, desde que você não tente empurrar informação demais pelo canal.

Capacidade do canal em termos simples

Capacidade do canal é o “limite de velocidade” do canal para informação: a taxa máxima (bits por segundo) que você pode transmitir com erros levados arbitrariamente perto de zero, dado o nível de ruído do canal e restrições como largura de banda e potência.

Não é o mesmo que a taxa bruta de símbolos (com que rapidez você altera um sinal). É sobre quanta informação significativa sobrevive após o ruído — quando você usa codificação, redundância e decodificação inteligentes.

O limite de Shannon: um limite que engenheiros perseguem

O limite de Shannon é o nome prático que se dá a essa fronteira: abaixo dele, você pode (em teoria) tornar a comunicação tão confiável quanto quiser; acima dele, não dá — erros permanecem não importa quão esperto seja o projeto.

Engenheiros empenham‑se em chegar perto desse limite com melhores modulações e códigos de correção. Sistemas modernos como LTE/5G e Wi‑Fi usam codificação avançada para operar próximos a essa fronteira em vez de desperdiçar enorme potência de sinal ou largura de banda.

O trade‑off chave (taxa vs. probabilidade de erro)

Pense nisso como empacotar itens em um caminhão que vai por uma estrada esburacada:

- Empacote demais (taxa acima da capacidade), e alguns itens sempre vão quebrar (um piso de erro não nulo).

- Empacote com folga e proteção (taxa abaixo da capacidade), e você pode fazer com que as quebras sejam tão raras quanto quiser — ao custo de menor rendimento ou mais redundância.

Shannon não nos deu um “código ótimo” único, mas provou que o limite existe — e que vale a pena perseguí‑lo.

Códigos de correção de erros em sistemas reais

Valide em produção

Implemente e hospede sua build para ver como ela se comporta em redes reais.

O teorema do canal ruidoso de Shannon costuma ser resumido como uma promessa: se você enviar dados abaixo da capacidade de um canal, existem códigos que podem tornar os erros arbitrariamente raros. A engenharia real trata de transformar essa “prova de existência” em esquemas práticos que cabem em chips, baterias e prazos.

Caixa de ferramentas prática: blocos, entrelaçamento e melhores palpites

A maioria dos sistemas reais usa códigos em bloco (protegem um bloco de bits por vez) ou códigos de fluxo (protegem uma sequência contínua).

Com códigos em bloco, você adiciona redundância bem projetada a cada bloco para que o receptor detecte e corrija erros. Com entrelaçamento, você embaralha a ordem dos bits/símbolos transmitidos para que um estouro de ruído (muitos erros seguidos) seja espalhado em erros menores e corrigíveis em vários blocos — crucial para wireless e armazenamento.

Outra grande divisão é como o receptor “decide” o que ouviu:

- Decisões duras (hard decisions): cada sinal recebido vira logo 0 ou 1.

- Decisões suaves (soft decisions): o receptor também mantém confiança (por exemplo, “isso provavelmente é 1, mas não tenho certeza”).

Decisões suaves fornecem mais informação ao decodificador e podem melhorar muito a confiabilidade, especialmente em Wi‑Fi e celular.

Códigos que você já usou

- Reed–Solomon: trabalha com símbolos (não bits) e é excelente contra estouros. Usado em QR codes, CD/DVD e alguns sistemas de transmissão/armazenamento.

- Códigos convolucionais: escolha clássica para fluxos contínuos; historicamente comuns em enlaces de satélite.

- Códigos Turbo: um salto importante nos anos 1990, amplamente usados em 3G/4G.

- LDPC (Low‑Density Parity‑Check): códigos em bloco altamente eficientes usados em Wi‑Fi, 5G e muitos sistemas de alto rendimento.

Onde eles fazem diferença

De comunicação em espaço profundo (onde reenviar é caro ou impossível) a satélites, Wi‑Fi e 5G, códigos de correção de erros são a ponte prática entre a teoria de Shannon e a realidade de canais ruidosos — trocando bits extras e computação por menos chamadas caídas, downloads mais rápidos e enlaces mais confiáveis.

Confiabilidade em redes: pacotes, retransmissões e throughput

A internet funciona mesmo que enlaces individuais sejam imperfeitos. Wi‑Fi desbota, sinais móveis são bloqueados, e cobre e fibra ainda sofrem ruído, interferência e falhas ocasionais. A mensagem central de Shannon — ruído é inevitável, mas a confiabilidade é alcançável — aparece nas redes como uma mistura cuidadosa de detecção/correção de erros e retransmissão.

Pacotes: pequenas apostas em vez de uma grande

Os dados são divididos em pacotes para que a rede possa contornar problemas e recuperar perdas sem reenviar tudo. Cada pacote carrega bits extras (cabeçalhos e verificações) que ajudam o receptor a decidir se o que chegou é confiável.

Um padrão comum é ARQ (Automatic Repeat reQuest):

- O receptor verifica um pacote (tipicamente com checksum/CRC).

- Se parecer bom, envia um reconhecimento (ACK).

- Se estiver faltando ou corrompido, o remetente retransmite após um timeout (ou após um NACK).

Corrigir vs. reenviar: o trade‑off da latência

Quando um pacote está errado, você tem duas escolhas principais:

- Corrigir agora usando forward error correction (FEC): adicionar redundância suficiente para que o receptor possa corrigir alguns erros sem pedir de novo.

- Reenviar usando ARQ: enviar menos redundância inicialmente, mas pagar tempo extra quando algo falhar.

FEC pode reduzir atrasos em enlaces onde retransmissões são caras (alta latência, perdas intermitentes). ARQ pode ser eficiente quando perdas são raras, porque você não “taxa” cada pacote com redundância pesada.

Throughput, congestionamento e por que confiabilidade não é grátis

Mecanismos de confiabilidade consomem capacidade: bits extras, pacotes adicionais e esperas. Retransmissões aumentam a carga, o que pode piorar o congestionamento; congestionamento, por sua vez, aumenta atraso e perda, gerando ainda mais retransmissões.

Bom projeto de redes busca um equilíbrio: confiabilidade suficiente para entregar dados corretos, mantendo overhead baixo para que a rede preserve throughput saudável sob condições variáveis.

Comunicação digital fim a fim: da fonte ao canal

Uma maneira útil de entender sistemas digitais modernos é como um pipeline com dois trabalhos: fazer a mensagem menor e fazer a mensagem sobreviver à jornada. A visão de Shannon foi que muitas vezes você pode pensar nesses problemas como camadas separadas — embora produtos reais às vezes as misturem.

Passo 1: codificação da fonte (compressão)

Você começa com uma “fonte”: texto, áudio, vídeo, leituras de sensores. Codificação da fonte remove estrutura previsível para que você não desperdice bits. Isso pode ser ZIP para arquivos, AAC/Opus para áudio ou H.264/AV1 para vídeo.

A compressão é onde entropia aparece na prática: quanto mais previsível o conteúdo, menos bits você precisa em média.

Passo 2: codificação de canal (correção de erros)

Então os bits comprimidos precisam atravessar um canal ruidoso: Wi‑Fi, celular, fibra, um cabo USB. Codificação de canal adiciona redundância bem pensada para que o receptor detecte e corrija erros. Este é o universo de CRCs, Reed–Solomon, LDPC e outros métodos de FEC.

A ideia de “separação” de Shannon (um modelo mental útil)

Shannon mostrou que, em teoria, você pode projetar codificação da fonte para se aproximar da melhor compressão possível e codificação de canal para se aproximar da melhor confiabilidade até a capacidade do canal — de forma independente.

Na prática, essa separação ainda é um ótimo modo de depurar sistemas: se o desempenho é ruim, você pode perguntar se perdeu eficiência na compressão (codificação da fonte), se a confiabilidade está ruim no enlace (codificação de canal), ou se está pagando muita latência com retransmissões e buffering.

Exemplo concreto: streaming de vídeo sobre Wi‑Fi

Ao transmitir vídeo, o app usa um codec para comprimir quadros. No Wi‑Fi, pacotes podem ser perdidos ou corrompidos, então o sistema adiciona detecção de erro, às vezes FEC, e então usa retransmissões (ARQ) quando necessário. Se a conexão piora, o player pode trocar para um stream de bitrate menor.

Sistemas reais misturam a separação porque tempo importa: esperar por retransmissões pode causar buffering, e condições wireless mudam rápido. Por isso pilhas de streaming combinam escolhas de compressão, redundância e adaptação — não perfeitamente separadas, mas ainda guiadas pelo modelo de Shannon.

Conceitos errados comuns e trade‑offs práticos

Teste vazão vs confiabilidade

Suba um frontend em React e um backend em Go para testar limites reais de vazão e latência.

Teoria da informação é citada frequentemente, e algumas ideias acabam simplificadas demais. Aqui vão mal‑entendidos comuns — e os trade‑offs reais que engenheiros fazem ao construir compressão, armazenamento e sistemas de rede.

Equívoco 1: “Entropia significa aleatoriedade”

No uso cotidiano, “aleatório” pode significar “bagunçado” ou “imprevisível”. A entropia de Shannon é mais estreita: mede surpresa dado um modelo de probabilidade.

- Um fluxo perfeitamente previsível (como todos zeros) tem baixa entropia.

- Um fluxo difícil de prever dado o que você sabe tem entropia maior.

Portanto entropia não é uma sensação; é um número ligado a suposições sobre o comportamento da fonte.

Equívoco 2: “Mais compressão é sempre melhor”

Compressão remove redundância. Correção de erros muitas vezes adiciona redundância de propósito para que o receptor consiga recuperar de danos.

Isso cria uma tensão prática:

- Se você comprime agressivamente e depois envia por um canal ruidoso, pode ter menos “margem” para recuperar danos.

- Sistemas bem projetados geralmente comprimem primeiro (removem padrões previsíveis) e depois adicionam redundância estruturada (códigos de correção) para o canal.

Equívoco 3: “Podemos ser perfeitamente confiáveis em qualquer velocidade”

A capacidade do canal de Shannon diz que todo canal tem um throughput confiável máximo sob dado ruído. Abaixo desse limite, as taxas de erro podem ser tornadas extremamente pequenas com a codificação certa; acima dele, erros tornam‑se inevitáveis.

Por isso “perfeitamente confiável a qualquer velocidade” não é possível: aumentar velocidade geralmente implica aceitar maior probabilidade de erro, maior latência (mais retransmissões) ou mais overhead (codificação mais forte).

Uma lista de verificação simples para sistemas reais

Ao avaliar um produto ou arquitetura, pergunte:

- Estatísticas da fonte: os dados são previsíveis (texto, logs) ou já parecem próximos de aleatórios (criptografados, comprimidos)?

- Ruído: o que pode corromper os dados — interferência wireless, bit rot, perda de pacotes?

- Orçamento de latência: você pode pagar retransmissões e buffering ou precisa de tempo real?

- Escolha de overhead: você está gastando bits em compressão, correção de erros, retransmissões ou alguma combinação?

Acertar esses quatro pontos importa mais do que decorar fórmulas.

Principais conclusões e para onde ir em seguida

A mensagem central de Shannon é que a informação pode ser medida, movida, protegida e comprimida usando um pequeno conjunto de ideias.

- Um bit é a moeda comum que permite tratar texto, áudio, vídeo e dados de sensores da mesma forma, uma vez codificados.

- Entropia mede quão imprevisível é uma fonte, e essa imprevisibilidade prevê o quão bem os dados podem ser comprimidos.

- Ruído e perdas são inevitáveis, então sistemas confiáveis adicionam redundância por meio de detecção de erros e códigos de correção.

- Capacidade do canal impõe um teto real: além de certa taxa, você não pode “se esforçar mais” e ainda ser confiável; é preciso diminuir a taxa, melhorar o canal ou mudar a codificação.

Redes e sistemas de armazenamento modernos são, essencialmente, trade‑offs constantes entre taxa, confiabilidade, latência e custo computacional.

Uma nota prática para quem constrói

Se você está construindo produtos reais — APIs, recursos de streaming, apps móveis, pipelines de telemetria — o arcabouço de Shannon é um checklist de design útil: comprima o que puder, proteja o que for necessário e seja explícito sobre o orçamento de latência/throughput. Um lugar onde isso aparece imediatamente é quando você prototipa sistemas fim a fim rapidamente e depois itera: com uma plataforma de “vibe‑coding” como Koder.ai, times podem levantar um app web React, um backend Go com PostgreSQL e até um cliente móvel Flutter a partir de uma especificação guiada por chat, e então testar trade‑offs do mundo real (tamanho de payload, retransmissões, comportamento de buffering) cedo. Recursos como modo de planejamento, snapshots e rollback facilitam experimentar mudanças entre “mais confiabilidade vs. menor overhead” sem perder ritmo.

Quem deve se aprofundar

Leitura adicional vale a pena para:

- Estudantes que querem um modelo mental limpo conectando probabilidade a compressão e codificação

- Product managers que precisam ponderar qualidade, latência, largura de banda e custo

- Engenheiros que trabalham com redes, codecs de mídia, armazenamento, telemetria ou pipelines de dados para ML

Para continuar, navegue por explicadores relacionados em /blog e então confira /docs para ver como nosso produto expõe configurações e APIs relacionadas a comunicação e compressão. Se estiver comparando planos ou limites de throughput, /pricing é a próxima parada.