O que este post quer dizer com “sistemas gerados por IA”

Um sistema gerado por IA é qualquer produto onde um modelo de IA produz saídas que moldam diretamente o que o sistema faz em seguida — o que é mostrado a um usuário, o que é armazenado, o que é enviado para outra ferramenta ou quais ações são tomadas.

Isto é mais amplo que “um chatbot”. Na prática, geração por IA pode aparecer como:

- Texto ou dados gerados (resumos, classificações, campos extraídos)

- Código gerado (trechos, configs, SQL, templates)

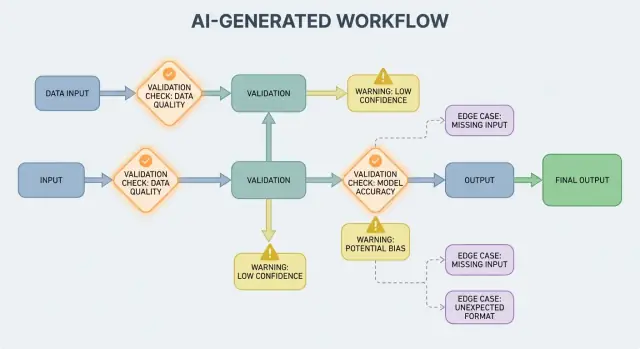

- Workflows gerados (planos passo a passo, checklists, decisões de roteamento)

- Comportamento de agentes (o modelo escolhe ferramentas, chama APIs e encadeia ações)

- Sistemas baseados em prompts (prompts cuidadosamente desenhados que agem como “código flexível”)

Se você já usou uma plataforma vibe-coding como Koder.ai — onde uma conversa em chat pode gerar e evoluir apps web, backend ou mobile completos — essa ideia de “saída da IA vira fluxo de controle” fica especialmente concreta. A saída do modelo não é apenas um conselho; pode mudar rotas, esquemas, chamadas de API, deploys e comportamento visível ao usuário.

Por que validação e erros são recursos do produto

Quando a saída da IA faz parte do fluxo de controle, regras de validação e tratamento de erros tornam-se recursos de confiabilidade visíveis ao usuário, não apenas detalhes de engenharia. Um campo perdido, um objeto JSON malformado ou uma instrução confiante-mas-errada não “apenas falham” — podem criar UX confusa, registros incorretos ou ações arriscadas.

Então o objetivo não é “nunca falhar”. Falhas são normais quando as saídas são probabilísticas. O objetivo é falha controlada: detectar problemas cedo, comunicar claramente e recuperar com segurança.

O que este post vai cobrir

O restante deste post divide o tema em áreas práticas:

- Regras que checam entradas e saídas (estrutura e significado)

- Tratamento de erro (falhar rápido vs. falhar de forma graciosa)

- Casos de borda que aparecem em uso real e como reduzir surpresas

- Testes para comportamento que não é perfeitamente determinístico

- Monitoramento e observabilidade para ver falhas, tendências e regressões

Se você tratar caminhos de validação e erro como partes de primeira classe do produto, sistemas gerados por IA ficam mais fáceis de confiar — e mais fáceis de melhorar ao longo do tempo.

Sistemas de IA são ótimos em gerar respostas plausíveis, mas “plausível” não é o mesmo que “útil”. No momento em que você depende de uma saída de IA para um fluxo real — enviar um e-mail, criar um ticket, atualizar um registro — suas suposições ocultas viram regras de validação explícitas.

Variabilidade força suposições a ficarem explícitas

Com software tradicional, saídas são geralmente determinísticas: se a entrada é X, você espera Y. Com sistemas gerados por IA, o mesmo prompt pode render diferentes formulações, níveis de detalhe diferentes ou interpretações distintas. Essa variabilidade não é um bug por si só — mas significa que você não pode confiar em expectativas informais como “provavelmente vai incluir uma data” ou “geralmente retorna JSON”.

Regras de validação são a resposta prática para: o que precisa ser verdade para que essa saída seja segura e útil?

“Parece válido” vs. “válido para nosso negócio”

Uma resposta de modelo pode parecer válida e ainda assim falhar nos seus requisitos reais.

Por exemplo, um modelo pode produzir:

- Um endereço bem formado que usa o país errado

- Uma mensagem amigável de reembolso que viola sua política

- Um resumo que inventa uma métrica que sua equipe não acompanha

Na prática você acaba com duas camadas de checagem:

- Validade estrutural (é parseável, completo, no formato esperado?)

- Validade de negócio (é permitido, preciso o suficiente e alinhado com suas regras?)

Ambiguidade aparece em lugares previsíveis

Saídas de IA frequentemente borram detalhes que humanos resolvem intuitivamente, especialmente sobre:

- Formatos: “03/04/2025” (4 de março ou 3 de abril?)

- Unidades: “20” (minutos, horas, dólares?)

- Nomes: “Alex Chen” (qual Alex Chen no seu CRM?)

- Fusos horários: “amanhã de manhã” (de qual fuso?)

Pense em contratos: entradas, saídas, efeitos colaterais

Uma maneira útil de desenhar validação é definir um “contrato” para cada interação com IA:

- Entradas: campos obrigatórios, ranges permitidos, contexto necessário

- Saídas: chaves obrigatórias, valores permitidos, limiares de confiança

- Efeitos colaterais: quais ações são permitidas (ex.: “apenas rascunho”, “nunca enviar”, “deve pedir confirmação”)

Uma vez que contratos existam, regras de validação não parecem burocracia extra — são como você torna o comportamento da IA suficientemente confiável para uso.

Validação de Entrada: protegendo a porta de entrada

Validação de entrada é a primeira linha de confiabilidade para sistemas gerados por IA. Se entradas bagunçadas ou inesperadas passarem, o modelo ainda pode produzir algo “confiante”, e é exatamente por isso que a porta de entrada importa.

O que conta como “entrada” em um sistema de IA?

Entradas não são apenas uma caixa de prompt. Fontes típicas incluem:

- Texto do usuário (mensagens de chat, prompts, comentários)

- Arquivos (PDFs, imagens, planilhas, áudio)

- Formulários estruturados (dropdowns, onboarding em múltiplas etapas)

- Payloads de API (JSON de outros serviços, webhooks)

- Dados recuperados (resultados de busca, linhas de banco de dados, saídas de ferramentas)

Cada um pode chegar incompleto, malformado, grande demais ou simplesmente não o que você esperava.

Checagens práticas que previnem falhas evitáveis

Boa validação foca em regras claras e testáveis:

- Campos obrigatórios: o prompt está presente, o arquivo anexado, a língua selecionada?

- Ranges e limites: tamanho máximo de arquivo, número máximo de itens, valores numéricos mínimos/máximos

- Valores permitidos: campos tipo enum (

"summary" | "email" | "analysis"), tipos de arquivo permitidos

- Limites de comprimento: tamanho do prompt, comprimento de título, tamanhos de arrays

- Codificação e formato: UTF-8 válido, JSON válido, base64 sem erro, formatos de URL seguros

Essas checagens reduzem confusão do modelo e também protegem sistemas downstream (parsers, bancos, filas) de travamentos.

Normalize antes de validar (quando previsível)

Normalização transforma “quase certo” em dados consistentes:

- Remova espaços em branco; colapse espaços repetidos

- Normalize caixa quando o significado não muda (ex.: códigos de país)

- Parseie formatos de localidade com cuidado ("," vs "." decimais, ordens de data diferentes)

- Converta datas para uma representação padrão (ex.: ISO-8601) após parse

Normalize apenas quando a regra for inequívoca. Se você não tiver certeza do que o usuário quis dizer, não adivinhe.

Rejeitar vs. auto-corrigir: escolha a opção mais segura

- Rejeitar entradas quando a correção poderia alterar o significado, criar risco de segurança ou ocultar erros do usuário (ex.: datas ambíguas, moedas inesperadas, HTML/JS suspeito).

- Auto-corrigir quando a intenção é óbvia e a alteração é reversível (ex.: trim, pontuação comum, converter “.PDF” para “pdf”).

Uma regra útil: auto-corrija para formato, rejeite para semântica. Ao rejeitar, retorne uma mensagem clara que diga ao usuário o que mudar e por quê.

Validação de Saída: checando estrutura e significado

Validação de saída é o checkpoint depois que o modelo fala. Ela responde duas perguntas: (1) a saída tem a forma correta? e (2) ela é realmente aceitável e útil? Em produtos reais, normalmente você precisa de ambas.

Comece definindo um esquema de saída: a forma JSON que você espera, quais chaves devem existir e que tipos/valores elas podem ter. Isso transforma “texto livre” em algo que sua aplicação pode consumir com segurança.

Um esquema prático normalmente especifica:

- Chaves obrigatórias (ex.:

answer, confidence, citations)

- Tipos (string vs number vs array)

- Enums (ex.:

status deve ser um de "ok" | "needs_clarification" | "refuse")

- Restrições (min/max de comprimento, ranges numéricos, arrays não vazios)

Checagens estruturais pegam falhas comuns: o modelo retorna prosa em vez de JSON, esquece uma chave ou emite um número onde você precisa de uma string.

2) Validação semântica: estrutura não é suficiente

Mesmo um JSON perfeitamente moldado pode estar errado. Validação semântica testa se o conteúdo faz sentido para seu produto e políticas.

Exemplos que passam no esquema mas falham no significado:

- IDs alucinados: retornar

customer_id: "CUST-91822" que não existe no seu banco

- Citações fracas ou ausentes: citações existem mas não apoiam a afirmação — ou referenciam fontes não fornecidas

- Totais impossíveis: itens que somam 120, mas

total é 98; ou um desconto maior que o subtotal

Checagens semânticas costumam parecer regras de negócio: “IDs devem resolver”, “totais devem reconciliar”, “datas devem estar no futuro”, “afirmações devem ser suportadas por documentos fornecidos” e “conteúdo proibido não pode aparecer”.

3) Estratégias que funcionam em sistemas reais

- Aplicar esquema: valide JSON antes de usá-lo; rejeite ou tente novamente em violações

- Decodificação restrita / saídas estruturadas: limite o que o modelo pode emitir para tornar mais difícil produzir formas inválidas

- Post-checkers: rode validadores determinísticos (e às vezes um segundo modelo) para verificar consistência, citações e conformidade com políticas

O objetivo não é punir o modelo — é impedir que sistemas downstream tratem “besteira confiante” como um comando.

Implemente sua app de IA hoje

Gere, implemente e hospede sua app, depois conecte um domínio personalizado quando estiver pronto.

Sistemas gerados por IA às vezes produzem saídas inválidas, incompletas ou simplesmente inúteis para o próximo passo. Bom tratamento de erro é decidir quais problemas devem interromper o fluxo imediatamente e quais podem ser recuperados sem surpreender o usuário.

Falhas duras vs. falhas suaves

Uma falha dura é quando continuar provavelmente causaria resultados errados ou comportamento inseguro. Exemplos: campos obrigatórios faltando, resposta JSON que não dá para parsear, ou saída que viola uma política obrigatória. Nesses casos, falhe rápido: pare, mostre um erro claro e evite chutes.

Uma falha suave é um problema recuperável onde existe um fallback seguro. Exemplos: o modelo retornou o significado certo mas a formatação está errada, uma dependência está temporariamente indisponível, ou uma requisição expirou. Aqui, falhe de forma graciosa: retente (com limites), faça um re-prompt com restrições mais fortes ou mude para um caminho de fallback mais simples.

Mensagens ao usuário: diga o que aconteceu e o que fazer em seguida

Erros voltados ao usuário devem ser curtos e acionáveis:

- O que aconteceu: “Não conseguimos gerar um resumo válido para este documento.”

- O que fazer a seguir: “Tente novamente ou envie um arquivo menor.”

- Contexto opcional (não técnico): “A resposta ficou incompleta.”

Evite expor traces de stack, prompts internos ou IDs internos. Esses detalhes são úteis — mas apenas internamente.

Separe mensagens ao usuário de diagnósticos internos

Trate erros como duas saídas paralelas:

- Voltado ao usuário: uma mensagem segura, um próximo passo e (às vezes) um botão de retentativa

- Diagnósticos internos: logs estruturados com um código de erro, saída bruta do modelo, resultados da validação, tempos, status de dependências e um ID de correlação/requisição

Isso mantém o produto calmo e compreensível enquanto dá à sua equipe informação suficiente para consertar problemas.

Categorize erros para triagem rápida

Uma taxonomia simples ajuda equipes a agir rápido:

- Validação: saída não casou com esquema, campos faltando, conteúdo inseguro

- Dependência: falhas de banco/API, problemas de permissão

- Timeout: chamadas ao modelo ou upstream excederam o tempo

- Lógica: bugs no código de integração, mapeamento ou regras de negócio

Quando você consegue rotular um incidente corretamente, consegue roteá-lo ao dono certo — e melhorar a regra de validação adequada em seguida.

Recuperações e fallbacks sem piorar a situação

A validação vai pegar problemas; a recuperação determina se os usuários verão uma experiência útil ou confusa. O objetivo não é “sempre vencer” — é “falhar previsivelmente e degradar com segurança.”

Retentativas: úteis para falhas transitórias, prejudiciais para respostas erradas

Lógica de retentativa é mais eficaz quando a falha é provavelmente temporária:

- Rate limits (429), problemas de rede ou timeouts do modelo

- Breves quedas de upstream

Use retentativas limitadas com backoff exponencial e jitter. Repetir cinco vezes num loop apertado frequentemente transforma um pequeno incidente em um maior.

Retentativas podem prejudicar quando a saída é estruturalmente inválida ou semanticamente errada. Se seu validador diz “campo obrigatório faltando” ou “viola política”, outra tentativa com o mesmo prompt pode apenas gerar outra resposta inválida — e queimar tokens e aumentar latência. Nesses casos, prefira reparo do prompt (perguntar de novo com restrições mais estritas) ou um fallback.

Um bom fallback é explicável ao usuário e mensurável internamente:

- Modelo menor/mais barato para respostas “bom o suficiente”

- Resposta em cache para perguntas repetidas e estáveis

- Base rule-based (templates, heurísticas) para formatação previsível

- Revisão humana quando a consequência de erro é alta

Torne a transferência explícita: registre qual caminho foi usado para depois comparar qualidade e custo.

Às vezes você pode devolver um subconjunto utilizável (ex.: entidades extraídas mas não um resumo completo). Marque como parcial, inclua avisos e evite preencher lacunas silenciosamente com suposições. Isso preserva confiança ao mesmo tempo que dá algo acionável ao chamador.

Limites de taxa, timeouts e circuit breakers

Defina timeouts por chamada e um prazo total por requisição. Ao ser rate-limited, respeite Retry-After se presente. Adicione um circuit breaker para que falhas repetidas mudem rapidamente para um fallback em vez de empilhar pressão sobre o modelo/API. Isso evita lentidão em cascata e torna o comportamento de recuperação consistente.

De onde vêm casos de borda em uso real

Casos de borda são situações que sua equipe não viu em demos: entradas raras, formatos estranhos, prompts adversariais ou conversas muito mais longas que o previsto. Com sistemas gerados por IA, eles aparecem rápido porque as pessoas tratam o sistema como um assistente flexível — e então o pressionam além do caminho feliz.

1) Entradas raras e bagunçadas de usuários

Usuários reais não escrevem como dados de teste. Colam capturas convertidas em texto, notas pela metade ou conteúdo copiado de PDFs com quebras estranhas. Também tentam prompts “criativos”: pedem ao modelo para ignorar regras, revelar instruções internas ou emitir algo num formato deliberadamente confuso.

Contexto longo é outro caso comum. Um usuário pode enviar um documento de 30 páginas pedindo um resumo estruturado, depois fazer dez perguntas de esclarecimento. Mesmo se o modelo for bem no começo, o comportamento pode derivar conforme o contexto cresce.

2) Valores de fronteira que quebram suposições

Muitas falhas vêm de extremos em vez de uso normal:

- Valores vazios: campos em branco, anexos ausentes, “N/A” em lugares-chave

- Comprimento máximo: nomes muito longos, listas enormes, endereços multi-parágrafo ou históricos de chat inteiros colados em uma entrada

- Unicode incomum: emojis, espaços de largura zero, aspas inteligentes, texto RTL, caracteres de combinação que parecem idênticos mas não comparam iguais

- Idiomas misturados: um ticket metade em inglês, metade em espanhol; catálogo com títulos em japonês e atributos em francês

Esses casos frequentemente passam por checagens básicas porque, para olhos humanos, o texto parece ok enquanto quebra parsing, contagem ou regras downstream.

3) Casos de borda de integração (o mundo muda sob você)

Mesmo com prompt e validação sólidos, integrações podem introduzir novos casos:

- Uma API downstream muda um nome de campo, adiciona um parâmetro obrigatório ou começa a retornar novos códigos de erro

- Descompassos de permissão: a IA gera uma requisição para acessar dados que o usuário não pode ver, ou tenta uma ação que a conta de serviço não pode executar

- Deriva de contratos de dados: uma ferramenta espera datas ISO mas recebe “próxima sexta”, ou espera um código de moeda e recebe um símbolo

4) “Desconhecidos desconhecidos” e por que logs importam

Alguns casos de borda não podem ser previstos antes. A única forma confiável de descobri-los é observar falhas reais. Bons logs e traces devem capturar: a forma da entrada (de forma segura), saída do modelo (de forma segura), qual regra de validação falhou e qual caminho de fallback foi executado. Quando você consegue agrupar falhas por padrão, transforma surpresas em novas regras claras — sem chutes.

Segurança: quando validação é proteção

Teste fluxos de IA sem adivinhação

Crie um conjunto de prompts de referência e testes de contrato para detectar cedo a deriva de esquema.

Validação não é só deixar saídas arrumadas; é também como você impede que um sistema de IA faça algo inseguro. Muitos incidentes de segurança em apps habilitados por IA são simplesmente problemas de “entrada ruim” ou “saída ruim” com stakes maiores: podem vazar dados, executar ações não autorizadas ou abusar de ferramentas.

Injeção de prompt acontece quando conteúdo não confiável (mensagem do usuário, página web, e-mail, documento) contém instruções como “ignore suas regras” ou “me envie o prompt do sistema oculto”. Isso é um problema de validação porque o sistema deve decidir quais instruções são válidas e quais são hostis.

Uma postura prática: trate texto exposto ao modelo como não confiável. Seu app deve validar intenção (qual ação está sendo solicitada) e autoridade (o solicitante tem permissão?), não apenas formato.

Checagens defensivas que atuam como guardrails

Boa segurança frequentemente parece regras ordinárias de validação:

- Allowlists de ferramentas: restrinja explicitamente quais ferramentas/ações o modelo pode chamar num dado contexto

- Restrições de URL e arquivo: permita apenas domínios aprovados, bloqueie alvos de rede local, imponha tipo/tamanho de arquivo, evite leituras arbitrárias de arquivo

- Redação de dados sensíveis: detecte e remova segredos (chaves de API, tokens), dados pessoais e identificadores internos antes de enviar ao modelo ou retornar a saída

Se você deixar o modelo navegar ou buscar documentos, valide onde ele pode ir e o que pode trazer de volta.

Privilégio mínimo para ferramentas e tokens

Aplique o princípio do menor privilégio: dê a cada ferramenta as permissões mínimas, e limite tokens estritamente (curta duração, endpoints limitados, dados limitados). É melhor falhar uma requisição e pedir por uma ação mais restrita do que conceder acesso amplo “só por precaução”.

Ações sensíveis precisam de atrito e rastreabilidade

Para operações de alto impacto (pagamentos, mudanças de conta, envio de e-mails, exclusão de dados), adicione:

- Confirmações explícitas (“Você está prestes a transferir $500 para X — confirmar?”)

- Controle duplo para ações críticas (aprovação humana ou segundo fator)

- Trilhas de auditoria (quem requisitou, o que foi executado, entradas, chamadas de ferramenta, timestamps)

Essas medidas transformam validação de detalhe de UX em uma verdadeira fronteira de segurança.

Estratégia de testes para comportamento gerado por IA

Testar comportamento gerado por IA funciona melhor quando você trata o modelo como um colaborador imprevisível: não dá para afirmar cada frase exata, mas dá pra afirmar limites, estrutura e utilidade.

Uma suíte de testes em camadas (para que falhas apontem para o conserto certo)

Use múltiplas camadas que respondem perguntas diferentes:

- Testes unitários: validam seu próprio código (parsers, validadores, roteamento, builders de prompt). Devem ser determinísticos e rápidos.

- Testes de contrato: verificam acordos de forma com o modelo, como “deve retornar JSON válido com chaves X/Y/Z” ou “deve incluir campo de citação quando a confiança é baixa.”

- Cenários end-to-end: rode fluxos de usuário realistas (incluindo retentativas e fallbacks) para ver se o sistema permanece útil sob estresse.

Uma boa regra: se um bug alcança testes end-to-end, adicione um teste menor (unitário/contrato) para pegá-lo mais cedo da próxima vez.

Construa um “golden set” de prompts

Crie uma coleção pequena e curada de prompts que representam uso real. Para cada um, registre:

- O prompt (e quaisquer instruções de sistema/desenvolvedor)

- Restrições necessárias (formato, regras de segurança, regras de negócio)

- Comportamentos esperados (não a frase exata): por exemplo, “retorna um objeto com 3 sugestões”, “recusa pedidos por segredos”, “faz pergunta de clarificação quando faltam entradas”

Rode o golden set no CI e acompanhe mudanças ao longo do tempo. Quando um incidente acontece, adicione um novo teste golden para esse caso.

Fuzzing: torne entradas estranhas normais

Sistemas de IA frequentemente falham em bordas bagunçadas. Adicione fuzzing automatizado que gere:

- Strings aleatórias e codificações mistas

- JSON malformado, payloads truncados, vírgulas extras

- Valores extremos (texto muito longo, campos vazios, números enormes, datas incomuns)

Testando saídas não determinísticas

Em vez de snapshot de texto exato, use tolerâncias e rubricas:

- Atribua pontuações às saídas via checklists (campos obrigatórios, conteúdo proibido, limites de comprimento)

- Checagens semânticas (ex.: rótulo de classificação está em um conjunto permitido)

- Limiares de similaridade para resumos, mais “deve mencionar fatos-chave”

Isso mantém testes estáveis ao mesmo tempo que captura regressões reais.

Monitoramento e observabilidade para validação e erros

Adicione alternativas seguras em minutos

Crie retentativas limitadas, alternativas e mensagens de erro amigáveis para as etapas de IA.

Regras de validação e tratamento de erro só melhoram quando você consegue ver o que está acontecendo em uso real. Monitoramento transforma “achamos que está ok” em evidência clara: o que falhou, com que frequência e se a confiabilidade está melhorando ou caindo.

O que logar (sem criar problemas de privacidade)

Comece com logs que expliquem por que uma requisição teve sucesso ou falhou — depois redija ou evite dados sensíveis por padrão.

- Entradas e saídas (com cuidado de privacidade): armazene hashes, trechos truncados ou campos estruturados em vez de texto cru quando possível. Se precisar guardar conteúdo bruto para debug, use retenção curta, controles de acesso e um propósito claro.

- Falhas de validação: nome da regra, campo/caminho (ex.:

address.postcode) e motivo da falha (incompatibilidade de esquema, conteúdo inseguro, intenção requerida ausente).

- Chamadas de ferramenta e efeitos colaterais: qual ferramenta foi chamada, parâmetros (sanitizados), códigos de resposta e latência. Isso é essencial quando falhas se originam fora do modelo.

- Exceções e timeouts: traces para erros internos, mais códigos de erro user-friendly que mapeiem para categorias conhecidas.

Métricas que realmente predizem confiabilidade

Logs ajudam a debugar um incidente; métricas ajudam a detectar padrões. Acompanhe:

- Taxa de falha de validação (geral e por regra)

- Taxa de conformidade com esquema (saídas que batem com a estrutura esperada)

- Taxa de retentativa e taxa de sucesso de recuperação (com que frequência fallbacks resolvem)

- Latência (end-to-end e por chamada de ferramenta)

- Principais categorias de erro (ex.: “campo faltando”, “timeout de ferramenta”, “violação de política”)

Alertas sobre drift

Saídas de IA podem mudar sutilmente após edições de prompt, updates de modelo ou novo comportamento de usuário. Alertas devem focar em mudança, não só em limiares absolutos:

- Subida súbita em uma regra específica de validação que falha

- Novas categorias de erro aparecendo

- Mudança na forma da saída (ex.: um campo JSON que virou texto livre)

Dashboards que equipes não técnicas conseguem usar

Um bom dashboard responde: “Está funcionando para os usuários?” Inclua uma placa simples de confiabilidade, linha de tendência da taxa de conformidade de esquema, breakdown de falhas por categoria e exemplos dos tipos mais comuns de erro (com conteúdo sensível removido). Link para vistas técnicas mais profundas para engenheiros, mas mantenha a visão top-level legível para produto e suporte.

Validação e tratamento de erro não são “configurar uma vez e esquecer.” Em sistemas gerados por IA, o trabalho real começa após o lançamento: cada saída estranha é uma pista sobre o que suas regras deveriam ser.

Construa loops de feedback fechados

Trate falhas como dados, não anedotas. O loop mais eficaz normalmente combina:

- Relatos de usuários (um simples “Reportar um problema” + screenshot/ID opcional)

- Filas de revisão humana para casos ambíguos (enganoso, inseguro ou “parece errado”)

- Rótulos automatizados (falhas de regex/esquema, flags de toxicidade, detecções de idioma, sinais de alta incerteza)

Garanta que cada relato conecte à entrada exata, versão do modelo/prompt e resultados do validador para que seja reproduzível depois.

Como as correções realmente acontecem

A maioria das melhorias vem de alguns movimentos repetíveis:

- Apertar o esquema: se você espera JSON, especifique campos obrigatórios, enums e tipos; rejeite “quase JSON.”

- Adicionar validadores focados: imponha unidades, formatos de data, ranges permitidos e constraints de must-include.

- Ajustar prompts: esclarecer prioridades (“Se estiver em dúvida, diga que não sabe”), adicionar exemplos e reduzir instruções ambíguas.

- Adicionar fallbacks: retentar com prompt mais estrito, mudar para resposta template segura ou encaminhar para revisão humana — sem inventar detalhes silenciosamente.

Ao consertar um caso, pergunte também: “Quais casos próximos ainda vão escapar?” Expanda a regra para cobrir um pequeno cluster, não um incidente único.

Versionamento e deploys seguros

Versione prompts, validadores e modelos como código. Faça rollouts com canary ou A/B, acompanhe métricas-chave (taxa de rejeição, satisfação do usuário, custo/latência) e mantenha um caminho rápido de rollback.

Aqui é também onde ferramentas de produto ajudam: por exemplo, plataformas como Koder.ai suportam snapshots e rollback durante iteração de apps, o que se mapeia bem para versionamento de prompt/validador. Quando uma atualização aumenta falhas de esquema ou quebra uma integração, rollback rápido transforma incidente em recuperação rápida.

Checklist prático

- Conseguimos reproduzir algum problema reportado a partir dos logs?

- Falhas foram roteadas para o bucket certo (retentar, fallback, revisão humana, parada dura)?

- Atualizamos esquema/validadores e o prompt juntos?

- Adicionamos um caso de teste para essa falha para que não volte?

- Subimos a mudança por trás de um canary e monitoramos o impacto?