02 de dez. de 2025·8 min

A visão original de IA de Larry Page por trás do jogo de longo prazo do Google

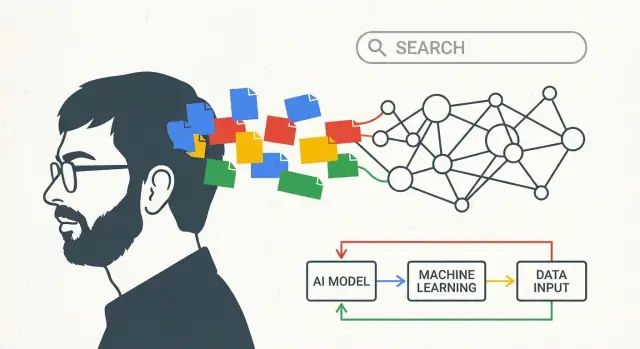

Explore como as ideias iniciais de Larry Page sobre IA e conhecimento moldaram a estratégia de longo prazo do Google — da qualidade da busca a moonshots e apostas IA-prioritárias.

O que este post quer dizer com “visão de IA de Larry Page”

Este não é um texto de hype sobre um único momento de breakthrough. Trata-se de pensamento de longo prazo: como uma empresa pode escolher uma direção cedo, continuar investindo através de múltiplas mudanças tecnológicas e, aos poucos, transformar uma grande ideia em produtos do dia a dia.

Quando este post fala em “visão de IA de Larry Page”, não quer dizer “o Google previu os chatbots de hoje”. Significa algo mais simples — e mais duradouro: construir sistemas que aprendem com a experiência.

Uma definição em termos simples

Aqui, “visão de IA” refere-se a algumas crenças conectadas:

- Computadores devem melhorar seu desempenho aprendendo com dados, não apenas seguindo regras escritas à mão.

- Os melhores sistemas ficam melhores ao longo do tempo porque o uso real gera feedback (o que as pessoas clicam, o que ignoram, como reformulam consultas).

- Para tornar o aprendizado prático, é preciso infraestrutura: computação rápida, armazenamento confiável e uma forma de rodar experimentos com segurança em grande escala.

Ou seja, a “visão” é menos sobre um único modelo e mais sobre um motor: coletar sinais, aprender padrões, entregar melhorias, repetir.

O arco que vamos seguir

Para tornar essa ideia concreta, o restante do post acompanha uma progressão simples:

- Busca: comece com um problema claro — ajudar pessoas a encontrar boas respostas.

- Dados + infraestrutura: use o uso real para aprender o que é “bom” e construa a maquinaria para processar isso.

- Produtos com IA como padrão: trate sistemas que aprendem como abordagem padrão, para que voz, imagens e novas interfaces funcionem bem sem reescrever tudo do zero.

No final, a “visão de IA de Larry Page” deve parecer menos um slogan e mais uma estratégia: investir cedo em sistemas de aprendizado, construir os canos que os alimentam e ter paciência enquanto o progresso se acumula ao longo dos anos.

O problema inicial que o Google tentou resolver: encontrar boas respostas

A web inicial tinha um problema simples com consequências desordenadas: de repente havia muito mais informação do que qualquer pessoa podia vasculhar, e a maioria das ferramentas de busca basicamente chutava o que importava.

Se você digitasse uma consulta, muitos mecanismos dependiam de sinais óbvios — com que frequência uma palavra aparecia numa página, se estava no título, ou quantas vezes o dono do site conseguia “enfiá-la” em texto invisível. Isso tornava os resultados fáceis de manipular e difíceis de confiar. A web crescia mais rápido do que as ferramentas destinadas a organizá-la.

PageRank, explicado como se você estivesse explicando uma recomendação

A grande sacada de Larry Page e Sergey Brin foi perceber que a web já trazia um sistema de votação embutido: os links.

Um link de uma página para outra é um pouco como uma citação num artigo ou uma recomendação de um amigo. Nem todas as recomendações valem o mesmo, porém. Um link vindo de uma página que muitas outras consideram valiosa deveria contar mais do que um link de uma página desconhecida. O PageRank transformou essa ideia em matemática: em vez de ranquear páginas apenas pelo que diziam sobre si mesmas, o Google ranqueava páginas pelo que o resto da web “dizia” sobre elas por meio de links.

Isso fez duas coisas importantes ao mesmo tempo:

- Ajudou a destacar páginas autoritativas mesmo quando não repetiam exatamente os termos da consulta.

- Tornou o ranqueamento mais difícil de manipular, porque a credibilidade precisava ser conquistada através da rede de sites.

Por que medição e iteração importaram desde o começo

Ter uma ideia de ranqueamento inteligente não era suficiente. A qualidade da busca é um alvo em movimento: novas páginas aparecem, spam se adapta, e o que as pessoas querem dizer com uma consulta pode mudar.

Então o sistema teve de ser mensurável e atualizável. O Google se apoiou em testes constantes — tentar mudanças, medir se os resultados melhoraram e repetir. Esse hábito de iteração moldou a abordagem de longo prazo da empresa para sistemas de “aprendizado”: trate a busca como algo que se pode avaliar continuamente, não como um projeto de engenharia único.

Dados como um volante de inércia: aprender com o uso real

Uma boa busca não é só sobre algoritmos engenhosos — é sobre a qualidade e a quantidade de sinais dos quais esses algoritmos podem aprender.

O Google inicial tinha uma vantagem embutida: a própria web é cheia de “votos” sobre o que importa. Links entre páginas (a base do PageRank) atuam como citações, e o texto âncora (“clique aqui” vs. “melhores botas de trilha”) adiciona significado. Além disso, padrões de linguagem através das páginas ajudam um sistema a entender sinônimos, variações de ortografia e as muitas formas de perguntar a mesma coisa.

O ciclo de feedback que se compõe

Quando as pessoas começam a usar um motor de busca em escala, o uso cria sinais adicionais:

- Cliques mostram quais resultados parecem relevantes para usuários reais numa dada consulta.

- “Cliques longos” vs. ir-e-vir rápidos podem indicar satisfação.

- Reformulações de consulta (buscar novamente com palavras diferentes) podem revelar incompatibilidades entre intenção e resultados.

Esse é o volante: melhores resultados atraem mais uso; mais uso cria sinais mais ricos; sinais mais ricos melhoram o ranqueamento e o entendimento; e essa melhoria puxa ainda mais usuários. Com o tempo, a busca deixa de ser um conjunto fixo de regras e vira um sistema de aprendizado que se adapta ao que as pessoas realmente acham útil.

Por que a variedade de dados importa

Diferentes tipos de dados se reforçam mutuamente. A estrutura de links pode destacar autoridade, enquanto o comportamento de cliques reflete preferências atuais, e os dados de linguagem ajudam a interpretar consultas ambíguas (“jaguar” animal vs. carro). Juntos, tornam possível responder não apenas “quais páginas contêm essas palavras”, mas “qual é a melhor resposta para esta intenção”.

Uma nota sobre privacidade

Esse volante levanta questões óbvias de privacidade. Reportagens bem fundamentadas há muito observam que grandes produtos consumidores geram dados massivos de interação, e que empresas usam sinais agregados para melhorar a qualidade. Também é amplamente documentado que o Google investiu em controles de privacidade e segurança ao longo do tempo, embora os detalhes e a eficácia sejam debatidos.

A conclusão é simples: aprender com o uso real é poderoso — e a confiança depende de quão responsavelmente esse aprendizado é conduzido.

Construindo a “máquina”: infraestrutura que tornou a IA prática

O Google não investiu cedo em computação distribuída porque era moda — era a única forma de acompanhar a escala bagunçada da web. Se você quer rastrear bilhões de páginas, atualizar ranqueamentos com frequência e responder a consultas em frações de segundo, não dá para contar com um único computador gigante. Você precisa de milhares de máquinas mais baratas trabalhando juntas, com software que trate falhas como normais.

Por que a computação distribuída importou tão cedo

A busca forçou o Google a construir sistemas que pudessem armazenar e processar enormes quantidades de dados de forma confiável. Essa mesma abordagem de “muitas máquinas, um sistema” virou a base para tudo que veio depois: indexação, analytics, experimentação e, eventualmente, machine learning.

A ideia-chave é que infraestrutura não é separada da IA — ela determina que tipos de modelos são possíveis.

Como a infraestrutura transforma IA de demo em produto

Treinar um modelo útil significa mostrá-lo a muitos exemplos reais. Servir esse modelo significa executá-lo para milhões de pessoas, instantaneamente, sem quedas. Ambos são problemas de escala:

- Treinamento precisa de grande poder de processamento para atravessar dados repetidamente.

- Servir precisa de sistemas de baixa latência para fazer previsões rápidas (frequentemente em milissegundos), mesmo durante picos de tráfego.

Uma vez que você constrói pipelines para armazenar dados, distribuir computação, monitorar desempenho e entregar atualizações com segurança, sistemas baseados em aprendizado podem melhorar continuamente em vez de chegar como reescritas raras e arriscadas.

Exemplos simples e cotidianos de “IA movida por canos”

Algumas funcionalidades familiares mostram por que a máquina era importante:

- Correção ortográfica: notar padrões como “restarant” → “restaurant” exige aprender com muitas buscas e cliques, depois aplicar correções instantaneamente na hora da consulta.

- Autocomplete: prever o que você está prestes a digitar depende do comportamento agregado e de inferência rápida — caso contrário as sugestões atrasam e parecem erradas.

- Tradução: melhor qualidade de tradução vem de treinar com grandes conjuntos de dados e entregar modelos que rodem rápido para usuários ao redor do mundo.

A vantagem de longo prazo do Google não era só ter algoritmos inteligentes — era construir o motor operacional que permitia aos algoritmos aprender, entregar e melhorar em escala de internet.

De regras a aprendizado: como a busca silenciosamente ficou mais “parecida com IA”

Implemente rapidamente um ciclo de aprendizado

Crie um MVP web ou de backend a partir do chat e adicione ciclos de feedback para aprender com os usuários.

O Google inicial já parecia “inteligente”, mas grande parte dessa inteligência era engenheirada: análise de links (PageRank), sinais de ranqueamento ajustados manualmente e muitas heurísticas para spam. Com o tempo, o centro de gravidade mudou de regras explicitamente escritas para sistemas que aprendiam padrões a partir dos dados — especialmente sobre o que as pessoas querem dizer, não apenas o que digitam.

Como o ML mudou a sensação da busca

O aprendizado de máquina melhorou gradualmente três coisas que usuários comuns percebem:

- Qualidade do ranqueamento: em vez de ponderar sinais com fórmulas fixas, modelos aprenderam quais combinações de sinais tendem a satisfazer usuários (medido por comportamento agregado anonimizado e feedback de avaliadores humanos).

- Compreensão de intenção: consultas como “jaguar speed” ou “apple support” forçam modelos a inferir significado, contexto e ambiguidade. Sistemas baseados em aprendizado ficaram melhores em mapear palavras a conceitos e prováveis objetivos.

- Spam e confiança: à medida que fazendas de conteúdo e SEO manipulativo cresceram, ML ajudou a detectar padrões de link não naturais, conteúdo raso e outras táticas — apoiando o movimento mais amplo por resultados de alta qualidade.

Uma linha do tempo amigável ao leitor

- 1998: PageRank e o artigo original do Google estabelecem a base para relevância via links.

- Início dos anos 2000: correção ortográfica estatística e sugestões de consulta melhoram o “queria dizer” e as reformulações.

- 2011: Panda mira conteúdo de baixa qualidade; sinais de qualidade se tornam mais sistemáticos.

- 2012: Penguin penaliza manipulação de links, levando o anti-spam além de regras manuais.

- 2015: RankBrain (componente de ranqueamento baseado em aprendizado) ajuda com consultas desconhecidas ou ambíguas.

- 2018–2019: neural matching e BERT trazem melhor entendimento de linguagem, especialmente para consultas mais longas e preposições.

- 2021+: era MUM com modelos multitarefa e esforços por “conteúdo útil” empurram em direção a sinais mais profundos de intenção e utilidade.

Fontes que vale citar

Para credibilidade, cite uma mistura de pesquisa primária e explicações públicas de produto:

- Artigos de pesquisa: Brin & Page (PageRank, 1998), BERT (Devlin et al., 2018).

- Anúncios oficiais de busca: posts no blog do Google Search sobre RankBrain, BERT, MUM, atualizações Panda/Penguin.

- Palestras/entrevistas/eventos: entrevistas com Amit Singhal sobre a evolução do ranqueamento; keynotes de Sundar Pichai (Google I/O); eventos “Search On” para marcos mais modernos.

Cultura de pesquisa: transformar apostas de longo prazo em sistemas úteis

O jogo de longo prazo do Google não era só ter grandes ideias — dependia de uma cultura de pesquisa capaz de transformar artigos acadêmicos em coisas que milhões de pessoas realmente usassem. Isso significava recompensar a curiosidade, mas também construir caminhos de um protótipo para um produto confiável.

De “publicar” a “publicar em produção”

Muitas empresas tratam pesquisa como uma ilha separada. O Google estimulou um circuito mais fechado: pesquisadores podiam explorar direções ambiciosas, publicar resultados e ainda colaborar com times de produto que se importavam com latência, confiabilidade e confiança do usuário. Quando esse ciclo funciona, um artigo não é linha de chegada — é o início de um sistema mais rápido e melhor.

Uma forma prática de ver isso é como ideias de modelos aparecem em recursos “pequenos”: melhor correção ortográfica, ranqueamento mais esperto, recomendações melhores ou tradução que soa menos literal. Cada passo pode parecer incremental, mas juntos mudam o que “buscar” significa.

Esforços emblemáticos que marcaram o ritmo

Vários esforços se tornaram símbolos dessa pipeline de artigo para produto. O Google Brain ajudou a empurrar deep learning para dentro da empresa ao provar que podia superar abordagens antigas com dados e compute suficientes. Depois, o TensorFlow facilitou treinar e implantar modelos de forma consistente — um ingrediente pouco glamuroso, mas crucial para escalar ML por muitos produtos.

Trabalhos de pesquisa em tradução neural, reconhecimento de fala e visão também passaram do laboratório para experiências cotidianas, frequentemente depois de múltiplas iterações que melhoraram qualidade e reduziram custo.

Por que paciência importa

A curva de retorno raramente é imediata. Versões iniciais podem ser caras, imprecisas ou difíceis de integrar. A vantagem vem de persistir com a ideia tempo suficiente para construir infraestrutura, coletar feedback e refinar o modelo até que seja confiável.

Essa paciência — financiar “apostas de longo prazo”, aceitar desvios e iterar por anos — ajudou a converter conceitos ambiciosos de IA em sistemas úteis nos quais as pessoas podiam confiar em escala do Google.

Novas entradas: voz, imagens e vídeo forçaram modelos mais espertos

A busca por texto recompensava truques de ranqueamento. Mas no momento em que o Google começou a receber voz, fotos e vídeo, a abordagem antiga encontrou um limite. Essas entradas são bagunçadas: sotaques, ruído de fundo, imagens borradas, filmagens tremidas, gírias e contexto que não está escrito em lugar nenhum. Para torná-las úteis, o Google precisou de sistemas que aprendessem padrões a partir de dados em vez de depender de regras escritas à mão.

Voz: transformar som em intenção

Com busca por voz e ditado no Android, o objetivo não era apenas “transcrever palavras”. Era entender o que alguém queria — rapidamente, no dispositivo ou sobre conexões instáveis.

O reconhecimento de fala empurrou o Google em direção ao aprendizado de máquina em grande escala porque o desempenho melhorava mais quando modelos eram treinados com enormes e diversos conjuntos de áudio. Essa pressão de produto justificou investimento sério em compute (para treinar), ferramentas especializadas (pipelines de dados, conjuntos de avaliação, sistemas de implantação) e contratação de pessoas capazes de iterar em modelos como produtos vivos — não demos de pesquisa pontuais.

Fotos: significado, não metadados

Fotos não chegam com palavras-chave. Usuários esperam que o Google Photos encontre “cachorros”, “praia” ou “minhas férias em Paris”, mesmo que nunca tenham marcado nada.

Essa expectativa forçou um entendimento de imagem mais forte: detecção de objetos, agrupamento de rostos e busca por similaridade. De novo, regras não cobrem a variedade da vida real, então sistemas de aprendizado tornaram-se o caminho prático. Melhorar a precisão exigiu mais dados rotulados, infraestrutura de treinamento melhor e ciclos de experimentação mais rápidos.

Vídeo e recomendações: a escala expõe fraquezas

Vídeo adiciona um desafio duplo: são imagens ao longo do tempo mais áudio. Ajudar usuários a navegar no YouTube — busca, legendas, “Próximo” e filtros de segurança — exigiu modelos que generalizassem entre tópicos e idiomas.

Recomendações deixou a necessidade de ML ainda mais clara. Quando bilhões de usuários clicam, assistem, pulam e retornam, o sistema precisa se adaptar continuamente. Esse tipo de ciclo de feedback naturalmente premiou investimentos em treinamento escalável, métricas e talento para manter modelos melhorando sem quebrar a confiança.

A mudança para IA-prioritária: tornar a IA padrão, não um recurso

Assuma o controle do seu resultado

Mantenha o controle exportando o código-fonte quando estiver pronto para assumir toda a pipeline.

“IA-prioritária” é mais fácil de entender como uma decisão de produto: em vez de adicionar IA como uma ferramenta especial à parte, você a trata como parte do motor dentro de tudo que as pessoas já usam.

O Google descreveu essa direção publicamente por volta de 2016–2017, enquadrando-a como uma mudança de “mobile-first” para “AI-first”. A ideia não era que toda funcionalidade de repente se tornasse “inteligente”, mas que a forma padrão de melhoria dos produtos seria cada vez mais por sistemas de aprendizado — ranqueamento, recomendações, reconhecimento de fala, tradução e detecção de spam — em vez de regras ajustadas manualmente.

IA dentro do loop principal

Na prática, uma abordagem IA-prioritária aparece quando o “loop principal” de um produto muda silenciosamente:

- Resultados de busca melhoram porque o sistema aprende padrões em consultas e cliques, não porque uma equipe codificou milhares de regras if-then.

- Fotos são organizadas pelo que nelas aparece, não apenas por nomes de arquivos e pastas.

- O Gmail pega mais mensagens indesejadas aprendendo comportamentos em vez de apenas casar palavras-chave conhecidas.

O usuário pode nunca ver um botão escrito “IA”. Apenas percebe menos resultados errados, menos atrito e respostas mais rápidas.

Assistentes elevaram a barra para linguagem natural

Assistentes de voz e interfaces conversacionais mudaram expectativas. Quando as pessoas podem dizer “Me lembre de ligar para a mãe quando eu chegar em casa”, passam a esperar que o software entenda intenção, contexto e linguagem cotidiana imperfeita.

Isso empurrou produtos para o entendimento de linguagem natural como capacidade básica — na fala, na digitação e até na câmera (apontar o telefone para algo e perguntar o que é). A mudança foi tanto para atender hábitos novos de usuários quanto por ambição de pesquisa.

Importante: “IA-prioritária” é melhor lida como uma direção — apoiada por declarações públicas repetidas e movimentos de produto — em vez de uma afirmação de que a IA substituiu todas as outras abordagens de uma hora para outra.

Alphabet e o jogo de longo prazo: espaço para apostas além da busca

A criação do Alphabet em 2015 foi menos um rebranding e mais uma decisão operacional: separar o núcleo maduro e gerador de receita (Google) dos esforços mais arriscados e de horizonte mais longo (frequentemente chamados de “Other Bets”). Essa estrutura importa se você está pensando na visão de IA de Larry Page como um projeto de décadas em vez de um único ciclo de produto.

Por que separar “core” de “apostas”

Google Search, Ads, YouTube e Android precisavam de execução implacável: confiabilidade, controle de custos e iteração constante. Moonshots — carros autônomos, ciências da vida, projetos de conectividade — precisavam de outra coisa: tolerância à incerteza, espaço para experimentos caros e permissão para errar.

Sob o Alphabet, o núcleo pôde ser gerido com expectativas de desempenho claras, enquanto apostas podiam ser avaliadas por marcos de aprendizado: “Provamos uma suposição técnica chave?” “O modelo melhorou o suficiente com dados do mundo real?” “O problema é mesmo solucionável com níveis aceitáveis de segurança?”

A lógica do moonshot: experimentação como estratégia

Essa mentalidade de “jogo de longo prazo” não assume que todo projeto vai vencer. Assume que a experimentação sustentada é como você descobre o que será importante depois.

Uma fábrica de moonshots como o X é um bom exemplo: equipes testam hipóteses ousadas, instrumentam os resultados e matam ideias rapidamente quando a evidência é fraca. Essa disciplina é especialmente relevante para IA, onde o progresso muitas vezes depende da iteração — melhores dados, melhores setups de treinamento, melhores avaliações — não apenas de um único avanço.

O que levar daqui (sem promessas)

O Alphabet não era garantia de vitórias futuras. Era uma forma de proteger dois ritmos diferentes de trabalho:

- Manter o negócio core focado e responsável.

- Criar um lar explícito para pesquisas e apostas de alta variância.

Para times, a lição é estrutural: se você quer resultados de IA de longo prazo, projete para isso. Separe entrega de curto prazo de trabalho exploratório, financie experimentos como veículos de aprendizado e meça progresso em insights validados — não apenas manchetes.

As partes difíceis: qualidade, segurança e confiança em escala

Experimente sem medo

Teste uma ideia com segurança usando snapshots e rollback quando um experimento não funcionar.

Quando sistemas de IA atendem bilhões de consultas, pequenas taxas de erro viram manchetes diárias. Um modelo que está “na maior parte certo” ainda pode enganar milhões — especialmente em saúde, finanças, eleições ou notícias de última hora. Em escala do Google, qualidade não é algo opcional; é uma responsabilidade que se compõe.

As principais trocas

Viés e representação. Modelos aprendem padrões dos dados, inclusive vieses sociais e históricos. Ranqueamentos “neutros” ainda podem amplificar pontos de vista dominantes ou atender mal línguas e regiões minoritárias.

Erros e excesso de confiança. IA costuma falhar de maneiras que soam convincentes. Os erros mais danosos não são bugs óbvios; são respostas plausíveis que os usuários confiam.

Segurança vs. utilidade. Filtros fortes reduzem danos, mas também podem bloquear consultas legítimas. Filtros fracos aumentam cobertura, mas elevam o risco de golpes, automutilação ou desinformação.

Responsabilização. À medida que sistemas ficam mais automatizados, fica mais difícil responder perguntas básicas: Quem aprovou esse comportamento? Como foi testado? Como os usuários apelam ou corrigem?

Por que escalar aumenta a necessidade de guardrails

Escalar melhora capacidade, mas também:

- Expande o número de casos de borda (línguas, culturas, contextos sensíveis)

- Aumenta incentivos para abuso (spam, injeção de prompt, SEO adversarial)

- Torna falhas mais difíceis de reverter uma vez integradas a produtos

Por isso guardrails também devem escalar: suítes de avaliação, red-teaming, aplicação de políticas, proveniência das fontes e interfaces claras que sinalizem incerteza.

Um checklist prático para avaliar afirmações de IA

Use isto para julgar qualquer recurso “potencializado por IA” — seja do Google ou de qualquer outro:

- Qual é o modo de falha? Eles mostram onde quebra, não apenas demos?

- Como é medido? Procure por métricas reais (acurácia, taxas de toxicidade, taxas de alucinação), não “melhorias” vagas.

- Em que dados foi treinado? No mínimo: categorias amplas, recência e políticas de exclusão.

- Quais são os guardrails? Regras de segurança, caminhos de revisão humana e monitoramento de abuso.

- Os usuários podem verificar? Citações, links ou explicações que permitam checar afirmações.

- Como são tratadas correções? Relatórios claros, atualizações rápidas e auditabilidade.

Confiança se conquista com processos repetíveis — não com um único modelo revolucionário.

Lições para times: como pensar em IA no longo prazo

O padrão mais transferível por trás do longo arco do Google é simples: objetivo claro → dados → infraestrutura → iteração. Você não precisa da escala do Google para usar esse loop — precisa de disciplina sobre o que está otimizando e uma forma de aprender com uso real sem se enganar.

O padrão central que você pode copiar

Comece com uma promessa de usuário mensurável (velocidade, menos erros, melhores correspondências). Instrumente isso para observar resultados. Construa a mínima “máquina” que permita coletar, rotular e entregar melhorias com segurança. Depois itere em passos pequenos e frequentes — trate cada lançamento como uma oportunidade de aprendizado.

Se seu gargalo é simplesmente sair da “ideia” para o “produto instrumentado” rápido demais, fluxos de trabalho modernos podem ajudar. Por exemplo, Koder.ai é uma plataforma vibe-coding onde equipes podem criar apps web, backend ou mobile a partir de uma interface de chat — útil para levantar um MVP que inclua ciclos de feedback (joinha/baixo, reportar problema, pesquisas rápidas) sem esperar semanas por um pipeline customizado. Recursos como modo de planejamento e snapshots/rollback também mapeiam bem para o princípio “experimente com segurança, meça, itere”.

6 lições para líderes aplicarem (sem ser o Google)

- Escolha uma estrela do norte que seja percebida pelo usuário. “Melhorar a experiência de busca” é mais claro que “adotar IA”. Defina sucesso em termos que as pessoas sintam.

- Projete seu produto para criar dados de aprendizado. Adicione ciclos de feedback (joinha/baixo, correções, “isso ajudou?”) que capturem intenção, não apenas cliques.

- Invista cedo em canos, não só em modelos. Verificações de qualidade de dados, painéis de avaliação e fluxos de implantação batem protótipos pontuais.

- Trate avaliação como um recurso de produto. Crie um scorecard repetível (qualidade, latência, custo, segurança) para que iteração não vire chute.

- Entregue em fatias. Comece com casos de uso estreitos, rode para uma audiência pequena, meça e depois expanda. Momentum vence lançamentos em grande escala.

- Torne apostas de longo prazo sobrevivíveis. Reserve uma pequena porção de capacidade para experimentos, mas exija marcos claros de aprendizado para mantê-los honestos.

Leituras relacionadas

Se quiser passos práticos seguintes, vincule estes textos à lista de leitura do seu time:

- /blog/ai-strategy-basics

- /blog/data-flywheels-for-product-teams

- /blog/evaluating-ml-models-without-a-phd

- /blog/ai-governance-lightweight