Почему код, сгенерированный ИИ, и автоматическая генерация тестов — естественные партнёры

Код приложения, написанный с помощью ИИ, означает, что «рабочие» части вашей кодовой базы создаются при поддержке ассистента: новые функции, небольшие фичи, рефакторы, обработка крайних случаев и даже переписывание существующих модулей. Вы по‑прежнему решаете, что строить, но первая версия реализации часто появляется быстрее — и иногда с допущениями, которые вы заметите только позже.

Автоматическая генерация тестов — это зеркальная способность со стороны верификации. Вместо того чтобы писать каждый тест вручную, инструменты могут предлагать тестовые случаи и утверждения на основе вашего кода, спецификации или шаблонов, извлечённых из прошлых багов. На практике это может выглядеть так:

- «Учитывая сигнатуру этой функции и ветви, вот тесты, покрывающие типичные входы, границы и пути ошибок.»

- «Вот регрессионные тесты, воспроизводящие краш, который мы видели в продакшне.»

Главное ожидание: сгенерированные тесты не автоматически «хороши»

Сгенерированный тест может вводить в заблуждение: он может утверждать текущее поведение, даже если поведение неверно, или пропустить продуктовые правила, которые хранятся в головах людей и в комментариях к тикетам. Поэтому важна человеческая проверка. Кто‑то должен подтвердить, что название теста, подготовка и утверждения отражают реальный замысел — а не просто то, что код делает сегодня.

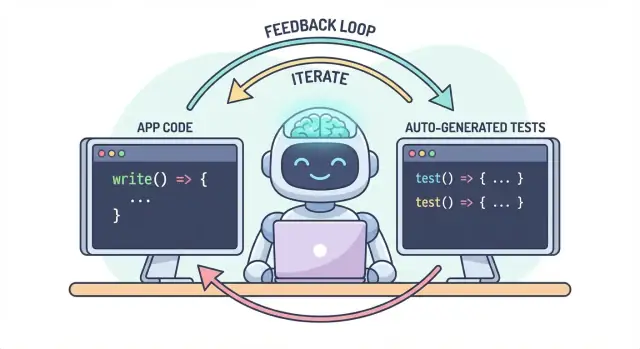

Один рабочий поток, два артефакта

Основная идея проста: код и тесты должны развиваться вместе в рамках одного рабочего потока. Если ИИ помогает быстро менять логику, автоматическая генерация тестов помогает так же быстро зафиксировать ожидаемое поведение — чтобы следующее изменение (человеческое или ИИ) имело чёткое, исполнимое определение «по‑прежнему корректно».

На практике такой подход «параллельного результата» легче поддерживать, когда ваш процесс уже основан на чате. Например, в Koder.ai (vibe-coding‑платформа для создания веб-, бэкенд- и мобильных приложений через чат) естественно рассматривать «фичу + тесты» как единый результат: вы описываете поведение, генерируете реализацию, затем генерируете и ревьюите тесты в том же разговоре перед деплоем.

Проблема: более быстрый код может означать более быстрые баги

Код, написанный ИИ, может ощущаться как суперсила: фичи появляются быстро, бойлерплейт исчезает, рефакторы, которые раньше занимали часы, могут быть сделаны до остывания кофе. Но скорость меняет форму риска. Когда код проще производить, легче и выпускать ошибки — иногда тонкие.

Частые способы провалиться для логики, сгенерированной ИИ

Ассистенты ИИ хороши в генерации «разумных» реализаций, но разумно — не всегда корректно для вашей предметной области.

Крайние случаи — первая жертва. ИИ‑логика часто хорошо обрабатывает счастливый путь, а затем наталкивается на граничные условия: пустые входы, часовые пояса, округление, null‑значения, поведение при повторных попытках или состояния «это не должно происходить», которые всё же происходят в продакшне.

Неверные предположения — ещё одна частая проблема. Ассистент может вывести требования, которые не были озвучены («пользователи всегда аутентифицированы», «ID — числовые», «это поле всегда присутствует»), или внедрить знакомый паттерн, который не соответствует правилам вашей системы.

Тихие регрессии часто самые дорогие. Вы просите небольшое изменение, ассистент переписывает кусок логики, и что‑то несвязанное ломается — без явных ошибок. Код всё ещё компилируется, UI загружается, но правило ценообразования, проверка разрешений или преобразование данных стали чуть неверными.

Почему ручное тестирование не масштабируется с ростом скорости

Когда изменения кода ускоряются, ручное тестирование становится узким местом и лотереей. Либо вы тратите больше времени на клики (замедляя поставку), либо тестируете меньше (увеличивая число «утечек»). Даже дисциплинированные QA‑команды не могут вручную покрыть все варианты, когда изменения частые и широкие.

Ещё хуже: ручные проверки тяжело повторять последовательно. Они живут в чьей‑то памяти или чеклисте и легко пропускаются при жёстких дедлайнах — ровно тогда, когда риск наивысший.

Тесты как страховочная сетка и средство коммуникации

Автоматические тесты создают долговечную страховочную сетку: они делают ожидания исполняемыми. Хороший тест говорит: «При этих входах и в этом контексте ожидается такой результат». Это не только верификация; это коммуникация для будущего вас, команды и даже для ИИ‑ассистента.

Когда тесты есть, изменения становятся менее пугающими: обратная связь немедленная. Вместо обнаружения проблем после кода‑ревью, в стейджинге или от клиентов — вы находите их через минуты после изменения.

Поймайте проблемы раньше, чтобы уменьшить переделки

Чем раньше пойман баг, тем дешевле его фиксить. Тесты укорачивают цикл обратной связи: они выявляют несоответствия предположений и пропущенные крайние случаи, пока намерение ещё свежее. Это уменьшает переделки, избегает патчей «fix‑forward» и предотвращает превращение скорости ИИ в хаотичные повторные правки.

Как тесты создают петлю обратной связи для логики, сгенерированной ИИ

Код, сгенерированный ИИ, эффективен, когда вы рассматриваете его как диалог, а не как одноразовый артефакт. Тесты — то, что делает этот диалог измеримым.

Петля «спек → код → тесты» (по‑простому)

-

Спек: вы описываете, что должно происходить (входы, выходы, крайние случаи).

-

Код: ИИ пишет реализацию, которая утверждает, что соответствует описанию.

-

Тесты: вы (или ИИ) генерируете проверки, которые доказывают, что поведение действительно соответствует описанию.

Повторяйте эту петлю — и вы не просто производите больше кода, вы постоянно уточняете определение «готово».

Тесты вынуждают яснее формулировать требования и интерфейсы

Расмытое требование вроде «корректно обрабатывать невалидных пользователей» легко обойти в коде. Тест не может быть расплывчатым. Он заставляет конкретизировать:

- Что считается «невалидным»? Отсутствующий ID, заблокированный статус, неправильно сформированный email?

- Что значит «корректно обрабатывать»? Сообщение об ошибке, код статуса, значение по умолчанию?

- Какой интерфейс? Сигнатура функции, форма возвращаемого значения, исключения?

Как только вы пробуете выразить эти детали в тесте, неясности вскрываются. Эта ясность улучшает промпт для ИИ и зачастую ведёт к более простым и стабильным интерфейсам.

Сгенерированные тесты проверяют то, что код утверждает

Код от ИИ может выглядеть корректно, скрывая предположения. Сгенерированные тесты — практичный способ проверить утверждения кода:

- «Эта функция чистая» → тест на отсутствие внешних сайд‑эффектов.

- «Обрабатывает крайние случаи» → тесты на null, пустые списки, граничные значения.

- «Совместимость назад» → тесты для старых входов и ожидаемых выходов.

Цель — не слепо доверять сгенерированным тестам, а использовать их как быстрый, структурированный скептицизм.

Падающий тест становится следующим промптом

Падающий тест — это действенная обратная связь: он указывает на конкретное несоответствие между спеками и реализацией. Вместо того чтобы просить ИИ «пофиксить», вы можете вставить ошибку и сказать: «Обнови код так, чтобы этот тест проходил, не меняя публичный API». Это превращает отладку в целенаправленную итерацию, а не в игру в догадки.

Где автоматическая генерация тестов вписывается в вашу пирамиду тестов

Автогенерация тестов наиболее полезна, когда она поддерживает существующую стратегию тестирования — особенно классическую «пирамиду тестов». Пирамида не ради самой себя; она помогает сохранить обратную связь быстрой и надёжной, при этом ловя реальные сбои.

ИИ может помогать создавать тесты на каждом уровне, но лучшие результаты вы получаете, генерируя больше дешёвых тестов (внизу пирамиды) и меньше дорогих (вверху). Такой баланс сохраняет CI быстрым и по‑прежнему защищает UX.

Модульные (unit) тесты: быстрые, фокусные и легко генерируемые

Модульные тесты — это небольшие проверки отдельных функций, методов или модулей. Они выполняются быстро, не требуют внешних систем и идеально подходят для автоматической генерации покрытий крайних случаев.

Хорошие применения автоматической генерации здесь:

- прогон валидации входов и «странных» граничных значений

- проверка бизнес‑правил (скидки, права, переходы состояний)

- закрепление фиксов багов регрессионными тестами

Поскольку модульные тесты узконаправленны, их проще ревьюить и они реже становятся флейковыми.

Интеграционные тесты: меньше, но с высокой ценностью

Интеграционные тесты проверяют, как части работают вместе: ваш API с базой, сервис, вызывающий другой сервис, обработку очередей, аутентификацию и т. д.

Сгенерированные интеграционные тесты могут быть ценными, но требуют дисциплины:

- явные setup/teardown, чтобы тесты не протекали данных

- стабильные тестовые среды (контейнеры, тестовые БД, моки, где уместно)

- утверждения, фокусирующиеся на результатах, а не на внутренних деталях реализации

Думайте о них как о проверках контрактов между компонентами.

E2E: генерируйте экономно

End‑to‑end тесты проверяют ключевые пользовательские пути. Это самые дорогие: медленнее выполняются, более ломкие и сложнее дебажить.

Автоматическая генерация может помочь набросать сценарии E2E, но их нужно тщательно кураторить. Держите небольшой набор критичных путей (регистрация, оформление заказа, основной рабочий поток) и избегайте попыток генерировать E2E для каждой фичи.

Практическая рекомендация: сбалансированная смесь

Не стремитесь генерировать всё подряд. Вместо этого:

- генерируйте много модульных тестов, чтобы удерживать честность логики на уровне функций

- добавляйте целевые интеграционные тесты для самых рискованных стыков (БД, auth, платежи)

- поддерживайте минимальный набор E2E для неминуемых пользовательских путей

Такой подход сохраняет пирамиду и делает автогенерацию тестов мультипликатором силы, а не источником шума.

Откуда генерировать тесты: код, спеки и реальные баги

Автоматическая генерация тестов не ограничивается «написать модульные тесты для этой функции». Наиболее полезные генераторы берут данные из трёх источников: существующего кода, намерения за ним и уже встреченных ошибок.

1) Из структуры кода: упражняйте поведение, а не только строки

Учитывая функцию или модуль, инструменты могут вывести тестовые случаи на основе входов/выходов, ветвления и путей исключений. Это обычно включает:

- «счастливый путь» с ожидаемым результатом

- граничные значения (пустые строки, ноль, максимальная длина)

- покрытие ветвлений (if/else)

- обработку ошибок (некорректные входы, отсутствующие поля, таймауты)

Такой подход хорош, чтобы быстро окружить ИИ‑сгенерированную логику проверками, подтверждающими её текущее поведение.

2) Из требований: превращайте намерение в исполняемые примеры

Если у вас есть критерии приёмки, юзер‑стори или таблицы примеров, генераторы могут конвертировать их в тесты, которые читаются как спецификация. Это часто ценнее тестов, выведенных из кода, потому что фиксирует «что должно происходить», а не «что сейчас происходит».

Практический паттерн: дайте несколько конкретных примеров (входы + ожидаемые исходы) и попросите генератор добавить граничные случаи, согласующиеся с этими правилами.

3) Из отчётов об ошибках: воспроизведите сначала, затем предотвратите

Генерация на основе багов — самый быстрый путь к значимой регрессионной сборке. Передайте шаги воспроизведения (или логи и минимальную нагрузку) и сгенерируйте:

- тест, который падает на текущем баге, затем

- тот же тест, проходящий после фикса — навсегда защищая от повторного появления

Снапшот/золотые тесты: полезно, но с оговорками

Snapshot (golden) тесты эффективны для стабильных выходов (рендер UI, сериализованные ответы). Используйте их аккуратно: большие снапшоты могут «утвердить» тонкие ошибки. Предпочитайте маленькие, фокусные снапшоты и комбинируйте их с утверждениями по ключевым полям, которые должны быть корректны.

С чего начать тестирование (без попытки покрыть всё сразу)

Автоматическая генерация тестов наиболее эффективна, когда вы даёте ей чёткие приоритеты. Если направить её на весь код и попросить «все тесты», вы получите шум: много низкоценностных проверок, дублирование и ломкие тесты, замедляющие доставку.

Начните с того, что принесёт бизнес‑боль

Начните с потоков, которые будут дороже всего при сломе — финансово, юридически или репутационно. Простой фильтр по риску держит объём реалистичным и быстро повышает качество.

Сфокусируйтесь в первую очередь на:

- бизнес‑критичных путях (регистрация, оформление заказа, основные рабочие процессы) и областях, которые часто меняются (активные фичи, рефакторы, новые интеграции)

- высокорисковых доменах: платежи, аутентификация, целостность данных, права/роли и всё, что влияет на то, что видят и делают пользователи

Для каждого выбранного потока генерируйте тесты по слоям: несколько быстрых модульных тестов для сложной логики и один‑два интеграционных теста, подтверждающих работу всего пути.

«Счастливый путь + топовые крайние случаи» лучше, чем исчерпывающие комбинации

Попросите покрытие, соответствующее реальным сбоям, а не теоретическим перестановкам. Хорошая стартовая наборка:

- один тест счастливого пути, подтверждающий ожидаемое поведение

- главные крайние случаи: отсутствующий/некорректный ввод, истёкшие токены, недостаточные права, конфликты параллелизма и «пустое состояние» данных

Позже можно расширять набор по мере багов, инцидентов или обратной связи пользователей.

Определите "done", чтобы оно оставалось done

Сделайте правило явным: фича не считается завершённой, пока существуют тесты. Это определение готовности особенно важно с ИИ‑кодом, потому что оно предотвращает превращение «быстрой доставки» в «быстрые регрессии». Если хотите закрепить практику, встроите её в рабочий процесс (например, требовать релевантные тесты перед мерджем в CI) и зафиксируйте в командных документах (например, /engineering/definition-of-done).

Шаблоны промптов, которые дают лучшие тесты

ИИ может генерировать тесты быстро, но качество сильно зависит от того, как вы просите. Цель — направить модель к тестам, которые защищают поведение, а не просто исполняют код.

Включите стандарты кодирования прямо в промпт

Начните с фиксации «формы» тестов, чтобы выход соответствовал вашему репозиторию.

Укажите:

- язык + тестовый фреймворк (например, TypeScript + Jest, Python + pytest)

- правила именования (например,

should_<поведение>_when_<условие>)

- расположение файлов и структуру (например,

src/ и tests/, или __tests__/)

- любые соглашения (фикстуры, фабрики, библиотеки мокинга)

Это предотвратит выдумывание моделью паттернов, которые ваша команда не использует.

Дайте 1–2 реальных тестовых примера для копирования

Вставьте существующий тест (или короткий фрагмент) и явно скажите: «Соответствуй этому стилю». Это заякорит решения о том, как организовывать тестовые данные, как называть переменные и предпочитаемый стиль (табличные тесты и т. п.).

Если в проекте есть хелперы (например, buildUser() или makeRequest()), включите их, чтобы сгенерированные тесты использовали их вместо повторной реализации.

Просите осмысленные утверждения (не только «запускается»)

Будьте явными насчёт того, что такое «хорошо»:

- ассертируйте на выходы и изменения состояния

- проверяйте сайд‑эффекты (записи в БД, эмитируемые события)

- утверждайте тип/сообщение ошибки там, где это уместно

Полезная строка промпта: «Каждый тест должен содержать по крайней мере одно утверждение про бизнес‑поведение (не только ‘не упало’).»

Требуйте негативных и граничных тестов

Большинство сгенерированных наборов смещаются в сторону счастливого пути. Противодействуйте этому, запрашивая:

- некорректные входы и ожидаемые ошибки

- граничные значения (пустые строки, ноль, максимальная длина)

- отказ в правах/авторизации

- отсутствующие зависимости (null‑ответы, таймауты)

Практический шаблон промпта

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

(Не переводите содержимое блока кода — оставьте как есть.)

Человеческий ревью: как убедиться, что сгенерированные тесты действительно полезны

ИИ может быстро набросать много тестов, но он не может окончательно судить, отражают ли эти тесты ваше намерение. Человеческая проверка превращает «тесты, которые выполняются», в «тесты, которые нас защищают». Цель — не придираться к стилю, а убедиться, что набор тестов поймает значимые регрессии, не превратившись в налог на поддержку.

Ревью на корректность и релевантность

Начните с двух вопросов:

- Ассертирует ли тест поведение, которое действительно нужно продукту?

- Было бы вам неприятно, если бы этот тест упал при будущем изменении — потому что он сигнализирует о реальной проблеме?

Сгенерированные тесты иногда закрепляют случайное поведение (внутренние детали) вместо желаемого правила. Если тест выглядит как копия кода, а не описание ожидаемого исхода, направьте его к более высокоуровневым утверждениям.

Следите за хрупкостью (тихий убийца продуктивности)

Частые источники флейковости: чрезмерный мокинг, жёстко закодированные метки времени, случайные значения. Предпочитайте детерминированные входы и стабильные утверждения (например, проверять распарсенную дату или диапазон, а не сырую строку Date.now()). Если тест требует чрезмерного мокинга, возможно, он проверяет проводку, а не поведение.

Убедитесь, что падения происходят по правильной причине

«Прохождение» теста не гарантирует полезность — он может проходить, даже если фича сломана (ложноположительный результат). Ищите слабые утверждения вроде «не бросает исключений» или проверки только того, что функция была вызвана. Укрепляйте их проверками выходов, изменений состояния, сохранённых данных или возвращаемых ошибок.

Лёгкий чеклист для код‑ревью

Простой чеклист делает ревью последовательным:

- Читаемость: понятные имена, минимальная подготовка, явно выраженный смысл

- Покрытие намерения: ключевые крайние случаи и пути ошибок включены

- Сопровождаемость: избегает излишней спецификации внутренних деталей; минимальный мокинг

- Качество сигнала: тест упадёт при реальной регрессии, а не при безобидном рефакторе

Относитесь к сгенерированным тестам как к любому коду: мержьте только то, что вы согласны поддерживать через полгода.

Закрепление практики: CI‑чеки, которые держат ИИ‑код честным

ИИ помогает писать код быстро, но реальная польза — сохранить этот код корректным со временем. Самый простой способ «запечатать» качество — запускать тесты и проверки автоматически на каждое изменение, чтобы регрессии ловились до релиза.

Практический рабочий поток, который работает

Лёгкий рабочий процесс, который используют многие команды:

- Сгенерировать или отредактировать код фичи (с помощью ИИ или вручную).

- Сгенерировать тесты для нового поведения (и для только что исправленной ошибки).

- Запустить всё локально, чтобы убедиться, что зелёно.

- Закоммитить код + тесты вместе.

Последний шаг важен: ИИ‑код без сопутствующих тестов начинает дрейфовать. С тестами вы записываете ожидаемое поведение в форму, которую CI может применить.

CI как неотъемлемая страховочная сетка

Настройте CI на каждый pull request (и желательно на мерджи в main). Минимум, он должен:

- устанавливать зависимости в чистой среде

- запускать модульные/интеграционные тесты

- падать при любой ошибке теста

Это предотвращает сюрпризы «у меня работает» и ловит случайные поломки, когда кто‑то (или позже промпт ИИ) меняет код в другой части.

Добавьте несколько лёгких правил качества (не усложняйте)

Тесты — обязательно, но они не ловят всё. Добавьте быстрые, лёгкие проверки, дополняющие генерацию тестов:

- линтинг (стиль + распространённые ошибки)

- тайпчеки (если применимо)

- форматирование (чтобы диффы оставались читабельными)

Держите эти проверки быстрыми — если CI станет медленным или шумным, люди начнут искать обходные пути.

Планирование затрат и ёмкости

Если вы увеличиваете число прогонов CI из‑за роста набора тестов, убедитесь, что бюджет это выдерживает. Если вы платите за минуты CI, стоит пересмотреть лимиты и опции (см. /pricing).

Использование падающих тестов как руководства для следующей итерации ИИ

Эффективный подход: воспринимать падающие тесты как «следующий промпт». Вместо того чтобы просить модель «улучшить фичу», вы даёте конкретную ошибку и позволяете ей ограничивать изменение.

Рабочий поток: fail → prompt → fix → repeat

- Запустите suite (или CI) и выберите одно падение. Скопируйте имя падающего теста и релевантный вывод/стек.

- Попросите ИИ решить только эту проблему. Дайте минимальный контекст (падающий тест и тестируемый код), плюс бизнес‑правило, если нужно.

- Требуйте регрессионный тест прежде, чем править. Если падение из баг‑репорта, попросите сначала добавить тест, который воспроизводит баг.

- Примените минимальное изменение, чтобы тест прошёл. Немедленно перезапустите тесты.

- Перейдите к следующему падению. По одному падению за итерацию — так проще понять изменения.

Шаблон промпта: держите маленькими и проверяемыми

Вместо: «Исправь логику логина и обнови тесты» используйте:

- «Этот тест падает:

shouldRejectExpiredToken. Вот вывод ошибки и релевантный код. Обнови реализацию так, чтобы этот тест проходил не меняя публичное поведение. При необходимости добавь регрессионный тест.»

Почему это уменьшает итерации

Падающие тесты убирают догадки. Они определяют, что такое «правильно», в исполняемой форме, так что вы не ведёте переговоров в чате. Вы также избегаете раздувания правок: каждый промпт ограничен до одного измеримого результата, что ускоряет ревью и помогает увидеть, когда ИИ «исправил» симптом, но сломал что‑то ещё.

Это тот случай, где агентный рабочий поток особенно полезен: один агент фокусируется на минимальном изменении кода, другой предлагает небольшое изменение теста, вы просматриваете diff. Платформы вроде Koder.ai устроены вокруг такого итеративного, чат‑ориентированного процесса — превращая «тест как следующий промпт» в обычную практику.

Как измерять успех без гонки за показухой

Автоматическая генерация тестов может мгновенно увеличивать набор тестов, но «больше» не равно «лучше». Цель — уверенность: ловить регрессии рано, сокращать дефекты в продакшне и поддерживать скорость команды.

Метрики, которые действительно отражают качество

Начните со сигналов, которые имеют привязку к результатам:

- Процент успешных сборок (на main): если мерджи часто ломаются, сгенерированные тесты могут быть слишком хрупкими или промпты ставят неверные предположения.

- Уровень флейковости: как часто тесты падают/прошли при повторах. Рост флейковости — налог на доверие к CI.

- Время обнаружения регрессий: время от внесения бага до падения CI. Генерированные тесты должны укорачивать этот интервал.

Относитесь к покрытию как к подсказке, а не к цели

Покрытие полезно как индикатор, но его легко «накрутить». Сгенерированные тесты могут увеличить покрытие, при этом утверждать мало. Предпочитайте индикаторы типа:

- количество утверждений на тест (контрольная метрика, а не KPI)

- результаты mutation testing (если используете)

- проходит ли набор тестов, когда вы намеренно ломаете поведение

Сфокусируйтесь на «дефектах, пойманных до релиза»

Если вы отслеживаете только количество тестов или покрытие, вы начнёте оптимизировать объём. Отслеживайте дефекты, пойманные до релиза: баги, найденные в CI, QA или стейджинге, которые иначе дошли бы до пользователей. Работая правильно, автогенерация тестов повышает это число (больше багов находится раньше) и снижает инциденты в продакшне.

Планируйте очистку, чтобы сохранить улучшения

Сгенерированные наборы требуют поддержки. Запланируйте регулярную задачу, чтобы:

- удалять избыточные тесты, не дающие уникальной защиты

- стабилизировать или удалить флейковые тесты

- консолидировать перекрывающиеся случаи в более ясные тесты

Успех = спокойный CI, более быстрая обратная связь и меньше сюрпризов — не красивая панель с большим числом тестов.

Частые подводные камни и практический план развёртывания

Автоматическая генерация тестов может быстро повысить качество — но только если её использовать как помощника, а не как авторитет. Самые распространённые ошибки похожи между командами и их можно избежать.

Частые ошибки

Чрезмерная зависимость — классическая ловушка: сгенерированные тесты создают иллюзию безопасности, пропуская реальные риски. Если люди перестают думать критически ("инструмент написал тесты, значит мы в безопасности"), вы начнёте выпускать баги быстрее — с большим числом зелёных чекбоксов.

Ещё одна проблема — проверка внутренних деталей реализации вместо поведения. Инструменты ИИ часто цепляются за текущие имена методов, внутренние хелперы или точные тексты ошибок. Такие тесты становятся ломкими: рефакторы ломают их, хоть фича и работает. Предпочитайте тесты, описывающие что должно происходить, а не как.

Безопасность и приватность: не сливайте лишнего

Генерация тестов часто включает копирование кода, трасс стеков или логов в промпт. Это может раскрывать секреты (API‑ключи), данные клиентов или проприетарную логику.

Держите промпты и фикстуры свободными от чувствительной информации:

- редактируйте токены, учётные данные и внутренние URL

- не вставляйте продакшн‑логи с личными данными

- используйте синтетические примеры (фейковые аккаунты, фейковые ID)

- если нужно делиться реальными кейсами — минимизируйте и анонимизируйте

Если вы используете хостинговую AI‑платформу, соблюдайте ту же дисциплину. Даже при региональном хостинге и современных настройках, ваши промпты и фикстуры — часть безопасности.

Практический план развёртывания

Начните с малого и делайте привычкой:

- Выберите один сервис или модуль, который часто меняется.

- Сгенерируйте модульные тесты для самых рисковых путей (движение денег, права, трансформации данных).

- Добавьте простое правило CI: новые фичи, написанные с помощью ИИ, должны включать тесты (см. /blog/ci-checks-for-ai-code).

- Требуйте быстрый чеклист ревью: «Ассертит ли тест поведение? Упадёт ли он по правильной причине?»

- Отслеживайте предотвращённые регрессии (не только покрытие), затем расширяйте до интеграционных тестов, когда модульные тесты станут стабильными.

Цель — не максимальное число тестов, а надёжная обратная связь, сохраняющая честность логики, сгенерированной ИИ.